RabbitMQ

消息队列

MQ的概念

MQ(message queue),从字面意思上看,本质是个队列,FIFO 先入先出,只不过队列中存放的内容是 message 而已,还是一种跨进程的通信机制,用于上下游传递消息。在互联网架构中,MQ 是一种非常常 见的上下游“逻辑解耦+物理解耦”的消息通信服务。使用了 MQ 之后,消息发送上游只需要依赖 MQ,不 用依赖其他服务。

应用场景

流量消峰

举个例子,如果订单系统最多能处理一万次订单,这个处理能力应付正常时段的下单时绰绰有余,正 常时段我们下单一秒后就能返回结果。但是在高峰期,如果有两万次下单操作系统是处理不了的,只能限 制订单超过一万后不允许用户下单。使用消息队列做缓冲,我们可以取消这个限制,把一秒内下的订单分 散成一段时间来处理,这时有些用户可能在下单十几秒后才能收到下单成功的操作,但是比不能下单的体 验要好。

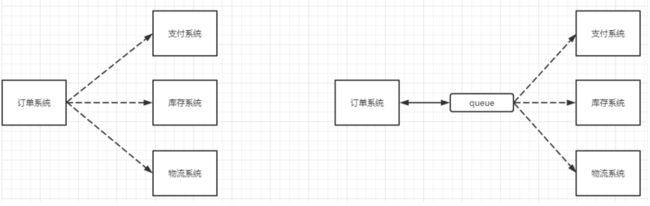

应用解耦

以电商应用为例,应用中有订单系统、库存系统、物流系统、支付系统。用户创建订单后,如果耦合 调用库存系统、物流系统、支付系统,任何一个子系统出了故障,都会造成下单操作异常。当转变成基于 消息队列的方式后,系统间调用的问题会减少很多,比如物流系统因为发生故障,需要几分钟来修复。在 这几分钟的时间里,物流系统要处理的内存被缓存在消息队列中,用户的下单操作可以正常完成。当物流 系统恢复后,继续处理订单信息即可,中间用户感受不到物流系统的故障,提升系统的可用性。

异步处理

有些服务间调用是异步的,例如 A 调用 B,B 需要花费很长时间执行,但是 A 需要知道 B 什么时候可 以执行完,以前一般有两种方式,A 过一段时间去调用 B 的查询 api 查询。或者 A 提供一个 callback api, B 执行完之后调用 api 通知 A 服务。这两种方式都不是很优雅,使用消息总线,可以很方便解决这个问题, A 调用 B 服务后,只需要监听 B 处理完成的消息,当 B 处理完成后,会发送一条消息给 MQ,MQ 会将此消 息转发给 A 服务。这样 A 服务既不用循环调用 B 的查询 api,也不用提供 callback api。同样B 服务也不用 做这些操作。A 服务还能及时的得到异步处理成功的消息。

分类

ActiveMQ

优点:单机吞吐量万级,时效性 ms 级,可用性高,基于主从架构实现高可用性,消息可靠性较 低的概率丢失数据

缺点:官方社区现在对 ActiveMQ 5.x 维护越来越少,高吞吐量场景较少使用。

Kafka

大数据的杀手锏,谈到大数据领域内的消息传输,则绕不开 Kafka,这款为大数据而生的消息中间件, 以其百万级 TPS 的吞吐量名声大噪,迅速成为大数据领域的宠儿,在数据采集、传输、存储的过程中发挥着举足轻重的作用。目前已经被 LinkedIn,Uber, Twitter, Netflix 等大公司所采纳。

优点: 性能卓越,单机写入 TPS 约在百万条/秒,最大的优点,就是吞**吐量高**。时效性 ms 级可用性非常高,kafka 是分布式的,一个数据多个副本,少数机器宕机,不会丢失数据,不会导致不可用,消费者采用 Pull 方式获取消息, 消息有序, 通过控制能够保证所有消息被消费且仅被消费一次;有优秀的第三方Kafka Web 管理界面 Kafka-Manager;在日志领域比较成熟,被多家公司和多个开源项目使用;功能支持: 功能较为简单,主要支持简单的 MQ 功能,在大数据领域的实时计算以及**日志采集**被大规模使用

缺点:Kafka 单机超过 64 个队列/分区,Load 会发生明显的飙高现象,队列越多,load 越高,发送消息响应时间变长,使用短轮询方式,实时性取决于轮询间隔时间,消费失败不支持重试;支持消息顺序, 但是一台代理宕机后,就会产生消息乱序,**社区更新较慢**;

RabbitMQ

2007 年发布,是一个在AMQP(高级消息队列协议)基础上完成的,可复用的企业消息系统,是当前最主流的消息中间件之一。

优点:由于 erlang 语言的**高并发特性**,性能较好;**吞吐量到万级**,MQ 功能比较完备,健壮、稳定、易用、跨平台、**支持多种语言** 如:Python、Ruby、.NET、Java、JMS、C、PHP、ActionScript、XMPP、STOMP 等,支持 AJAX 文档齐全;开源提供的管理界面非常棒,用起来很好用,**社区活跃度高**;更新频率相当高https://www.rabbitmq.com/news.html

缺点:商业版需要收费,学习成本较高

选择

Kafka

Kafka 主要特点是基于Pull 的模式来处理消息消费,追求高吞吐量,一开始的目的就是用于日志收集和传输,适合产生**大量数据**的互联网服务的数据收集业务。**大型公司**建议可以选用,如果有**日志采集**功能, 肯定是首选 kafka 了。

RocketMQ

天生为金融互联网领域而生,对于可靠性要求很高的场景,尤其是电商里面的订单扣款,以及业务削峰,在大量交易涌入时,后端可能无法及时处理的情况。RoketMQ 在稳定性上可能更值得信赖,这些业务场景在阿里双 11 已经经历了多次考验,如果你的业务有上述并发场景,建议可以选择 RocketMQ。

RabbitMQ

结合 erlang 语言本身的并发优势,性能好**时效性微秒级**,**社区活跃度也比较高**,管理界面用起来十分方便,如果你的**数据量没有那么大**,中小型公司优先选择功能比较完备的 RabbitMQ。

RabbitMQ

概念

RabbitMQ 是一个消息中间件:它接受并转发消息。你可以把它当做一个快递站点,当你要发送一个包裹时,你把你的包裹放到快递站,快递员最终会把你的快递送到收件人那里,按照这种逻辑 RabbitMQ 是一个快递站,一个快递员帮你传递快件。RabbitMQ 与快递站的主要区别在于,它不处理快件而是接收, 存储和转发消息数据。

四大核心概念

-

生产者

产生数据发送消息的程序是生产者

-

交换机

交换机是 RabbitMQ 非常重要的一个部件,一方面它接收来自生产者的消息,另一方面它将消息推送到队列中。交换机必须确切知道如何处理它接收到的消息,是将这些消息推送到特定队列还是推送到多个队列,亦或者是把消息丢弃,这个得有交换机类型决定

-

队列

队列是 RabbitMQ 内部使用的一种数据结构,尽管消息流经 RabbitMQ 和应用程序,但它们只能存储在队列中。队列仅受主机的内存和磁盘限制的约束,本质上是一个大的消息缓冲区。许多生产者可以将消息发送到一个队列,许多消费者可以尝试从一个队列接收数据。这就是我们使用队列的方式

-

消费者

消费与接收具有相似的含义。消费者大多时候是一个等待接收消息的程序。请注意生产者,消费者和消息中间件很多时候并不在同一机器上。同一个应用程序既可以是生产者又是可以是消费者。

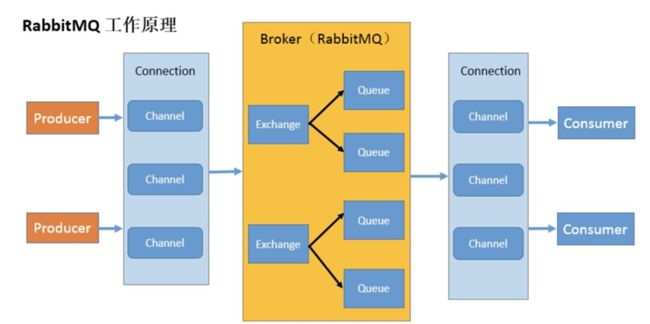

工作原理

Broker:接收和分发消息的应用,RabbitMQ Server 就是 Message Broker

Virtual host:出于多租户和安全因素设计的,把 AMQP 的基本组件划分到一个虚拟的分组中,类似于网络中的 namespace 概念。当多个不同的用户使用同一个 RabbitMQ server 提供的服务时,可以划分出多个 vhost,每个用户在自己的 vhost 创建 exchange/queue 等

Connection:publisher/consumer 和broker 之间的 TCP 连接

Channel:如果每一次访问 RabbitMQ 都建立一个 Connection,在消息量大的时候建立 TCP,Connection 的开销将是巨大的,效率也较低。Channel 是在 connection 内部建立的逻辑连接,如果应用程序支持多线程,通常每个 thread 创建单独的 channel 进行通讯,AMQP method 包含了 channel id 帮助客户端和 message broker 识别 channel,所以 channel 之间是完全隔离的。Channel 作为轻量级的Connection极大减少了操作系统建立TCP connection的开销

Exchange:message 到达 broker 的第一站,根据分发规则,匹配查询表中的 routing key,分发消息到 queue 中去。常用的类型有:direct (point-to-point), topic (publish-subscribe) and fanout (multicast)

Queue:消息最终被送到这里等待 consumer 取走

Binding:exchange 和queue 之间的虚拟连接,binding 中可以包含 routing key,Binding 信息被保存到 exchange 中的查询表中,用于 message 的分发依据

安装

官网:https://www.rabbitmq.com/download.html

因为RabbitMQ是基于erlang的,所以我们还要同时下载erlang

别用压缩包,直接找 rpm 软件包,一步安装到位

rpm -ivh erlang-23.3.4.11-1.el7.x86_64.rpm

yum install socat -y

rpm -ivh rabbitmq-server-3.8.28-1.el7.noarch.rpm

中间那步是为了下载一个插件

常用命令

- 添加开机启动 RabbitMQ 服务:chkconfig rabbitmq-server on

- 启动服务:/sbin/service rabbitmq-server start

- 查看服务状态:/sbin/service rabbitmq-server status

- 停止服务(选择执行):/sbin/service rabbitmq-server stop

可能会遇到的问题:

-

防火墙没关,使用下面的命令

firewall-cmd --zone=public --add-port=15672/tcp --permanent firewall-cmd --zone=public --add-port=5672/tcp --permanent firewall-cmd --reload -

无法启动,设置开机启动服务后,重启一下,利用开机启动来启动

添加用户

开启 web 管理插件:rabbitmq-plugins enable rabbitmq_management

用默认账号密码(guest)访问地址 http://47.115.185.244:15672/

-

创建账号:rabbitmqctl add_user username(admin) password(123)

-

设置用户角色:rabbitmqctl set_user_tags username(admin) administrator

-

设置用户权限:rabbitmqctl set_permissions -p “/” username(admin) “." ".” “.*”

用户 user_admin 具有/vhost1 这个 virtual host 中所有资源的配置、写、读权限

-

当前用户和角色:rabbitmqctl list_users

关闭应用的命令为:rabbitmqctl stop_app

清除的命令为:rabbitmqctl reset

重新启动命令为:rabbitmqctl start_app

简单应用

用 Java 编写两个程序。发送单个消息的生产者和接收消息并打印出来的消费者。

引入依赖

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.pluginsgroupId>

<artifactId>maven-compiler-pluginartifactId>

<configuration>

<source>8source>

<target>8target>

configuration>

plugin>

plugins>

build>

<dependencies>

<dependency>

<groupId>com.rabbitmqgroupId>

<artifactId>amqp-clientartifactId>

<version>5.8.0version>

dependency>

<dependency>

<groupId>commons-iogroupId>

<artifactId>commons-ioartifactId>

<version>2.6version>

dependency>

dependencies>

生产者

public class Producter {

private final static String QUEUE_NAME = "hello";

public static void main(String[] args) throws Exception {

//创建一个连接工厂

ConnectionFactory factory = new ConnectionFactory();

//RabbitMQ所在服务器的地址

factory.setHost("192.168.32.128");

factory.setUsername("admin");

factory.setPassword("123");

//channel 实现了自动 close 接口 自动关闭 不需要显示关闭

try (Connection connection = factory.newConnection();Channel channel = connection.createChannel()){

/**

* 生成一个队列

* 1.队列名称

* 2.队列里面的消息是否持久化 默认消息存储在内存中

* 3.该队列是否只供一个消费者进行消费 是否进行共享 true 可以多个消费者消费

* 4.是否自动删除 最后一个消费者端开连接以后 该队列是否自动删除 true 自动删除

* 5.其他参数

*/

channel.queueDeclare(QUEUE_NAME, false, false, false, null);

String message = "hello world";

/**

* 发送一个消息

* 1.发送到那个交换机

* 2.路由的 key 是哪个

* 3.其他的参数信息

* 4.发送消息的消息体

*/

channel.basicPublish("", QUEUE_NAME, null, message.getBytes());

System.out.println("消息发送完毕");

}

}

}

消费者

public class Consumer {

private final static String QUEUE_NAME = "hello";

public static void main(String[] args) throws Exception {

ConnectionFactory factory = new ConnectionFactory();

//RabbitMQ所在服务器的地址

factory.setHost("192.168.32.128");

factory.setUsername("admin");

factory.setPassword("123");

Connection connection = factory.newConnection();

Channel channel = connection.createChannel();

System.out.println("等待接收消息 ");

//推送的消息如何进行消费的接口回调

DeliverCallback deliverCallback = (consumerTag, delivery)-> {

String message = new String(delivery.getBody());

System.out.println(message);

};

//取消消费的一个回调接口 如在消费的时候队列被删除掉了

CancelCallback cancelCallback = (consumerTag) -> {System.out.println("消息消费被中断");};

/**

* 消费者消费消息

* 1.消费哪个队列

* 2.消费成功之后是否要自动应答 true 代表自动应答 false 手动应答

* 3.消费者未成功消费的回调

*/

channel.basicConsume(QUEUE_NAME, true, deliverCallback, cancelCallback);

}

}

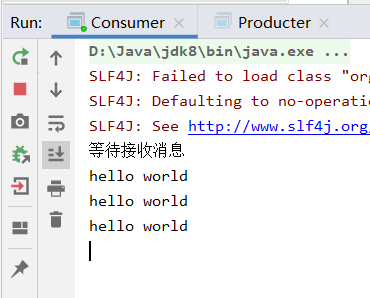

演示

每运行一次producter,consumer就会接收到一个hello world

工作队列

工作队列(又称任务队列)的主要思想是避免立即执行资源密集型任务,而不得不等待它完成。相反我们安排任务在之后执行。我们把任务封装为消息并将其发送到队列。在后台运行的工作进程将弹出任务并最终执行作业。当有多个工作线程时,这些工作线程将一起处理这些任务。

轮训分发消息

多个消费者将轮流接受消息

消息应答

概念

消费者完成一个任务可能需要一段时间,如果其中一个消费者处理一个长的任务并仅只完成了部分突然它挂掉了,会发生什么情况。RabbitMQ 一旦向消费者传递了一条消息,便立即将该消息标记为删除。在这种情况下,突然有个消费者挂掉了,我们将丢失正在处理的消息。以及后续发送给该消费这的消息,因为它无法接收到。

为了保证消息在发送过程中不丢失,rabbitmq 引入消息应答机制,消息应答就是:消费者在接收到消息并且处理该消息之后,告诉 rabbitmq 它已经处理了,rabbitmq 可以把该消息删除了。

自动应答

消息发送后立即被认为已经传送成功,这种模式需要在高吞吐量和数据传输安全性方面做权 衡,因为这种模式如果消息在接收到之前,消费者那边出现连接或者 channel 关闭,那么消息就丢失了,当然另一方面这种模式消费者那边可以传递过载的消息,没有对传递的消息数量进行限制, 当然这样有可能使得消费者这边由于接收太多还来不及处理的消息,导致这些消息的积压,最终使得内存耗尽,最终这些消费者线程被操作系统杀死,所以这种模式仅适用在消费者可以高效并以某种速率能够处理这些消息的情况下使用。

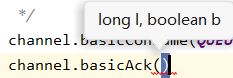

手动应答

是否手动应答取决于接收消息的方法 basicConsume 的第二个参数,true代表自动应答,false代表手动应答

方法

Channel.basicAck(用于肯定确认) RabbitMQ 已知道该消息并且成功的处理消息,可以将其丢弃了

Channel.basicNack(用于否定确认)

Channel.basicReject(用于否定确认) 与 Channel.basicNack 相比少一个参数

不处理该消息了直接拒绝,可以将其丢弃了

multiple参数

第二个参数就是multiple参数

true 代表批量应答 channel 上未应答的消息

比如说 channel 上有传送 tag 的消息 5,6,7,8 当前 tag 是 8 那么此时5-8 的这些还未应答的消息都会被确认收到消息应答

false 同上面相比

只会应答 tag=8 的消息 5,6,7 这三个消息依然不会被确认收到消息应答

消息自动重新入队

如果消费者由于某些原因失去连接(其通道已关闭,连接已关闭或 TCP 连接丢失),导致消息未发送 ACK 确认,RabbitMQ 将了解到消息未完全处理,并将对其重新排队。如果此时其他消费者可以处理,它将很快将其重新分发给另一个消费者。这样,即使某个消费者偶尔死亡,也可以确保不会丢失任何消息。

手动应答代码实现

连接工具类

public class RabbitMqUtils {

//得到一个连接的 channel

public static Channel getChannel() throws Exception {

//创建一个连接工厂

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("182.92.234.71");

factory.setUsername("admin");

factory.setPassword("123");

Connection connection = factory.newConnection();

Channel channel = connection.createChannel();

return channel;

}

}

睡眠工具类

public class SleepUtils {

public static void sleep(int second) {

try {

Thread.sleep(1000*second);

}catch (InterruptedException ignored){

Thread.currentThread().interrupt();

}

}

}

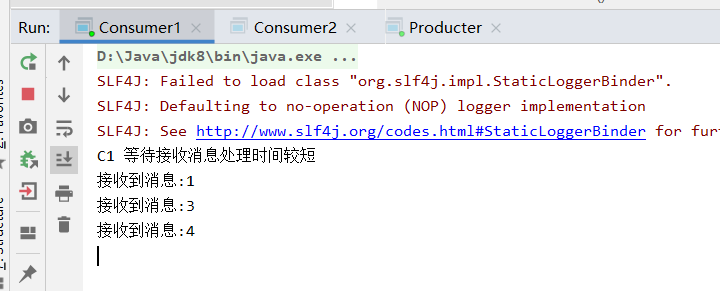

启动两个接收线程

public class Consumer1 {

private final static String QUEUE_NAME = "hello";

public static void main(String[] args) throws Exception {

Channel channel = RabbitMqUtils.getChannel();

System.out.println("C1 等待接收消息处理时间较短");

//消息消费的时候如何处理消息

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody());

SleepUtils.sleep(1);

System.out.println("接收到消息:" + message);

/**

* 1.消息标记 tag

* 2.是否批量应答未应答消息

*/

channel.basicAck(delivery.getEnvelope().getDeliveryTag(), false);

};

//采用手动应答

boolean autoAck = false;

channel.basicConsume(QUEUE_NAME, autoAck, deliverCallback, (consumerTag) -> {

System.out.println(consumerTag + "消费者取消消费接口回调逻辑");

});

}

}

第二个一样复制就可以了

生产者

public class Producter {

private final static String QUEUE_NAME = "hello";

public static void main(String[] args) throws Exception {

try (Channel channel = RabbitMqUtils.getChannel();) {

channel.queueDeclare(QUEUE_NAME, false, false, false, null);

//从控制台当中接受信息

Scanner scanner = new Scanner(System.in);

while (scanner.hasNext()) {

String message = scanner.next();

channel.basicPublish("", QUEUE_NAME, null, message.getBytes());

System.out.println("发送消息完成:" + message);

}

}

}

}

演示

我们模拟了一个处理时间是1s,一个是30秒。

同时发送 4 条消息,1s的消费者会在两秒内处理第一和第三条,在30s 消费者处理消息的过程中,如果我们暂停处理程序,那么未被处理的消息会重新入队,然后被1s的消费者接收到

持久化

概念

刚刚我们已经看到了如何处理任务不丢失的情况,但是如何保障当 RabbitMQ 服务停掉以后消

息生产者发送过来的消息不丢失。默认情况下 RabbitMQ 退出或由于某种原因崩溃时,它忽视队列和消息,除非告知它不要这样做。确保消息不会丢失需要做两件事:我们需要将队列和消息都标记为持久化。

实现

队列的持久化

之前我们创建的队列都是非持久化的,rabbitmq 如果重启的化,该队列就会被删除掉,如果 要队列实现持久化 需要在声明队列的时候把 durable 参数设置为持久化,这个时候即使重启 rabbitmq 队列也依然存在

但是需要注意的就是如果之前声明的队列不是持久化的,需要把原先队列先删除,或者重新创建一个持久化的队列,不然就会出现错误

消息的持久化

前提队列已经实现了持久化

要想让消息实现持久化需要在消息生产者修改代码,对basicPublish方法的第三个参数props添加这个属性MessageProperties.PERSISTENT_TEXT_PLAIN

![]()

将消息标记为持久化并不能完全保证不会丢失消息。尽管它告诉 RabbitMQ 将消息保存到磁盘,但是这里依然存在当消息刚准备存储在磁盘的时候 但是还没有存储完,消息还在缓存的一个间隔点。此时并没有真正写入磁盘。持久性保证并不强,但是对于我们的简单任务队列而言,这已经绰绰有余了。

不公平分发

之前讲到 RabbitMQ 分发消息采用的轮训分发,但是在某种场景下这种策略并不是很好,比方说有两个消费者在处理任务,其中有个消费者 1 处理任务的速度非常快,而另外一个消费者 2 处理速度却很慢,这个时候我们还是采用轮训分发的化就会到这处理速度快的这个消费者很大一部分时间处于空闲状态,而处理慢的那个消费者一直在干活,这种分配方式在这种情况下其实就不太好,但是RabbitMQ 并不知道这种情况,它依然很公平的进行分发。

为了避免这种情况,我们可以设置参数 channel.basicQos(1);(消费者的参数,数字是多少就是可以预取多少)

意思就是如果这个任务我还没有处理完或者我还没有应答你,你先别分配给我,我目前只能处理一个任务,然后 rabbitmq 就会把该任务分配给没有那么忙的那个空闲消费者,当然如果所有的消费者都没有完成手上任务,队列还在不停的添加新任务,队列有可能就会遇到队列被撑满的情况,这个时候就只能添加新的 worker 或者改变其他存储任务的策略

预取值

本身消息的发送就是异步发送的,所以在任何时候,channel 上肯定不止只有一个消息,另外来自消费者的手动确认本质上也是异步的。因此这里就存在一个未确认的消息缓冲区,所以希望开发人员能限制此缓冲区的大小,以避免缓冲区里面无限制的未确认消息问题。

这个时候就可以通过使用 basicqos() 方法设置“预取计数”值来完成的。**该值定义通道上允许的未确认消息的最大数量。**一旦数量达到配置的数量,RabbitMQ 将停止在通道上传递更多消息,直到至少有一个未处理的消息被确认,例如,假设在通道上有未确认的消息 5、6、7,8,并且通道的预取计数设置为 4,此时RabbitMQ 将不会在该通道上再传递任何消息,除非至少有一个未应答的消息被 ack。比方说 tag=6 这个消息刚刚被确认 ACK,RabbitMQ 将会感知这个情况到并再发送一条消息。

消息应答和 QoS 预取值对用户吞吐量有重大影响。通常,增加预取将提高向消费者传递消息的速度。虽然自动应答传输消息速率是最佳的,但是,在这种情况下已传递但尚未处理的消息的数量也会增加,从而增加了消费者的RAM 消耗(随机存取存储器)应该小心使用具有无限预处理的自动确认模式或手动确认模式,消费者消费了大量的消息如果没有确认的话,会导致消费者连接节点的内存消耗变大,所以找到合适的预取值是一个反复试验的过程

不同的负载该值取值也不同,100 到 300 范围内的值通常可提供最佳的吞吐量,并且不会给消费者带来太大的风险。预取值为 1 是最保守的。当然这将使吞吐量变得很低,特别是消费者连接延迟很严重的情况下,特别是在消费者连接等待时间较长的环境中。对于大多数应用来说,稍微高一点的值将是最佳的。

发布确认

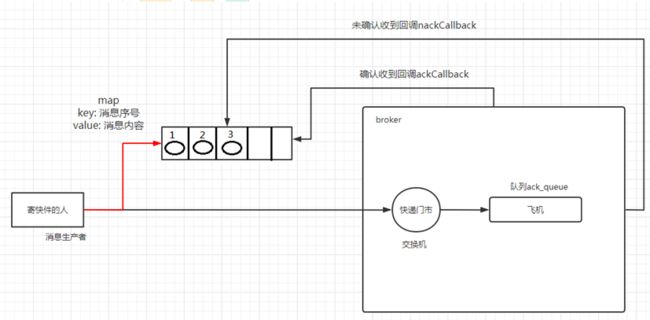

原理

生产者将信道设置成 confirm 模式,一旦信道进入 confirm 模式,所有在该信道上面发布的消息都将会被指派一个唯一的 ID( 从 1 开始),一旦消息被投递到所有匹配的队列之后,broker 就会发送一个确认给生产者(包含消息的唯一 ID),这就使得生产者知道消息已经正确到达目的队列了, 如果消息和队列是可持久化的,那么确认消息会在将消息写入磁盘之后发出,broker 回传给生产者的确认消息中 delivery-tag 域包含了确认消息的序列号,此外 broker 也可以设置basic.ack 的multiple 域,表示到这个序列号之前的所有消息都已经得到了处理。

confirm 模式最大的好处在于他是异步的,一旦发布一条消息,生产者应用程序就可以在等信道返回确认的同时继续发送下一条消息,当消息最终得到确认之后,生产者应用便可以通过回调方 法来处理该确认消息,如果 RabbitMQ 因为自身内部错误导致消息丢失,就会发送一条 nack 消息, 生产者应用程序同样可以在回调方法中处理该 nack 消息。

实现

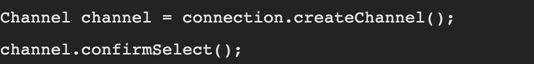

开启发布确认的方法

发布确认默认是没有开启的,如果要开启需要调用方法 confirmSelect,每当你要想使用发布确认,都需要在 channel 上调用该方法

单个确认发布

这是一种简单的确认方式,它是一种同步确认发布的方式,也就是发布一个消息之后只有它被确认发布,后续的消息才能继续发布,waitForConfirmsOrDie(long)这个方法只有在消息被确认的时候才返回,如果在指定时间范围内这个消息没有被确认那么它将抛出异常。

这种确认方式有一个最大的缺点就是:**发布速度特别的慢,**因为如果没有确认发布的消息就会阻塞所有后续消息的发布,这种方式最多提供每秒不超过数百条发布消息的吞吐量。当然对于某些应用程序来说这可能已经足够了。

public static void publishMessageIndividually() throws Exception {

try (Channel channel = RabbitMqUtils.getChannel()){

String queueName = UUID.randomUUID().toString(); channel.queueDeclare(queueName, false, false, false, null);

//开启发布确认

channel.confirmSelect();

long begin = System.currentTimeMillis();

for (int i = 0; i < MESSAGE_COUNT; i++) {

String message = i + "";

channel.basicPublish("", queueName, null, message.getBytes());

//服务端返回 false 或超时时间内未返回,生产者可以消息重发

boolean flag = channel.waitForConfirms();

if(flag){

System.out.println("消息发送成功");

}

}

long end = System.currentTimeMillis();

System.out.println("发布" + MESSAGE_COUNT + "个单独确认消息,耗时" + (end - begin) + "ms");

}

}

批量确认发布

与单个等待确认消息相比,先发布一批消息然后一起确认可以极大地提高吞吐量,当然这种方式的缺点就是:当发生故障导致发布出现问题时,不知道是哪个消息出现问题了,我们必须将整个批处理保存在内存中,以记录重要的信息而后重新发布消息。当然这种方案仍然是同步的,也一样阻塞消息的发布。

public static void publishMessageBatch() throws Exception {

try (Channel channel = RabbitMqUtils.getChannel()) {

String queueName = UUID.randomUUID().toString();

channel.queueDeclare(queueName, false, false, false, null);

//开启发布确认

channel.confirmSelect();

//批量确认消息大小

int batchSize = 100;

//未确认消息个数

int outstandingMessageCount = 0;

long begin = System.currentTimeMillis();

for (int i = 0; i < MESSAGE_COUNT; i++) {

String message = i + "";

channel.basicPublish("", queueName, null, message.getBytes());

outstandingMessageCount++;

if (outstandingMessageCount == batchSize) {

channel.waitForConfirms();

outstandingMessageCount = 0;

}

}

//为了确保还有剩余没有确认消息 再次确认

if (outstandingMessageCount > 0) {

channel.waitForConfirms();

}

long end = System.currentTimeMillis();

System.out.println("发布" + MESSAGE_COUNT + "个批量确认消息,耗时" + (end - begin) + "ms");

}

}

异步确认发布

异步确认虽然编程逻辑比上两个要复杂,但是性价比最高,无论是可靠性还是效率都没得说, 他是利用回调函数来达到消息可靠性传递的,这个中间件也是通过函数回调来保证是否投递成功。

public static void publishMessageAsync() throws Exception {

try (Channel channel = RabbitMqUtils.getChannel()) {

String queueName = UUID.randomUUID().toString();

channel.queueDeclare(queueName, false, false, false, null);

//开启发布确认

channel.confirmSelect();

/**

* 线程安全有序的一个哈希表,适用于高并发的情况

* 1.轻松的将序号与消息进行关联

* 2.轻松批量删除条目 只要给到序列号

* 3.支持并发访问

*/

ConcurrentSkipListMap<Long, String> outstandingConfirms = new ConcurrentSkipListMap<>();

/**

* 确认收到消息的一个回调

* 1.消息序列号

* 2.true 可以确认小于等于当前序列号的消息

* false 确认当前序列号消息

*/

ConfirmCallback ackCallback = (sequenceNumber, multiple) -> {

if (multiple) {

//返回的是小于等于当前序列号的未确认消息 是一个 map

ConcurrentNavigableMap<Long, String> confirmed = outstandingConfirms.headMap(sequenceNumber, true);

//清除该部分未确认消息

confirmed.clear();

} else {

//只清除当前序列号的消息

outstandingConfirms.remove(sequenceNumber);

}

};

ConfirmCallback nackCallback = (sequenceNumber, multiple) ->{

String message = outstandingConfirms.get(sequenceNumber);

System.out.println("发布的消息" + message + "未被确认,序列号" + sequenceNumber);

};

/**

* 添加一个异步确认的监听器

* 1.确认收到消息的回调

* 2.未收到消息的回调

*/

channel.addConfirmListener(ackCallback, null);

long begin = System.currentTimeMillis();

for (int i = 0; i < MESSAGE_COUNT; i++) {

String message = "消息" + i;

/**

* channel.getNextPublishSeqNo()获取下一个消息的序列号

* 通过序列号与消息体进行一个关联

* 全部都是未确认的消息体

*/

outstandingConfirms.put(channel.getNextPublishSeqNo(), message);

channel.basicPublish("", queueName, null, message.getBytes());

}

long end = System.currentTimeMillis();

System.out.println("发布" + MESSAGE_COUNT + "个异步确认消息,耗时" + (end - begin) + "ms");

}

}

三者对比

单独发布消息

同步等待确认,简单,但吞吐量非常有限。

批量发布消息

批量同步等待确认,简单,合理的吞吐量,一旦出现问题但很难推断出是哪条消息出现了问题。

异步处理

最佳性能和资源使用,在出现错误的情况下可以很好地控制,但是实现起来稍微难些

交换机

发布/订阅:将消息传达给多个消费者

Exchanges

概念

RabbitMQ 消息传递模型的核心思想是: 生产者生产的消息从不会直接发送到队列。实际上,通常生产者甚至都不知道这些消息传递传递到了哪些队列中。

相反,生产者只能将消息发送到交换机(exchange),交换机工作的内容非常简单,一方面它接收来自生产者的消息,另一方面将它们推入队列。交换机必须确切知道如何处理收到的消息。是应该把这些消息放到特定队列还是说把他们到许多队列中还是说应该丢弃它们。这就的由交换机的类型来决定

类型

直接(direct), 主题(topic) ,标题(headers) , 扇出(fanout)

无名exchange:即我们之前在调用basicPublish发送消息时的第一个参数是空字符串,它表示默认或无名称交换机:消息能路由发送到队列中其实是由 routingKey(bindingkey)绑定 key 指定的,如果它存在的话

临时队列

之前使用的是具有特定名称的队列。队列的名称至关重要-我们需要指定我们的消费者去消费哪个队列的消息。

每当我们连接到 Rabbit 时,我们都需要一个全新的空队列,为此我们可以创建一个具有随机名称的队列,或者能让服务器为我们选择一个随机队列名称那就更好了。其次一旦我们断开了消费者的连接,队列将被自动删除。

创建临时队列的方式如下:

String queueName = channel.queueDeclare().getQueue();

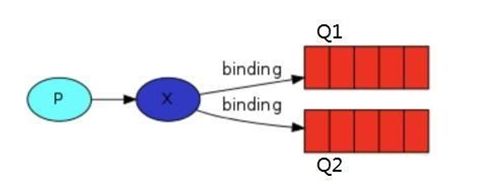

绑定(bindings)

binding 其实是 exchange 和queue 之间的桥梁,它告诉我们 exchange 和那个队列进行了绑定关系。

Fanout exchange

概念

将接收到的所有消息广播到它知道的所有队列中。

演示

public class EmitLog {

private static final String EXCHANGE_NAME = "logs";

public static void main(String[] argv) throws Exception {

try (Channel channel = RabbitUtils.getChannel()) {

/**

* 声明一个 exchange

* 1.exchange 的名称

* 2.exchange 的类型

*/

channel.exchangeDeclare(EXCHANGE_NAME, "fanout");

Scanner sc = new Scanner(System.in);

System.out.println("请输入信息");

while (sc.hasNext()) {

String message = sc.nextLine();

channel.basicPublish(EXCHANGE_NAME, "", null, message.getBytes("UTF-8"));

System.out.println("生产者发出消息" + message);

}

}

}

}

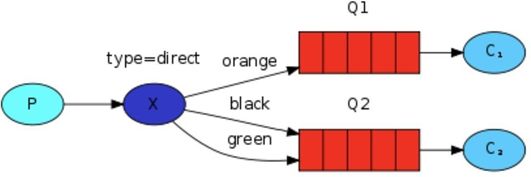

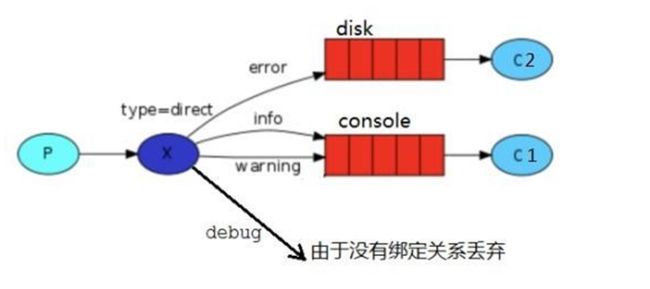

Direct exchange

概念

消息只去到它绑定的 routingKey 队列中去

在上面这张图中,我们可以看到X 绑定了两个队列,绑定类型是direct。队列Q1 绑定键为 orange, 队列 Q2 绑定键有两个:一个绑定键为 black,另一个绑定键为 green.

在这种绑定情况下,生产者发布消息到 exchange 上,绑定键为 orange 的消息会被发布到队列Q1。绑定键为 black,green 的消息会被发布到队列 Q2,其他消息类型的消息将被丢弃。

当它绑定的多个队列的 key 如果都相同,在这种情况下虽然绑定类型是 direct 但是它表现的就和 fanout 有点类似了,就跟广播差不多

演示

public class EmitLogDirect {

private static final String EXCHANGE_NAME = "direct_logs";

public static void main(String[] argv) throws Exception {

try (Channel channel = RabbitUtils.getChannel()) {

channel.exchangeDeclare(EXCHANGE_NAME, BuiltinExchangeType.DIRECT);

//创建多个 bindingKey

Map<String, String> bindingKeyMap = new HashMap<>();

bindingKeyMap.put("info", " 普 通 info 信 息 ");

bindingKeyMap.put("warning", " 警 告 warning 信 息 ");

bindingKeyMap.put("error", "错误 error 信息");

//debug 没有消费这接收这个消息 所有就丢失了

bindingKeyMap.put("debug", "调试 debug 信息");

for (Map.Entry<String, String> bindingKeyEntry : bindingKeyMap.entrySet()) {

String bindingKey = bindingKeyEntry.getKey();

String message = bindingKeyEntry.getValue();

channel.basicPublish(EXCHANGE_NAME, bindingKey, null, message.getBytes("UTF-8"));

System.out.println("生产者发出消息:" + message);

}

}

}

}

public class ReceiveLogsDirect01 {

private static final String EXCHANGE_NAME = "direct_logs";

public static void main(String[] argv) throws Exception {

Channel channel = RabbitUtils.getChannel();

channel.exchangeDeclare(EXCHANGE_NAME, BuiltinExchangeType.DIRECT);

String queueName = "disk";

channel.queueDeclare(queueName, false, false, false, null);

channel.queueBind(queueName, EXCHANGE_NAME, "error");

System.out.println("等待接收消息 ");

DeliverCallback deliverCallback = (consumerTag, delivery) ->

{

String message = new String(delivery.getBody(), "UTF-8");

message = "接收绑定键:" + delivery.getEnvelope().getRoutingKey() + ",消息:" + message;

File file = new File("C:\\work\\rabbitmq_info.txt");

FileUtils.writeStringToFile(file, message, "UTF-8");

System.out.println("错误日志已经接收");

};

channel.basicConsume(queueName, true, deliverCallback, consumerTag -> {

});

}

}

public class ReceiveLogsDirect02 {

private static final String EXCHANGE_NAME = "direct_logs";

public static void main(String[] argv) throws Exception {

Channel channel = RabbitUtils.getChannel();

channel.exchangeDeclare(EXCHANGE_NAME, BuiltinExchangeType.DIRECT);

String queueName = "console";

channel.queueDeclare(queueName, false, false, false, null);

channel.queueBind(queueName, EXCHANGE_NAME, "info");

channel.queueBind(queueName, EXCHANGE_NAME, "warning");

System.out.println("等待接收消息 ");

DeliverCallback deliverCallback = (consumerTag, delivery) ->

{

String message = new String(delivery.getBody(), "UTF-8");

System.out.println(" 接收绑定键 :" + delivery.getEnvelope().getRoutingKey() + ", 消息:" + message);

};

channel.basicConsume(queueName, true, deliverCallback, consumerTag -> {

});

}

}

提示

不管是消费者还是生产者都可以通过queueDeclare,exchangeDeclare来创建队列和交换机,同样的queueBind建立bindings也是通用的。所以这些步骤不管放在哪里都是可以的。但是如果选择在消费者创建队列,而先启动了生产者,就会导致消息丢失。

Topic exchange

概念

可以把 topic 交换机看作是routingKey具有特殊命名规则的direct 交换机

规则

routing_key 必须是一个单词列表,以点号分隔开

比如说:“stock.usd.nyse”, “nyse.vmw”,“quick.orange.rabbit”。但是这些单词列表最多不能超过 255 个字节。

它还拥有两个替换符

- ***(星号)**可以代替一个单词

- **#(井号)**可以替代零个或多个单词

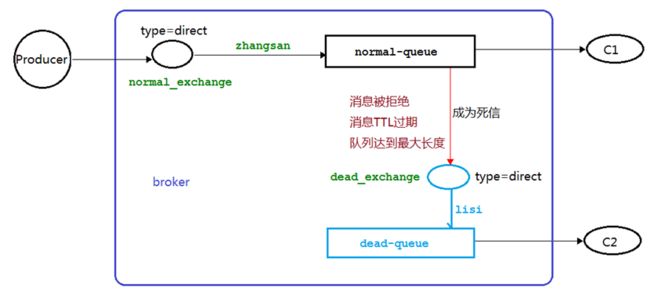

死信队列

概念

死信,顾名思义就是无法被消费的消息,字面意思可以这样理解,一般来说,producer 将消息投递到 broker 或者直接到queue 里了,consumer 从 queue 取出消息进行消费,但某些时候由于特定的原因导致 queue 中的某些消息无法被消费,这样的消息如果没有后续的处理,就变成了死信,有死信自然就有了死信队列。

应用场景:为了保证订单业务的消息数据不丢失,需要使用到 RabbitMQ 的死信队列机制,当消息消费发生异常时,将消息投入死信队列中.还有比如说: 用户在商城下单成功并点击去支付后在指定时间未支付时自动失效

死信的来源

消息 TTL 过期

队列达到最大长度(队列满了,无法再添加数据到 mq 中)

消息被拒绝(basic.reject 或 basic.nack)并且 requeue=false.

演示

消息TTL 过期

生产者

public class ProducerTTL {

private static final String NORMAL_EXCHANGE = "normal_exchange";

public static void main(String[] argv) throws Exception {

try (Channel channel = RabbitMqUtils.getChannel()) {

channel.exchangeDeclare(NORMAL_EXCHANGE, BuiltinExchangeType.DIRECT);

//设置消息的 TTL 时间

new AMQP.BasicProperties().builder().expiration("10000").build();

//该信息是用作演示队列个数限制

for (int i = 1; i < 11; i++) {

String message = "info" + i;

channel.basicPublish(NORMAL_EXCHANGE, "zhangsan", null, message.getBytes());

System.out.println("生产者发送消息:" + message);

}

}

}

}

消费者

public class ConsumerTTL01 {

//普通交换机名称

private static final String NORMAL_EXCHANGE = "normal_exchange";

//死信交换机名称

private static final String DEAD_EXCHANGE = "dead_exchange";

public static void main(String[] argv) throws Exception {

Channel channel = RabbitMqUtils.getChannel();

// 声 明 死 信 和 普 通 交 换 机 类 型 为 direct

channel.exchangeDeclare(NORMAL_EXCHANGE, BuiltinExchangeType.DIRECT);

channel.exchangeDeclare(DEAD_EXCHANGE, BuiltinExchangeType.DIRECT);

//声明死信队列

String deadQueue = "dead-queue";

channel.queueDeclare(deadQueue, false, false, false, null);

//死信队列绑定死信交换机与 routingkey

channel.queueBind(deadQueue, DEAD_EXCHANGE, "lisi");

//正常队列绑定死信队列信息

Map<String, Object> params = new HashMap<>();

//正常队列设置死信交换机 参数 key 是固定值

params.put("x-dead-letter-exchange", DEAD_EXCHANGE);

//正常队列设置死信 routing-key 参数 key 是固定值

params.put("x-dead-letter-routing-key", "lisi");

String normalQueue = "normal-queue";

channel.queueDeclare(normalQueue, false, false, false, params);

channel.queueBind(normalQueue, NORMAL_EXCHANGE, "zhangsan");

System.out.println("等待接收消息 ");

DeliverCallback deliverCallback = (consumerTag, delivery) ->

{

String message = new String(delivery.getBody(), "UTF-8");

System.out.println("Consumer01 接收到消息" + message);

};

channel.basicConsume(normalQueue, true, deliverCallback, consumerTag -> {

});

}

}

关键代码

//正常队列绑定死信队列信息

Map<String, Object> params = new HashMap<>();

//正常队列设置死信交换机 参数 key 是固定值

params.put("x-dead-letter-exchange", DEAD_EXCHANGE);

//正常队列设置死信 routing-key 参数 key 是固定值

params.put("x-dead-letter-routing-key", "lisi");

String normalQueue = "normal-queue";

channel.queueDeclare(normalQueue, false, false, false, params);

在创建队列时我们可以通过设置queueDeclare方法的第五个参数来建立正常队列与死信队列的连接

其实这一步放在哪里都可以,主要看先启动哪个

队列达到最大长度

生产者

去掉TTL属性,使其能够超长

public class ProducerTTL {

private static final String NORMAL_EXCHANGE = "normal_exchange";

public static void main(String[] argv) throws Exception {

try (Channel channel = RabbitMqUtils.getChannel()) {

channel.exchangeDeclare(NORMAL_EXCHANGE, BuiltinExchangeType.DIRECT);

//该信息是用作演示队列个数限制

for (int i = 1; i < 11; i++) {

String message = "info" + i;

channel.basicPublish(NORMAL_EXCHANGE, "zhangsan", null, message.getBytes());

System.out.println("生产者发送消息:" + message);

}

}

}

}

消费者

通过设置queueDeclare方法的第五个参数来设置队列长度限制

//正常队列绑定死信队列信息

Map<String, Object> params = new HashMap<>();

//正常队列设置死信交换机 参数 key 是固定值

params.put("x-dead-letter-exchange", DEAD_EXCHANGE);

//正常队列设置死信 routing-key 参数 key 是固定值

params.put("x-dead-letter-routing-key", "lisi");

//正常队列设置长度限制

params.put("x-max-length", 6);

String normalQueue = "normal-queue";

channel.queueDeclare(normalQueue, false, false, false, params);

消息被拒

生产者

和上面一样

消费者

public class ConsumerTTL01 {

//普通交换机名称

private static final String NORMAL_EXCHANGE = "normal_exchange";

//死信交换机名称

private static final String DEAD_EXCHANGE = "dead_exchange";

public static void main(String[] argv) throws Exception {

Channel channel = RabbitMqUtils.getChannel();

// 声 明 死 信 和 普 通 交 换 机 类 型 为 direct

channel.exchangeDeclare(NORMAL_EXCHANGE, BuiltinExchangeType.DIRECT);

channel.exchangeDeclare(DEAD_EXCHANGE, BuiltinExchangeType.DIRECT);

//声明死信队列

String deadQueue = "dead-queue";

channel.queueDeclare(deadQueue, false, false, false, null);

//死信队列绑定死信交换机与 routingkey

channel.queueBind(deadQueue, DEAD_EXCHANGE, "lisi");

//正常队列绑定死信队列信息

Map<String, Object> params = new HashMap<>();

//正常队列设置死信交换机 参数 key 是固定值

params.put("x-dead-letter-exchange", DEAD_EXCHANGE);

//正常队列设置死信 routing-key 参数 key 是固定值

params.put("x-dead-letter-routing-key", "lisi");

String normalQueue = "normal-queue";

channel.queueDeclare(normalQueue, false, false, false, params);

channel.queueBind(normalQueue, NORMAL_EXCHANGE, "zhangsan");

System.out.println("等待接收消息 ");

DeliverCallback deliverCallback = (consumerTag, delivery) ->

{

String message = new String(delivery.getBody(), "UTF-8");

if (message.equals("info5")) {

System.out.println("Consumer01 接收到消息" + message + "并拒绝签收该消息");

//requeue 设置为 false 代表拒绝重新入队 该队列如果配置了死信交换机将发送到死信队列中

channel.basicReject(delivery.getEnvelope().getDeliveryTag(), false);

} else {

System.out.println("Consumer01 接 收 到 消 息 " + message);

channel.basicAck(delivery.getEnvelope().getDeliveryTag(), false);

}

};

boolean autoAck = false;

channel.basicConsume(normalQueue, autoAck, deliverCallback, consumerTag -> {

});

}

}

关键代码

通过basicReject方法,拒收消息

延迟队列

概念

延时队列,队列内部是有序的,最重要的特性就体现在它的延时属性上,延时队列中的元素是希望在指定时间到了以后或之前取出和处理,简单来说,延时队列就是用来存放需要在指定时间被处理的元素的队列。

使用场景

- 订单在十分钟之内未支付则自动取消

- 新创建的店铺,如果在十天内都没有上传过商品,则自动发送消息提醒。

- 用户注册成功后,如果三天内没有登陆则进行短信提醒。

- 用户发起退款,如果三天内没有得到处理则通知相关运营人员。

- 预定会议后,需要在预定的时间点前十分钟通知各个与会人员参加会议

这些场景都有一个特点,需要在某个事件发生之后或者之前的指定时间点完成某一项任务,如: 发生订单生成事件,在十分钟之后检查该订单支付状态,然后将未支付的订单进行关闭;看起来似乎使用定时任务,一直轮询数据,每秒查一次,取出需要被处理的数据,然后处理不就完事了吗?如果数据量比较少,确实可以这样做,比如:对于“如果账单一周内未支付则进行自动结算”这样的需求, 如果对于时间不是严格限制,而是宽松意义上的一周,那么每天晚上跑个定时任务检查一下所有未支付的账单,确实也是一个可行的方案。但对于数据量比较大,并且时效性较强的场景,如:“订单十分钟内未支付则关闭“,短期内未支付的订单数据可能会有很多,活动期间甚至会达到百万甚至千万级别,对这么庞大的数据量仍旧使用轮询的方式显然是不可取的,很可能在一秒内无法完成所有订单的检查,同时会给数据库带来很大压力,无法满足业务要求而且性能低下。

设置TTL

TTL 是 RabbitMQ 中一个消息或者队列的属性,表明一条消息或者该队列中的所有消息的最大存活时间,单位是毫秒。

消息设置TTL

队列设置TTL

消息即使过期,也不一定会被马上丢弃,因为消息是否过期是在即将投递到消费者之前判定的,如果当前队列有严重的消息积压情况,则已过期的消息也许还能存活较长时间;另外,还需要注意的一点是,如果不设置 TTL,表示消息永远不会过期,如果将 TTL 设置为 0,则表示除非此时可以直接投递该消息到消费者,否则该消息将会被丢弃。

实现延迟队列

TTL 能让消息在延迟多久之后成为死信,另一方面, 成为死信的消息都会被投递到死信队列里,这样只需要消费者一直消费死信队列里的消息就完事了,因为里面的消息都是希望被立即处理的消息。

结合SpringBoot

引入依赖

<dependencies>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-amqpartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-testartifactId>

<scope>testscope>

dependency>

<dependency>

<groupId>com.alibabagroupId>

<artifactId>fastjsonartifactId>

<version>1.2.47version>

dependency>

<dependency>

<groupId>org.projectlombokgroupId>

<artifactId>lombokartifactId>

dependency>

<dependency>

<groupId>io.springfoxgroupId>

<artifactId>springfox-swagger2artifactId>

<version>2.9.2version>

dependency>

<dependency>

<groupId>io.springfoxgroupId>

<artifactId>springfox-swagger-uiartifactId>

<version>2.9.2version>

dependency>

<dependency>

<groupId>org.springframework.amqpgroupId>

<artifactId>spring-rabbit-testartifactId>

<scope>testscope>

dependency>

dependencies>

修改配置文件

spring:

rabbitmq:

host: 192.168.32.128

port: 5672

username: admin

password: 123

添加Swagger配置类

用于测试

@Configuration

@EnableSwagger2

public class SwaggerConfig {

@Bean

public Docket webApiConfig() {

return new Docket(DocumentationType.SWAGGER_2)

.groupName("webApi")

.apiInfo(webApiInfo())

.select()

.build();

}

private ApiInfo webApiInfo() {

return new ApiInfoBuilder()

.title("rabbitmq 接口文档")

.description("本文档描述了 rabbitmq 微服务接口定义")

.version("1.0")

.contact(new Contact("enjoy6288", "http://atguigu.com", "[email protected]"))

.build();

}

}

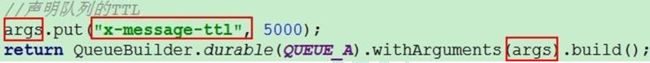

代码架构

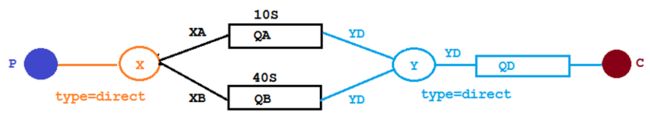

创建两个队列 QA 和 QB,两者队列 TTL 分别设置为 10S 和 40S,然后在创建一个交换机 X 和死信交换机 Y,它们的类型都是direct,创建一个死信队列 QD,它们的绑定关系如下:

添加配置类

@Configuration

public class TtlQueueConfig {

public static final String X_EXCHANGE = "X";

public static final String QUEUE_A = "QA";

public static final String QUEUE_B = "QB";

public static final String Y_DEAD_LETTER_EXCHANGE = "Y";

public static final String DEAD_LETTER_QUEUE = "QD";

// 声明 xExchange

@Bean("xExchange")

public DirectExchange xExchange() {

return new DirectExchange(X_EXCHANGE);

}

// 声明 xExchange

@Bean("yExchange")

public DirectExchange yExchange() {

return new DirectExchange(Y_DEAD_LETTER_EXCHANGE);

}

//声明队列 A ttl 为 10s 并绑定到对应的死信交换机

@Bean("queueA")

public Queue queueA() {

Map<String, Object> args = new HashMap<>(3);

//声明当前队列绑定的死信交换机

args.put("x-dead-letter-exchange", Y_DEAD_LETTER_EXCHANGE);

//声明当前队列的死信路由 key

args.put("x-dead-letter-routing-key", "YD");

//声明队列的 TTL

args.put("x-message-ttl", 10000);

return QueueBuilder.durable(QUEUE_A).withArguments(args).build();

}

// 声明队列 A 绑定 X 交换机

@Bean

public Binding queueaBindingX(@Qualifier("queueA") Queue queueA,

@Qualifier("xExchange") DirectExchange xExchange) {

return BindingBuilder.bind(queueA).to(xExchange).with("XA");

}

//声明队列 B ttl 为 40s 并绑定到对应的死信交换机

@Bean("queueB")

public Queue queueB() {

Map<String, Object> args = new HashMap<>(3);

//声明当前队列绑定的死信交换机

args.put("x-dead-letter-exchange", Y_DEAD_LETTER_EXCHANGE);

//声明当前队列的死信路由 key

args.put("x-dead-letter-routing-key", "YD");

//声明队列的 TTL

args.put("x-message-ttl", 40000);

return QueueBuilder.durable(QUEUE_B).withArguments(args).build();

}

//声明队列 B 绑定 X 交换机

@Bean

public Binding queuebBindingX(@Qualifier("queueB") Queue queue1B,

@Qualifier("xExchange") DirectExchange xExchange) {

return BindingBuilder.bind(queue1B).to(xExchange).with("XB");

}

//声明死信队列 QD

@Bean("queueD")

public Queue queueD() {

return new Queue(DEAD_LETTER_QUEUE);

}

//声明死信队列 QD 绑定关系

@Bean

public Binding deadLetterBindingQAD(@Qualifier("queueD") Queue queueD,

@Qualifier("yExchange") DirectExchange yExchange) {

return BindingBuilder.bind(queueD).to(yExchange).with("YD");

}

}

消息生产者

@Slf4j

@RequestMapping("ttl")

@RestController

public class SendMsgController {

@Autowired

private RabbitTemplate rabbitTemplate;

@GetMapping("sendMsg/{message}")

public void sendMsg(@PathVariable String message) {

log.info("当前时间:{},发送一条信息给两个 TTL 队列:{}", new Date(), message);

rabbitTemplate.convertAndSend("X", "XA", "消息来自 ttl 为 10S 的队列: " + message);

rabbitTemplate.convertAndSend("X", "XB", "消息来自 ttl 为 40S 的队列: " + message);

}

}

消息消费者

@Slf4j

@Component

public class DeadLetterQueueConsumer {

@RabbitListener(queues = "QD")

public void receiveD(Message message, Channel channel) throws IOException {

String msg = new String(message.getBody());

log.info("当前时间:{},收到死信队列信息{}", new Date().toString(), msg);

}

}

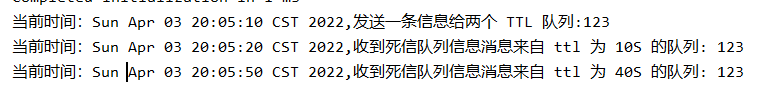

启动

启动项目

消费者接收到消息

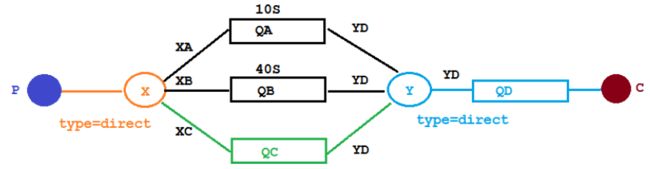

延时队列优化

实现在发送消息的同时,设置它的TTL

代码架构

在这里新增了一个队列 QC,绑定关系如下,该队列不设置TTL 时间

添加配置类

@Component

public class MsgTtlQueueConfig {

public static final String Y_DEAD_LETTER_EXCHANGE = "Y";

public static final String QUEUE_C = "QC";

//声明队列 C 死信交换机

@Bean("queueC")

public Queue queueB() {

Map<String, Object> args = new HashMap<>(3);

//声明当前队列绑定的死信交换机

args.put("x-dead-letter-exchange", Y_DEAD_LETTER_EXCHANGE);

//声明当前队列的死信路由 key

args.put("x-dead-letter-routing-key", "YD");

//没有声明 TTL 属性

return QueueBuilder.durable(QUEUE_C).withArguments(args).build();

}

//声明队列 B 绑定 X 交换机

@Bean

public Binding queuecBindingX(@Qualifier("queueC") Queue queueC,

@Qualifier("xExchange") DirectExchange xExchange) {

return BindingBuilder.bind(queueC).to(xExchange).with("XC");

}

}

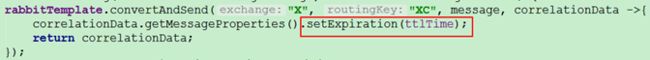

生产者

@GetMapping("sendExpirationMsg/{message}/{ttlTime}")

public void sendMsg(@PathVariable String message, @PathVariable String ttlTime) {

rabbitTemplate.convertAndSend("X", "XC", message, correlationData -> {correlationData.getMessageProperties().setExpiration(ttlTime);

return correlationData;

});

log.info("当前时间:{},发送一条时长{}毫秒 TTL 信息给队列 C:{}", new Date(), ttlTime, message);

}

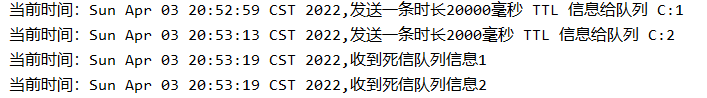

启动

利用idea发起两个个请求,得到响应

缺点

如果使用在消息属性上设置 TTL 的方式,消 息可能并不会按时“死亡“,因为 RabbitMQ 只会检查第一个消息是否过期,如果过期则丢到死信队列, 如果第一个消息的延时时长很长,而第二个消息的延时时长很短,第二个消息并不会优先得到执行。

Rabbitmq 插件实现延迟队列

安装延时队列插件

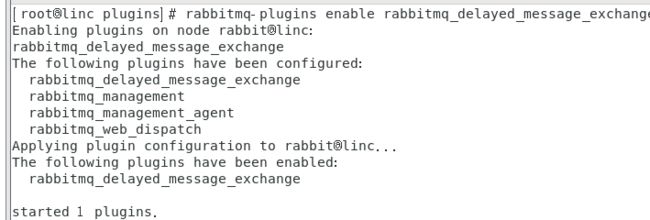

在官网上下载 https://www.rabbitmq.com/community-plugins.html,下载 rabbitmq_delayed_message_exchange 插件,然后解压放置到 RabbitMQ 的插件目录。

进入 RabbitMQ 的安装目录下的 plgins 目录,执行下面命令让该插件生效,然后重启 RabbitMQ

/usr/lib/rabbitmq/lib/rabbitmq_server-3.8.8/plugins rabbitmq-plugins enable rabbitmq_delayed_message_exchange

交换机拥有了一个新的类型x-delayed-message

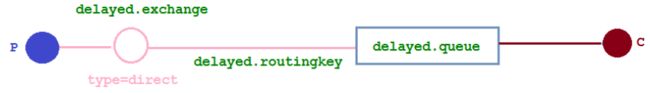

代码架构

新增了一个队列delayed.queue,一个自定义交换机 delayed.exchange,绑定关系如下:

添加配置类

在我们自定义的交换机中,这是一种新的交换类型,该类型消息支持延迟投递机制 消息传递后并 不会立即投递到目标队列中,而是存储在 mnesia(一个分布式数据系统)表中,当达到投递时间时,才 投递到目标队列中。

@Configuration

public class DelayedQueueConfig {

public static final String DELAYED_QUEUE_NAME = "delayed.queue";

public static final String DELAYED_EXCHANGE_NAME = "delayed.exchange";

public static final String DELAYED_ROUTING_KEY = "delayed.routingkey";

@Bean

public Queue delayedQueue() {

return new Queue(DELAYED_QUEUE_NAME);

}

//自定义交换机 我们在这里定义的是一个延迟交换机

@Bean

public CustomExchange delayedExchange() {

Map<String, Object> args = new HashMap<>();

//自定义交换机的类型

args.put("x-delayed-type", "direct");

return new CustomExchange(DELAYED_EXCHANGE_NAME, "x-delayed-message", true, false, args);

}

@Bean

public Binding bindingDelayedQueue(@Qualifier("delayedQueue") Queue queue,

@Qualifier("delayedExchange") CustomExchange delayedExchange) {

return BindingBuilder.bind(queue).to(delayedExchange).with(DELAYED_ROUTING_KEY).noargs();

}

}

生产者

public static final String DELAYED_EXCHANGE_NAME = "delayed.exchange";

public static final String DELAYED_ROUTING_KEY = "delayed.routingkey";

@GetMapping("sendDelayMsg/{message}/{delayTime}")

public void sendMsg(@PathVariable String message, @PathVariable Integer delayTime) {

rabbitTemplate.convertAndSend(DELAYED_EXCHANGE_NAME, DELAYED_ROUTING_KEY, message,

correlationData -> {

correlationData.getMessageProperties().setDelay(delayTime);

return correlationData;

});

log.info(" 当 前 时 间 : {}, 发 送 一 条 延 迟 {} 毫秒的信息给队列 delayed.queue:{}", new Date(), delayTime, message);

}

消费者

public static final String DELAYED_QUEUE_NAME = "delayed.queue";

@RabbitListener(queues = DELAYED_QUEUE_NAME)

public void receiveDelayedQueue(Message message) {

String msg = new String(message.getBody());

log.info("当前时间:{},收到延时队列的消息:{}", new Date().toString(), msg);

}

启动

发起请求,并接收到

第二个消息被先消费掉了,符合预期

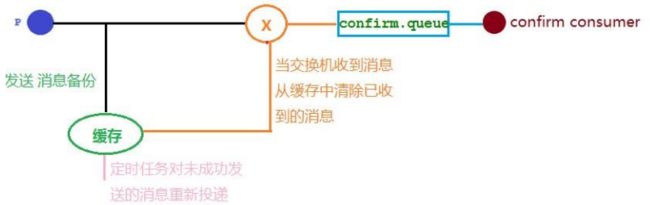

发布确认高级

在生产环境中由于一些不明原因,导致 rabbitmq 重启,在 RabbitMQ 重启期间生产者消息投递失败, 导致消息丢失,需要手动处理和恢复。于是,我们开始思考,如何才能进行 RabbitMQ 的消息可靠投递呢? 特 别是在这样比较极端的情况,RabbitMQ 集群不可用的时候,无法投递的消息该如何处理呢

发布确认 springboot 版本

确认机制

代码架构

增加配置

在配置文件当中需要添加

参数

NONE 禁用发布确认模式,是默认值

CORRELATED 发布消息成功到交换器后会触发回调方法

SIMPLE 有两种效果,其一效果和 CORRELATED 值一样会触发回调方法, 其二在发布消息成功后使用 rabbitTemplate 调用 waitForConfirms 或 waitForConfirmsOrDie 方法 等待 broker 节点返回发送结果,根据返回结果来判定下一步的逻辑,要注意的点是 waitForConfirmsOrDie 方法如果返回 false 则会关闭 channel,则接下来无法发送消息到 broker

添加配置类

@Configuration

public class ConfirmConfig {

public static final String CONFIRM_EXCHANGE_NAME = "confirm.exchange";

public static final String CONFIRM_QUEUE_NAME = "confirm.queue";

//声明业务 Exchange

@Bean("confirmExchange")

public DirectExchange confirmExchange() {

return new DirectExchange(CONFIRM_EXCHANGE_NAME);

}

// 声明确认队列

@Bean("confirmQueue")

public Queue confirmQueue() {

return QueueBuilder.durable(CONFIRM_QUEUE_NAME).build();

}

// 声明确认队列绑定关系

@Bean

public Binding queueBinding(@Qualifier("confirmQueue") Queue queue,

@Qualifier("confirmExchange") DirectExchange exchange) {

return BindingBuilder.bind(queue).to(exchange).with("key1");

}

}

消息生产者

@RestController

@RequestMapping("/confirm")

@Slf4j

public class Producer {

public static final String CONFIRM_EXCHANGE_NAME = "confirm.exchange";

@Autowired

private RabbitTemplate rabbitTemplate;

@Autowired

private MyCallBack myCallBack;

//依赖注入 rabbitTemplate 之后再设置它的回调对象

@PostConstruct

public void init() {

rabbitTemplate.setConfirmCallback(myCallBack);

}

@GetMapping("sendMessage/{message}")

public void sendMessage(@PathVariable String message) {

//指定消息 id 为 1

CorrelationData correlationData1 = new CorrelationData("1");

String routingKey = "key1";

rabbitTemplate.convertAndSend(CONFIRM_EXCHANGE_NAME, routingKey, message + routingKey, correlationData1);

CorrelationData correlationData2 = new CorrelationData("2");

routingKey = "key2";

rabbitTemplate.convertAndSend(CONFIRM_EXCHANGE_NAME, routingKey, message + routingKey, correlationData2);

log.info("发送消息内容:{}", message);

}

}

回调接口

@Component

@Slf4j

public class MyCallBack implements RabbitTemplate.ConfirmCallback {

/**

* 交换机不管是否收到消息的一个回调方法

* CorrelationData

* 消息相关数据

* ack

* 交换机是否收到消息

*/

@Override

public void confirm(CorrelationData correlationData, boolean ack, String cause) {

String id = correlationData != null ? correlationData.getId() : "";

if (ack) {

log.info("交换机已经收到 id 为:{}的消息", id);

} else {

log.info("交换机还未收到 id 为:{}消息,由于原因:{}", id, cause);

}

}

}

消费者

@Component

@Slf4j

public class ConfirmConsumer {

public static final String CONFIRM_QUEUE_NAME = "confirm.queue";

@RabbitListener(queues = CONFIRM_QUEUE_NAME)

public void receiveMsg(Message message) {

String msg = new String(message.getBody());

log.info("接受到队列 confirm.queue 消息:{}", msg);

}

}

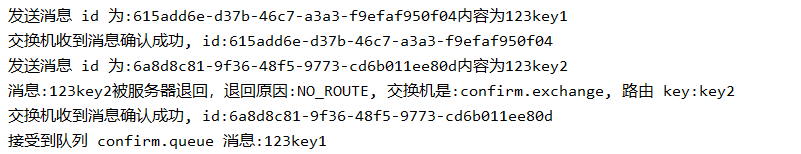

启动

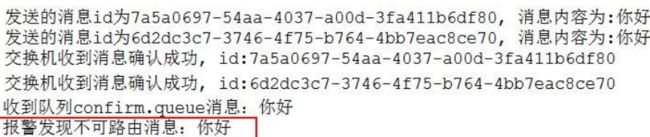

可以看到,发送了两条消息,第一条消息的 RoutingKey 为 “key1”,第二条消息的 RoutingKey 为 “key2”,两条消息都成功被交换机接收,也收到了交换机的确认回调,但消费者只收到了一条消息,因为 第二条消息的 RoutingKey 与队列的 BindingKey 不一致,也没有其它队列能接收这个消息,所有第二条 消息被直接丢弃了。

回退消息

在仅开启了生产者确认机制的情况下,交换机接收到消息后,会直接给消息生产者发送确认消息,如 果发现该消息不可路由,那么消息会被直接丢弃,此时生产者是不知道消息被丢弃这个事件的。

那么如何 让无法被路由的消息返回呢?通过设置 mandatory 参数可以在当消息传递过程中不可达目的地时将消息返回给生产者。

生产者

@Slf4j

@Component

public class MessageProducer implements RabbitTemplate.ConfirmCallback, RabbitTemplate.ReturnCallback {

@Autowired

private RabbitTemplate rabbitTemplate;

//rabbitTemplate 注入之后就设置该值

@PostConstruct

private void init() {

rabbitTemplate.setConfirmCallback(this);

/**

* true:

* 交换机无法将消息进行路由时,会将该消息返回给生产者

* false:

* 如果发现消息无法进行路由,则直接丢弃 */

rabbitTemplate.setMandatory(true);

//设置回退消息交给谁处理

rabbitTemplate.setReturnCallback(this);

}

@GetMapping("sendMessage")

public void sendMessage(String message) {

//让消息绑定一个 id 值

CorrelationData correlationData1 = new CorrelationData(UUID.randomUUID().toString());

rabbitTemplate.convertAndSend("confirm.exchange", "key1", message + "key1", correlationData1)

;

log.info("发送消息 id 为:{}内容为{}", correlationData1.getId(), message + "key1");

CorrelationData correlationData2 = new CorrelationData(UUID.randomUUID().toString());

rabbitTemplate.convertAndSend("confirm.exchange", "key2", message + "key2", correlationData2)

;

log.info("发送消息 id 为:{}内容为{}", correlationData2.getId(), message + "key2");

}

@Override

public void confirm(CorrelationData correlationData, boolean ack, String cause) {

String id = correlationData != null ? correlationData.getId() : "";

if (ack) {

log.info("交换机收到消息确认成功, id:{}", id);

} else {

log.error("消息 id:{}未成功投递到交换机,原因是:{}", id, cause);

}

}

@Override

public void returnedMessage(Message message, int replyCode, String replyText, String

exchange, String routingKey) {

log.info("消息:{}被服务器退回,退回原因:{}, 交换机是:{}, 路由 key:{}",

new String(message.getBody()), replyText, exchange, routingKey);

}

}

回调接口

@Component

@Slf4j

public class MyCallBack implements RabbitTemplate.ConfirmCallback, RabbitTemplate.ReturnCallback {

/**

* 交换机不管是否收到消息的一个回调方法

* CorrelationData

* 消息相关数据

* ack

* 交换机是否收到消息

*/

@Override

public void confirm(CorrelationData correlationData, boolean ack, String cause) {

String id = correlationData != null ? correlationData.getId() : "";

if (ack) {

log.info("交换机已经收到 id 为:{}的消息", id);

} else {

log.info("交换机还未收到 id 为:{}消息,由于原因:{}", id, cause);

}

}

//当消息无法路由的时候的回调方法

@Override

public void returnedMessage(Message message, int replyCode, String replyText, String

exchange, String routingKey) {

log.error(" 消 息 {}, 被 交 换 机 {} 退 回 , 退 回 原 因 :{}, 路 由 key:{}", new

String(message.getBody()), exchange, replyText, routingKey);

}

}

启动

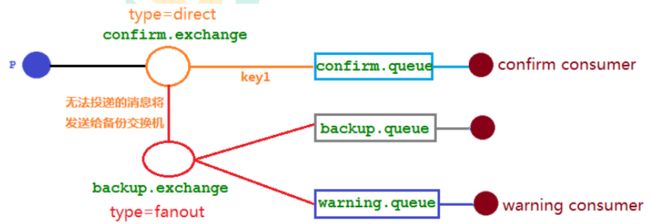

备份交换机

有了 mandatory 参数和回退消息,我们获得了对无法投递消息的感知能力,有机会在生产者的消息 无法被投递时发现并处理。但有时候,我们并不知道该如何处理这些无法路由的消息,最多打个日志,然 后触发报警,再来手动处理。而通过日志来处理这些无法路由的消息是很不优雅的做法,特别是当生产者 所在的服务有多台机器的时候,手动复制日志会更加麻烦而且容易出错。而且设置 mandatory 参数会增 加生产者的复杂性,需要添加处理这些被退回的消息的逻辑。如果既不想丢失消息,又不想增加生产者的 复杂性,该怎么做呢?前面在设置死信队列的文章中,我们提到,可以为队列设置死信交换机来存储那些 处理失败的消息,可是这些不可路由消息根本没有机会进入到队列,因此无法使用死信队列来保存消息。 在 RabbitMQ 中,有一种备份交换机的机制存在,可以很好的应对这个问题。什么是备份交换机呢?备份交换机可以理解为 RabbitMQ 中交换机的“备胎”,当我们为某一个交换机声明一个对应的备份交换机时,就 是为它创建一个备胎,当交换机接收到一条不可路由消息时,将会把这条消息转发到备份交换机中,由备 份交换机来进行转发和处理,通常备份交换机的类型为 Fanout ,这样就能把所有消息都投递到与其绑定 的队列中,然后我们在备份交换机下绑定一个队列,这样所有那些原交换机无法被路由的消息,就会都进 入这个队列了。当然,我们还可以建立一个报警队列,用独立的消费者来进行监测和报警。

代码架构

修改配置类

@Configuration

public class ConfirmConfig {

public static final String CONFIRM_EXCHANGE_NAME = "confirm.exchange";

public static final String CONFIRM_QUEUE_NAME = "confirm.queue";

public static final String BACKUP_EXCHANGE_NAME = "backup.exchange";

public static final String BACKUP_QUEUE_NAME = "backup.queue";

public static final String WARNING_QUEUE_NAME = "warning.queue";

// 声明确认队列

@Bean("confirmQueue")

public Queue confirmQueue(){

return QueueBuilder.durable(CONFIRM_QUEUE_NAME).build();

}

//声明确认队列绑定关系

@Bean

public Binding queueBinding(@Qualifier("confirmQueue") Queue queue,

@Qualifier("confirmExchange") DirectExchange exchange){

return BindingBuilder.bind(queue).to(exchange).with("key1");

}

//声明备份 Exchange

@Bean("backupExchange")

public FanoutExchange backupExchange(){

return new FanoutExchange(BACKUP_EXCHANGE_NAME);

}

//声明确认 Exchange 交换机的备份交换机

@Bean("confirmExchange")

public DirectExchange

confirmExchange(){ExchangeBuilder

exchangeBuilder =

ExchangeBuilder.directExchange(CONFIRM_EXCHANGE_NAME)

.durable(true)

//设置该交换机的备份交换机

.withArgument("alternate-exchange", BACKUP_EXCHANGE_NAME);

return (DirectExchange)exchangeBuilder.build();

}

// 声明警告队列

@Bean("warningQueue")

public Queue warningQueue(){

return QueueBuilder.durable(WARNING_QUEUE_NAME).build();

}

// 声明报警队列绑定关系

@Bean

public Binding warningBinding(@Qualifier("warningQueue") Queue queue,

@Qualifier("backupExchange") FanoutExchange

backupExchange){

return BindingBuilder.bind(queue).to(backupExchange);

}

// 声明备份队列

@Bean("backQueue")

public Queue backQueue(){

return QueueBuilder.durable(BACKUP_QUEUE_NAME).build();

}

// 声明备份队列绑定关系

@Bean

public Binding backupBinding(@Qualifier("backQueue") Queue queue,

@Qualifier("backupExchange") FanoutExchange backupExchange){

return BindingBuilder.bind(queue).to(backupExchange);

}

}

报警消费者

@Component

@Slf4j

public class WarningConsumer {

public static final String WARNING_QUEUE_NAME = "warning.queue";

@RabbitListener(queues = WARNING_QUEUE_NAME)

public void receiveWarningMsg(Message message) {

String msg = new String(message.getBody());

log.error("报警发现不可路由消息:{}", msg);

}

}

结果

mandatory 参数与备份交换机可以一起使用的时候,如果两者同时开启,消息究竟何去何从?谁优先 级高,经过上面结果显示答案是备份交换机优先级高。

RabbitMQ 其他知识点

幂等性

概念

用户对于同一操作发起的一次请求或者多次请求的结果是一致的,不会因为多次点击而产生了副作用。 举个最简单的例子,那就是支付,用户购买商品后支付,支付扣款成功,但是返回结果的时候网络异常, 此时钱已经扣了,用户再次点击按钮,此时会进行第二次扣款,返回结果成功,用户查询余额发现多扣钱 了,流水记录也变成了两条。在以前的单应用系统中,我们只需要把数据操作放入事务中即可,发生错误 立即回滚,但是再响应客户端的时候也有可能出现网络中断或者异常等等

消息重复消费

消费者在消费 MQ 中的消息时,MQ 已把消息发送给消费者,消费者在给MQ 返回 ack 时网络中断, 故 MQ 未收到确认信息,该条消息会重新发给其他的消费者,或者在网络重连后再次发送给该消费者,但 实际上该消费者已成功消费了该条消息,造成消费者消费了重复的消息。

解决思路

MQ 消费者的幂等性的解决一般使用全局 ID 或者写个唯一标识比如时间戳 或者 UUID 或者订单消费 者消费 MQ 中的消息也可利用 MQ 的该 id 来判断,或者可按自己的规则生成一个全局唯一 id,每次消费消 息时用该 id 先判断该消息是否已消费过。

消费端的幂等性保障

在海量订单生成的业务高峰期,生产端有可能就会重复发生了消息,这时候消费端就要实现幂等性, 这就意味着我们的消息永远不会被消费多次,即使我们收到了一样的消息。业界主流的幂等性有两种操作:a. 唯一 ID+指纹码机制,利用数据库主键去重, b.利用 redis 的原子性去实现

唯一ID+指纹码机制

指纹码:我们的一些规则或者时间戳加别的服务给到的唯一信息码,它并不一定是我们系统生成的,基 本都是由我们的业务规则拼接而来,但是一定要保证唯一性,然后就利用查询语句进行判断这个 id 是否存 在数据库中,优势就是实现简单就一个拼接,然后查询判断是否重复;劣势就是在高并发时,如果是单个数 据库就会有写入性能瓶颈当然也可以采用分库分表提升性能,但也不是我们最推荐的方式。

Redis 原子性

利用 redis 执行 setnx 命令,天然具有幂等性。从而实现不重复消费

优先级队列

使用场景

在我们系统中有一个订单催付的场景,我们的客户在天猫下的订单,淘宝会及时将订单推送给我们,如 果在用户设定的时间内未付款那么就会给用户推送一条短信提醒,很简单的一个功能对吧,但是,tmall 商家对我们来说,肯定是要分大客户和小客户的对吧,比如像苹果,小米这样大商家一年起码能给我们创 造很大的利润,所以理应当然,他们的订单必须得到优先处理,而曾经我们的后端系统是使用 redis 来存 放的定时轮询,大家都知道 redis 只能用 List 做一个简简单单的消息队列,并不能实现一个优先级的场景, 所以订单量大了后采用 RabbitMQ 进行改造和优化,如果发现是大客户的订单给一个相对比较高的优先级, 否则就是默认优先级。

如何添加

队列中代码添加优先级

Map<String, Object> params = new HashMap();

params.put("x-max-priority", 10);

channel.queueDeclare("hello", true, false, false, params);

消息中代码添加优先级

AMQP.BasicProperties properties = new

AMQP.BasicProperties().builder().priority(5).build();

要让队列实现优先级需要做的事情有如下事情:队列需要设置为优先级队列,消息需要设置消息的优先 级,消费者需要等待消息已经发送到队列中才去消费因为,这样才有机会对消息进行排序

惰性队列

使用场景

RabbitMQ 从 3.6.0 版本开始引入了惰性队列的概念。惰性队列会尽可能的将消息存入磁盘中,而在消 费者消费到相应的消息时才会被加载到内存中,它的一个重要的设计目标是能够支持更长的队列,即支持 更多的消息存储。当消费者由于各种各样的原因(比如消费者下线、宕机亦或者是由于维护而关闭等)而致 使长时间内不能消费消息造成堆积时,惰性队列就很有必要了。

默认情况下,当生产者将消息发送到 RabbitMQ 的时候,队列中的消息会尽可能的存储在内存之中, 这样可以更加快速的将消息发送给消费者。即使是持久化的消息,在被写入磁盘的同时也会在内存中驻留 一份备份。当 RabbitMQ 需要释放内存的时候,会将内存中的消息换页至磁盘中,这个操作会耗费较长的 时间,也会阻塞队列的操作,进而无法接收新的消息。虽然 RabbitMQ 的开发者们一直在升级相关的算法, 但是效果始终不太理想,尤其是在消息量特别大的时候。

两种模式

队列具备两种模式:default 和 lazy。默认的为default 模式,在3.6.0 之前的版本无需做任何变更。lazy 模式即为惰性队列的模式,可以通过调用 channel.queueDeclare 方法的时候在参数中设置,也可以通过 Policy 的方式设置,如果一个队列同时使用这两种方式设置的话,那么 Policy 的方式具备更高的优先级。 如果要通过声明的方式改变已有队列的模式的话,那么只能先删除队列,然后再重新声明一个新的。

在队列声明的时候可以通过“x-queue-mode”参数来设置队列的模式,取值为“default”和“lazy”。

Map<String, Object> args = new HashMap<String, Object>();

args.put("x-queue-mode", "lazy");

channel.queueDeclare("myqueue", false, false, false, args);

RabbitMQ 集群

clustering

使用集群的原因

最开始我们介绍了如何安装及运行 RabbitMQ 服务,不过这些是单机版的,无法满足目前真实应用的 要求。如果 RabbitMQ 服务器遇到内存崩溃、机器掉电或者主板故障等情况,该怎么办?单台 RabbitMQ 服务器可以满足每秒 1000 条消息的吞吐量,那么如果应用需要 RabbitMQ 服务满足每秒 10 万条消息的吞吐量呢?购买昂贵的服务器来增强单机 RabbitMQ 务的性能显得捉襟见肘,搭建一个 RabbitMQ 集群才是 解决实际问题的关键

搭建步骤

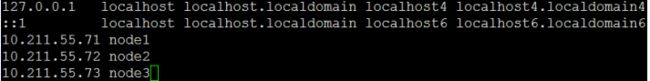

1.修改 3 台机器的主机名称

vim /etc/hostname

2.配置各个节点的 hosts 文件,让各个节点都能互相识别对方

vim /etc/hosts

10.211.55.74 node1

10.211.55.75 node2

10.211.55.76 node3

3.以确保各个节点的 cookie 文件使用的是同一个值

在 node1 上执行远程操作命令

scp /var/lib/rabbitmq/.erlang.cookie root@node2:/var/lib/rabbitmq/.erlang.cookie

scp /var/lib/rabbitmq/.erlang.cookie root@node3:/var/lib/rabbitmq/.erlang.cookie

4.启动 RabbitMQ 服务,顺带启动 Erlang 虚拟机和 RbbitMQ 应用服务(在三台节点上分别执行以 下命令)

rabbitmq-server -detached

5.在节点 2 执行

rabbitmqctl stop_app (rabbitmqctl stop 会将Erlang 虚拟机关闭,rabbitmqctl stop_app 只关闭 RabbitMQ 服务)

rabbitmqctl reset

rabbitmqctl join_cluster rabbit@node1

rabbitmqctl start_app(只启动应用服务)

6.在节点 3 执行

rabbitmqctl stop_app

rabbitmqctl reset

rabbitmqctl join_cluster

rabbit@node2 rabbitmqctl start_app

7.集群状态

rabbitmqctl cluster_status

8.需要重新设置用户

创建账号

rabbitmqctl add_user admin 123

设置用户角色

rabbitmqctl set_user_tags admin administrator

设置用户权限

rabbitmqctl set_permissions -p “/” admin “." ".” “.*”

9.解除集群节点(node2 和 node3 机器分别执行)

rabbitmqctl stop_app

rabbitmqctl reset

rabbitmqctl start_app

rabbitmqctl cluster_status

rabbitmqctl forget_cluster_node rabbit@node2(node1 机器上执行)

镜像队列

如果 RabbitMQ 集群中只有一个 Broker 节点,那么该节点的失效将导致整体服务的临时性不可用,并 且也可能会导致消息的丢失。可以将所有消息都设置为持久化,并且对应队列的durable属性也设置为true,但 是这样仍然无法避免由于缓存导致的问题:因为消息在发送之后和被写入磁盘井执行刷盘动作之间存在一 个短暂却会产生问题的时间窗。通过 publisherconfirm 机制能够确保客户端知道哪些消息己经存入磁盘,尽 管如此,一般不希望遇到因单点故障导致的服务不可用。

引入镜像队列(Mirror Queue)的机制,可以将队列镜像到集群中的其他 Broker 节点之上,如果集群中 的一个节点失效了,队列能自动地切换到镜像中的另一个节点上以保证服务的可用性。

步骤

1.启动三台集群节点

2.随便找一个节点添加 policy

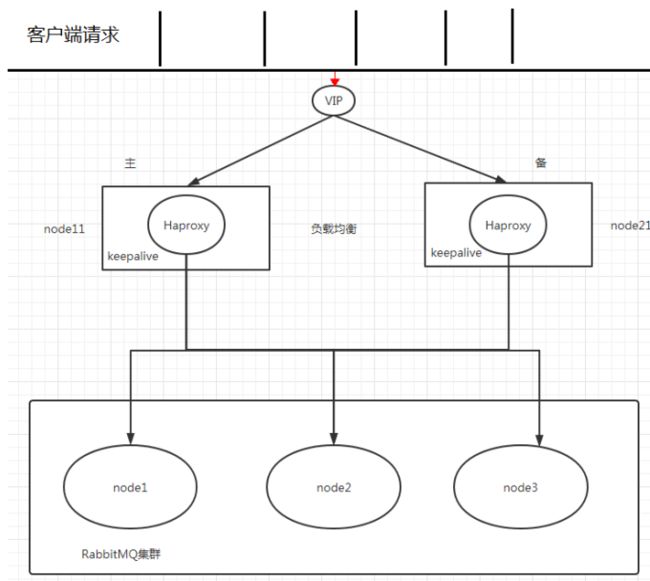

Haproxy+Keepalive 实现高可用负载均衡

整体架构图

Haproxy 实现负载均衡

HAProxy 提供高可用性、负载均衡及基于TCPHTTP 应用的代理,支持虚拟主机,它是免费、快速并 且可靠的一种解决方案,包括 Twitter,Reddit,StackOverflow,GitHub 在内的多家知名互联网公司在使用。 HAProxy 实现了一种事件驱动、单一进程模型,此模型支持非常大的井发连接数。

搭建步骤

1.下载 haproxy(在 node1 和 node2)

yum -y install haproxy

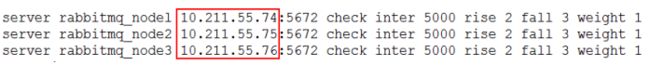

2.修改 node1 和 node2 的 haproxy.cfg

vim /etc/haproxy/haproxy.cfg

需要修改红色 IP 为当前机器 IP

3.在两台节点启动

haproxy haproxy -f /etc/haproxy/haproxy.cfg

ps -ef | grep haproxy

4.访问地址

http://10.211.55.71:8888/stats

Keepalived 实现双机(主备)热备

试想如果前面配置的 HAProxy 主机突然宕机或者网卡失效,那么虽然 RbbitMQ 集群没有任何故障但是 对于外界的客户端来说所有的连接都会被断开结果将是灾难性的为了确保负载均衡服务的可靠性同样显得 十分重要,这里就要引入 Keepalived 它能够通过自身健康检查、资源接管功能做高可用(双机热备),实现 故障转移

搭建步骤

1.下载 keepalived

yum -y install keepalived

2.节点 node1 配置文件

vim /etc/keepalived/keepalived.conf

把资料里面的 keepalived.conf 修改之后替换

3.节点 node2 配置文件

需要修改global_defs 的 router_id,如:nodeB

其次要修改 vrrp_instance_VI 中 state 为"BACKUP";

最后要将priority 设置为小于 100 的值

4.添加 haproxy_chk.sh

(为了防止 HAProxy 服务挂掉之后 Keepalived 还在正常工作而没有切换到 Backup 上,所以这里需要编写一个脚本来检测 HAProxy 务的状态,当 HAProxy 服务挂掉之后该脚本会自动重启 HAProxy 的服务,如果不成功则关闭 Keepalived 服务,这样便可以切换到 Backup 继续工作)

vim /etc/keepalived/haproxy_chk.sh(可以直接上传文件)

修改权限 chmod 777 /etc/keepalived/haproxy_chk.sh

5.启动 keepalive 命令(node1 和 node2 启动)

systemctl start keepalived

6.观察 Keepalived 的日志

tail -f /var/log/messages -n 200

7.观察最新添加的 vip

ip add show

8.node1 模拟 keepalived 关闭状态

systemctl stop keepalived

9.使用 vip 地址来访问 rabbitmq 集群

Federation Exchange

使用原因

(broker 北京),(broker 深圳)彼此之间相距甚远,网络延迟是一个不得不面对的问题。有一个在北京 的业务(Client 北京) 需要连接(broker 北京),向其中的交换器 exchangeA 发送消息,此时的网络延迟很小, (Client 北京)可以迅速将消息发送至 exchangeA 中,就算在开启了 publisherconfirm 机制或者事务机制的情 况下,也可以迅速收到确认信息。此时又有个在深圳的业务(Client 深圳)需要向 exchangeA 发送消息, 那 么(Client 深圳) (broker 北京)之间有很大的网络延迟,(Client 深圳) 将发送消息至 exchangeA 会经历一定 的延迟,尤其是在开启了 publisherconfirm 机制或者事务机制的情况下,(Client 深圳) 会等待很长的延迟 时间来接收(broker 北京)的确认信息,进而必然造成这条发送线程的性能降低,甚至造成一定程度上的阻 塞。

将业务(Client 深圳)部署到北京的机房可以解决这个问题,但是如果(Client 深圳)调用的另些服务都部 署在深圳,那么又会引发新的时延问题,总不见得将所有业务全部部署在一个机房,那么容灾又何以实现? 这里 使用 Federation 插件就可以很好地解决这个问题.

搭建步骤

1.需要保证每台节点单独运行

2.在每台机器上开启 federation 相关插件 rabbitmq-plugins enable

rabbitmq_federation rabbitmq-plugins enable

rabbitmq_federation_management

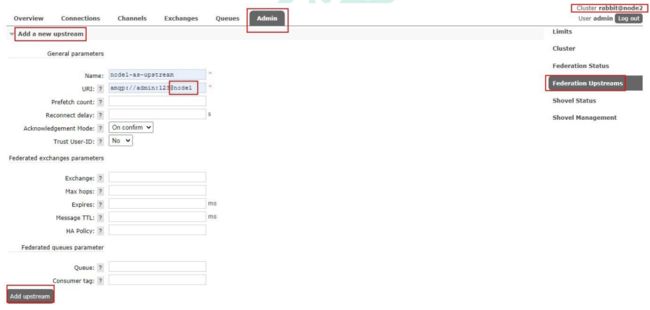

3.原理图(先运行 consumer 在 node2 创建 fed_exchange)

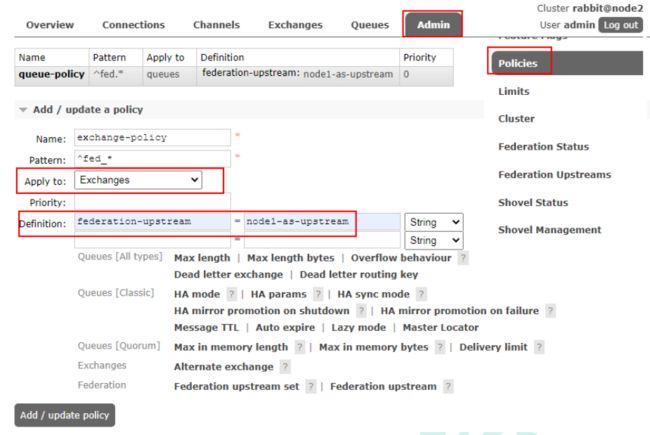

4.在 downstream(node2)配置 upstream(node1)

5.添加 policy

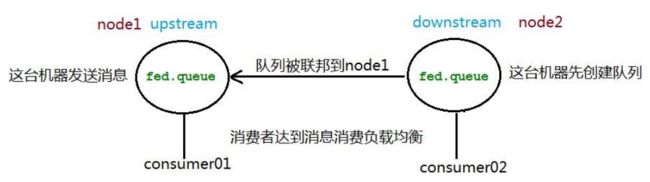

Federation Queue

使用原因

联邦队列可以在多个 Broker 节点(或者集群)之间为单个队列提供均衡负载的功能。一个联邦队列可以 连接一个或者多个上游队列(upstream queue),并从这些上游队列中获取消息以满足本地消费者消费消息 的需求。

搭建步骤

1.原理图

2.添加 upstream(同上)

3.添加 policy

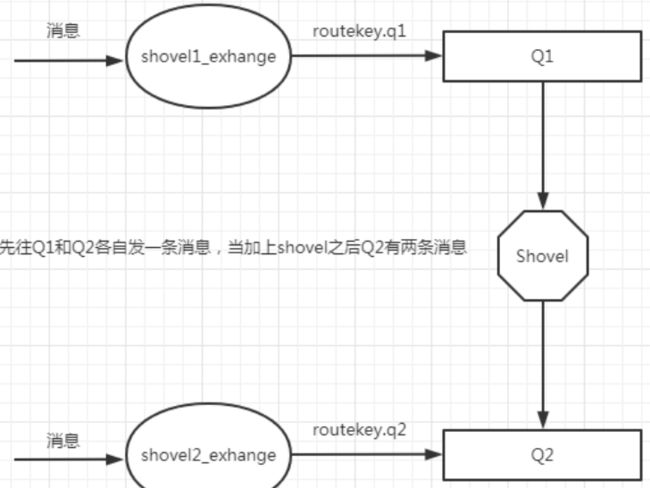

Shovel

使用原因

Federation 具备的数据转发功能类似,Shovel 够可靠、持续地从一个 Broker 中的队列(作为源端,即 source)拉取数据并转发至另一个 Broker 中的交换器(作为目的端,即 destination)。作为源端的队列和作为 目的端的交换器可以同时位于同一个 Broker,也可以位于不同的 Broker 上。Shovel 可以翻译为"铲子",是 一种比较形象的比喻,这个"铲子"可以将消息从一方"铲子"另一方。Shovel 行为就像优秀的客户端应用程 序能够负责连接源和目的地、负责消息的读写及负责连接失败问题的处理。

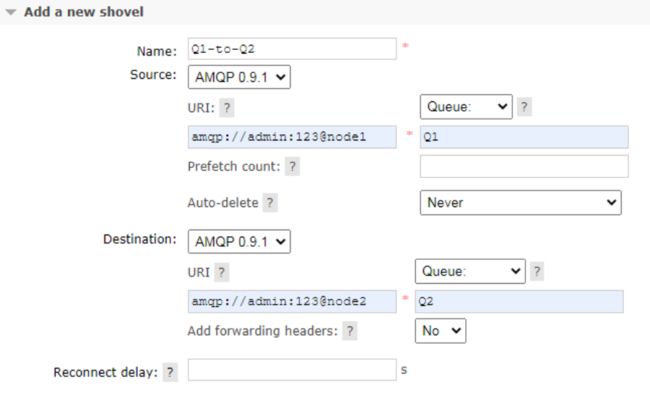

搭建步骤

1.开启插件(需要的机器都开启)

rabbitmq-plugins enable rabbitmq_shovel

rabbitmq-plugins enable rabbitmq_shovel_management

2.原理图(在源头发送的消息直接回进入到目的地队列)

3.添加 shovel 源和目的地

tail -f /var/log/messages -n 200

7.观察最新添加的 vip

ip add show

8.node1 模拟 keepalived 关闭状态

systemctl stop keepalived

9.使用 vip 地址来访问 rabbitmq 集群

Federation Exchange

使用原因

(broker 北京),(broker 深圳)彼此之间相距甚远,网络延迟是一个不得不面对的问题。有一个在北京 的业务(Client 北京) 需要连接(broker 北京),向其中的交换器 exchangeA 发送消息,此时的网络延迟很小, (Client 北京)可以迅速将消息发送至 exchangeA 中,就算在开启了 publisherconfirm 机制或者事务机制的情 况下,也可以迅速收到确认信息。此时又有个在深圳的业务(Client 深圳)需要向 exchangeA 发送消息, 那 么(Client 深圳) (broker 北京)之间有很大的网络延迟,(Client 深圳) 将发送消息至 exchangeA 会经历一定 的延迟,尤其是在开启了 publisherconfirm 机制或者事务机制的情况下,(Client 深圳) 会等待很长的延迟 时间来接收(broker 北京)的确认信息,进而必然造成这条发送线程的性能降低,甚至造成一定程度上的阻 塞。

将业务(Client 深圳)部署到北京的机房可以解决这个问题,但是如果(Client 深圳)调用的另些服务都部 署在深圳,那么又会引发新的时延问题,总不见得将所有业务全部部署在一个机房,那么容灾又何以实现? 这里 使用 Federation 插件就可以很好地解决这个问题.

搭建步骤

1.需要保证每台节点单独运行

2.在每台机器上开启 federation 相关插件 rabbitmq-plugins enable

rabbitmq_federation rabbitmq-plugins enable

rabbitmq_federation_management

3.原理图(先运行 consumer 在 node2 创建 fed_exchange)

[外链图片转存中…(img-BAyZmbu8-1649055971615)]

4.在 downstream(node2)配置 upstream(node1)

[外链图片转存中…(img-r2lMSg7o-1649055971616)]

5.添加 policy

[外链图片转存中…(img-lkA5bCnb-1649055971616)]

Federation Queue

使用原因

联邦队列可以在多个 Broker 节点(或者集群)之间为单个队列提供均衡负载的功能。一个联邦队列可以 连接一个或者多个上游队列(upstream queue),并从这些上游队列中获取消息以满足本地消费者消费消息 的需求。

搭建步骤

1.原理图

[外链图片转存中…(img-OkpWfsea-1649055971617)]

2.添加 upstream(同上)

3.添加 policy

[外链图片转存中…(img-Ajgb3pOK-1649055971617)]

Shovel

使用原因

Federation 具备的数据转发功能类似,Shovel 够可靠、持续地从一个 Broker 中的队列(作为源端,即 source)拉取数据并转发至另一个 Broker 中的交换器(作为目的端,即 destination)。作为源端的队列和作为 目的端的交换器可以同时位于同一个 Broker,也可以位于不同的 Broker 上。Shovel 可以翻译为"铲子",是 一种比较形象的比喻,这个"铲子"可以将消息从一方"铲子"另一方。Shovel 行为就像优秀的客户端应用程 序能够负责连接源和目的地、负责消息的读写及负责连接失败问题的处理。

搭建步骤

1.开启插件(需要的机器都开启)

rabbitmq-plugins enable rabbitmq_shovel

rabbitmq-plugins enable rabbitmq_shovel_management

2.原理图(在源头发送的消息直接回进入到目的地队列)

[外链图片转存中…(img-p0lAA3Om-1649055971617)]

3.添加 shovel 源和目的地

[外链图片转存中…(img-SYduO4kJ-1649055971618)]