风格迁移篇-AdaIN --使用自适应实例规范化实时传输任意样式

文章目录

- Abstract

- 1. Introduction

- 2. Related Work

- 3. Background

-

- 3.1. Batch Normalization

- 3.2. Instance Normalization

- 3.3. Conditional Instance Normalization

- 4. Interpreting Instance Normalization

- 5. Adaptive Instance Normalization

- 6. Experimental Setup

-

- 6.1. Architecture

- 6.2. Training

- 7. Results

-

- 7.1. Comparison with other methods

- 7.2. Additional experiments.

- 7.3. Runtime controls

- 8. Discussion and Conclusion

- References

代码: https://github.com/xunhuang1995/AdaIN-style

论文: http://arxiv.org/abs/1703.06868

Abstract

Gatys等人最近介绍了一种神经算法,该算法以另一图像的样式呈现内容图像,实现所谓的样式转换。然而,他们的框架需要缓慢的迭代优化过程,这限制了其实际应用。提出了前馈神经网络的快速近似,以加快神经风格的转换。不幸的是,速度的提高是有代价的:网络通常与一组固定的样式相联系,无法适应任意的新样式。在本文中,我们提出了一种简单而有效的方法,首次实现了实时任意样式的传输。我们方法的核心是一个新的自适应实例归一化(AdaIN)层,该层将内容特征的均值和方差与样式特征的均值和方差对齐。我们的方法实现了与现有最快方法相当的速度,不受预定义样式集的限制。此外,我们的方法允许灵活的用户控制,如内容风格权衡、风格插值、颜色和空间控制,所有这些都使用单个前馈神经网络。

1. Introduction

Gatys等人[16]的开创性工作表明,深度神经网络(DNN)不仅编码图像的内容,而且编码图像的样式信息。此外,图像样式和内容在某种程度上是可分离的:可以更改图像的样式,同时保留其内容。[16]的风格转换方法足够灵活,可以将任意图像的内容和风格结合起来。然而,它依赖的优化过程非常缓慢。

为了加速神经风格的转换,人们付出了大量的努力。[24,51,31]试图训练前馈神经网络,该网络通过一次向前传递执行风格化。大多数前馈方法的一个主要限制是每个网络仅限于一种样式。最近有一些工作解决了这个问题,但它们要么仍然局限于有限的风格集[11、32、55、5],要么比单一风格转换方法慢得多[6]。

在这项工作中,我们提出了第一种神经式传输算法,解决了这一基本的灵活性和速度难题。我们的方法可以实时传输任意新样式,结合了基于优化的框架[16]的灵活性和类似于最快前馈方法[24,52]的速度。我们的方法受到实例归一化(IN)[52,11]层的启发,该层在前馈式传输中非常有效。为了解释实例规范化的成功,我们提出了一种新的解释,即实例规范化通过规范化特征统计来执行样式规范化,已发现特征统计携带图像的样式信息[16,30,33]。基于我们的解释,我们引入了对IN的一个简单扩展,即自适应实例规范化(AdaIN)。给定内容输入和样式输入,AdaIN只需调整内容输入的均值和方差以匹配样式输入的均值和方差。通过实验,我们发现AdaIN通过传递特征统计信息,有效地结合了前者的内容和后者的风格。然后,通过将AdaIN输出反转回图像空间,学习解码器网络以生成最终样式化图像。我们的方法比[16]快近三个数量级,同时不牺牲将输入转换为任意新样式的灵活性。此外,我们的方法在运行时提供了丰富的用户控制,而不需要对训练过程进行任何修改。

2. Related Work

风格转换。风格转换问题源于非光真实感渲染[28],与纹理合成和转换密切相关[13、12、14]。一些早期方法包括线性滤波器响应的直方图匹配[19]和非参数采样[12,15]。这些方法通常依赖于低级统计数据,并且往往无法捕获语义结构。Gatys等人[16]首次通过匹配DNN卷积层中的特征统计数据证明了令人印象深刻的风格转换结果。最近,对[16]提出了一些改进。李和Wand[30]在深度特征空间中引入了一种基于马尔可夫随机场(MRF)的框架来增强局部模式。Gatys等人[17]提出了控制颜色保存、空间位置和风格转移规模的方法。Ruder等人[45]通过施加时间约束,提高了视频风格传输的质量1 arXiv:1703.06868v2[cs.CV]2017年7月30日。

Gatys等人[16]的框架基于缓慢的优化过程,该过程迭代更新图像,以最小化由丢失网络计算的内容丢失和样式丢失。即使与现代GPU融合,也可能需要几分钟的时间。因此,移动应用程序中的设备处理速度太慢,不实用。一种常见的解决方法是用前馈神经网络代替优化过程,前馈神经网络经过训练以最小化相同目标[24、51、31]。这些前馈式传输方法比基于优化的方法快约三个数量级,为实时应用打开了大门。王等人[53]使用多分辨率架构增强了前馈风格传输的粒度。Ulyanov等人[52]提出了提高生成样本质量和多样性的方法。然而,上述前馈方法在每个网络绑定到固定样式的意义上是有限的。为了解决这个问题,Dumoulin等人[11]引入了一个能够编码32种样式及其插值的单一网络。与我们的工作同时,李等人[32]提出了一种前馈架构,可以合成多达300种纹理并传输16种风格。然而,上述两种方法不能适应训练期间未观察到的任意风格。

最近,陈和施密特[6]介绍了一种前馈方法,借助于样式交换层,该方法可以传输任意样式。给定内容和样式图像的特征激活,样式交换层以逐块方式用最接近的匹配样式特征替换内容特征。然而,他们的样式交换层创建了一个新的计算瓶颈:超过95%的计算用于512×512输入图像的样式交换。我们的方法还允许任意风格转换,同时比[6]快1-2个数量级。

风格转换中的另一个中心问题是使用哪种风格损失函数。Gatys等人[16]的原始框架通过匹配Gram矩阵捕获的特征激活之间的二阶统计量来匹配样式。已经提出了其他有效损失函数,例如MRF损失[30]、对抗性损失[31]、直方图损失[54]、珊瑚损失[41]、MMD损失[33]以及信道均值和方差之间的距离[33]。注意,上述所有损失函数都旨在匹配样式图像和合成图像之间的一些特征统计信息。

深度生成图像建模。图像生成有几种替代框架,包括变分自动编码器[27]、自回归模型[40]和生成对抗网络[18]。值得注意的是,GANs获得了最令人印象深刻的视觉质量。已经提出了对GAN框架的各种改进,例如条件生成[43,23]、多级处理[9,20]和更好的训练目标[46,1]。GANs还被应用于风格转换[31]和跨域图像生成[50、3、23、38、37、25]。

3. Background

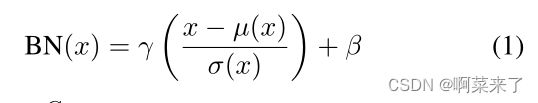

3.1. Batch Normalization

Ioffe和Szegedy[22]的开创性工作引入了批量归一化(BN)层,通过归一化特征统计数据,显著简化了前馈网络的训练。BN层最初设计用于加速判别网络的训练,但也被发现在生成图像建模中有效[42]。给定输入批次x∈ RN×C×H×W,BN归一化每个特征通道的平均值和标准偏差:

其中γ,β∈ RC是从数据中学习的仿射参数;µ(x),σ(x)∈ RC是平均值和标准差,针对每个特征通道独立计算批次大小和空间尺寸:

BN在训练过程中使用小批量统计数据,在推理过程中用流行的统计数据替换它们,引入了训练和推理之间的差异。最近提出了批重正化[21],通过在训练期间逐渐使用流行的统计数据来解决这个问题。作为BN的另一个有趣应用,李等人[34]发现,BN可以通过重新计算目标域中的流行统计数据来缓解域转移。最近,提出了几种替代的归一化方案,以将BN的有效性扩展到递归架构[35、2、47、8、29、44]

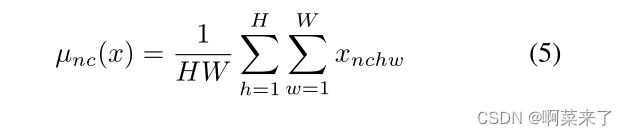

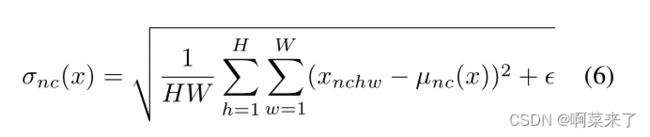

3.2. Instance Normalization

在原始前馈样式化方法[51]中,样式传输网络在每个卷积层之后包含一个BN层。令人惊讶的是,Ulyanov等人[52]发现,只需将BN层替换为IN层即可实现显著改善:

与BN层不同的是,这里µ(x)和σ(x)是针对每个通道和每个样本在空间维度上独立计算的:

【图1。为了理解IN在风格转换中有效的原因,我们使用(a)MS-COCO中的原始图像[36],(b)对比度归一化图像,以及(c)使用预先训练的风格转换网络[24]的风格归一化图像来训练IN模型和BN模型。即使将所有训练图像归一化为相同的对比度,IN带来的改善仍然显著,但当所有图像(近似)归一化为相同的样式时,改善要小得多。我们的结果表明,IN执行了一种风格规范化。】

另一个区别是,IN层在测试时应用不变,而BN层通常用总体统计替换小批量统计。

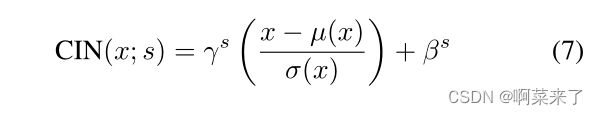

3.3. Conditional Instance Normalization

Dumoulin等人[11]没有学习一组仿射参数γ和β,而是提出了一个条件实例归一化(CIN)层,该层为每个样式学习一组不同的参数γs和βs:

在训练期间,从固定的样式集中随机选择样式图像及其索引∈ {1,2,…,S}(在他们的实验中S=32)。然后,内容图像由样式传输网络处理,其中在CIN层中使用相应的γs和βs。令人惊讶的是,通过在层中使用相同的卷积参数但不同的仿射参数,该网络可以生成完全不同样式的图像。

与没有归一化层的网络相比,具有CIN层的网络需要2F S附加参数,其中F是网络中特征映射的总数[11]。由于附加参数的数量与样式的数量呈线性关系,因此将其方法扩展到建模大量样式(例如,数万种)是一个挑战。此外,如果不重新训练网络,他们的方法无法适应任意的新风格。

4. Interpreting Instance Normalization

尽管(有条件的)实例规范化取得了巨大成功,但它们在风格转换方面特别有效的原因仍然不清楚。Ulyanov等人[52]将IN的成功归因于其对内容图像对比度的不变性。然而,IN发生在特征空间中,因此它应该比像素空间中的简单对比度归一化具有更深远的影响。也许更令人惊讶的是,中的仿射参数可以完全改变输出图像的样式。

众所周知,DNN的卷积特征统计可以捕捉图像的样式[16、30、33]。虽然Gatys等人[16]使用二阶统计量作为其优化目标,但Li等人[33]最近表明,匹配许多其他统计量,包括通道均值和方差,也可以有效地进行风格转换。基于这些观察结果,我们认为实例规范化通过规范化特征统计信息(即均值和方差)来执行一种形式的风格规范化。虽然DNN在[16,33]中用作图像描述符,但我们认为生成器网络的特征统计也可以控制生成图像的样式。

我们运行改进的纹理网络代码[52]来执行单样式转换,使用IN或BN层。正如所料,具有IN的模型比BN模型收敛更快(图1(a))。为了测试[52]中的解释,我们通过在亮度通道上执行直方图均衡化,将所有训练图像归一化为相同的对比度。如图1(b)所示,in仍然有效,表明[52]中的解释不完整。为了验证我们的假设,我们使用[24]提供的预训练风格传输网络将所有训练图像归一化为相同风格(不同于目标风格)。根据图1(c),当图像已经被样式归一化时,输入带来的改善变得更小。剩下的差距可以解释为[24]的样式规范化并不完美。此外,在样式归一化图像上训练BN的模型可以像在原始图像上训练IN的模型一样快速收敛。我们的结果表明,IN确实执行了一种风格规范化。

由于BN归一化了一批样本而不是单个样本的特征统计,因此可以直观地理解为将一批样本归一化为以单个样式为中心。然而,每个样本仍然可能有不同的样式。当我们想要将所有图像传输到同一样式时,这是不可取的,就像原始前馈样式传输算法[51]中的情况一样。虽然卷积层可能会学习补偿批内风格的差异,但这对训练提出了额外的挑战。另一方面,IN可以将每个样本的样式规范化为目标样式。由于网络的其余部分可以专注于内容操作,同时丢弃原始样式信息,因此可以方便地进行培训。CIN成功的原因也很清楚:不同的仿射参数可以将特征统计归一化为不同的值,从而将输出图像归一化为不同的样式。

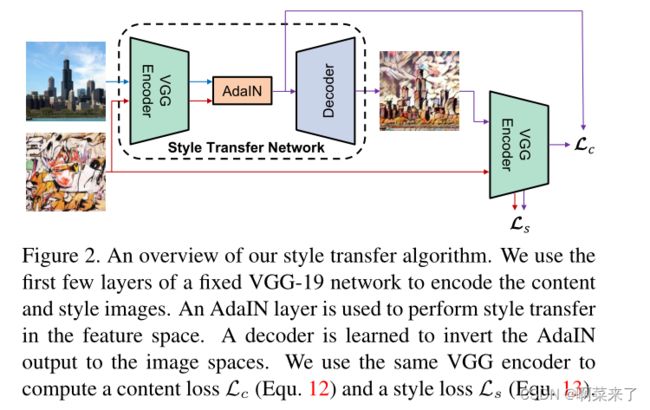

[图2:我们的风格转换算法概述。我们使用固定VGG-19网络的前几层对内容和样式图像进行编码。AdaIN层用于在特征空间中执行样式转换。学习解码器将AdaIN输出反转到图像空间。我们使用相同的VGG编码器来计算内容损失Lc(等式12)和样式损失Ls(等式13)。]

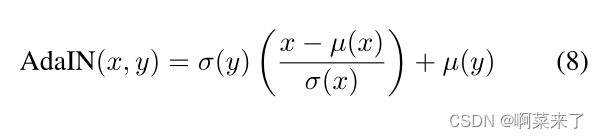

5. Adaptive Instance Normalization

如果IN将输入规格化为仿射参数指定的单个样式,是否可以通过使用自适应仿射变换使其适应任意给定的样式?在这里,我们提出了对IN的一个简单扩展,我们称之为自适应实例规范化(AdaIN)。AdaIN接收内容输入x和样式输入y,并简单地对齐x的通道均值和方差以匹配y的均值和方差。与BN、IN或CIN不同,AdaIN没有可学习的仿射参数。相反,它从样式输入中自适应计算仿射参数:

其中,我们简单地用σ(y)缩放归一化内容输入,并用µ(y)移位。与中类似,这些统计数据是跨空间位置计算的。

直观地说,让我们考虑一个检测特定风格笔触的特征通道。具有这种笔划的样式图像将对此特征产生高平均激活。AdaIN生成的输出将具有与此特征相同的高平均激活率,同时保留内容图像的空间结构。可以使用前馈解码器将笔划特征反转到图像空间,类似于[10]。该特征通道的方差可以编码更精细的样式信息,这些信息也会传输到AdaIN输出和最终输出图像。

简而言之,AdaIN通过传输特征统计信息,特别是通道均值和方差,在特征空间中执行样式转换。我们的AdaIN层与[6]中提出的样式交换层起着类似的作用。虽然样式交换操作非常耗时和占用内存,但我们的AdaIN层与IN层一样简单,几乎不增加任何计算成本。

6. Experimental Setup

图2显示了基于拟议AdaIN层的我们风格传输网络的概述。代码和预训练模型(在Torch 7[7]中)可从以下网址获得: https://github.com/xunhuang1995/AdaIN-style

6.1. Architecture

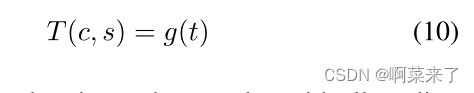

我们的风格传输网络T将内容图像c和任意风格图像s作为输入,并合成将前者的内容和后者的风格重新组合的输出图像。我们采用了一种简单的编码器-解码器架构,其中编码器f固定在预训练VGG-19[48]的前几层(直到relu4 1)。在特征空间中对内容和样式图像进行编码后,我们将两个特征映射馈送到AdaIN层,该层将内容特征映射的均值和方差与样式特征映射的均值和方差对齐,生成目标特征映射t:

训练随机初始化的解码器g将t映射回图像空间,生成样式化图像t(c,s):

解码器主要镜像编码器,所有池层由最近的上采样取代,以减少棋盘效应。我们在f和g中使用反射填充来避免边界伪影。另一个重要的架构选择是解码器应该使用实例层、批处理层还是不使用规范化层。如第。4.IN将每个样本归一化为单个样式,而BN将一批样本归一化为围绕单个样式居中。当我们希望解码器生成风格迥异的图像时,两者都是不可取的。因此,我们在解码器中不使用归一化层。以秒为单位。7.1我们将表明,解码器中的IN/BN层确实会影响性能。

6.2. Training

我们使用MS-COCO[36]作为内容图像,使用主要从WikiArt[39]收集的绘画数据集作为风格图像,按照[6]的设置来训练我们的网络。每个数据集包含大约80000个训练示例。我们使用adam优化器[26]和8个内容样式图像对的批量大小。在训练过程中,我们首先将两幅图像的最小维数调整为512,同时保持纵横比,然后随机裁剪大小为256×256的区域。由于我们的网络是完全卷积的,因此它可以在测试期间应用于任何大小的图像。

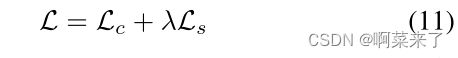

与[51,11,52]类似,我们使用预训练VGG19[48]来计算损失函数,以训练解码器:

它是内容损失Lc和风格损失Ls与风格损失权重λ的加权组合。内容损失是目标特征和输出图像特征之间的欧几里得距离。我们使用AdaIN输出t作为内容目标,而不是内容图像的常用特征响应。我们发现,这导致了更快的收敛速度,也符合我们反转AdaIN输出t的目标。

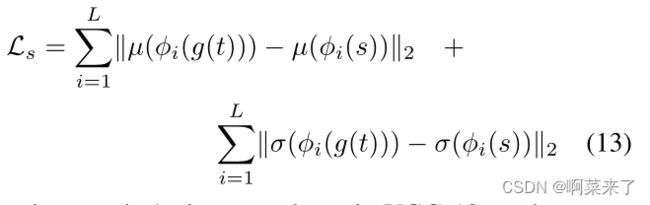

由于我们的AdaIN层只传递样式特征的均值和标准差,因此我们的样式损失仅与这些统计数据匹配。虽然我们发现常用的Gram矩阵损失可以产生类似的结果,但我们匹配IN统计,因为它在概念上更清晰。李等人[33]也探讨了这种风格的丧失。

其中,每个φi表示VGG-19中用于计算样式损耗的层。在我们的实验中,我们使用等权重的relu1 1、relu2 1、relu3 1、relu4 1层。

7. Results

7.1. Comparison with other methods

在本小节中,我们将我们的方法与三种类型的样式转换方法进行比较:1)灵活但缓慢的基于优化的方法[16],2)限制于单一样式的快速前馈方法[52],以及3)基于灵活面片的中速方法[6]。如果没有另外提及,则通过使用默认配置运行其代码来获得比较方法的结果。对于【6】,我们使用作者提供的预训练逆网络。所有测试图像的大小为512×512。

定性示例。在图4中,我们展示了通过比较方法生成的示例样式转换结果。注意,在我们的模型训练期间,从未观察到所有测试样式图像,而[52]的结果是通过将一个网络拟合到每个测试样式来获得的。即便如此,对于许多图像(例如第1、2、3行),我们的风格化图像的质量与[52]和[16]相当有竞争力。在其他一些情况下(例如第5行),我们的方法的质量略低于[52]和[16]。这并不意外,因为我们相信在速度、灵活性和质量之间有三种权衡。与[6]相比,对于大多数比较的图像,我们的方法似乎更忠实地传递了样式。最后一个示例清楚地说明了[6]的一个主要限制,即尝试将每个内容补丁与最接近的匹配样式补丁相匹配。但是,如果大多数内容修补程序与不代表目标样式的少数样式修补程序匹配,则样式传输将失败。因此,我们认为匹配全局特征统计是一种更通用的解决方案,尽管在某些情况下(例如第3行),[6]的方法也可以产生吸引人的结果。

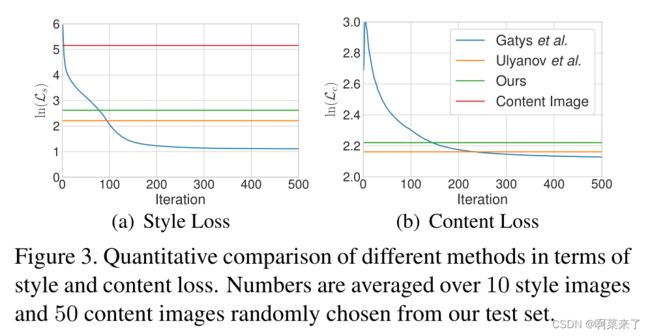

定量评估。我们的算法是否权衡了一些质量以获得更高的速度和灵活性,如果是这样的话,代价是多少?为了定量地回答这个问题,我们将我们的方法与基于优化的方法[16]和快速单风格转换方法[52]在内容和风格损失方面进行了比较。由于我们的方法使用了基于IN统计的样式损失,因此我们也相应地修改了[16]和[52]中的损失函数,以进行公平比较(图4中的结果仍然是使用默认的Gram矩阵损失获得的)。此处显示的内容损失与[52,16]中所示相同。报告的数字是从WikiArt数据集[39]和MS-COCO[36]的测试集中随机选择的10幅风格图像和50幅内容图像的平均数。

如图3所示,我们合成图像的平均内容和风格损失略高,但与Ulyanov等人[52]的单一风格转移方法相当。特别是,我们的方法和[52]都在优化的50到100次迭代之间获得了类似于[16]的风格损失。这证明了我们的方法具有很强的泛化能力,考虑到我们的网络在训练期间从未见过测试风格,而[52]的每个网络都是针对一种测试风格进行专门训练的。此外,请注意,我们的样式损失比原始内容图像的样式损失小得多。

速度分析。我们的大部分计算都花在内容编码、样式编码和解码上,每种编码大约占用三分之一的时间。在一些应用场景中,例如视频处理,样式图像只需要编码一次,AdaIN可以使用存储的样式统计信息来处理所有后续图像。在其他一些情况下(例如,将相同的内容转换为不同的样式),可以共享用于内容编码的计算。

在选项卡中。1我们将我们的方法与之前的方法[16、52、11、6]进行了速度比较。除去样式编码时间,我们的算法对256×256和512×512图像分别以56和15fps的速度运行,从而可以实时处理用户上传的任意样式。在适用于任意样式的算法中,我们的方法比[16]快近3个数量级,比[6]快1-2个数量级。与[6]相比,速度的提高对于更高分辨率的图像尤其重要,因为[6]中的样式交换层不能很好地扩展到高分辨率样式图像。此外,我们的方法实现了与仅限于几种风格的前馈方法相当的速度[52,11]。我们的方法处理时间稍长,主要是由于我们基于VGG的网络更大,而不是方法上的局限性。有了更高效的架构,我们的速度可以进一步提高。

【表1。256×256和512×512图像的速度比较(秒)。我们的方法实现了与局限于少量样式的方法相当的速度[52,11],同时比适用于任意样式的其他现有算法快得多[16,6]。我们显示了不包括和包括(括号中)样式编码过程的处理时间。结果使用Pascal Titan X GPU获得,平均超过100幅图像。】

7.2. Additional experiments.

在本小节中,我们进行实验来证明我们的重要架构选择。我们表示第2.1节中描述的方法。6作为Enc-AdaIN-Dec。我们实验了一个名为Enc Concat Dec的模型,该模型用串联取代AdaIN,这是一种自然的基线策略,用于组合来自内容和样式图像的信息。此外,我们在解码器的层中使用BN /运行模型,分别表示为Enc AdaIN BNDec和Enc AdaIN INDec。其他训练设置保持不变。

在图5和图6中,我们展示了比较方法的示例和训练曲线。在由Enconcat Dec基线生成的图像(图5(d))中,可以清楚地观察到样式图像的对象轮廓,这表明网络无法将样式信息与样式图像的内容分离开来。这也与图6一致,其中Enc Concat Dec可以达到较低的样式损失,但无法减少内容损失。层中含有BN/的模型也会获得更差的质量结果和更高的损失。分层的结果尤其糟糕。这再次验证了我们的说法,即分层往往会将输出标准化为单个样式,因此当我们想要生成不同样式的图像时,应该避免。

7.3. Runtime controls

为了进一步强调我们方法的灵活性,我们展示了我们的风格转换网络允许用户控制风格化程度,在不同风格之间插值,在保留颜色的同时转换风格,以及在不同的空间区域使用不同的风格。请注意,所有这些控件仅在运行时使用相同的网络应用,没有对训练过程进行任何修改。

内容风格权衡。在训练期间,可以通过调整Eqa中的风格权重λ来控制风格转移的程度。11.此外,我们的方法允许在测试时通过在反馈给解码器的特征映射之间插值来权衡内容风格。注意,这相当于AdaIN仿射参数之间的插值。

当α=0时,该网络试图忠实地重建内容图像,当α=1时,合成最具风格的图像。如图7所示,通过将α从0更改为1,可以观察到内容相似性和风格相似性之间的平滑过渡。

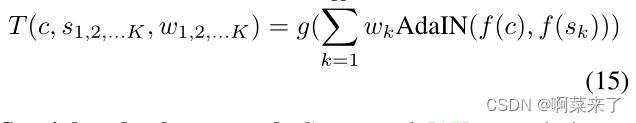

样式插值。要在一组K样式图像s1、s2、…、之间插值。。。,具有相应权重w1,w2。。。,wK使得PK k=1 wK=1,我们在特征图之间进行类似的插值(结果如图8所示):

空间和颜色控制。Gatys等人[17]最近引入了用户对颜色信息和风格转移的空间位置的控制,这可以很容易地纳入我们的框架。为了保留内容图像的颜色,我们首先将样式图像的颜色分布使用颜色对齐的样式图像作为样式输入,执行正常样式转换。示例结果如图9所示。

在图10中,我们证明了我们的方法可以将内容图像的不同区域转换为不同的样式。这是通过使用来自不同风格输入的统计信息分别对内容特征图中的不同区域执行AdaIN来实现的,类似于[4,17],但以完全前馈的方式。虽然我们的译码器只在具有同质风格的输入上训练,但它自然地推广到不同区域具有不同风格的输入。

8. Discussion and Conclusion

在本文中,我们提出了一个简单的自适应实例规范化(AdaIN)层,该层首次支持实时的任意样式传输。除了引人入胜的应用之外,我们相信这项工作还为我们理解深度图像表示提供了帮助。

有趣的是,考虑我们的方法与以前基于特征统计的神经风格转换方法之间的概念差异。Gatys等人[16]采用优化过程操纵像素值以匹配特征统计。在[24,51,52]中,优化过程被前馈神经网络取代。尽管如此,网络训练工作是修改像素值以间接匹配特征统计。我们采用了一种非常不同的方法,一次直接对齐特征空间中的统计信息,然后将特征反转回像素空间。

鉴于我们的方法简单,我们认为仍有很大的改进空间。在未来的工作中,我们计划探索更先进的网络架构,如残余架构[24]或具有编码器额外跳过连接的架构[23]。我们还计划研究更复杂的训练方案,如增量训练[32]。此外,我们的AdaIN层只对齐最基本的特征统计(均值和方差)。用相关对齐[49]或直方图匹配[54]替换AdaIN可能会通过传递高阶统计量进一步提高质量。另一个有趣的方向是将AdaIN应用于纹理合成。

References

[1] M. Arjovsky, S. Chintala, and L. Bottou. Wasserstein gan.

arXiv preprint arXiv:1701.07875, 2017. 2

[2] J. L. Ba, J. R. Kiros, and G. E. Hinton. Layer normalization.

arXiv preprint arXiv:1607.06450, 2016. 2

[3] K. Bousmalis, N. Silberman, D. Dohan, D. Erhan, and

D. Krishnan. Unsupervised pixel-level domain adapta-

tion with generative adversarial networks. arXiv preprint

arXiv:1612.05424, 2016. 2

[4] A. J. Champandard. Semantic style transfer and turn-

ing two-bit doodles into fine artworks. arXiv preprint

arXiv:1603.01768, 2016. 8

[5] D. Chen, L. Y uan, J. Liao, N. Y u, and G. Hua. Stylebank:

An explicit representation for neural image style transfer. In

CVPR, 2017. 1

[6] T. Q. Chen and M. Schmidt. Fast patch-based style transfer

of arbitrary style. arXiv preprint arXiv:1612.04337, 2016. 1,

2, 4, 5, 6, 7

[7] R. Collobert, K. Kavukcuoglu, and C. Farabet. Torch7:

A matlab-like environment for machine learning. In NIPS

Workshop, 2011. 4

[8] T. Cooijmans, N. Ballas, C. Laurent, C ¸ . Gülc ¸ehre, and

A. Courville. Recurrent batch normalization. In ICLR, 2017.

2

[9] E. L. Denton, S. Chintala, R. Fergus, et al. Deep genera-

tive image models using a laplacian pyramid of adversarial

networks. In NIPS, 2015. 2

[10] A. Dosovitskiy and T. Brox. Inverting visual representations

with convolutional networks. In CVPR, 2016. 4

[11] V . Dumoulin, J. Shlens, and M. Kudlur. A learned represen-

tation for artistic style. In ICLR, 2017. 1, 2, 3, 5, 6, 7

[12] A. A. Efros and W. T. Freeman. Image quilting for texture

synthesis and transfer. In SIGGRAPH, 2001. 1

[13] A. A. Efros and T. K. Leung. Texture synthesis by non-

parametric sampling. In ICCV, 1999. 1

[14] M. Elad and P . Milanfar. Style-transfer via texture-synthesis.

arXiv preprint arXiv:1609.03057, 2016. 1

[15] O. Frigo, N. Sabater, J. Delon, and P . Hellier. Split and

match: example-based adaptive patch sampling for unsuper-

vised style transfer. In CVPR, 2016. 1

[16] L. A. Gatys, A. S. Ecker, and M. Bethge. Image style transfer

using convolutional neural networks. In CVPR, 2016. 1, 2,

3, 5, 6, 7, 8

[17] L. A. Gatys, A. S. Ecker, M. Bethge, A. Hertzmann, and

E. Shechtman. Controlling perceptual factors in neural style

transfer. In CVPR, 2017. 1, 7, 8

[18] I. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu,

D. Warde-Farley, S. Ozair, A. Courville, and Y . Bengio. Gen-

erative adversarial nets. In NIPS, 2014. 2

[19] D. J. Heeger and J. R. Bergen. Pyramid-based texture analy-

sis/synthesis. In SIGGRAPH, 1995. 1

[20] X. Huang, Y . Li, O. Poursaeed, J. Hopcroft, and S. Belongie.

Stacked generative adversarial networks. In CVPR, 2017. 2

[21] S. Ioffe. Batch renormalization: Towards reducing minibatch

dependence in batch-normalized models. arXiv preprint

arXiv:1702.03275, 2017. 2

[22] S. Ioffe and C. Szegedy. Batch normalization: Accelerating

deep network training by reducing internal covariate shift. In

JMLR, 2015. 2

[23] P . Isola, J.-Y . Zhu, T. Zhou, and A. A. Efros. Image-to-image

translation with conditional adversarial networks. In CVPR,

2017. 2, 8

[24] J. Johnson, A. Alahi, and L. Fei-Fei. Perceptual losses for

real-time style transfer and super-resolution. In ECCV, 2016.

1, 2, 3, 8

[25] T. Kim, M. Cha, H. Kim, J. Lee, and J. Kim. Learning to

discover cross-domain relations with generative adversarial

networks. arXiv preprint arXiv:1703.05192, 2017. 2

[26] D. Kingma and J. Ba. Adam: A method for stochastic opti-

mization. In ICLR, 2015. 5

[27] D. P . Kingma and M. Welling. Auto-encoding variational

bayes. In ICLR, 2014. 2

[28] J. E. Kyprianidis, J. Collomosse, T. Wang, and T. Isenberg.

State of the” art: A taxonomy of artistic stylization tech-

niques for images and video. TVCG, 2013. 1

[29] C. Laurent, G. Pereyra, P . Brakel, Y . Zhang, and Y . Ben-

gio. Batch normalized recurrent neural networks. In ICASSP,

2016. 2

[30] C. Li and M. Wand. Combining markov random fields and

convolutional neural networks for image synthesis. In CVPR,

2016. 1, 2, 3

[31] C. Li and M. Wand. Precomputed real-time texture synthesis

with markovian generative adversarial networks. In ECCV,

2016. 1, 2

[32] Y . Li, C. Fang, J. Yang, Z. Wang, X. Lu, and M.-H. Yang.

Diversified texture synthesis with feed-forward networks. In

CVPR, 2017. 1, 2, 8

[33] Y . Li, N. Wang, J. Liu, and X. Hou. Demystifying neural

style transfer. arXiv preprint arXiv:1701.01036, 2017. 1, 2,

3, 5

[34] Y . Li, N. Wang, J. Shi, J. Liu, and X. Hou. Revisiting

batch normalization for practical domain adaptation. arXiv

preprint arXiv:1603.04779, 2016. 2

[35] Q. Liao, K. Kawaguchi, and T. Poggio. Streaming normal-

ization: Towards simpler and more biologically-plausible

normalizations for online and recurrent learning. arXiv

preprint arXiv:1610.06160, 2016. 2

[36] T.-Y . Lin, M. Maire, S. Belongie, J. Hays, P . Perona, D. Ra-

manan, P . Dollár, and C. L. Zitnick. Microsoft coco: Com-

mon objects in context. In ECCV, 2014. 3, 5

[37] M.-Y . Liu, T. Breuel, and J. Kautz. Unsupervised

image-to-image translation networks. arXiv preprint

arXiv:1703.00848, 2017. 2

[38] M.-Y . Liu and O. Tuzel. Coupled generative adversarial net-

works. In NIPS, 2016. 2

[39] K. Nichol. Painter by numbers, wikiart. https://www.

kaggle.com/c/painter-by-numbers, 2016. 5

[40] A. v. d. Oord, N. Kalchbrenner, and K. Kavukcuoglu. Pixel

recurrent neural networks. In ICML, 2016. 2

[41] X. Peng and K. Saenko. Synthetic to real adaptation

with deep generative correlation alignment networks. arXiv

preprint arXiv:1701.05524, 2017. 2

[42] A. Radford, L. Metz, and S. Chintala. Unsupervised repre-

sentation learning with deep convolutional generative adver-

sarial networks. In ICLR, 2016. 2

[43] S. Reed, Z. Akata, X. Yan, L. Logeswaran, B. Schiele, and

H. Lee. Generative adversarial text to image synthesis. In

ICML, 2016. 2

[44] M. Ren, R. Liao, R. Urtasun, F. H. Sinz, and R. S. Zemel.

Normalizing the normalizers: Comparing and extending net-

work normalization schemes. In ICLR, 2017. 2

[45] M. Ruder, A. Dosovitskiy, and T. Brox. Artistic style transfer

for videos. In GCPR, 2016. 1

[46] T. Salimans, I. Goodfellow, W. Zaremba, V . Cheung, A. Rad-

ford, and X. Chen. Improved techniques for training gans. In

NIPS, 2016. 2

[47] T. Salimans and D. P . Kingma. Weight normalization: A

simple reparameterization to accelerate training of deep neu-

ral networks. In NIPS, 2016. 2

[48] K. Simonyan and A. Zisserman. V ery deep convolutional

networks for large-scale image recognition. In ICLR, 2015.

4, 5

[49] B. Sun, J. Feng, and K. Saenko. Return of frustratingly easy

domain adaptation. In AAAI, 2016. 8

[50] Y . Taigman, A. Polyak, and L. Wolf. Unsupervised cross-

domain image generation. In ICLR, 2017. 2

[51] D. Ulyanov, V . Lebedev, A. V edaldi, and V . Lempitsky. Tex-

ture networks: Feed-forward synthesis of textures and styl-

ized images. In ICML, 2016. 1, 2, 4, 5, 8

[52] D. Ulyanov, A. V edaldi, and V . Lempitsky. Improved texture

networks: Maximizing quality and diversity in feed-forward

stylization and texture synthesis. In CVPR, 2017. 1, 2, 3, 5,

6, 7, 8

[53] X. Wang, G. Oxholm, D. Zhang, and Y .-F. Wang. Mul-

timodal transfer: A hierarchical deep convolutional neu-

ral network for fast artistic style transfer. arXiv preprint

arXiv:1612.01895, 2016. 2

[54] P . Wilmot, E. Risser, and C. Barnes. Stable and controllable

neural texture synthesis and style transfer using histogram

losses. arXiv preprint arXiv:1701.08893, 2017. 2, 8

[55] H. Zhang and K. Dana. Multi-style generative network for

real-time transfer. arXiv preprint arXiv:1703.06953, 2017. 1