【全文翻译】Edge Intelligence: Paving the Last Mile of Artificial Intelligence With Edge Computing

Edge Intelligence:Paving the Last Mile of Artificial Intelligence With Edge Computing

-

-

-

-

- I.INTRODUCTION

- II.PRIMER ON ARTIFICIAL INTELLIGENCE(人工智能入门)

-

- A. Artifificial Intelligence

- B. Deep Learning and Deep Neural Networks(深度学习与深层神经网络)

- C.From Deep Learning to Model Training and Inference(从深度学习到模型训练和推理)

- D. Popular Deep Learning Models

- III.EDGE INTELLIGENCE( 边缘智能)

-

- A. Motivation and Benefifits of Edge Intelligence

- B. Scope and Rating of Edge Intelligence(边缘智能的范围和等级)

- IV.EDGE INTELLIGENCE MODEL TRAINING( 边缘智能模型培训)

-

- A. Architectures

- B. Key Performance Indicators

- C. Enabling Technologies

- D. Summary of Existing Systems and Frameworks

- V.EDGE INTELLIGENCE MODEL INFERENCE(边缘智能模型推论)

-

- A. Architectures

- B. Key Performance Indicators

- C. Enabling Technologies

- D. Summary of Existing Systems and Frameworks

- VI.FUTURE RESEARCH DIRECTIONS

-

- A. Programming and Software Platforms(编程和软件平台)

- B. Resource-Friendly Edge AI Model Design(资源友好型Edge AI模型设计)

- C. Computation-Aware Networking Techniques(计算感知网络技术)

- D. Tradeoff Design With Various DNN Performance Metrics(具有各种DNN性能指标的权衡设计)

- E. Smart Service and Resource Management(智能服务和资源管理)

- F. Security and Privacy Issues(安全和隐私问题)

- G. Incentive and Business Models(激励和商业模式)

- VII.CONCLUSION

-

-

-

摘要 随着深度学习的突破,近年来见证了人工智慧(AI)应用程序和服务的蓬勃发展,从个人助理到推荐系统再到视频/音频监视者。 最近,随着移动计算和物联网(IoT)的普及,数十亿个移动和IoT设备连接到Internet,从而在网络边缘生成了数十亿字节的数据。 在这种趋势的推动下,迫切需要将AI前沿推向网络边缘,以充分释放边缘大数据的潜力。 为了满足这种需求,边缘计算是一种新兴的范例,它将计算任务和服务从网络核心推向网络边缘,已被广泛认为是一种有前途的解决方案。 由此产生的新的交叉学科,边缘人工智能或边缘智能(EI)正开始受到极大的关注。但是,有关EI的研究仍处于起步阶段,计算机系统和AI社区都非常希望有专门的场所来交流EI的最新进展。 为此,我们对EI的最新研究工作进行了全面调查。 具体来说,我们首先回顾一下在网络边缘运行AI的背景和动机。然后,我们提供了针对深度学习模型的总体架构,框架和新兴关键技术的概述,以用于在网络边缘进行训练/推理。 最后,我们讨论了有关EI的未来研究机会。 我们相信,这项调查将引起越来越多的关注,激发富有成果的讨论,并激发有关EI的进一步研究思路。

I.INTRODUCTION

我们生活在一个前所未有的人工智能蓬勃发展的时代。 在算法,计算能力和大数据的最新进步的推动下,深度学习在计算机视觉,语音识别和计算机视觉等众多领域取得了重大突破。 象棋(例如AlphaGo)和机器人技术的自然语言处理。 得益于这些突破,以智能个人助理,个性化购物建议,视频监控和智能家居设备为代表的一系列智能应用程序迅速受到关注,并获得了极大的普及。 众所周知,这些智能应用程序极大地丰富了人们的生活方式,提高人类生产力,并提高社会效率。

作为推动AI发展的关键驱动力,近来大数据经历了数据源的巨变,从巨型云数据中心转移到了越来越广泛的终端设备,例如移动设备和物联网(IoT)设备。 传统上,大数据(例如,在线购物记录,社交媒体内容和业务信息学)主要是在巨型云数据中心中生成和存储的。 但是,随着移动计算和物联网的普及,这种趋势现在正在逆转。 具体地说,思科估计,到2021年,网络边缘的所有人,机器和事物将产生近850 ZB 。与之形成鲜明对比的是,到2021年,全球数据中心流量将仅达到20.6 ZB。显然,通过将大量数据引入AI,边缘生态系统将为AI提供许多新颖的应用场景,并推动AI的持续蓬勃发展。

然而,由于对性能,成本和隐私的关注,将AI前沿推到位于互联网最后一英里的边缘生态系统是非常重要的。 为了实现这一目标,传统的观点是将大量数据从物联网设备传输到云数据中心进行分析。 但是,当在广域网(WAN)上移动大量数据时,金钱成本和传输延迟可能会非常高,隐私泄漏也可能成为主要问题。 另一种选择是设备上分析,该分析在设备上运行AI应用程序以本地处理IoT数据,但是,性能和能源效率很低。 这是因为许多AI应用程序都需要很高的计算能力,这大大超出了资源和能源受限的IoT设备的容量。

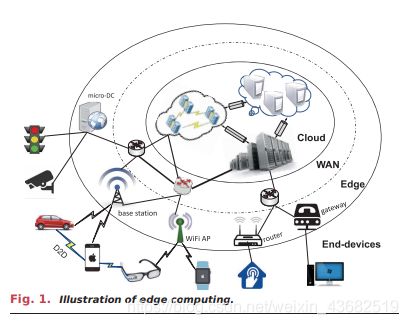

为了应对上述挑战,近来提出了边缘计算,其将云服务从网络核心推向了更靠近物联网设备和数据源的网络边缘。 如图1所示,这里的边缘节点可以通过设备到设备(D2D)通信,连接到接入点的服务器(例如,WiFi,路由器和基站)在附近的终端设备附近进行连接。网络网关甚至是可供附近设备使用的微数据中心。 尽管边缘节点的大小可以变化:从信用卡大小的计算机到具有几个服务器机架的微型数据中心,但边缘计算所强调的最关键的特性是与信息生成源的物理距离。 从本质上讲,与传统的基于云的计算方法相比,计算和信息生成源之间的物理邻近性有望带来诸多好处,包括低延迟,能效,隐私保护,减少带宽消耗,内部部署和上下文意识。

的确,边缘计算和AI的结合引发了一个新的研究领域,即“边缘智能(EI)”或“边缘AI”。EI并未完全依赖云,而是充分利用最了广泛的边缘资源以获得AI洞察力。 值得注意的是,EI受到了业界和学术界的广泛关注。 例如,著名的Gartner炒作周期已将EI纳入一项新兴技术,该技术将在接下来的五到十年内达到稳定的生产力水平。 包括Google,Microsoft,Intel和IBM在内的主要企业已经提出了试点项目,以展示边缘计算在铺开AI的最后一步方面的优势。 这些努力促进了广泛的AI应用,从实时视频分析,认知辅助到精密农业,智能家居和工业物联网(IIoT)。

值得注意的是,对这种新兴的跨学科EI的研究和实践仍处于早期阶段。 通常,在工业和学术界都缺少专门用于总结,讨论和传播EI的最新进展的场所。 为了弥合这一差距,在本文中,我们对EI的最新研究成果进行了全面而具体的调查。 具体来说,我们将首先回顾AI的背景。 然后,我们将讨论EI的动机,定义和评级。 接下来,我们将进一步回顾和分类概括新兴的计算架构以及用于EI模型训练和推理的支持技术。 最后,我们将讨论EI的一些开放研究挑战和机遇。 本文的组织如下。

1)第二部分概述了AI的基本概念,重点是深度学习-AI的最流行领域。

2)第三部分讨论了EI的动机,定义和评级。

3)第四节回顾了用于训练EI模型的体系结构,技术支持,系统和框架。

4)第五节回顾了EI模型推断的体系结构,启用技术,系统和框架。

5)第六节讨论了EI的未来方向和挑战。

对于本次调查,我们希望它能够引起人们的关注,激发富有成果的讨论,并激发关于EI的进一步研究思路。

II.PRIMER ON ARTIFICIAL INTELLIGENCE(人工智能入门)

在本节中,我们将回顾AI的概念,模型和方法,特别侧重于深度学习(AI的最流行领域)。

A. Artifificial Intelligence

尽管AI最近受到关注并引起了广泛关注,但它并不是一个新名词,它始于1956年。简而言之,AI是一种构建能够执行人类任务的智能机器的方法。 这显然是一个非常宽泛的定义,可以从Apple Siri引用到Google AlphaGo以及尚未发明的功能强大的技术。 在模拟人类智能时,人工智能系统通常会展示出至少一些与人类智能相关的行为:计划,学习,推理,解决问题,知识表示,感知,运动和操纵,并且在较小程度上 ,社交智慧和创造力。 在过去60年的发展中,人工智能经历了兴衰,兴衰。 人工智能在2010年代后的最新兴起部分是由于深度学习取得的突破,深度学习已在某些有趣的领域达到了人类水平的准确性。

B. Deep Learning and Deep Neural Networks(深度学习与深层神经网络)

机器学习是实现人工智能目标的有效方法。许多以决策树、K-均值聚类和贝叶斯网络为例的ML方法已经被开发出来,以训练机器根据从现实世界获得的数据进行分类和预测。在现有的ML方法中,深度学习通过利用人工神经网络(ANNs)来学习数据的深度表示,在图像分类、人脸识别等多个任务中取得了惊人的性能。由于深度学习模型所采用的人工神经网络通常由一系列的层次组成,因此该模型被称为深度神经网络(DNN)。如图2所示,DNN的每一层都由神经元组成,这些神经元能够根据来自神经元输入的数据生成非线性输出。

输入层的神经元接收数据并将其传送到中间层(也称为隐藏层)。然后,中间层的神经元生成输入数据的加权和,并使用特定的激活函数(如tanh)输出加权和,然后将输出传播到输出层。最终结果显示在输出层。DNNs具有比典型模型更复杂、更抽象的层次,能够学习高级特征,实现任务的高精度推理。图3展示了dnn的三种流行结构:多层感知器(mlp)、卷积神经网络(CNNs)和递归神经网络(RNNs)。

MLP模型是最基本的DNN,由一系列完全连接的层组成[17]。与MLPs中的全连通层不同,在CNN模型中,卷积层通过执行卷积运算从输入中提取简单特征。通过使用可变卷积滤波器,CNN模型可以捕获输入数据的高级表示,使其在计算机视觉任务中最受欢迎,例如图像分类(例如AlexNet[18]、VGG网络[19]、ResNet[20]和MobileNet[21])和目标检测(如Fast R-CNN[22]、YOLO[23]和SSD[24])。RNN模型是dnn的另一种类型,它使用顺序数据馈送。如图3(c)所示,RNN的基本单元称为单元,并且每个单元由层和一系列单元组成,使得RNN模型的顺序处理成为可能。RNN模型广泛应用于自然语言处理任务中,如语言建模、机器翻译、问答、文档分类等。

深度学习代表了最先进的人工智能技术,以及对资源要求很高的工作负荷,自然适合边缘计算。因此,由于篇幅的限制,在本文的剩余部分,我们将重点研究深度学习与边缘计算之间的相互作用。我们相信所讨论的技术对其他人工智能模型和方法也有一定的启示,即随机梯度下降(SGD)是许多AI/ML算法(如k-均值、支持向量机和套索回归)的常用训练方法[25],以及本文介绍的SGD训练优化技术也可以部署在其他人工智能模型的训练过程中。

C.From Deep Learning to Model Training and Inference(从深度学习到模型训练和推理)

对于DNN层中的每个神经元,它有一个与该层的输入数据大小相关联的权重向量。

不用说,深度学习模型中的权重需要通过训练过程进行优化。

在一个深度学习模型的训练过程中,模型中的权重值通常是随机分配的。然后,最后一层的输出代表任务结果,并设置一个损失函数,通过计算错误率来评估结果的正确性(例如。均方根误差)。为了调整模型中每个神经元的权值,采用了一种优化算法,如SGD[25],并计算了损失函数的梯度。利用反向传播机制[26],[27],错误率被传回整个神经网络,并根据梯度和学习率更新权重。通过输入大量的训练样本并重复这个过程直到错误率低于预先设定的阈值,获得了一个高精度的深度学习模型。

DNN模型推断在训练后发生。 例如,对于图像分类任务,在大量训练样本的馈送下,对DNN进行训练以学习如何识别图像,然后,推理将真实世界的图像作为输入,并快速得出预测结果 /他们的分类。 训练过程包括前馈过程和反向传播过程。 请注意,推理仅涉及前馈过程,即来自真实世界的输入将通过整个神经网络传递,并且模型将输出预测结果。

D. Popular Deep Learning Models

为了更好地理解深度学习及其应用,在本节中,我们概述了各种流行的深度学习模型。

1)卷积神经网络:为了进行图像分类,AlexNet 作为2012年第一个赢得ImageNet挑战的CNN,由五个卷积层和三个完全连接的层组成。 AlexNet需要6100万个权重和7.24亿个MAC(乘加计算)来对尺寸为227×227的图像进行分类。为了获得更高的精度,VGG-16 被训练为由16个层组成的更深的结构,该结构由13个卷积层和3个完全连接的层组成,需要1.38亿的权重和15.5G的MAC来分类大小为224×224的图像 。为提高准确性同时减少DNN推理的计算,GoogleNet 引入了由不同大小的滤波器组成的初始模块GoogleNet与VGG-16相比,具有更高的准确性,同时仅需要700万个砝码和1.43G MAC即可处理相同大小的图像。ResNet 是最先进的技术,它使用“捷径”结构来达到人类水平的准确性,且前五位的错误率低于5%。 “快捷”模块用于解决训练过程中的梯度消失问题,从而可以训练具有更深结构的DNN模型。 CNN通常用于计算机视觉中。 给定来自现实世界的一系列图像或视频,并利用CNN,AI系统将学习自动提取这些输入的功能以完成特定任务,例如图像分类,面部认证和图像语义分割。

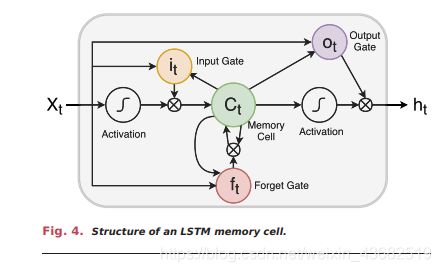

2)递归神经网络:对于顺序输入数据,已经开发了RNN来解决时间序列问题。 RNN的输入包括当前输入和先前的样本。 RNN中的每个神经元都拥有一个内部存储器,该存储器保留先前样本中的计算信息。 RNN的训练基于时间反向传播(BPTT)。长短期记忆(LSTM)[30]是RNN的扩展版本。 在LSTM中,门用来代表神经元的基本单位。 如图4所示,LSTM中的每个神经元都称为存储单元,并包括乘法忘记门,输入门和输出门。 这些门用于控制对存储单元的访问,并防止它们因不相关的输入而受到干扰。 信息通过门添加或删除到存储单元。 门是不同的神经网络,它们确定在存储单元上允许哪些信息。 忘记门可以了解训练期间保留或忘记的信息。 由于处理输入长度不固定的数据的优越性,RNN已广泛用于自然语言处理中。 AI在这里的任务是建立一个可以理解人类说的自然语言的系统,例如自然语言建模,单词嵌入和机器翻译。

3)生成对抗网络:如图5所示,生成对抗网络(GAN)由两个主要组成部分组成,即生成和区分信息网络(即生成器和鉴别器)。 生成器负责从真实数据的训练数据集中学习数据分布之后,负责生成新数据。 鉴别器负责根据生成器生成的伪数据对真实数据进行分类。GAN通常部署在图像生成,图像转换,图像合成,图像超分辨率和其他应用程序中。

4)深度强化学习:深度强化学习(DRL)由DNN和RL组成。 如图6所示,DRL的目标是创建一个智能代理,该代理可以执行有效策略,以可控动作最大化长期任务的回报。 DRL的典型应用是解决各种调度问题,例如游戏中的决策问题,视频传输的速率选择等。

在DRL方法中,RL从环境中寻找状态对状态的最优策略,DNN负责表示大量的状态并逼近动作值来估计给定状态下的动作质量。奖励是一个函数,用来表示预先定义的需求与行动的执行之间的距离。通过不断学习,DRL模型的agent可以用于各种任务,例如游戏。

III.EDGE INTELLIGENCE( 边缘智能)

边缘计算和AI的结合催生了EI。 在本节中,我们将讨论EI的动机,好处和定义。

A. Motivation and Benefifits of Edge Intelligence

AI和边缘计算的融合是自然而然的,因为它们之间有明显的交集。 具体来说,边缘计算旨在协调大量协作性边缘设备和服务器以处理附近生成的数据,而AI致力于通过学习数据来模拟设备/机器中的智能人类行为。 除了享受边缘计算的一般优势(例如低延迟和减少带宽消耗)外,将AI推到边缘还可以在以下几个方面使彼此受益。

1)在网络边缘生成的数据需要AI充分发挥其潜力:由于飞速增长的数量和类型的移动和IoT设备激增,大量的多模式数据(例如,音频,图片和视频) 在设备侧不断检测物理环境。在这种情况下,人工智能在功能上是必要的,因为它能够快速分析这些巨大的数据量,并从中提取见解,以便做出高质量的决策。作为最流行的AI技术之一,深度学习具有自动识别模式并检测边缘设备感测到的数据异常的能力,例如人口分布,交通流量,湿度,温度,压力和空气质量 。 从感测到的数据中提取的见解随后被反馈到实时预测性决策中(例如,公共交通规划,交通控制和驾驶警报),以响应快速变化的环境,从而提高运营效率。 根据Gartner的预测,到2022年,超过80%的企业物联网项目将包括AI组件,而如今这一比例仅为10%。

2)边缘计算能够通过更丰富的数据和应用场景使AI兴旺发达:众所周知,最近深度学习的蓬勃发展背后的驱动力是四方面:算法,硬件,数据和应用场景。 尽管算法和硬件对深度学习发展的影响是直观的,但数据和应用程序场景的作用已大为忽略。 具体来说,为了提高深度学习算法的性能,最常用的方法是使用更多层神经元来细化DNN。 通过这样做,我们需要在DNN中学习更多参数,训练所需的数据也会增加。 这无疑证明了数据对人工智能发展的重要性。 在认识到数据的重要性之后,下一个问题就是数据的来源。 传统上,数据大部分是在超大型数据中心中生成和存储的。然而,随着物联网的飞速发展,这种趋势正在逆转。 根据思科的报告[3],在不久的将来,将在边缘端生成大量的物联网数据。 如果这些数据在云数据中心由AI算法处理,将消耗大量带宽资源,并给云数据中心带来巨大压力。 为了应对这些挑战,提出了边缘计算以通过将计算能力从云数据中心转移到边缘侧(即数据生成源)来实现低延迟数据处理,从而可以实现高性能的AI处理。

尽管边缘计算和AI从技术角度来看是相辅相成的,但它们的应用和普及也互惠互利。

3)AI民主化需要边缘计算作为关键基础设施:AI技术在我们日常生活中的许多数字产品或服务中取得了巨大的成功,例如在线购物,服务推荐,视频监控,智能家居设备等。 人工智能还是自动驾驶汽车,智能金融,癌症诊断和医学发现等新兴创新领域背后的关键驱动力。 除了上述示例之外,为了支持更多的应用程序并突破可能的界限,大型IT公司宣布了AI民主化或无处不在的AI ,其愿景是“在任何地方为每个人和每个组织制造人工智能。” 为此,AI应该“更接近”人们,数据和终端设备。显然,边缘计算在实现此目标方面比云计算更胜任。 首先,与云数据中心相比,边缘服务器更接近人员,数据源和设备。 其次,与云计算相比,边缘计算也更实惠和更容易获得。 最后,与云计算相比,边缘计算有潜力提供更多的AI应用场景。 由于这些优势,边缘计算自然是无处不在的AI的关键推动因素。

4)边缘计算可以通过AI应用程序普及:在边缘计算的早期发展期间,云计算社区一直关注着高要求应用程序边缘计算可以带入云计算所不能达到的更高水平的趋势,以及边缘计算的杀手级应用是什么。为了消除疑问,微软自2009年以来一直在不断探索应将哪种类型从云迁移到边缘,范围从语音命令识别,AR / VR和交互式云游戏[36]到实时。 视频分析。相比之下,实时视频分析被认为是边缘计算的杀手级应用。作为基于计算机视觉的新兴应用程序,实时视频分析不断从监控摄像头中提取高清视频,并且需要高计算量,高带宽,高私密性和低延迟来分析视频。 可以满足这些严格要求的一种可行方法是边缘计算。 回顾边缘计算的上述发展,可以预见,来自IIoT,智能机器人,智能城市和智能家居等领域的新型AI应用将在边缘计算的普及中发挥关键作用。 这主要是由于以下事实:许多与移动和物联网相关的AI应用程序代表了一系列实际应用程序,这些应用程序需要大量计算和能源,对隐私和延迟敏感,因此自然可以与边缘计算保持一致。

由于在边缘运行AI应用程序的优越性和必要性,边缘AI最近受到了极大的关注。 2017年12月,在加利福尼亚大学伯克利分校发布的白皮书“伯克利关于AI的系统挑战的观点” 中,云边缘AI系统被构想为实现任务目标的重要研究方向, 关键和个性化的AI。2018年8月,边缘AI首次出现在Gartner Hype Cycle 中。 根据Gartners的预测,边缘AI仍处于创新触发阶段,并且在接下来的五到十年内将达到生产力的稳定水平。 在行业中,也已经针对边缘AI进行了许多试点项目。 具体来说,在边缘AI服务平台上,传统的云提供商(例如Google,Amazon和Microsoft)已经启动了服务平台,通过使终端设备能够在本地使用预先训练的模型运行ML推理,从而将智能带到了边缘。边缘AI芯片,各种用于运行ML型号的高端芯片已经在市场上销售,例如Google Edge TPU、Intel Nervana NNP、华为Ascend 910和Ascend 310。

B. Scope and Rating of Edge Intelligence(边缘智能的范围和等级)

尽管“边缘AI或EI”一词是全新的,但朝这个方向的探索和实践却早已开始。 如前所述,在2009年,为了展示边缘计算的优势,Microsoft构建了基于边缘的原型来支持移动语音命令识别(一种AI应用程序)。 尽管探索的早期开始,但对于EI仍没有正式定义。

当前,大多数组织[和印刷机将EI视为在终端设备上本地运行AI算法的范例,其中包含在设备上创建的数据(传感器数据或信号)。虽然这代表了现实世界中当前针对EI的最常见方法(例如,使用高端AI芯片),但必须指出的是,这一定义大大缩小了EI的解决范围。 在本地运行DNN模型所例示的计算密集型算法非常耗费资源,因此需要在设备中配备高端处理器。 这样严格的要求不仅增加了EI的成本,而且与计算能力有限的现有传统终端设备不兼容且不友好。

在本文中,我们认为EI的范围不应限于仅在边缘服务器或设备上运行AI模型。 实际上,最近的一项研究表明,对于DNN模型,与本地执行方法相比,利用边缘云协同效应运行它们可以减少端到端延迟和能耗。 由于这些实际的优势,我们认为这种协作层次结构应集成到高效EI解决方案的设计中。 此外,关于EI的现有想法主要集中在推断阶段(即运行AI模型),假设在功率云数据中心中执行AI模型的训练,因为训练阶段的资源消耗大大加重了推断阶段。 但是,这意味着应将大量训练数据从设备或边缘传送到云,这会导致通信开销过大以及对数据隐私的担忧。

相反,我们认为EI应该是在终端设备,边缘节点和云数据中心的层次结构中充分利用可用数据和资源的范例,以优化训练和推论DNN模型的整体性能。 这表明EI并不一定意味着DNN模型在边缘经过了全面训练或推断,但可以通过数据卸载以云边缘设备协调的方式工作。 具体来说,根据数据卸载的数量和路径长度,我们将EI分为六个级别,如图7所示。具体地,以下给出各种水平的EI的定义。

1)云智能:完全在云中训练和推断DNN模型

2)第1级-云边缘协作和云训练:在云中训练DNN模型,但以边缘云协作方式推断DNN模型。 在这里,边缘云合作意味着将数据部分卸载到云中。

3)第2级-边缘协同和云训练:在云中训练DNN模型,但以边缘方式推断DNN模型。 这里的边缘意味着模型推断是在网络边缘内进行的,这可以通过将数据完全或部分卸载到边缘节点或附近的设备(通过D2D通信)来实现。

4)第3级-设备上的推断和云训练:在云中训练DNN模型,但以完全本地的设备上方式推断DNN模型。 在这里,在设备上意味着不会卸载任何数据。

5)第4级-云边缘协作和推理:以边缘云协作方式对DNN模型进行训练和推理。

6)5级-所有边缘:以边缘方式训练和推论DNN模型。

7)第6级-所有设备上:都以设备上方式训练和推论DNN模型。

随着EI级别的提高,数据分载的数量和路径长度会减少。 结果,减少了数据卸载的传输延迟,增加了数据保密性,并降低了WAN带宽成本。 然而,这是以增加的计算等待时间和能量消耗为代价的。 该冲突表明,总体上没有“最佳级别”。 取而代之的是,“最佳级别” EI是取决于应用程序的,应该通过共同考虑诸如延迟,能效,隐私和WAN带宽成本等多个标准来确定它。 在后面的部分中,我们将介绍针对不同级别EI的支持技术以及现有解决方案。

IV.EDGE INTELLIGENCE MODEL TRAINING( 边缘智能模型培训)

随着移动和物联网设备的激增,在网络边缘越来越多地生成了AI模型训练必不可少的数据。 在本节中,我们专注于在边缘进行DNN的分布式培训,包括体系结构,关键性能指标,支持技术以及现有系统和框架。

A. Architectures

边缘的分布式DNN训练的体系结构可以分为三种模式:集中式,分散式和混合(云边缘设备)。 图8分别示出了在(a),(b)和(c)中示出的三种架构。 云是指中央数据中心,而终端设备以手机,汽车和监控摄像头(也都是数据源)为代表。 对于边缘服务器,我们将基站用作图例。

1)集中式:图8(a)描述了集中式DNN训练,其中DNN模型在云数据中心中训练。 用于训练的数据是从诸如移动电话,汽车和监控摄像头之类的分布式终端设备生成和收集的。 数据到达后,云数据中心将使用这些数据执行DNN培训。 因此,可以根据系统采用的特定推理模式在图7中的云智能,级别1,级别2或级别3中标识基于集中式体系结构的系统。

2)分布式:在图8(b)所示的分散模式下,每个计算节点利用本地数据在本地训练自己的DNN模型,从而在本地保存私有信息。为了通过共享局部训练改进来获得全局DNN模型,网络中的节点相互通信以交换局部模型的更新。在这种模式下,可以在没有云数据中心干预的情况下训练全局DNN模型,对应于图7中定义的5级EI。

3)混合:混合模式将集中模式和分散模式结合在一起。 如图8(c)所示,作为架构的枢纽,边缘服务器可以通过彼此分散的更新或通过云数据中心的集中式训练来训练DNN模型。 因此,混合架构涵盖了第4级和第5级,如图7所示。由于涉及角色,混合架构也称为云边缘设备训练。

B. Key Performance Indicators

为了更好地评估分布式培训方法,有六个关键绩效指标。

1)训练损失:从本质上讲,DNN训练过程解决了一个优化问题,旨在使训练损失最小化。 由于训练损失捕获了学习的(例如,预测的)值和标记的数据之间的差距,因此它指示了训练后的DNN模型与训练数据的拟合程度。 因此,期望可以将训练损失最小化。 训练损失主要受训练样本和训练方法的影响。

2)收敛:收敛指标专门用于分散方法。 直观上,去中心化的方法仅在分布式训练过程收敛到共识时才有效,这是该方法的训练结果。 术语“收敛”衡量的是分散方法是否以及以多快的速度收敛到这种共识。 在分散训练模式下,收敛值取决于梯度的同步和更新方式。

3)隐私:当使用源自大量终端设备的数据训练DNN模型时,原始数据或中间数据应从终端设备中转移出去。 显然,在这种情况下不可避免地要处理隐私问题。 为了保护隐私,可以期望将对隐私不太敏感的数据从终端设备中传输出去。 是否实施隐私保护取决于是否将原始数据卸载到边缘。

4)通信成本:训练DNN模型是数据密集型的,因为原始数据或中间数据应在节点之间传输。 直观地讲,这种通信开销增加了训练等待时间,能量和带宽消耗。 通信开销受原始输入数据的大小,传输方式和可用带宽的影响。

5)延迟:可以说,延迟是分布式DNN模型训练的最基本的性能指标之一,因为它直接影响训练后的模型何时可用。 分布式训练过程的等待时间通常包括计算等待时间和通信等待时间。 计算延迟是紧密依赖边缘节点的能力。通信等待时间可能与传输的原始数据或中间数据的大小以及网络连接的带宽不同。

6)能源效率:以分散方式训练DNN模型时,计算和通信过程都消耗大量能源。 但是,对于大多数终端设备而言,它们都是能量受限的。 结果,非常希望DNN模型训练具有能源效率。 能源效率主要受目标训练模型的大小和二手设备资源的影响。

值得注意的是,绩效指标,训练损失和收敛是共同的目标,因此一些有关DNN训练的文献可能没有明确要求它们。

C. Enabling Technologies

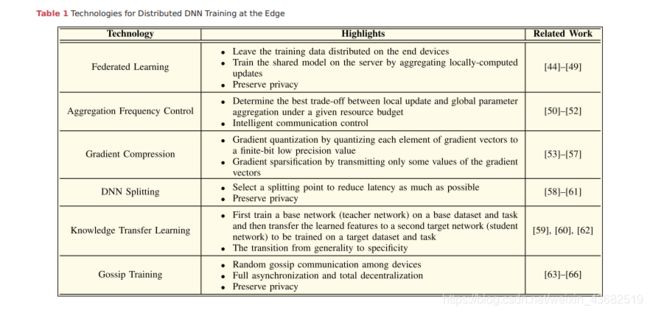

在本节中,我们将介绍在培训EI模型时用于改进一个或多个上述关键绩效指标的支持技术。 表1总结了每种支持技术的重点。

1)联邦学习:联邦学习致力于优化上述关键绩效指标中的隐私问题。 联合学习是一种新兴的但有前途的方法,可在基于多个客户端发起的数据训练DNN模型时保护隐私。 联邦学习并未将原始数据汇总到集中的数据中心进行培训,而是将原始数据保留在客户端(例如,移动设备)上,并通过汇总本地计算的更新来在服务器上训练共享模型。 联邦学习的主要挑战是优化和沟通。

对于优化问题,挑战在于通过移动设备上的分布式梯度更新来优化共享模型的梯度。 在此问题上,联邦学习采用SGD。 SGD更新整个数据集的极小子集(最小批量)上的梯度,这是一种简单但广泛使用的梯度下降方法。 Shokri和Shmatikov 设计了一种选择性SGD(SSGD)协议,该协议允许客户独立地对其自己的数据集进行训练,并有选择地将其模型关键参数的一小部分共享给集中的聚合器。 由于SGD易于并行化和异步执行,因此SSGD既可以保护隐私又可以减少培训损失。 特别是,在保护客户自己的隐私的同时,与仅根据他们自己的输入进行培训相比,可以通过在客户之间共享模型来减少培训损失。 [46]的一个缺陷是它没有考虑不平衡且非独立的相同分布(非IID)数据。 作为扩展,McMahan等。 提倡一种称为联合学习的分散方法,并提出了基于迭代模型平均的DNN联合学习的FedAvg方法。 这里,迭代模型平均意味着客户使用一个步骤的SGD在本地更新模型,然后服务器使用权重对所得模型进行平均。[45]中的优化强调了不平衡和非IID的属性,因为分布式数据可能来自各种来源。

对于通信问题,它是不可靠,不可预测的网络给通信效率带来了挑战。 在联邦学习中,每个客户端在典型的回合中将完整模型或完整模型更新发送回服务器。 对于大型机型,由于网络连接不可靠,此步骤可能成为瓶颈。 为了减少训练的轮数,McMahan等提议增加客户端上本地更新的计算。 但是,当客户端受到严格的计算资源约束时,这是不切实际的。 针对这一问题,Koneˇcn´y等人提出用两种新的更新方案来降低通信成本,即结构化更新和速写更新。 在结构化更新中,模型直接从使用较少数量变量(例如低秩或随机掩码)进行参数化的受限空间中学习更新。 如果使用速写的更新,则模型首先学习完整的模型更新,然后使用量化,随机旋转和子采样的组合压缩更新,然后再将其发送到服务器。

尽管联邦学习技术采用了一种新的分散式深度学习架构,但它是基于中央服务器构建的,用于聚合本地更新。 考虑一种在完全分散的网络(即没有中央服务器的网络)上训练DNN模型的场景,Lalitha等人提出了一种基于贝叶斯的分布式算法,其中每个设备通过汇总来自其单跳邻居的信息来更新其信念,以训练一个最适合整个网络观测的模型。 此外,随着新兴的区块链技术,Kim等人提出了区块链联邦学习(BlockFL),通过利用区块链来交换和验证设备模型更新。BlockFL还适用于完全分散的网络,即使某些设备缺乏自己的训练数据样本,也可以在没有任何中央协调的情况下训练ML模型。

2)聚合频率控制:此方法侧重于DNN模型训练期间的通信开销的优化。 在边缘计算环境中训练深度学习模型时,一个普遍采用的想法(例如联邦学习)是先在本地训练分布式模型,然后集中汇总更新。 在这种情况下,更新聚合频率的控制会显着影响通信开销。 因此,应谨慎控制聚合过程,包括聚合内容以及聚合频率。

基于上述观点,Hsieh等人开发Gaia系统和近似同步并行(ASP)模型,用于分布式DNN模型训练。Gaia的基本思想是使数据中心内的通信与数据中心之间的通信脱钩,从而为每个中心启用不同的通信和一致性模型。 为此,开发了ASP模型以动态消除数据中心之间的无关紧要的通信,在这些数据中心中,聚合频率由预设的重要阈值控制。但是,Gaia专注于容量不受限制的地理分布的数据中心,这使得它通常不适用于容量受到高度限制的边缘计算节点。

为了纳入边缘节点的容量约束,Wang等人提出了一种控制算法,该算法确定在给定资源预算下本地更新和全局参数聚合之间的最佳权衡。 该算法基于分布式梯度下降的收敛性分析,可应用于边缘计算中的联邦学习,具有可证明的收敛性。 为了在容量有限的边缘计算环境中实施联邦学习,Nishio和Yonetani 研究了资源受限的客户选择问题。 特别是,开发了一种名为FedCS的更新聚合协议,以允许集中式服务器聚合尽可能多的客户端更新,并加快ML模型中的性能改进。 FedCS的图示如图9所示。

3) 梯度压缩:为了减少分散训练带来的通信开销,梯度压缩是另一种直观的模型更新压缩方法(即梯度信息)。为此,人们提倡梯度量子化和梯度稀疏化。具体地说,梯度量化通过将梯度向量的每个元素量化为有限比特低精度值来执行梯度向量的有损压缩。梯度稀疏化通过传输部分梯度矢量来减少通信开销。

Tao和Li受[53]的启发,提出了一类既有收敛性又有实际性能保证的稀疏格式。为了改进边缘计算中随机目标函数的一阶梯度优化,eSGD包括两种机制:1)确定哪个梯度坐标很重要,仅发送这些坐标; 2)设计动量残差累积,以跟踪过期的残差梯度坐标,以避免稀疏更新导致的低收敛速度。 稀疏SGD的简洁收敛分析在[55]中给出,其中SGD用k稀疏或压缩(例如top-k或random-k)进行分析。 分析表明,在配备错误补偿(跟踪内存中累积的错误)后,该方案的收敛速度与香草SGD相同。 换句话说,通信可以减少问题的大小(有时甚至更多),同时仍以相同的速率收敛。

将梯度量化为低精度值还可以减少通信带宽。 对此,Tang等开发了压缩分散训练的框架,并提出了两种不同的算法,分别称为外推压缩和差分压缩。 对这两种算法的分析证明,两者都以O(1 / n T \sqrt{nT} nT)的速率收敛,其中n是客户数量,T是迭代数量,与收敛速率匹配,从而可以进行全精度,集中式训练。 Amiri和Gunduz 在远程参数服务器的帮助下在无线边缘实现了DSGD,并分别以数字和模拟方案进一步开发了DSGD。 数字DSGD(D-DSGD)假定客户端在DSGD算法的每次迭代时都在多址访问(MAC)容量区域的边界上运行,并采用梯度量化和错误累积在允许的比特预算内传输其梯度估计 通过使用的功率分配。 在模拟DSGD(A-DSGD)中,客户端首先使用误差累积来稀疏其梯度估计,然后将其投影到可用信道带宽所强加的较低维度空间。这些预测直接通过MAC传输,无需使用任何数字代码。

4)DNN拆分:DNN拆分的目的是保护隐私。 DNN拆分通过传输部分处理的数据而不是传输原始数据来保护用户隐私。 为了对DNN模型进行基于边缘的隐私保护训练,在终端设备和边缘服务器之间进行DNN拆分。 这是基于以下重要观察结果:DNN模型可以在两个连续的层之间内部拆分,并且两个分区部署在不同的位置而不会损失准确性。

DNN分割中不可避免的问题是如何选择分割点,以使分布式DNN训练仍处于等待时间要求之下。 关于这个问题,Mao等人利用差分隐私机制,并在第一卷积层之后对DNN进行分区,以最大程度地降低移动设备的成本。[58]中的证明保证了在激活时应用差分隐私机制对于将培训任务外包给不可信的边缘服务器是可行的。Wang等在移动设备和云数据中心之间考虑了这个问题。 为了从云数据中心的计算能力中受益,而没有隐私风险,Wang等人设计Arden(基于Deep nEural Networks的私有信息框架),该框架使用轻量级的隐私保护机制对DNN模型进行了划分。通过任意数据无效和随机噪声添加,Arden实现了隐私保护。 考虑到私人干扰对原始数据的负面影响,Wang等使用一种噪声训练方法来增强云侧网络对数据扰动的鲁棒性。

Osia等引入了一个关于隐私问题的混合用户云框架,该框架利用私有特征提取器作为其核心组件,并分解了大型,复杂的深度模型,以进行协作的隐私保护分析。 在此框架中,特征提取器模块经过适当设计,可以输出受约束的私有特征,以保留主要信息,同时丢弃所有其他敏感信息。 三种不同的技术被用来使敏感措施变得不可预测:降维,添加噪声和Siamese微调。

当将DNN拆分用于隐私保护时,值得注意的是,该技术还可以处理DNN的大量计算。 利用边缘计算通常涉及大量设备这一事实,通常采用并行化方法来管理DNN计算。 并行DNN训练包括两种并行性:数据同等平行性和模型并行性。 但是,数据并行化可能带来大量的通信开销,而模型并行化通常会导致严重不足的计算资源利用率。 为了解决这些问题,Harlap等人提出了管道并行性,这是对模型并行性的增强,其中将多个微型批处理一次注入到系统中,以确保高效并发地使用计算资源。基于管道并行性,Harlap等人设计PipeDream,这是一个支持流水线训练并自动确定如何在可用计算节点上系统划分给定模型的系统。PipeDream具有减少通信开销和有效利用计算资源的优势。图10显示了PipeDream自动机制的概述。

5)知识迁移学习:知识迁移学习,或为简单起见而迁移学习,与DNN拆分技术紧密相连。 在迁移学习中,为了减少在边缘设备上进行DNN模型训练的能源成本,我们首先在基本数据集上训练基础网络(教师网络),然后重新利用学习的功能,即将其转移到第二个目标网络(学生网络)上要训练的目标数据集。如果特性是通用的(即既适用于基本任务也适用于目标任务),而不是特定于基本任务,则此过程将趋于有效。从一般性到特殊性的过渡过程。

迁移学习的方法似乎可以在边缘设备上进行学习,因为它已大大减少了资源需求,但是缺乏对其有效性的透彻研究。 为了弥合这一差距,Sharma等人和Chen等考虑了不同的学生网络体系结构和不同的从老师到学生的知识迁移技术,对迁移学习的性能(准确性和收敛速度)进行了广泛的研究。 结果因架构和传输技术而异。 通过将知识从教师的中间层和最后一层迁移到较浅的学生中,可以获得很好的性能改进,而其他体系结构和转移技术的表现则不太好,其中一些甚至会带来负面的性能影响。

迁移学习技术将一个数据集上经过预训练的DNN的浅层视为通用特征提取器,可以将其应用于其他目标任务或数据集。 利用此功能,迁移学习被用于许多研究中,并激发了某些框架的设计。 Osia等。 我们在第IVC4节中提到的文献[60]使用迁移学习来确定私有功能的普遍性和特殊性。 在[59]中提出的Arden在移动设备和云数据中心之间划分了DNN,原始数据由DNN在移动设备侧的浅层部分进行转换。 正如[59]所指,在Arden中进行DNN拆分的设计是受迁移学习启发的。

6) Gossip训练:Gossip训练是为了缩短训练延迟,是一种基于随机Gossip算法的新型分散训练方法。随机Gossip算法的早期工作是Gossip平均,它可以通过点对点交换信息来快速收敛到节点之间的共识。gossip分布式算法具有完全异步和完全分散的优点,因为它们不需要集中的节点或变量。受此启发,Gossip SGD(GoSGD)被提出以异步和分散的方式训练DNN模型。 GoSGD管理一组独立的节点,其中每个节点承载一个DNN模型,并迭代进行两个步骤:梯度更新和混合更新。具体来说,每个节点在梯度更新步骤中本地更新其托管的DNN模型,然后在混合更新步骤中与另一个随机选择的节点共享其信息,如图11所示。这些步骤重复进行,直到所有DNN收敛于共识为止。

GoSGD的目的是解决加速卷积网络训练的问题。 相反,另一种基于Gossip的算法,Gossip SGD ,旨在保留同步和异步SGD方法的积极特性。 Gossip SGD用 Gossip聚合算法代替了同步训练的所有减少集体操作,从而实现了异步方式。Blot等和Jin等两者在SGD的更新中应用了Gossip算法,但是它们都没有大规模地降低性能收敛。通过部署在大型系统上,Daily等人表明,基于琐碎的Gossip算法大规模地导致了通信不平衡,收敛性差和通信开销大。 为了减轻这些问题,Daily等人介绍GossipGraD,这是一种基于Gossip通信协议的SGD算法,可用于在大规模系统上扩展深度学习算法。GossipGrad将总体通信复杂度从 Θ \Theta Θ( l o g ( p ) log(p) log(p))降低到 O ( 1 ) O(1) O(1),并考虑了扩散,以便计算节点在每个 l o g ( p ) log(p) log(p)步骤之后都直接交换其更新(梯度)。 它还考虑了通信伙伴的旋转,以便在SGD的前馈阶段中促进梯度的直接扩散和异步分布的样本混洗,以防止过度拟合。

D. Summary of Existing Systems and Frameworks

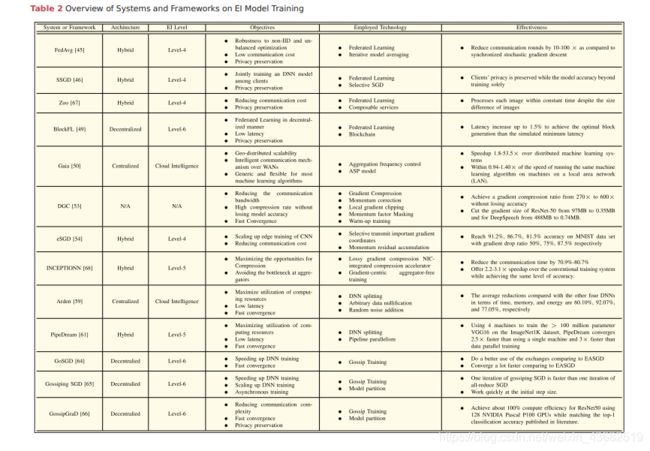

在本节中,我们总结了用于边缘的分布式EI模型训练的系统和框架。 表2给出了上述现有系统和框架的概述,包括体系结构,EI级别,目标,采用的技术和有效性。

通常,分布式EI模型训练的关键挑战是数据隐私问题。 这是因为分布式数据源可能源自每个人的个人和不同的组织。 对于用户而言,他们可能对自己的私人数据敏感,不允许共享任何私人信息。 对于公司而言,他们必须考虑隐私政策,以避免法律传票和法外监视。 因此,分布式培训系统的设计需要仔细考虑隐私保护。 表2中考虑隐私问题的系统包括FedAvg,BlockFL,GossipGraD等。 分散式架构自然可以保护用户的隐私,为此,基于分散式架构的系统(例如BlockFL和GossipGraD)通常可以更好地保护隐私。 相比之下,集中式架构涉及集中式数据收集操作,而混合式架构则需要数据传输操作。 因此,基于这两种体系结构的系统将在数据隐私保护方面进行更多的工作。

与基于云的框架下的DNN培训相比,基于边缘的框架下的DNN培训更加注重保护用户的隐私并更快地训练可用的深度学习模型。 在基于云的训练下,客户端生成的大量原始数据通过长广域网直接传输到云数据中心,不仅造成用户隐私泄露的隐患,而且消耗大量带宽资源。 此外,在某些情况下(例如军事和灾难应用程序),当无法访问云中心时,非常需要基于边缘的培训。 另一方面,云数据中心可以收集更大量的数据并使用更强大的资源来训练AI模型,因此,云智能的优势在于它可以训练更大规模,更准确的模型。

V.EDGE INTELLIGENCE MODEL INFERENCE(边缘智能模型推论)

在深度学习模型的分布式训练之后,在边缘的模型推理的有效实现对于实现高质量EI服务部署至关重要。 在本节中,我们将在边缘讨论DNN模型的推论,包括体系结构,关键性能指标,支持技术以及现有系统和框架。

A. Architectures

除了常见的基于云和设备云的推理架构,我们还定义了几种主要的以边缘为中心的推理架构,并将其分类为四种DNN模型推断模式,分别是基于边缘的,基于设备的,边缘设备和边缘云模式,分别在图12(a)-(d)中进行了说明。 我们描述每种模式的主要工作流程如下。

1)基于边缘的模式:在图12(a)中,设备A处于基于边缘的模式,这意味着设备接收输入数据,然后将其发送到边缘服务器。 当在边缘服务器上完成DNN模型推断时,预测结果将返回到设备。 在这种推理模式下,由于DNN模型位于边缘服务器上,因此很容易在不同的移动平台上实现该应用程序。 但是,主要缺点是推理性能取决于设备和边缘服务器之间的网络带宽。

2)基于设备的模式:在图12(b)中,设备B处于基于设备的模式。 移动设备从边缘服务器获取DNN模型,并在本地执行模型推断。 在推理过程中,移动设备不与边缘服务器通信。 因此,推论是可靠的,但是它需要大量资源,例如移动设备上的CPU,GPU和RAM。 性能取决于本地设备本身。

3)边缘设备模式:在图12(c)中,设备C处于边缘设备模式。 在边缘设备模式下,设备首先根据当前系统环境因素(例如网络带宽,设备资源和边缘服务器工作负载)将DNN模型分为多个部分。 然后,设备将执行DNN模型直到特定层,并将中间数据发送到边缘服务器。 边缘服务器将执行其余的层,并将预测结果发送到设备。与基于边缘的模式和基于设备的模式相比,边缘设备模式更加可靠和灵活。 由于DNN模型前部的卷积层通常需要大量计算,因此在移动设备上也可能需要大量资源

4)边缘云模式:在图12(d)中,设备D处于边缘云模式。 它与边缘设备模式相似,适用于设备资源严重受限的情况。 在这种模式下,设备负责输入数据的收集,并且通过边缘云协同作用执行DNN模型。 该模型的性能在很大程度上取决于网络连接质量。

我们应该强调的是,通过在多个端部有效地分散异构资源,可以在系统中同时采用上述四种以边缘为中心的推理模式,以执行复杂的AI模型推理任务(例如,云-边缘设备层次结构) 设备,边缘节点和云。

B. Key Performance Indicators

为了描述EI模型推断的服务质量,我们介绍了以下五个指标。

1)延迟:延迟是指在整个推理过程中所花费的时间,包括预处理,模型推理,数据传输和后处理。 对于某些实时智能移动应用程序(例如AR / VR移动游戏和智能机器人),它们通常具有严格的期限要求,例如100毫秒的延迟。 延迟指示器受许多因素影响,包括边缘设备上的资源,数据传输方式以及执行DNN模型的方式。

2)准确性:准确性是指从推理中获得正确预测的输入样本数与输入样本总数之比,反映了DNN模型的性能。 对于某些要求高度可靠性的移动应用程序,例如自动驾驶汽车和人脸验证,他们要求DNN模型推断具有超高精度。 除了DNN模型本身的推理能力外,推理准确性还取决于将输入数据馈送到DNN模型的速度。对于视频分析应用程序,由于边缘设备的约束资源,在快速供给速率下,某些输入样本可能会被跳过,从而导致准确性下降。

3)能源:要执行DNN模型,与边缘服务器和云数据中心相比,终端设备通常受电池限制。 DNN模型推论的计算和通信开销带来了大量的能耗。对于EI应用程序,能源效率非常重要,并且受DNN模型的大小和边缘设备上的资源的影响。

4)隐私:物联网和移动设备会生成大量数据,这可能是隐私敏感的。 因此,在模型推断阶段,为EI应用程序保护数据源附近的隐私和数据安全也很重要。 隐私保护取决于处理原始数据的方式。

5)通信开销:除了基于设备的模式外,通信开销会极大地影响其他模式的推理性能。 必须在EI应用程序的DNN模型推断过程中最大程度地减少开销,尤其是云的昂贵WAN带宽使用。这里的通信开销主要取决于DNN推理的模式和可用带宽。

6)内存占用:优化在移动设备上执行DNN模型推断的内存占用是非常必要的。 一方面,通常,高精度DNN模型伴随着数百万个参数,这非常需要移动设备的硬件资源。 另一方面,与云数据中心上的高性能离散GPU不同,移动设备上没有针对移动GPU的专用高带宽内存[69]。 此外,移动CPU和GPU通常会争夺共享和稀缺的内存带宽。 为了在边缘侧优化DNN推断,内存占用量是不可忽略的指标。 内存占用空间主要受原始DNN模型的大小以及加载庞大DNN参数的方式影响。

C. Enabling Technologies

在本节中,我们将介绍用于改进一个或多个上述用于EI模型推断的关键性能指标的支持技术。 表3总结了每种支持技术的重点。

1)模型压缩:为缓解资源匮乏的DNN与资源贫乏的终端设备之间的紧张关系,通常采用DNN压缩来降低模型的复杂性和资源需求,从而实现本地,设备上的推断,进而减少 响应延迟,并减少隐私隐患。 也就是说,模型压缩方法优化了上述四个指标。 延迟,能源,隐私和内存占用。已经提出了各种DNN压缩技术,包括权重修剪,数据量化和紧凑的体系结构设计。

权重修剪代表了最广泛采用的模型压缩技术。 该技术从训练有素的DNN中消除了多余的权重(即神经元之间的连接)。 具体来说,它首先根据神经元的贡献程度对DNN中的神经元进行排名,然后删除低排名的神经元以减小模型大小。 由于去除神经元会损害DNN的准确性,因此如何在保持准确性的同时减小网络规模是关键的挑战。 对于现代大规模DNN,[70]的一项试点研究通过应用基于幅度的权重修剪方法解决了这一挑战。 此方法的基本思想如下:首先,删除幅度低于阈值(例如0.001)的小权重,然后微调模型以恢复准确性。 对于AlexNet和VGG-16,此方法可以将权重数量减少9倍和13倍,而不会降低ImageNet的准确性。 后续工作深度压缩[71]融合了修剪,权重共享和霍夫曼编码等优点来压缩DNN,进一步将压缩比提高到35–49倍。

然而,对于能量受限的终端设备,上述基于大小的权重修剪方法可能无法直接应用,因为经验测量表明,权重数量的减少并不一定会转化为显着的节能效果。 这是因为对于以AlexNet为例的DNN,卷积层的能量支配了总能量成本,而全连接层中的能量占DNN权重总数的大部分。 这表明砝码的数量可能不是能量的良好指标,并且砝码修剪应直接针对终端设备进行能量感知。作为实现这一目标的第一步,一个在线DNN能量估计工具(https://energyestimation.mit.edu/)已经由麻省理工学院开发,以实现快速和简单的DNN能量估算。这种细粒度的工具可以从不同层次的存储器层次结构,MAC的数量以及DNN层粒度的数据稀疏性剖析数据移动的能量。 基于这种能量估计工具,提出了一种称为EAP的能量感知修剪方法。

用于模型压缩的另一种主流技术是数据量化。 代替采用32位浮点格式,此技术使用更紧凑的格式来表示图层输入,权重或两者。 由于用更少的位表示一个数字会减少内存占用并加速计算,因此数据量化可改善总体计算和能源效率。 大多数先前的量化建议仅以固定方式对固定数字类型的位宽进行调整,这可能会导致效果不佳。 为了解决这个问题,最近的工作[76]研究了在层粒度上的最佳数字表示问题,这是基于IEEE 754标准找到规范格式的最佳位宽。 由于可行数字格式的组合爆炸,此问题极具挑战性。 作为回应,作者开发了一种可移植的API,称为数字抽象数据类型(ADT)。 它使用户可以将要量化的数据声明为一层(例如,输入,权重或两者)作为数字类型。 通过这样做,ADT封装了数字的内部表示,从而将开发有效DNN的关注与优化位级别的数字表示的关注分开了。

尽管大多数现有成果都使用单一压缩技术,但它们可能不足以满足某些物联网设备对准确性,延迟,存储和能源的各种要求和约束。 新兴研究表明如何协调不同的压缩技术以最大程度地压缩DNN模型。 例如,深度压缩[71]和密涅瓦[74]都结合了权重修剪和数据量化功能,以实现快速,低功耗和高精度的DNN推理。 最近,研究人员认为,对于给定的DNN,应按需选择压缩技术的组合,即适应应用程序驱动的系统性能(例如,准确性,等待时间和能量)以及不同资源之间的可用性 平台(例如,存储年龄和处理能力)。 为此,拟议的自动优化框架AdaDeep 系统将精确度,等待时间,存储和能量的目标和约束条件表述为统一的优化问题,并利用DRL有效地找到压缩技术的良好组合。

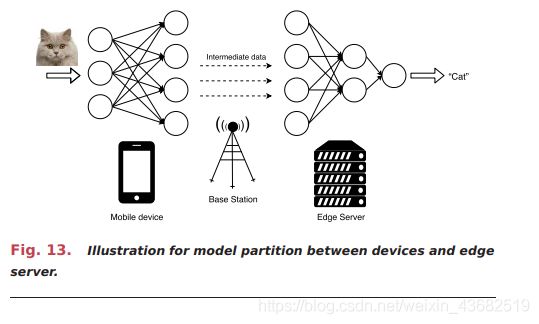

2) 模型划分:为了减轻EI应用在终端设备上执行的压力,如图13所示,一个直观的想法是模型划分,将计算密集的部分卸载到边缘服务器或附近的移动设备上,获得更好的模型推理性能。模型划分主要考虑延迟、能量和隐私问题。

模型分区可以分为两种类型:服务器和设备之间的分区以及设备之间的分区。 对于服务器和设备之间的模型分区,Neurosurgeon [79]代表了标志性的努力。在Neurosurgeon中,DNN模型在设备和服务器之间进行分区,关键的挑战是找出一个合适的分区点以获得最佳的模型推理性能。 作者分别考虑了延迟方面和能源效率方面,提出了一种基于回归的方法来估计DNN模型中每个层的延迟,并返回使模型推断满足延迟要求或能量要求的最佳划分点。

此后,Ko等提出了一种边缘主机划分方法,该方法将模型划分与有损特征编码相结合。 也就是说,模型分区后的中间数据将在传输前使用有损特征编码进行压缩。 此外,JALAD框架结合模型分割和有损特征编码,将模型划分公式化为整数线性规划(ILP)问题,以在保证精度约束的情况下最小化模型推理延迟。对于DNN,它们的特征在于有向无环图(DAG)而不是链,优化模型分区以最大程度地减少延迟被证明通常是NP困难的。 作为回应,Hu等人基于图最小割方法,提出了一种近似算法,该算法提供了最坏情况下的性能保证。 上述框架均假设服务器具有EI应用程序的DNN模型。 IONN 提出了一种用于EI应用的增量卸载技术。 IONN对DNN层进行分区并递增地上传它们,以允许移动设备和边缘服务器进行协作的DNN模型推断。 与上传整个模型的方法相比,IONN显着提高了DNN模型上传期间的查询性能和能耗。

设备之间的分区是另一种类型的分区。作为设备间模型划分的先驱,MoDNN引入了WiFi direct技术,在WLAN中使用多个授权的WiFi支持移动设备构建一个微型计算集群,用于分区DNN模型推理。承担DNN任务的移动设备将成为组所有者,其他充当工作节点。 在MoDNN中,提出了两种分区方案来加速DNN层的执行。 实验表明,使用2到4个工作节点,MoDNN可以将DNN模型推断速度提高2.17–4.28倍。 在后续工作MeDNN [84]中,提出了贪婪的2-D划分,以将DNN模型自适应地划分为多个移动设备,并利用结构化稀疏修剪技术压缩DNN模型。MeDNN使用2到4个工作节点将DNN模型推论提高了1.86–2.44倍,并节省了26.5%的额外计算时间和14.2%的额外通信时间。 请注意,DNN层在MoDNN和MeDNN中是水平划分的,而DeepThings 采用融合的图块划分方法来垂直划分DNN层以减少内存占用。

DeepX 也尝试对DNN模型进行分区,但它仅将DNN模型分区为几个子模型,并将它们分配在本地处理器上。 DeepX提出了两种方案:运行时层压缩(RLC)和深度架构分解(DAD)。 压缩后的层将由特定的本地处理器(CPU,GPU和DSP)执行。 另外需要注意的是,当我们有多个模型划分任务时,需要对调度程序进行优化。 LEO 是一种新颖的传感算法调度程序,它通过对传感算法执行进行分区并在CPU,协处理器,GPU和云上分配任务来最大化多个连续移动传感器应用程序的性能。

3)模型提前退出:高精度的DNN模型通常具有较深的结构。 在终端设备上执行这种DNN模型会消耗大量资源。 为了加快模型推理,模型早期退出方法利用早期层的输出数据获得分类结果,这意味着使用局部DNN模型完成了推理过程。 延迟是模型提前退出的优化目标。

BranchyNet 是一个实现模型早期退出机制的编程框架。 使用BranchyNet,可以通过在某些图层位置添加出口分支来修改标准DNN模型结构。 每个出口分支都是出口点,并且与标准DNN模型共享DNN层的一部分。 图14显示了具有三个五个点的CNN模型。 可以在这些不同的提前退出点对输入数据进行分类。

基于BranchyNet,提出了一个跨云、跨边缘、跨设备的分布式dnn框架DDNNs。DDNNs具有三层结构框架,包括设备层、边缘服务器层和云层。每层代表一个分支网的出口点。提出了最大池(MP)、平均池(AP)和连接(CC)三种聚合方法。当多个移动设备向边缘服务器发送中间数据或多个边缘服务器向云数据中心发送中间数据时,聚合方法有效。MP通过取每个分量的最大值来聚合数据向量。AP通过取每个分量的平均值来聚合数据向量。CC只是简单地将数据向量连接为一个向量。同时,在BranchyNet的基础上,提出了Edgent在模型早期退出和模型划分的联合应用中实现精确的延迟权衡。Edgent的基本思想是通过基于回归的层延迟预测模型,在给定的时延需求下最大限度地提高预测精度。

除了BranchyNet,还有其他方法可以实现模型提前退出。 例如,级联网络只需将MP层和完全连接的层添加到标准DNN模型中,即可实现20%的加速。DeepIns 提出了一种使用DNN模型提前退出的智能行业制造检查系统。 在DeepIns中,边缘设备负责数据收集,边缘服务器充当第一个出口点,云数据中心充当第二个出口点。然后,Lo等建议在基本的BranchyNet模型中添加一个真实的操作(AO)单元。 AO单元通过为不同的DNN模型输出类别设置置信度的不同阈值标准,确定是否必须将输入传输到边缘服务器或云数据中心以进一步执行。 Bolukbasi等训练了一种策略,该策略通过将正则化添加到DNN模型的评估延迟中来确定当前样本是否应继续进行到下一层。

4)边缘缓存:边缘缓存是一种用于加速DNN模型推理的新方法,即通过缓存DNN推理结果来优化延迟问题。边缘缓存的核心思想是在网络边缘缓存和重用任务结果,例如图像分类的预测,从而减少EI应用程序的查询延迟。 图15示出了语义高速缓存技术的基本过程。 如果来自移动设备的请求命中了存储在边缘服务器中的缓存结果,则边缘服务器将返回结果,否则,该请求将被传输到云数据中心以使用全精度模型进行推断。

Glimpse 是将缓存技术引入DNN推理任务的开创性工作。 对于对象检测应用程序,Glimpse建议重用陈旧的检测结果以在当前帧上检测对象。 将检测到的过时帧对象的结果缓存在移动设备上,然后,gissue提取这些缓存结果的子集,并计算处理后的帧与当前帧之间的特征光流。光流的计算结果将指导我们在当前帧中将边界框移动到正确的位置。Glimpse获得1.6-5.5倍的加速。

但是,局部缓存结果的规模不会超过数十个图像,因此提出了Cachier 以实现对数千个对象的识别。 在Cachier中,EI应用程序的结果缓存在边缘服务器中,存储输入的特征(例如图像)和相应的任务结果。 然后,Cachier使用最不常用的(LFS)作为缓存替换策略。 如果输入无法访问缓存,则边缘服务器会将输入传输到云数据中心。 Cachier可以将响应速度提高3倍或更多。 Precog 是Cachier的扩展。 在Precog中,缓存的数据不仅存储在边缘服务器中,而且存储在移动设备中。 Precog使用Markov链的预测将数据预取到移动设备上,并加速5倍。 此外,Precog还建议根据环境信息动态调整移动设备上的缓存特征提取模型。 Shadow Puppets是Cachier的另一个改进版本。 Cachier使用标准的特征提取(例如局部敏感哈希(LSH))从输入中提取特征,但是这些特征可能无法像人类剂量那样精确地反映出相似性。 然后,在Shadow Puppets [96]中,它使用小尺寸DNN生成代表输入数据的哈希码,并显着提高了5-10倍的延迟。

考虑到同一应用程序在非常接近的多个设备上运行并且DNN模型经常处理相似的输入数据的应用场景,建议使用FoggyCache 来最小化这些冗余计算。 FoggyCache中存在两个挑战:一个是输入数据的分布未知,因此问题在于如何以恒定的查询质量索引输入数据,另一个是如何表示输入数据的相似性。 为了解决这两个挑战,FoggyCache分别提出了自适应LSH(A-LSH)和同源kNN(H-kNN)方案。 FoggyCache将计算延迟和能耗降低了3倍至10倍。

5)输入过滤:输入过滤是加速DNN模型推断的有效方法,尤其是对于视频分析而言。 如图16所示,输入过滤的关键思想是删除输入数据的非目标对象帧,避免DNN模型推理的冗余计算,从而提高了推理精度,缩短了推理延迟,并降低了能源成本。

NoScope 被提议通过跳过几乎没有变化的帧来加速视频分析。 为此,NoScope实现了一个差异检测器,该差异检测器突出显示了帧之间的时间差异,例如,检测器监视帧以检查汽车是否出现在框架中,并且带有汽车的框架将在DNN模型推断中进行处理。 通过使用轻量级二进制分类器可以检测到差异。 在无人驾驶飞机连续视频传输的情况下,Wang等人针对DNN推理的第一跳无线带宽进行了优化。 特别是,提出了四种减少总传输量的策略:EarlyDiscard,即时学习(JITL),Reachback和Context-Aware。

FFS-VA [100]是用于多级视频分析的流水线系统。 FFS-VA过滤系统的构建分为三个阶段。 第一个是专用于数据流的不同检测器(SDD),用于删除仅包含背景的帧。 第二个是用于识别目标对象帧的流专用网络模型(SNM)。 第三个是Tiny-YOLO-Voc(T-YOLO)模型,用于删除目标对象小于阈值的帧。 Canel等提出了一种用于视频分析的两阶段过滤系统。 它首先通过输出DNN的中间数据来提取帧的语义内容,然后将这些输出特征累积在帧缓冲区中。 缓冲区被视为DAG,并且过滤系统使用欧几里得距离作为相似性度量来计算出前k个有趣的帧。

上述框架集中于针对单个相机时代过滤视频流的无用帧。 ReXCam 加快了跨摄像机分析的DNN模型推断。 ReXCam利用学习到的时空模型来过滤视频帧。 ReXCam减少了4.6倍的计算工作量,并将DNN模型的推理精度提高了27%。

6)模型选择:提出了一种模型选择方法来优化DNN推理的时延,准确性和能量问题。 模型选择的主要思想是,我们可以先离线训练具有各种模型尺寸的一组DNN模型,以完成同一任务,然后自适应地选择模型以在线进行推理。 模型选择类似于模型提前退出,并且模型提前退出机制的退出点可以视为DNN模型。 但是,关键的区别在于出口点与主分支模型共享DNN层的一部分,并且模型选择机制中的模型是独立的。

Park等提出了一个大/小DNN模型选择框架。 也就是说,使用小而快速的模型来尝试对输入数据进行分类,而仅当小模型的置信度小于预定义的阈值时才使用大模型。 泰勒等指出,不同的DNN模型(例如MobileNet,ResNet和Inception)在不同图像的不同评估指标(top-1或top-5)上达到最低的推理延迟或最高的准确性。 然后,他们提出了一个在延迟和准确性方面选择最佳DNN的框架。 在此框架中,训练了模型选择器以为不同的输入图像选择最佳的DNN。 同样,IF-CNN [105]还训练了一个称为识别预测器(RP)的模型选择器,以更改任务中使用的模型。 RP是多任务的DNN模型,这意味着RP具有多个输出。 RP的输出表示每个候选DNN模型的top-1标签的概率。 RP的输入是图像,如果RP的输出超过预定义的阈值,则将选择相应的DNN模型。

除了针对DNN模型推理延迟的优化之外,Stamoulis等人还着眼于节能。 [106]通过考虑设备施加的准确性和通信约束,将自适应DNN模型选择问题转换为超参数优化问题。 然后,采用贝叶斯优化(BO)来解决此问题,在精度约束下,每幅图像的最小能量方面可提高多达6倍。

7)支持多租户:实际上,一台终端或边缘设备通常同时运行多个DNN应用程序。 例如,用于互联网车辆的高级驾驶员辅助系统(ADAS)同时运行DNN程序,以进行车辆检测,行人检测,交通标志识别和车道线检测。在这种情况下,多个DNN应用程序将争夺有限的资源。 如果没有对多租户的仔细支持,即那些并发应用程序的资源分配和任务调度,全局效率将大大降低。 对多租户的支持着重于能源和内存占用的优化。

考虑到运行时资源的动态性,建议使用NestDNN [107]为每个DNN模型提供灵活的资源-准确性折衷方案。NestDNN实施了新的模型修剪和恢复方案,将DNN模型转换为包含一组降级模型的单个紧凑型多容量模型。 每个后代模型都提供了独特的资源-准确性权衡。 对于每个并发下降模型,NestDNN将其准确性和等待时间编码为成本函数,然后构建资源准确性运行时调度程序以对每个并发后代模型进行最佳权衡。 此外,为解决实现灵活权衡的挑战,Mainstream 使用流行的转移学习DNN训练方法来训练具有不同准确度的多个DNN模型,并采用贪婪的方法来找到适合成本预算的最佳调度程序 。 为了在一台设备上执行多个DNN模型,提出了HiveMind 来提高这些并发工作负载的GPU利用率。 HiveMind由两个关键组件组成:编译器和运行时模块。 编译器优化了跨工作负载的数据传输,数据预处理和计算,然后,运行时模块将优化的模型转换为执行DAG,该DAG将在GPU上执行,同时尝试提取尽可能多的并发性。

在更好的粒度下,DeepEye 被提出通过调度异构DNN层的执行来优化移动设备上的多任务推理。DeepEye首先将所有任务的DNN层分为两个池:卷积层和完全连接的层。 对于卷积层,采用基于先进先出(先进先出)队列的执行策略。 对于完全连接的层,DeepEye采用贪婪方法来缓存完全连接的层的参数,以最大程度地利用内存。

8)特定于应用程序的优化:虽然上述优化技术通常适用于EI应用程序,但是可以利用特定于应用程序的优化来进一步优化EI应用程序的性能,即准确性,延迟,能耗和内存占用。 例如,对于基于视频的应用,可以灵活地调节两个旋钮,即帧频和分辨率,以减少资源需求。 但是,由于这种对资源敏感的旋钮也会降低推理精度,因此它们自然会导致成本准确性的折衷。 这要求我们在调整视频帧速率和分辨率时在资源成本和推理精度之间取得良好的平衡。

为了实现上述目标,Chameleon 通过在每个任务之间共享最佳的top-k配置来调整每个视频分析任务的旋钮。在Chameleon中,视频任务根据空间相关性进行分组,然后由组长搜索出最佳的top-k配置并与跟随者共享。DeepDecision 将旋钮调整问题表述为多项选择的多约束背包程序,并使用改进的蛮力搜索方法解决了该问题。

还值得注意的是,在计算机体系结构社区中,用于有效DNN推理的硬件加速一直是非常热门的话题,并且已进行了广泛的研究。 鼓励感兴趣的读者参考最新的专着,以更全面地讨论DNN处理的硬件加速方面的最新进展。

D. Summary of Existing Systems and Frameworks

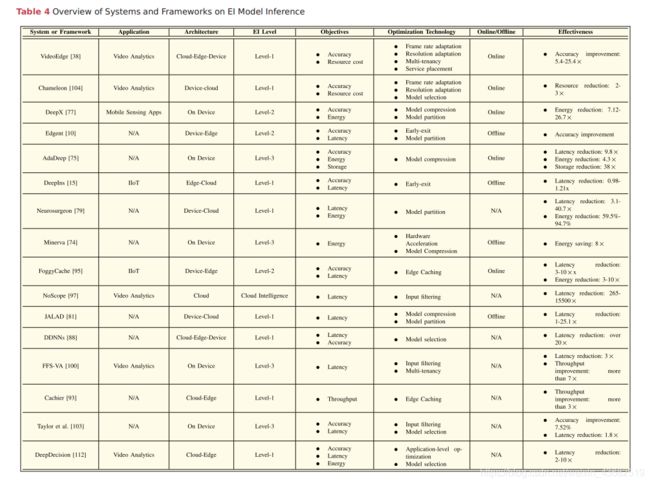

为了展示上述使能技术在EI模型推理中的应用,表4总结了相关的系统和框架,包括目标应用,体系结构和EI级别,优化目标和采用的技术以及有效性的观点。

显然,现有系统和框架采用了针对特定EI应用程序和要求量身定制的支持技术的不同子集。 为了最大程度地提高通用EI系统的整体性能,应全面配合使能技术和各种优化方法,以提供丰富的设计灵活性。 然而,我们将面临一个高维配置问题,该问题是实时确定大量性能关键型配置参数所必需的。 以视频分析为例,高维配置参数可以包括视频帧速率,分辨率,模型选择和模型提前退出。 由于组合的性质,高维配置问题涉及巨大的参数搜索空间,并且很难解决。

VI.FUTURE RESEARCH DIRECTIONS

在上面对现有工作进行的全面讨论的基础上,我们现在阐述了EI的关键开放挑战和未来研究方向。

A. Programming and Software Platforms(编程和软件平台)

当前,世界各地许多公司都专注于AI云计算服务供应。 一些领先的公司还开始提供程序定位/软件平台来提供边缘计算服务,例如亚马逊的Greengrass,微软的Azure IoT Edge和Google的Cloud IoT Edge。 然而,目前,大多数这些平台主要充当中继器,以连接到功能强大的云数据中心。

随着越来越多的AI驱动的计算密集型移动和物联网应用的出现,EI作为一种服务(EIaaS)可以成为一种普遍的范例,具有强大的边缘AI功能的EI平台将得到开发和部署。 这与公共云提供的ML即服务(MLaaS)完全不同。 本质上,MLaaS属于云智能,它专注于选择适当的服务器配置和ML框架,以经济高效的方式在云中训练模型。 与之形成鲜明对比的是,EIaaS更加关注如何在资源受限且对隐私敏感的边缘计算环境中执行模型训练和推理。 要完全实现EI服务的潜力,需要克服几个关键挑战。 首先,EI平台应该是异构兼容的。 将来,有许多分散的EI服务提供商/供应商,应该设置通用的开放标准,以便用户可以随时随地在异构EI平台上享受无缝,流畅的服务。 其次,有许多可用的AI程序命名框架(例如Tensorflow,Torch和Caffe)。 将来,应支持由不同编程框架在异构分布式边缘节点上训练的边缘AI模型的可移植性。 第三,有许多专门为边缘设备设计的编程框架(例如TensorFlow Lite,Caffe2,CoreML和MXNet); 然而,实证测量[115]表明,在所有指标上,没有哪个胜过其他框架。将来可以期望在更多指标上有效执行的框架。 最后但并非最不重要的一点是,应进一步探索轻量级虚拟化和计算技术,例如容器和函数计算,以实现在资源受限的边缘环境中进行有效的EI服务放置和迁移。

B. Resource-Friendly Edge AI Model Design(资源友好型Edge AI模型设计)

许多现有的AI模型(例如CNN和LSTM)最初是为计算机视觉和自然语言处理等应用程序设计的。 大多数基于深度学习的AI模型都是高度资源密集型的,这意味着由丰富的硬件资源(例如GPU,现场可编程门阵列(FPGA)和TPU)支持的强大计算能力对于提升应用程序的开发水平至关重要。 这些AI模型的性能。 如上所述,因此有许多研究利用模型压缩技术(例如,权重修剪)来调整AI模型的大小,从而使其对边缘部署更加资源友好。

沿着不同的路线,我们可以促进资源感知的边缘AI模型设计。 代替利用现有的资源密集型AI模型,我们可以利用AutoML想法[116]和神经体系结构搜索(NAS)技术[117]设计出针对硬件资源约束量身定制的资源有效的边缘AI模型。 基础边缘设备和服务器。 例如,可以采用诸如RL,遗传算法和BO之类的方法,通过考虑硬件资源(例如CPU和硬件)的影响来有效地搜索AI模型设计参数空间(即AI模型组件及其连接)。 内存)对性能指标的约束,例如执行延迟和能耗。

C. Computation-Aware Networking Techniques(计算感知网络技术)

对于EI,基于计算的AI密集型应用程序通常在分布式边缘计算环境上运行。 结果,非常需要具有计算意识的高级联网解决方案,从而可以在不同的边缘节点之间有效地共享计算结果和数据。

对于未来的5G网络,已经为要求低延迟和高可靠性的关键任务应用场景定义了超可靠的低延迟通信(URLLC)。 因此,将5G URLLC功能与边缘计算相集成以提供超可靠的低延迟EI(URLL-EI)服务将是有希望的。 此外,5G将采用诸如软件定义的网络和网络功能虚拟化之类的先进技术。 这些技术将实现对网络资源的灵活控制,以支持计算密集型AI应用程序跨不同边缘节点的按需互连。

另一方面,自主网络机制设计对于在动态异构网络共存(例如LTE / 5G / WiFi / LoRa)下实现有效的EI服务配置非常重要,从而允许新添加的边缘节点和设备在网络中进行自我配置。 即插即用的方式。 同样,计算感知通信技术也开始引起人们的注意,例如梯度编码[118]以减轻分布式学习中的散乱效应和DSGD的空中计算[119],这对于边缘AI可能很有用。 模型训练加速度。

D. Tradeoff Design With Various DNN Performance Metrics(具有各种DNN性能指标的权衡设计)

对于具有特定任务的EI应用程序,通常会有一系列能够完成任务的DNN模型候选者。 但是,软件开发人员很难为EI应用程序选择合适的DNN模型,因为诸如top-k精度或平均平均精度之类的标准性能指标无法反映边缘设备上DNN模型推断的运行时性能。 例如,在EI应用程序部署阶段,除准确性外,推断速度和资源使用情况也是关键指标。 我们需要探索这些指标之间的权衡,并确定影响它们的因素。

对于目标识别应用,Huang等人研究主要因素,如建议数、输入图像大小、特征提取器的选择对推理速度和准确性的影响。根据他们的实验结果,发现这些因素的新组合优于最新方法。 因此,有必要探索不同指标之间的权衡,以帮助提高EI应用程序的部署效率。

E. Smart Service and Resource Management(智能服务和资源管理)

由于边缘计算的分布式特性,提供EI功能的边缘设备和节点分散在不同的地理位置和区域中。 不同的边缘设备和节点可以运行不同的AI模型并部署不同的特定AI任务。 因此,重要的是设计有效的服务发现协议,以便用户可以识别和定位相关的EI服务提供商,以及时满足其需求。 同样,为了充分利用跨边缘节点和设备的分散资源,将复杂的边缘AI模型划分为小的子任务并有效地将这些任务卸载到边缘节点和设备之间以进行协作执行是必不可少的。

由于对于许多EI应用场景(例如,智能城市),服务环境具有高动态性,因此很难准确预测未来事件。 结果,它将需要出色的在线边缘资源编排和配置功能,以连续容纳大量的EI任务。 实时联合优化异构计算,通信和缓存资源分配以及针对各种任务需求量身定制的高维系统参数配置(例如选择适当的模型训练和推理技术)至关重要。 为了解决算法设计的复杂性,一个新兴的研究方向是利用诸如DRL之类的AI技术,以数据驱动的自学方式来适应高效的资源分配策略。

F. Security and Privacy Issues(安全和隐私问题)

边缘计算的开放性强加要求分散的信任,使得不同实体提供的EI服务值得信赖。 因此,轻量级和分布式安全机制设计对于确保用户身份验证和访问控制,模型和数据完整性以及EI的相互平台验证至关重要。 同样,在考虑可信边缘节点与恶意边缘节点的共存时,研究新颖的安全路由方案和用于EI服务交付的信任网络拓扑也很重要。

另一方面,最终用户和设备将在网络边缘生成大量数据,并且这些数据可能包含隐私信息,因为它们可能包含用户的位置数据,健康或活动记录或制造信息等。根据隐私保护要求(例如欧盟的通用数据保护法规(GDPR)),在多个边缘节点之间直接共享原始数据集可能会导致隐私泄漏的风险很高。 因此,联合学习对于隐私友好的分布式数据训练可能是一种可行的范例,这样原始数据集将保留在其生成的设备/节点中,并且共享边缘AI模型参数。 为了进一步增强数据隐私,越来越多的研究工作致力于使用差分隐私和同态加密以及安全的多方计算工具来设计保护隐私的AI模型参数共享方案。

G. Incentive and Business Models(激励和商业模式)

EI生态系统将是一个由EI服务提供商和用户组成的大型开放式财团,包括但不限于:平台提供商(例如Amazon),AI软件提供商(例如SenseTime),边缘设备提供商(例如Hikvision) ,网络运营商(例如AT&T),数据生成器(例如IoT和移动设备所有者)和服务使用者(即EI用户)。 EI服务的高效运营可能需要跨不同服务提供商的紧密协作和集成,例如,以实现扩展的资源共享和平滑的服务切换。 因此,适当的激励机制和商业模式对于激发EI生态系统所有成员之间的有效合作至关重要。 同样,对于EI服务,用户可以是服务使用者,同时也可以是数据生成器。 在这种情况下,需要一种新颖的智能定价方案来考虑用户的服务消耗及其数据贡献的价值。

作为分散协作的一种手段,可以通过在分散边缘服务器上运行,将带有智能合约的区块链集成到EI服务中。 有必要进行研究如何根据EI的工作量证明如何聪明地收取价格并在EI生态系统中的成员之间正确分配收入。 此外,非常需要为EI设计资源友好的轻量级区块链共识协议。

VII.CONCLUSION

在AI和IoT蓬勃发展的推动下,迫切需要将AI前沿从云推进到网络边缘。 为了满足这一趋势,边缘计算已被广泛认为是一种在资源受限的环境中支持计算密集型AI应用程序的有前途的解决方案。 边缘计算和AI之间的联系催生了EI的新颖范式。

在本文中,我们对EI的最新研究工作进行了全面调查。 具体来说,我们首先回顾了在网络边缘运行AI的背景和动机。 然后,我们提供了针对深度学习模型的总体架构,框架和新兴关键技术的概述,以用于在网络边缘进行训练和推理。 最后,我们讨论了EI面临的开放挑战和未来的研究方向。

我们希望这项调查能够引起越来越多的关注,激发出富有成果的讨论,并激发有关EI的进一步研究思路。