ElasticSearch分布式搜索引擎从入门到实战应用(入门篇-基本命令操作)

ElasticSearch分布式搜索引擎从入门到实战应用(入门篇)

- 1、入门须知

- 2、ElasticSearch概述

-

- 2.1、ES简介

- 2.2、应用场景

- 3、ES和Solr的对比

-

- 3.1、ES作用

- 3.2、Solr作用

- 3.3、实际应用对比

- 3.4、总结

- 4、ElasticSearch安装

-

- 4.1、下载安装es

- 4.2、安装elasticSearch-head插件(es可视化界面)

- 5、安装kibana

-

- 5.1、下载kibana

- 5.2、安装

- 5.3、启动

- 5.4、kibana汉化

- 6、了解ELK

- 7、ElasticSearch核心概念

-

- 7.1、ES核心概念

- 7.2、物理设计

- 7.3、逻辑设计

- 8、IK分词器(插件)

-

- 8.1、IK分词器:中文分词器

- 8.2、自定义词典库

- 9、ES基于Rest风格调用说明

-

- 9.1、基本Rest请求说明

- 9.2、测试无条件请求

- 9.3、解决Kibana驱动报错

- 9.4、测试带条件请求(重点)

-

- 9.4.1、简单条件查询

- 9.4.2、复杂条件查询

- 9.4.3、text和keyword字段类型的区别(重点)

- 9.4.4、高亮查询

1、入门须知

笔记记录来源B站狂神的ElasticSearch课程:https://www.bilibili.com/video/BV17a4y1x7zq

-

世界搜索引擎排行榜:https://db-engines.com/en/ranking/search+engine

-

注意这句话(看了这句,就知道这哥有多强了!!!)。

#关于 I am a founder of the Apache Lucene, Nutch, Hadoop and Avro open source projects. I served for six years on Apache's Board of Directors, three as its chair. #翻译 我是Apache Lucene, Nutch, Hadoop和Avro开源项目的创始人。 我在阿帕奇董事会工作了6年,其中3年是主席。 -

Lucene是用Java语言编写的,目标是为各种中小型应用软件加入全文检索功能。

-

2001年,Lucene称为Apache软件基金会 jakarta项目的一个子项目。

-

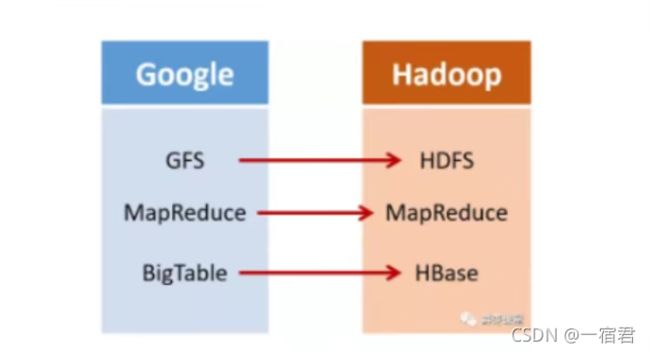

2003年,谷歌发表了一篇学术论文,公开介绍GFS(Google File System),是谷歌为了存储海量搜索数据专门设计的文件系统。

-

2004年,Doug cutting在Lucene的基础之上,和Apache的开源伙伴Mike Cafarella一起开发了一个可以代替当时主流搜索的开源搜索引擎,命名为

Nutch。 -

Nutch是一个建立在Lucene核心之上的网页搜索应用程序,Nutch在在Lucene的基础上增加了网络爬虫和一些网页相关的功能,目的是为了从简单的站内检索推广到全球网络的搜索上,就想Google一样。

-

2004年,同年Doug cutting基于Google的GFS论文,实现了分布式文件存储系统,并将其命名为NDFS(Nutch Distributed File System)。

-

2004年,Google又发表了一篇学术论文,介绍了MapReduce编程模型,用于大规模数据集(大于1TB)的并行分析运算。

-

2006年,Doug cutting加入了Yahoo(雅虎),他将NDFS和MapReduce进行了升级改造,并将其命名为Hadoop(NDFS也改名为HDFS,Hadoop Distributed File System)。

-

这就是大名鼎鼎的大数据框架系统—Hadoop的由来,Doug cutting也被称为hadoop之父 (没错,

hadoop的logo就是来源于他儿子的玩具大象)。

-

2006年,Google又发布学术论文,介绍了自己的BigTable,这是一种分布式数据存储系统,用来处理海量数据的非关系型数据库,同时Doug cutting在自己的hadoop系统里面,引入了BigTable,并将其命名为大名鼎鼎的Hbase。

-

上面说了那么多,其实对于Doug cutting就一句话,Google出什么,我用什么!

-

2008年,hadoop成为Apache基金会的顶级项目。

2、ElasticSearch概述

2.1、ES简介

ElasticSearch,简称es,es是一个开源的高扩展的分布式全文检索引擎,它可以近乎实时的存储检索、检索数据;本身扩展性很好,可以扩展到上百太服务器,处理PB级别(大数据时代)的数据。es也是使用Java语言开发的,并使用Lucene作为其核心来实现索引和搜索的功能,但是它的目的是通过简单的RESTFUL API,来隐藏Lucene的复杂性,从而让全文搜索变得简单。

2.2、应用场景

- 1、维基百科,类似百度百科,全文检索,高亮,搜索推荐(权重,做的最好的国内是百度)。

- 2、The Guardian (国外新闻网站) ,类似搜狐新闻,用户行为日志(点击,浏览,收藏,评论) +社交网络数据(对某某新闻的相关看法) ,数据分析,给到每篇新闻文章的作者,让他知道他的文章的公众反馈(好,坏,热门,垃圾,鄙视,崇拜)

- 3、Stack Overflow (国外的程序异常讨论论坛) , IT问题,程序的报错,提交上去,有人会跟你讨论和回答,全文检索,搜索相关问题和答案,程序报错了,就会将报错信息粘贴到里面去,搜索有没有对应的答案

- 4、GitHub (开源代码管理),搜索 上千亿行代码

- 5、电商网站,检索商品

- 6、日志数据分析, logstash采集日志, ES进行复杂的数据分析, ELK技术,

elasticsearch+logstash+kibana - 7、商品价格监控网站,用户设定某商品的价格阈值,当低于该阈值的时候,发送通知消息给用户,比如说订阅牙膏的监控,如果高露洁牙膏的家庭套装低于50块钱,就通知我,我就去买

- 8、BI系统,商业智能, Business Intelligence。比如说有个大型商场集团,BI ,分析一下某某区域最近3年的用户消费 金额的趋势以及用户群体的组成构成,产出相关的数张报表, **区,最近3年,每年消费金额呈现100%的增长,而且用户群体85%是高级白领,开-个新商场。ES执行数据分析和挖掘, Kibana进行数据可视化

- 9、国内:站内搜索(电商,招聘,门户,等等),IT系统搜索(OA,CRM,ERP,等等),数据分析(ES热门

的一一个使用场景)

3、ES和Solr的对比

3.1、ES作用

- Elasticsearch是一个实时分布式搜索和分析引擎。 它让你以前所未有的速度处理大数据成为可能。

- 它用于全文搜索、结构化搜索、分析以及将这三者混合使用:

- 维基百科使用Elasticsearch提供全文搜索并高亮关键字,以及输入**实时搜索(search-asyou-type)和搜索- 纠错(did-you-mean)**等搜索建议功能。

- 英国卫报使用Elasticsearch结合用户日志和社交网络数据提供给他们的编辑以实时的反馈,以便及时了解公众对新发表的文章的回应。

- StackOverflow结合全文搜索与地理位置查询,以及more-like-this功能来找到相关的问题和答案。

- Github使用Elasticsearch检索1300亿行的代码。

- 但是Elasticsearch不仅用于大型企业,它还让像DataDog以及Klout这样的创业公司将最初的想法变成可扩展的解决方案。

- Elasticsearch可以在你的笔记本上运行,也可以在数以百计的服务器上处理PB级别的数据。

- Elasticsearch是一个基于Apache Lucene™的开源搜索引擎。无论在开源还是专有领域, Lucene可被认为是迄今为止最先进、性能最好的、功能最全的搜索引擎库。

- Lucene只是一个库,想要使用它,你必须使用Java来作为开发语言并将其直接集成到你的应用中,更糟糕的是, Lucene非常复杂,你需要深入了解检索的相关知识来理解它是如何工作的。

- Elasticsearch也使用Java开发并使用Lucene作为其核心来实现所有索引和搜索的功能,但是它的目的是通过简单的RESTful API来隐藏Lucene的复杂性,从而让全文搜索变得简单。

3.2、Solr作用

- Solr是Apache下的一个顶级开源项目,采用Java开发,它是基于Lucene的全文搜索服务器。Solr提供了比Lucene更为丰富的查询语言,同时实现了可配置、可扩展,并对索引、搜索性能进行了优化

- Solr可以独立运行,运行在letty. Tomcat等这些Selrvlet容器中 , Solr 索引的实现方法很简单,用POST方法向Solr服务器发送一个描述Field及其内容的XML文档, Solr根据xml文档添加、删除、更新索引。Solr 搜索只需要发送HTTP GET请求,然后对Solr返回xml、json等格式的查询结果进行解析,组织页面布局。

- Solr不提供构建UI的功能, Solr提供了一个管理界面,通过管理界面可以查询Solr的配置和运行情况。

- Solr是基于lucene开发企业级搜索服务器,实际上就是封装了lucene.

- Solr是一个独立的企业级搜索应用服务器,它对外提供类似于Web-service的API接口。用户可以通过http请求,向搜索引擎服务器提交-定格式的文件,生成索引;也可以通过提出查找请求,并得到返回结果。

3.3、实际应用对比

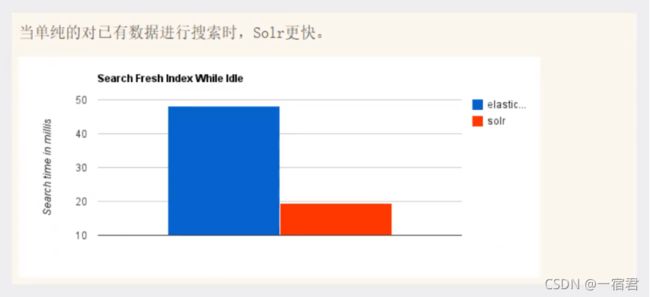

1、当单纯的对已有数据进行搜索时,Solr更快

2、当实时建立索引时,Solr会产生io阻塞,查询性能较差,ElasticSearch具有明显的优势

3、随着数据量的增加,Solr的搜索效率会变得更低,而ElasticSearch却没有明显的变化

4、转变我们的搜索基础设施后从Solr ElasticSearch,我们看见一个即时~ 50x提高搜索性能!

3.4、总结

1、es基本是开箱即用(解压就可以用!) ,非常简单。Solr安装略微复杂一丢丢!

2、Solr 利用Zookeeper进行分布式管理,而Elasticsearch自身带有分布式协调管理功能。

3、Solr 支持更多格式的数据,比如JSON、XML、 CSV ,而Elasticsearch仅支持json文件格式(现今json格式是主流形式,基本能够满足绝大部分应用场景)。

4、Solr 官方提供的功能更多,而Elasticsearch本身更注重于核心功能,高级功能多有第三方插件提供,例如图形化界面需要kibana友好支撑。

5、Solr 查询快,但更新索引时慢(即插入删除慢) ,用于电商等查询多的应用;

- ES建立索引快(即查询慢) ,即实时性查询快,用于facebook新浪等搜索。

- Solr是传统搜索应用的有力解决方案,但Elasticsearch更适用于新兴的实时搜索应用。

6、Solr比较成熟,有一个更大,更成熟的用户、开发和贡献者社区,而Elasticsearch相对开发维护者较少,更新太快,学习使用成本较高。

4、ElasticSearch安装

- ElasticSearch是基于lucence开发的,也就是运行需要java jdk支持。所以要先安装JAVA环境。

- 由于ElasticSearch 5.x 往后依赖于JDK 1.8的,我们此处讲解

ElasticSearch是7.6.1版本的,所以最低版本要求,jdk8。 - 使用Java开发,必须保证ElasticSearch的版本与Java的核心jar包版本对应!

- 如果是linux的话,1核1G的基本跑不起来,为了方便演示,此处我们暂时在windows下操作,后续再去学习在linux下搭建es集群。

4.1、下载安装es

1、下载

- Elasticsearch: 权威指南文档(可能有些已经过时,仅作为参考)

- 官网下载地址(是最新版本):https://www.elastic.co/cn/downloads/

- 官网所有的历史版本:https://www.elastic.co/cn/downloads/past-releases#elasticsearch

2、安装(直接解压即可)

介绍下相关目录及其下的文件的作用:

bin:启动文件目录

config:配置文件目录

1og4j2:日志配置文件

jvm.options:java虚拟机相关的配置(默认启动占1g内存,内存不够的话可以自己调整)

elasticsearch.ym1:es的配置文件! 默认9200端口!跨域!

1ib :相关jar包

modules:功能模块目录

plugins:插件目录,eg:ik分词器

3、进入bin目录,双击elasticsearch.bat启动es

只要能看到started,就说明是启动成功了,此时我们直接访问地址http://127.0.0.1:9200/

4.2、安装elasticSearch-head插件(es可视化界面)

1、下载elasticsearch-head插件

2、下载node(如果已经安装过可以掠过此步骤)

3、安装grunt(这一步也可以省略,不是必须的,当然安装了也没啥影响,可以选用)

- grunt是一个很方便的构建工具,可以进行打包压缩、测试、执行等等的工作,elasticsearch-head-5.x里之后的插件支持通过grunt启动。

- 安装grunt

npm install -g grunt-cli - 查看版本号

grunt -version

4、启动elasticsearch-head

- 尽量将elasticsearch-head和elasticsearch放在同一个目录下

- 打开cmd窗口进入elasticsearch-head-master目录下

- 首先安装依赖(此处是为安装进行安装pathomjs)

#npm安装 npm install(是国外的镜像,速度会比较慢,还容易安装出错) #cnpm安装(推荐) cnpm install(cnpm是国内的淘宝镜像,安装比较快) #如果cnpm命令不可用,可以使用如下方式配置淘宝镜像 npm install -g cnpm -registry=https://registry.npm.taobao.org #查看cnpm的版本(出现版本信息说明是安装成功) D:\dev\elasticsearch\elasticsearch-head-master>cnpm -v cnpm@7.1.0 (C:\Users\admin\AppData\Roaming\npm\node_modules\cnpm\lib\parse_argv.js) npm@6.14.15 (C:\Users\admin\AppData\Roaming\npm\node_modules\cnpm\node_modules\npm\lib\npm.js) node@16.13.0 (D:\Sfotware\node\node.exe) npminstall@5.2.2 (C:\Users\admin\AppData\Roaming\npm\node_modules\cnpm\node_modules\npminstall\lib\index.js) prefix=C:\Users\admin\AppData\Roaming\npm win32 x64 10.0.19042 registry=https://registry.npmmirror.com #然后再次 cnpm install - 启动

# 启动 npm run start #或者是使用上述安装的grunt工具(都可以) grunt server

- 访问地址

http://localhost:9100

5、跨域问题

- 存在跨域问题(只有当两个页面同源,才能交互)

- 同源(端口,主机,协议三者都相同)

- https://blog.csdn.net/qq_38128179/article/details/84956552

- 上述出现跨域问题是因为两个端口不一致

6、修改es的参数,允许es被跨域访问,编辑文件config/elasticsearch.yml

# 开启跨域

http.cors.enabled: true

# 所有人访问

http.cors.allow-origin: "*"

7、重启启动es,刷新elasticsearch-head,再次连接

8、如何理解上图(对于初学者来说,姑且认为如下,理解即可)

- 索引:可以看做 “数据库”

- 类型:可以看做 “表”

- 文档:可以看做 “库中的数据(表中的行)”

- 这个head,我们只是把它当做可视化数据展示工具,因为它不支持json格式化,不方便操作,之后我们所有的查询都在

kibana工具中进行,后续安装。

5、安装kibana

5.1、下载kibana

- 官网下载地址(最新版本):https://www.elastic.co/cn/downloads/

- 历史版本下载地址:https://www.elastic.co/cn/downloads/past-releases/

切忌!!!kibana要和elasticsearch版本保持一直!!!

5.2、安装

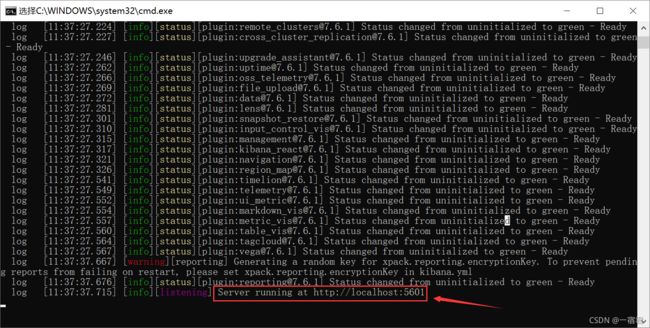

5.3、启动

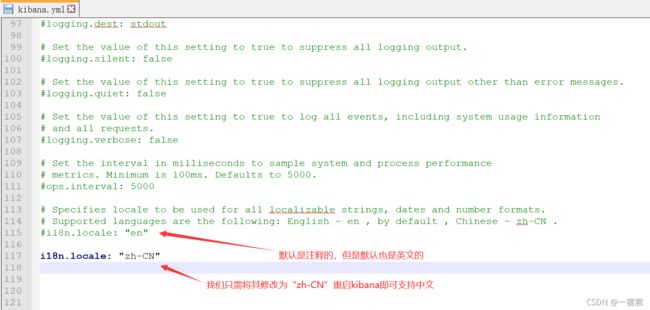

5.4、kibana汉化

- kibana是必经是大数据操作工具,不熟悉大数据里面很多名词也就不认识,但是不用担心,kibana很贴心,它支持汉化,很人性化(kibana这个项目远远比我们想象中要完善的多的多)。

- 在

kibana-7.6.1-windows-x86_64\x-pack\plugins\translations目录下可以找打zh-CN.json文件,打开瞧一瞧

- 编辑器打开

kibana解压目录/config/kibana.yml,修改如下参数即可

- 重新启动kibana,再次访问

http://localhost:5601/,此时已经汉化成功

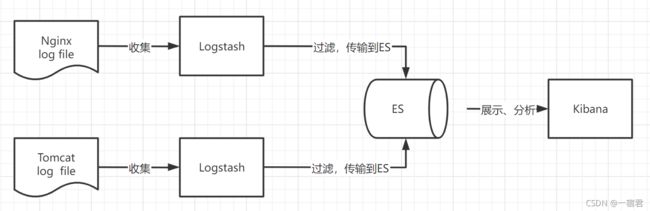

6、了解ELK

ELK是Elasticsearch、Logstash、 Kibana三大开源框架首字母大写简称。市面上也被成为Elastic Stack。

- Elasticsearch是一个基于Lucene、分布式、通过Restful方式进行交互的近乎实时搜索平台框架。像类似百度、谷歌这种大数据全文搜索引擎的场景都可以使用Elasticsearch作为底层支持框架,可见Elasticsearch提供的搜索能力确实强大,市面上很多时候我们简称Elasticsearch为es。

- Logstash是ELK的中央数据流引擎,用于从不同目标(文件/数据存储/MQ )收集的不同格式数据,经过过滤后支持输出到不同目的地(文件/MQ/redis/elasticsearch/kafka等)。

- Kibana可以将elasticsearch的数据通过友好的页面展示出来 ,提供实时分析的功能。

市面上很多开发只要提到ELK能够一致说出它是一个日志分析架构技术栈总称 ,但实际上ELK不仅仅适用于日志分析,它还可以支持其它任何数据分析和收集的场景,日志分析和收集只是更具有代表性,并非唯一性。

可以简单理解为如下图所示:

收集清洗数据(Logstash) ==> 搜索、存储(ElasticSearch) ==> 展示(Kibana)

7、ElasticSearch核心概念

7.1、ES核心概念

集群,节点,索引,类型,文档,分片,映射分别是什么?

至关重要的核心概念:

- 索引(ElasticSearch):包含多个分片

- 分片(基于Lucene索引,倒排索引)

- 字段类型(映射mapping):字段类型映射(字段是整型,还是字符型…)

- 文档(documents):行数据

ElasticSearch是面向文档的。

如下是关系型数据库和ElasticSearch索引库的客观对比!一切都是JSON!

| Relational DB | ElasticSearch |

|---|---|

| 数据库(database) | 索引(index) |

| 表(tables) | 类型(types 慢慢会被弃用) |

| 行(rows) | 文档(documents ) |

| 列(columns) | 字段映射(fields-mapping) |

elasticsearch(集群)中,总结如下:

- 集群中可以包含多个索引(数据库)

- 每个索引中可以包含多个类型(表)

- 每个类型下又包含多个文档(行)

- 每个文档中又包含多个字段(列)

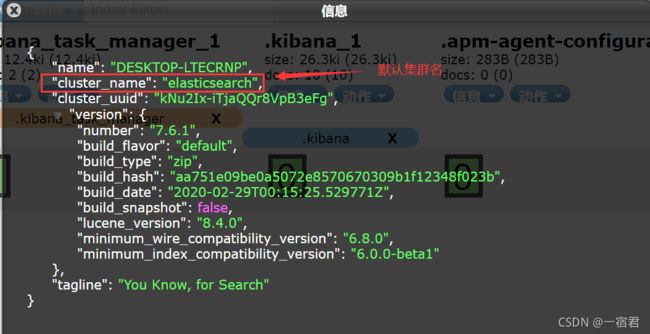

7.2、物理设计

- elasticsearch在后台把每个索引划分成多个分片,每个分片可以在集群中的不同服务器间迁移。

- 一个人就是一个集群! ,即启动后的ElasticSearch服务,虽然只启动一个服务,默认仍然是一个集群,且默认集群名为elasticsearch。

7.3、逻辑设计

- 一个索引类型中,包含多个文档,比如说文档1,文档2。

- 当我们索引一篇文档时,可以通过这样的顺序找到它:

索引 => 类型 => 文档ID,通过这个组合我们就能索引到某个具体类型的文档。- 注意:ID不必是整数,实际上它是个字符串。

1、文档(行)

之前说elasticsearch是面向文档的,也就是意味着索引搜索数据的最小单位是文档,在elasticsearch中文档有如下几个重要属性:

- 自我包含,一篇文档同时包含字段和对应的值,也就是同时包含key:value(键值对)。

- 可以是层次型的,一个文档中可以包含子文档,复杂的逻辑实体就是这么来得。(其实就是一个json对象,通过fastjson就可以自动转换)

- 灵活的结构,文档不依赖预先定义的模式,我们知道在关系型数据库中,要提前定义字段才能使用,在elasticsearch中,对应字段是非常灵活的,有时候我们可以忽略该字段,或者动态的添加一个新的字段。

尽管我们可以随意的新增或者忽略某个字段,但是,每个字段的类型非常重要,比如一个年龄字段类型,可以是字符串也可以是整形。因为elasticsearch会保存字段和类型之间的映射及其他的设置。这种映射具体到每个映射的每种类型,这也是为什么在elasticsearch中,类型有时候也称为映射类型。

2、类型(表)

类型是文档的逻辑容器,就像关系型数据库一样,表格是行的容器。- es类型中对于字段的定义称为映射,比如字段name映射为字符串类型。

- 我们说文档是无模式的,它们不需要拥有映射中所定义的所有字段,比如新增一个字段,那么elasticsearch是怎么做的呢?

elasticsearch会自动的将新字段加入映射,但是这个字段不确定它是什么类型,elasticsearch就开始猜,如果这个值是18,那么elasticsearch会认为它是整形。但是elasticsearch也可能猜不对,所以最安全的方式就是提前定义好所需要的映射,这点跟关系型数据库殊途同归了,先定义好字段,然后再使用。

3、索引(库)

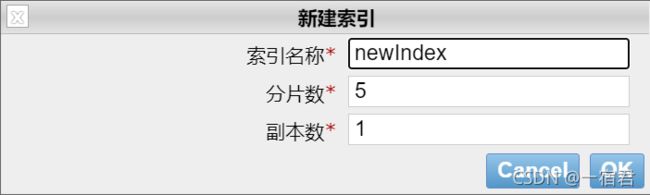

索引是映射类型的容器, elasticsearch中的索引是一个非常大的文档集合。 索引存储了映射类型的字段和其他设置。然后它们被存储到了各个分片上了,我们来研究下分片是如何工作的。

- 创建索引

- 一个集群至少有一个节点,而一个节点就是一个elasticsearch进程,节点默认可以有多个索引,如果你创建索引,那么索引默认将会有5个分片(primary shard ,又称主分片)构成的,每一个主分片会有一个副本(replica shard,又称复制分片)。

- 上图是一个有3个节点的集群,可以看到主分片和**对应的复制分片(副分片)**都不会在同一个节点内,这样即使是某个节点挂掉了,其他节点数据仍然存在。

- 实际上,

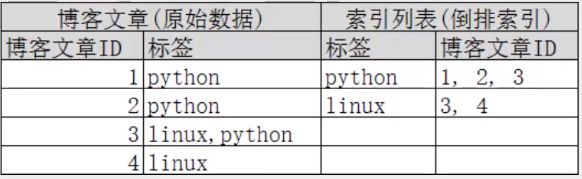

一个分片是一个Lucene索引(一个ElasticSearch索引包含多个Lucene索引) ,本质上一个包含倒排索引的文件目录,倒排索引的结构使得elasticsearch在不扫描全部文档的情况下,就能找到哪些文档包含我们所要查询的关键字。

4、倒排索引(Lucene索引底层原理)

简单的说,倒排索引就是按照我们所查询的关键字再次建立索引,其底层就是依赖Lucene索引根据关键字筛选包含关键字的文档,自动为我们生成新的倒排索引的形式,然后我们根据关键字查询的过程中,就可以直接查询到包含关键字对应的文档,不包含关键字的文档根本不会被检索到,如图所示:

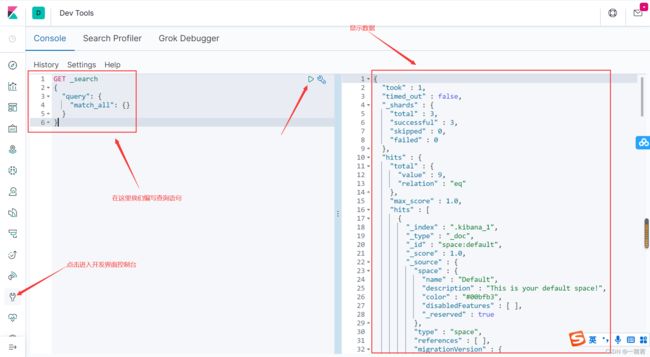

后续我们的操作都是在Kibana的DEV Tools的Consol控制台下完成,基础操作!!!

8、IK分词器(插件)

8.1、IK分词器:中文分词器

分词:即把一段中文或者别的语言划分成一个个的关键字,我们在浏览器搜索的时候,浏览器的搜索引擎会把我们输入的关键字进行分词拆分,也会把数据库中或者索引库中的数据文档内容进行分词拆分,然后进行一个个的匹配操作。

不使用IK分词器的情况下,默认的中文分词是将每个字看成一个词,比如你好一宿君会被分为你、好、一、宿、君,这显然是不符合要求的,所以我们需要安装中文分词器ik来解决这个问题。

IK提供了两个分词算法: ik_smart和ik_max_word:

ik_smart为最少切分ik_max_word为最细粒度划分

1、下载对应es版本的ik分词器

- 下载地址: https://github.com/medcl/elasticsearch-analysis-ik/releases

2、安装

3、重启ElasticSearch,加载ik分词器插件

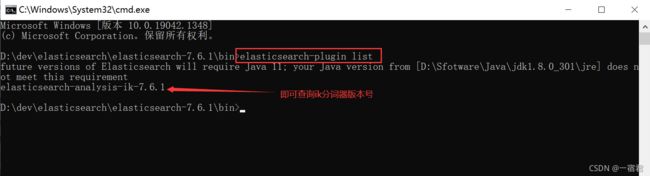

4、使用命令查看elasticsearch下的插件列表

8.2、自定义词典库

对于这句话你好java一宿君,上述两种分词方式看似没有任何区别,但是这并不是我们想要的结果,我想要的结果是一宿君这个关键词要组合在一起做为查询条件,因为一宿君这三个字是我自己定的网名,词典中肯定没有,如果我们想要使用这个关键词怎么办?

- 这个时候我们就可以自定义添加分词库了!!!

- 找到我们上述在es的plugins目录下添加的

elasticsearch-analysis-ik-7.6.1ik分词插件 - 编辑

elasticsearch-analysis-ik-7.6.1/config/IKAnalyzer.cfg.xmlik分词配置文件

- 上述

一宿君这个关键词没有,那我们就自己写一个

- 添加到扩展配置文件中

- 重新启动es和Kibana,再次测试两种分词查询:

- 这样自定义词典库就配置成功了,后续有新的词都可以写入我们自定义的词典库文件中!!!

9、ES基于Rest风格调用说明

Rest是一种软件架构风格,而不是一种标准,只是提供了一组设计原则和约束条件。它主要用于客户端和服务器交互类的软件。基于这个风格设计的软件可以更简洁,更有层次,更易于实现缓存等机制。

9.1、基本Rest请求说明

| method | url地址 | 描述 |

|---|---|---|

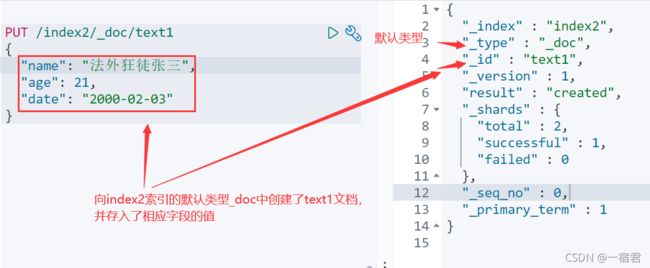

| PUT(创建,修改) | localhost:9200/索引名称/类型名称/文档id | 创建文档(指定文档id) |

| POST(创建) | localhost:9200/索引名称/类型名称 | 创建文档(随机文档id) |

| POST(修改) | localhost:9200/索引名称/类型名称/文档id/_update |

修改文档 |

| POST(查询) | localhost:9200/索引名称/类型名称/文档id/_search |

查询所有数据 |

| GET(查询) | localhost:9200/索引名称/类型名称/文档id | 查询文档通过文档ID |

| DELETE(删除) | localhost:9200/索引名称/类型名称/文档id | 删除文档 |

补充说明:

- 类似Postman工具,上述的URL地址需要加上ip和端口号;如果使用的是Kibana可以不用加。

- 上述请求方法,URL地址中,如果是修改、查询和删除某个文档,需要带上文档id;如果是创建文档,可以指定文档id,不指定会随机生成一个文档id。

- 类型对应数据库中的表,可以不特定指定,默认是就以

_doc为类型名。 - 所有的请求方法,在Kibana中都要是大写的。

9.2、测试无条件请求

这个时候我们就要用到es-head插件来显示数据了!

可以看出下述索引中只有三个,都是Kibana系统自带的,不要删!

0、字数据类型

-

字符串类型

- text:支持分词、全文检索、支持模糊、精确查询;不支持聚合、排序操作。text类型最大支持的字符长度无限制,适合大字段存储。

- keyword:不支持分词,直接索引、支持模糊、精确匹配、聚合、排序操作。keyword类型最大支持的长度为

32766个UTF-8类型的字符,可以通过设置ignore_above指定所支持的字符长度,超过给定长度后的数据将不被索引,无法通过term精确匹配检索返回结果。

-

数值型

- long、Integer、short、byte、double、float、half float、scaled float

-

日期类型

- date

-

te布尔类型

- boolean

-

二进制类型

- binary

1、创建索引库(PUT和POST)

-

使用PUT创建,不指定字段类型

如果自己创建的文档字段没有指定类型,那么ElasticSearch就会给我们默认配置字段映射类型

-

使用PUT创建,指定字段类型

_doc默认类型(default type),type 在未来的版本中会逐渐弃用,因此产生一个默认类型进行代替#此处写到索引名称,代表该索引下所有文档的如下三个字段都是指定的类型 #默认类型为_doc(类型是唯一的,不可再创建类型) PUT /index2 { "mappings": { "properties": { "name": { "type": "text" }, "age":{ "type": "long" }, "birthday":{ "type": "date" } } } }

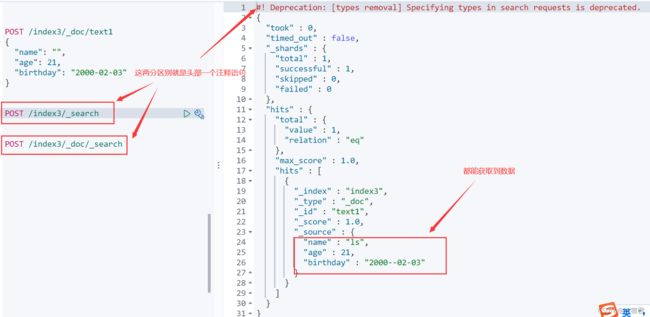

2、获取数据(GE和POST)

3、扩展:通过get _cat/可以获取ElasticSearch的当前的很多信息!

GET _cat/indices

GET _cat/aliases

GET _cat/allocation

GET _cat/count

GET _cat/fielddata

GET _cat/health

GET _cat/indices

GET _cat/master

GET _cat/nodeattrs

GET _cat/nodes

GET _cat/pending_tasks

GET _cat/plugins

GET _cat/recovery

GET _cat/repositories

GET _cat/segments

GET _cat/shards

GET _cat/snapshots

GET _cat/tasks

GET _cat/templates

GET _cat/thread_pool

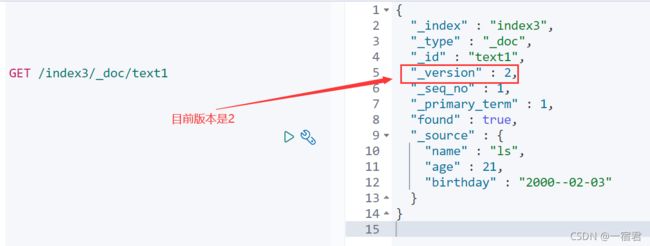

4、修改(PUT:老版本和POST:新版本)

老版本:使用PUT方式,会覆盖原来一整行的数据,版本version会加1,如果修改的时候有没写到的字段,那么那些字段将会被覆盖掉,也就是在新版本中不会在出现,这样及很容易造成数据丢失(非常不推荐使用)

新版本:使用POST ~/_update方式,可以单独修改某个字段的值,也可以修改全部字段的值,无论是单个字段还是全部字段的修改,都不是完全覆盖

5、删除索引和文档(DELETE)

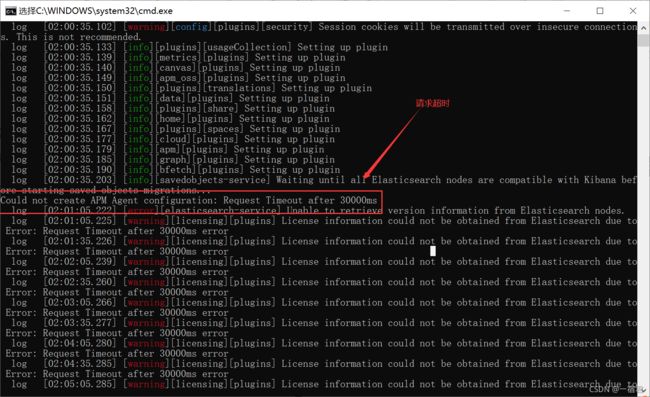

9.3、解决Kibana驱动报错

如果在启动Kibana出现如下错误!!!

Could not create APM Agent configuration: Request Timeout after 30000ms

原因 :elasticsearch内存不足,造成IO读写阻塞。

在上述4.1、下载安装es处,有解压包目录解释:

介绍下相关目录及其下的文件的作用:

bin:启动文件目录

config:配置文件目录

1og4j2:日志配置文件

jvm.options:java虚拟机相关的配置(默认启动占1g内存,内存不够的话可以自己调整)

elasticsearch.ym1:es的配置文件! 默认9200端口!跨域!

1ib :相关jar包

modules:功能模块目录

plugins:插件目录,eg:ik分词器

注意:

jvm.options:java虚拟机相关的配置(默认启动占1g内存,内存不够的话可以自己调整

此时就是因为你es运行过程中内存不够用,IO阻塞,导致Kibana无法正常连接!

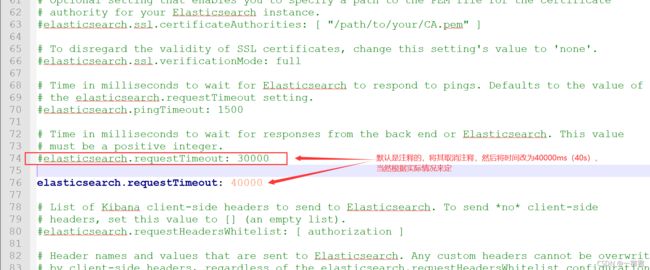

解决此问题有两种方法:

- 1、修改

es/config/jvm.options文件中的JVM运行参数-Xms1g,将其调整为2g或者更大,根据服务器配置来调。

#linux系统下 vim jvm.options - 2、修改kibana的请求超时时间,编辑

kibana-7.6.1-windows-x86_64/config/kibana.yml文件

#linux系统下直接 vim kibana.yml

上述两种情况任选其一即可,一般是推荐使用第一种方式!!!

9.4、测试带条件请求(重点)

9.4.1、简单条件查询

PUT /index3/user/1

{

"name": "一宿君",

"age": 21,

"desc": "是个程序员",

"hobby": ["sing","song","emomo"]

}

PUT /index3/user/2

{

"name": "狂神说",

"age": 23,

"desc": "是个语出迅疾的优秀者",

"hobby": ["技术宅","帅","java"]

}

PUT /index3/user/3

{

"name": "法外狂徒张三",

"age": 30,

"desc": "徘徊法律边缘的大哥",

"hobby": ["想犯罪","想搞事","想体验鉴于生活"]

}

9.4.2、复杂条件查询

| 关键字 | 作用 |

|---|---|

| match | 匹配(会使用分词器解析(先分析文档,然后进行查询)) |

| _source | 过滤字段(就是只查询我们想要的字段) |

| sort | 排序 |

| from、size | 分页查询(from代表当前页码,size代表每页数据条数) |

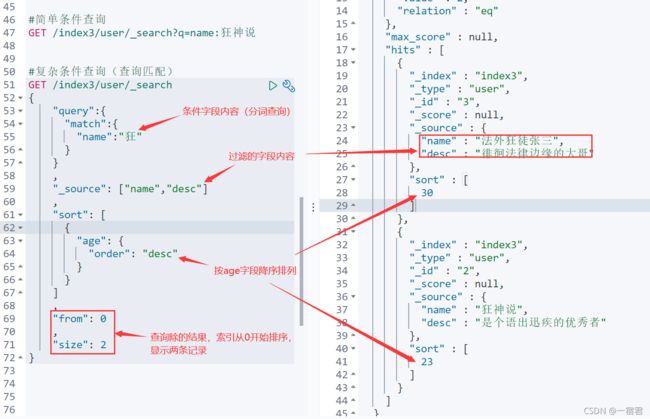

#复杂条件查询(查询匹配)

GET /index3/user/_search

{

"query":{

"match":{

"name":"狂"

}

}

,

"_source": ["name","desc"]

,

"sort": [

{

"age": {

"order": "desc"

}

}

]

,

"from": 0,

"size": 2

}

must相当于 andshould相当于 ormust_not相当于 not (… and …)filter过滤-

gt:大于 -

gte:大于等于 -

lt:小于 -

lte:小于等于

-

#多条件查询

GET /index3/user/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"name": "狂"

}

},

{

"match": {

"desc": "的"

}

}

],

"filter": {

"range": {

"age": {

"gte": 1,

"lte": 35

}

}

}

}

},

"sort": [

{

"age": {

"order": "desc"

}

}

]

}

- 貌似不能与其它字段一起使用

- 可以多关键字查(空格隔开),匹配字段也是符合的

match会使用分词器解析(先分析文档,然后进行查询)- 搜词

#匹配数组

GET /index3/user/_search

{

"query": {

"match": {

"desc": "是个 优大哥"

}

}

}

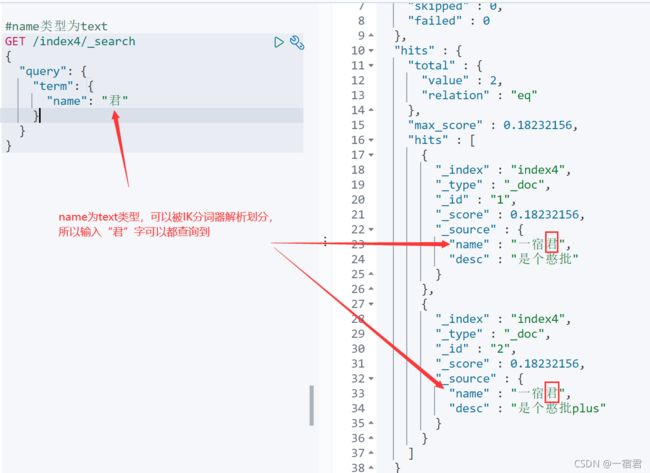

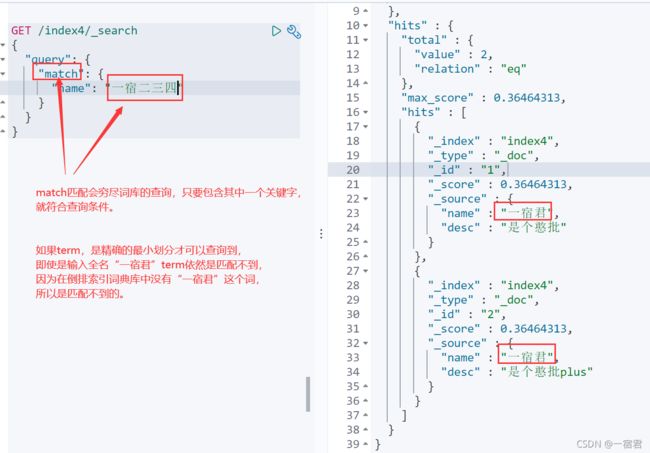

9.4.3、text和keyword字段类型的区别(重点)

text:

支持分词、全文检索、支持模糊和精确查询,不支持聚合和排序操作;- text类型最大支持的字符长度无限制,适合大字段存储;

keyword:

不支持分词、直接通过倒排索引查询、支持模糊和精确匹配,支持聚合、排序操作。- keyword类型的最大支持的长度为32766个UTF-8类型的字符,可以通过设置

ignore_above指定支持字符长度,超过给定长度后的数据将不被索引,无法通过term精确匹配检索返回结果。

PUT /index4/_doc/1

{

"name": "一宿君",

"desc": "是个憨批"

}

PUT /index4/_doc/2

{

"name": "一宿君",

"desc": "是个憨批plus"

}

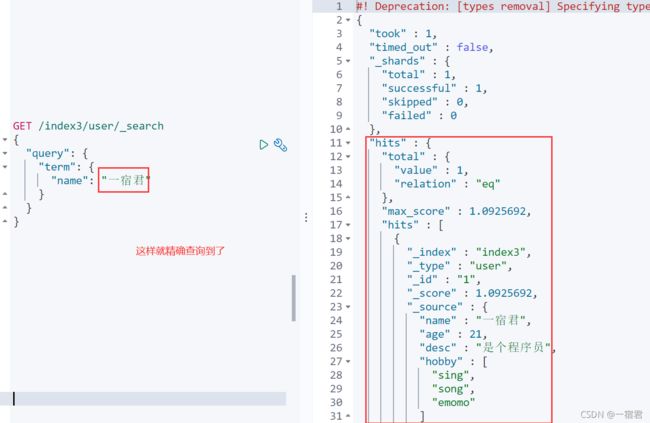

通过name字段查询

通过desc字段查询:

通过match匹配查询,再次重复上述查询,看结果:

match和term的区别需要自己去悟!!!

9.4.4、高亮查询

默认查询高亮:

GET /index3/_search

{

"query": {

"match": {

"name": "狂"

}

},

"highlight": {

"fields": {

"name": {}

}

}

}