【论文学习】《Practical Attacks on Voice Spoofing Countermeasures》

《Practical Attacks on Voice Spoofing Countermeasures》论文学习

文章目录

- 《Practical Attacks on Voice Spoofing Countermeasures》论文学习

-

- 摘要

- 1 介绍

- 2 背景

-

- A 自动说话人验证系统

- B 欺骗的对策

- 3 威胁模型

- 4 攻击语音认证系统

-

- A 问题陈述

- B 攻击概述

- C 现有攻击的谬论

- D 我们的攻击

- 5 实验

-

- A 愚弄机器

- B 内容保留

- C 愚弄人类

- 6 通过电话网络攻击

-

- A 模拟通过电话网络攻击

- B 对抗样本生成

- C 实验与结果

- 7 讨论

-

- A 我们攻击的实用性

- B 减弱我们的攻击

- C 未来的工作

- 8 相关工作

- 8 结论

摘要

语音认证已经成为关键安全操作(如银行交易和呼叫中心通话)中不可或缺的一部分。自动说话人验证系统(ASV)对欺骗攻击的脆弱性促使了对抗措施(CMs)的发展,其任务是区分真实和欺骗语音。ASV和CMs共同构成了今天的语音认证平台,被宣传为一种坚不可摧的访问控制机制。

我们开发了第一个针对CMs的实际攻击,并展示了恶意行为者如何高效地制作音频样本,以绕过最严格形式的语音认证。以前的工作主要集中在非主动攻击或对抗策略的ASV,而不是使用受害者的音色生成语音。我们攻击的后果要严重得多,因为我们生成的样本听起来像受害者,消除了受害者任何貌似合理的推脱机会。

此外,现有的少数针对CMs的对抗性攻击错误地优化了特征空间中的欺骗语音,并且没有考虑到ASV的存在,导致合成音频在现实环境下的失败。通过我们的关键技术贡献,我们消除了这些障碍:我们提出一种新的联合损失功能,可以直接在时域内对ASV/CM组合部署进行高级对抗攻击。我们的对抗样本在最先进的认证平台上实现了黑盒成功率(高达93.57%)。

最后,我们对CMs执行了第一次有针对性的、适用于电话网络的攻击,绕过了几种认证挑战,使各种潜在的威胁成为可能。我们的研究结果对现代语音认证系统的安全性提出了质疑,因为攻击者会绕过这些措施来获取用户最有价值的资源。

1 介绍

自动说话人验证系统(ASV)被广泛用于认证平台,通过将从给定音频样本中提取的特征与从之前收集的录音中获得的声纹进行比较,来验证使用者声称的身份。ASV越来越受欢迎,主要是因为它们提供的便利,让用户从必须记住密码的负担中解脱出来。ASV易受模仿(《Vulnerability of speaker verification to voice mimicking》)、重放(《On the study of replay and voice conversion attacks to text-dependent speaker verification》)、语音合成(《Natural TTS synthesis by conditioning wavenet on mel spectrogram predictions》)、语音转换(《All your voices are belong to us: Stealing voices to fool humans and machines》,《Voice conversion based on maximum-likelihood estimation of spectral parameter trajectory》)等欺骗攻击的脆弱性已经成为众多学术和行业项目的研究课题,并通过部分个体的努力(《Void: A fast and light voice liveness detection system》)或INTERSPEECH的ASVspoof挑战开发了欺骗干扰对策(CMs)(《ASVspoof: the automatic speaker verification spoofing and countermeasures challenge》)。这些工作设想语音认证平台的形式结合了ASV和CM。前者验证身份声明,而后者拒绝欺骗的、机器生成的样本。这样的组合解决方案在已部署的应用程序(《The attacker s perspective on automatic speaker verification: An overview》)中非常普遍。许多服务提供商明确地通知客户在ASV旁边存在CM,以减轻与欺骗攻击(《HSBC Voice ID》)相关的安全问题。

语音认证已被部署在安全关键环境中,如银行(如花旗银行(《Citibank Voice Biometric》)和《first direct Phone Banking》)。通讯公司的VocalPassword(《Nuance VocalPassword : voice biometrics authentication》)(今年4月被微软(Microsoft)以197亿美元收购)和类似的产品被服务提供商广泛用于访问控制,要么是在他们的呼叫中心,要么是通过智能手机应用(《ING introduces a voice-controlled mobile banking app powered by Nuance》,《Nuance voice biometrics quickly identifies customers and strengthens security for National Australia Bank》)实现交易。这些服务提供商发布的声明大放阙词(例如《TD VoicePrint》),承诺他们的客户其安全是不可渗透的,这引起了人们对这些声明的可靠性的质疑。

本工作的主要目标是研究CMs的鲁棒性,以及它们将ASV转变为可信赖的认证系统的能力。上面提到的四种欺骗攻击CMs是健壮的,但它们不是主动的,而是具有随机性的。除了对ASV(《The attacker s perspective on automatic speaker verification: An overview》)不构成现实威胁的模拟攻击外,其余三类攻击都是通过良性算法和方法获得的,它们不是为击败语音认证系统而设计的,而是通常为帮助残疾人或娱乐(《8 Use Cases for Voice Cloning with Artificial Intelligence》)而开发的。因此,问题是,带有恶意意图的高级攻击是否会危及使用CM增强的ASV。

CMs主要用于防止攻击,其中对抗噪声是难以察觉的,并想让人类侦听者认为是受害者的声音,这是针对安全关键系统的基本需求(见III)。尽管目前有许多工作使用对抗样本进行主动攻击(《Who is real Bob? Adversarial attacks on speaker recognition systems》,《SirenAttack: Generating adversarial audio for endto-end acoustic systems》,《Adversarial attack and defense strategies for deep speaker recognition systems》,《Fooling end-to-end speaker verification with adversarial examples》),但都没有达到使对抗噪声难以察觉的要求(由人类侦听者检查时),并且也不是针对配备CM的语音认证平台的实际攻击。

本文演示了对CMs的第一次实际攻击,CMs是真实世界语音认证平台的一个组成部分。我们的现实威胁模型要求成功的攻击必须避开四个独立的组件:CM、ASV、语音内容验证单元,以及可能被要求验证机器判断结果的人类侦听者。我们建立对抗样本作为一种合适的攻击策略,并将从欺骗语音针对CMs生成对抗噪声的问题归约为一个受威胁模型约束的优化问题。

我们发现,现有的针对CMs(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》)的攻击方法中,没有一种(《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》)能够产生在实际环境中成功的对抗例子。我们的研究将这些失败归因于在频谱领域产生的对抗扰动,无法承受(逆)时频变换,从而导致CMs可以检测到的类似机器痕迹的人工制品。现有工作忽略的另一个因素是ASV和目标CMs的共同存在需要在生成攻击样本时考虑。

我们通过实现必要的逻辑,通过特征提取器支持梯度的反向传播,引入了一种针对CMs的新型攻击类型,使我们能够在时域中构建对抗示例,这是我们在攻击CM时必不可少的要求。我们的梯度支持的特征提取器使我们能够通过我们的联合损失函数考虑ASV来鲁棒攻击,该函数包括一个指定的部分来正则化对手,并排除可能消除受害者声纹的扰动。优化是在受害者的声音中执行的,由现成的语音合成或语音转换算法生成。其结果是端到端攻击,以最严格的形式绕过语音验证。

为了演示我们的攻击的实际风险,我们在两个真实世界的场景中评估它们:银行应用程序攻击和电话攻击。在前者场景下,攻击者绕过银行应用程序用来保护应用程序内交易(《Voice ID in the ANZ App》)的语音认证系统。在后者中,攻击者在与目标系统的电话中伪装成受害者,发出虚假的事务(《TD VoicePrint》)。我们提出的对抗攻击绕过了相关障碍成功完成通话(《The faults in our ASRs: An overview of attacks against automatic speech recognition and speaker identification systems》),并抵御了电话中失真的影响。我们的攻击行为即使经过人类的检查也不会被发现,这消除了受害者任何可能的推诿机会。由于我们的攻击和发现,用户应该重新考虑他们对语音生物识别技术的信任,研究人员和服务提供商应该投入资源开发技术,使这些机制更安全。

我们的攻击是根据2019年ASVspoof挑战(《ASVspoof 2019: Future horizons in spoofed and fake audio detection》)的顶级提交进行评估的。我们的ASV与CMs并排部署,由x-vector和i-vector的GMM-UBM模型组成,代表了前沿技术。我们的大规模研究实验以各种配置作为目标系统,并在所有这些设置中展示了成功的攻击。我们的对手都是在黑盒场景中评估的,利用对抗样本的可转移性。我们在MTurk(《Amazon Mechanical Turk Platform》)上进行了一项用户研究,以评估我们优化的欺骗示例的能力,以欺骗人类听众。在黑盒设置下,我们的攻击成功率高达93.57%。

总的来说,这项工作做出了以下贡献:

(1)我们引入并规范了一个现实的威胁模型,其中采用欺骗对策(CMs)来确保语音认证的安全性。我们从理论上仔细研究了文献中提出的针对CMs制作音频对抗样本的策略,发现现有的方法在我们考虑的实际威胁模型的限制下是无效的。我们进行了实验来证实这些发现。

(2)我们提出了第一种技术,通过一种新型的对抗攻击显著降低最健壮的语音认证的性能。我们开发了一种方法来生成CMs的时域对抗样本。通过最小化一个新的联合损失函数,我们生成了强大的对手,它们可以同时逃避四种防御:CMs、ASV、人类验证和内容验证。

(3)我们演示了第一个针对ASV/CM组合系统的有针对性的通过电话网络进行对抗攻击,并提出了对失真具有鲁棒性的技术。

(4)我们的攻击的端到端延迟低于5秒,使它们成为击败语音认证系统的实际实时策略。

(5)我们将公开我们的源代码,供其他研究人员复制我们的结果。

2 背景

本节介绍了自动说话人验证系统的初步设计和欺骗干扰对策。

A 自动说话人验证系统

ASV的核心是声纹,这是一套独特的可测量的个人声音特征。这种声纹被认为是一种识别特征,因为它可以捕捉到诸如声道和喉部的形状和大小等物理因素,以及包括口音、节奏、发音等行为特征(《Robustness-related issues in speaker recognition》)。这种所谓的声纹特性促使研究人员对其作为生物识别的有效性进行了研究。

ASV分为两个阶段,即注册阶段和验证阶段。在注册过程中,用户提供语音样本,这些样本用于构建他们的声纹并推导说话人的模型,这些模型将作为他们的识别签名。在未来的访问请求中,用户的身份通过提供的语音样本进行验证,这些语音样本与声纹进行对照,以输出一个决定(接受/拒绝)。

验证阶段可以按照三种方案:1)文本依赖——预设的短语反复用于身份验证的;2)文本独立——用户可能提供任何随机的短语;3)文本提示——系统需要一个特定的随机文本从用户使用。第三种方案是最安全的,因为它对重放攻击具有鲁棒性,被多个服务提供商认为是一种鲁棒防御策略,是本文的重点。我们的攻击绕过了这个最强大的防御以及所有其他的验证方案。

研究人员提出了各种各样的特征,这些特征已经成为ASV的黄金标准。这些特征包括梅尔频率倒谱系数(MFCC)和对数功率幅度谱(LPMS),其中前者的表达能力和捕获众多说话人特征(《Adversarial attacks on GMM i-vector based speaker verification systems》)的能力在文献中占主导地位。ASV的架构有三种典型的代表:基于i-vector说话人嵌入式系统、基于神经网络(x-vector)的系统和端到端方法(《Adversarial attacks on GMM i-vector based speaker verification systems》)。本文考虑基于i-vector和x-vector嵌入的高斯混合模型系统(或GMM i-vector/x-vector)(《Adversarial attacks on GMM i-vector based speaker verification systems》,《SirenAttack: Generating adversarial audio for endto-end acoustic systems》),因为它们在生物特征认证任务中的广泛应用和普及。

B 欺骗的对策

ASV系统很容易受到欺骗攻击,在验证步骤中使用的语音样本不是由真实用户提供的,而是由冒名顶替者提供的。欺骗和零成本攻击之间的区别在于,后者攻击者仅仅声称自己是受害者,并提供自己的声音录音作为证据,希望幸运地出现混淆。ASV系统在拒绝零成本攻击方面效率很高。

欺骗攻击可以分为四类:

1)模仿攻击,攻击者操纵自己的声音,以便听起来像受害者(这是在没有机器的帮助下完成的),

2)语音合成攻击,攻击者利用先进的ML技术(《Natural TTS synthesis by conditioning wavenet on mel spectrogram predictions》)合成生成模仿受害者的语音样本,

3)语音转换攻击,攻击者利用最先进的技术,通过算法将录音中的语音转换为受害者的语音,同时保留录音内容

4)重放攻击,攻击者重放原始用户之前录制的样本。在模拟攻击中,攻击者倾向于通过操纵高水平的声音线索,而不是asv使用的低水平的光谱特征,来模仿目标说话者的声音。因此,asv天生对模仿攻击(《The attacker s perspective on automatic speaker verification: An overview》)是健壮的。

对可靠的ASV的需求导致了欺骗干扰对抗(CMs)的出现。这些分类器是用来解决二进制问题,区分真实的语音样本(真伪)和他们的仿冒的副本。与说话人验证的任务类似,欺骗干扰对策依赖于一组通用的特征,这些特征将人的语音与机器生成的语音或只有在计算机参与生成样本时才会出现的人工语音区分开来。这些细微差别由为此目的开发或研究的特性集捕获,包括前面描述的MFCCs和LPMS,以及Constant-Q倒谱系数(CQCCs)。

CMs被设计成与ASV一起部署。语音样本必须经过两个系统的批准才能通过身份验证。

3 威胁模型

攻击者的目标: 攻击者希望在远程系统中模拟某些用户。与远程系统的交互可以以两种形式进行:

(1)通过指定的应用程序——在过去的几年中,随着许多服务提供商(尤其是银行)通过他们的应用程序(《ING introduces a voice-controlled mobile banking app powered by Nuance》)提供安全的语音触发服务,这种设置已经获得了势头。用户发出交易,然后使用他们的语音对其进行身份验证。

(2)通过电话网络——同样,通过电话提供远程服务的银行和服务提供商的数量也在增加。用户调用服务提供商并与系统交互,同时使用语音身份验证(《Chris Burt. Zoom adds voice biometrics, contact center services with $14.7B Five9 deal》)验证用户的身份。

对远程系统的访问通过语音身份验证进行了保护。该系统还配备了一个CM(《Void: A fast and light voice liveness detection system》),以降低语音欺骗的威胁。我们排除了文本相关的验证方案,因为它们很容易受到重放攻击。我们假设要克服的验证方案是文本独立的或文本提示的。在这两种情况下,攻击变得更加困难,因为口语短语必须包含非常具体的内容;在前一种情况下,用户可以简单地通过这样的语句进行交互:将1000美元转移到XXXX账户,这既用于验证,也用于传递必须保留的预期命令。在后一种情况下,必须准确地重复远程系统提供的内容。

在指定应用场景中,用户提供的录音直接转发到远程服务器。在电话网络场景中,输入经过编码,然后通过电话网络传输到远程服务器。第二种情况带来了额外的挑战,因为攻击必须经受住噪声介质的影响。

最后,或许也是最重要的一点,攻击必须是不可察觉的。由于我们只考虑安全关键环境,所以很自然地假设可疑的事务将在执行之前由人工代理标记和验证。或者,如果执行了恶意的事务,受害者将对该事务提出争议,从而进行追溯性调查。因此,这些攻击必须经受住人类的检验。为了达到这个目的,攻击者想让任何人类都将录音的音色判断为受害者本人。

攻击者的知识:

我们主要关注更真实的黑盒场景,尽管我们也在白盒场景中演示了攻击,以供参考。也就是说,攻击者无法访问目标模型的内部结构或目标系统使用的训练数据集(即用来训练这些模型的说话人和音频)。回想一下,目标系统使用的CM模型需要模拟语音样本来训练它们。这些欺骗样本是用欺骗算法创建的。我们假设攻击者可以使用相同的欺骗算法(但不是样本本身)进行攻击,因为该领域的领先技术是使用的共同标准。在附录B中,相比不知道作为目标系统训练一部分的欺骗算法的攻击者,我们展示了这一假设并不会导致一个更强大的对手。

最后,攻击者拥有足够的数据来训练受害者的语音合成模型。最先进的语音合成系统只需要受害者15分钟的语音就能完成这一任务(《LibriTTS: A corpus derived from LibriSpeech for text-to-speech》)。由于有了社交媒体,这些数据很容易获得,特别是对于一个针对特定人物且有足够耐心的攻击者来说。

攻击者的能力:

攻击者可以绕过用于与远程服务器交互的设备上的麦克风,将加有对抗扰动的音频波形直接注入到服务提供商的应用程序(或电话应用程序)。这需要攻击者获得一些根设备,在这些设备上他们可以绕过麦克风,使这个假设非常可信。重要的是,我们不假设攻击者能够访问受害者的设备。

在指定应用场景中,攻击者将受害者的银行应用安装在根设备上。大多数银行允许用户在多种设备上安装应用程序。它们可能要求用户输入密码或PIN码(《Voice ID in the ANZ App》),攻击者可以通过社会工程(《Social engineering attacks by the numbers: Prevalence, costs, and impact》)获得密码或PIN码(《Voice ID in the ANZ App》)。在电话网络的场景中,这一要求可以放弃,因为攻击者可以使用任何设备进行呼叫,而不需要知道PIN。此外,在这种情况下,不需要根设备,因为攻击者可以使用计算机和VOIP程序(如Skype)进行攻击。虽然银行应用程序可能配备了根探测器,但这些通常可以避开(《Android: How to bypass root check and certificate pinning》)。值得注意的是,由于整个身份验证过程是在服务器端(《Nuance VocalPassword : voice biometrics authentication》)上进行的,因此攻击者对设备进行根认证的能力并不会使更强大的攻击成为可能。

攻击者有足够的计算资源和数据来构建模拟目标系统的阴影。攻击者训练这些模型,并以此为基础进行攻击。

总的来说,除了计算资源,我们只要求攻击者访问一个根设备,15分钟的受害者的声音,可能通过社会工程获得的PIN,这取决于威胁模型。

4 攻击语音认证系统

A 问题陈述

在我们的设计中,攻击者的目标是产生一个音频信号来绕过语音认证。威胁模型要求攻击者产生能够欺骗机器和人类侦听器的信号。该认证机器由一个ASV和一个CM组成。两个模块的输入都是从信号中提取的一组声学(频谱)特征。

对于音频输入 x ∈ X x \in X x∈X,其中 x x x是音频信号空间,以及声明的身份标识 U I D U_{ID} UID, ASV模块公式如下:

A S V ( x , U I D ) = h A S V ( g A S V ( x ) , g A S V ( D B ( U I D ) ) ) ASV(x,U_{ID})=h_{ASV}(g_{ASV}(x),g_{ASV}(DB(U_{ID}))) ASV(x,UID)=hASV(gASV(x),gASV(DB(UID))) 其中 h A S V h_{ASV} hASV是一个二进制映射(接受/拒绝), g A S V g_{ASV} gASV是一个提取函数,用于获取ASV所需的特征。 D B DB DB是包含所有用户声纹的数据库。系统从数据库中检索与身份 U I D U_{ID} UID对应的声纹,从输入和声纹中提取ASV需要的特征,并输出样本 x x x是否属于 U I D U_{ID} UID。

CM模型的公式如下:

C M ( x ) = h C M ( g C M ( x ) ) CM(x)=h_{CM}(g_{CM}(x)) CM(x)=hCM(gCM(x)) 其中 h C M h_{CM} hCM是一个二进制映射, g C M g_{CM} gCM是一个特征提取器。系统从 x x x中提取相关特征,并输出 x x x是欺骗的还是真实的。

当攻击者试图模拟用户 U I D U_{ID} UID时,他们不仅必须绕过ASV和CM,而且提供的示例的内容必须匹配系统给出的密码短语 t t t。我们假设服务器上有一个Speech-To-Text验证单元( V S VS VS),它接受 t t t和提供的样本 x x x作为输入,并表明这个条件是否成立。

为了捕获隐匿性对人类侦听者的表现,我们将其建模为 H J ( x , U I D , t ) HJ(x, U_{ID}, t) HJ(x,UID,t),它将声明的标识、提供的示例和预期的文本作为输入。当语音认证系统的决定受到质疑时,人工判断会被询问,并决定来自声称的用户的样本是否听起来很自然,并嵌入预期的文本内容。

攻击者的任务是躲避所有这些防御。我们让 A \mathcal{A} A表示攻击者用来制作恶意样本的策略。 A \mathcal{A} A的输入是 t t t和 U I D U_{ID} UID,输出是一个音频样本,表示为 A ( t , U I D ) \mathcal{A}(t, U_{ID}) A(t,UID)。要使攻击者的策略成功,必须满足以下条件:

T r u e = A S V ( A ( t , U I D ) , U I D ) ∧ C M ( A ( t , U I D ) ) ∧ V S ( A ( t , U I D ) , t ) ∧ H J ( A ( t , U I D ) , U I D , t ) True=ASV(\mathcal{A}(t,U_{ID}), U_{ID}) \land CM(\mathcal{A}(t, U_{ID})) \land VS(\mathcal{A}(t, U_{ID}), t) \land HJ(\mathcal{A}(t, U_{ID}), U_{ID},t) True=ASV(A(t,UID),UID)∧CM(A(t,UID))∧VS(A(t,UID),t)∧HJ(A(t,UID),UID,t)

B 攻击概述

正如在第二节和第三节中所解释的,唯一能够成功攻击独立于文本或文本提示的ASV-CM组合系统的攻击类型是语音转换(VC)和语音合成(SS)攻击。然而,CMs可能会显著降低这些攻击的可能性。激发这一研究的问题是,SS和VC攻击是否可以被优化以击败CM系统。

最先进的VC或SS算法(《Natural TTS synthesis by conditioning wavenet on mel spectrogram predictions》)可以生成完美的合成语音。我们的假设是,敌对的例子,当从这些算法的输出精心设计,是完美的攻击候选。我们的攻击通过对抗性扰动来呈现目标CMs,优化带有受害者声纹的机器生成语音。

给定 S A S_A SA表示的SS或VC算法,我们提出的攻击如图1所示,针对指定应用场景:

(1)攻击者在自己的手机上访问远程服务提供的应用,并发出请求资源或触发事务的命令。该命令可能是一个语音命令,使用 S A S_A SA在受害者的语音中生成(并使用我们下面描述的相同方法进行反向优化)。

(2)远程服务通过应用程序接收请求/事务;

(3)随机向攻击者提示认证短语 t t t。

(4)攻击者通过 S A S_A SA在受害者的语音中生成请求短语,保证 H J HJ HJ和 V S VS VS接受。

(5)结果转发到对抗样本生成器 A E AE AE,通过轻微的扰动生成一个文本内容和听起来都完全相同的样本,同时也固化受害者的声纹,用对抗的方式优化它,使其被CM接受。

(6)对抗样本被注入到应用程序,传输到远程服务器。

(7)服务器验证样本是否带有受害者的声纹(ASV接受),样本的文本内容是否为 t t t( V S VS VS接受),样本是否来自人类( C M CM CM接受)。

(8)如果请求/交易被检测到或报告为可疑的,人类会被表面上真实的样本所欺骗,并确认请求/交易的真实性。

通过电话网络场景的攻击也是类似的。唯一的区别是,指定的服务应用程序被电话应用程序取代,而在步骤(2)中,攻击者必须在电话中听到重复的短语(而不是提示)。攻击者在步骤(5)中提供的示例通过电话网络转发到远程服务器,需要对其进行编码。攻击者面临的挑战是电话网络的噪声,这需要专门的技术来增强攻击(见第六节)。我们假设攻击者与电话另一边的自动化系统交互,而不是人工代理。许多公司都部署了自动系统(《Chris Burt. Zoom adds voice biometrics, contact center services with $14.7B Five9 deal》),这使得我们的攻击更容易,因为VC或SS系统不一定能在与人工代理的整个对话中生成高质量的语音。

C 现有攻击的谬论

一些著作考虑了对ASV(《Who is real Bob? Adversarial attacks on speaker recognition systems》,《SirenAttack: Generating adversarial audio for endto-end acoustic systems》,《Adversarial attack and defense strategies for deep speaker recognition systems》,《Fooling end-to-end speaker verification with adversarial examples》,《Investigating robustness of adversarial samples detection for automatic speaker verification》)的对抗攻击。这些攻击展示了ASV如何被敌对地操纵,以接受攻击者的样本并将其分类,就像它属于受害者一样。在我们的威胁模型下,这些攻击没有达到攻击者的目标;它们不是不可察觉的,人类将能够分辨出属于冒名顶替者的样本。因此,我们认为之前唯一合适的攻击是针对CMs的攻击。本节的其余部分将详细讨论这些针对CMs(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》,《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》)的现有对抗攻击,并指出它们的局限性。我们随后提出的方法,通过对已知的针对CMs的对抗性示例生成策略的系统更改,引入了一个范式转换,绕过了限制,并证明了对配备CM的语音认证系统的对抗性攻击是一个现实的威胁。

(1)攻击发生在特征域,而不是时间域。

假设一个ML模型 M : W → { 0 , 1 } M: W \to \{0,1\} M:W→{0,1} (W是输入域)和一个样本 w ∈ W w \in W w∈W,使 M ( w ) = a ∈ { 0 , 1 } M(w) = a \in \{0,1\} M(w)=a∈{0,1}。一个对抗样本算法 A \mathbb{A} A需要 M M M和 w w w,和输出样本 A ( M , w ) = w ^ \mathbb{A}(M, w) = \hat{w} A(M,w)=w^,例如 M ( w ^ ) = ¬ a ∧ ∣ ∣ w − w ^ ∣ ∣ ≤ ϵ M(\hat{w}) =\neg a \land ||w-\hat{w}|| \le \epsilon M(w^)=¬a∧∣∣w−w^∣∣≤ϵ对于某些 ϵ \epsilon ϵ的值,它表示允许的最大扰动(输出的样本与原始样本无法区分,但它导致模型改变其决定)。由于 M M M是一种基于梯度的分类器,通常可以通过梯度下降/上升技术(《Intriguing properties of neural networks》)轻松地进行优化。本次优化的输出样本在 M M M的输入域中。

我们的新见解使我们的工作与之前攻击CMs(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》)的尝试不同(《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》),即当目标系统是CM时,该策略会失败(正如我们在V-A中所展示的那样),尽管它可能仍然是对付包括ASV在内的各种其他系统的最佳策略。下面我们将给出这个之前被忽视的现象背后的原因。

通常,ASV和CMs的输入是频谱特征,通常是不可逆的(例如,MFCC)。因此,对抗性变化应用于音频信号的频谱表示,输出对抗性谱图。为了将信号传输到远程ASV或CM,时域信号必须从修改后的频谱表示中恢复,这带来了两个主要挑战:

第一,请注意,从谱图合成波形的过程是许多VC和SS算法(基于WaveNet的方法(《Wavenet: A generative model for raw audio》))不可分割的一部分。因此,从本质上讲,这个过程引入了可以被训练来识别这些算法的CMs检测到的指纹。换句话说,在优化之后发生的恢复过程重新引入了敌对优化试图消除的机器痕迹,从而抵消了攻击的影响。

第二,频谱表示法由两部分组成:相位和幅度。ASV和CMs在处理信号时丢弃相位。然而,相位对于从声谱图中恢复音频波形至关重要。这是通过Griffin-Lim(《Signal estimation from modified short-time fourier transform》)算法恢复波形时的情况,就像在之前的工作(《Adversarial attacks on GMM i-vector based speaker verification systems》,《Adversarial attacks on spoofing countermeasures of automatic speaker verification》)中所做的那样(《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》)。其他现代方法(恢复波形),如WaveNet声码器(《Wavenet: A generative model for raw audio》),仍然受到上述第一个限制的影响。此外,由于声码器所需的特性和它们的超参数与ASV和CMs所使用的特性和超参数之间的差异,这些可能并不总是适用。上述工作采用了以下技术:首先从原始音频中提取频谱表示,攻击者从中获得幅度和相位。之后,震级受到了对抗扰动。恢复过程使用修改后的幅度和原始相位进行。重要的是,用于恢复信号的相位与修改后的样本不匹配,因为它属于原始记录。这种方法乐观的不切实际,因为CMs被训练来检测机器生成的语音和发现机器加工痕迹。用不匹配的幅度和相位产生的信号不能来自人类。当攻击CM时,这个障碍是关键的,而ASV可能没有那么健壮。当装载在特征空间时,对ASV的攻击仍然非常成功,即使波形如(《Fooling end-to-end speaker verification with adversarial examples》,《Adversarial attacks on GMM i-vector based speaker verification systems》)所述被重建。我们的见解使我们放弃了所有针对CMs(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》)的现有攻击所采用的传统方法(《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》),并将其作为我们稍后提出的策略的基础。

尽管如此,对CMs(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》)的现有攻击(《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》)报告了较高的成功率。我们认为,这是因为他们没有从受干扰的声谱图中重建音频,并假定这些音频可以直接输入被攻击的服务器。然而,在真实的设置中,攻击者可能只能将一个波形转发给服务器,服务器将独立提取谱图。正如我们在V-A中所展示的,从对抗的声谱图中合成语音并将其转发给服务器,严重地降低了这些攻击的成功率。

(2)攻击不考虑联合ASV-CM部署:

现有的对CMs(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》,《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》)的攻击在评估中没有考虑ASV。该攻击对初始被CM拒绝的欺骗样本进行扰动,并重新评估CM对扰动样本的性能。报告的成功率仅显示了成功优化绕过CM的样本数量。然而,在此优化过程中,某些痕迹被引入到样本中,可能导致ASV拒绝它们。

(3)攻击是在一个宽松的黑盒设置下进行的:

在现有的对CMs的攻击中,Adversarial attacks on spoofing countermeasures of automatic speaker verification》,《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》通过改变目标CMs的体系结构,针对阴影模型制作示例,利用可转移性属性来发起成功的攻击,而所有模型所训练的数据集都是相同的。在这种情况下,很自然地,大部分对抗样本将转移。在现实场景中,攻击者通常无法访问目标系统所训练的相同数据集。在评估此限制下的攻击时,我们预计可转移率将显著下降。

D 我们的攻击

(1)概述:

我们展示了攻击的细节,并解释了对抗样本生成过程的数学公式,以制作高质量的欺骗音频。

我们的攻击由两个组件组成:一个欺骗语音生成器 S A S_A SA和一个对抗样本引擎 A E AE AE,该引擎优化一个欺骗语音样本,使其绕过CM。我们将前面介绍的攻击者的算法 A \mathcal{A} A 重新定义如下: A = A E ∘ S A \mathcal{A} = AE \circ S_A A=AE∘SA。我们假设 S A S_A SA是最先进的SS或VC算法,并将我们的重点转移到优化器组件AE,这是我们的技术贡献所在。

A E AE AE定义为算法 A E : X → X AE: X \to X AE:X→X,给定一个输入语音记录 x x x,生成一个录音 x a d v x_{adv} xadv,使得 x a d v x_{adv} xadv是以下优化问题的解:

a r g m i n x ′ l ( x ′ ) s . t ∣ ∣ x − x ′ ∣ ∣ ∞ ≤ ϵ argmin_{x'} \mathcal{l}(x') \\ s.t \ ||x-x'||_\infty \le \epsilon argminx′l(x′)s.t ∣∣x−x′∣∣∞≤ϵ l \mathcal{l} l是一个稍后讨论的损失函数,由攻击者基于他们拥有白盒访问权的本地训练的阴影模型的输出构建。 x x x的算法力求优化样品输出样本 x a d v x_{adv} xadv: 1)使阴影模型的损失函数最小化,这与样本绕过CM的能力相对应;2)确保原始示例和对抗样本之间的差异的规范低于某个小阈值 ϵ \epsilon ϵ 。

(2)损失函数:

接下来我们介绍损失函数 l \mathcal{l} l。回想一下,我们的攻击者希望干扰输入的欺骗语音样本,以绕过CM,同时保留样本中受害者的声纹、文本内容以及受害者的声音与人类侦听者的相似之处。通过选择一个足够小的 ϵ \epsilon ϵ 来满足保持与受害者声音相似的要求(人类和机器认为ASV很容易受到欺骗攻击)和文本内容。因此,损耗函数只与绕过CM有关。

构建这一损失函数的过程是由我们从IV-C的见解所指导的,这导致了 A E AE AE必须满足两个需求才能构建成功的对抗样本:

i.扰动必须能承受有耗(逆)谱变换的影响。

ii.受害者的声纹必须被保存。

下面,我们将分别处理这两个要求,并给出可能的损失函数。

i.时域信号的对抗操纵

为了克服在谱图中引入对抗扰动并从中重构信号时所遇到的障碍,我们建议在输入域(即时域)中生成对抗扰动,直接干扰输入波形。假设损失函数 l F : F → R \mathcal{l_F}: F \to \mathbb{R} lF:F→R,其中F是特征空间。由于ASV和CMs作用于频谱表示,这种损失函数是最常见的。当生成我们的对手时,我们希望优化原始波形本身的损失。给定从输入中提取的特征集合上定义的损失函数 l F \mathcal{l_F} lF,以及特征提取器 g : X → F g: X \to F g:X→F,我们将损失 l \mathcal{l} l定义为 l = l F ∘ g \mathcal{l}= \mathcal{l_F} \circ g l=lF∘g。假设存在一个可微分的 l F \mathcal{l_F} lF,带有一个梯度支持的实现。另一方面,特征,比如MFCC特征提取器,LPMS,或CQCC通常在库不支持实施梯度反向传播(如librosa),因为当学习输入是可训练参数而不是信号的模型权值时,不需要这样的功能。由于执行对抗优化的典型过程涉及到输入的梯度下降(上升)的多个步骤,我们需要一种方法将特征提取器的梯度传播回原始波形阶段。

为了解决这个问题,我们在Python的Tensorflow中重新实现了支持梯度的特征提取器。因此,我们的特征提取器可以接收并操作由我们的输入向量构造的张量。这些函数能够在时域输入信号的基础上计算特征的梯度。

最后,使用链式法则,我们现在能够将梯度传播回原始信号层,因为:

l = l F ∘ g ⇒ l ( x ) = l ( g ( x ) ) ⇒ ∂ l ∂ x = ∂ l F ∂ g ⋅ ∂ g ∂ x \mathcal{l}= \mathcal{l_F} \circ g \Rightarrow \mathcal{l}(x) = \mathcal{l}(g(x)) \Rightarrow \frac {\partial \mathcal{l}} {\partial x} = \frac {\partial \mathcal{l}_F} {\partial g} \cdot \frac {\partial g} {\partial x} l=lF∘g⇒l(x)=l(g(x))⇒∂x∂l=∂g∂lF⋅∂x∂g 该方法消除了IV-C1中直接对输入施加对抗扰动时出现的所有问题,防止了逆变换阶段的损失。

提出损失1

ADVCM(对抗性CM):假设攻击者可以构建一个影子CM,标记为 C M S CM_S CMS,直接的方法是使用该模型的损失函数。通过最小化这个损失,我们保证我们的影子CM更有可能接受这个样本(我们假设一个更低的损失对应于一个真正的样本)。对抗样本的可迁移性(《Towards understanding and improving the transferability of adversarial examples in deep neural networks》)也将使该样本绕过目标CM。这种方法已经解决了之前所有针对CMs的对抗样本的工作中的挑战,因为我们直接操纵时域信号的方法消除了重构误差。该方法在算法1中给出。

算法将随机噪声 δ \delta δ 初始化为对抗扰动,其中我们从 [ − ϵ , ϵ ] [-\epsilon, \epsilon] [−ϵ,ϵ]中均匀采样 δ \delta δ。我们采用梯度下降的方法使损失函数最小化来解决优化问题。为了避免从频谱表示中重建信号,我们将 x x x作为原始信号进行操作。在每次迭代中,我们取当前的样本 x ′ x' x′,并通过梯度支持的特征提取器提取阴影CM使用的特征:

f e a t s = g C M S ( x ′ ) feats = g_{CM}^S(x') feats=gCMS(x′) 这些特征被用来计算CM的损失,即 l o s s = C M S ( f e a t s ) loss = CM_S(feats) loss=CMS(feats)。用链式法则计算梯度:

G r a d s = ∇ x ′ ( ∇ f e a t s ( L o s s ) ∗ f e a t s ) Grads = \nabla_{x'}(\nabla_{feats}(Loss)*feats) Grads=∇x′(∇feats(Loss)∗feats) 这些梯度使我们能够执行梯度下降收敛到最优解:

x ′ ⟵ c l i p ϵ ( x ) { x ′ − α ∗ s i g n ( G r a d s ) } x' \longleftarrow clip_{\epsilon(x)}\{ x' - \alpha * sign(Grads) \} x′⟵clipϵ(x){x′−α∗sign(Grads)} 这里, α \alpha α是我们根据经验调整的学习率, ϵ ( x ) \epsilon(x) ϵ(x)代表了边界 ( x − ϵ , x + ϵ ) (x-\epsilon, x+\epsilon) (x−ϵ,x+ϵ),使每一步数据都保持在 x x x的 L ∞ L_\infty L∞区间中,以满足最小的失真要求。上面的过程返回一个时域对抗样本 x a d v x_{adv} xadv。

ii.保留受害者的声纹

虽然ADVCM可以在白盒设置中成功击败任何CM模型,但这并不是联合ASVCM部署的情况。忽略ASV的优化可能无法制造成功绕过这两个系统的对手。生成对抗样本需要对欺骗样本应用扰动。不管这些样本最初是否能够通过ASV,添加的噪声可能会去除说话者的声纹。我们将此称为CM过拟合现象,应用的扰动可能确实有助于通过消除机器假象绕过欺骗检测器。然而,用于应用这些变化的影子CMs并没有经过训练来识别或保留特定用户的声纹。因此,在优化过程中,这些用户特定的提示信息可能会被污染,因为CM主要关注的是消除机器签名,这将导致样本被目标ASV拒绝。

考虑到这些观察结果,一个理想的对抗样本生成策略将完全缓解CM过拟合效应,以确保鲁棒性。因此,对影子CM的依赖是次优的,我们接下来提出一个更好的替代方案。

提出损失2

ADVSR(对抗式说话人正则化):我们建议使用一种新颖的损失函数,当最小化时,可以间接获得更高质量的欺骗示例,可以绕过CMs而不去除受害者的声纹。我们失去的选择是一个影子ASV。下面我们将解释为什么这样一个功能能够产生能够击败CMs和ASV的通用对手。与我们实验的ASV一致,我们假设受害者的声纹是真实的声音记录。考虑到攻击者访问影子ASV记为 A S V S ASV_S ASVS的损失是 l A S V l_{ASV} lASV,我们认为,如果攻击者获得了受害者的单个真实参考记录(可能与存储在服务器上的受害者的声纹不同),记作 y y y,他们可以通过损失函数优化欺骗样本 x x x:

l A S V S ( x , y ) l_{ASV_S}(x, y) lASVS(x,y) 有趣的是,这将导致一个更自然的样本,能够绕过CMs,同时保留声纹。我们的假设如下:欺骗样本是由SS或VC算法产生的,试图模仿受害者的声纹。由于这些算法存在缺陷,它们会产生人工产物;也就是帮助CMs识别欺骗样本的人工制品。这些细微差别可能通过人类通常无法产生的类似机器的效果表现出来,或者以计算机无法捕捉到的缺乏人类特征的形式表现出来。在这两种情况下,我们的样本的差异证明了机器参与了伪造样本的创建,因此它将显示出与任何真实样本的差异。

通过根据ASV的损失对欺骗样本进行优化,消除了上述差异。这个想法是把用户的声纹刻在欺骗的样本中,并通过在这个过程中包含ASV来进一步优化它。我们遵循的基本原理是,ASV的损失表明,在两个样本 x x x和 y y y中的说话人是不同的,我们把这归因于其中一个样本是由机器“说”的。当ASV消除这些差异时,机器的特征作为一种副作用被消除了。因此,样本 x x x不像机器,能够绕过CM,而不使用阴影CM进行优化。我们的新策略的另一个优点是ASV保留了受害者的声纹。最后,通过整合前面介绍的时域对抗扰动方法,避免破坏性重构噪声,这是使攻击成功的关键。算法2描述了这种方法。总的来说,它与算法1相同,只是损失函数被阴影ASV的损失所代替。

提出损失3

ADVJOINT:最后,我们提出了一个结合ASV损失和CM损失的联合损失函数。ASV损失作为一种正则化方法,防止对抗样本过度拟合到CMs。CM损失力求提供更健壮的任务特定扰动,而ADVSR可能会错过这些扰动。由于任务的差异,ASV损失恰当地诱导足够欺骗CM的所需扰动的能力可能仍然有限,并且还受到ASV和CM受类似的低级特征影响的程度的影响。共同地,我们期望CM损失产生所需的扰动,而ASV防止上述过拟合并保留受害者的声纹。值得注意的是,由于我们的方法能够将CMs的误差传播到时域的输入,所以定义和使用联合损失函数才成为可能,因为ASV和CMs依赖于不同的特征集。算法3描述了这种方法。优化阶段所要最小化的联合损耗函数为:

λ 1 l A S V S ( x , y ) + λ 2 l C M S ( x ) \lambda_1l_{ASV_S}(x,y) + \lambda_2 l_{CM_S}(x) λ1lASVS(x,y)+λ2lCMS(x) 其中, y y y为真实样本, λ 1 λ_1 λ1和 λ 2 λ_2 λ2为两个待调的超参数。

5 实验

我们的实验是在黑盒环境中进行的。我们假设攻击者无法访问用于训练目标模型的数据集,也无法访问这些系统的体系结构。为了便于参考,并说明可迁移性对攻击成功率的影响,我们还提供了白盒设置的结果。根据我们的威胁模型,我们评估攻击的三个因素:1)欺骗机器的能力(即ASV和CMs), 2)内容保留,3)从真实样本到人类判断的不可区分性。

A 愚弄机器

我们首先评估我们的攻击能力以欺骗联合ASV-CM系统。我们假设攻击者拥有最先进的VC或SS算法(见IV-D),并认为评估生成的欺骗语音的质量超出了范围。因此,我们的起始点是一个欺骗样本,我们向其添加对抗噪声。

数据集

我们主要使用ASVspoof2019数据集的逻辑访问(见VIII)部分(《ASVspoof 2019: A large-scale public database of synthesized, converted and replayed speech》),其中包括来自107名说话人(46名男性和61名女性)的样本。对于每个说话者,数据集包含使用VC或SS算法生成的说话人语音中的真实样本和欺骗样本。数据集被划分为三个部分:训练、开发和评估。每个训练和开发数据集包含来自20个说话人的样本,而评估数据集的样本来自67个说话人。就所包含的说话人而言,数据集是不相连的,这与我们的威胁模型一致,我们假设攻击者可能无法访问目标模型的内部结构。

设置

我们首先给出了指定应用程序场景的实验。对于电话网络场景的实验在VI中进行。对于CMs,我们使用三种不同的架构进行实验:lcnnHalf、lcnnFull和SENet(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》)。这些或高度相似的架构被提交到ASVspoof2019挑战赛,并在15个最佳竞争系统中得分。对于ASV,我们采用Li等人(《Adversarial attacks on GMM i-vector based speaker verification systems》)提出的GMM i-vector架构。我们通过改变超参数来使用不同的阴影/目标架构,这些超参数决定了i-vector的维数(阴影:400,目标:300),以及GMM模型中的高斯函数数(阴影:2048,目标:1024)。我们认为,即使在黑盒场景中,这些变化也足以捕捉到真实世界的攻击者的知识,因为GMM i-vector模型被广泛使用,因此它很可能是攻击者和目标ASV的选择。由于我们研究的大规模性质和所需的大量计算资源,我们在这里选择不探讨x-vector体系结构。然而,VI中的实验假设了一个限制性更强的场景(电话网络),并且针对x-vector ASV的目标系统(使用i-vector阴影)的高成功率也保证了在我们这里考虑的场景下的成功。

我们的CMs的输入特性是LPMSs,而ASVs的输入特性是MFCCs。对于目标系统,我们部署了ASV和CM模型,共同判断给定的样本。在攻击者一方,我们基于攻击方法安装阴影模型(对于ADVCM和CMSPEC只有一个阴影CM,对于ADVSR只有一个阴影ASV,对于ADVJOINT同时有一个阴影CM和一个阴影ASV)。CMSPEC是在特征域中生成对抗实例的方法,正如现有攻击(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》,《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》)所做的那样。

我们在ASVspoof2019训练部分训练影子CMs ( l c n n H a l f s lcnnHalf_s lcnnHalfs、 l c n n F u l l s lcnnFull_s lcnnFulls和 S E N e t s SENet_s SENets),而目标CMs ( l c n n H a l f t lcnnHalf_t lcnnHalft、 l c n n F u l l t lcnnFull_t lcnnFullt和 S E N e t t SENet_t SENett)在开发部分训练。这样,我们的黑盒假设就被保留了。用于生成训练和开发部分中包含的欺骗示例的VC和SS算法是相同的,正如在第三节中所述,这仍然会导致攻击者的强大程度与真实世界的对手一样。为了训练ASV,我们只使用真实的样本。影子ASV a s v s asv_s asvs使用ASVspoof2019培训部分进行培训,而目标ASV a s v t asv_t asvt使用开发部分。所有模型的基线性能见附录A中的表VI。所有的实验都是在一台服务器上运行Gentoo 2.6操作系统,CPU为Intel Xeon Gold 6238 Cascade Lake 2.1 GHz,内存为64G,两个Turing T4 GPU,内存为16G。

实验设计

由于我们有三个不同的CM架构和一个ASV,我们有三个组合目标系统的选择。同样地,我们最后也得到了三种可能的影子系统组合。由于攻击者不知道目标体系结构,所以我们没有在同一个实验中同时包含影子系统和目标系统的相同体系结构。因此,我们总共有六种攻击配置。在所有这些配置中,阴影系统和目标系统具有不同的体系结构和不同的训练集。

评价指标

我们关注攻击者试图用假样本欺骗语音认证系统的情况。因此,我们只关注恶搞的语音录音,在我们的评估中不包括任何真实的样本。具体来说,我们从ASVspoof2019的评估部分的63K个欺骗语音实例中随机选择20K个样本,并将我们的攻击成功率定义为使用我们的算法之一对这些样本生成的对手的错误接受率(FAR)。要接受对抗样本A,它需要绕过ASV和CM。对于每个A,目标系统接收A应该属于的说话人ID,并检索存储在系统中的同一说话人的注册话语。这个报名短语是说话人在ASVspoof2019评估部分的真实录音之一。通过这样做,目标系统可以调用A上的ASV模型,以根据检索到的声纹验证所声明的身份。

我们使用以下术语: X / Y X/Y X/Y表示ASV-CM部署(要么两者都是影子模型,要么两者都是目标系统), X X X是ASV, Y Y Y是CM。 S − T S - T S−T表示阴影-目标配置。也就是说,我们使用影子系统 S S S去攻击目标系统 T T T去创造对抗例子。对于CMSPEC和ADVCM,白盒结果只表示样本绕过阴影CM的能力(因为没有阴影ASV)。对于ADVSR,白盒结果同样代表了与受害者用户声纹匹配的样本中阴影ASV的置信度。对于ADVJOINT,结果考虑了阴影ASV和CM的结合。通常,所有的黑盒系统,除了CMSPEC(见下文),都由ASV和CM组成。

结果

(1)CMSPEC

我们首先介绍了通过传统特征域对抗方法对CMs(《Adversarial attacks on spoofing countermeasures of automatic speaker verification》,《Black-box attacks on spoofing countermeasures using transferability of adversarial examples》)获得的结果,以证实我们关于这些方法无效的主张(见IV-C)。结果见表Ⅰ和Ⅱ在每一行中,粗体显示的数字对应于该特定配置的最高成功率。

ϵ \epsilon ϵ表示摄动预算(即对抗噪声 L ∞ L_\infty L∞范数的极限)。 ϵ = 0 \epsilon=0 ϵ=0的列表示没有进行对抗修改的欺骗样本的成功率。表Ⅰ列出了白框设置的结果,每个阴影CM包含两行;第一行(直接)是直接输入分类器时对抗特征的成功率(避免了恢复操作)。第二行(重构的)是添加恢复操作时的成功率。

我们让 ϵ \epsilon ϵ从 0 0 0到 20 20 20。对于每一种CM类型,在白盒设置中,直接将对抗频谱图输入目标系统的成功率接近100% ( ϵ = 10 \epsilon=10 ϵ=10)。当从对抗频谱图中重建音频时( ϵ = 10 \epsilon=10 ϵ=10时的“重建”),这些分数会显著下降。这些差异源于反向转换的效果,它会极大地降低修改后信号的质量。对于 l c n n F u l l s lcnnFull_s lcnnFulls,重建后的样品成功率仍为 100 % 100\% 100%。我们将其归因于CM阴影对对抗样本的过度拟合,随着 ϵ \epsilon ϵ的增长,CM阴影变得更加主导。对于如此大的 ϵ \epsilon ϵ的值,对抗样本明显不同于最初,这种改变很好的适应了CM的特质。尽管其强度足以承受逆变换,但对手无法转移到其他模型,如表二所示。

表Ⅱ中的黑盒结果表示使用阴影CM从特征域扰动的谱图中恢复对抗波形后,对抗波形对目标CM的成功率。这是唯一一个黑盒系统只包含一个CM组件的实验。由于我们将ASV识别为进一步降低对CMs的对抗性攻击性能的一个额外因素,我们在这里排除了它们,因此结果可以用来证明谱图级对抗生成策略中的缺陷。

与白盒设置相比,我们可以看到,与基线( ϵ = 0 \epsilon=0 ϵ=0)相比,所有的影子架构几乎都无法提高黑盒设置中的成功率,在基线中,没有应用对抗扰动。因此,所产生的对抗样本是不能转移的,因为作为重建的副产物,它们的“大小”降低了,证实了IV-C中提出的要求。下面提供的实验进一步证实了这一结果,显示了ADVCM是如何设法达到相关的成功率的。

(2)ADVCM, ADVSR, & ADVJOINT

表Ⅲ&Ⅳ部分分别展示了我们的新技术在黑盒和白盒设置下直接在时域生成对抗样本的成功率。我们根据IV-D中讨论的三种方法生成对抗样本:ADVCM、ADVSR和ADVJOINT。回想一下,扩展了ADVSR的ADVSR和ADVJOINT都需要一个额外的真实参考样本,在优化阶段属于受害者。我们从数据集的评估部分获得这些真实的样本。

基线系统

ASV易受欺骗攻击的弱点已经很明显了。为了验证我们的ASV和欺骗样本也是如此,我们评估了我们的欺骗(非干扰)记录对目标ASV单独(没有CM)的成功率,即 a s v t asv_t asvt。仿真实例的成功率高达 71.65 % 71.65\% 71.65%。

在表III中,每行的目标架构是一个组合的ASV-CM部署。我们感兴趣的是基线情况( ϵ = 0 \epsilon=0 ϵ=0),它显示了缺乏对抗干扰的部分虚假音频,能够欺骗这样的联合部署。所示的成功率很低( 3.64 % 3.64\% 3.64%或更少),这明显低于单独对抗 a s v t asv_t asvt的成功率,这也解释了现代语音认证系统由于CMs而产生的安全性错觉。行业部署的成功率甚至更低。

我们的攻击

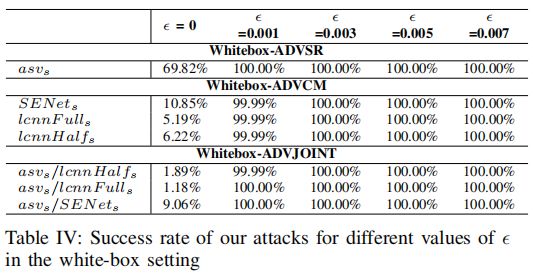

对于对抗修改样品( ϵ > 0 \epsilon > 0 ϵ>0),相比于在特征空间中进行操作(见表I和表II),由于输入音频幅度明显小于谱图值,需要更小的 ϵ \epsilon ϵ值。在 ϵ = 0.003 \epsilon=0.003 ϵ=0.003时,我们所有的方法都会产生100%的白盒成功率(见表Ⅳ)。

我们从调查ADVCM开始。与基线( ϵ = 0 \epsilon=0 ϵ=0)相比,ADVCM显著降低了目标ASV-CM的防御能力。ADVCM完美地构建了对抗样本,击败了白盒设置中的阴影CM(表Ⅳ中 ϵ = 0.003 \epsilon=0.003 ϵ=0.003)。该策略在黑盒设置中面临挑战(见表III)。在 a s v t / l c n n F u l l t asv_t/lcnnFull_t asvt/lcnnFullt的黑盒设置中,通过ADVCM获得的最佳成功率为 22.73 % 22.73\%% 22.73% ( ϵ = 0.001 \epsilon=0.001 ϵ=0.001, 阴影模型为 S E N e t s SENet_s SENets)。同样, a s v t / l c n n H a l f t asv_t/lcnnHalf_t asvt/lcnnHalft的最佳成功率为 52.24 % 52.24\% 52.24% ( ϵ = 0.005 \epsilon=0.005 ϵ=0.005, 阴影模型为 S E N e t s SENet_s SENets), a s v t / S E N e t t asv_t/SENet_t asvt/SENett的最佳得分为 66.58 % 66.58\% 66.58% ( ϵ = 0.003 \epsilon=0.003 ϵ=0.003, 阴影模型为 l c n n H a l f s lcnnHalf_s lcnnHalfs)。这些数字远远大于非对抗性欺骗攻击( ϵ = 0 \epsilon=0 ϵ=0)所获得的数字,这表明了广泛使用的系统的漏洞,并进一步建立了直接在时域中生成对抗样本的可靠性。尽管如此,它们的成功率仍远未达到白盒( 100 % 100\% 100%)。这是没有考虑到ASV存在的结果。对抗噪声不仅不希望在音频样本中嵌入受害者用户的声纹,而且还可能引入扰动,导致该签名被删除。

当我们将焦点转移到ADVSR时,我们注意到 a s v t / l c n n F u l l t asv_t/lcnnFull_t asvt/lcnnFullt的最大成功率为 11.59 % 11.59\% 11.59% ( ϵ = 0.001 \epsilon=0.001 ϵ=0.001, 阴影模型为 a s v s asv_s asvs)。它对 a s v t / l c n n H a l f t asv_t/lcnnHalf_t asvt/lcnnHalft的最佳成功率为 36.1 % 36.1\% 36.1% ( ϵ = 0.005 \epsilon=0.005 ϵ=0.005, 阴影模型为 a s v s asv_s asvs),对 a s v t / S E N e t t asv_t/SENet_t asvt/SENett的最佳成功率为 93.57 93.57% 93.57 ( ϵ = 0.007 \epsilon=0.007 ϵ=0.007, 阴影模型为 a s v s asv_s asvs)。这些结果证实了ADVSR作为损失函数的有效性。对于 a s v t / S E N e t t asv_t/SENet_t asvt/SENett, ASVDR的成功率是三种方法中最优的。在最后一个场景中,该方法能够以近乎完美的成功欺骗目标ASV和CM,并且优于ADVCM和ADVJOINT,尽管ADVSR的损失函数只考虑ASV成分而忽略了CM。在另外两种情况下( a s v t / l c n n H a l f t asv_t/lcnnHalf_t asvt/lcnnHalft和 a s v t / l c n n F u l l t asv_t/lcnnFull_t asvt/lcnnFullt),ASVDR优于ADVCM。ADVSR设法保存受害者的声纹,并消除了ADVCM的CM过拟合现象(见IV-D)。此外,通过这种方法将损失最小化,使伪造样本听起来更像与它们相关的人类说话人,因此,消除了机器人工制品痕迹,从而产生更自然的通用对抗样本,绕过CMs(见IV-D)。仅使用ADVSR(与 ϵ = 0 \epsilon=0 ϵ=0相比)显著提高了欺骗CMs的能力,验证了这一说法,并确立了这种方法的有效性。然而,IV-D2中概述的局限性导致这种方法不能充分发挥对抗样本的潜力。例如,ADVCM在某些情况下仍然取得了较高的成功率。

最后,我们检验了我们的新ADVJOINT方法。对于 a s v t / l c n n F u l l t asv_t/lcnnFull_t asvt/lcnnFullt和 a s v t / l c n n H a l f t asv_t/lcnnHalf_t asvt/lcnnHalft, ADVJOINT的成功率在三种方法中最高,分别为 34.09 % 34.09\% 34.09% ( ϵ = 0.001 \epsilon=0.001 ϵ=0.001,阴影模型为 a s v s / S E N e t s asv_s/SENet_s asvs/SENets)和 73.5 % 73.5\% 73.5% ( ϵ = 0.007 \epsilon=0.007 ϵ=0.007,阴影模型为 a s v s / S E N e t s asv_s/SENet_s asvs/SENets)。ADVJOINT可实现的 a s v t / S E N e t t asv_t/SENet_t asvt/SENett的最高成功率为 91.49 % 91.49\% 91.49% ( ϵ = 0.007 \epsilon=0.007 ϵ=0.007,阴影为 a s v s / l c n n F u l l s asv_s/lcnnFull_s asvs/lcnnFulls)。注意,在这个单独的实例中,ADVSR的性能比ADVJOINT好。我们将此归因于使用ADVJOINT制作的样本略微过度拟合用于制作它们的CM分类器的 l c n n F u l l s lcnnFull_s lcnnFulls架构,导致它们表现出较低的可转移率。然而,对于这个目标配置,这两种方法的性能差异是微不足道的。总而言之,ADVJOINT方法被证明能够生成高质量的对抗样本,从而绕过现实世界的部署。平均而言,该方法显著优于ADVCM和ADVSR。

总结

研究结果清楚地揭示了现代语音认证平台对对抗样本的脆弱性。尽管这些系统对非主动欺骗攻击很健壮( ϵ = 0 \epsilon=0 ϵ=0的攻击成功率不超过 3.64 % 3.64\% 3.64%),但可以使用我们在输入域中制对抗样本造的新攻击来规避这些系统。我们的第一个方法,ADVCM,它只制造对抗影子CMs的对抗样本,显著降低了这些防御的性能。也就是说,在任何情况下,ADVCM都不是最佳策略。我们的第二种方法,ADVSR,在构建对手的同时考虑了ASV组件,以保存受害者的声纹并消除CM过拟合。它可以提高ASV-CM联合部署的成功率。尽管如此,由于某些欺骗语音对ASV来说是不可见的,通过结合这两种方法,ADVJOINT获得了最佳成功率(与ADVCM相比高达2倍,与ADVSR相比高达3倍)。总之,我们的发现是有关的,表明了保护有价值资源的系统如何通过对抗攻击变得无用(成功率高达 93.57 % 93.57\% 93.57%)。

B 内容保留

在这一节中,我们评估我们的攻击在转录单元的鲁棒性。我们的目标是证明我们的攻击能够保存给定(欺骗)音频剪辑的文本内容,以便将它们精确地转录为所需的身份验证文本。

实验设计

请注意,我们依靠优化机器生成(修改)的语音来产生高质量的欺骗音频。我们的攻击假设存在最先进的欺骗算法,如Shen等人的《Natural TTS synthesis by conditioning wavenet on mel spectrogram predictions》,攻击者可以访问。这种算法以能够产生高质量的欺骗语音而闻名。评估这些算法超出了本文的范围,我们假设攻击者可用的算法具有这种质量,并且能够生成与语音到文本转录器确定的给定文本相匹配的语音。不幸的是,对于用于在ASVspoof2019数据集中创建欺骗样本的所有算法来说,未必都是这样;虽然有些算法可以生成高质量的语音,但有些算法的准确性较低。

我们使用谷歌语音识别模块,可以通过语音识别Python包获得。我们从之前的实验中随机选择25个对抗样本,使用ADVJOINT方法生成 ϵ = 0.003 \epsilon=0.003 ϵ=0.003和 a s v s / S E N e t s asv_s/SENet_s asvs/SENets作为阴影架构。从黑箱设置中设法绕过目标模型的随机选择的对抗样本,以评估端到端攻击的成功程度。为了消除欺骗算法质量对结果的影响,并排除由于我们无法正确理解样本中的内容而导致的任何不准确性,我们选择以下策略:为每个选择对抗样本,我们找到原始样本数据集(没有对抗扰动)。这两个样本被传递到语音识别模块。我们测试该系统转录的两个样本是否相同。通过这样做,我们保证我们的对抗扰动保持文本的正确性(并且假定欺骗算法生成的音频被正确转录,攻击者的目标就实现了)。

结果

在25对测试对中,18对转录到相同的内容( 72 % 72\% 72%的成功率)。我们手工检查了7个失败的样本对。这7个样本中有5个的内容是不可理解的,无论是原始的欺骗样本,还是相应的对抗样本。因此,这些样本失败是很自然的。我们的对抗样本引擎试图删除这些样本中占主导地位的机器人工制品(它们听起来不像人类),我们怀疑这是转录内容差异的来源。第6对中的原始样本被转录成*“the conference of the first test”,而听了之后就会清楚地意识到这个输出是错误的,因为说话人说的是“the conference is the first test”。这与我们对抗样本的输出相匹配。通过删除一些样本,内容对语音识别模块来说变得更加清晰。在第7对中,我们的对抗样本确实失败了,因为它被转录为“no irony was not lost”,与原始样本相反,它被转录为“the irony was not lost”*,与样本的实际内容相匹配。总的来说,当丢弃5个“较差”的测试对时,我们的对抗样本引擎的成功率是 95 % 95\% 95%( 19 / 20 19/20 19/20)。

我们进一步手工验证,在绝大多数情况下,当这些对被转录成相同的文本时,文本确实与这些对音频样本的内容匹配。在没有匹配的情况下,差异很小(一个单词被误译了)。语音转文本算法的不完善保证了在执行语音身份验证时使用错误阈值来允许请求的短语和转录的短语之间的细微差异,就像在Voicfox(《Voicefox: Leveraging inbuilt transcription to enhance the security of machine-human speaker verification against voice synthesis attacks》)中所做的那样。我们注意到,同一篇论文认为,恶搞言论比真实言论更容易被误译,因此建议将这种现象作为一种防御策略。但是,我们在实验中并没有遇到这个问题。无论如何,我们认为这方面超出了本工作的范围,并提出了一个基于VII-B中对抗性优化的可能的解决方案。

C 愚弄人类

我们的威胁模型要求我们的攻击必须愚弄人类听众(HJ)。给定一个音频样本、一个声明的身份和一些文本,这个人负责验证该样本1)来自声明的用户,2)与文本内容匹配。我们的攻击优化了由最先进的欺骗算法生成的合成示例。因此,我们避免评估欺骗算法本身,而是评估我们的对抗性攻击。我们求助于ABX听力测试(《Standardizing auditory tests》),参与者一开始被要求听两个样本, A A A和 B B B。然后,两个样本中的一个, X X X,被随机选择并重放给参与者,他必须决定 X X X是 A A A还是 B B B。

在我们的研究中, A A A和 B B B是一个欺骗样本和由它产生的对抗音频(反之亦然)。这样做的目的是为了表明,听者无法以比随机成功概率更好的概率识别重放的样本。这种设置意味着对我们的敌对样本的限制远比我们的攻击所需要的要多:我们需要对抗样本听起来只像是受害者说的,并保存内容。但我们要求与原样品保持一致。

我们对MTurk(《Amazon Mechanical Turk Platform》)进行了IRB批准的用户研究,使用了来自V-B的25对相同的测试对。根据ABX指南(《QSC ABX Comparator user manual》),我们将研究限制在25个样本,以避免由于疲劳或缺乏注意力而导致的错误反应。此外,为了确保高质量的反馈,我们筛选了MTurk支持率低于 95 % 95\% 95%的参与者。我们收到了20份回复,其中19份包含了25个ABX任务的答案。一位受访者在完成20个问题后选择了辞职。为了确保每一对的结果不受其在测试中的位置的影响(越到最后,参与者的注意力就越不集中),我们对每个受试者的任务进行了重组。

对于这25对测试,我们总共收到了495个回答,这些回答被汇总到每对样本中,并转换成每对样本中正确回答的比例。为了验证样本对人类听众来说是无法区分的,我们在假设回答是随机选择的情况下,制定了一个假设检验。我们检验原假设 H 0 : μ = 0.5 H_0: \mu = 0.5 H0:μ=0.5,其中 μ \mu μ是每个测试对选择正确答案的真实概率,使用单样本 T T T检验。我们未能拒绝原假设,显著性水平为 α = 0.05 α = 0.05 α=0.05, p p p值为 0.142 0.142 0.142。25对样本的平均比例为 0.54 0.54 0.54, 95 % 95\% 95%置信区间 [ 0.486 , 0.594 ] [0.486,0.594] [0.486,0.594]。我们的结论是,没有足够的证据来反驳“反应是随机选择的”这一假设,从而确定了我们攻击的有效性和它们愚弄人类听众的能力。

6 通过电话网络攻击

现在,我们提出了针对过电话网络场景的CMs的对抗性攻击。据我们所知,我们是第一个为有针对性的攻击探索这种设置的人,唯一已知的通过电话网络对音频系统的对敌攻击是非针对性的(语音被干扰,因此它被任意错误分类)(《* Hear ”no evil”, see ”Kenansville”: Efficient and transferable black-box attacks on speech recognition and voice identification systems *》)。我们提供了高级的针对机器和人类的攻击,目的是模拟特定的受害者。通过电话网络的攻击已经被证明是很难发起的,因为有三个主要的挑战:编解码器、包丢失和抖动(《The faults in our ASRs: An overview of attacks against automatic speech recognition and speaker identification systems》)。

编解码器用于对音频信号在网络中传输前后进行编码和解码。现代VOIP和VOLTE服务提供商采用编解码器,在传输数据之前对数据进行压缩。实际使用的编解码器是有损的。当选择对抗样本作为攻击策略时,这一特性显著提高了难度,因为对抗扰动是不稳定的,因此不能保证在有损(噪声)编码/解码过程中保存下来。

第二个影响对抗样本成功率的因素是网络的数据包丢失,这导致即使在有无损编解码器的情况下,接收到的数据也不能完全匹配传输的信号。丢失 2 % 2\% 2%的数据包是正常的。电话网络上的对抗样本应该对包丢失具有鲁棒性。

最后,还有抖动效应。现代编解码器配备了抖动缓冲器,最大限度地减少抖动的影响。因此,抖动不是我们实验中考虑的因素。

A 模拟通过电话网络攻击

为了模拟真实的攻击,我们选择了开源的Opus编解码器(《Internet Engineering Task Force (IETF). Opus interactive audio codec》)。Opus是WhatsApp使用的高质量有损编解码器。此外,它与许多电话运营商和设备支持的增强语音服务(EVS)音频编码标准(《Enhanced Voice Services (EVS)》)相当。因此,我们的研究结果适用于电话以及VOIP电话。

为了发动攻击,我们生成对抗样本,用Opus对其进行编码,通过互联网将其从远程数据中心传输到我们大学的服务器上,使用UDP进行解码,并将其输入目标系统。Opus存储库(《Internet Engineering Task Force (IETF). Opus interactive audio codec》)包含一个子项目Opus -tools,该项目提供了一些脚本,可以促进我们的首次实验。首先,脚本opusenc接受一个音频波形并输出一个**.opus文件,该文件对应于该工具所编码的信号。其次,opusrtp接收Opus编码的信号,并通过RTP** (Opus基于UDP的应用层协议)将其发送到目的地。在目的地,我们可以使用opusdec,它将接收到的从pcap数据包中提取的opus编码文件作为输入,并将其解码回波形。该工具还允许我们设置我们希望在此阶段模拟的数据包丢失百分比。我们所有的实验都指定 2 % 2\% 2%的包丢失(模拟真实世界的网络)。在两个相隔很远的服务器之间发送样本会导致额外的包丢失和抖动。

B 对抗样本生成

如上所述,由于分组丢失和编解码器,在电话网络上传输对抗样本更具挑战性。为了克服包丢失的问题,我们为编码后的包添加冗余。Opus提供了自动生成冗余的选项,从而能够从预期的包丢失百分比(在我们的实验中为 2 % 2\% 2%)中恢复。还有有损编解码器的使用。这种损失通常是对抗攻击的主要挑战,它的发生是因为编解码器无法以 100 % 100\% 100%的精度解码压缩信号。这些原始信号和重建信号之间的差异可以看作是噪声,可以中和对抗扰动的影响。然而,对于这种形式的扭曲,我们的攻击自然是稳健的。原因是编解码器通过心理声学技术进行有损语音压缩,以丢弃无用的信息,并获得输入音频的紧凑表示,如人类(《*Psychoacoustic models for perceptual audio coding a tutorial review *》)所确定的。我们的攻击优化音频样本,通过插入类人“指纹”或消除机器人工制品来欺骗CMs。因此,我们希望我们的对抗性修改与音频编解码器高度兼容,这将认为它们(对人类)是必要的,从而使它们不会被丢弃。由于我们的时域对手是有效的线路设置,他们保持这样,当通过网络传输。也就是说,一些损失是可以预料的。为了克服这一问题,我们提出以下策略:

我们让函数 η : X → X η: X \to X η:X→X模拟编码/解码失真。为了从语音 x x x生成对抗样本,我们首先将其通过编码/解码阶段,以获得噪声 η ( x ) η(x) η(x),它类似于远程系统接收的信号,并封装了添加的解码器噪声。此时, η ( x ) η(x) η(x)被输入阴影CM,对抗噪声 δ δ δ被制作成 η ( x ) η(x) η(x)。最后, x + δ x + δ x+δ被转发到服务器。由于 δ δ δ表示一个难以察觉的微小扰动,我们预计 x x x和 x + δ x + δ x+δ在通过编解码器传播时(或在数学上)会经历相同的噪声。

l i m δ → 0 η ( x + δ ) = η ( x ) + δ \underset {\delta \to 0} {lim} \ \eta (x+\delta) = \eta (x) + \delta δ→0lim η(x+δ)=η(x)+δ 由于我们设计的 δ δ δ使得 η ( x ) + δ η(x) + δ η(x)+δ是一个有效的对抗样本,我们期望 η ( x + δ ) η(x + δ) η(x+δ)在服务器接收到(因为我们编码了 x + δ x + δ x+δ,其中加入了解码噪声)也欺骗目标系统。

C 实验与结果

表V显示了我们的过电话网络实验的黑盒结果,其中涉及到来自V-A的相同的20K对样本。我们用ADVJOINT来生成对抗样本,因为我们证明了它比其他方法更好。在这些实验中,我们切换了先前实验中使用的目标和阴影模型,以证明我们的结果并不仅仅体现在初始配置上。这些实验还包括一个最先进的GMM x-vector模型作为目标ASV,以证明我们的对手也有能力转移到这些架构。因此,目标系统是ASV-CMs,其中ASV可以是GMM i-vector(与之前的 a s v s asv_s asvs相同),也可以是在不同的数据集(VoxCeleb数据集(《VoxCeleb: a large-scale speaker identification dataset》))上训练的GMM x-vector。这个模型在VoxCeleb测试分区上的初始EER值见附录A中的表VI。我们的GMM x-vector架构取自(《Adversarial attacks on GMM i-vector based speaker verification systems》)。

对于 ϵ \epsilon ϵ的每个值,我们有两列(i-vector/x-vector),这些列中的比率指的是针对目标ASV-CMs配置的成功概率,其中ASV模型是i-vector或x-vector。CM的目标在第二列中。非对抗欺骗攻击( ϵ = 0 \epsilon=0 ϵ=0)的成功率证明了目标ASV-CMs是鲁棒的。有趣的是,我们发现x-vector ASV比i-vector ASV更容易受到欺骗攻击。这是因为x-vector模型是一个参数更多的DNN,它在更多的数据上进行训练,使得它更准确。由于欺骗攻击的目的是使其听起来像受害者,所以x-vector越“精确”,性能就越“好”,因为它更容易受到欺骗攻击(它接受听起来像受害者的假样本)。具体来说,Li等人的(《Adversarial attacks on GMM i-vector based speaker verification systems》)展示了在VoxCeleb上训练x-vector模型时,x-vector模型如何优于i-vector模型。然而,当增加 ϵ \epsilon ϵ时,两个系统都变得非常脆弱。当 ϵ \epsilon ϵ值最大(0.007)时,成功率最高。请记住,在V-A中,大多数目标系统的最高成功率是在 ϵ \epsilon ϵ(0.001)的较低值上测量的。因为在本实验中攻击是通过网络传输的,并且由于前面提到的各种因素,消除了对抗干扰。为了能够仍然影响目标模型的决策,需要更大的扰动幅度。将 ϵ \epsilon ϵ值增加到0.007以上可能会导致更好的成功率。然而,这将降低恶搞语音的质量。找到一个最佳的位置是留给未来的工作。

我们的实验证明了电话网络对抗攻击的实用性,成功率高达 37.2 % 37.2\% 37.2%(相对于 5.79 % 5.79\% 5.79%的基线),并对部署的语音认证系统的可靠性提出了质疑。

7 讨论

A 我们攻击的实用性

在我们的所有攻击中,每个样本平均需要4秒生成对抗扰动,这使得它们非常实用,因为攻击者可以实时安装它们,并在与人类预期的时间一致的时间内响应身份验证请求。攻击者还需要事先生成合成语音,使用最先进的VC和SS算法(《Nuance Text-To-Speech》),这需要几毫秒。

B 减弱我们的攻击

依靠伴随人类语言的身体特征的活动检测技术,如VoiceLive(《VoiceLive: A phoneme localization based liveness detection for voice authentication on smartphones》)、VoiceGesture(《Hearing your voice is not enough: An articulatory gesture based liveness detection for voice authentication》)和EchoVib(《EchoVib: Exploring voice authentication via unique non-linear vibrations of short replayed speech》),是针对我们攻击的缓解策略,因为它们检测到没有人类说话者。尽管如此,这些方法可能并不总是适用,因为它们依赖于设备,并且需要用于与服务交互的设备的支持。例如,在过户电话网络场景中,后端服务器还需要支持从固定电话拨打电话的用户,这些用户不需要为这些防御装备所需的传感器。能够访问设备内部的攻击者也可以通过发动强大的攻击来绕过这些方法。也就是说,这些防御系统的融合可能是一个很有前途的方法。

另一类可能的防御包括对抗攻击减弱技术,特别是空间平滑和对抗训练(《Defense against adversarial attacks on spoofing countermeasures of asv》)、自我监督学习的对抗防御者(《Defense for black-box attacks on anti-spoofing models by self-supervised learning》)和音频压缩。然而,正如FAKEBOB(《Who is real Bob? Adversarial attacks on speaker recognition systems》)所示,空间平滑和音频压缩对于声学系统的攻击是无效的。Wu等人(《Defense for black-box attacks on anti-spoofing models by self-supervised learning》)假设在特征空间中生成的对手可能对我们的攻击具有有限的适用性。对抗训练和类似的方法(《Generative adversarial networks: An overview》),(《Adversarial attacks and defenses for speaker identification systems》),(《Auto-encoding variational Bayes》),(《Adversarial defense for deep speaker recognition using hybrid adversarial training》),(《Adversarial regularization for end-to-end robust speaker verification》)通常无法抵御由不同的对抗算法和参数(《Investigating robustness of adversarial samples detection for automatic speaker verification》)派生的攻击。

最后,Voicfox(《Voicefox: Leveraging inbuilt transcription to enhance the security of machine-human speaker verification against voice synthesis attacks》)建议转录器可以用来识别机器生成的音频,以击败语音合成攻击。然而,攻击者可能会敌对地尝试优化生成的语音,以欺骗语音到文本组件。对这一现象的探索有待于未来的工作。

C 未来的工作

我们的攻击需要访问一些根设备来注入对抗波形。这可能是多余的如果我们证明攻击能力在空中环境中生存。早期的工作已经证明,音频对抗样本可以通过麦克风(《Who is real Bob? Adversarial attacks on speaker recognition systems》)传输。在这种情况下,攻击者甚至可以利用受害者的设备进行攻击。在电话网络环境中,攻击必须经受住网络的失真。对两种有耗介质传输过程中传输速率的下降进行量化,并开发保持高传输成功率的方法是未来的研究方向。开发用于认证的面向验证的ML分类器是我们目前正在探索的另一个方向,该分类器本质上对对抗样本是健壮的。

8 相关工作

文献通常在两种主要情况下讨论欺骗攻击:逻辑访问(over-the-line)和物理访问(over-the-air)(《ASVspoof: the automatic speaker verification spoofing and countermeasures challenge》),并针对这两种情况提出了对策。在无线环境中,也就是说,当欺骗样本必须通过扬声器播放才能到达目标ASV时,针对人类声音系统和扬声器产生的声音之间的物理差异的各种方法被用来作为检测欺骗攻击的证据。这包括人类用户的发音手势(《Hearing your voice is not enough: An articulatory gesture based liveness detection for voice authentication》)、手机两个麦克风音位序列的到达时间差(TDoA)变化(《VoiceLive: A phoneme localization based liveness detection for voice authentication on smartphones》)、通过扬声器播放的音频频谱图(《Void: A fast and light voice liveness detection system》)所特有的人工制品,以及振动信号(《EchoVib: Exploring voice authentication via unique non-linear vibrations of short replayed speech》)。

我们考虑更有问题的防御场景,修改后的音频不需要通过扬声器播放。这被称为逻辑访问设置。在这里,威胁模型限制了我们可以使用的识别欺骗语音的工具,这些工具不依赖于电子扬声器的物理特性。ASVspoof挑战(《ASVspoof: the automatic speaker verification spoofing and countermeasures challenge》)长期以来一直是这种新型CM架构出现的平台,它既针对逻辑访问设置,也针对物理访问设置。然而,现有的研究已经证明,CMs自身也容易受到某些攻击(《A spoofing benchmark for the 2018 voice conversion challenge: Leveraging from spoofing countermeasures for speech artifact assessment》)。然而,后来出现了更先进的CMs,显示了更高的稳健性。上述攻击都是幼稚的、非主动的攻击,它们并不针对ASVs或CMs,而是作为一种良性技术的(不幸的)副产品绕过这些系统。

后来,随着对抗样本的引入,出现了更强大的、面向任务的攻击。自2017年以来,对声学系统(《Did you hear that? Adversarial examples against automatic speech recognition》,《Audio adversarial examples: Targeted attacks on speech-to-text》,《Houdini: Fooling deep structured visual and speech recognition models with adversarial examples》)]的敌对攻击就已为人所知。第一个研究ASVs上对抗样本的工作是由Kreuk等人提出的。作者在《Fooling end-to-end speaker verification with adversarial examples》语音信号的频谱表示中引入了扰动。然后,利用反变换恢复对抗音频。Li等人(《Adversarial attacks on GMM i-vector based speaker verification systems》)后来采用了相同的方法,他们也考虑了GMM i-vector/x-vector模型,并研究了对抗语音在ASV架构上的可转移性。FAKEBOB(《Who is real Bob? Adversarial attacks on speaker recognition systems》)演示了一个全黑盒场景中的攻击,使用了一个阈值估计过程。最近的作品(《Practical adversarial attacks against speaker recognition systems》,《Real-time, universal, and robust adversarial attacks against speaker recognition systems》)通过建模房间脉冲响应来探索空中攻击的实用性,但仅限于白盒设置。Jati等人(《Adversarial attack and defense strategies for deep speaker recognition systems》)比较了各种对抗性攻击并评估了已知防御的有效性。其他著作(《x-vectors meet adversarial attacks: Benchmarking adversarial robustness in speaker verification》,《Inaudible adversarial perturbations for targeted attack in speaker recognition》)主要关注基于x-vector的模型及其对对抗样本的脆弱性。SirenAttack(《SirenAttack: Generating adversarial audio for endto-end acoustic systems》)运行在逻辑访问设置中,并引入了一种方法来制造对抗自动说话人识别系统的对手,假设波形可以直接输入目标。这个假设在之前的其他著作(《Practical hidden voice attacks against speech and speaker recognition systems》,《Audio adversarial examples: Targeted attacks on speech-to-text》)中也有提出。但在SirenAttack中不考虑欺骗干扰对策。AdvPulse(《AdvPulse: Universal, synchronization-free, and targeted audio adversarial attacks via subsecond perturbations》)关注物理接入场景,并提出了一种基于惩罚的方法,结合噪声建模来生成通用物理访问对抗样本。为了更广泛地讨论对ASVs的对抗性攻击,我们参考Abdullah等人的(《The faults in our ASRs: An overview of attacks against automatic speech recognition and speaker identification systems》)。这些攻击都没有生成听起来像受害者的样本,在我们的威胁模型(III)下失败。

到目前为止,对CMs的对抗性攻击还没有得到足够的关注。第一项工作是Liu等人的成果。在《Adversarial attacks on spoofing countermeasures of automatic speaker verification》中光谱特征由阴影模型操纵,以制作对抗样本。作者通过跨不同架构的可移植性来考虑半黑盒设置。Zhang等人(《》)[71]的目标是使用迭代优化和阴影模型集合来增强可转移性。这些工作不包括有目标的ASVs。此外,对抗样本是在特征空间中生成的,因此无法在真实场景(IV-C)中构成威胁。

在讨论CMs和ASVs时,必须记住这两个是联合部署的。然而,针对联合ASV-CM系统的攻击尚未出现。文献为这些系统提出了几种可能的集成策略,尽管这些方法的鲁棒性仅通过对CMs进行训练的非主动攻击进行评估。Sahidullah等人(《Integrated spoofing countermeasures and automatic speaker verification: An evaluation on ASVspoof 2015》)首先引入了级联方法,Todisco等人(《Integrated presentation attack detection and automatic speaker verification: Common features and gaussian back-end fusion》)后来提出了一种更先进的高斯后端融合方案,将两种模型结合起来,Dhanush等人(《Factor analysis methods for joint speaker verification and spoof detection》)提出了一种联合方法,利用因子分析方法同时学习任务。Gomez-Alanis等人(《On joint optimization of automatic speaker verification and anti-spoofing in the embedding space》)提出了一个整合神经网络。Aljasem等人(《Secure automatic speaker verification (SASV) system through sm-ALTP features and asymmetric bagging》)通过一种新的特征集和通过非对称bagging的集成学习提出了一种集成防御。这些工作都没有引入专门针对集成系统的攻击。

8 结论

我们提出了第一个实际的对抗性攻击欺骗对策。我们的新算法能够生成高质量的欺骗语音,愚弄机器和人类,并使攻击者在安全关键环境中伪装成受害者,严重损害用户的安全。我们的攻击成功率令人担忧,主要是因为它们是在黑盒设置和现实威胁模型的假设下实现的,包括智能手机应用程序场景和电话会话设置,我们也演示了新的有针对性的攻击。我们的研究结果突出了语音认证系统的严重缺陷,并强调需要更可靠的机制。

Kassis A, Hengartner U. Practical attacks on voice spoofing countermeasures[J]. arXiv preprint arXiv:2107.14642, 2021.