issue3:linear classification

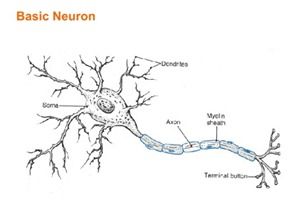

线性分类的最初发展来源于神经细胞,神经细胞接收其他神经元传来的信号,并且在效果叠加之后产生兴奋或者抑制的效果。基于神经细胞的特点,最初人们够早了感知器(perceptron)算法。

感知器的构造非常简单,实际上,它就是一个神经网络(neural network)的一层,而且这一层只有一个感知点。

具体在训练过程中,遇到分类错误的情况就做处罚,改变权值;如果预测是正确的,则不作任何改变。实质上,这个训练过程就是一个随机梯度下降法。

perceptron convergence theorem证明了对于线性可分的问题,感知器最终一定会收敛。但是对于非线性可分的问题,感知器无能为力。由于这个原因,后来引出了神经网络,可以分类非线性可分的问题。而神经网络最终被学术界和工业界都认可的支持向量机SVM所取代。但是近年来非常火的deep learning,又把神经网络推到了很高的程度。科学的进步是循环往复的。

SVM由Vapnik等人在1995年提出,它有着很强的泛化能力(可见Vapnik关于VC dimension和PAC的相关知识) 【待补充】

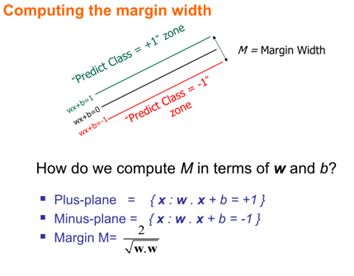

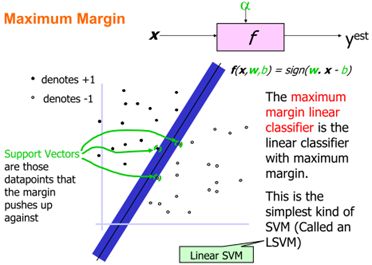

SVM最终是寻找一个最大的margin,这是一个最优化问题。最大margin的直观表示如下:

关于为什么需要最大margin,而不是其他的margin。因为由于斜率的原因,margin越大,则参数w越小。参数w即线性函数的斜率,斜率越小,则y随x的变化越缓慢。在同样的x变换范围中,w较大者y变化较大,而w较小者y变化较小。即较小的w会是的解空间越小,获得的解越稳定,泛化能力越强。这里和前面提到的regularization是同样的道理。

也可以从另一个角度来看,平滑能力(smoothness)也是一个重要的衡量标准。对于普通的线性函数![]() 来说,其平滑性衡量如下:

来说,其平滑性衡量如下:

这里w的范式越小,则平滑性越好,平滑性好的优点可以从nearest neighbor来看,两个点离得比较近,根据NN的观点来看这两个点应该越像,而曲线越平滑,这个能力就能得到更好的保证。

margin的最优化式子为:

从最优化的式子中也可以发现,w与margin的变化趋势。关于如何发现最大间隔的分类超平面、如何求得最优解以及kernel与SVM的联系将在其他章节中讲到。 【待补充】

Soft margin:

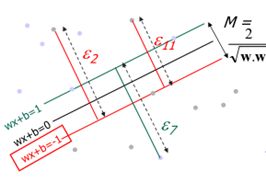

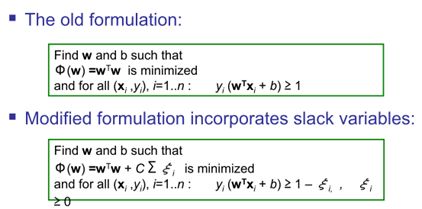

soft margin引入了松弛变量(slack variable)。因为数据总会有噪声,难免有一两个点总是无法线性可分的。在这种情况下,为了避免outliers对分类面造成很大的扰动,于是允许错分,但是一旦出现错分,将会得到惩罚。松弛变量引入前后最优化式子的变化:

其中多出来的一项正是错误分类产生的代价。sum中的项均为错分的类别离分类超平面的距离。

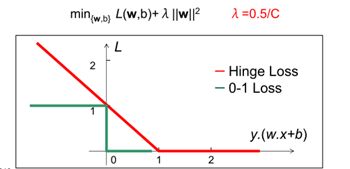

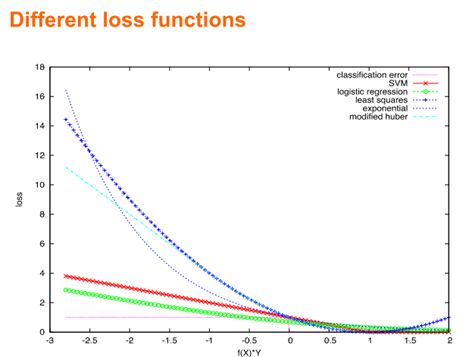

可以从Loss function上更直观的看出,soft margin SVM等价于一个hinge loss function:

意即,对于每一个数据点,如果分类结果是正确的,则不作惩罚,即选择0,如果是错误的,则加上惩罚。

所以SVM最优化式子等价于上式,上式非常直观,如果使用一个smoothness的函数去逼近hinge loss function,可以使用普通的凸优化方法直接获得最优解,这种方法适合自己构造一个SVM 【待分析】。

虽然SVM用到了大量的数学证明,他有很强的泛化能力,而且数学上面也很漂亮,但是简单的logistic regression可以获得同样好的效果。我在对同义句对的“描述类”分类的时候,同时使用了SVM和LR两种方法,最终证明两个方法获得一样好的效果。

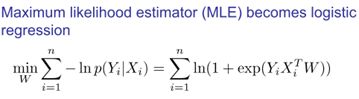

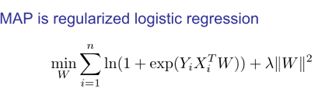

值得一提的是,frequentist的方法和bayesian的方法有共同之处。使用MAP(最大后验)方法去求解LR的时候,获得的解析式其实就是带有regularization的最大似然的结果。

附:(通过尝试不同的loss function和regularization,可以获得不同的效果。)

![_@%P(7`]X3}]ZRW1LHL){TH _@%P(7`]X3}]ZRW1LHL){TH](http://img.e-com-net.com/image/product/2fbd13d89e3540bfa87857d91447983b.jpg)