- PyTorch & TensorFlow速成复习:从基础语法到模型部署实战(附FPGA移植衔接)

阿牛的药铺

算法移植部署pytorchtensorflowfpga开发

PyTorch&TensorFlow速成复习:从基础语法到模型部署实战(附FPGA移植衔接)引言:为什么算法移植工程师必须掌握框架基础?针对光学类产品算法FPGA移植岗位需求(如可见光/红外图像处理),深度学习框架是算法落地的"桥梁"——既要用PyTorch/TensorFlow验证算法可行性,又要将训练好的模型(如CNN、目标检测)转换为FPGA可部署的格式(ONNX、TFLite)。本文采用"

- 算法学习笔记:17.蒙特卡洛算法 ——从原理到实战,涵盖 LeetCode 与考研 408 例题

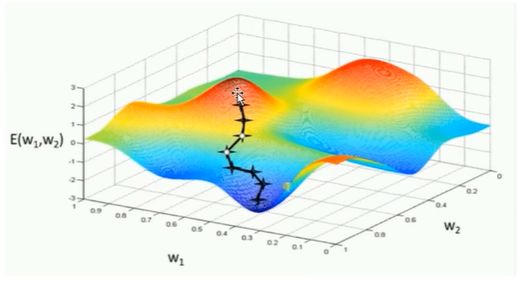

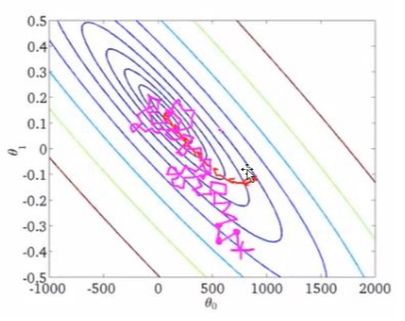

在计算机科学和数学领域,蒙特卡洛算法(MonteCarloAlgorithm)以其独特的随机抽样思想,成为解决复杂问题的有力工具。从圆周率的计算到金融风险评估,从物理模拟到人工智能,蒙特卡洛算法都发挥着不可替代的作用。本文将深入剖析蒙特卡洛算法的思想、解题思路,结合实际应用场景与Java代码实现,并融入考研408的相关考点,穿插图片辅助理解,帮助你全面掌握这一重要算法。蒙特卡洛算法的基本概念蒙特卡

- AI音乐模拟器:AIGC时代的智能音乐创作革命

lauo

人工智能AIGC开源前端机器人

AI音乐模拟器:AIGC时代的智能音乐创作革命引言:AIGC浪潮下的音乐创作新范式在数字化转型的浪潮中,人工智能生成内容(AIGC)正在重塑各个创意领域。音乐产业作为创意经济的重要组成部分,正经历着前所未有的变革。据最新市场研究数据显示,全球AI音乐市场规模预计将从2023年的5.8亿美元增长到2030年的26.8亿美元,年复合增长率高达24.3%。这一快速增长的市场背后,是AI音乐技术正在打破传

- 深度学习模型表征提取全解析

ZhangJiQun&MXP

教学2024大模型以及算力2021AIpython深度学习人工智能pythonembedding语言模型

模型内部进行表征提取的方法在自然语言处理(NLP)中,“表征(Representation)”指将文本(词、短语、句子、文档等)转化为计算机可理解的数值形式(如向量、矩阵),核心目标是捕捉语言的语义、语法、上下文依赖等信息。自然语言表征技术可按“静态/动态”“有无上下文”“是否融入知识”等维度划分一、传统静态表征(无上下文,词级为主)这类方法为每个词分配固定向量,不考虑其在具体语境中的含义(无法解

- 视频分析:让AI看懂动态画面

随机森林404

计算机视觉音视频人工智能microsoft

引言:动态视觉理解的革命在数字信息爆炸的时代,视频已成为最主要的媒介形式。据统计,每分钟有超过500小时的视频内容被上传到YouTube平台,而全球互联网流量的82%来自视频数据传输。面对如此海量的视频内容,传统的人工处理方式已无法满足需求,这正是人工智能视频分析技术大显身手的舞台。视频分析技术赋予机器"看懂"动态画面的能力,使其能够自动理解、解释甚至预测视频中的内容,这一突破正在彻底改变我们与视

- 【Qualcomm】高通SNPE框架简介、下载与使用

Jackilina_Stone

人工智能QualcommSNPE

目录一高通SNPE框架1SNPE简介2QNN与SNPE3Capabilities4工作流程二SNPE的安装与使用1下载2Setup3SNPE的使用概述一高通SNPE框架1SNPE简介SNPE(SnapdragonNeuralProcessingEngine),是高通公司推出的面向移动端和物联网设备的深度学习推理框架。SNPE提供了一套完整的深度学习推理框架,能够支持多种深度学习模型,包括Pytor

- 深度学习篇---昇腾NPU&CANN 工具包

Atticus-Orion

上位机知识篇图像处理篇深度学习篇深度学习人工智能NPU昇腾CANN

介绍昇腾NPU是华为推出的神经网络处理器,具有强大的AI计算能力,而CANN工具包则是面向AI场景的异构计算架构,用于发挥昇腾NPU的性能优势。以下是详细介绍:昇腾NPU架构设计:采用达芬奇架构,是一个片上系统,主要由特制的计算单元、大容量的存储单元和相应的控制单元组成。集成了多个CPU核心,包括控制CPU和AICPU,前者用于控制处理器整体运行,后者承担非矩阵类复杂计算。此外,还拥有AICore

- 深度学习图像分类数据集—桃子识别分类

AI街潜水的八角

深度学习图像数据集深度学习分类人工智能

该数据集为图像分类数据集,适用于ResNet、VGG等卷积神经网络,SENet、CBAM等注意力机制相关算法,VisionTransformer等Transformer相关算法。数据集信息介绍:桃子识别分类:['B1','M2','R0','S3']训练数据集总共有6637张图片,每个文件夹单独放一种数据各子文件夹图片统计:·B1:1601张图片·M2:1800张图片·R0:1601张图片·S3:

- 法律科技领域人工智能代理构建的十个经验教训,一位人工智能工程师通过构建、部署和维护智能代理的经验教训来优化法律工作流程的历程。

知识大胖

NVIDIAGPU和大语言模型开发教程人工智能ai

目录介绍什么是代理人?为什么它对法律如此重要?法律技术中代理用例示例-合同审查代理-法律研究代理在LegalTech中使用代理的十个教训-教训1:即使代理很酷,它们也不能解决所有问题-教训2:选择最适合您用例的框架-教训3:能够快速迭代不同的模型-教训4:从简单开始,必要时扩展-教训5:使用跟踪解决方案;您将需要它-教训6:确保跟踪成本,代理循环可能很昂贵-教训7:将控制权交给最终用户(人在环路中

- Llama-Omni会说话的人工智能“语音到语音LLM” 利用低延迟、高质量语音转语音 AI 彻底改变对话方式(教程含源码)

知识大胖

NVIDIAGPU和大语言模型开发教程llama人工智能nvidiallm

介绍“单靠技术是不够的——技术与文科、人文学科的结合,才能产生让我们心花怒放的成果。”——史蒂夫·乔布斯近年来,人机交互领域发生了重大变化,尤其是随着ChatGPT、GPT-4等大型语言模型(LLM)的出现。虽然这些模型主要基于文本,但人们对语音交互的兴趣日益浓厚,以使人机对话更加无缝和自然。然而,实现语音交互而不受语音转文本处理中常见的延迟和错误的影响仍然是一个挑战。关键字:Llama-Omni

- 什么是热力学计算?它如何帮助人工智能发展?

知识大胖

NVIDIAGPU和大语言模型开发教程人工智能量子计算

现代计算的基础是晶体管,这是一种微型电子开关,可以用它构建逻辑门,从而创建CPU或GPU等复杂的数字电路。随着技术的进步,晶体管变得越来越小。根据摩尔定律,集成电路中晶体管的数量大约每两年增加一倍。这种指数级增长使得计算技术呈指数级发展。然而,晶体管尺寸的缩小是有限度的。我们很快就会达到晶体管无法工作的阈值。此外,人工智能的进步使得对计算能力的需求比以往任何时候都更加迫切。根本问题是自然是随机的(

- 上海交大:工具增强推理agent

标题:SciMaster:TowardsGeneral-PurposeScientificAIAgentsPartI.X-MasterasFoundation-CanWeLeadonHumanity’sLastExam?来源:arXiv,2507.05241摘要人工智能代理的快速发展激发了利用它们加速科学发现的长期雄心。实现这一目标需要深入了解人类知识的前沿。因此,人类的最后一次考试(HLE)为评

- 微算法科技的前沿探索:量子机器学习算法在视觉任务中的革新应用

MicroTech2025

量子计算算法

在信息技术飞速发展的今天,计算机视觉作为人工智能领域的重要分支,正逐步渗透到我们生活的方方面面。从自动驾驶到人脸识别,从医疗影像分析到安防监控,计算机视觉技术展现了巨大的应用潜力。然而,随着视觉任务复杂度的不断提升,传统机器学习算法在处理大规模、高维度数据时遇到了计算瓶颈。在此背景下,量子计算作为一种颠覆性的计算模式,以其独特的并行处理能力和指数级增长的计算空间,为解决这一难题提供了新的思路。微算

- 中国银联豪掷1亿采购海光C86架构服务器

信创新态势

海光芯片C86国产芯片海光信息

近日,中国银联国产服务器采购大单正式敲定,基于海光C86架构的服务器产品中标,项目金额超过1亿元。接下来,C86服务器将用于支撑中国银联的虚拟化、大数据、人工智能、研发测试等技术场景,进一步提升其业务处理能力、用户服务效率和信息安全水平。作为我国重要的银行卡组织和金融基础设施,中国银联在全球183个国家和地区设有银联受理网络,境内外成员机构超过2600家,是世界三大银行卡品牌之一。此次中国银联发力

- AI人工智能浪潮中文心一言的独特优势

AI人工智能浪潮中文心一言的独特优势:为什么它是中国市场的“AI主力军”?关键词:文心一言,AI大模型,中文处理,多模态融合,产业落地,安全可控,百度ERNIE摘要:在全球AI大模型浪潮中,百度文心一言(ERNIEBot)凭借“懂中文、会多模态、能落地、守规矩”的四大核心优势,成为中国市场最具竞争力的AI产品之一。本文将用“超级大脑”的比喻,从中文理解、多模态能力、产业生态融合、安全可控性四个维度

- 正义的算法迷宫—人工智能重构司法体系的技术悖论与文明试炼

一、法庭的数字化迁徙当美国威斯康星州法院采纳COMPAS算法评估被告再犯风险,当中国"智慧法院"系统年处理1.2亿件案件,司法体系正经历从石柱法典到代码裁判的范式革命。这场转型的核心驱动力是司法效率与公正的永恒张力:美国重罪案件平均审理周期达18个月,中国基层法官年人均结案357件(是德国同行的6倍),而算法能在0.3秒内完成百万份文书比对。人工智能渗透司法引发三重裂变:证据分析从经验推断转向数据

- NumPy-@运算符详解

GG不是gg

numpynumpy

NumPy-@运算符详解一、@运算符的起源与设计目标1.从数学到代码:符号的统一2.设计目标二、@运算符的核心语法与运算规则1.基础用法:二维矩阵乘法2.一维向量的矩阵语义3.高维数组:批次矩阵运算4.广播机制:灵活的形状匹配三、@运算符与其他乘法方式的核心区别1.对比`np.dot()`2.对比元素级乘法`*`3.对比`np.matrix`的`*`运算符四、典型应用场景:从基础到高阶1.深度学习

- 【python实战】不玩微博,一封邮件就能知道实时热榜,天秀吃瓜

一条coding

从实战学python人工智能pythonlinux爬虫

❤️欢迎订阅《从实战学python》专栏,用python实现办公自动化、数据可视化、人工智能等各个方向的实战案例,有趣又有用!❤️更多精品专栏简介点这里有的人金玉其表败絮其中,有的人却若彩虹般绚烂,怦然心动前言哈喽,大家好,我是一条。在生活中我是一个不太喜欢逛娱乐平台的人,抖音、快手、微博我手机里都没装,甚至微信朋友圈都不看,但是自从开始写博客,有些热度不得不蹭。所以就有了这样一个需求,能不能让微

- NLP_知识图谱_大模型——个人学习记录

macken9999

自然语言处理知识图谱大模型自然语言处理知识图谱学习

1.自然语言处理、知识图谱、对话系统三大技术研究与应用https://github.com/lihanghang/NLP-Knowledge-Graph深度学习-自然语言处理(NLP)-知识图谱:知识图谱构建流程【本体构建、知识抽取(实体抽取、关系抽取、属性抽取)、知识表示、知识融合、知识存储】-元気森林-博客园https://www.cnblogs.com/-402/p/16529422.htm

- 解决 Python 包安装失败问题:以 accelerate 为例

在使用Python开发项目时,我们经常会遇到依赖包安装失败的问题。今天,我们就以accelerate包为例,详细探讨一下可能的原因以及解决方法。通过这篇文章,你将了解到Python包安装失败的常见原因、如何切换镜像源、如何手动安装包,以及一些实用的注意事项。一、问题背景在开发一个深度学习项目时,我需要安装accelerate包来优化模型的训练过程。然而,当我运行以下命令时:bash复制pipins

- MCP协议:AI时代的“万能插座”如何重构IT生态与未来

MCP协议:AI时代的“万能插座”如何重构IT生态与未来在人工智能技术爆炸式发展的浪潮中,一个名为ModelContextProtocol(MCP)的技术协议正以惊人的速度重塑IT行业的底层逻辑。2024年11月由Anthropic首次发布,MCP在短短半年内获得OpenAI、谷歌、亚马逊、阿里、腾讯等全球科技巨头的支持,被业内誉为AI时代的HTTP协议或USB-C接口,正在成为连接大模型与现实世

- 从RNN循环神经网络到Transformer注意力机制:解析神经网络架构的华丽蜕变

熊猫钓鱼>_>

神经网络rnntransformer

1.引言在自然语言处理和序列建模领域,神经网络架构经历了显著的演变。从早期的循环神经网络(RNN)到现代的Transformer架构,这一演变代表了深度学习方法在处理序列数据方面的重大进步。本文将深入比较这两种架构,分析它们的工作原理、优缺点,并通过实验结果展示它们在实际应用中的性能差异。2.循环神经网络(RNN)2.1基本原理循环神经网络是专门为处理序列数据而设计的神经网络架构。RNN的核心思想

- 《算法备案全攻略:规范与流程引领数字时代新秩序》

算法及大模型备案顾问刘老师

算法备案深度学习AIGC语言模型算法人工智能

一、算法备案:开启合规新征程(一)备案规定的起源与发展2022年国家互联网信息办公室、工业和信息化部、公安部、国家市场监督管理总局联合发布《互联网信息服务算法推荐管理规定》,自2022年3月1日起施行。此后,相关规定不断完善和演进。如国家网信办于2022年8月、10月及2023年1月先后三次公布了《境内互联网信息服务算法备案清单》。同时,2022年发布的最高人民法院《关于规范和加强人工智能司法应用

- C语言学生成绩管理系统<;自创>;(功能7有小错误,但可运行)

han_xue_feng

java

腾讯云加速企业和个人开发创新公开直播预告直播预告:07/18(周四)15:00-16:00随着人工智能与大模型的蓬勃发展,我们正步入一个由技微信实习第一天周五入职,早上早早来到了公司,发现好多人都没上班,到十点才陆陆续续有人来,办理完入职后,mentor中联夏令营遗憾没有入选不过hr的回复真的很好,辛苦啦#提前批简历挂麻了怎么办##机械制造投递记录#大数据开发的工作有点过于简单了吧sq大数据开发的

- Python 实战人工智能数学基础:推荐系统应用

AI天才研究院

AI大模型企业级应用开发实战大数据人工智能语言模型JavaPython架构设计

作者:禅与计算机程序设计艺术文章目录1.背景介绍2.核心概念与联系2.1用户画像2.2相似性计算2.2.1基于物品的相似度2.2.2基于用户的相似度2.3协同过滤算法2.3.1基于用户的协同过滤算法2.3.2基于物品的协同过滤算法2.3.3基于上下文的协同过滤算法3.核心算法原理和具体操作步骤以及数学模型公式详细讲解3.1基于用户的协同过滤算法3.2基于物品的协同过滤算法3.3混合协同过滤算法3.

- Python桌面应用开发的未来——智能化工具与大模型赋能

IronwoodStag78

开发AI智能应用,就下载InsCodeAIIDE,一键接入DeepSeek-R1满血版大模型!标题:Python桌面应用开发的未来——智能化工具与大模型赋能随着人工智能技术的飞速发展,传统软件开发模式正在被重新定义。Python作为一门功能强大且灵活的语言,在桌面应用开发领域一直占据重要地位。然而,面对日益复杂的用户需求和快速变化的技术环境,如何提升开发效率、降低开发门槛,成为开发者亟需解决的问题

- 如何使用Python实现交通工具识别

如何使用Python实现交通工具识别文章目录技术架构功能流程识别逻辑用户界面增强特性依赖项主要类别内容展示该系统是一个基于深度学习的交通工具识别工具,具备以下核心功能与特点:技术架构使用预训练的ResNet50卷积神经网络模型(来自ImageNet数据集)集成图像增强预处理技术(随机裁剪、旋转、翻转等)采用多数投票机制提升预测稳定性基于置信度评分的结果筛选策略功能流程用户通过GUI界面选择待识别图

- Python OpenCV教程从入门到精通的全面指南【文末送书】

一键难忘

pythonopencv开发语言

文章目录PythonOpenCV从入门到精通1.安装OpenCV2.基本操作2.1读取和显示图像2.2图像基本操作3.图像处理3.1图像转换3.2图像阈值处理3.3图像平滑4.边缘检测和轮廓4.1Canny边缘检测4.2轮廓检测5.高级操作5.1特征检测5.2目标跟踪5.3深度学习与OpenCVPythonOpenCV从入门到精通【文末送书】PythonOpenCV从入门到精通OpenCV(Ope

- 第八周 tensorflow实现猫狗识别

降花绘

365天深度学习tensorflow系列tensorflow深度学习人工智能

本文为365天深度学习训练营内部限免文章(版权归K同学啊所有)**参考文章地址:[TensorFlow入门实战|365天深度学习训练营-第8周:猫狗识别(训练营内部成员可读)]**作者:K同学啊文章目录一、本周学习内容:1、自己搭建VGG16网络2、了解model.train_on_batch()3、了解tqdm,并使用tqdm实现可视化进度条二、前言三、电脑环境四、前期准备1、导入相关依赖项2、

- 深度学习实战-使用TensorFlow与Keras构建智能模型

程序员Gloria

Python超入门TensorFlowpython

深度学习实战-使用TensorFlow与Keras构建智能模型深度学习已经成为现代人工智能的重要组成部分,而Python则是实现深度学习的主要编程语言之一。本文将探讨如何使用TensorFlow和Keras构建深度学习模型,包括必要的代码实例和详细的解析。1.深度学习简介深度学习是机器学习的一个分支,使用多层神经网络来学习和表示数据中的复杂模式。其广泛应用于图像识别、自然语言处理、推荐系统等领域。

- java观察者模式

3213213333332132

java设计模式游戏观察者模式

观察者模式——顾名思义,就是一个对象观察另一个对象,当被观察的对象发生变化时,观察者也会跟着变化。

在日常中,我们配java环境变量时,设置一个JAVAHOME变量,这就是被观察者,使用了JAVAHOME变量的对象都是观察者,一旦JAVAHOME的路径改动,其他的也会跟着改动。

这样的例子很多,我想用小时候玩的老鹰捉小鸡游戏来简单的描绘观察者模式。

老鹰会变成观察者,母鸡和小鸡是

- TFS RESTful API 模拟上传测试

ronin47

TFS RESTful API 模拟上传测试。

细节参看这里:https://github.com/alibaba/nginx-tfs/blob/master/TFS_RESTful_API.markdown

模拟POST上传一个图片:

curl --data-binary @/opt/tfs.png http

- PHP常用设计模式单例, 工厂, 观察者, 责任链, 装饰, 策略,适配,桥接模式

dcj3sjt126com

设计模式PHP

// 多态, 在JAVA中是这样用的, 其实在PHP当中可以自然消除, 因为参数是动态的, 你传什么过来都可以, 不限制类型, 直接调用类的方法

abstract class Tiger {

public abstract function climb();

}

class XTiger extends Tiger {

public function climb()

- hibernate

171815164

Hibernate

main,save

Configuration conf =new Configuration().configure();

SessionFactory sf=conf.buildSessionFactory();

Session sess=sf.openSession();

Transaction tx=sess.beginTransaction();

News a=new

- Ant实例分析

g21121

ant

下面是一个Ant构建文件的实例,通过这个实例我们可以很清楚的理顺构建一个项目的顺序及依赖关系,从而编写出更加合理的构建文件。

下面是build.xml的代码:

<?xml version="1

- [简单]工作记录_接口返回405原因

53873039oycg

工作

最近调接口时候一直报错,错误信息是:

responseCode:405

responseMsg:Method Not Allowed

接口请求方式Post.

- 关于java.lang.ClassNotFoundException 和 java.lang.NoClassDefFoundError 的区别

程序员是怎么炼成的

真正完成类的加载工作是通过调用 defineClass来实现的;

而启动类的加载过程是通过调用 loadClass来实现的;

就是类加载器分为加载和定义

protected Class<?> findClass(String name) throws ClassNotFoundExcept

- JDBC学习笔记-JDBC详细的操作流程

aijuans

jdbc

所有的JDBC应用程序都具有下面的基本流程: 1、加载数据库驱动并建立到数据库的连接。 2、执行SQL语句。 3、处理结果。 4、从数据库断开连接释放资源。

下面我们就来仔细看一看每一个步骤:

其实按照上面所说每个阶段都可得单独拿出来写成一个独立的类方法文件。共别的应用来调用。

1、加载数据库驱动并建立到数据库的连接:

Html代码

St

- rome创建rss

antonyup_2006

tomcatcmsxmlstrutsOpera

引用

1.RSS标准

RSS标准比较混乱,主要有以下3个系列

RSS 0.9x / 2.0 : RSS技术诞生于1999年的网景公司(Netscape),其发布了一个0.9版本的规范。2001年,RSS技术标准的发展工作被Userland Software公司的戴夫 温那(Dave Winer)所接手。陆续发布了0.9x的系列版本。当W3C小组发布RSS 1.0后,Dave W

- html表格和表单基础

百合不是茶

html表格表单meta锚点

第一次用html来写东西,感觉压力山大,每次看见别人发的都是比较牛逼的 再看看自己什么都还不会,

html是一种标记语言,其实很简单都是固定的格式

_----------------------------------------表格和表单

表格是html的重要组成部分,表格用在body里面的

主要用法如下;

<table>

&

- ibatis如何传入完整的sql语句

bijian1013

javasqlibatis

ibatis如何传入完整的sql语句?进一步说,String str ="select * from test_table",我想把str传入ibatis中执行,是传递整条sql语句。

解决办法:

<

- 精通Oracle10编程SQL(14)开发动态SQL

bijian1013

oracle数据库plsql

/*

*开发动态SQL

*/

--使用EXECUTE IMMEDIATE处理DDL操作

CREATE OR REPLACE PROCEDURE drop_table(table_name varchar2)

is

sql_statement varchar2(100);

begin

sql_statement:='DROP TABLE '||table_name;

- 【Linux命令】Linux工作中常用命令

bit1129

linux命令

不断的总结工作中常用的Linux命令

1.查看端口被哪个进程占用

通过这个命令可以得到占用8085端口的进程号,然后通过ps -ef|grep 进程号得到进程的详细信息

netstat -anp | grep 8085

察看进程ID对应的进程占用的端口号

netstat -anp | grep 进程ID

&

- 优秀网站和文档收集

白糖_

网站

集成 Flex, Spring, Hibernate 构建应用程序

性能测试工具-JMeter

Hmtl5-IOCN网站

Oracle精简版教程网站

鸟哥的linux私房菜

Jetty中文文档

50个jquery必备代码片段

swfobject.js检测flash版本号工具

- angular.extend

boyitech

AngularJSangular.extendAngularJS API

angular.extend 复制src对象中的属性去dst对象中. 支持多个src对象. 如果你不想改变一个对象,你可以把dst设为空对象{}: var object = angular.extend({}, object1, object2). 注意: angular.extend不支持递归复制. 使用方法: angular.extend(dst, src); 参数:

- java-谷歌面试题-设计方便提取中数的数据结构

bylijinnan

java

网上找了一下这道题的解答,但都是提供思路,没有提供具体实现。其中使用大小堆这个思路看似简单,但实现起来要考虑很多。

以下分别用排序数组和大小堆来实现。

使用大小堆:

import java.util.Arrays;

public class MedianInHeap {

/**

* 题目:设计方便提取中数的数据结构

* 设计一个数据结构,其中包含两个函数,1.插

- ajaxFileUpload 针对 ie jquery 1.7+不能使用问题修复版本

Chen.H

ajaxFileUploadie6ie7ie8ie9

jQuery.extend({

handleError: function( s, xhr, status, e ) {

// If a local callback was specified, fire it

if ( s.error ) {

s.error.call( s.context || s, xhr, status, e );

}

- [机器人制造原则]机器人的电池和存储器必须可以替换

comsci

制造

机器人的身体随时随地可能被外来力量所破坏,但是如果机器人的存储器和电池可以更换,那么这个机器人的思维和记忆力就可以保存下来,即使身体受到伤害,在把存储器取下来安装到一个新的身体上之后,原有的性格和能力都可以继续维持.....

另外,如果一

- Oracle Multitable INSERT 的用法

daizj

oracle

转载Oracle笔记-Multitable INSERT 的用法

http://blog.chinaunix.net/uid-8504518-id-3310531.html

一、Insert基础用法

语法:

Insert Into 表名 (字段1,字段2,字段3...)

Values (值1,

- 专访黑客历史学家George Dyson

datamachine

on

20世纪最具威力的两项发明——核弹和计算机出自同一时代、同一群年青人。可是,与大名鼎鼎的曼哈顿计划(第二次世界大战中美国原子弹研究计划)相 比,计算机的起源显得默默无闻。出身计算机世家的历史学家George Dyson在其新书《图灵大教堂》(Turing’s Cathedral)中讲述了阿兰·图灵、约翰·冯·诺依曼等一帮子天才小子创造计算机及预见计算机未来

- 小学6年级英语单词背诵第一课

dcj3sjt126com

englishword

always 总是

rice 水稻,米饭

before 在...之前

live 生活,居住

usual 通常的

early 早的

begin 开始

month 月份

year 年

last 最后的

east 东方的

high 高的

far 远的

window 窗户

world 世界

than 比...更

- 在线IT教育和在线IT高端教育

dcj3sjt126com

教育

codecademy

http://www.codecademy.com codeschool

https://www.codeschool.com teamtreehouse

http://teamtreehouse.com lynda

http://www.lynda.com/ Coursera

https://www.coursera.

- Struts2 xml校验框架所定义的校验文件

蕃薯耀

Struts2 xml校验Struts2 xml校验框架Struts2校验

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年7月11日 15:54:59 星期六

http://fa

- mac下安装rar和unrar命令

hanqunfeng

mac

1.下载:http://www.rarlab.com/download.htm 选择

RAR 5.21 for Mac OS X 2.解压下载后的文件 tar -zxvf rarosx-5.2.1.tar 3.cd rar sudo install -c -o $USER unrar /bin #输入当前用户登录密码 sudo install -c -o $USER rar

- 三种将list转换为map的方法

jackyrong

list

在本文中,介绍三种将list转换为map的方法:

1) 传统方法

假设有某个类如下

class Movie {

private Integer rank;

private String description;

public Movie(Integer rank, String des

- 年轻程序员需要学习的5大经验

lampcy

工作PHP程序员

在过去的7年半时间里,我带过的软件实习生超过一打,也看到过数以百计的学生和毕业生的档案。我发现很多事情他们都需要学习。或许你会说,我说的不就是某种特定的技术、算法、数学,或者其他特定形式的知识吗?没错,这的确是需要学习的,但却并不是最重要的事情。他们需要学习的最重要的东西是“自我规范”。这些规范就是:尽可能地写出最简洁的代码;如果代码后期会因为改动而变得凌乱不堪就得重构;尽量删除没用的代码,并添加

- 评“女孩遭野蛮引产致终身不育 60万赔偿款1分未得”医腐深入骨髓

nannan408

先来看南方网的一则报道:

再正常不过的结婚、生子,对于29岁的郑畅来说,却是一个永远也无法实现的梦想。从2010年到2015年,从24岁到29岁,一张张新旧不一的诊断书记录了她病情的同时,也清晰地记下了她人生的悲哀。

粗暴手术让人发寒

2010年7月,在酒店做服务员的郑畅发现自己怀孕了,可男朋友却联系不上。在没有和家人商量的情况下,她决定堕胎。

12月5日,

- 使用jQuery为input输入框绑定回车键事件 VS 为a标签绑定click事件

Everyday都不同

jspinput回车键绑定clickenter

假设如题所示的事件为同一个,必须先把该js函数抽离出来,该函数定义了监听的处理:

function search() {

//监听函数略......

}

为input框绑定回车事件,当用户在文本框中输入搜索关键字时,按回车键,即可触发search():

//回车绑定

$(".search").keydown(fun

- EXT学习记录

tntxia

ext

1. 准备

(1) 官网:http://www.sencha.com/

里面有源代码和API文档下载。

EXT的域名已经从www.extjs.com改成了www.sencha.com ,但extjs这个域名会自动转到sencha上。

(2)帮助文档:

想要查看EXT的官方文档的话,可以去这里h

- mybatis3的mapper文件报Referenced file contains errors

xingguangsixian

mybatis

最近使用mybatis.3.1.0时无意中碰到一个问题:

The errors below were detected when validating the file "mybatis-3-mapper.dtd" via the file "account-mapper.xml". In most cases these errors can be d