lda 可以处理中文_商品评论情感化分析案例(LDA主题分析)

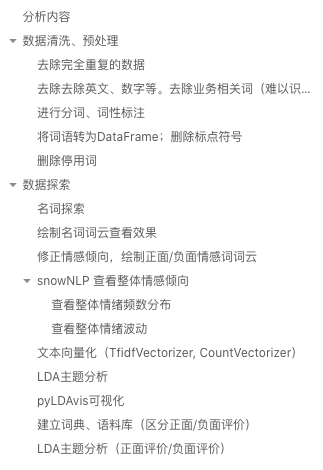

分析内容

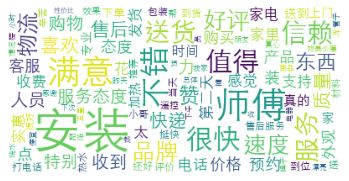

正负面高频词汇

正负面情绪波动

正负面情感倾向

正负面LDA主题分析

文章目录

因为内容较长,这里附上文章内容目录(上传图片有些失真模糊,凑合看看了):

数据清洗、预处理

文本数据,是一种非结构化数据。因此,其预处理的步骤与方式也会与结构化数据有所差异。文本数据预处理主要包括:

缺失值处理

重复值处理

文本内容清洗(去除指定字符)

分词

停用词处理

去除完全重复的数据

import pandas '/reviews.csv')去除去除英文、数字等。去除业务相关词(难以识别)

# 去除去除英文、数字等进行分词、词性标注

# 分词、词性标注0 [(东西, ns), (收到, v), (这么久, r), (,, x), (都, d), ...将词语转为DataFrame;删除标点符号

# 将词语转为dataframe形式,一列是词,一列是词语所在的句子ID,最后一列是词语在该句子的位置删除停用词

# 删除停用词,导入停用词词库# 构造各词在对应评论的位置列数据探索

名词探索

'n' 绘制名词词云查看效果

import matplotlib.pyplot 修正情感倾向,绘制正面/负面情感词词云

# 匹配情感词# 修正情感倾向# 绘制词云# 负面情感词词云snowNLP 查看整体情感倾向

查看整体情绪频数分布

from snownlp 查看整体情绪波动

result = []

i = 0

while i500]):

result.append(sentimentslist[i]-0.5)

i = i + 1#可视化画图import matplotlib.pyplot as plt

plt.figure(figsize=(12,8))# import numpy as np

plt.plot(result, 'k-')

plt.xlabel('数量')

plt.ylabel('情绪')

plt.title('整体倾向')

plt.show()文本向量化(TfidfVectorizer, CountVectorizer)

from sklearn.feature_extraction.text 'word', binary=False, decode_error=LDA主题分析

from sklearn.decomposition LatentDirichletAllocation(batch_size=128, doc_topic_prior=None,

evaluate_every=-1, learning_decay=0.7,

learning_method='online', learning_offset=50.0,

max_doc_update_iter=100, max_iter=50,

mean_change_tol=0.001, n_components=10, n_jobs=None,

perp_tol=0.1, random_state=0, topic_word_prior=None,

total_samples=1000000.0, verbose=0)

def print_top_words(model, feature_names, n_top_words):20#0:pyLDAvis可视化

import pyLDAvis建立词典、语料库(区分正面/负面评价)

# -*- coding: utf-8 -*-LDA主题分析(正面评价/负面评价)

# LDA主题分析0,# 负面评价主题分析0,关注公众号,在对话框回复「10193」获取源码 + 数据集。