泰坦尼克号数据集_sklearn实践项目:泰坦尼克号生存率预测

此次进行分析的数据集来自Kaggle,链接如下

数据集下载链接www.kaggle.com1.提出问题

什么样的人在泰坦尼克号中更容易存活?

2.理解数据

2.1采集数据

从上面给出的链接里面将泰坦尼克号项目相关的数据集下载下来,包括gender_submission,test和train三个数据集,并在网站上对数据集内包含的信息有一个初步的认识。

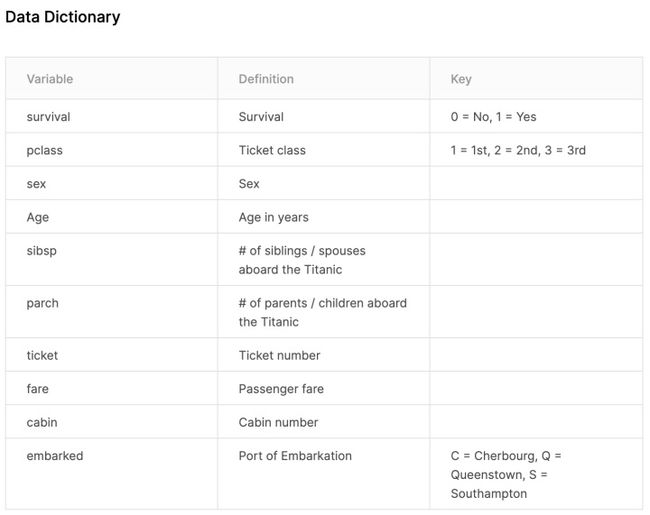

数据集里面的变量的定义 官网对变量的说明2.2导入数据

# 忽略警告提示

import warnings

warnings.filterwarnings('ignore')

#导入处理数据包

import numpy as np

import pandas as pd

#导入训练数据集

train=pd.read_csv('/Users/huang/Python/3.泰坦尼克号/train.csv')

#导入测试数据集

test=pd.read_csv('/Users/huang/Python/3.泰坦尼克号/test.csv')

#查看数据集的概况

print('训练数据集:',train.shape,'测试数据集:',test.shape)输出结果:

训练数据集: (891, 12) 测试数据集: (418, 11)从结果可以看到,测试数据集中少的一个变量,这个变量就是生存率预测。因为我们的目的是生成模型来预测生存率,因此测试数据集没有这个变量。

#为了方便同时对训练数据和测试数据进行清洗,需要将两个数据集合并

full=train.append(test,ignore_index=True)

print('合并后的数据集:',full.shape)输出结果:

合并后的数据集: (1309, 12)2.3查看数据集信息

#查看合并后的数据集信息

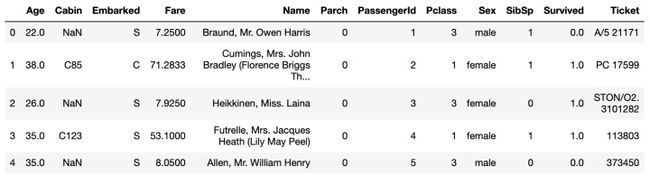

full.head()输出结果:

'''使用discribe获取数据类型列的描述统计信息;需要注意discribe只能显示出数据类型的列信息,对于其他类型的数据不显示,比如字符串类型姓名(name),客舱号(Cabin)

这很好理解,因为描述统计指标是计算数值,所以需要该列的数据类型是数据'''

full.describe()输出结果:

#查看缺失数据

#使用info方法,查看每列的数据总数和数据类型

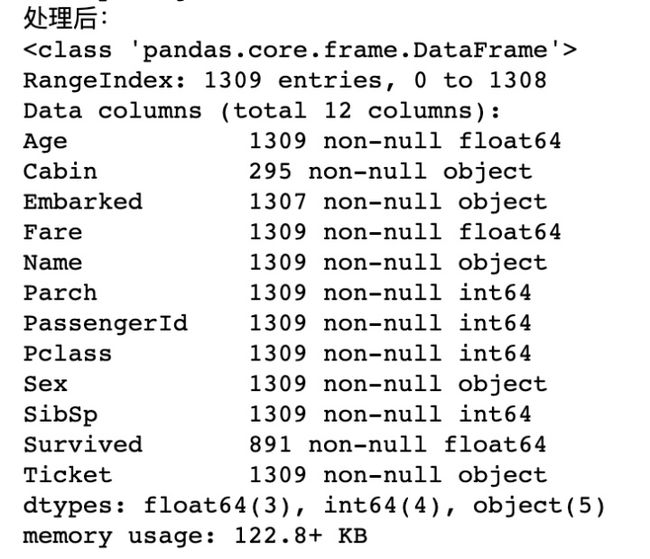

full.info()输出结果:

可以看到总共有1309行数据,其中有缺失数据的列包括年龄(Age)、船舱号(Cabin)、登船港口(Embarked)、船票价格(Fare),属于数据类型的是年龄和船票价格,属于字符串类型的是船舱号、登船港口。

其中:

年龄项总数据为1046,缺失了263项,缺失率约为20%;

船票价格总数据为1308,缺失了1项;

登船港口总数据为1307,缺失了2项;

船舱号总数据为295,缺失了1014项,缺失率约为77.5%,缺失较多。

此处先将数据缺失的情况列明,方便后续进行针对性处理。

3.数据清洗

3.1数据预处理

缺失值处理

很多机器学习算法为了训练模型,要求所传入的特征中不能有空值,因此需要事先对缺失值进行处理。常见处理的方法包括:

- 数值类型,可用平均值填充

- 分类数据,可用最常见的类别填充

- 使用模型预测缺失值

3.1.1数据类型缺失值的处理

从前面我们可以得到年龄和船票价格的缺失值是数据类型,因此这里需要对数据类型的缺失值进行处理。

#使用平均值对年龄和船票价格列缺失值进行填充

#年龄(Age)

full['Age']=full['Age'].fillna( full['Age'].mean() )

#船票价格(Fare)

full['Fare'] = full['Fare'].fillna( full['Fare'].mean() )

print('处理后:')

full.info()输出处理后的结果:

#检查数据处理是否正常

full.head()输出结果:

3.1.2字符串类型缺失值的处理

字符串类型缺失列分别为登船港口(Embarked)和船舱号(Cabin),下面先来处理登船港口列。

- 登船港口(Embarked)

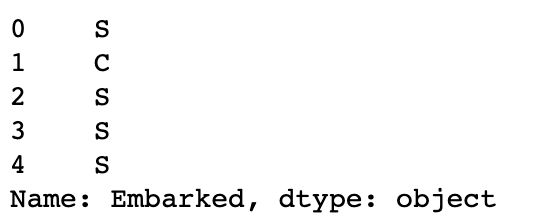

#查看登船港口列里面数据样貌

full['Embarked'].head()输出结果为:

由数据下载页面给出的信息,我们可以知道S=英国南安普顿Southampton;C=法国 瑟堡市Cherbourg;Q=爱尔兰 昆士敦Queenstown

#对此列下面的三个值进行统计,查看下最常见的类别,用其填充

full['Embarked'].value_counts()输出结果为:

可以看到S(英国南安普顿Southampton)出现的频次最多,因此可以用其来对缺失值进行填充。

full['Embarked'] = full['Embarked'].fillna( 'S' )到此,登船港口列的缺失值已经处理完毕,接下来处理船舱号。

- 船舱号(Cabin)

#查看船舱号里面数据样貌

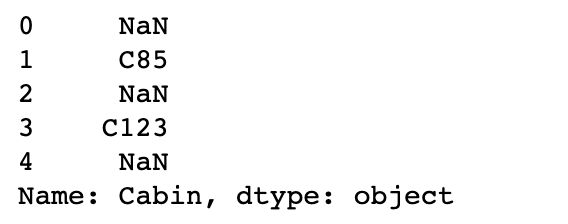

full['Cabin'].head()输出结果为:

由于船舱号缺失率约为77.5%,缺失较多,因此这里不能简单地用出现频率最高的值来填充。可将缺失值填充为U,表示Unknown

full['Cabin'] = full['Cabin'].fillna( 'U' )然后检查数据处理后的数据集是否正常

#检查数据处理是否正常

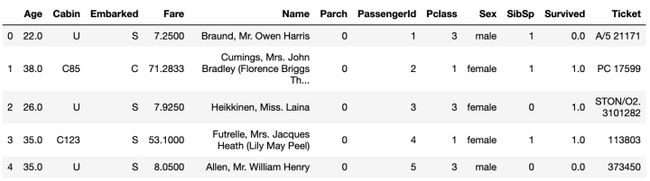

full.head()输出结果为:

查看缺失值处理后的数据集情况

#查看最终缺失值处理情况,记住生成情况(Survived)这里一列是我们的标签,用来做机器学习预测的,不需要处理这一列

full.info()输出结果为:

可以看到除了生存情况(Survived)外,其他列的数据数目都与行数一致,到此缺失值处理完毕。

3.2特征提取

3.2.1数据分类

数据类型分为3类,数值类型、时间序列和分类数据,此步骤需要对类别数据进行处理,使用数值代替类别,并进行One-hot编码。在此案例中,各个变量的归类如下:

- 数值类型

乘客编号(PassengerId),年龄(Age),船票价格(Fare),同代直系亲属人数(SibSp),不同代直系亲属人数(Parch)

- 时间序列

无

- 分类数据

分类数据分为有直接类别的和字符串类型的

1)有直接类别的

乘客性别(Sex):男性male,女性female

登船港口(Embarked):出发地点S=英国南安普顿Southampton,途径地点1:C=法国 瑟堡市Cherbourg,出发地点2:Q=爱尔兰 昆士敦Queenstown

客舱等级(Pclass):1=1等舱,2=2等舱,3=3等舱

2)字符串类型:没有直接给出分类,但可能可以从这里面提取出特征来,因此也归到分类数据中

乘客姓名(Name),客舱号(Cabin),船票编号(Ticket)

3.2.1.1有直接类别的分类数据处理

- 性别

对性别的处理:先查看性别这一列的数据,然后将性别的值映射为数值,男对应数值1,女对应数值0

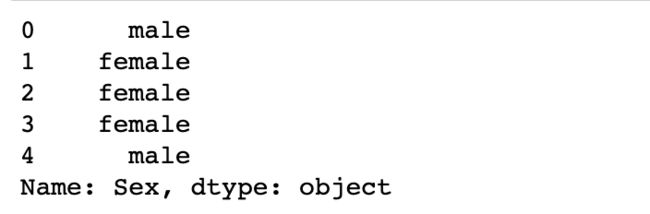

#查看性别数据这一列

full['Sex'].head()输出结果为:

'''

将性别的值映射为数值

男(male)对应数值1,女(female)对应数值0

'''

sex_mapDict={'male':1,

'female':0}

#map函数:对Series每个数据应用自定义的函数计算

full['Sex']=full['Sex'].map(sex_mapDict)

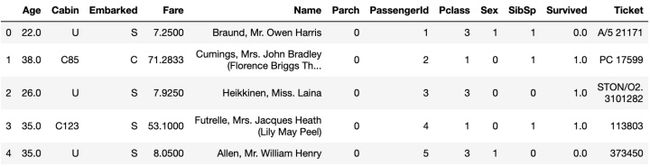

full.head()输出结果为:

- 登船港口

由前面可知登船港口有三个不同的值,分别为S,C,Q。当类别超过两个的时候,就需要使用get_dummies方法来进行one-hot编码。

#查看该类数据内容

full['Embarked'].head()输出结果为:

#建立embarkedDf,用来存放提取后的特征

embarkedDf = pd.DataFrame()

'''

使用get_dummies进行one-hot编码,产生虚拟变量(dummy variables),列名前缀(prefix)是Embarked

'''

embarkedDf = pd.get_dummies( full['Embarked'] , prefix='Embarked' )

embarkedDf.head()输出结果为:

#添加one-hot编码产生的虚拟变量(dummy variables)到泰坦尼克号数据集full

#使用concat方法进行添加,axis表示按行操作

full = pd.concat([full,embarkedDf],axis=1)

'''

因为已经使用登船港口(Embarked)进行了one-hot编码产生了它的虚拟变量(dummy variables)

所以这里把登船港口(Embarked)删掉

'''

full.drop('Embarked',axis=1,inplace=True)

full.head()输出结果:

补充知识点:drop方法删除某列或某几列代码的语法:drop([列名1,列名2],axis=1),其中axis=1表示按行操作。

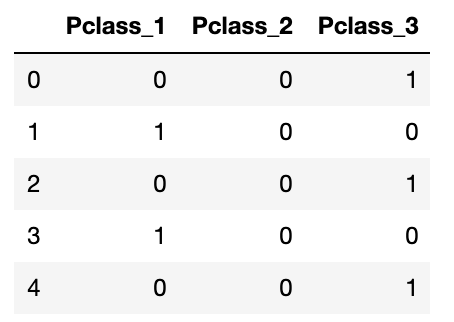

- 客舱等级

'''

客舱等级(Pclass):1=1等舱,2=2等舱,3=3等舱

'''

#使用pclassDf存放提取后的特征

pclassDf = pd.DataFrame()

#使用get_dummies进行one-hot编码,列名前缀是Pclass

pclassDf = pd.get_dummies( full['Pclass'] , prefix='Pclass' )

pclassDf.head()输出结果为:

#添加one-hot编码产生的虚拟变量(dummy variables)到泰坦尼克号数据集full

full = pd.concat([full,pclassDf],axis=1)

#删掉客舱等级(Pclass)这一列

full.drop('Pclass',axis=1,inplace=True)

full.head()输出结果:

3.2.1.1字符串类型的分类数据处理

- 姓名:从姓名中提取头衔

#查看姓名列的数据样貌

full[ 'Name' ].head()输出结果为:

可以看到在乘客姓名中,有一个特点:乘客头衔每个名字当中都包含了具体的称谓或者说是头衔,如Mr. ,将这部分信息提取出来后可以作为一个新变量,帮助我们进行预测。

'''

定义函数:从姓名中获取头衔

以Braund, Mr. Owen Harris 为例

'''

def getTitle(name):

str1=name.split( ',' )[1] #获得’Mr. Owen Harris‘这部分

str2=str1.split( '.' )[0]#获得名字中的头衔 Mr

#strip() 方法用于移除字符串头尾指定的字符(默认为空格)

str3=str2.strip()

return str3定义的getTitle函数可以获取名字中的头衔。

#定义titleDf,用于存放提取后的特征

titleDf = pd.DataFrame()

#map函数:对Series每个数据应用自定义的函数计算

titleDf['Title'] = full['Name'].map(getTitle)

titleDf.head()输出结果为:

#对头衔进行统计,查看都有哪些头衔

titleDf['Title'].value_counts()输出结果:

'''

定义以下几种头衔类别:

Officer政府官员

Royalty王室(皇室)

Mr已婚男士

Mrs已婚妇女

Miss年轻未婚女子

Master有技能的人/教师

'''

#姓名中头衔字符串与定义头衔类别的映射关系

title_mapDict = {

"Capt": "Officer",

"Col": "Officer",

"Major": "Officer",

"Jonkheer": "Royalty",

"Don": "Royalty",

"Sir" : "Royalty",

"Dr": "Officer",

"Rev": "Officer",

"the Countess":"Royalty",

"Dona": "Royalty",

"Mme": "Mrs",

"Mlle": "Miss",

"Ms": "Mrs",

"Mr" : "Mr",

"Mrs" : "Mrs",

"Miss" : "Miss",

"Master" : "Master",

"Lady" : "Royalty"

}

#map函数:对Series每个数据应用自定义的函数计算

titleDf['Title'] = titleDf['Title'].map(title_mapDict)

#使用get_dummies进行one-hot编码

titleDf = pd.get_dummies(titleDf['Title'])

titleDf.head()输出结果:

#添加one-hot编码产生的虚拟变量(dummy variables)到泰坦尼克号数据集full

full = pd.concat([full,titleDf],axis=1)

#删掉原姓名这一列

full.drop('Name',axis=1,inplace=True)

full.head()输出结果为:

一共有21个列。

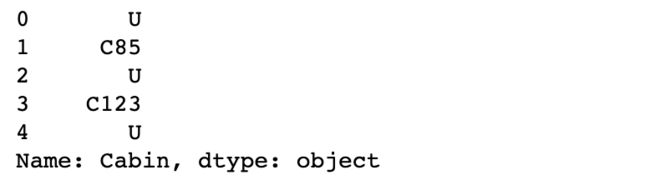

- 从客舱号中提取客舱类别

'''

目的:将客舱号的首字母提取出来,作为客舱的类别

'''

#查看客舱号的内容

full['Cabin'].head()输出结果为:

#建立cabinDf,用于存放客舱号信息

cabinDf = pd.DataFrame()

'''

客场号的类别值是首字母,例如:

C85 类别映射为首字母C

'''

full[ 'Cabin' ] = full[ 'Cabin' ].map( lambda c : c[0] ) #使用lambda函数,提取首字母

##使用get_dummies进行one-hot编码,列名前缀是Cabin

cabinDf = pd.get_dummies( full['Cabin'] , prefix = 'Cabin' )

cabinDf.head()输出结果为:

#添加one-hot编码产生的虚拟变量(dummy variables)到泰坦尼克号数据集full

full = pd.concat([full,cabinDf],axis=1)

#删掉客舱号这一列

full.drop('Cabin',axis=1,inplace=True)

full.head()输出结果:

- 家庭人数和家庭类别

#建立familyDf,存放家庭信息

familyDf = pd.DataFrame()

'''

家庭人数=同代直系亲属数(Parch)+不同代直系亲属数(SibSp)+乘客自己

(因为乘客自己也是家庭成员的一个,所以这里加1)

'''

familyDf[ 'FamilySize' ] = full[ 'Parch' ] + full[ 'SibSp' ] + 1

'''

家庭类别:

小家庭Family_Single:家庭人数=1

中等家庭Family_Small: 2<=家庭人数<=4

大家庭Family_Large: 家庭人数>=5

'''

#if 条件为真的时候返回if前面内容,否则返回0

familyDf[ 'Family_Single' ] = familyDf[ 'FamilySize' ].map( lambda s : 1 if s == 1 else 0 )

familyDf[ 'Family_Small' ] = familyDf[ 'FamilySize' ].map( lambda s : 1 if 2 <= s <= 4 else 0 )

familyDf[ 'Family_Large' ] = familyDf[ 'FamilySize' ].map( lambda s : 1 if 5 <= s else 0 )

familyDf.head()输出结果为:

#添加one-hot编码产生的虚拟变量(dummy variables)到泰坦尼克号数据集full

full = pd.concat([full,familyDf],axis=1)

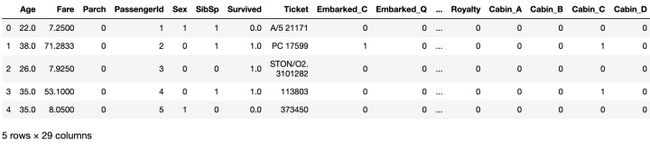

full.head()输出结果:

到此,特征提取已经完毕,查看此时的数据概貌

full.shape输出结果:

3.3 特征选择

使用相关系数法计算各个特征之间的相关系数

#相关性矩阵

corrDf = full.corr()

corrDf输出结果为:

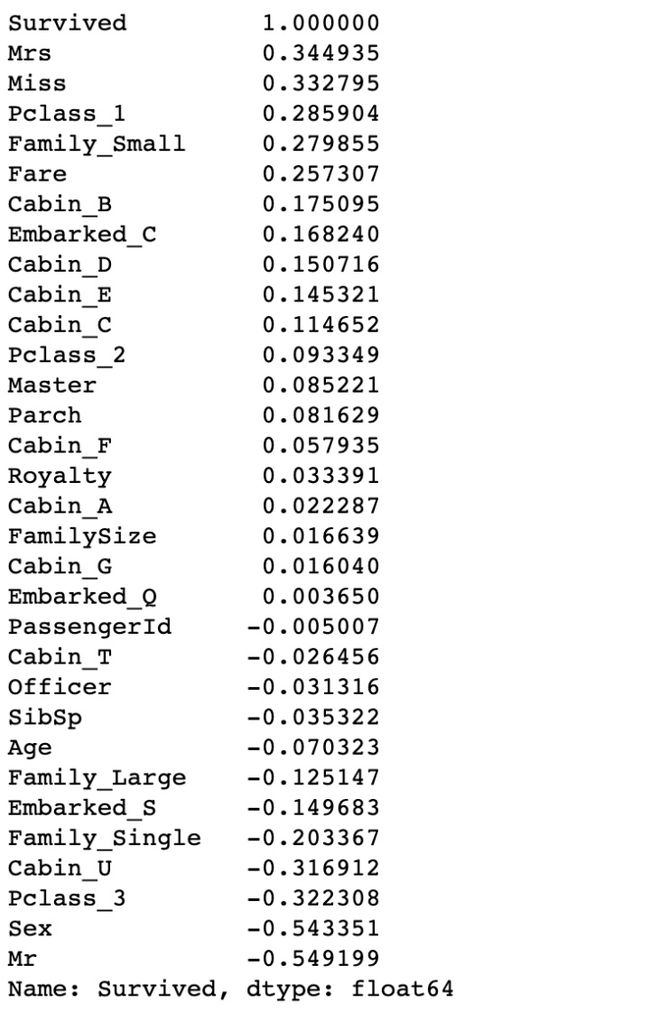

'''

查看各个特征与生存情况(Survived)的相关系数,

ascending=False表示按降序排列

'''

corrDf['Survived'].sort_values(ascending =False)输出结果以相关性从大到小进行排序,也就是排在越前面的特征与存活下来的相关性越大。因此,我们选择这几个特征作为模型的输入:头衔(前面所在的数据集titleDf)、客舱等级(pclassDf)、家庭大小(familyDf)、船票价格(Fare)、船舱号(cabinDf)、登船港口(embarkedDf)、性别(Sex)

#特征选择

full_X = pd.concat( [titleDf,#头衔

pclassDf,#客舱等级

familyDf,#家庭大小

full['Fare'],#船票价格

cabinDf,#船舱号

embarkedDf,#登船港口

full['Sex']#性别

] , axis=1 )

full_X.head()输出结果为:

4.构建模型

4.1建立训练数据集和测试数据集

在开始之前需明确:

1)由于泰坦尼克号测试数据集(test.csv)是最后要提交给Kaggle的,里面没有生存情况的值,因此不能用于评估模型。将Kaggle泰坦尼克号项目给我们的测试数据,定为预测数据集(记为pred,也就是预测英文单词predict的缩写),也就是我们需要使用建立的机器学习模型来对其生存情况进行预测。

2)使用Kaggle泰坦尼克号项目给的训练数据集(train.csv),定为原始数据集(记为source),从这个原始数据集中再进一步拆分出训练数据集(记为train:用于模型训练)和测试数据集(记为test:用于模型评估)。

#原始数据集(train.csv)有891行

sourceRow=891

#因为full_x为train.csv和test.csv合并后的数据,因此需要从特征集合full_X中提取前891行数据

#原始数据集:特征

source_X = full_X.loc[0:sourceRow-1,:]

#原始数据集:标签

source_y = full.loc[0:sourceRow-1,'Survived']

#预测数据集:特征

pred_X = full_X.loc[sourceRow:,:]

'''

查看提取出来的原始数据集和预测数据集的行数,确保无误

'''

#原始数据集有多少行

print('原始数据集有多少行:',source_X.shape[0])

#预测数据集大小

print('预测数据集有多少行:',pred_X.shape[0])输出结果为:

'''

从原始数据集(source)(train.csv)中拆分出训练数据集(用于模型训练train)(80%),测试数据集(用于模型评估test)(20%)

train_test_split是交叉验证中常用的函数,功能是从样本中随机的按比例选取train data和test data

train_data:所要划分的样本特征集

train_target:所要划分的样本结果

test_size:样本占比,如果是整数的话就是样本的数量

'''

from sklearn.model_selection import train_test_split

#建立模型用的训练数据集和测试数据集

train_X, test_X, train_y, test_y = train_test_split(source_X ,

source_y,

train_size=.8)

#输出数据集大小

print ('原始数据集特征:',source_X.shape,

'训练数据集特征:',train_X.shape ,

'测试数据集特征:',test_X.shape)

print ('原始数据集标签:',source_y.shape,

'训练数据集标签:',train_y.shape ,

'测试数据集标签:',test_y.shape)输出结果为:

#原始数据查看

source_y.head()输出结果为:

4.3选择机器学习算法

使用逻辑回归算法

#导入算法

from sklearn.linear_model import LogisticRegression

#创建模型:逻辑回归(logisic regression)

model = LogisticRegression()4.3 训练模型

#训练模型

model.fit( train_X , train_y )输出结果为:

5.模型评估

#分类问题,score得到的是模型的正确率

model.score(test_X , test_y )输出结果为:

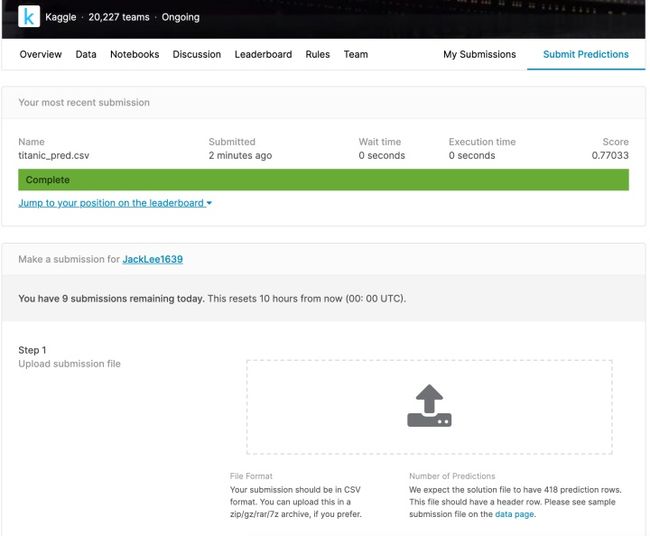

6.方案实施

6.1 得到预测结果上传到Kaggle

使用预测数据集到底预测结果,并保存到csv文件中,上传到Kaggle。

#使用机器学习模型,对预测数据集中的生存情况进行预测

pred_Y = model.predict(pred_X)

'''

生成的预测值是浮点数(0.0,1,0)

但是Kaggle要求提交的结果是整型(0,1)

所以要对数据类型进行转换

'''

pred_Y=pred_Y.astype(int)

#乘客id

passenger_id = full.loc[sourceRow:,'PassengerId']

#数据框:乘客id,预测生存情况的值

predDf = pd.DataFrame(

{ 'PassengerId': passenger_id ,

'Survived': pred_Y } )

predDf.shape

predDf.head()

#保存结果

predDf.to_csv( 'titanic_pred.csv' , index = False )输出的文件默认在当前目录下,将输出文件上传至Kaggle网站即可看到得分和排名。