预训练模型的记忆机制解密!

文 | python

近年来,大规模预训练语言模型给自然语言处理领域带来了翻天覆地的变化。

一提到预训练模型为什么好,标准回答往往是:利用了无标注自监督学习数据,习得了语言学与语义知识,并有效迁移到下游任务中。

然而,预训练模型究竟如何运用预训练过程中记住的内容呢?

本文作者借助英文习语生成任务,探秘预训练模型的记忆唤起机制。

作者发现,在记忆唤起中,底层结构存储与检索可能的表达组合,并形成若干候选,而上层结构会进一步强化模型的信心。

论文题目:

Understanding Transformer Memorization Recall Through Idioms

论文链接:

https://arxiv.org/abs/2210.03588

https://github.com/adihaviv/idiomem/

习语生成检测

为了探索预训练模型运用记忆的方式,首先需要找到一种上下文无关的生成文本。否则,无法确定文本生成的过程激活的是模型的“泛化”能力,还是唤醒了“记忆”。

作者认为“习语”就是一种很合适的研究对象。因为习语不像普通语言那样有很多可替换性,且和组成词汇间的语义关联较低。

比如“我喜欢猫/狗/猴子”都是可行,但“play it by ear”不能改成“play it by nose”,并且其含义“随机应变”也同“玩耳朵”没啥关联。所以其生成过程完全依赖“记忆”而不适用组合泛化及词义相关的泛化机制。

因此,作者选用习语生成任务作为探索预训练模型记忆唤起机制的检测方法。

具体而言,作者给定一个习语的前面若干个词,让模型预测其最后一个词,以检测预训练模型的记忆唤起能力。

如果最后一个词被分割成了多个sub-word,仅预测其第一个token。

一般情况下,如果引起了基于语义的生成,对于“play it by ear”而言,生成的内容会是任何一个可以被“玩”的名词,而只有唤起了预训练中的记忆,才会高概率地生成“ear”。

作者认可的习语例如:

play it by ear

make a mountain out of a molehill think outside the box

there’s no such thing as a free lunch

但还有一些不太合适的习语,通常是动宾搭配、词义相似度等上下文语义信息带来了很强的提示。作者采用了启发式规则+人工标注的手段,去除了这些习语。

总体而言,大概只保留了MAGPIE[1]、EPIE[2]、LIDIOMS[3]三个数据集中收集的习语的45%。

不合适的习语例如:

go back to the drawing board

boys will be boys

take it or leave it

实验与结果

作者进一步构建了3个集合:习语中,模型能记住,即能预测对的那些习语(绿色);模型不能记住,即预测错的那些习语(黄色);及随机采样的wiki句子(蓝色),作者这里假设大多数普通的句子不会被预训练模型记住。

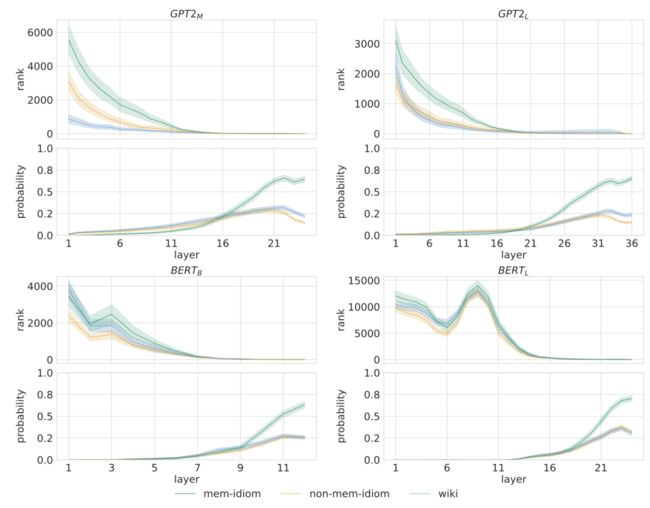

实验结果如下图所示,作者针对预训练模型每一层的建模向量,加一个全连接层后进行预测,并汇报了正确的词在预测中的平均排名与平均概率。

其中,检测的预训练模型包括 GPT2 medium,GPT2 large, BERT base, BERT large。

作者发现:

对于记住的习语部分(绿色),排名在浅层部分急速下降的同时(同其他颜色一样,且预测排名更靠后),概率却一直保持在相对较低的水平,接近零,甚至比其它颜色还低。作者对此的解释是,浅层预测时更多关注一些常见的n-gram组合,导致习语排序落后[4]。而排序快速上升,概率基本不变,表示模型在检索可能出现的搭配组合,但并没有给他们分配很高的概率,以便后续结构从全局上进一步调整概率分布。

在后半部分,能记住的习语部分(绿色)的正确答案的平均概率急速上升。而对于没有记住的那些习语及随机采样的语句,正确答案的概率相对较低。作者解释是,在这一阶段模型调整了预测的概率分布,对绿色部分表现出单峰分布,体现出习语的不可替代性。而没有记住的那两部分(黄色、蓝色),模型在应用泛化能力,预测出了多个语法和语义上潜在可能的答案,形成一种多峰分布。

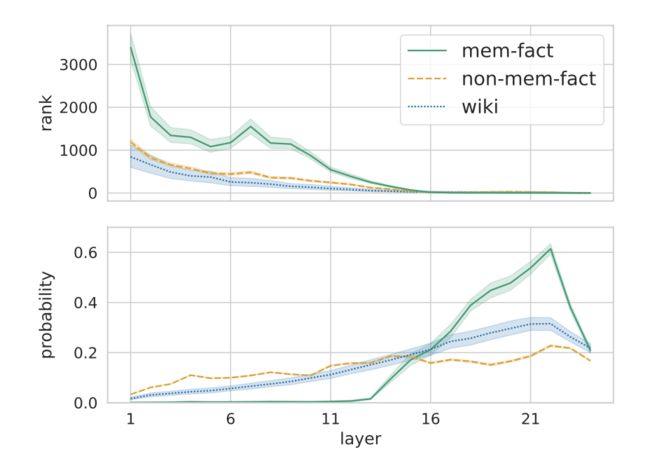

作者后续又用事实组合重复了这一实验,并得到了类似的结果。该实验采用了LAMA-UHN[5]数据集的一个筛选的子集。形式例如:

Federico López was born in

在GPT medium上的结果如下图所示。

作者指出,在事实数据上的实验,相比习语数据上的,主要有一点不同:在最后两层时,正确词汇的预测概率有明显下降。

作者人工检查发现,82%的样本实际上有多个正确答案,不像习语具有唯一性(编者猜测可能是类似于两个同名的人出生地不同之类的)。

这一差异彰显了本文所构建的习语数据集的优越性。

小编的话

个人认为,这篇文章算不上什么大发现。这篇文章研究的问题——预训练模型如何唤醒记忆,是一个很有意思的问题。

但在神经网络不可解释的大背景下,作者只能设计一系列验证任务,通过模型表现来做一些推测。这种做法并非作者首创,也不是第一次被用在预训练模型记忆机制的分析上,所以并没有很高的创新性。

作者采用习语生成这个任务,是一个很聪明的想法,习语的一系列特点让它很适合用来分析预训练模型的记忆召回机制。

作者也用了较大的篇幅描述为什么习语更合适,描述其构建的习语数据集,以及作者在这方面的贡献。

实验结果上,最初的层中,习语的正确答案的排名更靠后这一点上,作者用[4]的结论来解释,认为浅层预测更多关注常见的n-gram,这点相对比较合理。而最后层的表现中,用习语中答案分布的单峰性来解释习语的正确答案概率更高也是说的通的。

然而,对于中间阶段,作者声称的两段式过程并非唯一解释。

我觉得看起来,中间的变化过程很像是给定起点和终点状态之后的一个指数函数拟合。之所以是指数函数,是因为随着层数的加深,微小的变化会得到正反馈的累加。这样,这篇文章的结果就只是一个数学上的现象,而非作者生成的记忆召回的语用过程了。

北大毕业的NLP博士。日常写点论文,码点知乎,刷点leetcode。主要关注问答、对话、信息抽取、预训练、智能法律等方向。力扣国服第一python选手(经常掉下来)。知乎 ID 是 Erutan Lai, leetcode/力扣 ID 是 pku_erutan,欢迎没事常来逛逛。

作品推荐

恕我直言,你的实验结论可能严重依赖随机数种子!

AllenAI 发布万能问答系统 MACAW!各类题型样样精通,性能大幅超越 GPT-3!

吐血整理:论文写作中注意这些细节,能显著提升成稿质量

恕我直言,你的模型可能并没看懂 prompt 在说啥

加入卖萌屋NLP、CV、搜广推与求职讨论群

[1] Hessel Haagsma, Johan Bos, and Malvina Nissim. 2020. MAGPIE: A large corpus of potentially idiomatic expressions. In Proceedings of the 12th Language Resources and Evaluation Conference, pages 279–287, Marseille, France. European Language Resources Association.

[2] Prateek Saxena and Soma Paul. 2020. Epie dataset: A corpus for possible idiomatic expressions. In Text, Speech, and Dialogue, pages 87–94, Cham. Springer International Publishing.

[3] Diego Moussallem, Mohamed Ahmed Sherif, Diego Esteves, Marcos Zampieri, and Axel-Cyrille Ngonga Ngomo. 2018. LIdioms: A multilingual linked idioms data set. In Proceedings of the Eleventh International Conference on Language Resources and Evaluation (LREC 2018), Miyazaki, Japan. European Language Resources Association (ELRA).

[4] Mor Geva, Roei Schuster, Jonathan Berant, and Omer Levy. 2021. Transformer feed-forward layers are key-value memories. In Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing, pages 5484–5495, Online and Punta Cana, Dominican Republic. Association for Computational Linguistics.

[5] Nina Poerner, Ulli Waltinger, and Hinrich Schütze. 2020. E-BERT: Efficient-yet-effective entity embeddings for BERT. In Findings of the Association for Computational Linguistics: EMNLP 2020, pages 803–818, Online. Association for Computational Linguistics.