ceph实战之ceph集群搭建

上一篇ceph基础_Mr.Lilh的博客-CSDN博客讲了ceph基础

这一篇是ceph实战之ceph搭建

一:环境要求

服务器系统:centos7.9_x86_64

ceph版本: octopus

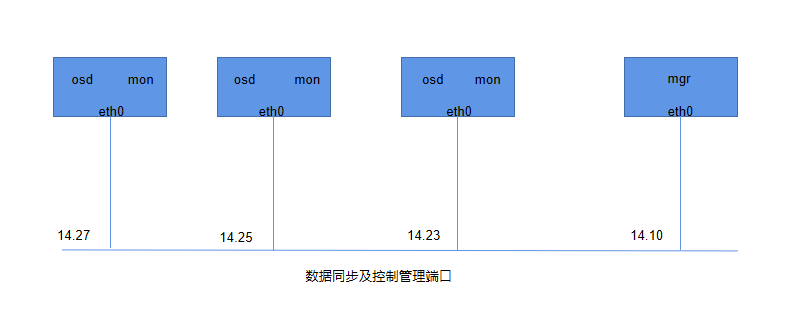

二:搭建架构

三: 各节点服务器资源分配详情

| 节点类型 | 主机IP | 主机名 | 系统盘 | 数据盘1 | 数据盘2 |

| mgr节点 | 10.19.14.10 | cephmgr | sda | sdb | sdc |

| mon节点 | 10.19.14.23 | cephstore2 | sda | sdb | sdc |

| 10.19.14.25 | cephstore3 | sda | sdb | sdc | |

| 10.19.14.27 | cephstore1 | sda | sdb | sdc | |

| store节点 | 10.19.14.23 | cephstore2 | sda | sdb | sdc |

| 10.19.14.25 | cephstore3 | sda | sdb | sdc | |

| 10.19.14.27 | cephstore1 | sda | sdb | sdc |

四:ceph集群搭建之基础工作

1)各节点创建ceph用户

#创建ceph用户

useradd ceph

#创建ceph用户密码

passwd ceph2)在mgr节点上切换到ceph用户,生成ssh-pub秘钥

#切换到ceph用户执行下面命令,一直敲回车即可

su - ceph

ssh-keygen3)同步mgr节点的ceph用户公钥到osd节点

#在mgr节点同步ceph用户公钥到个节点

ssh-copy-id [email protected]

ssh-copy-id [email protected]

ssh-copy-id [email protected]

ssh-copy-id [email protected]4)在各节点修改/etc/hosts文件添加主机名和IP对应解析

#在hosts文件里写入以下映射信息

vim /etc/hosts

10.19.14.10 cephmgr

10.19.14.27 cephstore1

10.19.14.23 cephstore2

10.19.14.25 cephstore35)在各节点配置ceph 的yum源

centos7的base源和epel源都改为阿里云镜像源此处不做介绍,详情参考:阿里巴巴开源镜像站-OPSX镜像站-阿里云开发者社区

#配置ceph.repo文件

vim /etc/yum.repos.d/ceph.repo

[ceph]

name=ceph

baseurl=https://mirrors.aliyun.com/ceph/rpm-octopus/el7/x86_64/

gpgcheck=0

[ceph-noarch]

name=cephnoarch

baseurl=https://mirrors.aliyun.com/ceph/rpm-octopus/el7/noarch/

gpgcheck=06)在各个节点安装ceph依赖文件

#各个节点安装依赖文件

yum install -y python2-subprocess32 python36-werkzeug

pip3 install pecan -i https://pypi.douban.com/simple7)在每个节点上添加ceph用户免密执行root权限

#在每个节点上添加ceph用户免密执行root权限

vim /etc/sudoers

ceph ALL=(ALL) NOPASSWD: ALL 8)在mgr节点创建ceph集群配置文件

#安装ceph-deploy

yum install -y ceph-deploy

#切换到ceph用户

su - ceph

#--cluster-network 为集群内部地址, --public-network 为外部可以调用地址

ceph-deploy new --cluster-network 10.19.14.10/24 --public-network 10.19.14.10/24 cephmgr

9)在mgr节点上修改ceph.conf配置

#在ceph用户家目录下修改ceph.conf配置文件

vim ceph.conf

[global]

fsid = 3ef172a8-147b-442d-a24a-1cd17ae2357e

public_network = 10.19.14.10/24

cluster_network = 10.19.14.10/24

mon_initial_members = cephstore1 #修改此处mon的主机名称

mon_host = 10.19.14.27 #修改此处mon的IP地址

auth_cluster_required = cephx

auth_service_required = cephx

auth_client_required = cephx五:ceph集群搭建之ceph-mon节点安装

1)在所有mon节点上安装ceph-mon服务

yum install -y ceph-mon2)在mgr节点ceph用户下初始化ceph-mon主节点

#在mgr节点ceph用户下初始化mon节点

ceph-deploy mon create-initial

#在cephstore1节点验证是否安装mon成功

ps aux | grep mon

六:ceph集群搭建之ceph-mgr节点安装

1)在mgr节点上执行安装ceph-mgr服务

yum install -y ceph-mgr2)在mgr节点ceph用户下执行创建mgr

ceph-deploy mgr create cephmgr

#验证mgr是否安装成功

ps aux | grep mgr七:ceph集群搭建之ceph-osd节点安装(即cephstore节点)

1)在mgr节点ceph用户下初始化每个storge节点

#在mgr节点ceph用户下执行初始化每个storge节点命令

ceph-deploy install --no-adjust-repos --nogpgcheck cephstore1

ceph-deploy install --no-adjust-repos --nogpgcheck cephstore2

ceph-deploy install --no-adjust-repos --nogpgcheck cephstore32)在mgr节点ceph用户下依次执行擦除磁盘数据

ceph-deploy disk zap cephstore1 /dev/sdb # 节点名称 #磁盘名称

ceph-deploy disk zap cephstore1 /dev/sdc

ceph-deploy disk zap cephstore2 /dev/sdb

ceph-deploy disk zap cephstore2 /dev/sdc

ceph-deploy disk zap cephstore3 /dev/sdb

ceph-deploy disk zap cephstore3 /dev/sdc3)在mgr节点ceph用户下添加磁盘为OSD

ceph-deploy osd create cephstore1 --data /dev/sdb

ceph-deploy osd create cephstore1 --data /dev/sdc

ceph-deploy osd create cephstore2 --data /dev/sdb

ceph-deploy osd create cephstore2 --data /dev/sdc

ceph-deploy osd create cephstore3 --data /dev/sdb

ceph-deploy osd create cephstore3 --data /dev/sdc八:查看集群信息

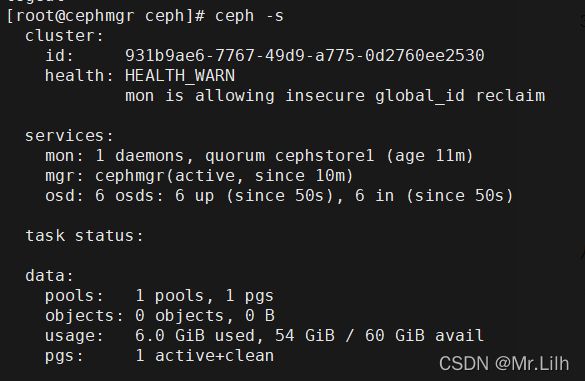

把ceph家用户下的 ceph.conf 和 ceph.client.admin.keyring 文件移动到/etc/ceph/ 目录下

切换到root用户下,执行ceph -s

处理 mon is allowing insecure global_id reclaim 警告

执行以下命令即可

ceph config set mon auth_allow_insecure_global_id_reclaim false下一篇写写ceph集群的扩展:ceph实战之ceph集群扩展_Mr.Lilh的博客-CSDN博客