ISPRS2022/遥感影像云检测:Cloud detection with boundary nets基于边界网的云检测

ISPRS2022/云检测:Cloud detection with boundary nets基于边界网的云检测

- 0.摘要

- 1.概述

-

- 1.1. 云检测方法综述

- 1.2. 挑战

- 1.3. 有前途的策略

- 1.4. 一种新的框架:边界网

- 2. 调查的数据

- 3.边界网Boundary nets

-

- 3.1. Scalable-boundary Net可伸缩边界网络

- 3.2. Differentiable-boundary net可微边界网络

- 4. 训练边界网

-

- 4.1. 训练数据构建

- 4.2. 一种分布式的、全面的监督方式

- 4.3. 损失函数

- 4.4. 优化

- 5.云检测

- 6.总结

- 参考文献

论文下载

代码开源

0.摘要

在卫星光学图像中,云通常以不同的尺度和不同的边界显示。为了准确捕捉云的可变视觉形式,我们提出了一种基于深度学习的策略,即边界网,该策略生成一个云掩码,用于检测一幅云图中的云。边界网由两个网络组成,即(a)可伸缩边界网和(b)可微边界网。可扩展边界网从云图像中提取多尺度特征,并通过多尺度融合模块综合表征具有可变边界尺度的云。多尺度特征提取和多尺度融合一致地捕获不同大小的云,为云图像生成多尺度云掩模。可微边界网通过残差结构表征了多尺度云掩码和地面真实云掩码之间的差异。它生成一个差分云遮罩,作为多尺度云遮罩边界细节的补充。最后,通过融合多尺度云掩模和差分云掩模得到整体云掩模。在训练过程中,边界网的多个关键部分以分布式方式访问监督信息,并总结损失以进行整体训练计算。这种分布式、全面的监督不仅避免了单独训练两个网络,而且还将两个网络紧密地耦合到一个整体框架中。实验结果验证了我们的边界网络性能良好,并取得了显著的效果。

1.概述

在过去几十年遥感技术进步的推动下,光学遥感图像得到了广泛的应用。云是大气中的自然现象,经常出现在遥感图像中。全球平均年云量约为66%(张等,2004)。在遥感图像中准确探测云的任务在协助使用遥感技术观察地球方面发挥着重要作用。

云检测旨在识别遥感图像中的云像素。准确的云检测有助于遥感技术的高水平应用,例如收获产量估计(Sakamoto,2020;Holzman等人,2018)、土地变化检测(Hu等人,2018b;Yan等人,2019)和灾害管理(Boluwade,2020)。另一方面,不准确的云检测可能会给后续的实际任务带来麻烦,并对结果产生负面影响(朱和Woodcock,2012)。

云的多样性和下垫面的复杂性使得在遥感光学图像中区分云像素和非云像素很困难。因此,云检测通常是一项艰巨的任务。在本节的剩余部分,我们将回顾现有的云检测方法,解释云检测中的挑战,提出我们自己的云检测解决方案,并介绍我们的新贡献。

1.1. 云检测方法综述

在过去几年中,已经开发了许多云检测方法。在本小节中,将回顾三大类云检测方法,即基于阈值的方法、基于手工特征或规则的方法以及基于深度学习的方法。

基于阈值的云检测方法主要利用光谱信息通过设置阈值来区分云和非云像素。有各种基于阈值的方法,例如ISCCP云掩码算法(Rossow和Garder,1993),APOLLO(云、陆地和海洋上的AVHRR处理方案)方法(Kriebel等人,2003)和Fmask方法(Zhu等人,2015)。这些基于阈值的方法在某些条件下提供了良好的云检测结果(Foga等人,2017)。然而,这些基于阈值的方法存在明显的不足。一方面,基于阈值的云检测方法依赖于各种信息(例如,光谱反射率、亮度和温度),并且可能具有受类似信息影响的不正确像素分类。另一方面,阈值通常根据特定的卫星平台和传感器设置,并且具有较弱的通用能力

近年来,基于手工特征或统计规则的云检测方法蓬勃发展。胡等(2015)将随机森林算法与视觉显著性特征相结合,得到云的分割图。Lin等人(2015)使用加权主成分分析和统计模型从多时相图像中获取云掩码。Joshi等人(2019)提出了基于支持向量机(SVM)算法的STmask方法,以从流苏帽带4(TC4)和短波红外光谱带2(SWIR2,2.107–2.294μm)生成云掩码。虽然这些方法通过统计学习取得了良好的效果,但它们在很大程度上依赖于手工特征或人类指定的规则。在这种情况下,很难设计一个通用的范例来应对云的多样性。手工特征或某些人类指定规则的应用仅限于特定情况。

最近,深度学习技术被部署到云检测中。在这种情况下,云检测通常被视为通过基于深度学习的方法解决的多通道图像分割问题。在自然图像分割的文献中,提出了各种基于深度学习的方法,例如FCN(Long等人,2015)、U-Net(Ronneberger等人,2015)、SegNet(Badrinarayanan等人,2017)和DeepLab V3+(Chen等人,2017)。这些基于深度学习的图像分割方法主要依赖于卷积神经网络(CNN)(LeCun等人,1998)。CNN是一种有效的端到端深度分层特征学习模型,可以自动捕获图像的固有特征。CNN也被用来处理云检测问题。谢等(2017)应用基于浅层CNN的模型对云像素进行分类,取得了良好的性能。Shi等人(2017)提出了一种云检测方法,使用CNN进行特征提取,使用支持向量机进行分类。虽然上述两种方法都使用了基于CNN的结构来自动提取特征,但由于网络结构相对简单,在复杂场景中的检测效果并不好。李等人(2019)提出了一种融合低层次高分辨率特征和高层次高语义特征的特征金字塔网络,用于云检测。Jeppesen等人(2019)使用了一种基于编码器-解码器的结构,该结构逐渐提取和恢复特征,以在陆地卫星-8图像上生成云掩码。Mohajerani和Saeedi(2019)提出了基于复杂卷积块和各种垂直路径卷积的云网络,以区分云和非云像素。Segal Rozenhaimer等人(2020年)通过开发三种新的基于深度CNN的网络结构和一种新的转移学习框架,对使用多模式数据检测云进行了开创性研究。何等人(2021)优化了CNN结构的空间特征表示(孙等人,2021),并在高分1号图像上构建了高效的云检测网络结构。为了增强薄云的特征,张等人(2021)提出了一种用于云检测的AUDI-Net,方法是在深层结构中引入小波变换和暗通道先验,并在浅层中放置多个扩展卷积,以获得更多的空间信息。这些现有的基于深度学习的云检测方法以加深模型架构的一般方式有效地从光学图像中提取光谱和空间信息。然而,这些深层架构往往具有很强的表征一般场景的能力,但可能没有足够的能力捕捉云层显示的各种外观。

1.2. 挑战

尽管云检测已经研究了很多年,但仍有一些具有挑战性的问题尚未解决。一个主要问题来自于在不均匀土地上充满破碎薄云的高度混合场景的复杂现象(例如,图1所示的多云场景)。在这种情况下,现有的云检测方法(即使是最先进的方法)很难处理这些复杂的现象。复杂的现象给云检测带来了两大挑战,如下所示:

1) 第一个挑战是检测具有不同边界尺度的云。这一挑战源于解决各种规模的碎云的困难。大多数现有的深度模型(尤其是深度神经网络)倾向于通过固定尺度的感受野捕捉视觉特征。如图2(a)所示,卷积神经网络(CNN)中的一个固定比例感受野只能对固定大小区域内的附近像素进行建模(Szegedy等人,2015;Ranftl等人,2021)。这种结构很难应付边界尺度不稳定的云。如图3所示,一些标准方法(即U-Net(Ronneberger等人,2015年)、SegNet(Badrinarayanan等人,2017年)和DeepLab V3+(Chen等人,2017年))检测大多数具有大规模边界的云,但往往忽略小尺寸的云(由蓝色圆圈标记)。限制的一个主要原因是,这些现有方法是由固定尺度的感受野构成的,很难处理具有不稳定边界尺度的云。

2) 第二个挑战是区分复杂的云边界。具有不均匀陆地的高度混合场景导致难以区分的云边界,尤其是薄云。此外,云的形状随着环境的变化而急剧变化(朱和伍德科克,2012),使得复杂的云边界更难捕捉。现有的深度学习方法在全局范围内获得云检测结果,而不需要特别考虑边界。对于一些复杂的现象,大多数现有的基于深度学习的云检测方法在识别复杂云边界上的云像素时置信度较低。因此,如果采用检测置信度来表示云掩码,则通常会在云掩码的云边界处出现模糊。图3显示了从一些标准方法获得的模糊边界(用橙色圆圈标记)。因此,如何生成高置信度、清晰边界的云掩码仍是云检测的一个挑战

1.3. 有前途的策略

为了应对第1.2节中描述的两个挑战,我们提出了两种有前途的策略,简要介绍如下。

我们在第1.2节中提出的挑战1)的解决方案是一种多尺度处理策略。多尺度处理从多尺度的感受野开始,感受野能够捕捉不同尺度的云(如图2(b)所示)。将从多尺度感受野获得的多尺度特征进行叠加和融合,得到多云图像的多尺度表示。多尺度处理策略是可扩展的,因此它能够生成从非常小的规模到相当大的规模的云掩码。它解决了现有基于深度学习的方法中通常出现的开销敏感性缺陷。

我们在第1.2节中提出的挑战2)的解决方案是一个残差架构。它实现差分运算并生成差分云掩码。差分云掩模是增强云掩模边界的有效手段。这样,沿云遮罩边界产生的模糊被抵消。

1.4. 一种新的框架:边界网

通过利用这两种有前途的策略,我们开发了一个用于云检测的边界网总体框架。边界网由两个基于深度学习的网络组成:可扩展边界网和可微边界网。

可扩展边界网从光学图像中提取多尺度特征,并将其融合生成多尺度云掩模。在我们的工作中,我们通过暗示网络能够在多个尺度上表征云来重载“可扩展”一词的含义。

可微边界网学习云特征的固有差异,并生成差异云掩码。将差分云掩模与其对应的多尺度云掩模融合生成整体云掩模。在我们的工作中,我们通过暗示网络倾向于可区分的边界,强调了“可微”这个词的含义。

训练边界网需要训练数据,其中每个样本都由一个云图和它的地面真云遮罩组成。云图和地面真实云掩码对为训练网提供监督信息。虽然这两个网络具有不同的功能,但它们是在一种分布式的、全面的监督方式下训练的。具体而言,边界网多个关键部分分布式接入监管信息,将损失汇总,统筹两网训练。分布式监控使得培训过程更加全面,涉及到多个关键环节的监控。在总损失测量方面的全面监督不仅使两个网以一致的方式耦合,而且使边界网成为一个不可分割的框架。

一旦训练良好,边界网可以为给定的多云图像生成精确的云遮罩。大量的实验验证了边界网在云检测中的有效性。

我们的工作的新颖贡献总结如下:

1)我们开发了一种新型的边界网云检测框架,解决了基于深度学习的云检测方法长期面临的尺度不敏感和边界模糊问题。

2)我们开发了一种分布式的、整体监督的方式来训练边界网。分布式监控为两网各关键部位提供监控信息,实现全面培训。整体监督不仅使两网保持一致,而且使经济培训过载。

3)边界网实现了最先进的云检测性能。我们发布了实现边界网的代码。我们鼓励研究人员在不同的情况下对边界网进行实证评估,并使广泛的研究成为可能。

2. 调查的数据

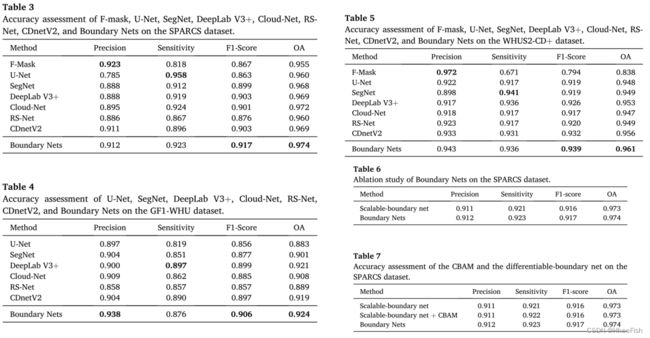

在我们的研究中,我们使用三个数据集,即SPARCS (Hughes和Hayes, 2014)、GF1-WHU (Li等人,2017)和WHUS2-CD+ (Wu等人,2019)来验证提出的边界网。

1) sparc数据集

SPARCS数据集是基于Landsat-8图像构建的,这些图像在地理上与WRS2路径/行系统一起被捕获和组织。SPARCS数据集的空间分布较为随机,每条路径/行图像均随机选取2013 - 2014年的图像。由于整个Landsat图像中的子区域具有相似的土地覆盖、相同的大气条件和相同的采集变量(如太阳角度),所以使用整个Landsat图像中的一些子图像来表示整个Landsat图像。在SPARCS数据集中,从每张图像中手动选择1000 × 1000个像素子图像,以确保不同像素类型(如云、晴空、水)的存在。SPARCS数据集包含10个波段的80幅Landsat-8卫星图像。表1显示了SPARCS数据集中包含的波段的详细信息。原标注图像包含“云”、“云影”、

2) GF1-WHU数据集

基于高分一号WFV影像构建了GF1-WHU数据集。高分一号卫星上的WFV成像系统具有16米的空间分辨率和跨越可见光到近红外光谱区域的四个多光谱波段。这些验证数据包括108个Level-2A场景,这些场景来自不同的全球陆地覆盖类型和不同的云条件。相关的掩码包含两个类别,即“云”和“云阴影”。

3) WHUS2-CDþ数据集

WHUS2-CD+数据集包括32幅Sentinel-2A图像,覆盖了中国大陆的所有季节和各种土地覆盖类型(如植被、水、城市、荒地和冰雪)。以10 m空间分辨率手工标记WHUS2-CD+的参考云掩码。

3.边界网Boundary nets

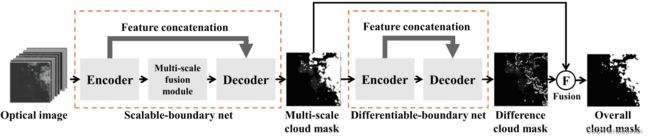

图4所示。边界网的整体架构。

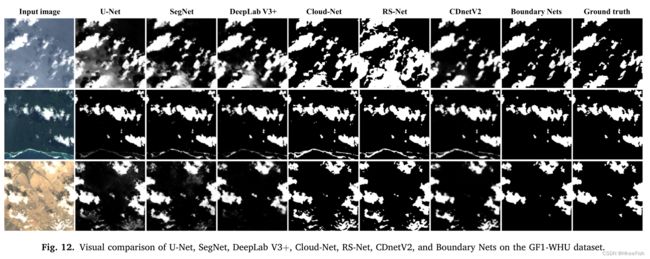

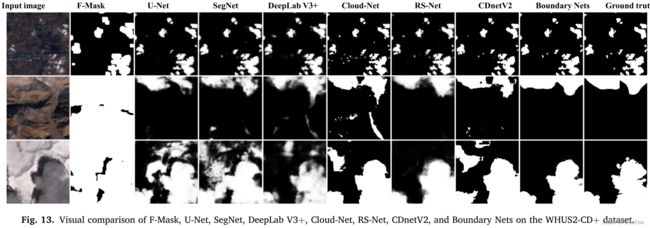

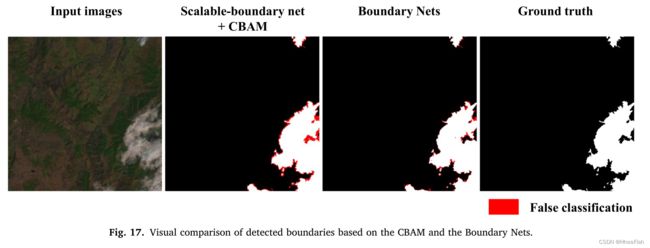

在本节中,我们将介绍边界网的整体架构。边界网的结构如图4所示。边界网由两个网组成,即可伸缩边界网和可微边界网。可微边界网首先生成一个多尺度云掩模,然后将其放入可微边界网中。可微边界网产生差分云掩模。将多尺度云掩码与差分云掩码融合,得到整体云掩码。图5说明了将边界网应用于示例云图的中间和最终云检测结果。

3.1. Scalable-boundary Net可伸缩边界网络

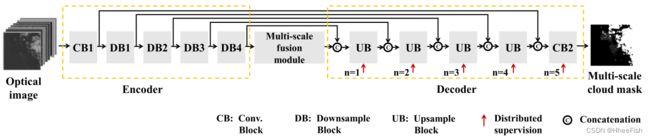

图6所示。可扩展边界网的体系结构。

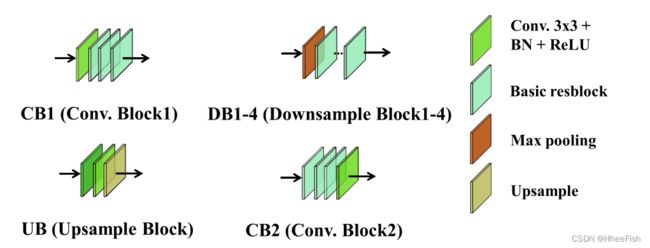

图7所示。可扩展边界网的子体系结构。

可伸缩边界网络采用基于编码器-解码器的结构,如图6所示。可伸缩边界网的子架构(CB、DB、UB)如图7所示。编码器提取不同层次的特征。解码器从融合的多尺度特征中恢复云掩码。编码器和解码器之间使用多个特征级联模块和一个多尺度融合模块。

特征拼接模块将不同尺度的浅层空间信息和深层语义信息结合起来构建多尺度表示。多尺度融合模块进一步提高了多尺度表示能力。

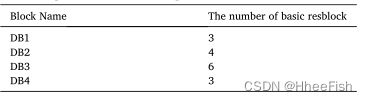

编码器采用全卷积网络结构。该部分由卷积块s1 (CB1)和四个下采样块(DB1-DB4)组成。通过修改ResNet-34的第一层,CB1的结构如下:(i) 7 × 7卷积被替换为两个3 × 3卷积,(ii)去除了轮询层。这些修改使得更高的分辨率和增强边界信息(Shen等,2020)。每个DB包含一个最大池层和几个基本的重阻塞。采用最大池法进行下采样,保留了丰富的纹理信息。基本重块的结构与(He et al., 2016)相同。表2显示了不同数据库中包含的基本重块的数量。

表2下样块的描述。

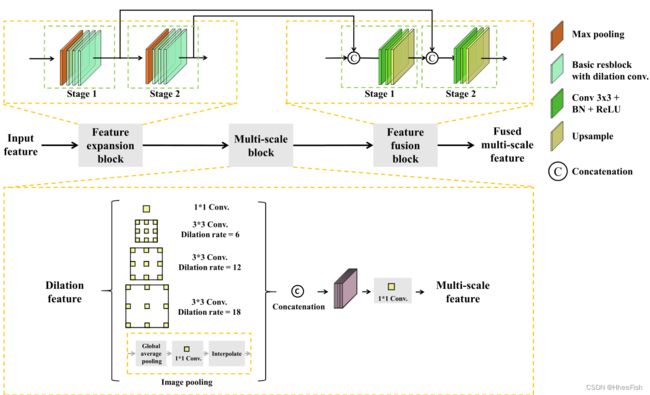

图8所示。多尺度融合模块的体系结构。

多尺度融合模块产生融合的多尺度特征,用于检测不同边界尺度的云,如图8所示。多尺度融合模块由特征扩展块、多尺度块和特征融合块三部分组成。特征扩展块增加特征的接受域,产生膨胀特征。特征扩展块由两个特征扩展阶段组成。每个特征扩展阶段都有一个最大池化层和三个基本的带膨胀卷积的重块。采用多尺度块生成多尺度特征。在多尺度块中,膨胀特征首先通过5个平行分支:4个膨胀率不同的膨胀卷积层和1个图像池化操作。四个扩张卷积层产生具有不同接收野的特征。一个图像池模块生成通道特征。然后,利用不同接收域的特征和通道特征,通过一次拼接运算和一次1 × 1卷积得到多尺度特征;特征融合块由两个特征融合阶段组成。每个特征融合阶段都有两个卷积层、一个上样本层和一个融合操作。在第一特征融合阶段,首先将多尺度特征与第二特征展开阶段的输出进行拼接,然后通过两个卷积层和一个上采样层产生输出。在第二特征融合阶段,输入为第一特征融合阶段和第一特征扩展阶段的输出。第二特征融合阶段所进行的操作与第一特征融合阶段相同。经过两个特征融合阶段后,将得到的特征与空间信息丰富的浅层特征进行融合,生成融合后的多尺度特征。

四个上样块从不同尺度的特征中逐渐恢复出云遮罩。CB2聚合空间信息和通道信息,形成多尺度云掩码。

可缩放边界网能有效检测不同边界尺度的云。代表性的用于云检测的深度网(如Jeppesen et al., 2019)具有固定大小的接受域,仅对一定规模的云敏感,不能扩展到更大或更小的云。为了解决这一限制,我们开发了一个多尺度处理策略的可伸缩边界网。“多尺度”一词有两层含义。第一个是我们部署了一个下采样和上采样架构,允许在不同的尺度上处理信息。第二,我们使用不同扩张速率的扩张卷积层来有效地调整网络接收区域的大小。不同大小的接收场捕捉了不同边界尺度云的特征。此外,利用多尺度融合模块对来自不同大小接收域的多尺度特征进行拼接运算和特征融合块融合。该多尺度处理策略使可伸缩边界网能够生成捕获不同大小云的多尺度云掩码。

我们将可伸缩边界网表示为:可缩放边界网的输入是X∈RW×H×C,其中X表示归一化卫星图像,W表示宽度,H表示高度,C表示通道。可伸缩边界网的输出为Ym∈RW×H×1,其中Ym为多尺度云掩码。获取方式如下:

![]()

式中,Fs表示从X到Ym的映射,θ1表示可缩放边界网学习到的参数。

3.2. Differentiable-boundary net可微边界网络

图9所示。可微边界网的结构。

可微边界网的结构与可缩放边界网类似。它们都具有基于编码器-解码器的架构。可微边界网的接收域比可伸缩边界网的接收域小。这种结构的一个原因是,可微边界网旨在识别具有丰富局部特征的精细边界,而小尺寸的接受域更适合捕捉局部特征。与可伸缩边界网的复杂结构相比,可微边界网的结构要简单得多。可微边界网的详细结构如图9所示。

可微边界网采用残差结构构建,残差结构表征了内部各层之间的差异。差分运算捕捉了细节,增强了边界表示。残差结构产生不同的云掩码,捕捉云边界。将不同的云掩码与其对应的多尺度云掩码融合,得到整体云掩码。在这种情况下,多尺度云遮罩中可能出现的边界模糊被相应的差分云遮罩中和。因此,整体云掩码兼具多尺度灵活性和清晰边界表示的优势。

我们将可微边界网表述如下。可微边界网的输入为多尺度云掩码Ym。可微边界网的输出为Yd∈RW×H×1,其中Yd为差分云掩码。获取方式如下:

![]()

式中Fd表示从Ym到Yd的映射。θ2表示可微边界网学习的参数。最后得到整体云掩码Yo如下:

![]()

其中ω1和ω2表示平衡项的超参数。

4. 训练边界网

在本节中,我们将介绍边界网的训练细节。4.1节给出了训练数据的构建过程。训练方式在第4.2节中介绍。训练损失将在4.3节中介绍。优化方法在4.4节介绍。

4.1. 训练数据构建

我们使用384 × 384的滑动窗口将第2节描述的SPARCS数据集中的每张图像裁剪成小的图像补丁。来自GF1-WHU和WHUS2-CD+数据集的场景图像通常是巨大的,从每个完整的场景中选择100个具有代表性的384 × 384的patch来训练我们的网络。训练数据和测试数据按8:2的比例随机划分。训练数据的每个训练样本由一个云图X∈RW×H×C和它的ground truth云掩码Y∈RW×H×1组成。将作物重叠率设置为50%,可以有效扩展SPARCS数据集的训练数据。在训练过程中采用随机水平翻转策略对训练数据进行扩展。

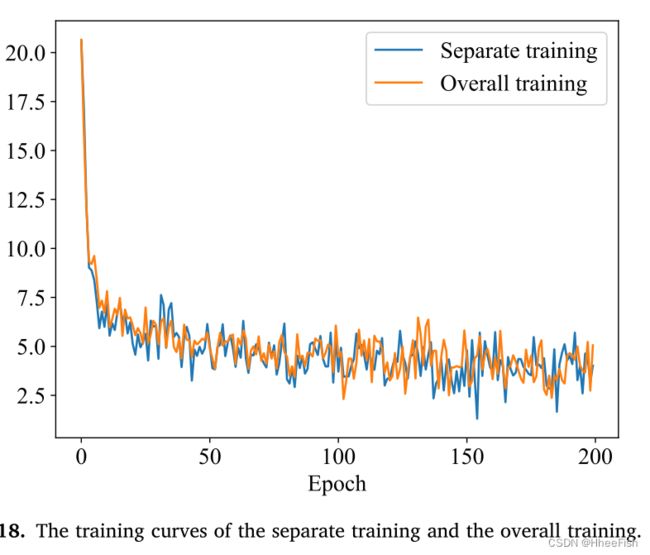

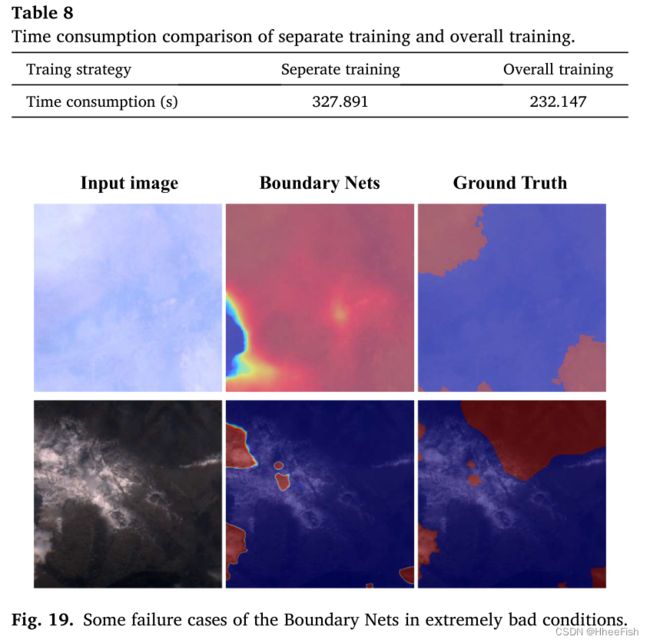

4.2. 一种分布式的、全面的监督方式

训练数据由4.1节构造的云图和地面真实云掩码对组成,为训练边界网提供监督信息。如图6和图9所示,边界网各关键部分均采用分布式方式访问监督信息。具体而言,可伸缩边界网络中的每个UBs都可以访问监管信息。另外,根据监督信息对整个云掩码进行评估。虽然以分布式的方式访问,但与监督信息有关的每个关键部分的损失都被总结为整体损失,使边界网成为一个不可分割的框架。看似矛盾的分布式接入操作和整体损失之和形成了一个不一致的训练策略,既对网中每个关键部分进行了综合训练,又通过不是单独训练而是作为一个不可分割的框架来训练两个网,从而保持了经济的训练过载。第4.3节将描述如何构造分布式、整体监督方式的损失函数。

4.3. 损失函数

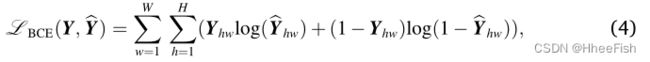

我们开发了一个双层(DL)损失函数LDL,它结合了二元交叉熵(BCE)损失LBCE和联合损失LIoU的交集来训练我们的边界网。

BCE损失广泛应用于图像分类和分割任务中。BCE损失明细如下:

其中Y∈RW×H×1表示真云掩码。真云掩码取值为0或1。0表示云像素,1表示非云像素Y∧∈RW×H×1表示制作的云掩码Y∧的取值范围为0 ~ 1。该值越大,该像素被认为是云像素的可能性越大。Yhw表示真云掩码中第h行、w列的值Y∧hw表示生成的云掩码中的相应值。

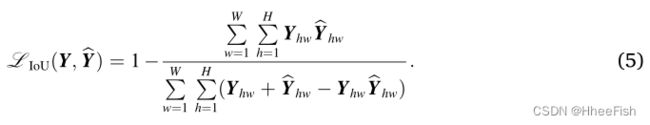

联合交集(IoU)是一种广泛应用于目标检测和图像分割的评价指标。它测量交集与预测面积和实际面积的并集之比。最近,Rezatofighi等人(2019)探索了将其用于训练损失函数的可能性。IoU损失如下:

由式(5)可知,生成的云掩膜与真实云掩膜的重叠面积之比越大,则lou值越小。LIoU作为图像级的损失函数,从整体的角度对网络进行优化,达到更好的效果。

双级(DL)损失函数L DL通过结合二值交叉熵(BCE)损失LBCE和交集over union (IoU)损失LIoU来保持像素级和图像级的监督。DL损失LDL如下所示:

![]()

其中λ1和λ2表示相应损失函数的权值。

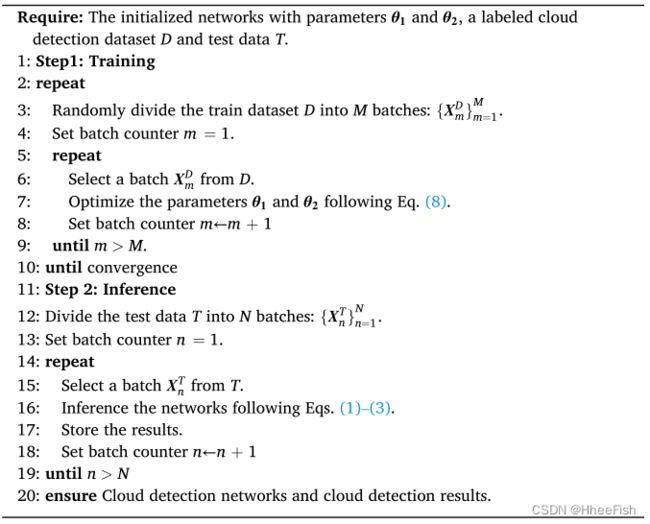

基于DL损失,我们构造了分布的整体监督方式的整体损失函数,如第4.2节所示。分布式监控为两网各关键部位提供监控信息。我们对图6和图9所示的关键部分生成的云掩码提供监督信息。从n=1到n=5的每个关键部分都使用一个1×1的卷积来降维,并使用一个双线性插值层进行尺度扩展来生成一个即时云掩膜。通过总结各关键环节的损失来实施整体监督,进行全面训练。得到总体损失函数L总体如下:

式中,N为重点部分监督次数。Y∧(n)表示关键部分n生成的中间云掩码。

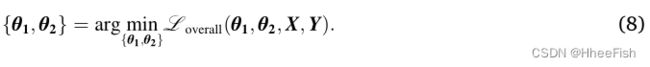

特别地,我们使用Loverall训练边界网,并使用以下公式更新网络参数:

算法1,我们给出了关于边界网的更多细节。

4.4. 优化

我们使用自适应运动估计(Adam)优化器(Kingma and Ba, 2014),它可以最小化网络结果和地面真相之间的差异。我们设置超参数为β1 = 0.9, β2 = 0.999, ε = 10−8。初始学习率为10−6。每组实验,我们训练了200个epoch来得到最终的结果。

5.云检测

6.总结

在本文中,我们提出了一个由粗到细的云检测框架,即边界网,它由可伸缩边界网和可微边界网组成。可缩放边界网从光学图像生成多尺度云掩模。它可以检测不同边界尺度的云。可微边界网通过学习差异来细化多尺度云掩码的边界。它增强了云的边界,很容易在云遮罩中产生模糊。两个网络的结果被融合在一起来产生整体的云掩码。开发了一种分布式的、全面的监督方式来培训边界网。在边界网的训练中,验证了新的监督方式的有效性和效率。实验结果表明,在大多数情况下,该方法在精度评估、云量估算精度评估和目视比较等方面优于其他先进方法。

参考文献

Badrinarayanan, V., Kendall, A., Cipolla, R., 2017. Segnet: A deep convolutional encoder- decoder architecture for image segmentation. IEEE Trans. Pattern Anal. Machine Intell. 39 (12), 2481–2495.

Boluwade, A., 2020. Remote sensed-based rainfall estimations over the east and west africa regions for disaster risk management. ISPRS J. Photogram. Remote Sens. 167, 305–320. URL https://www.sciencedirect.com/science/article/pii/S0924271 620302021.

Chen, L.-C., Papandreou, G., Kokkinos, I., Murphy, K., Yuille, A.L., 2017. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs. IEEE Trans. Pattern Anal. Machine Intell. 40 (4), 834–848.

Foga, S., Scaramuzza, P.L., Guo, S., Zhu, Z., Dilley Jr, R.D., Beckmann, T., Schmidt, G.L., Dwyer, J.L., Hughes, M.J., Laue, B., 2017. Cloud detection algorithm comparison and validation for operational landsat data products. Remote Sens. Environ. 194, 379–390.

Guo, J., Yang, J., Yue, H., Tan, H., Hou, C., Li, K., 2020. Cdnetv2: Cnn-based cloud detection for remote sensing imagery with cloud-snow coexistence. IEEE Trans. Geosci. Remote Sens. 59 (1), 700–713.

Han, L., Li, P., Plaza, A., Ren, P., 2021. Hashing for localization (hfl): A baseline for fast localizing objects in a large-scale scene. IEEE Trans. Geosci. Remote Sens. 1–16.

He, K., Zhang, X., Ren, S., Sun, J., 2016. Deep residual learning for image recognition. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. pp. 770–778.

He, Q., Sun, X., Yan, Z., Fu, K., 2021. DABNet: Deformable Contextual and Boundary- Weighted Network for Cloud Detection in Remote Sensing Images. IEEE Trans. Geosci. Remote Sens. 1–16.

Holzman, M.E., Carmona, F., Rivas, R., Nicl`os, R., 2018. Early assessment of crop yield from remotely sensed water stress and solar radiation data. ISPRS J. Photogramm. Remote Sens. 145, 297–308 sI: Latin America Issue. URL: https://www.sciencedirec t.com/science/article/pii/S0924271618300790.

Hu, J., Shen, L., Sun, G., 2018a. Squeeze-and-excitation networks. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. pp. 7132–7141.

Hu, X., Wang, Y., Shan, J., 2015. Automatic recognition of cloud images by using visual saliency features. IEEE Geosci. Remote Sens. Lett. 12 (8), 1760–1764.

Hu, Y., Dong, Y., Batunacun, 2018b. An automatic approach for land-change detection and land updates based on integrated ndvi timing analysis and the cvaps method with gee support. ISPRS J. Photogramm. Remote Sens. 146, 347–359. URL https:// www.sciencedirect.com/science/article/pii/S0924271618302867.

Hughes, M.J., Hayes, D.J., 2014. Automated detection of cloud and cloud shadow in single-date landsat imagery using neural networks and spatial post-processing. Remote Sens. 6 (6), 4907–4926.

Jeppesen, J.H., Jacobsen, R.H., Inceoglu, F., Toftegaard, T.S., 2019. A cloud detection algorithm for satellite imagery based on deep learning. Remote Sens. Environ. 229, 247–259.

Joshi, P.P., Wynne, R.H., Thomas, V.A., 2019. Cloud detection algorithm using svm with swir2 and tasseled cap applied to landsat 8. Int. J. Appl. Earth Obs. Geoinf. 82, 101898.

Kingma, D.P., Ba, J., 2014. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980.

Kriebel, K.-T., Gesell, G., Ka Stner, M., Mannstein, H., 2003. The cloud analysis tool apollo: improvements and validations. Int. J. Remote Sens. 24 (12), 2389–2408.

LeCun, Y., Bottou, L., Bengio, Y., Haffner, P., 1998. Gradient-based learning applied to document recognition. Proc. IEEE 86 (11), 2278–2324.

Li, Z., Shen, H., Cheng, Q., Liu, Y., You, S., He, Z., 2019. Deep learning based cloud detection for medium and high resolution remote sensing images of different sensors. ISPRS J. Photogramm. Remote Sens. 150, 197–212.

Li, Z., Shen, H., Li, H., Xia, G., Gamba, P., Zhang, L., 2017. Multi-feature combined cloud and cloud shadow detection in gaofen-1 wide field of view imagery. Remote Sens. Environ. 191, 342–358.

Lin, C.-H., Lin, B.-Y., Lee, K.-Y., Chen, Y.-C., 2015. Radiometric normalization and cloud detection of optical satellite images using invariant pixels. ISPRS J. Photogramm. Remote Sens. 106, 107–117.

Long, J., Shelhamer, E., Darrell, T., 2015. Fully convolutional networks for semantic segmentation. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. pp. 3431–3440.

Lotan, O., Irani, M., 2016. Needle-match: Reliable patch matching under high uncertainty. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. pp. 439–448.

Mohajerani, S., Saeedi, P., 2019. Cloud-net: An end-to-end cloud detection algorithm for landsat 8 imagery. In: IGARSS 2019-2019 IEEE International Geoscience and Remote Sensing Symposium. IEEE, pp. 1029–1032.

Ranftl, R., Bochkovskiy, A., Koltun, V., 2021. Vision transformers for dense prediction. In: Proceedings of the IEEE/CVF International Conference on Computer Vision. pp. 12179–12188.

Rezatofighi, H., Tsoi, N., Gwak, J., Sadeghian, A., Reid, I., Savarese, S., 2019. Generalized intersection over union: A metric and a loss for bounding box regression. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. pp. 658–666.

Ronneberger, O., Fischer, P., Brox, T., 2015. U-net: Convolutional networks for biomedical image segmentation. In: International Conference on Medical Image Computing and Computer-assisted Intervention. Springer, pp. 234–241.

Rossow, W.B., Garder, L.C., 1993. Cloud detection using satellite measurements of infrared and visible radiances for isccp. J. Climate 6 (12), 2341–2369.

Sakamoto, T., 2020. Incorporating environmental variables into a modis-based crop yield estimation method for united states corn and soybeans through the use of a random forest regression algorithm. ISPRS J. Photogramm. Remote Sens. 160, 208–228. URL https://www.sciencedirect.com/science/article/pii/S0924271619303065.

Segal-Rozenhaimer, M., Li, A., Das, K., Chirayath, V., 2020. Cloud detection algorithm for multi-modal satellite imagery using convolutional neural-networks (CNN). Remote Sens. Environ. 237, 111446. URL https://linkinghub.elsevier.com/retrieve /pii/S0034425719304651.

Shen, Y., Ji, R., Wang, Y., Chen, Z., Zheng, F., Huang, F., Wu, Y., 2020. Enabling deep residual networks for weakly supervised object detection. In: European Conference on Computer Vision. Springer, pp. 118–136.

Shi, C., Wang, C., Wang, Y., Xiao, B., 2017. Deep convolutional activations-based features for ground-based cloud classification. IEEE Geosci. Remote Sens. Lett. 14 (6), 816–820.

Sun, X., Wang, B., Wang, Z., Li, H., Li, H., Fu, K., 2021. Research progress on few-shot learning for remote sensing image interpretation. IEEE J. Sel. Top. Appl. Earth Obser. Remote Sens. 14, 2387–2402.

Szegedy, C., Liu, W., Jia, Y., Sermanet, P., Reed, S., Anguelov, D., Erhan, D., Vanhoucke, V., Rabinovich, A., 2015. Going deeper with convolutions. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. pp. 1–9.

Woo, S., Park, J., Lee, J.-Y., Kweon, I.S., 2018. Cbam: Convolutional block attention module. In: Proceedings of the European Conference on Computer Vision (ECCV). pp. 3–19. Wu, Z., Li, J., Wang, Y., Hu, Z., Molinier, M., 2019. Self-attentive generative adversarial network for cloud detection in high resolution remote sensing images. IEEE Geosci. Remote Sens. Lett. 17 (10), 1792–1796.

Xie, F., Shi, M., Shi, Z., Yin, J., Zhao, D., 2017. Multilevel cloud detection in remote sensing images based on deep learning. IEEE J. Sel. Top. Appl. Earth Obser. Remote Sens. 10 (8), 3631–3640.

Yan, J., Wang, L., Song, W., Chen, Y., Chen, X., Deng, Z., 2019. A time-series classification approach based on change detection for rapid land cover mapping. ISPRS J. Photogramm. Remote Sens. 158, 249–262. URL https://www.sciencedirect. com/science/article/pii/S0924271619302400.

Zhang, J., Wang, H., Wang, Y., Zhou, Q., Li, Y., 2021. Deep network based on up and down blocks using wavelet transform and successive multi-scale spatial attention for cloud detection. Remote Sens. Environ. 261, 112483.

Zhang, Y., Rossow, W.B., Lacis, A.A., Oinas, V., Mishchenko, M.I., 2004. Calculation of radiative fluxes from the surface to top of atmosphere based on isccp and other global data sets: Refinements of the radiative transfer model and the input data.

J. Geophys. Res.: Atmosph. 109 (D19). Zhu, Z., Wang, S., Woodcock, C.E., 2015. Improvement and expansion of the fmask algorithm: Cloud, cloud shadow, and snow detection for landsats 4–7, 8, and sentinel 2 images. Remote Sens. Environ. 159, 269–277.

Zhu, Z., Woodcock, C.E., 2012. Object-based cloud and cloud shadow detection in landsat imagery. Remote Sens. Environ. 118, 83–94.