风格迁移篇---U-GAT-IT:图像到图像翻译的无监督生成注意网络

文章目录

- ABSTRACT

-

- 1 INTRODUCTION

- 2 UNSUPERVISED GENERATIVE ATTENTIONAL NETWORKS WITH ADAPTIVE LAYER-INSTANCE NORMALIZATION2.具有自适应层实例归一化的无监督生成注意网络

-

- 2.1 MODEL

-

- 2.1.1 GENERATOR

- 2.1.2 DISCRIMINATOR

- 2.2 LOSS FUNCTION

- 3 EXPERIMENTS

-

- 3.1 BASELINE MODEL

- 3.2 DATASET

- 3.3 EXPERIMENT RESULTS

-

- 3.3.1 CAM ANALYSIS

- 3.3.2 ADALIN ANALYSIS

- 3.3.3 QUALITATIVE EVALUATION

- 3.3.4 QUANTITATIVE EVALUATION

- 4 CONCLUSIONS

- REFERENCES

- A RELATED WORKS

-

- A.1 GENERATIVE ADVERSARIAL NETWORKS

- A.2 IMAGE-TO-IMAGE TRANSLATION

- A.3 CLASS ACTIVATION MAP

- A.4 NORMALIZATION

- B IMPLEMENTATION DETAILS

-

- B.1 NETWORK ARCHITECTURE

- B.2 TRAINING

- C DATASET DETAILS

- D ADDITIONAL EXPERIMENTAL RESULTS

ABSTRACT

我们提出了一种新的无监督图像到图像翻译方法,该方法以端到端的方式结合了新的注意模块和新的可学习归一化函数。注意力模块根据辅助分类器获得的注意力图,引导我们的模型关注区分源域和目标域的更重要区域。与以前基于注意力的方法不能处理域之间的几何变化不同,我们的模型可以转换需要整体变化的图像和需要大形状变化的图像。此外,我们新的AdaLIN(自适应层实例归一化)函数有助于我们的注意力引导模型根据数据集通过学习参数灵活控制形状和纹理的变化量。实验结果表明,与现有的具有固定网络结构和超参数的先进模型相比,该方法具有优越性。我们的代码和数据集可在 https://github.com/taki0112/UGA TIT

和 https://github.com/znxlwm/UGA TIT-

pytorch

1 INTRODUCTION

图像到图像翻译旨在学习在两个不同域内映射图像的函数。由于其广泛的应用,包括图像修复,该主题已获得机器学习和计算机视觉领域研究人员的大量关注(Pathak等人(2014);Iizuka等人(2017)),超分辨率(Dong等人(2016);Kim等人(2016))、着色(Zhang等人(2016;2017))和风格转移(Gatys等人(2016);Huang&Belongie(2017))。当给出配对样本时,可以使用条件生成模型以监督方式训练映射模型(Isola等人(2017);李等人(2017a);Wang等人(2018))或简单回归模型(Larsson等人(2016);Long等人(2015年);张等人(2016))。在没有配对数据可用的无监督环境中,多重工作(Anoosheh等人(2018);Choi等人(2018年);黄等人(2018);Kim等人(2017年);刘等人(2017年);Royer等人(2017年);Taigman等人(2017年);Yi等人(2017年);Zhu等人(2017))成功地使用共享潜在空间(Liu等人(2017)),和循环一致性假设(Kim等人(2017)翻译了图像;朱等人(2017))。这些工作已得到进一步发展,以处理任务的多模态(Huang等人(2018))。

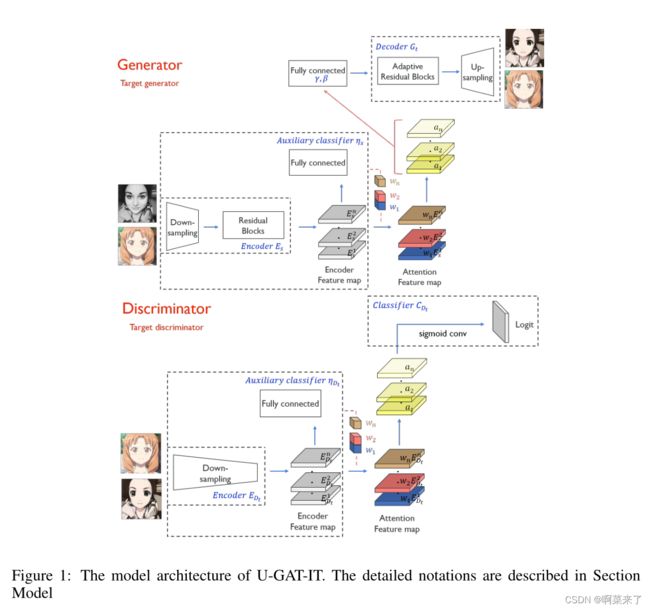

图1:U-GA T-IT的模型架构。详细符号在“模型”一节中描述

尽管有这些进步,以前的方法显示性能差异取决于域之间形状和纹理的变化量。例如,它们成功地用于映射局部纹理的样式转换任务(如photo2vangogh和photo2portrait),但通常不成功地用于野生图像中形状变化较大的图像转换任务(例如selfie2anime和cat2dog)。因此,通常需要图像裁剪和对齐等预处理步骤,以通过限制数据分布的复杂性来避免这些问题(Huang等人(2018);Liu等人(2017))。此外,现有的方法,如DRIT(Lee等人(2018))无法实现通过固定的网络架构和超参数,获得保持形状的图像平移(如horse2zebra)和改变形状的图像变换(如cat2dog)所需的结果。需要针对特定数据集调整网络结构或超参数设置。

在这项工作中,我们提出了一种新的无监督图像到图像翻译方法,该方法以端到端的方式结合了新的注意模块和新的可学习归一化函数。我们的模型通过基于辅助分类器获得的注意力图区分源域和目标域,引导翻译关注更重要的区域而忽略次要区域。这些注意力图嵌入到生成器和鉴别器中,以关注语义上重要的区域,从而促进形状变换。虽然生成器中的注意力图会将注意力集中在具体区分两个域的区域上,但鉴别器中的注意力地图会通过关注目标域中真实图像和虚假图像之间的差异来帮助进行微调。除了注意机制外,我们还发现,对于形状和纹理变化量不同的各种数据集,归一化函数的选择对转换结果的质量有显著影响。受批实例归一化(BIN)(Nam&Kim(2018))的启发,我们提出了自适应层实例归一化(AdaLIN),通过自适应选择实例归一化(IN)和层归一化(LN)之间的适当比例,在训练期间从数据集学习其参数。AdaLIN函数帮助我们的注意力引导模型灵活控制形状和纹理的变化量。因此,我们的模型在不修改模型结构或超参数的情况下,可以执行图像转换任务,不仅需要整体变化,还需要大的形状变化。在实验中,我们展示了与现有最先进的模型相比,该方法在风格转换和对象变形方面的优越性。拟议工作的主要贡献可总结如下:

- 我们提出了一种新的无监督图像到图像翻译方法,该方法使用了新的注意模块和新的归一化函数AdaLIN。

- 我们的注意力模块通过基于辅助分类器获得的注意力图区分源域和目标域,帮助模型知道在哪里进行集中转换。

- AdaLIN函数帮助我们的注意力引导模型灵活控制形状和纹理的变化量,而无需修改模型架构或超参数。

2 UNSUPERVISED GENERATIVE ATTENTIONAL NETWORKS WITH ADAPTIVE LAYER-INSTANCE NORMALIZATION2.具有自适应层实例归一化的无监督生成注意网络

我们的目标是训练一种功能→其仅使用从每个域提取的未配对样本将图像从源域Xs映射到目标域Xt。我们的框架由两个生成器Gs组成→t和Gt→s和两个鉴别器Ds和Dt。我们将注意力模块集成到生成器和鉴别器中。鉴别器中的注意力模块引导生成器聚焦于对生成真实图像至关重要的区域。生成器中的注意力模块关注与其他域不同的区域。在这里,我们只解释Gs→t和Dt(参见图1),反之亦然,应该是直线向前的。

2.1 MODEL

2.1.1 GENERATOR

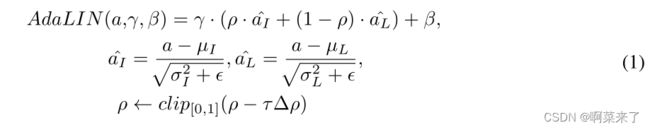

让x∈ {Xs,Xt}表示来自源域和目标域的样本。我们的翻译模型是Gs→t由编码器Es、解码器Gt和辅助分类器ηs组成,其中ηs(x)表示x来自Xs的概率。设Eks(x)是编码器的第k个激活映射,Ekijs(x)为(i,j)处的值。受CAM(Zhou等人(2016))的启发,通过使用全局平均池和全局最大池,即ηs(x)=σ(σkwks∑ijEkijs(x)),训练辅助分类器以学习源域的第k个特征映射的权重,wks。通过利用wks,我们可以计算一组特定于领域的注意力特征图,即(x)=ws∗ Es(x)={wks∗ Eks(x)|1≤k≤n} ,其中n是编码特征映射的数量。然后,我们的翻译模型是Gs→t变得等于Gt(as(x))。受最近在归一化层中使用仿射变换参数并结合归一化函数的工作的启发(Huang&Belongie(2017);Nam&Kim(2018)),我们为剩余块配备了AdaLIN,AdaLIN的参数γ和β由注意力图的全连通层动态计算。

其中µI、µL和σI、σL分别为通道、层平均值和标准偏差,γ和β为全连接层生成的参数,τ为学习率,σ∆ρ表示由优化器确定的参数更新向量(例如梯度)。通过在参数更新步骤施加边界,ρ的值被限制在[0,1]的范围内。生成器调整该值,以便在实例规范化很重要的任务中ρ的值接近1,在LN很重要的工作中ρ值接近0。ρ的值在解码器的剩余块中被初始化为1,在解码器的上采样块中初始化为0。

将内容特征转换为样式特征的最佳方法是应用白化和着色变换(WCT)(Li等人(2017b)),但由于计算协方差矩阵和矩阵逆,计算成本很高。尽管AdaIN(Huang&Belongie(2017))比WCT快得多,但它对WCT来说是次优的,因为它假设特征通道之间不相关。因此,传输的特征包含稍微更多的内容模式。另一方面,LN(Ba et al.(2016))不假设频道之间不相关,但有时,它没有很好地保留原始域的内容结构,因为它只考虑特征图的全局统计。为了克服这一问题,我们提出的归一化技术AdaLIN结合了AdaIN和LN的优点,有选择地保留或更改内容信息,这有助于解决广泛的图像到图像翻译问题。

2.1.2 DISCRIMINATOR

让x∈ {Xt,Gs→t(Xs)}表示来自目标域和翻译源域的样本。与其他翻译模型类似,鉴别器Dt是一个多尺度模型,由编码器EDt、分类器CDt和辅助分类器ηDt组成。与其他翻译模型不同,ηDt(x)和Dt(x)都经过训练,以区分x是来自Xt还是来自Gs→t(Xs)。给定一个样本x,Dt(x)利用注意力特征映射aDt(x)=wDt∗ EDt(x)在由ηDt(x)训练的编码特征映射EDt(x)上使用wDt。然后,我们的鉴别器Dt(x)等于CDt(aDt(x))。

2.2 LOSS FUNCTION

我们模型的全部目标包括四个损失函数。在这里,我们没有使用普通的GAN目标,而是使用最小二乘GAN(Mao等人(2017))目标进行稳定训练。

对抗性损失采用对抗性损失将翻译图像的分布与目标图像分布相匹配:

为了缓解模式崩溃问题,我们对生成器应用了循环一致性约束。给定图像x∈ Xs,在x从Xs到Xt和从Xt到Xs的顺序转换后,图像应成功地转换回原始域:

身份丢失为了确保输入图像和输出图像的颜色分布相似,我们对生成器应用身份一致性约束。给定图像x∈ 在使用Gs翻译x之后→t、 图像不应改变。

通过利用来自辅助分类器ηs和ηDt的信息(给定图像x∈ {Xs,Xt}。Gs→t和Dt了解需要改进的地方,或者在当前状态下两个域之间的最大差异是什么:

全目标最后,我们联合训练编码器、解码器、鉴别器和辅助分类器,以优化最终目标:

其中λ1=1,λ2=10,λ3=10,以及λ4=1000。这里,Llsgan=Ls→tlsgan+Lt→slsgan和其他损失的定义类似(Lcycle、Lidentiy和Lcam)

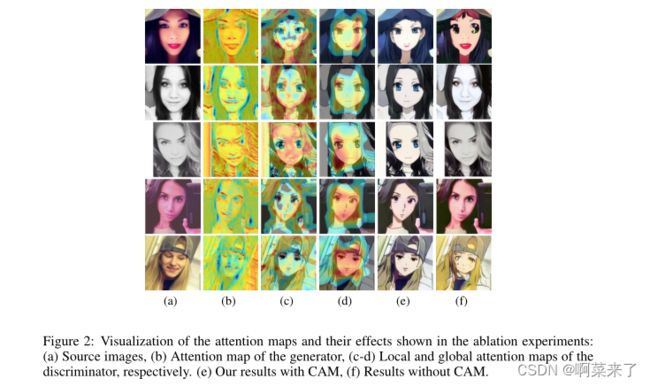

【图2:消融实验中注意力图及其效果的可视化:(a)源图像,(b)发生器的注意力图,(c-d)鉴别器的局部和全局注意力图。(e) 我们使用CAM的结果,(f)没有CAM的结果。】

3 EXPERIMENTS

3.1 BASELINE MODEL

我们将我们的方法与各种模型进行了比较,包括CycleGAN(Zhu等人(2017))、UNIT(Liu等人(2017)”、MUNIT(Huang等人(2018))、DRIT(Lee等人(2018)”、AGGAN(Mejjati等人(2018))和Cartongan(Chen等人(2018))。所有基线方法都是使用作者的代码实现的。

3.2 DATASET

我们使用五个未配对的图像数据集(包括四个代表性图像翻译数据集)和一个新创建的数据集(由真实照片和动画艺术品组成),即selfie2anime,评估了每种方法的性能。所有图像的大小都调整为256 x 256以进行训练。关于我们实验的每个数据集,请参见附录C。

3.3 EXPERIMENT RESULTS

我们首先分析了注意模块和AdaLIN在所提出模型中的作用。然后,我们将我们的模型的性能与上一节列出的其他无监督图像翻译模型进行比较。为了评估翻译图像的视觉质量,我们进行了一项用户研究。要求用户从五种不同方法生成的图像中选择最佳图像。补充材料中包含了更多将我们的模型与其他模型进行比较的结果示例。

3.3.1 CAM ANALYSIS

首先,我们进行了一项消融研究,以确认发生器和鉴别器中使用的注意力模块的益处。如图2(b)所示,注意力特征图有助于生成器将注意力集中在与目标域更具区分性的源图像区域,如眼睛和嘴巴。同时,我们可以看到鉴别器集中注意力的区域,通过可视化目标图像的局部和全局注意力图来确定目标图像是真是假 分别如图2(c)和(d)所示的鉴别器。生成器可以使用这些注意力图微调鉴别器关注的区域。注意,我们合并了来自两个具有不同大小感受野的鉴别器的全局和局部注意力图。这些贴图可以帮助生成器捕捉全局结构(例如面部区域和眼睛附近)以及局部区域。有了这些信息,一些区域的翻译会更加小心。图2(e)所示的注意力模块的结果验证了在图像翻译任务中利用注意力特征图的有利效果。另一方面,在没有使用注意模块的情况下,可以看到眼睛错位,或者根本没有在结果中进行平移,如图2(f)所示。

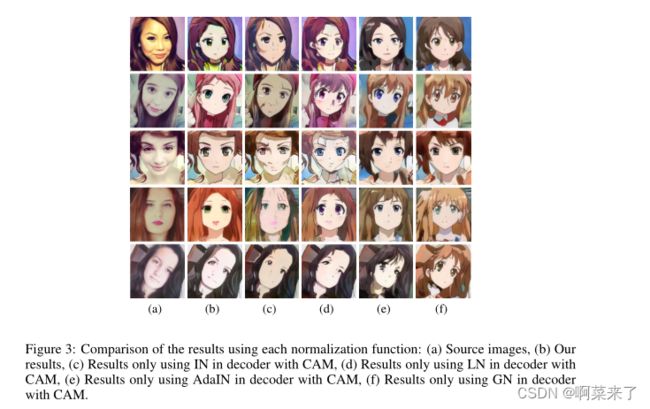

【图3:使用每个归一化函数的结果比较:(a)源图像,(b)我们的结果,(c)仅使用带CAM的IN-IN解码器的结果,(d)仅使用带有CAM的LN-IN解码器结果,(e)仅使用AdaIN-IN解码器和CAM的结果,(f)仅使用GN-IN解码器与CAM的结果。】

3.3.2 ADALIN ANALYSIS

如附录B所述,我们仅将AdaLIN应用于生成器的解码器。解码器中残差块的作用是嵌入特征,而解码器中上采样卷积块的作用则是从嵌入特征生成目标域图像。如果门参数ρ的学习值接近1,则意味着相应层更多地依赖于IN而不是LN。同样,如果ρ的学习值接近0,则意味着相应层更多地依赖于LN而不是IN。如图3(c)所示,在仅在解码器中使用的情况下,源域的特征(例如,颧骨周围的耳环和阴影)由于在剩余块中使用的按通道归一化的特征统计而得到很好的保留。然而,转换到目标域样式的量有些不足,因为全局样式不能被上采样卷积块的IN捕获。另一方面,如图3(d)所示,如果我们在解码器中仅使用LN,则通过上采样卷积中使用的分层归一化特征统计,可以充分传输目标域样式。但是通过在残差块中使用LN,源域图像的特征保留较少。对两种极端情况的分析告诉我们,在特征表示层中更多地依赖IN而不是LN来保留源域的语义特征是有益的,而对于实际从特征嵌入生成图像的上采样层,情况正好相反。因此,在无监督图像到图像翻译任务中,所提出的根据源和目标域分布调整解码器中IN和LN比率的AdaLIN更为可取。此外,图3(e)、(f)分别是使用AdaIN和群归一化(GN)的结果(Wu&He(2018)),与这些方法相比,我们的方法显示出更好的结果。

【图4:五个数据集的视觉比较。自上而下:selfie2anime、horse2zebra、cat2dog、photo2portrait和photo2vangogh。(a) 源图像,(b)U-GAT-IT,(c)CycleGAN,(d)UNIT,(e)MUNIT,(f)DRIT,(g)AGGAN】

【表1:核起始距离×100±标准。×100用于我们的模型。越低越好。有一些符号;GN:群归一化,G凸轮:生成器的凸轮,D凸轮:鉴别器的凸轮】

此外,如表1所示,我们通过使用内核起始距离(KID)的消融研究,证明了selfie2anime数据集中注意力模块和阿达林的性能(Binkowski等人(2018))。我们的模型实现了最低的KID值。即使注意力模块和AdaLIN单独使用,我们也可以看到我们的模型比其他模型表现得更好。然而,当一起使用时,性能甚至更好。

3.3.3 QUALITATIVE EVALUATION

对于定性评估,我们还进行了感性研究。向135名参与者展示了不同方法的翻译结果,包括针对源图像提出的方法,并要求他们选择到目标域的最佳翻译图像。我们只向参与者通知目标域的名称,即动画、狗和斑马。但是,为肖像和梵高数据集提供了一些目标域的示例图像,作为确保正确判断的最小信息。表2显示,除了photo2vangogh外,所提出的方法获得了显著更高的分数,但与其他方法相比,在人类感知研究中具有可比性。在图4中,我们给出了每种方法的图像转换结果,用于性能比较。U-GA T-IT通过更多地关注源之间的不同区域,可以生成无失真图像并且通过利用注意力模块来识别目标域。请注意,在CycleGAN的结果中,两条斑马的头部或狗的眼睛周围的区域被扭曲。此外,使用U-GA T-IT的翻译结果在视觉上优于其他方法,同时保留了源域的语义特征。值得注意的是,MUNIT和DRIT的结果与源图像非常不同,因为它们生成的图像具有随机样式代码以实现多样性。此外,应该强调的是,U-GA和T-it对所有五个不同的数据集应用了相同的网络架构和超参数,而其他算法则使用预设网络或超参数进行训练。通过用户研究的结果,我们表明我们的注意力模块和AdaLIN的结合使我们的模型更加灵活。

【表2:用户研究对翻译图像的偏好得分。】

【表3:核起始距离×100±标准。×100表示差分图像转换模式。越低越好。】

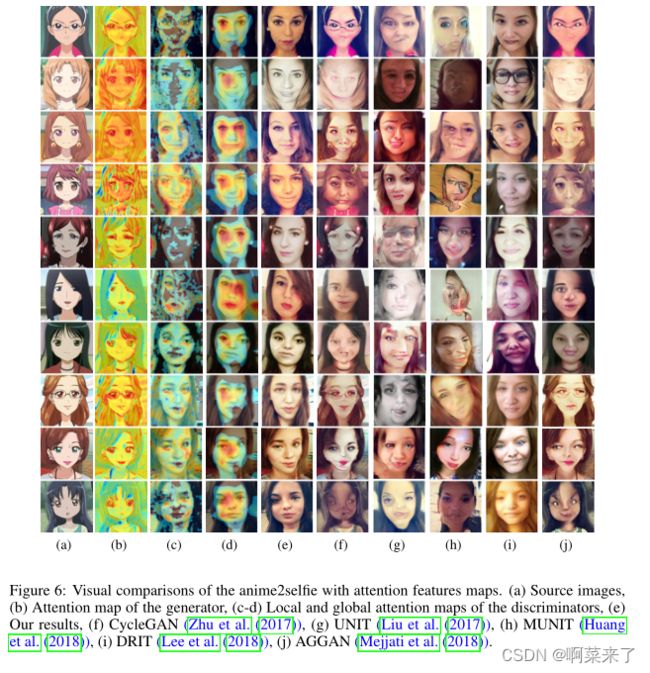

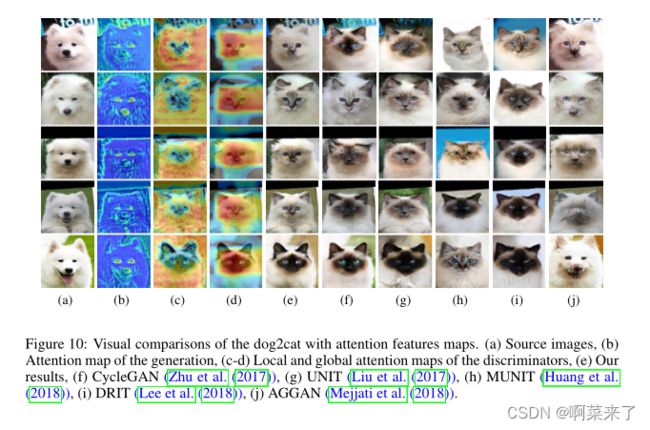

3.3.4 QUANTITATIVE EVALUATION

对于定量评估,我们使用最近提出的KID,它计算真实图像和生成图像的特征表示之间的平方最大均值差异。从初始网络中提取特征表示(Szegedy等人(2016))。与Frchet初始距离相比(Heusel等人(2017)),KID具有无偏估计器,这使其更加可靠,尤其是当测试图像少于初始特征的维数时。越低的孩子表明真实图像和生成图像之间的视觉相似性越高(Mejjati等人(2018))。因此,如果翻译得好,这个孩子在几个数据集中的价值很小。表3显示,除了风格转换任务,如photo2vangogh和photo2portrait,所提出的方法获得了最低的儿童分数。然而,与最低分数没有太大差异。此外,与UNIT和MUNIT不同,我们可以看到源→ 目标,目标→ 源代码翻译都是稳定的。U-GA T-IT显示出比最近基于注意力的方法AGGAN更低的KID。与U-GAT-IT不同的是,AGGAN在形状变化(如dog2cat和anime2selfie)的转换中表现不佳,U-GAT-IT的注意力模块重点不在于区分背景和前景,而在于区分背景与前景之间两个域的差异。如补充资料所示,卡通安只将图像的整体颜色改为动画风格,但与自拍相比,作为动画最大特征的眼睛一点也没有改变。因此,卡通安的孩子更高。

4 CONCLUSIONS

在本文中,我们提出了无监督图像到图像翻译(U-GA T-IT),使用注意模块和AdaLIN,可以在具有固定网络结构和超参数的各种数据集中产生更直观的结果。对各种实验结果的详细分析支持我们的假设,即通过辅助分类器获得的注意力图可以引导生成器更多地关注源域和目标域之间的不同区域。此外,我们还发现,自适应层实例规范化(AdaLIN)对于转换包含不同数量几何体和样式变化的各种数据集至关重要。通过实验,我们证明了与现有的基于GAN的无监督图像到图像翻译任务模型相比,该方法的优越性。

REFERENCES

Asha Anoosheh, Eirikur Agustsson, Radu Timofte, and Luc V an Gool. Combogan: Unrestrained

scalability for image domain translation. In Proceedings of the IEEE Conference on Computer

Vision and Pattern Recognition Workshops, pp. 783–790, 2018.

Martin Arjovsky, Soumith Chintala, and Léon Bottou. Wasserstein generative adversarial networks.

In International Conference on Machine Learning, pp. 214–223, 2017.

Jimmy Lei Ba, Jamie Ryan Kiros, and Geoffrey E Hinton. Layer normalization. arXiv preprint

arXiv:1607.06450, 2016.

David Berthelot, Tom Schumm, and Luke Metz. Began: Boundary equilibrium generative adversar-

ial networks. arXiv preprint arXiv:1703.10717, 2017.

Mikołaj Bi´nkowski, Dougal J. Sutherland, Michael Arbel, and Arthur Gretton. Demystifying

MMD GANs. In International Conference on Learning Representations, 2018. URL https:

//openreview.net/forum?id=r1lUOzWCW.

Y ang Chen, Y u-Kun Lai, and Y ong-Jin Liu. Cartoongan: Generative adversarial networks for photo

cartoonization. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recog-

nition, pp. 9465–9474, 2018.

Y unjey Choi, Minje Choi, Munyoung Kim, Jung-Woo Ha, Sunghun Kim, and Jaegul Choo. Star-

gan: Unified generative adversarial networks for multi-domain image-to-image translation. In

Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 8789–

8797, 2018.

Chao Dong, Chen Change Loy, Kaiming He, and Xiaoou Tang. Image super-resolution using deep

convolutional networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 38(2):

295–307, 2016.

Vincent Dumoulin, Jonathon Shlens, and Manjunath Kudlur. A learned representation for artis-

tic style. In International Conference on Learning Representations, 2017. URL https:

//openreview.net/forum?id=BJO-BuT1g.

Leon A Gatys, Alexander S Ecker, and Matthias Bethge. Image style transfer using convolutional

neural networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recog-

nition, pp. 2414–2423, 2016.

Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair,

Aaron Courville, and Y oshua Bengio. Generative adversarial nets. In Advances in Neural Infor-

mation Processing Systems, pp. 2672–2680, 2014.

9

Published as a conference paper at ICLR 2020

Martin Heusel, Hubert Ramsauer, Thomas Unterthiner, Bernhard Nessler, and Sepp Hochreiter.

Gans trained by a two time-scale update rule converge to a local nash equilibrium. In Advances

in Neural Information Processing Systems, pp. 6626–6637, 2017.

Xun Huang and Serge Belongie. Arbitrary style transfer in real-time with adaptive instance nor-

malization. In Proceedings of the IEEE International Conference on Computer Vision, pp. 1501–

1510, 2017.

Xun Huang, Ming-Y u Liu, Serge Belongie, and Jan Kautz. Multimodal unsupervised image-to-

image translation. In Proceedings of the European Conference on Computer Vision, pp. 172–189,

2018.

Satoshi Iizuka, Edgar Simo-Serra, and Hiroshi Ishikawa. Globally and locally consistent image

completion. ACM Transactions on Graphics, 36(4):107, 2017.

Phillip Isola, Jun-Y an Zhu, Tinghui Zhou, and Alexei A Efros. Image-to-image translation with

conditional adversarial networks. In Proceedings of the IEEE Conference on Computer Vision

and Pattern Recognition, pp. 1125–1134, 2017.

Tero Karras, Timo Aila, Samuli Laine, and Jaakko Lehtinen. Progressive growing of gans for im-

proved quality, stability, and variation. In International Conference on Learning Representations,

2018. URL https://openreview.net/forum?id=Hk99zCeAb.

Jiwon Kim, Jung Kwon Lee, and Kyoung Mu Lee. Accurate image super-resolution using very deep

convolutional networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern

Recognition, pp. 1646–1654, 2016.

Taeksoo Kim, Moonsu Cha, Hyunsoo Kim, Jung Kwon Lee, and Jiwon Kim. Learning to discover

cross-domain relations with generative adversarial networks. In Proceedings of the International

Conference on Machine Learning, pp. 1857–1865, 2017. URL http://proceedings.mlr.

press/v70/kim17a.html.

Diederik P . Kingma and Jimmy Ba. Adam: A method for stochastic optimization. In International

Conference on Learning Representations, 2015. URL http://arxiv.org/abs/1412.

6980.

Gustav Larsson, Michael Maire, and Gregory Shakhnarovich. Learning representations for auto-

matic colorization. In Proceedings of the European Conference on Computer Vision, pp. 577–593.

Springer, 2016.

Hsin-Ying Lee, Hung-Y u Tseng, Jia-Bin Huang, Maneesh Singh, and Ming-Hsuan Y ang. Diverse

image-to-image translation via disentangled representations. In Proceedings of the European

Conference on Computer Vision, pp. 35–51, 2018.

Chunyuan Li, Hao Liu, Changyou Chen, Y uchen Pu, Liqun Chen, Ricardo Henao, and Lawrence

Carin. Alice: Towards understanding adversarial learning for joint distribution matching. In

Advances in Neural Information Processing Systems, pp. 5501–5509, 2017a.

Yijun Li, Chen Fang, Jimei Y ang, Zhaowen Wang, Xin Lu, and Ming-Hsuan Y ang. Universal style

transfer via feature transforms. In Advances in Neural Information Processing Systems, pp. 386–

396, 2017b.

Ming-Y u Liu, Thomas Breuel, and Jan Kautz. Unsupervised image-to-image translation networks.

In Advances in Neural Information Processing Systems, pp. 700–708, 2017.

Jonathan Long, Evan Shelhamer, and Trevor Darrell. Fully convolutional networks for semantic seg-

mentation. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,

pp. 3431–3440, 2015.

Xudong Mao, Qing Li, Haoran Xie, Raymond YK Lau, Zhen Wang, and Stephen Paul Smolley.

Least squares generative adversarial networks. In Proceedings of the IEEE International Confer-

ence on Computer Vision, pp. 2813–2821. IEEE, 2017.

10

Published as a conference paper at ICLR 2020

Y oussef Alami Mejjati, Christian Richardt, James Tompkin, Darren Cosker, and Kwang In Kim.

Unsupervised attention-guided image-to-image translation. In Advances in Neural Information

Processing Systems, pp. 3697–3707, 2018.

Takeru Miyato, Toshiki Kataoka, Masanori Koyama, and Y uichi Y oshida. Spectral normalization

for generative adversarial networks. In International Conference on Learning Representations,

2018. URL https://openreview.net/forum?id=B1QRgziT-.

Hyeonseob Nam and Hyo-Eun Kim. Batch-instance normalization for adaptively style-invariant

neural networks. In Advances in Neural Information Processing Systems, pp. 2563–2572, 2018.

Deepak Pathak, Philipp Krahenbuhl, Jeff Donahue, Trevor Darrell, and Alexei A Efros. Context

encoders: Feature learning by inpainting. In Proceedings of the IEEE Conference on Computer

Vision and Pattern Recognition, pp. 2536–2544, 2014.

Amélie Royer, Konstantinos Bousmalis, Stephan Gouws, Fred Bertsch, Inbar Moressi, Forrester

Cole, and Kevin Murphy. Xgan: Unsupervised image-to-image translation for many-to-many

mappings. arXiv preprint arXiv:1711.05139, 2017.

Christian Szegedy, Vincent V anhoucke, Sergey Ioffe, Jon Shlens, and Zbigniew Wojna. Rethink-

ing the inception architecture for computer vision. In Proceedings of the IEEE Conference on

Computer Vision and Pattern Recognition, pp. 2818–2826, 2016.

Y aniv Taigman, Adam Polyak, and Lior Wolf. Unsupervised cross-domain image generation. In

International Conference on Learning Representations, 2017. URL https://openreview.

net/forum?id=Sk2Im59ex.

Ting-Chun Wang, Ming-Y u Liu, Jun-Y an Zhu, Andrew Tao, Jan Kautz, and Bryan Catanzaro. High-

resolution image synthesis and semantic manipulation with conditional gans. In Proceedings of

the IEEE Conference on Computer Vision and Pattern Recognition, pp. 8798–8807, 2018.

Y uxin Wu and Kaiming He. Group normalization. In Proceedings of the European Conference on

Computer Vision, September 2018.

Zili Yi, Hao Zhang, Ping Tan, and Minglun Gong. Dualgan: Unsupervised dual learning for image-

to-image translation. In Proceedings of the IEEE International Conference on Computer Vision,

pp. 2849–2857, 2017.

Richard Zhang, Phillip Isola, and Alexei A Efros. Colorful image colorization. In Proceedings of

the European Conference on Computer Vision, pp. 649–666. Springer, 2016.

Richard Zhang, Jun-Y an Zhu, Phillip Isola, Xinyang Geng, Angela S. Lin, Tianhe Y u, and Alexei A.

Efros. Real-time user-guided image colorization with learned deep priors. ACM Transactions on

Graphics, 36(4):119:1–119:11, 2017. doi: 10.1145/3072959.3073703. URL https://doi.

org/10.1145/3072959.3073703.

Junbo Jake Zhao, Michaël Mathieu, and Y ann LeCun. Energy-based generative adversarial net-

works. In International Conference on Learning Representations, 2017. URL https://

openreview.net/forum?id=ryh9pmcee.

Bolei Zhou, Aditya Khosla, Agata Lapedriza, Aude Oliva, and Antonio Torralba. Learning deep

features for discriminative localization. In Proceedings of the IEEE Conference on Computer

Vision and Pattern Recognition, pp. 2921–2929. IEEE, 2016.

Jun-Y an Zhu, Taesung Park, Phillip Isola, and Alexei A Efros. Unpaired image-to-image translation

using cycle-consistent adversarial networks. In Proceedings of the IEEE International Conference

on Computer Vision, pp. 2223–2232, 2017.

A RELATED WORKS

A.1 GENERATIVE ADVERSARIAL NETWORKS

生成性对抗网络(GAN)(Goodfello等人(2014))在各种图像生成方面取得了令人印象深刻的成果(Arjovsky等人(2017);Berthelot等人(2017年);Karras等人(2018年);赵等人(2017)),图像修复(Iizuka等人(2017))和图像翻译(Choi等人(2018);黄等人(2018);伊索拉等人(2017年);刘等人(2017年);王等人(2018);朱等人(2017))任务。在训练中,生成器旨在生成真实图像以愚弄鉴别器,而鉴别器试图将生成的图像与真实图像区分开来。多种多阶段生成模型(Karras等人(2018年);Wang等人(2018))和更好的培训目标(Arjovsky等人(2017);Berthelot等人(2017年);Mao等人(2017年);Zhao等人(2017))已被提议生成更逼真的图像。在本文中,我们的模型使用GAN来学习在给定未配对训练数据的情况下从源域到显著不同的目标域的转换。

A.2 IMAGE-TO-IMAGE TRANSLATION

Isola等人(Isola et al.(2017))提出了一种基于条件GAN的图像到图像翻译统一框架。Wang等人(Wang等人,(2018))提出了pix2pix的高分辨率版本,最近进行了各种尝试(Huang等人(2018);Kim等人(2017年);刘等人(2017年);Taigman等人(2017年);Zhu等人(2017))从未配对数据集学习图像翻译。CycleGAN(Zhu等人(2017))首次提出了循环一致性损失,以实施一对一映射。UNIT(Liu等人(2017))假设共享潜在空间来处理无监督图像翻译。然而,只有当两个域具有相似的模式时,这种方法才能很好地执行。MUNIT(Huang et al.(2018))通过将图像分解为域不变的内容代码和捕获特定于域的属性的样式代码,可以扩展到多对多映射。MUNIT合成分离的内容和风格以生成最终图像,通过使用自适应实例归一化提高图像质量(Huang&Belongie(2017))。出于与MUNIT相同的目的,DRIT(Lee等人(2018))将图像分解为内容和风格,从而实现多对多映射。唯一的区别是,使用作为辅助分类器的权重共享和内容鉴别器在两个域之间共享内容空间。然而,这些方法的性能(Huang等人(2018);刘等人(2017年);Lee等人(2018))仅限于包含源域和目标域之间良好对齐的图像的数据集。此外,AGGAN(Mejjati等人(2018))通过使用注意机制区分前景和背景,提高了图像翻译的性能。然而,AGGAN中的注意力模块无法帮助变换图像中对象的形状。尽管卡通安(Chen et al.(2018))在动画风格翻译方面表现良好,但它仅改变图像中线条的颜色、色调和厚度。因此,不适合图像中的形状变化。

A.3 CLASS ACTIVATION MAP

Zhou等人(Zhou et al.(2016))提出了使用CNN中的全局平均池的类激活图(CAM)。特定类别的CAM通过CNN显示鉴别图像区域以确定该类别。在这项工作中,我们的模型导致通过使用CAM方法区分两个域而提供的区分图像区域发生剧烈变化。然而,不仅使用了全局平均池,还使用了全局最大池来改善结果。

A.4 NORMALIZATION

最近的神经风格转换研究表明,CNN特征统计(例如,Gram矩阵(Gatys et al.(2016))、均值和方差(Huang&Belongie(2017))可以用作图像风格的直接描述符。特别是,实例归一化(In)具有通过直接归一化图像的特征统计信息来消除样式变化的效果,并且在样式转换中比批量归一化(BN)或层归一化(LN)更常用。然而,在对图像进行归一化时,最近的研究使用了自适应实例归一化(AdaIN)(Huang&Belongie(2017))、条件实例归一化(CIN)(Dumoulin等人(2017))和批量实例归一化(BIN)(Nam&Kim(2018))而不是单独使用IN。在我们的工作中,我们提出了一种自适应实例归一化(AdaLIN)函数,以自适应地选择IN和LN之间的适当比率。通过AdaLIN,我们的注意力引导模型可以灵活地控制形状和纹理的变化量。

B IMPLEMENTATION DETAILS

B.1 NETWORK ARCHITECTURE

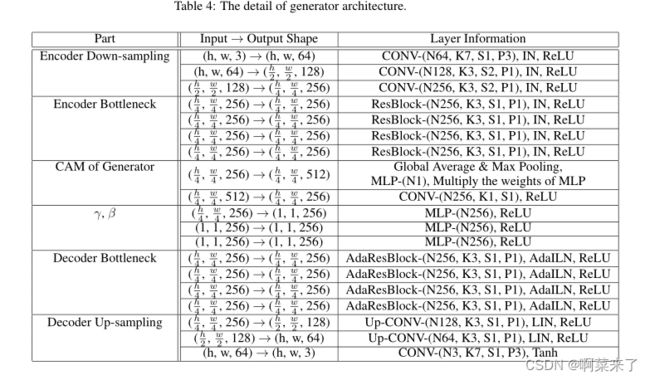

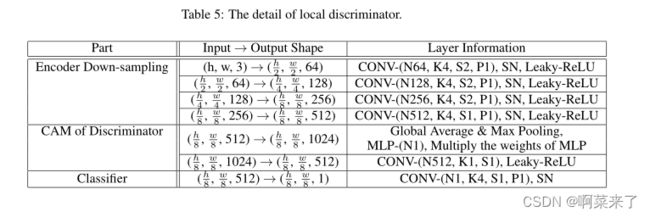

U-GA T-IT的网络架构如表4、5和6所示。生成器的编码器由两个卷积层组成,步长为2,用于下采样和四个残差块。生成器的解码器由四个残差块和两个步长为1的上采样卷积层组成。请注意,我们分别对编码器和解码器使用实例规范化。一般而言,LN在分类问题上的表现并不比批量归一化更好(Wu&He(2018))。由于辅助分类器从生成器中的编码器连接,为了提高辅助分类器的精度,我们使用实例归一化(小批量大小为1的批量归一化)而不是AdaLIN。频谱归一化(Miyato等人(2018))用于鉴别器。我们采用两种不同尺度的PatchGAN(Isola等人(2017))作为鉴别器网络,该网络将局部(70 x 70)和全局(286 x 286)图像块分为真实或虚假。对于激活函数,我们在生成器中使用ReLU,在鉴别器中使用斜率为0.2的泄漏ReLU。

B.2 TRAINING

所有模型都使用Adam(Kingma&Ba(2015))进行训练,β1=0.5,β2=0.999。为了增加数据,我们以0.5的概率水平翻转图像,将其大小调整为286 x 286,并将其随机剪切为256 x 256。所有实验的批量大小都设置为1。我们以0.0001的固定学习率训练所有模型,直到500000次迭代,并线性衰减到1000000次迭代。我们还使用0.0001的权重衰减率。权重由零中心正态分布初始化,标准偏差为0.02。

C DATASET DETAILS

selfie2anime自拍数据集包含46836张自拍图像,带有36种不同属性的注释。我们只使用女性的照片作为训练数据和测试数据。训练数据集的大小为3400,测试数据集的尺寸为100,图像大小为256 x 256。对于动画数据集,我们首先从anime-Planet1中检索了69926个动画角色图像。在这些图像中,使用动画人脸检测器2提取了27023个人脸图像。在仅选择女性角色图像并手动移除单色图像后,我们收集了两组女性动画人脸图像数据集,大小分别为3400和100,用于训练和测试数据,与自拍数据集的数字相同。最后,通过应用基于CNN的图像超分辨率算法3,将所有动画人脸图像的大小调整为256 x 256。

horse2zebra和photo2vangogh这些数据集用于CycleGAN(Zhu等人(2017))。每个类别的训练数据集大小:1067(马)、1334(斑马)、6287(照片)和400(vangogh)。测试数据集包括120(马)、140(斑马)、751(照片)和400(万戈)。请注意,vangogh类的训练数据和测试数据是相同的。

cat2dog和photo2portrait这些数据集用于DRIT(Lee等人(2018))。每个类别的数据数量分别为871(cat)、1364(斑马)、6452(照片)和1811(vangogh)。我们分别使用120(马)、140(斑马)、751(照片)和400(vangogh)随机选择的图像作为测试数据。

D ADDITIONAL EXPERIMENTAL RESULTS

除了本文中给出的结果外,我们还在图5、6、7、8、9、10、11和12中显示了五个数据集的补充生成结果。

[图5:selfie2anime与注意力特征图的视觉比较。(a) 源图像,(b)生成器的注意力图,(c-d)鉴别器的局部和全局注意力图,(e)我们的结果,(f)CycleGAN(Zhu等人(2017)),(g)UNIT(Liu等人(2017)”,(h)MUNIT(Huang等人(2018)),(i)DRIT(Lee等人(2018)],(j)AGGAN(Mejjati等人(2018))和(k)Cartongan(Chen等人(2018))。]

[ 图6:anime2selfie与注意力特征图的视觉比较。(a) 源图像,(b)生成器的注意力图,(c-d)鉴别器的局部和全局注意力图,(e)我们的结果,(f)CycleGAN(Zhu等人(2017)),(g)UNIT(Liu等人(2017)”,(h)MUNIT(Huang等人(2018)),(i)DRIT(Lee等人(2018))和(j)AGGAN(Mejjati等人(2018))。]

图7:马斑马与注意力特征图的视觉比较。(a) 源图像,(b)生成器的注意力图,(c-d)鉴别器的局部和全局注意力图,(e)我们的结果,(f)CycleGAN(Zhu等人(2017)),(g)UNIT(Liu等人(2017)”,(h)MUNIT(Huang等人(2018)),(i)DRIT(Lee等人(2018))和(j)AGGAN(Mejjati等人(2018))。

图8:斑马马与注意力特征图的视觉比较。(a) 源图像,(b)生成器的注意力图,(c-d)鉴别器的局部和全局注意力图,(e)我们的结果,(f)CycleGAN(Zhu等人(2017)),(g)UNIT(Liu等人(2017)”,(h)MUNIT(Huang等人(2018)),(i)DRIT(Lee等人(2018))和(j)AGGAN(Mejjati等人(2018))。

[ 图9:cat2dog与注意力特征图的视觉比较。(a) 源图像,(b)一代人的注意力图,(c-d)鉴别器的局部和全局注意力图,(e)我们的结果,(f)CycleGAN(Zhu等人(2017)),(g)UNIT(Liu等人(2017)”,(h)MUNIT(Huang等人(2018)),(i)DRIT(Lee等人(2018))和(j)AGGAN(Mejjati等人(2018))。]

图10:dog2cat与注意力特征图的视觉比较。(a) 源图像,(b)一代人的注意力图,(c-d)鉴别器的局部和全局注意力图,(e)我们的结果,(f)CycleGAN(Zhu等人(2017)),(g)UNIT(Liu等人(2017)”,(h)MUNIT(Huang等人(2018)),(i)DRIT(Lee等人(2018))和(j)AGGAN(Mejjati等人(2018))。

图11:photo2vangogh与注意力特征图的视觉比较。(a) 源图像,(b)一代人的注意力图,(c-d)分别是鉴别器的局部和全局注意力图,(e)我们的结果,(f)CycleGAN(Zhu等人(2017)),(g)UNIT(Liu等人(2017)”,(h)MUNIT(Huang等人(2018)),(i)DRIT(Lee等人(2018))和(j)AGGAN(Mejjati等人(2018))。

图12:photo2portrait与注意力特征图的视觉比较。(a) 源图像,(b)生成器的注意力图,(c-d)鉴别器的局部和全局注意力图,(e)我们的结果,(f)CycleGAN(Zhu等人(2017)),(g)UNIT(Liu等人(2017)],(h)MUNIT(Huang等人(2018)),(i)DRIT(Lee等人(2018)],(j)AGGAN(Mejjati等人(2018))。