【论文翻译】【剪枝】Pruning filters for efficient convnets修剪滤波以实现高效卷积网络

摘要

神经网络在各种应用中的成功伴随着计算和参数存储成本的显著增加。最近为减少这些开销所做的努力包括在不损害原始精度的情况下修剪和压缩各个层的权重。然而,基于大小的权重修剪减少了来自全连接层的大量参数,并且由于修剪后的网络中的不规则稀疏性,可能不能充分降低卷积层中的计算成本。我们提出了一种用于神经网络的加速方法,其中我们从被识别为对输出精度影响较小的神经网络中删除滤波器。通过去除网络中的整个滤波器及其连接的特征图,计算成本显著降低。与修剪权重相反,这种方法不会导致稀疏的连接模式。因此,它不需要稀疏卷积库的支持,并且可以与现有的高效BLAS库一起用于密集矩阵乘法。我们表明,即使是简单的滤波器修剪技术,在CIFAR10上也可以将VGG-16和ResNet-110的推理成本降低高达34%,同时通过重新训练网络恢复接近原始精度。

1.介绍

ImageNet挑战在探索CNNs中的各种架构选择方面取得了重大进展(Russakovsky等人(2015);Krizhevsky等人(2012);Simonyan和Zisserman(2015);Szegedy等人(2015a);他等人(2016))。过去几年来的总趋势是,随着参数数量和卷积运算的总体增加,网络已经变得更深。这些高容量网络具有显著的推理成本,特别是当与嵌入式传感器或移动设备一起使用时。对于这些应用,除了准确性之外,计算效率和小网络规模也是关键的启用因素(Szegedy等人(2015b))。此外,对于提供图像搜索和图像分类API的web服务,这些API以时间预算运行,通常每秒提供数十万张图像,因此推断时间较低会显著受益。

在通过模型压缩降低存储和计算成本方面,已经进行了大量的工作(Le Cun等人(1989);Hassibi&Stork(1993);Srinivas&Babu(2015);Han等人(2015);Mariet&Sra(2016))。最近,Han等人(2015;2016b)报告了AlexNet(Krizhevsky等人(2012))和VGGNet(Simonyan&Zisserman(2015))上令人印象深刻的压缩率,通过用小幅度修剪权重,然后在不影响整体准确性的情况下进行再训练。然而,修剪参数不一定减少计算时间,因为移除的大多数参数来自计算成本低的完全连接层,例如,VGG-16的完全连接的层占总参数的90%,但仅占总浮点运算(FLOP)的不到1%。他们还证明,卷积层可以被压缩和加速(Iandola等人(2016)),但另外需要稀疏的BLAS库或甚至专用硬件(Han等人(2016a))。在CNN上使用稀疏操作提供加速的现代图书馆通常受到限制(Szegedy等人(2015a);Liu et al(2015))和保持稀疏数据结构也会产生额外的存储开销,这对于低精度权重来说可能非常重要。

最近对神经网络的研究产生了具有更有效设计的深层架构(Szegedy等人(2015a;b);He&Sun(2015);He等人(2016)),其中完全连接的层被平均池化层取代(Lin等人(2013);He等人(2016)),这显著减少了参数的数量。通过在早期阶段对图像进行下采样以减少特征图的大小,也降低了计算成本(He&Sun(2015))。然而,随着网络的不断深入,卷积层的计算成本继续占据主导地位。

具有大容量的CNN通常在不同滤波器和特征通道之间具有显著的冗余。在这项工作中,我们专注于通过修剪滤波器来降低训练有素的神经网络的计算成本。与在整个网络中修剪权重相比,滤波器修剪是一种自然结构化的修剪方式,不引入稀疏性,因此不需要使用稀疏库或任何专用硬件。通过减少矩阵乘法的数量,修剪滤波器的数量与加速度直接相关,这很容易针对目标加速进行调整。此外,我们采用一次性修剪和再培训策略,而不是逐层迭代微调(再培训),以节省跨多个层修剪滤波器的再培训时间,这对于修剪非常深的网络至关重要。最后,我们观察到,即使对于ResNets(其参数和推理成本比AlexNet或VGGNet少得多),FLOP约有30%的减少,而不会牺牲太多的准确性。我们对ResNets中的卷积层进行了灵敏度分析,以提高对ResNet的理解。

2.相关工作

Le Cun等人(1989年)的早期工作引入了最佳脑损伤,它通过理论上合理的显著性度量来削减权重。后来,Hassibi&Stork(1993)提出了最佳脑外科医生,以去除由二阶导数信息确定的不重要权重。Mariet&Sra(2016)通过识别不需要再训练的不同神经元的子集来减少网络冗余。然而,此方法仅在完全连接的层上操作,并引入稀疏连接。

为了降低卷积层的计算成本,过去的工作已经提出通过将权重矩阵表示为两个较小矩阵的低秩乘积来近似卷积运算,而不改变滤波器的原始数量(Denil等人(2013);Jaderberg等人(2014);Zhang等人(2015b;a);Tai等人(2016);Ioannou等人(2016))。减少卷积开销的其他方法包括使用基于FFT的卷积(Mathieu等人(2013))和使用Winograd算法的快速卷积(Lavin&Gray(2016))。此外,量化(Han等人(2016b))和二值化(Rastegari等人(2016);Courbariaux&Bengio(2016))可用于减少模型大小和降低计算开销。除了这些技术之外,我们的方法还可以用于减少计算成本,而不会产生额外的开销。

一些工作已经研究了从经过良好训练的网络中去除冗余特征图(Anwar等人(2015); Polyak&Wolf(2015))。Anwar等人(2015)引入了权重的三级剪枝,并使用粒子过滤定位剪枝候选,该过滤从多个随机生成的掩码中选择最佳组合。Polyak&Wolf(2015)使用人脸检测应用的样本输入数据检测不太频繁激活的特征图。我们选择分析滤波器权重,并使用简单的基于大小的度量来修剪滤波器及其相应的特征图,而不检查可能的组合。我们还引入了网络范围的整体方法来修剪简单和复杂卷积网络架构的滤波器。

与我们的工作同时,人们对训练具有稀疏约束的紧凑型神经网络越来越感兴趣(Lebedev&Lempitsky(2016);Zhou等人(2016);Wen等人(2016))。Lebedev&Lempitsky(2016)利用卷积滤波器上的组稀疏性来实现结构化大脑损伤,即以组方式修剪卷积核的条目。Zhou等人(2016)在训练期间增加了神经元的群体稀疏正则化,以学习具有减少滤波器的紧凑型神经网络。Wen等人(2016)在每个层上添加结构化稀疏正则化器,以减少琐碎的滤波器、通道甚至层。在滤波器级修剪中,所有上述工作都使用![]() 作为正则化器。

作为正则化器。

与上述工作类似,我们使用“![]() -norm”来选择不重要的过滤器并对其进行物理修剪。我们的微调过程与常规训练程序相同,没有引入额外的正则化。我们的方法没有为正则化器引入额外的分层元参数,除了要修剪的过滤器的百分比,这与期望的加速率直接相关。通过采用分段修剪,我们可以在一个阶段中为所有层设置单个修剪率。

-norm”来选择不重要的过滤器并对其进行物理修剪。我们的微调过程与常规训练程序相同,没有引入额外的正则化。我们的方法没有为正则化器引入额外的分层元参数,除了要修剪的过滤器的百分比,这与期望的加速率直接相关。通过采用分段修剪,我们可以在一个阶段中为所有层设置单个修剪率。

3.修剪滤波器和特征图

设![]() 表示第i个卷积层的输入通道的数量,

表示第i个卷积层的输入通道的数量,![]() 是输入特征图的高度/宽度。卷积层将输入特征映射

是输入特征图的高度/宽度。卷积层将输入特征映射![]() 转换为输出特征映射

转换为输出特征映射![]() ,作为下一卷积层的输入特征映射。这是通过在

,作为下一卷积层的输入特征映射。这是通过在![]() 个输入通道上应用

个输入通道上应用![]() 个3D滤波器

个3D滤波器![]() 来实现的,其中一个滤波器生成一个特征图。每个滤波器由

来实现的,其中一个滤波器生成一个特征图。每个滤波器由![]() 个2D核

个2D核![]() (例如,3×3)组成。所有滤波器一起构成核矩阵

(例如,3×3)组成。所有滤波器一起构成核矩阵![]() 。卷积层的操作数为

。卷积层的操作数为![]() 。如图1所示,当过滤器

。如图1所示,当过滤器![]() 被修剪时,其对应的特征映射

被修剪时,其对应的特征映射![]() 被删除,这减少了

被删除,这减少了![]() 操作。应用于从下一卷积层的滤波器移除的特征图的内核也被移除,这节省了额外的

操作。应用于从下一卷积层的滤波器移除的特征图的内核也被移除,这节省了额外的![]() 操作。修剪层i的m个滤波器将减少层i和i+1的计算成本的

操作。修剪层i的m个滤波器将减少层i和i+1的计算成本的![]() 。

。

图1:修剪过滤器会导致移除下一层中相应的特征图和相关内核。

3.1确定要在单个层中修剪哪些滤波器

为了提高计算效率,我们的方法从训练有素的模型中删除了不太有用的滤波器,同时将精度下降降至最低。我们通过计算滤波器的绝对权重![]() 之和,即其“

之和,即其“![]() ”,来测量滤波器在每个层中的相对重要性。由于输入通道的数量,

”,来测量滤波器在每个层中的相对重要性。由于输入通道的数量,![]() ,和滤波器数量是相同的,所以

,和滤波器数量是相同的,所以![]() 也表示其内核权重的平均值。该值给出了输出特征图大小的预期值。

也表示其内核权重的平均值。该值给出了输出特征图大小的预期值。

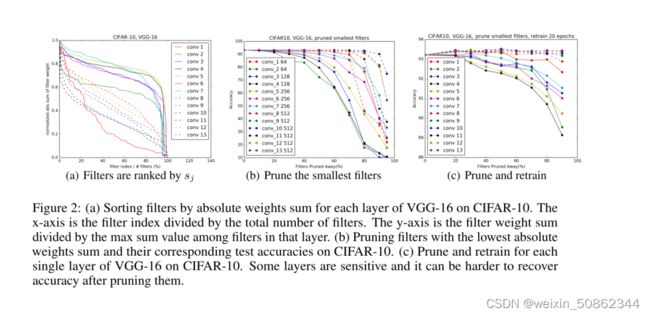

与该层中的其他过滤器相比,具有较小内核权重的过滤器倾向于生成具有弱激活的特征图。图2(a)说明了在CIFAR-10数据集上训练的VGG-16网络中每个卷积层的滤波器绝对权重和的分布,其中分布在各个层之间显著不同。我们发现,与修剪相同数量的随机或最大过滤器相比,修剪最小过滤器效果更好(第4.4节)。与基于激活的特征图修剪的其他标准(第4.5节)相比,我们发现“![]() -norm”是无数据过滤器选择的好标准。

-norm”是无数据过滤器选择的好标准。

从第i个卷积层修剪m个滤波器的过程如下:

2.按![]() 对过滤器进行排序。

对过滤器进行排序。

3.用最小和值修剪m个滤波器及其对应的特征图。对应于修剪的特征图的下一卷积层中的核也被去除。

4.为第i层和第i+1层创建新的核矩阵,并将剩余的核权重复制到新模型。

与修剪权重的关系 具有低绝对权重和的修剪滤波器类似于修剪低幅度权重(Han等人(2015))。当滤波器的所有内核权重低于给定阈值时,基于幅度的权重修剪可以修剪掉整个滤波器。然而,它需要仔细调整阈值,并且很难预测最终将被删减的过滤器的确切数量。此外,由于缺乏有效的稀疏库,特别是在低稀疏性的情况下,它生成的稀疏卷积核很难加速。

与滤波器上的群稀疏正则化的关系 最近的工作(Zhou等人(2016);Wen等人(2016))在卷积滤波器上应用群稀疏正则化( 或

或![]() ),这也有利于具有小l2范数的零输出滤波器,即

),这也有利于具有小l2范数的零输出滤波器,即![]() 。在实践中,我们没有观察到滤波器选择的“

。在实践中,我们没有观察到滤波器选择的“![]() ”和“

”和“![]() ”之间的显著差异,因为重要的滤波器对于两个度量值都具有较大的值(附录6.1)。在训练期间将多个滤波器的权重归零与使用第3.4节中介绍的迭代修剪和再训练策略修剪滤波器具有类似的效果。

”之间的显著差异,因为重要的滤波器对于两个度量值都具有较大的值(附录6.1)。在训练期间将多个滤波器的权重归零与使用第3.4节中介绍的迭代修剪和再训练策略修剪滤波器具有类似的效果。

3.2 确定单层对修剪的敏感性

图2:(a)根据CIFAR-10上VGG-16每层的绝对权重总和对过滤器进行排序。x轴是过滤器索引除以过滤器总数。y轴是过滤器权重总和除以该层中过滤器之间的最大总和值。(b) 在CIFAR-10上修剪具有最低绝对权重和的滤波器及其相应的测试精度。(c) 修剪并重新训练CIFAR-10上VGG-16的每一个单层。有些层是敏感的,在修剪它们之后,恢复精度可能会更困难。

为了了解每一层的敏感性,我们独立地对每一层进行修剪,并在验证集上评估所得到的修剪网络的准确性。图2(b)显示,当滤波器被修剪掉时保持其精度的层对应于图2(a)中斜率较大的层。相反,坡度相对平坦的层对修剪更敏感。我们根据每个层对修剪的敏感性,根据经验确定要修剪的过滤器的数量。对于VGG-16或ResNets等深度网络,我们观察到同一阶段(具有相同特征图大小)的层对修剪具有相似的敏感性。为了避免引入逐层元参数,我们对同一阶段中的所有层使用相同的修剪比率。对于对修剪敏感的层,我们修剪这些层的较小百分比,或者完全跳过修剪。

3.3 跨多个层修剪滤波器

我们现在讨论如何在整个网络中修剪过滤器。先前的工作是逐层删减权重,然后迭代重新训练并补偿任何精度损失(Han等人(2015)). 然而,了解如何一次修剪多个层的过滤器可能很有用:1)对于深度网络,逐层修剪和重新训练可能非常耗时2)在整个网络中修剪层可以提供网络健壮性的整体视图,从而生成更小的网络3)对于复杂网络,可能需要整体方法。例如,对于ResNet,修剪身份特征图或每个残差块的第二层会导致其他层的额外修剪。

为了在多个层之间修剪过滤器,我们考虑两种分层过滤器选择策略:

•独立修剪 确定在独立于其他层的每层中哪些过滤器 应 修剪 。

•贪婪的修剪 用于先前层中已移除的过滤器。该策略在计算绝对权重之和时不考虑先前修剪的特征图的核

图3说明了计算绝对权重之和的两种方法之间的差异。贪婪方法虽然不是全局最优的,但它是考虑全局的,并且会得到具有较高精度的修剪网络,特别是当许多过滤器被修剪时。

对于像VGGNet或AlexNet这样的简单的CNN,我们可以很容易地修剪任何卷积层中的任何滤波器。然而,对于复杂的网络架构,如残余网络(He等人(2016)),修剪过滤器可能并不简单。ResNet的架构施加了限制,需要仔细修剪过滤器。我们在图4中展示了带有投影映射的残差块的滤波器修剪。这里,可以任意修剪残差块中第一层的滤波器,因为它不会改变块的输出特征图的数量。然而,第二卷积层的输出特征图与同一特征图之间的对应性使得难以修剪。因此,为了修剪残差块的第二卷积层,还必须修剪相应的投影特征图。由于相同的特征图比添加的残差图更重要,因此要修剪的特征图应该由快捷层的修剪结果来确定。为了确定要修剪哪些身份特征图,我们使用基于快捷卷积层(具有1×1核)的滤波器的相同选择标准。残余块的第二层用与通过修剪快捷层所选择的相同的过滤器索引进行修剪。

3.4重新训练修剪后的网络以恢复准确性

在修剪滤波器之后,应该通过重新训练网络来补偿性能下降。有两种策略可以跨多个层修剪过滤器:

1.修剪一次并重新训练:一次修剪多个层的过滤器并重新训练它们,直到恢复原始精度。

2.删减并迭代重新训练:逐层删减过滤器或逐过滤器删减过滤器,然后迭代重新训练。在修剪下一层之前对模型进行重新训练,以使权重适应修剪过程的变化。

我们发现,对于具有修剪弹性的层,一次修剪和再训练策略可以用于修剪掉网络的重要部分,并且通过短时间(少于原始训练时间)的再训练可以恢复任何精度损失。然而,当来自敏感层的一些滤波器被修剪掉或网络的大部分被修剪掉时,可能不可能恢复原始精度。迭代修剪和再训练可能会产生更好的结果,但迭代过程需要更多的时间,特别是对于非常深的网络。

4.实验

我们对了两种类型的网络进行了剪枝:简单的网络(CIFAR-10上的VGG-16)和残差网络(CIFAR-10上的ResNet-56/110和ImageNet上的ResNet-34)。与通常用于演示模型压缩的AlexNet或VGG(在ImageNet上)不同,VGG(CIFAR-10上)和残差网络在完全连接的层中具有较少的参数。因此,从这些网络中修剪很大比例的参数是具有挑战性的。我们在Torch7中实现了我们的滤波器修剪方法(Collobert等人(2011))。修剪过滤器后,将创建具有较少过滤器的新模型,并将修改图层的其余参数以及未受影响的图层复制到新模型中。此外,如果对卷积层进行修剪,则随后的批量归一化层的权重也被去除。为了获得每个网络的基线精度,我们从头开始训练每个模型,并遵循与ResNet相同的预处理和超参数(He等人(2016)). 对于再培训,我们使用恒定的学习率0.001,并对CIFAR-10和ImageNet分别进行了40个时期和20个时期的再培训,这是原始培训时期的四分之一。过去的工作报告了最多3倍的原始训练时间来重新训练修剪的网络(Han等人(2015))。

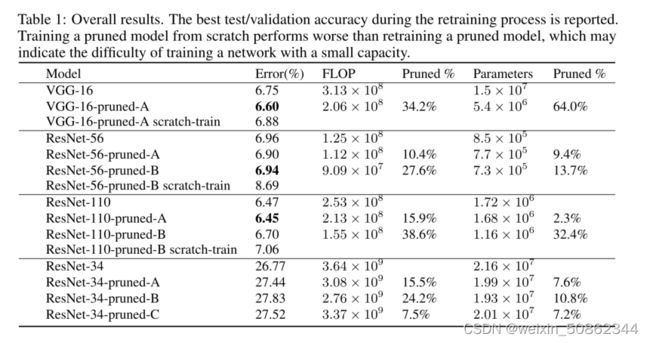

表1:总体结果。报告了再培训过程中的最佳测试/验证准确性。从头开始训练修剪模型比重新训练修剪模型的效果更差,这可能表明用小容量训练网络的难度。

4.1 CIFAR-10上的VGG-16

表2:CIFAR-10上的VGG-16和修剪模型。最后两列显示了特征图的数量和修剪模型中FLOP的减少百分比。

每个卷积层和第一线性层之后的层,而不使用Dropout(Srivastava等人(2014)). 注意,当最后一个卷积层被修剪时,线性层的输入被改变,并且连接也被移除。

如图2(b)所示,每个具有512个特征图的卷积层可以丢弃至少60%的滤波器,而不影响精度。图2(c)显示,通过再培训,这些层中几乎90%的过滤器都可以安全移除。一种可能的解释是,这些滤波器在4×4或2×2的特征图上运行,而这些特征图在如此小的维度上可能没有有意义的空间连接。例如,CIFAR-10的ResNets不会对8×8维以下的特征图执行任何卷积。与之前的工作不同(Zeiler&Fergus(2014);Han等人(2015)),我们观察到,与接下来的几层相比,第一层对修剪是鲁棒的。这对于像CIFAR-10这样的简单数据集是可能的,在该数据集上,模型没有像在ImageNet上学习到那么多有用的过滤器(如图5所示)。即使当来自第一层的80%的滤波器被修剪时,剩余滤波器(12)的数量仍然大于原始输入信道的数量。然而,当从第二层移除80%的滤波器时,该层对应于64到12的映射,这可能会丢失来自先前层的重要信息,从而损害准确性。通过在第1层中修剪50%的滤波器,从8到13,我们实现了34%的FLOP减少,以获得相同的精度。

4.2 RESNET-56/110 ON CIFAR-10

CIFAR-10的ResNets具有三个阶段的残差块,用于大小为32×32、16×16和8×8的特征图。每个阶段具有相同数量的剩余块。当特征映射的数量增加时,快捷方式层为增加的维度提供了一个带有额外零填充的身份映射。由于没有用于选择身份特征图的投影映射,我们只考虑修剪残差块的第一层。如图6所示,大多数层对修剪都是健壮的。对于ResNet-110,在不进行再训练的情况下修剪某些单层甚至可以提高性能。此外,我们发现对修剪敏感的层(ResNet-56的层20、38和54,ResNet-110的层36、38和74)位于接近特征图数量变化的层的残差块处,例如每个阶段的第一个和最后一个残差块。我们认为这是因为新添加的空特征地图需要精确的残差。

跳过这些敏感层可以提高再训练性能。如表1所示,ResNet-56-pruned-A通过在跳过敏感层16、20、38和54的同时修剪10%的滤波器来提高性能。此外,我们发现较深的层比网络早期阶段的层对修剪更敏感。因此,我们对每个阶段使用不同的修剪率。我们使用pi表示第i阶段的层的修剪率。ResNet-56-pruned-B跳过更多层(16、18、20、34、38、54),并修剪p1=60%、p2=30%和p3=10%的层。对于ResNet-110,第一个修剪模型得到的结果稍好,p1=50%,跳过了层36。ResNet-110修剪-B跳过层36、38、74并修剪p1=50%、p2=40%和p3=30%。当在每个阶段有两个以上的残差块时,中间的残差块可能是冗余的,并且可以容易地修剪。这可能解释了为什么ResNet-110比ResNet-56更容易修剪

4.3 ILSVRC2012上的RESNET-34

ImageNet的ResNets具有四个阶段的残差块,用于大小为56×56、28×28、14×14和7×7的特征图。当对要素地图进行下采样时,ResNet-34使用投影快捷方式。我们首先修剪每个残差块的第一层。图7显示了每个残余块的第一层的灵敏度。与ResNet-56/110类似,每个阶段的第一个和最后一个残差块比中间块(即,层2、8、14、16、26、28、30、32)对修剪更敏感。我们跳过这些层,并在每个阶段均等地修剪剩余的层。在表1中,我们比较了前三个阶段的两种修剪百分比配置:(A)p1=30%,p2=30%,p3=30%;(B) p1=50%,p2=60%,p3=40%。选项B提供24%的FLOP降低,精度损失约1%。如ResNet-50/110的修剪结果所示,我们可以预测,与深度更深的ResNets相比,ResNet-34相对更难修剪。

我们还修剪了身份快捷方式和残差块的第二卷积层。由于这些层具有相同数量的过滤器,因此它们将被同等地修剪。如图7(b)所示,这些层比第一层对修剪更敏感。通过再培训,ResNet-34-pruned-C将第三阶段的p3=20%进行修剪,结果FLOP减少7.5%,精度降低0.75%。因此,修剪残差块的第一层比修剪第二层更有效地减少总FLOP。这一发现还与深度ResNets的瓶颈块设计相关,该设计首先降低了残余层的输入特征图的维度,然后增加了维度以匹配身份映射。

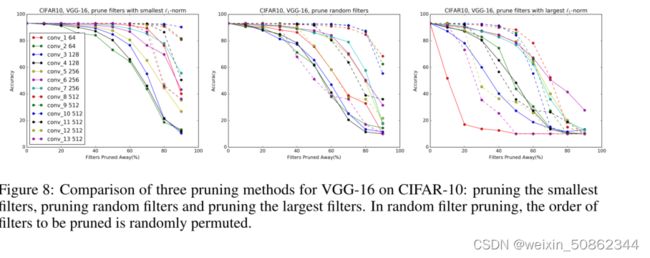

4.4与修剪随机滤波器和最大滤波器的比较

我们将我们的方法与修剪随机过滤器和最大过滤器进行了比较。如图8所示,在不同的修剪比率下,修剪最小的过滤器优于修剪大多数层的随机过滤器。例如,对于修剪比率为90%的所有层,最小过滤器修剪比随机过滤器修剪具有更好的准确性。随着修剪比率的增加,具有最大“![]() ”的修剪过滤器的精度迅速下降,这表明具有较大“

”的修剪过滤器的精度迅速下降,这表明具有较大“![]() 的过滤器的重要性。

的过滤器的重要性。

4.5与基于激活的特征图修剪的比较

4.5与基于激活的特征图修剪的比较

基于激活的特征图修剪方法移除了具有弱激活模式的特征图及其相应的过滤器和内核(Polyak&Wolf(2015)),这需要样本数据作为输入来确定要修剪哪些特征图。通过对前一层![]() ,即

,即![]() 的特征图应用滤波器

的特征图应用滤波器![]() ,生成特征图

,生成特征图![]() 。给定来自训练集的N个随机选择的图像

。给定来自训练集的N个随机选择的图像![]() ,可以用N个采样数据的一个历元前向通过来估计每个特征图的统计。注意,我们在批量归一化或非线性激活之前计算从卷积操作生成的特征图的统计信息。我们使用以下标准将基于

,可以用N个采样数据的一个历元前向通过来估计每个特征图的统计。注意,我们在批量归一化或非线性激活之前计算从卷积操作生成的特征图的统计信息。我们使用以下标准将基于![]() 的滤波器修剪与特征图修剪进行比较:

的滤波器修剪与特征图修剪进行比较:

,其中mean、std和var是输入的标准统计(平均值、标准差和方差)。这里,![]() 是Polyak&Wolf(2015)中提出的信道标准的贡献方差,其动机是直觉,即不重要的特征图对整个训练数据具有几乎相似的输出,并且充当额外的偏差。

是Polyak&Wolf(2015)中提出的信道标准的贡献方差,其动机是直觉,即不重要的特征图对整个训练数据具有几乎相似的输出,并且充当额外的偏差。

当使用更多样本数据时,标准的估计变得更准确。这里我们使用整个训练集(CIFAR-10的N=50000)来计算统计数据。图9显示了使用上述标准对每个层进行特征图修剪的性能。最小滤波器修剪优于特征图修剪,其标准为![]() 、

、![]() 、

、![]() 和

和![]() 。σmean std标准具有优于或类似于“1-范数”的性能,修剪率为60%。然而,在这之后,其性能迅速下降,尤其是对于conv_1、conv_2和conv_3的层。考虑到“l1-norm”是无数据的,我们发现它是一个很好的启发式过滤器选择方法。

。σmean std标准具有优于或类似于“1-范数”的性能,修剪率为60%。然而,在这之后,其性能迅速下降,尤其是对于conv_1、conv_2和conv_3的层。考虑到“l1-norm”是无数据的,我们发现它是一个很好的启发式过滤器选择方法。

5 结论

现代神经网络通常具有高容量,且训练和推理成本高。在本文中,我们提出了一种在不引入不规则稀疏性的情况下,修剪具有相对较低权重大小的滤波器以产生具有降低计算成本的神经网络的方法。它实现了VGGNet(在CIFAR-10上)和深度ResNets的FLOP降低约30%,而不会显著降低原始精度。

为了简化和易于实现,我们使用一次性修剪和重新训练策略,而不是使用特定的逐层干草参数和耗时的迭代重新训练进行修剪。通过对非常深的神经网络进行损伤研究,我们确定了强健或敏感的层