人工智能的安全问题与差分隐私【笔记】

人工智能的安全问题与差分隐私

- 写在前面的话

- 2021-AI-Index-Report_Master

- 承上启下

- 人工智能模型数据泄露的攻击与防御

-

- 介绍

- 概述

- 启发

- Threat of Adversarial Attacks on Deep Learning in Computer Vision: A Survey

-

- 介绍

- 概述

- 启发

- 差分隐私

- 差分隐私和人工智能

- 成员推理攻击

-

- MI攻击面临的四个问题

- Practical Blind Membership Inference Attack via Differential Comparisons

- 对抗样本攻击

-

- Certified Robustness to Adversarial Examples with Differential Privacy

- 总结

- 参考文献

写在前面的话

这篇博客是我为了人工智能作业写的,由于下周二要汇报这里就定时在下周二零点发布了。阅读《2021-AI-Index-Report_Master》报告做一个汇报。这里我从自己研究的差分隐私这个角度出发,谈一谈人工智能的安全问题与差分隐私之间的关系。

2021-AI-Index-Report_Master

根据报告显示,人工智能很难落地,大家都不敢用,其中存在一个重要的原因——安全问题。我们都在关注人工智能的性能或者伦理,对于人工智能的安全问题相关的研究仍然是一个重要的方向。

直接看下面这三幅图,给我最直观的感受就是尽管AI存在最大的风险是网络/信息安全问题,但是目前主要的研究方向还是如何提高人工智能的性能。并且从博士研究方向占比以及占比变化可以看出,这其中存在严重的不平衡情况和内卷情况。

承上启下

根据报告进行拓展,人工智能存在两个主要的安全问题,其一是数据安全问题,其二是模型安全问题。这里的数据安全问题主要指敏感数据的泄露,例如训练集,模型参数等等。模型安全问题主要指模型被攻击导致不能正常工作这类的问题。后面的内容我会结合我的研究方向分别从这两个方向出发,通过综述和论文来讲述这两个问题。

人工智能模型数据泄露的攻击与防御

介绍

接下来我们谈论人工智能的安全问题主要从数据安全和隐私保护问题出发。结合我的研究方向我找了一篇与人工智能安全问题有关的综述。作者团队是浙江大学NSA实验室,这个团队主要研究方向为数据挖掘安全,人工智能安全,隐私保护以及大数据分析。这篇综述于2021年收录于网络与信息安全学报。

概述

以攻击为主线,根据攻击者需求的信息类型不同,分为基于模型输出的数据泄露和基于梯度更新的数据泄露。关于模型输出的数据泄露又可以根据数据信息不同分为模型窃取(模型自身数据)和隐私泄露(训练/测试数据)。关于基于梯度更新的数据泄露主要是在分布式学习中比较严重。由此,防御方作为后手开始博弈,对于不同的攻击研究不同的防御。

启发

防御的方法所体现的思想与差分隐私的思想及其相似,从这里面我感受到了一种趋势。不影响 AI 模型有效性的情况下,尽可能减少或者混淆这类交互数据中包含的有效信息。量子计算的发展使得目前传统密码学方法逐渐失效,计算机学科逐渐朝实验性学科转型,在数据和技术上的革新需要加快进程。

Threat of Adversarial Attacks on Deep Learning in Computer Vision: A Survey

介绍

模型本身的安全问题和对抗攻击是分不开的,针对计算机视觉中对抗样本攻击,已经有了一些解决的办法,但是还是存在很多问题。

概述

启发

从对抗样本攻击可以看出来,它正是利用了机器学习的无限敏感性导致其输出错误的结果。当前也有很多针对其的防御措施,但是从攻防角度来说防御方总是被动的,对于完全防御对抗样本攻击还有很长的路要走。

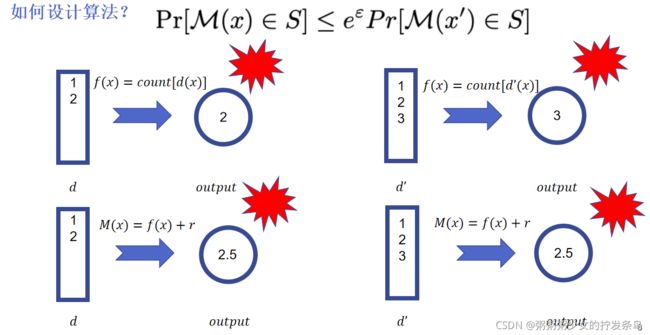

差分隐私

说完人工智能模型的两大主要问题,就顺便聊一下我的研究方向差分隐私,先举一个简单的例子。

差分隐私和人工智能

差分隐私作为保护个人隐私的一种思想已经成为隐私保护的黄金标准。对于人工智能存在的两大主要问题,我落实到两个结合差分隐私的具体攻击给大家做介绍。

成员推理攻击

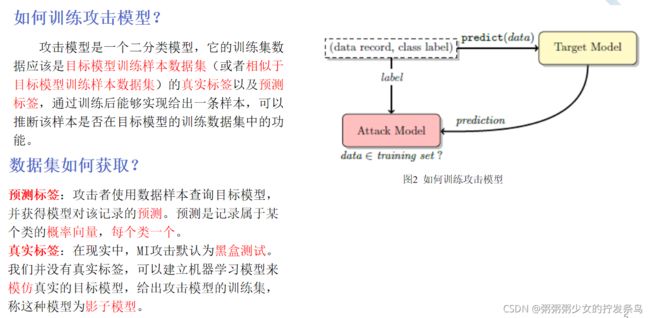

这里介绍第一个主要问题中的一个攻击,成员推理攻击。成员推理攻击利用了这样一种观察,机器学习模型在它们所训练的数据上的行为常常与它们第一次“看到”的数据不同。过拟合是一个常见的原因,但不是唯一的原因。攻击者的目的是构建一个攻击模型,该模型可以识别目标模型行为中的这些差异,并利用它们来区分目标模型的成员和非成员。简单来说就是,你给我一个数据样本我就能判断这是不是来自于你的训练集。

攻击模型是一组模型,为目标模型的每个输出类设置一个。这增加了攻击的准确性,因为目标模型根据输入的真实的类从而在其输出的类上产生不同的分布。为了训练的攻击模型,本文构建了多个影子模型(shadow model),这些模型的行为类似于目标模型,与目标模型相比每个影子模型的真实情况是已知的,即给定的记录是否在其训练数据集中。因此,可以对影子模型的输入和相应的输出(每个标记为“in”或“out”)进行监督训练,教攻击模型如何区分影子模型对其训练数据集成员的输出和对非成员的输出,如下图:

攻击者使用数据记录查询目标模型,并获取该记录的模型预测。预测是一个概率向量,每类一个,表明记录属于某个类。该预测向量连同目标记录的标签被传递到攻击模型,该攻击模型推断该记录是否在目标模型的训练数据集中。

MI攻击面临的四个问题

1、过度依赖影子模型。在不知道目标模型的模型结构和超参的情况下去训练影子模型得到的结果很有可能与目标模型得到的结果差别较大,因为目标模型可以通过数据增强,正则化等多角度优化来迷惑攻击者。

2、对于真实标签的利用。在真实世界中,特别是在医学领域想获得数据的真实标签往往很难,需要专业人士打标,这样对于攻击者成本太高。

3、对于隐私预算的对策。在差分隐私中一开始设定较小的隐私预算,随着询问次数的增多会消耗隐私预算导致预算增加,这意味着每次查询都会对查询结果引入随机噪声,从而迷惑攻击者。

4、正则化的影响。机器学习模型存在过拟合问题,通过正则化提高模型泛化能力,针对模型中参数过大的问题引入惩罚项,惩罚每个神经元的权重大小,从而避免网络中的神经元走极端抄近路。

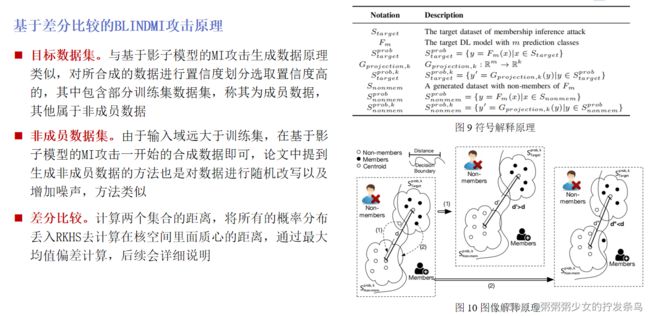

提出了一种新型MI攻击方案,优于目前最先经的MI攻击并且能在一定程度上打败现有最先进的防御机制,并且适用盲盒模型等多个威胁模型,不依赖影子模型,可选择性利用真实标签。

Practical Blind Membership Inference Attack via Differential Comparisons

对这篇论文就不多赘述了,这种成员推理攻击不基于影子模型,是基于差分的思想。这体现出即使当前最先进的防御还是不能防御这种攻击,攻击者作为主动方仍然抢占先机。

从论文的思考出发,有以下几点:

对抗样本攻击

在计算机视觉场景下,对输入样本故意添加一些人无法察觉的细微的干扰,导致模型以高置信度给出一个错误的输出。其实还有很多地方都会用到对抗样本攻击,它们的目的不是获取敏感数据,而是破坏模型结构或者性能。在介绍这一部分之前先提出两个问题

Q1:你觉得两者之间有什么关系?或者说对你有什么启示?

Q2:你觉得差分隐私能防御对抗攻击吗?为什么?

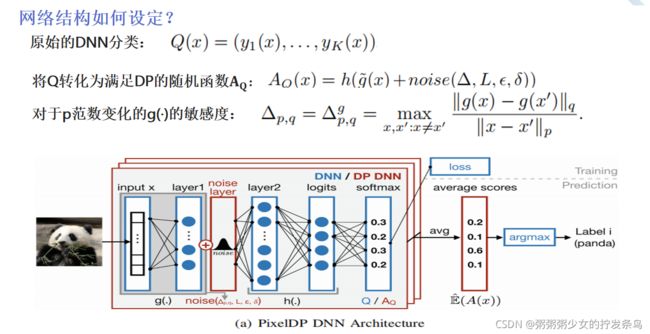

Certified Robustness to Adversarial Examples with Differential Privacy

从攻防的角度考虑,如下图所示:

简单介绍一下差分隐私怎么防御的:

Q1:你觉得两者之间有什么关系?或者说对你有什么启示?

A1:扰动后的变化(差异程度),攻防对立或者转换,最优问题,场景应用…

Q2:你觉得差分隐私能防御对抗攻击吗?为什么?

A2:能,对机器学习模型来说,对抗攻击利用了机器学习模型的对于数据变化的无限敏感性这一漏洞做出攻击。而差分隐私的思想可以使得机器学习模型变得不那么敏感,通过牺牲精度来保证安全性,顺带还一定程度上保证了信息安全。文中这个防御的方向是通过修改网络来达到防御的效果,并且归属于完全防御这一范畴(计算机视觉领域)。

启示:差分隐私的思想并不局限于隐私保护,更一般的说是缓和数据的差异性。隐私保护只是其中达到的一个目的,准确的说隐私保护是一个抽象的场景。在文中,差分隐私这一特性恰好能够解决对抗攻击给机器学习模型所带来的问题。这其中还有很多问题,从结果表明这样做是有效的。

批判:这样的防御存在很多漏洞,如果我的攻击是高于所设置的L(L本身不能设置太高),文中的防御效果就会降低。从精度上来说,图像识别本来就要求高准确率,即使防御了攻击,效果降低对于图像识别的意义也就大打折扣了。如何从其中找到纳什平衡成为关键。

总结

先从报告中的人工智能的风险出发,我关注到了最重要的网络安全问题。人工智能的安全问题又可以分为两个主要的问题,分别是数据安全问题和模型安全问题。结合当前隐私保护的黄金标准差分隐私,我从两个主要的问题中找出两个具体的问题,成员推理攻击以及对抗样本攻击,进行简要阐述和思考。最后进行进一步总结,如下:

1、训练阶段的输入数据

修改模型训练阶段的输入数据,对最后的模型准确性产生影响。

2、训练阶段的模型训练

通过在线的模型训练API,用户“逆向工程”的方式来解析模型的内部结构,从而导致模型的隐私信息的泄露。

3、推理阶段的预测数据

恶意改变推理数据让模型进行错误的分类。(汽车刹车)

4、推理阶段的结果预测

建立“影子”模型,模拟原有模型的行为,从而实施更加自由的攻击模式。

举个例子:这四个阶段分别对应的就是网络流量攻击(物理世界获取信息),将获取的信息通过在网卡上进行数据包嗅探,用tcpdump等抓包工具抓包转化成图片进入预处理阶段(转化成数字表征),接下来将包的特征进行提取(表征转化),应用模型对其进行攻击置信度的计算(进入机器学习模型训练),反馈到物理世界中,关闭基础设施(返回到物理世界推理)。

参考文献

[1] M. Lecuyer, V. Atlidakis, R. Geambasu, D. Hsu and S. Jana, “Certified Robustness to Adversarial Examples with Differential Privacy,” 2019 IEEE Symposium on Security and Privacy (SP), 2019, pp. 656-672, doi: 10.1109/SP.2019.00044.

[2] Giraldo, Jairo & Cardenas, Alvaro & Kantarcioglu, Murat & Katz, Jonathan. (2020). Adversarial Classification Under Differential Privacy. 10.14722/ndss.2020.23047.

[3] 任奎, 孟泉润, 闫守琨, 秦湛. 人工智能模型数据泄露的攻击与防御研究综述[J]. 网络与信息安全学报, 2021, 7(1): 1-10.

[4] N. Akhtar and A. Mian, “Threat of Adversarial Attacks on Deep Learning in Computer Vision: A Survey,” in IEEE Access, vol. 6, pp. 14410-14430, 2018, doi: 10.1109/ACCESS.2018.2807385.

[5] Reza Shokri, Marco Stronati, Congzheng Song, Vitaly Shmatikov:

Membership Inference Attacks Against Machine Learning Models. IEEE Symposium on Security and Privacy 2017: 3-18

[6] Bo Hui, Yuchen Yang, Haolin Yuan, Philippe Burlina, Neil Zhenqiang Gong, Yinzhi Cao: Practical Blind Membership Inference Attack via Differential Comparisons. NDSS 2021

[7] Cynthia Dwork, Aaron Roth:The Algorithmic Foundations of Differential Privacy. Found. Trends Theor. Comput. Sci. 9(3-4): 211-407 (2014)