- 算法学习笔记:17.蒙特卡洛算法 ——从原理到实战,涵盖 LeetCode 与考研 408 例题

在计算机科学和数学领域,蒙特卡洛算法(MonteCarloAlgorithm)以其独特的随机抽样思想,成为解决复杂问题的有力工具。从圆周率的计算到金融风险评估,从物理模拟到人工智能,蒙特卡洛算法都发挥着不可替代的作用。本文将深入剖析蒙特卡洛算法的思想、解题思路,结合实际应用场景与Java代码实现,并融入考研408的相关考点,穿插图片辅助理解,帮助你全面掌握这一重要算法。蒙特卡洛算法的基本概念蒙特卡

- AI音乐模拟器:AIGC时代的智能音乐创作革命

lauo

人工智能AIGC开源前端机器人

AI音乐模拟器:AIGC时代的智能音乐创作革命引言:AIGC浪潮下的音乐创作新范式在数字化转型的浪潮中,人工智能生成内容(AIGC)正在重塑各个创意领域。音乐产业作为创意经济的重要组成部分,正经历着前所未有的变革。据最新市场研究数据显示,全球AI音乐市场规模预计将从2023年的5.8亿美元增长到2030年的26.8亿美元,年复合增长率高达24.3%。这一快速增长的市场背后,是AI音乐技术正在打破传

- 视频分析:让AI看懂动态画面

随机森林404

计算机视觉音视频人工智能microsoft

引言:动态视觉理解的革命在数字信息爆炸的时代,视频已成为最主要的媒介形式。据统计,每分钟有超过500小时的视频内容被上传到YouTube平台,而全球互联网流量的82%来自视频数据传输。面对如此海量的视频内容,传统的人工处理方式已无法满足需求,这正是人工智能视频分析技术大显身手的舞台。视频分析技术赋予机器"看懂"动态画面的能力,使其能够自动理解、解释甚至预测视频中的内容,这一突破正在彻底改变我们与视

- 法律科技领域人工智能代理构建的十个经验教训,一位人工智能工程师通过构建、部署和维护智能代理的经验教训来优化法律工作流程的历程。

知识大胖

NVIDIAGPU和大语言模型开发教程人工智能ai

目录介绍什么是代理人?为什么它对法律如此重要?法律技术中代理用例示例-合同审查代理-法律研究代理在LegalTech中使用代理的十个教训-教训1:即使代理很酷,它们也不能解决所有问题-教训2:选择最适合您用例的框架-教训3:能够快速迭代不同的模型-教训4:从简单开始,必要时扩展-教训5:使用跟踪解决方案;您将需要它-教训6:确保跟踪成本,代理循环可能很昂贵-教训7:将控制权交给最终用户(人在环路中

- Llama-Omni会说话的人工智能“语音到语音LLM” 利用低延迟、高质量语音转语音 AI 彻底改变对话方式(教程含源码)

知识大胖

NVIDIAGPU和大语言模型开发教程llama人工智能nvidiallm

介绍“单靠技术是不够的——技术与文科、人文学科的结合,才能产生让我们心花怒放的成果。”——史蒂夫·乔布斯近年来,人机交互领域发生了重大变化,尤其是随着ChatGPT、GPT-4等大型语言模型(LLM)的出现。虽然这些模型主要基于文本,但人们对语音交互的兴趣日益浓厚,以使人机对话更加无缝和自然。然而,实现语音交互而不受语音转文本处理中常见的延迟和错误的影响仍然是一个挑战。关键字:Llama-Omni

- 什么是热力学计算?它如何帮助人工智能发展?

知识大胖

NVIDIAGPU和大语言模型开发教程人工智能量子计算

现代计算的基础是晶体管,这是一种微型电子开关,可以用它构建逻辑门,从而创建CPU或GPU等复杂的数字电路。随着技术的进步,晶体管变得越来越小。根据摩尔定律,集成电路中晶体管的数量大约每两年增加一倍。这种指数级增长使得计算技术呈指数级发展。然而,晶体管尺寸的缩小是有限度的。我们很快就会达到晶体管无法工作的阈值。此外,人工智能的进步使得对计算能力的需求比以往任何时候都更加迫切。根本问题是自然是随机的(

- 上海交大:工具增强推理agent

标题:SciMaster:TowardsGeneral-PurposeScientificAIAgentsPartI.X-MasterasFoundation-CanWeLeadonHumanity’sLastExam?来源:arXiv,2507.05241摘要人工智能代理的快速发展激发了利用它们加速科学发现的长期雄心。实现这一目标需要深入了解人类知识的前沿。因此,人类的最后一次考试(HLE)为评

- 微算法科技的前沿探索:量子机器学习算法在视觉任务中的革新应用

MicroTech2025

量子计算算法

在信息技术飞速发展的今天,计算机视觉作为人工智能领域的重要分支,正逐步渗透到我们生活的方方面面。从自动驾驶到人脸识别,从医疗影像分析到安防监控,计算机视觉技术展现了巨大的应用潜力。然而,随着视觉任务复杂度的不断提升,传统机器学习算法在处理大规模、高维度数据时遇到了计算瓶颈。在此背景下,量子计算作为一种颠覆性的计算模式,以其独特的并行处理能力和指数级增长的计算空间,为解决这一难题提供了新的思路。微算

- 中国银联豪掷1亿采购海光C86架构服务器

信创新态势

海光芯片C86国产芯片海光信息

近日,中国银联国产服务器采购大单正式敲定,基于海光C86架构的服务器产品中标,项目金额超过1亿元。接下来,C86服务器将用于支撑中国银联的虚拟化、大数据、人工智能、研发测试等技术场景,进一步提升其业务处理能力、用户服务效率和信息安全水平。作为我国重要的银行卡组织和金融基础设施,中国银联在全球183个国家和地区设有银联受理网络,境内外成员机构超过2600家,是世界三大银行卡品牌之一。此次中国银联发力

- AI人工智能浪潮中文心一言的独特优势

AI人工智能浪潮中文心一言的独特优势:为什么它是中国市场的“AI主力军”?关键词:文心一言,AI大模型,中文处理,多模态融合,产业落地,安全可控,百度ERNIE摘要:在全球AI大模型浪潮中,百度文心一言(ERNIEBot)凭借“懂中文、会多模态、能落地、守规矩”的四大核心优势,成为中国市场最具竞争力的AI产品之一。本文将用“超级大脑”的比喻,从中文理解、多模态能力、产业生态融合、安全可控性四个维度

- 正义的算法迷宫—人工智能重构司法体系的技术悖论与文明试炼

一、法庭的数字化迁徙当美国威斯康星州法院采纳COMPAS算法评估被告再犯风险,当中国"智慧法院"系统年处理1.2亿件案件,司法体系正经历从石柱法典到代码裁判的范式革命。这场转型的核心驱动力是司法效率与公正的永恒张力:美国重罪案件平均审理周期达18个月,中国基层法官年人均结案357件(是德国同行的6倍),而算法能在0.3秒内完成百万份文书比对。人工智能渗透司法引发三重裂变:证据分析从经验推断转向数据

- 【python实战】不玩微博,一封邮件就能知道实时热榜,天秀吃瓜

一条coding

从实战学python人工智能pythonlinux爬虫

❤️欢迎订阅《从实战学python》专栏,用python实现办公自动化、数据可视化、人工智能等各个方向的实战案例,有趣又有用!❤️更多精品专栏简介点这里有的人金玉其表败絮其中,有的人却若彩虹般绚烂,怦然心动前言哈喽,大家好,我是一条。在生活中我是一个不太喜欢逛娱乐平台的人,抖音、快手、微博我手机里都没装,甚至微信朋友圈都不看,但是自从开始写博客,有些热度不得不蹭。所以就有了这样一个需求,能不能让微

- MCP协议:AI时代的“万能插座”如何重构IT生态与未来

MCP协议:AI时代的“万能插座”如何重构IT生态与未来在人工智能技术爆炸式发展的浪潮中,一个名为ModelContextProtocol(MCP)的技术协议正以惊人的速度重塑IT行业的底层逻辑。2024年11月由Anthropic首次发布,MCP在短短半年内获得OpenAI、谷歌、亚马逊、阿里、腾讯等全球科技巨头的支持,被业内誉为AI时代的HTTP协议或USB-C接口,正在成为连接大模型与现实世

- 《算法备案全攻略:规范与流程引领数字时代新秩序》

算法及大模型备案顾问刘老师

算法备案深度学习AIGC语言模型算法人工智能

一、算法备案:开启合规新征程(一)备案规定的起源与发展2022年国家互联网信息办公室、工业和信息化部、公安部、国家市场监督管理总局联合发布《互联网信息服务算法推荐管理规定》,自2022年3月1日起施行。此后,相关规定不断完善和演进。如国家网信办于2022年8月、10月及2023年1月先后三次公布了《境内互联网信息服务算法备案清单》。同时,2022年发布的最高人民法院《关于规范和加强人工智能司法应用

- C语言学生成绩管理系统<;自创>;(功能7有小错误,但可运行)

han_xue_feng

java

腾讯云加速企业和个人开发创新公开直播预告直播预告:07/18(周四)15:00-16:00随着人工智能与大模型的蓬勃发展,我们正步入一个由技微信实习第一天周五入职,早上早早来到了公司,发现好多人都没上班,到十点才陆陆续续有人来,办理完入职后,mentor中联夏令营遗憾没有入选不过hr的回复真的很好,辛苦啦#提前批简历挂麻了怎么办##机械制造投递记录#大数据开发的工作有点过于简单了吧sq大数据开发的

- Python 实战人工智能数学基础:推荐系统应用

AI天才研究院

AI大模型企业级应用开发实战大数据人工智能语言模型JavaPython架构设计

作者:禅与计算机程序设计艺术文章目录1.背景介绍2.核心概念与联系2.1用户画像2.2相似性计算2.2.1基于物品的相似度2.2.2基于用户的相似度2.3协同过滤算法2.3.1基于用户的协同过滤算法2.3.2基于物品的协同过滤算法2.3.3基于上下文的协同过滤算法3.核心算法原理和具体操作步骤以及数学模型公式详细讲解3.1基于用户的协同过滤算法3.2基于物品的协同过滤算法3.3混合协同过滤算法3.

- Python桌面应用开发的未来——智能化工具与大模型赋能

IronwoodStag78

开发AI智能应用,就下载InsCodeAIIDE,一键接入DeepSeek-R1满血版大模型!标题:Python桌面应用开发的未来——智能化工具与大模型赋能随着人工智能技术的飞速发展,传统软件开发模式正在被重新定义。Python作为一门功能强大且灵活的语言,在桌面应用开发领域一直占据重要地位。然而,面对日益复杂的用户需求和快速变化的技术环境,如何提升开发效率、降低开发门槛,成为开发者亟需解决的问题

- 深度学习实战-使用TensorFlow与Keras构建智能模型

程序员Gloria

Python超入门TensorFlowpython

深度学习实战-使用TensorFlow与Keras构建智能模型深度学习已经成为现代人工智能的重要组成部分,而Python则是实现深度学习的主要编程语言之一。本文将探讨如何使用TensorFlow和Keras构建深度学习模型,包括必要的代码实例和详细的解析。1.深度学习简介深度学习是机器学习的一个分支,使用多层神经网络来学习和表示数据中的复杂模式。其广泛应用于图像识别、自然语言处理、推荐系统等领域。

- AI产品经理需要了解的算法知识

AI劳模

人工智能产品经理AI产品经理AI产品经理入门零基础入门产品经理算法语言模型

1、自然语言生成(NLG)自然语言生成(NaturalLanguageGeneration,简称NLG)是一种人工智能技术,它的目标是将计算机的数据、逻辑或算法产生的信息转换成人类可读的自然语言文本。换句话说,NLG能让机器“学会”写文章、报告、故事或者其他任何形式的文字,就像人类作家那样。这项技术使得机器能够理解复杂的数据并将其转化为易于理解的语言,以适应不同的受众和情境。应用实例:金融报告自动

- 【Python】OpenAI API

宅男很神经

python开发语言

【Python与OpenAIAPI深度探索:从基础到未来】第一章:OpenAIAPI概览与核心概念1.1OpenAIAPI是什么?能做什么?OpenAIAPI(ApplicationProgrammingInterface,应用程序编程接口)是一套允许开发者通过编程方式访问和使用OpenAI开发的各种先进人工智能模型的服务。这些模型经过海量数据的训练,能够在多种任务上达到甚至超越人类水平。通过AP

- Python:操作 Word 对齐方式

Thomas Kant

Pythonpythonwordc#

亲爱的技术爱好者们,热烈欢迎来到Kant2048的博客!我是ThomasKant,很开心能在CSDN上与你们相遇~本博客的精华专栏:【自动化测试】【测试经验】【人工智能】【Python】Python:操作Word对齐方式详解(左对齐/右对齐/居中/两端对齐)在日常办公自动化中,我们经常需要对Word文档中的段落设置对齐方式,如左对齐、右对齐、居中、两端对齐等。本文将带你使用python-docx库

- TestCafe ➜ Playwright fixture 架构迁移指南

Thomas Kant

自动化测试playwrighttestcafetypescript测试架构

亲爱的技术爱好者们,热烈欢迎来到Kant2048的博客!我是ThomasKant,很开心能在CSDN上与你们相遇~本博客的精华专栏:【自动化测试】【测试经验】【人工智能】【Python】

- 医疗金融预测与语音识别中的模型优化及可解释性技术突破

智能计算研究中心

其他

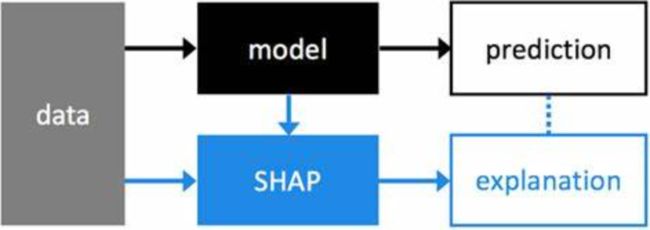

内容概要随着人工智能技术的纵深发展,模型优化与可解释性技术正在重塑医疗诊断、金融预测及语音识别领域的应用范式。在医疗领域,基于自适应学习的动态参数调整机制,结合迁移学习的跨场景知识复用,显著提升了疾病筛查模型的泛化能力;而金融预测场景中,联邦学习框架通过分布式数据协作,在保障隐私安全的前提下,实现了风险预测模型的多维度优化。语音识别领域则依托边缘计算架构,将模型压缩技术与实时推理引擎结合,有效解决

- 【kafka】在Linux系统中部署配置Kafka的详细用法教程分享

景天科技苑

linux基础与进阶shell脚本编写实战kafkalinux分布式kafka安装配置kafka优化

✨✨欢迎大家来到景天科技苑✨✨养成好习惯,先赞后看哦~作者简介:景天科技苑《头衔》:大厂架构师,华为云开发者社区专家博主,阿里云开发者社区专家博主,CSDN全栈领域优质创作者,掘金优秀博主,51CTO博客专家等。《博客》:Python全栈,PyQt5和Tkinter桌面应用开发,小程序开发,人工智能,js逆向,App逆向,网络系统安全,云原生K8S,Prometheus监控,数据分析,Django

- AI技术全景图鉴:从模型开发到落地部署的全链路拆解

大模型玩家

人工智能langchain大模型产品经理学习ai程序员

人工智能(AI)技术的快速发展,使得企业在AI模型的开发、训练、部署和运维过程中面临前所未有的复杂性。从数据管理、模型训练到应用落地,再到算力调度和智能运维,一个完整的AI架构需要涵盖多个层面,确保AI技术能够高效、稳定地运行。本文将基于AI技术架构全景图,深入剖析AI的开发工具、AI平台、算力与框架、智能运维四大核心部分,帮助大家系统性地理解AI全生命周期管理。一、AI开发工具:赋能高效开发,提

- 铸造软件交付的“自动驾驶”系统——AI大模型如何引爆DevOps革命

LucianaiB

评测人工智能自动驾驶devops

铸造软件交付的“自动驾驶”系统——AI大模型如何引爆DevOps革命嗨,我是LucianaiB!总有人间一两风,填我十万八千梦。路漫漫其修远兮,吾将上下而求索。摘要(Abstract)本文深入探讨了人工智能大模型(AILargeModels)如何驱动DevOps从“自动化”(Automation)向“自主化”(Autonomous)的革命性跃迁。文章指出,AI大模型正成为现代软件工厂的“中枢神经系

- 解读《生成式人工智能服务管理暂行办法》我的大模型服务需要备案还是登记?

纵深企服

人工智能AIGC安全

一、大模型备案和登记是什么?根据《暂行办法》及相关指引文件,大模型相关的合规路径主要分为“备案”和“登记”两种。准确理解二者的定义、适用情形及区别,是企业合规的第一步。1、大模型备案(生成式人工智能服务上线备案)定义:大模型备案,通常指的是生成式人工智能服务上线备案。根据《暂行办法》,“提供具有舆论属性或者社会动员能力的生成式人工智能服务的,应当按照国家有关规定开展安全评估,并按照《互联网信息服务

- 显卡GPU的架构和工作原理

InnoLink_1024

芯片人工智能AGI架构硬件架构人工智能

显卡GPU(图形处理单元)是专为并行计算和图形处理设计的芯片,广泛应用于游戏、科学计算、人工智能和数据中心等领域。以下详细介绍GPU的架构和工作原理,涵盖核心组件、计算流程和关键技术,尽量简洁清晰。一、GPU架构概述GPU架构与CPU不同,专注于高并行计算,适合处理大量简单、重复的任务。其核心设计目标是最大化吞吐量,而非单任务的低延迟。主流GPU厂商(如NVIDIA、AMD、Intel)架构虽有差

- Github 2025-01-07Python开源项目日报 Top10

老孙正经胡说

github开源Github趋势分析开源项目PythonGolang

根据GithubTrendings的统计,今日(2025-01-07统计)共有10个项目上榜。根据开发语言中项目的数量,汇总情况如下:开发语言项目数量Python项目10TypeScript项目1C++项目1OpenHands:人工智能驱动的软件开发代理平台创建周期:195天开发语言:Python协议类型:MITLicenseStar数量:31753个Fork数量:3660次关注人数:31753人

- Python 生态发展之路

仓颉编程语言

技术文章python

目录#Python是如何炼成的##生态系统持续扩张##Python开发的开源社区运作#更加广义的Python社区#广泛应用##Web开发、数据科学##不得不提的人工智能#支持Python成长的商业公司#Python成功之路小结##附:Python生态发展大事记#参考Python是现今最受欢迎的编程语言之一,2021年8月的TIOBE编程语言排行榜中,Python排名第二,仅次于C[1]。2017年

- Java 并发包之线程池和原子计数

lijingyao8206

Java计数ThreadPool并发包java线程池

对于大数据量关联的业务处理逻辑,比较直接的想法就是用JDK提供的并发包去解决多线程情况下的业务数据处理。线程池可以提供很好的管理线程的方式,并且可以提高线程利用率,并发包中的原子计数在多线程的情况下可以让我们避免去写一些同步代码。

这里就先把jdk并发包中的线程池处理器ThreadPoolExecutor 以原子计数类AomicInteger 和倒数计时锁C

- java编程思想 抽象类和接口

百合不是茶

java抽象类接口

接口c++对接口和内部类只有简介的支持,但在java中有队这些类的直接支持

1 ,抽象类 : 如果一个类包含一个或多个抽象方法,该类必须限定为抽象类(否者编译器报错)

抽象方法 : 在方法中仅有声明而没有方法体

package com.wj.Interface;

- [房地产与大数据]房地产数据挖掘系统

comsci

数据挖掘

随着一个关键核心技术的突破,我们已经是独立自主的开发某些先进模块,但是要完全实现,还需要一定的时间...

所以,除了代码工作以外,我们还需要关心一下非技术领域的事件..比如说房地产

&nb

- 数组队列总结

沐刃青蛟

数组队列

数组队列是一种大小可以改变,类型没有定死的类似数组的工具。不过与数组相比,它更具有灵活性。因为它不但不用担心越界问题,而且因为泛型(类似c++中模板的东西)的存在而支持各种类型。

以下是数组队列的功能实现代码:

import List.Student;

public class

- Oracle存储过程无法编译的解决方法

IT独行者

oracle存储过程

今天同事修改Oracle存储过程又导致2个过程无法被编译,流程规范上的东西,Dave 这里不多说,看看怎么解决问题。

1. 查看无效对象

XEZF@xezf(qs-xezf-db1)> select object_name,object_type,status from all_objects where status='IN

- 重装系统之后oracle恢复

文强chu

oracle

前几天正在使用电脑,没有暂停oracle的各种服务。

突然win8.1系统奔溃,无法修复,开机时系统 提示正在搜集错误信息,然后再开机,再提示的无限循环中。

无耐我拿出系统u盘 准备重装系统,没想到竟然无法从u盘引导成功。

晚上到外面早了一家修电脑店,让人家给装了个系统,并且那哥们在我没反应过来的时候,

直接把我的c盘给格式化了 并且清理了注册表,再装系统。

然后的结果就是我的oracl

- python学习二( 一些基础语法)

小桔子

pthon基础语法

紧接着把!昨天没看继续看django 官方教程,学了下python的基本语法 与c类语言还是有些小差别:

1.ptyhon的源文件以UTF-8编码格式

2.

/ 除 结果浮点型

// 除 结果整形

% 除 取余数

* 乘

** 乘方 eg 5**2 结果是5的2次方25

_&

- svn 常用命令

aichenglong

SVN版本回退

1 svn回退版本

1)在window中选择log,根据想要回退的内容,选择revert this version或revert chanages from this version

两者的区别:

revert this version:表示回退到当前版本(该版本后的版本全部作废)

revert chanages from this versio

- 某小公司面试归来

alafqq

面试

先填单子,还要写笔试题,我以时间为急,拒绝了它。。时间宝贵。

老拿这些对付毕业生的东东来吓唬我。。

面试官很刁难,问了几个问题,记录下;

1,包的范围。。。public,private,protect. --悲剧了

2,hashcode方法和equals方法的区别。谁覆盖谁.结果,他说我说反了。

3,最恶心的一道题,抽象类继承抽象类吗?(察,一般它都是被继承的啊)

4,stru

- 动态数组的存储速度比较 集合框架

百合不是茶

集合框架

集合框架:

自定义数据结构(增删改查等)

package 数组;

/**

* 创建动态数组

* @author 百合

*

*/

public class ArrayDemo{

//定义一个数组来存放数据

String[] src = new String[0];

/**

* 增加元素加入容器

* @param s要加入容器

- 用JS实现一个JS对象,对象里有两个属性一个方法

bijian1013

js对象

<html>

<head>

</head>

<body>

用js代码实现一个js对象,对象里有两个属性,一个方法

</body>

<script>

var obj={a:'1234567',b:'bbbbbbbbbb',c:function(x){

- 探索JUnit4扩展:使用Rule

bijian1013

java单元测试JUnitRule

在上一篇文章中,讨论了使用Runner扩展JUnit4的方式,即直接修改Test Runner的实现(BlockJUnit4ClassRunner)。但这种方法显然不便于灵活地添加或删除扩展功能。下面将使用JUnit4.7才开始引入的扩展方式——Rule来实现相同的扩展功能。

1. Rule

&n

- [Gson一]非泛型POJO对象的反序列化

bit1129

POJO

当要将JSON数据串反序列化自身为非泛型的POJO时,使用Gson.fromJson(String, Class)方法。自身为非泛型的POJO的包括两种:

1. POJO对象不包含任何泛型的字段

2. POJO对象包含泛型字段,例如泛型集合或者泛型类

Data类 a.不是泛型类, b.Data中的集合List和Map都是泛型的 c.Data中不包含其它的POJO

- 【Kakfa五】Kafka Producer和Consumer基本使用

bit1129

kafka

0.Kafka服务器的配置

一个Broker,

一个Topic

Topic中只有一个Partition() 1. Producer:

package kafka.examples.producers;

import kafka.producer.KeyedMessage;

import kafka.javaapi.producer.Producer;

impor

- lsyncd实时同步搭建指南——取代rsync+inotify

ronin47

1. 几大实时同步工具比较 1.1 inotify + rsync

最近一直在寻求生产服务服务器上的同步替代方案,原先使用的是 inotify + rsync,但随着文件数量的增大到100W+,目录下的文件列表就达20M,在网络状况不佳或者限速的情况下,变更的文件可能10来个才几M,却因此要发送的文件列表就达20M,严重减低的带宽的使用效率以及同步效率;更为要紧的是,加入inotify

- java-9. 判断整数序列是不是二元查找树的后序遍历结果

bylijinnan

java

public class IsBinTreePostTraverse{

static boolean isBSTPostOrder(int[] a){

if(a==null){

return false;

}

/*1.只有一个结点时,肯定是查找树

*2.只有两个结点时,肯定是查找树。例如{5,6}对应的BST是 6 {6,5}对应的BST是

- MySQL的sum函数返回的类型

bylijinnan

javaspringsqlmysqljdbc

今天项目切换数据库时,出错

访问数据库的代码大概是这样:

String sql = "select sum(number) as sumNumberOfOneDay from tableName";

List<Map> rows = getJdbcTemplate().queryForList(sql);

for (Map row : rows

- java设计模式之单例模式

chicony

java设计模式

在阎宏博士的《JAVA与模式》一书中开头是这样描述单例模式的:

作为对象的创建模式,单例模式确保某一个类只有一个实例,而且自行实例化并向整个系统提供这个实例。这个类称为单例类。 单例模式的结构

单例模式的特点:

单例类只能有一个实例。

单例类必须自己创建自己的唯一实例。

单例类必须给所有其他对象提供这一实例。

饿汉式单例类

publ

- javascript取当月最后一天

ctrain

JavaScript

<!--javascript取当月最后一天-->

<script language=javascript>

var current = new Date();

var year = current.getYear();

var month = current.getMonth();

showMonthLastDay(year, mont

- linux tune2fs命令详解

daizj

linuxtune2fs查看系统文件块信息

一.简介:

tune2fs是调整和查看ext2/ext3文件系统的文件系统参数,Windows下面如果出现意外断电死机情况,下次开机一般都会出现系统自检。Linux系统下面也有文件系统自检,而且是可以通过tune2fs命令,自行定义自检周期及方式。

二.用法:

Usage: tune2fs [-c max_mounts_count] [-e errors_behavior] [-g grou

- 做有中国特色的程序员

dcj3sjt126com

程序员

从出版业说起 网络作品排到靠前的,都不会太难看,一般人不爱看某部作品也是因为不喜欢这个类型,而此人也不会全不喜欢这些网络作品。究其原因,是因为网络作品都是让人先白看的,看的好了才出了头。而纸质作品就不一定了,排行榜靠前的,有好作品,也有垃圾。 许多大牛都是写了博客,后来出了书。这些书也都不次,可能有人让为不好,是因为技术书不像小说,小说在读故事,技术书是在学知识或温习知识,有

- Android:TextView属性大全

dcj3sjt126com

textview

android:autoLink 设置是否当文本为URL链接/email/电话号码/map时,文本显示为可点击的链接。可选值(none/web/email/phone/map/all) android:autoText 如果设置,将自动执行输入值的拼写纠正。此处无效果,在显示输入法并输

- tomcat虚拟目录安装及其配置

eksliang

tomcat配置说明tomca部署web应用tomcat虚拟目录安装

转载请出自出处:http://eksliang.iteye.com/blog/2097184

1.-------------------------------------------tomcat 目录结构

config:存放tomcat的配置文件

temp :存放tomcat跑起来后存放临时文件用的

work : 当第一次访问应用中的jsp

- 浅谈:APP有哪些常被黑客利用的安全漏洞

gg163

APP

首先,说到APP的安全漏洞,身为程序猿的大家应该不陌生;如果抛开安卓自身开源的问题的话,其主要产生的原因就是开发过程中疏忽或者代码不严谨引起的。但这些责任也不能怪在程序猿头上,有时会因为BOSS时间催得紧等很多可观原因。由国内移动应用安全检测团队爱内测(ineice.com)的CTO给我们浅谈关于Android 系统的开源设计以及生态环境。

1. 应用反编译漏洞:APK 包非常容易被反编译成可读

- C#根据网址生成静态页面

hvt

Web.netC#asp.nethovertree

HoverTree开源项目中HoverTreeWeb.HVTPanel的Index.aspx文件是后台管理的首页。包含生成留言板首页,以及显示用户名,退出等功能。根据网址生成页面的方法:

bool CreateHtmlFile(string url, string path)

{

//http://keleyi.com/a/bjae/3d10wfax.htm

stri

- SVG 教程 (一)

天梯梦

svg

SVG 简介

SVG 是使用 XML 来描述二维图形和绘图程序的语言。 学习之前应具备的基础知识:

继续学习之前,你应该对以下内容有基本的了解:

HTML

XML 基础

如果希望首先学习这些内容,请在本站的首页选择相应的教程。 什么是SVG?

SVG 指可伸缩矢量图形 (Scalable Vector Graphics)

SVG 用来定义用于网络的基于矢量

- 一个简单的java栈

luyulong

java数据结构栈

public class MyStack {

private long[] arr;

private int top;

public MyStack() {

arr = new long[10];

top = -1;

}

public MyStack(int maxsize) {

arr = new long[maxsize];

top

- 基础数据结构和算法八:Binary search

sunwinner

AlgorithmBinary search

Binary search needs an ordered array so that it can use array indexing to dramatically reduce the number of compares required for each search, using the classic and venerable binary search algori

- 12个C语言面试题,涉及指针、进程、运算、结构体、函数、内存,看看你能做出几个!

刘星宇

c面试

12个C语言面试题,涉及指针、进程、运算、结构体、函数、内存,看看你能做出几个!

1.gets()函数

问:请找出下面代码里的问题:

#include<stdio.h>

int main(void)

{

char buff[10];

memset(buff,0,sizeof(buff));

- ITeye 7月技术图书有奖试读获奖名单公布

ITeye管理员

活动ITeye试读

ITeye携手人民邮电出版社图灵教育共同举办的7月技术图书有奖试读活动已圆满结束,非常感谢广大用户对本次活动的关注与参与。

7月试读活动回顾:

http://webmaster.iteye.com/blog/2092746

本次技术图书试读活动的优秀奖获奖名单及相应作品如下(优秀文章有很多,但名额有限,没获奖并不代表不优秀):

《Java性能优化权威指南》