Luma AI:基于NeRF,文字、图片、视频都可生成3D模型

上周,我们刚刚报道了3D内容方案商Luma AI完成2000万美元A轮融资消息,本周Luma AI继续宣布推出视频转3D场景API:Video-to-3D API。简单来说,现在Luma正式开放了NeRF能力,意味着正在进行商业化探索。

正如最近很火爆的GPT等生成式AI那样,NeRF在最近两年同样是一项关注度极高的方案,而以NeRF为核心的Luma AI发展同样迅速。

可能很多人还不熟悉Luma AI这家公司,它是一个专注于3D内容方案的平台,短短半年之内先后基于NeRF上线了文生3D模型、网页版全体积NeRF渲染器、视频到3D模型API等功能。

关于Luma AI

前面我们提到,Luma的核心就NeRF,简单来讲这是一套三维重建技术方案,它的特点是基于现有视角的图像生成新视角的图像。

有了NeRF,可以说你手里的相机不单单只是拍照这么简单,而是变成数据采集装置,通过拍摄大量图片或视频,即可创建出一个可微分的三维场景。比起传统的摄影测量方案,NeRF的优势是可以用更少量的数据生成三维模型。

据青亭网了解,Luma公司成立于2021年9月,总部位于美国加州,创始人:Amit Jain、Alex Yu,分别在3D视觉、机器学习、实时图形学有所建树。

近半年发展历程:

- 22年10月,开放网页版Luma;

- 22年11月,iOS版App开始测试;

- 22年12月,推出文生3D模型功能;

- 23年1月,iOS版App开始支持NeRF Reshoot;

- 23年1月,升级NeRF,自动去除杂影;

- 23年2月,推出网页版全体积NeRF渲染器;

- 23年3年,iOS版App 支持AR预览;

- 23年3月,推出视频转3D API。

那么,接下来我们分开来解析一下Luma的产品组合。

Luma App

实际上,上述很多功能都是组合形式出现,例如手机App,当前Luma只推出了iOS客户端。可以通过iPhone上传视频,基于NeRF生成3D场景。手机版App的推出可以说是一个大的突破,因为之前市面上并没有类似的NeRF产品出现。

很快,经过网友们的测试发现Luma NeRF的效果非常出色,色彩、光影、清晰度等方面都良好。据悉,Luma对NeRF进行了改良和优化,才有这么好的表现。

视频效果

导出3D模型效果

iOS端支持导入视频,以及引导模式和自由模式三种:

- 导入模式,这个很好理解,和Web模式功能类似,对设备和视频理论上要求最低。

- 引导模式,需要360度拍摄,App将具体提示框提醒你的拍摄视角、拍摄位置;

- 自由模式,支持非360度(部分视角)拍摄,App不会给出明确提示框,当然也需要尽可能拍摄多个角度。

引导模式、和自由模式需iPhone 11或更新机型,而查看3D模型要求是iPhone X或更新机型。

根据@未来GIS实验室 的测试,小物体渲染后细节表现不错,室内场景可还原墙面和地板的反光,室外场景的效果同样非常逼真,整体的效果可以说是非常不错。

NeRF Reshoot也是一个有意思的功能,通过生成的3D场景你可以“重新拍照”,比如你可以从其它角度查看图片并重新拍照;重新定制虚拟相机路线,生成一段新的视频;修改图片/视频比例;调整帧率等等,也可以在AR模式下结合6DoF模式还原当时拍摄场景,算是一项进阶玩法。

另外,Luma App还加入AR预览模式,这个没啥难度,应该就是基于ARKit的体验拓展。

网页和API类

网页版本目前集成了主流功能,包括:网页版Luma、文字转3D模型、视频转3D API。

1,网页版Luma

网页版Luma就是自行上传照片、视频来进行三维重建,网页版可以上传更大的文件,目前视频和图片(ZIP压缩包)体积最大限制5GB,通常来讲照片的生成质量比视频要好一些,前提是照片是进行特定拍摄,无明显模糊。

另外,Luma官网还会列出一些精选的3D场景,大家可以用于参考。当然,在App里可以查看或编辑其他人的精选3D场景。

2,文字转3D模型

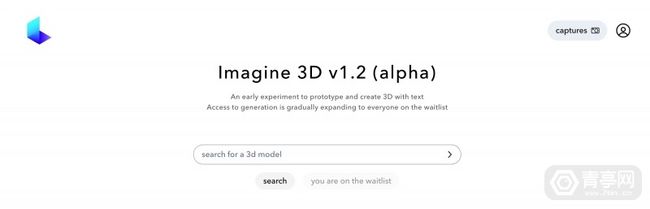

文字转3D模型功能目前依然未全量开放,就像是Midjourney一样,只需输入文字描述,即可生成对应的3D模型。

文字生成3D模型效果图

上图是文字生成3D模型的示例,官网上也有更多示例,并不是每一个质量都很好。当然,目前也处于测试阶段,效果也跟你的Prompt有很大关系,感兴趣可以先加入等待列表。

3,视频转3D API

效果方面,视频转3D的效果几乎和网页版一致。价格方面,转换一个视频费用1美元,就是单纯的按照次数收费,不管视频容量大小,所以当然是尽量丰富视频的细节,转换时间在30分钟左右。

Luma表示,这一方案将为:电子商务、游戏美术、影视特效等领域发展重要价值,因为此前创建3D模型的价格在60-1500美元,时间需要2-10周(Luma提供数据)。

以下是Luma提供的用于转换3D场景的视频拍摄技巧:

捕获过程

捕获速度:运动模糊会显著降低重建质量。为了达到最佳效果,慢慢移动手机,尽量避免快速移动,尤其是旋转。

场景覆盖:为了获得最佳效果,应该从尽可能多的独特视角捕捉物体或场景。此外,在拍摄时最好移动手机(在3D空间中),而不是从静止位置旋转它。站在同一个地方,在一个球体中向外捕捉通常不太好。引导捕获模式是一个很好的选择,以确保足够的覆盖。

对象大小:对于引导捕获,任何可以从所有角度(包括顶部和底部)轻松查看的对象都是一个很好的候选对象。对于自由形式的捕捉来说,任何东西都是公平的,尽管更好的覆盖范围会产生更好的结果,所以较大的物体可能难以获得完全干净的结果。

物体距离:为了获得最佳效果,在扫描时尽量保持整个物体在帧中。这样做将为应用程序提供更多关于反射和物体形状的信息,从而实现更准确的重建。

物体材质:目前,该应用程序挣扎于复杂的反射(例如,曲面镜面),弯曲的透明物体(例如,车窗或塑料水瓶),以及非常大的无纹理表面(例如白墙)。大多数其他材料都很好。

捕捉环境光照水平:该应用程序可以在大多数光照条件下捕捉物体,只要纹理仍然可以识别(即,没有被洗掉或完全黑暗)。照明条件将被烘焙,所以场景应该点亮,但你希望它出现在最终的结果。

移动的物体:在捕捉过程中,场景中的任何运动都可能降低最终结果的质量。例如,在风中移动的树叶可能会导致细节的丢失,而在背景中移动的人可能会引入伪影。拍摄时请注意不要将手指/手臂/腿伸入画面。

相机设置

视频设置注意事项:如上传视频,需关闭视频稳定选项,尤其安卓手机;iOS需禁止使用“HDR视频”选项。

曝光:建议使用固定曝光,尽管动态曝光对室外场景有益。

捕获格式

基于图片生成:可在Luma网页上传图片压缩包。通常照片比视频质量更高,但需特定拍摄,无模糊,并包含EXIF元数据。

提醒:可上传原始格式图像(如CR3和DNG等)和HDR图像(.exr),以实现更高的动态范围,以提高质量。如果使用原始文件,元数据将用于sRGB渲染(而底层NeRF将是HDR)。使用EXR,渲染的颜色将在当前颜色空间中,因为没有colorspace元数据。

不建议上传大于4K分辨率的图片,当前版本对高分辨率图像效率更低;

鱼眼相机和360相机:360度视频可以更有效实现大面积,但很多360相机实际上是双鱼眼相机,进行拼接形成,拼接可能会导致失真。但可以手动在网页版上传,注意选择对应的模式。注:单鱼眼模式Insta360 .insv文件可以直接重命名为mp4上传;多鱼眼模式可将Insta360 .insv文件放在一个zip上传。