Docker:(十)consul注册中心、注册机

目录

一:docker consul概述和特性

1.1consul概述

1.2consul的特性

1.3容器服务更新与发现

1.4consul-template概述

二:consul使用场合、优势及端口

2.1consul 使用场合

2.2consul的优势

2.3consul端口

三:基于docker的consul服务搭建

3.1server部署(192.168.137.20)

3.2client部署(192.168.137.15)

3.3配置template模板自动更新

3.4测试访问代理服务器

3.5consul多节点配置

四:总结

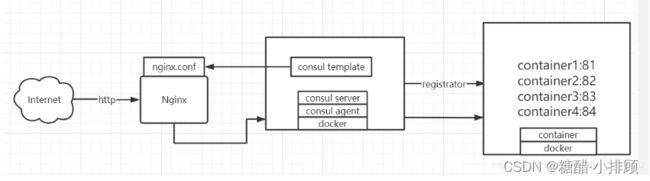

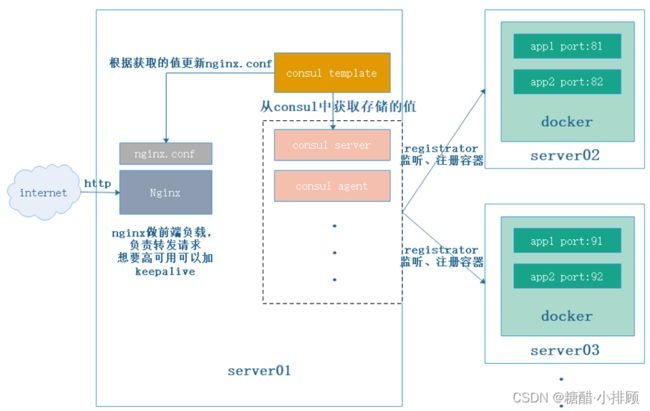

引言:consul也可以说是一个注册中心,可以将监控的应用服务的基本信息,都注册到consul这里,然后consul将这些节点的信息进行制作一个可以被前端所能识别的更新的模板,然后将这个模板同步到主页的更新列表中,一旦后面的应用服务节点增加信息的服务,则会及时的将信息更新到consul中,consul再去通知主页进行更新。

一:docker consul概述和特性

1.1consul概述

Consul 是一个支持多数据中心分布式高可用的 服务发现 和 配置共享 的服务软件,由 HashiCorp 公司用 Go 语言开发,基于 Mozilla Public License 2.0 的协议进行开源。

Consul是分布式的、高可用的、可横向扩展的用于实现分布式系统的服务发现与配置。

支持多数据中心、分布式高可用的、服务发现和配置共享。采用Raft算法,用来保证服务的高可用。内置了服务注册与发现框架、分布一致性协议实现、健康检查、Key/Value存储、多数据中心方案,不再需要依赖其他工具(比如ZooKeeper等)。服务部署简单,只有一个可运行的二进制的包。每个节点都需要运行agent,他有两种运行模式server和client。每个数据中心官方建议需要3或5个server节点以保证数据安全,同时保证server-leader的选举能够正确的进行。

1.2consul的特性

- Consul 支持健康检查,并允许 HTTP 、GRPC 和 DNS 协议调用 API 存储键值对。

- 一致性协议采用 Raft 算法,用来保证服务的高可用。 使用 GOSSIP 协议管理成员和广播消息, 并且支持 ACL 访问控制。

支持健康检查、允许存储键值对

基于Golong语言,可移植性强

支持ACL访问控制consul的实例叫agent,agent有两种运行模式:server和client 。

官方建议每个Consul Cluster数据中心至少有3个或以上的运行在Server Mode的Agent,Client节点不限。

1.3容器服务更新与发现

先发现再更新,发现的是后端节点上容器的变化(registrator),更新的是nginx配置文件(agent)

registrator:是consul安插在docker容器里的眼线,用于监听监控节点上容器的变化(增加或减少,或者宕机),一旦有变化会把这些信息告诉并注册在consul server端(使用回调和协程的方式,所以它的延迟和资源消耗会很少),consul server发生一旦发生注册列表的变化后,会把注册的信息告诉agent

agent(代理):用来控制consul template模板,用template组件去和nginx.conf来进行对接,模板里全是变量,用变量的方式去加载后端由注册到consul server端之后,server端会把信息告诉agent,agent和template进行对接,写入template,template就有了镜像,更新完之后会作为nginx.conf子配置文件被前端的nginx识别,consul agent会控制reload之后会识别nginx.conf配置文件中的变化,相当于识别后端的节点,就可以在地址池中动态调整自己后端资源

1.4consul-template概述

Consul-Template是一个守护进程,用于实时查询Consul集群信息

Consul-Template可以更新文件系统上任意数量的指定模板,生成配置文件

更新完成以后,可以选择运行shell命令执行更新操作,重新加载Nginx。

Consul-Template可以查询Consul中的服务目录、Key、Key-values等。

这种强大的抽象功能和查询语言模板可以使Consul-Template特别适合动态的创建配置文件。

例如:创建Apache/Nginx Proxy Balancers、Haproxy Backends

二:consul使用场合、优势及端口

2.1consul 使用场合

- Docker 容器的注册与配置共享

- Coreos 实例的注册与配置共享

- SaaS 应用的配置共享、服务发现和健康检查。

- vitess 集群

- 与 confd 服务集成,动态生成 nginx 和 haproxy 配置文件

2.2consul的优势

使用 Raft 算法来保证一致性,比复杂的 Paxos 算法更直接。相比较而言,zookeeper 采用的是 Paxos,而 etcd使用的则是 Raft。

支持多数据中心,内外网的服务采用不同的端口进行监听。

多数据中心集群可以避免单数据中心的单点故障,而其部署则需要考虑网络延迟,分片等情况等。 zookeeper 和 etcd均不提供多数据中心功能的支持。

支持 健康检查。 etcd 不提供此功能。

支持 HTTP、DNS 和 GPRS 协议接口。 zookeeper 的集成较为复杂,etcd 只支持 http 协议。

官方提供 WEB管理界面,etcd 无此功能。

2.3consul端口

| 端口 | 说明 |

| TCP/8300 | 8300 |

| TCP/UDP/8301 | 8301端口用于单个数据中心所有节点之间的互相通信,即对LAN池信息的同步。它使得整个数据中心能够自动发现服务器地址,分布式检测节点故障,事件广播(如领导选举时间)。 |

| TCP/UDP/8302 | 8302端口用于单个或多个数据中心之间的服务器节点的信息同步,即对WAN池信息的同步。它针对互联网的高延迟进行了优化,能够实现跨数据中心请求。 |

| 8500 | 8500端口基于HTTP协议,用于API接口或web UI访问 |

| 8600 | 8600端口作为DNS服务器,它使得我们可以通过节点名查询节点信息 |

三:基于docker的consul服务搭建

| 主机 | 主机IP | 安装工具 |

| consul服务器 | 192.168.137.20 | Docker、Consul、Consul-template模板、nginx代理服务 |

| 容器服务器 | 192.168.137.15 | Docker、registrator、nginx容器 |

建立Consul服务

每个提供服务的节点上都要部署和运行Consul的agent

Consul agent有两种运行模式

Server

Client

Server和Client只是Consul集群层面的区分,与搭建在Cluster之上的应用服务无关

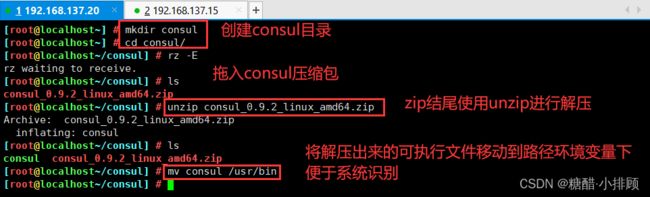

3.1server部署(192.168.137.20)

mkdir /root/consul

cd consul

rz consul_0.9.2_linux_amd64.zip

unzip consul_0.9.2_linux_amd64.zip

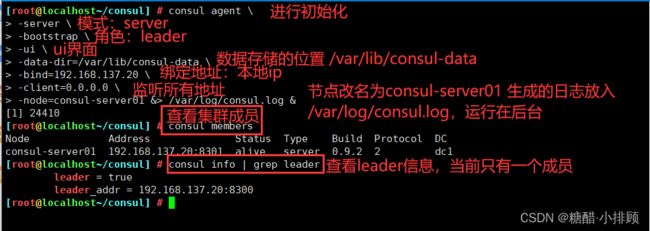

mv consul /usr/binconsul agent \

-server \

-bootstrap \

-ui \

-data-dir=/var/lib/consul-data \

-bind=192.168.184.11 \

-client=0.0.0.0 \

-node=consul-server01 &> /var/log/consul.log &

consul members

consul info | grep leader| 模块 | 解释 |

| -server | 以server身份启动。默认是client |

| -bootstrap | 用来控制一个server是否在bootstrap模式, 在一个数据中心中只能有一个server处于bootstrap模式, 当一个server处于bootstrap模式时,可以自己选举为server-leader |

| -bootstrap-expect=2 | 集群要求的最少server数量,当低于这个数量,集群即失效 |

| -ui | 指定开启UI界面,这样可以通过http://localhost:8500/ui 这样的地址访问consul 自带的web UI界面 |

| -data-dir | 指定数据存储目录 |

| -bind | 指定用来在集群内部的通讯地址,集群内的所有节点到此地址都必须是可达的,默认是0.0.0.0 |

| -client | 指定consul 绑定在哪个client 地址上,这个地址提供HTTP、 DNS、 RPC等服务,默认是127.0.0.1 |

| -node | 节点在集群中的名称,在一个集群中必须是唯一 的,默认是该节点的主机名 |

| -datacenter | 指定数据中心名称,默认是dc1 |

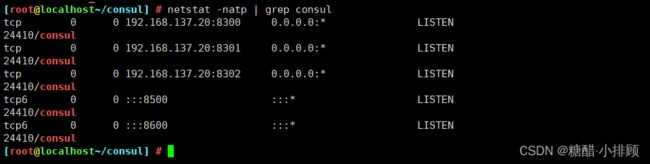

netstat -natp | grep consul

启动consul后默认监听的端口

| 端口号 | 端口说明 |

| 8300 | replication、 leader farwarding的端口 |

| 8301 | lan cossip的端口 |

| 8302 | wan gossip的端口 |

| 8500 | webui界面的端口 |

| 8600 | 使用dns协议查看节点信息的端口 |

通过http api获取集群信息

curl 127.0.0.1:8500/v1/status/peers #查看集群server成员

curl 127.0.0.1:8500/v1/status/leader #集群server-leader

curl 127.0.0.1:8500/v1/catalog/services #注册的所有服务

curl 127.0.0.1:8500/v1/catalog/nginx #查看nginx服务信息

curl 127.0.0.1:8500/v1/catalog/nodes #集群节点详细信息

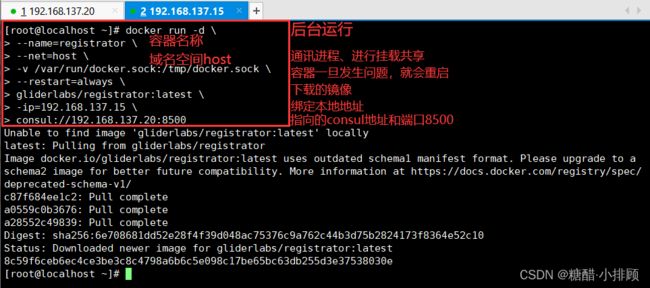

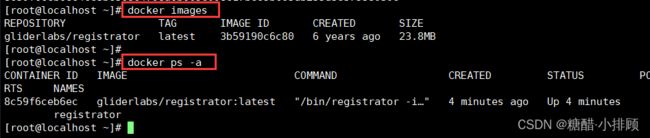

3.2client部署(192.168.137.15)

容器服务自动加入nginx集群

1、安装Gliderlabs/Registrator Gliderlabs/Registrator

可检查容器运行状态自动注册,还可注销docker容器的服务 到服务配置中心

目前支持Consul、Etcd和SkyDNS2

在192.168.137.15节点上,执行以下操作

docker run -d \

--name=registrator \

--net=host \

-v /var/run/docker.sock:/tmp/docker.sock \

--restart=always \

gliderlabs/registrator:latest \

-ip=192.168.137.15 \

consul://192.168.137.20:8500

| 命令 | 解释 |

| -net=host | 把运行的docker容器设定为host网络模式 |

| -v /var/run/docker.sock:/tmp/docker.sock | 把宿主机的Docker守护进程(Docker daemon)默认监听的Unix域套接字挂载到容器中 |

| –restart=always | 设置在容器退出时总是重启容器 |

| -ip | 刚才把network指定了host模式,所以我们指定ip为宿主机的ip |

| consul | 指定consul服务器的Ip和端口 |

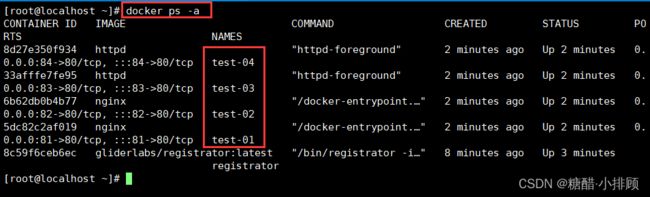

systemctl restart docker

docker run -itd -p:81:80 --name test-01 -h test01 nginx

docker run -itd -p:82:80 --name test-02 -h test02 nginx

docker run -itd -p:83:80 --name test-03 -h test03 httpd

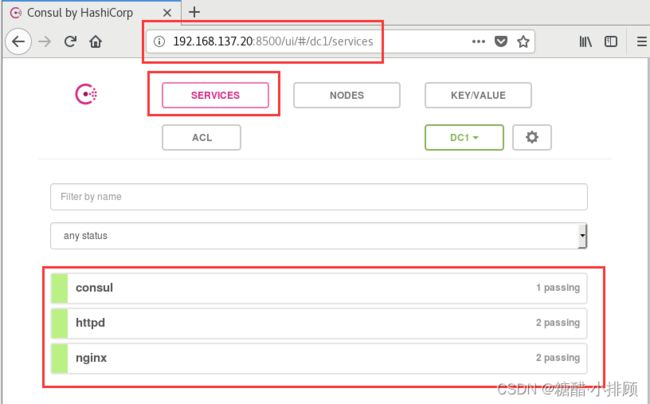

docker run -itd -p:84:80 --name test-04 -h test04 httpd真机访问http://192.168.137.20:8500

此时应该可以发现5个服务

ps:访问不到页面,请检查防火墙是否关闭

3.3配置template模板自动更新

server(192.168.137.20)

Consul-Template是一个守护进程,用于实时查询Consul集群信息,并更新文件系统上任意数量的指定模板,生成配置文件,更新完成以后,可以查询Consul中的服务目录,Key、Key-values等。

cd consul/

vim nginx.ctmpl

upstream http_backend {

{{range service "nginx"}}

server {{.Address}}:{{.Port}};

{{end}}

}

server {

listen 100;

server_name localhost 192.168.137.20;

access_log /var/log/nginx/lic.com-access.log;

index index.html index.php;

location / {

proxy_set_header HOST $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header Client-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_pass http://http_backend;

}

}

====>:wq

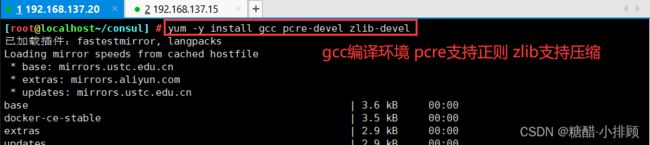

yum -y install gcc pcre-devel zlib-devel

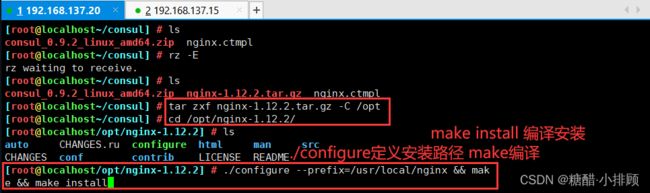

rz nginx-1.12.2.tar.gz

tar zxvf nginx-1.12.2.tar.gz -C /opt

cd /opt/nginx-1.12.2

./configure --prefix=/usr/local/nginx

make && make install

vim /usr/local/nginx/conf/nginx.conf

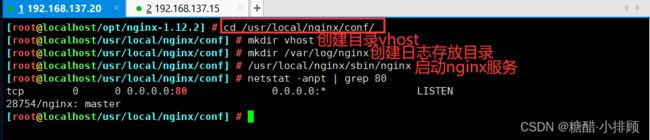

//19 include vhost/*.conf;cd /usr/local/nginx/conf/

mkdir vhost

mkdir /var/log/nginx

/usr/local/nginx/sbin/nginx #启动nginx服务

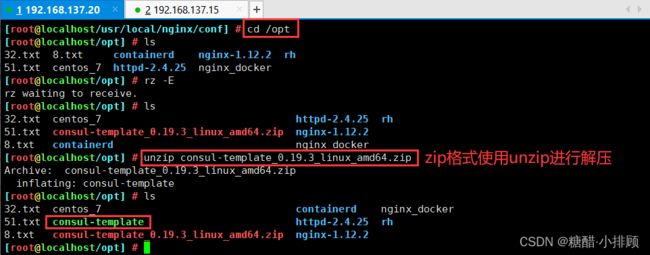

cd /opt

rz consul-template_0.19.3_linux_amd64.zip

unzip consul-template_0.19.3_linux_amd64.zipmv consul-template /usr/bin

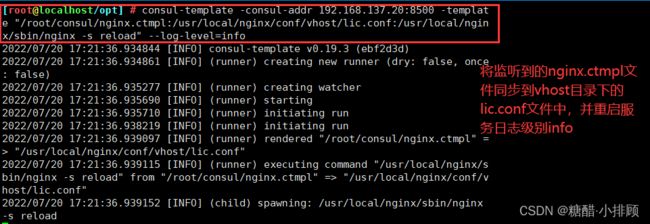

consul-template -consul-addr 192.168.137.20:8500 -template "/root/consul/nginx.ctmpl:/usr/local/nginx/conf/vhost/lic.conf:/usr/local/nginx/sbin/nginx -s reload" --log-level=info

#将监听到的nginx.ctmpl文件同步到vhost目录下的lic.conf文件中,并重启服务日志级别info再打开一个终端:

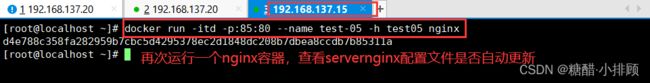

client(192.168.137.15)

docker run -itd -p:85:80 --name test-05 -h test05 nginx3.4测试访问代理服务器

是否可以完成代理访问轮询

192.168.137.20

http://192.168.137.20:100/

docker logs -f test-01

docker logs -f test-02

docker logs -f test-053.5consul多节点配置

添加一台已有docker环境的服务器192.168.137.10加入已有的群集中

consul agent \

-server \

--bootstrap \

-ui \

-data-dir=/var/lib/consul-data \

-bind=192.168.137.20 \

-client=0.0.0.0 \

-node=consul-server02 \

-enable-script-checks=true \

-datacenter=dc1 \

-join 192.168.137.10 &> /var/log/consul.log &

--enable-script-ckecks=true:设置检查服务为可用

-datacenter:数据中心名称

-join:加入到已有的集群中四:总结

consul是google开源的一个使用go语言开发的服务管理软件。

在client模式下,所有注册到当前节点的服务会被转发到server节点,本身是不持久化这些信息。

在server模式下,功能和client模式相似,唯一不同的是,它会把所有的信息持久化到本地,这样遇到故障,信息是可以被保留的。server-leader是所有server节点的老大,它和其它server节点不同的是,它需要负责同步注册的信息给其它的server节点,同时也要负责各个节点的健康监测。

Consul的特性

- 支持健康检查、允许存储键值对

- 基于Golong语言,可移植性强

- 支持ACL访问控制