- 借助AI学习开源代码git0.7之二核心概念和总结

余很多之很多

源码学习git学习

借助AI学习开源代码git0.7之二核心概念和总结核心概念:对象数据库(ObjectDatabase):内容寻址:所有数据都通过其内容的SHA1哈希值来唯一标识和存储。这意味着任何内容的更改都会导致其SHA1哈希值的变化,从而生成一个新的对象。不可变性:一旦对象被创建并存储,它就是不可变的。这种设计保证了数据的完整性和历史的可靠性。对象类型:Blob(二进制大对象):存储文件的实际内容。它是最基本

- Mysql索引底层数据结构及原理解析

有缘再见

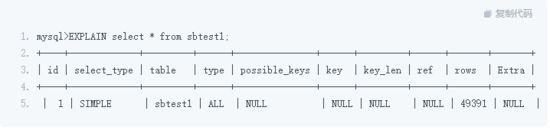

一、索引是什么?索引是帮助mysql高效获取数据排序好的数据结构。索引存储在文件里面。磁盘存取原理:1.寻道时间(速度慢,费时)2.旋转时间(速度较快)磁盘构造数据文件存储在磁盘的磁道划分出的扇区里面。磁盘指针先去找到数据存储在哪一个磁道(寻道时间),然后逆时针旋转找打扇区(旋转时间)。现在都在优化减少寻道时间。二、常见的数据结构介绍。(一)二叉树。二叉树示意图定义:二叉树(binarytree)

- 2021,零日漏洞最疯狂的一年

GoUpSec

2021年,零日漏洞的数量增长了一倍,价格增长了十倍,但攻击回报增长了百倍!零日漏洞利用,即通过以前未知的漏洞发起网络攻击的方式,是黑客手中最有价值的武器,因为这些漏洞在公开市场上的价格很轻松就能超过100万美元。近日,麻省理工科技评论走访了多个数据库、安全研究人员和网络安全公司,发现今年网络安全防御者的人数达到了有史以来的最高水平,但零日漏洞的数量也创下了新的记录。根据零日漏洞追踪项目的统计(下

- 新闻资讯|基于springboot的新闻资讯系统设计与实现(附项目源码+论文+数据库)

code.song

springboot数据库后端

私信或留言即免费送开题报告和任务书(可指定任意题目)目录一、摘要二、相关技术三、系统设计四、数据库设计五、核心代码六、论文参考七、源码获取一、摘要传统信息的管理大部分依赖于管理人员的手工登记与管理,然而,随着近些年信息技术的迅猛发展,让许多比较老套的信息管理模式进行了更新迭代,文章信息因为其管理内容繁杂,管理数量繁多导致手工进行处理不能满足广大用户的需求,因此就应运而生出相应的新闻资讯系统。本新闻

- 如何进行MySQL配置性能优化

anpeng2025

技术爽文大集合架构师mysql性能优化数据库oracle华为学习OracleERP

MySQL的性能优化是一个系统工程,涉及配置调整、查询优化、架构设计等多个层面。下面我作为架构师,将重点讲解关键的配置参数优化,这些是提升MySQL性能最常见且效果显著的基础步骤:核心原则:基于硬件和工作负载:没有放之四海而皆准的配置。优化必须考虑你的服务器硬件(内存大小、CPU核数、磁盘类型-SSD还是HDD)以及你的应用负载特点(读多写少?写多读少?事务型还是分析型?)。循序渐进,监控验证:每

- Apache与Nginx服务器区别简述

camellia_halo_

Apache与Nginx服务器区别1)nginx和apache的软件底层架构不一样。①:Nginx的并发性要比apache好很多;②:nginx属于轻量级服务器软件,apache属于重量级软件;③:nginx在处理静态页的效率要比apache好很多,apache在处理动态页面上的效率要比nginx高④:apache在安全性要比nginx要好。因此有一种不常用的组合:lnamp。2)运行模式不同的。

- Linux教程(4)----[hive数据仓库工具]

.房东的猫

Linux教程(完善中~~)linux

Hive基本概念Hive简介什么是HiveHive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供类SQL查询功能。为什么使用Hive直接使用hadoop所面临的问题人员学习成本太高

- Java:对给定的字符串和给定的模式执行Boyer-Moore搜索算法(附带源码)

Katie。

Java算法完整教程java开发语言

一、项目背景详细介绍在文本处理与信息检索中,需要在海量文本中高效地查找模式串(Pattern)。经典的朴素搜素在最坏情况下时间复杂度为O(N·M),效率不够高。Boyer–Moore算法则采用“坏字符”与“好后缀”两种启发规则,从模式尾部匹配开始,通常能大幅跳过不可能匹配的位置,平均时间复杂度接近O(N/M),在实际应用(如grep、数据库索引)中非常高效。本项目旨在用Java实现Boyer–Mo

- springboot注册servlet

hie98894

springbootservlethive

在SpringBoot应用中,虽然SpringMVC已经提供了强大的功能来处理HTTP请求,但在某些情况下,我们可能仍需要直接注册和使用Servlet。本文将详细介绍如何在SpringBoot中注册Servlet。1.什么是Servlet?Servlet是JavaEE中的一种服务器端组件,用于处理HTTP请求和生成响应。Servlet最常见的用途是创建动态Web内容,例如表单处理和数据库查询结果的

- 5个坑?1个法则!数据库索引的最左前缀魔法揭秘:从10秒到0.1秒的逆袭!

墨瑾轩

数据库学习数据库oraclesql

关注墨瑾轩,带你探索编程的奥秘!超萌技术攻略,轻松晋级编程高手技术宝库已备好,就等你来挖掘订阅墨瑾轩,智趣学习不孤单即刻启航,编程之旅更有趣**最左前缀法则——数据库的“最左”情结**问题1:索引明明存在,为什么查询还是慢到怀疑人生?案例:--创建用户表CREATETABLEusers(idINTPRIMARYKEY,nameVARCHAR(50),ageINT,emailVARCHAR(100)

- 解决SpringBoot 连接数据库失败,报错Error querying database.

在SpringBoot项目中,想连接数据库查询数据时,发现页面报出“WhitelabelErrorPageThelastpacketsentsuccessfullytotheserverwas0millisecondsago.Thedriverhasnotreceivedanypacketsfromtheserver…”的错误,大致意思是:在连接数据库时出现意外,导致无法连接。出现上述情况,极大可

- Mybatis与Spring的整合

知向谁边

1、MyBatis与Spring整合所需JAR包的种类MyBatis与Spring整合所需JAR包主要包括:Spring框架所需的JAR包、MyBatis框架所需的JAR包、MyBatis与Spring整合的中间JAR、数据库驱动JAR包,以及数据源所需的JAR包。2、MapperFactoryBean和MapperScannerConfigurerMapperFactoryBean是MyBati

- iOS 审核 4.3 (b) 【审核机制与未上架代码的数据库策略】

976503335

iosflutterswiftios开发objective-c

提审但未上架的IPA代码是否会被录入苹果特征库?这个问题非常重要,因为这是解决4.3(b)的核心问题1.苹果如何处理未上架的IPA代码?假设1:会录入特征库理由:苹果需要从首次提审就防范“马甲包”,即使未上架,代码特征也可能被记录(尤其是因4.3被拒的应用)。技术上,提取二进制代码特征(如代码结构、第三方库、资源文件哈希等)的成本极低,苹果完全有能力建立全量数据库。问题:未上架的代码量远大于已上架

- springboot整合Swagger

志华2020

Swagger简介1、认识SwaggerSwagger是一个规范和完整的框架,用于生成、描述、调用和可视化RESTful风格的Web服务。总体目标是使客户端和文件系统作为服务器以同样的速度来更新。文件的方法,参数和模型紧密集成到服务器端的代码,允许API来始终保持同步。作用:1.接口的文档在线自动生成。2.功能测试。Swagger是一组开源项目,其中主要要项目如下:Swagger-tools:提供

- ARTS-第七周

梧上擎天

Algorithm一、用链表和二叉树实现Set集合GitHub地址二、散列表散列表就是使用数组下标随机访问时候复杂度为O(1)的特性,当我们按照键值查找元素时,通过散列函数将key转化为下标然后进行访问,当有大量散列冲突时会退化为O(n)的时间复杂度。解决散列冲突的方法:开放寻址法和链表法ReviewFlink动态表概念原文地址流和表为什么可以相互转换呢?我们都知道传统Mysql的主从复制是通过b

- Redis 线上操作最佳实践

阿贾克斯的黎明

javaredis

在2024年9月19日,Redis作为一种高性能的内存数据库,在许多线上应用中发挥着重要作用。为了确保Redis在生产环境中的稳定运行和高效性能,以下是一些Redis线上操作的最佳实践。一、配置优化1.内存设置-根据实际需求合理设置Redis的内存限制。可以通过maxmemory参数来限制Redis使用的内存大小,避免因内存使用过多导致系统内存不足。-同时,设置合适的内存淘汰策略,如volatil

- mysql笔记17视图

程宇寒

mysql笔记视图

mysql笔记17视图一、含义mysql5.1版本出现的新特性,本身是一个虚拟表,它的数据来自于表,通过执行时动态生成。好处:1、简化sql语句2、提高了sql的重用性3、保护基表的数据,提高了安全性二、创建createview视图名as查询语句;三、修改方式一:createorreplaceview视图名as查询语句;方式二:alterview视图名as查询语句四、删除dropview视图1,视

- Redis常见问题汇总

目录1、Redis为什么这么快2、Redis的过期策略以及内存淘汰机制2.1、为什么不用定时删除策略2.2、定期删除+惰性删除是如何工作的2.3、采用定期删除+惰性删除就没其他问题了么?2.4、Redis内存淘汰机制3、Redis并发环境下使用3.1、如何解决redis的并发竞争key问题3.2、MySQL里有2000w数据,redis中只存20w的数据,如何保证redis中的数据都是热点数据4、

- Redis-py 实战指南:从安装到向量索引,Python 操作 Redis 全解析

佑瞻

数据库与知识图谱redispython数据库人工智能

在Python开发中,操作Redis数据库是很多场景下的刚需,而redis-py作为Redis官方推荐的Python客户端,更是我们绕不开的工具。但你是否在安装时踩过版本兼容的坑?是否在连接集群或配置TLS时犯过难?甚至想尝试向量索引却不知从何下手?今天我们就从基础到进阶,手把手带你玩转redis-py,让Python操作Redis变得简单又高效。一、redis-py安装:避坑指南首先,我们需要安

- .NetCore发布到Linux下(Shell脚本控制服务启动)

.NetHero

c#.netcorelinux

一、netcore后端部署1.设置端口号配置文件,指定接口的端口号(*注意不要和已有的服务端口相同!)Program

- Go-Redis × 向量检索实战用 HNSW 在 Redis 中索引与查询文本 Embedding(Hash & JSON 双版本)

Hello.Reader

数据库运维缓存技术golangredisembedding

1.场景与思路痛点:把“文本内容”转成向量后,如何在本地Redis里做近似向量搜索(KNN),而不依赖外部向量数据库?方案:利用HuggingFace模型sentence-transformers/all-MiniLM-L6-v2生成384维Float32向量;借助RediSearch的HNSW索引能力,在Hash或JSON文档里存储&查询向量;用go-redisv9的高阶API(FTCreate

- Oracle分区表插入数据库时间时报ORA-14400

Indestructible

使用springdatajpa插入数据时,需要表中的createtime保存为数据库时间,而不是应用服务器时间,实现这个功能只需要在实体类上面加@DynamicInsert就可以了。代码如下:@Entity@Table(name="ENTITY")@DynamicInsertpublicclassEntity{@Column(nullable=false)privateDatecreatetime

- Spring AI 概述与功能简介

drebander

AI编程spring人工智能java

SpringAI是一个由Spring团队开发的开源框架,旨在为人工智能(AI)和机器学习(ML)提供一个成熟且高效的开发平台。它将Spring生态系统的设计理念应用于AI开发,尤其强调模块化、可移植性以及简洁的集成。SpringAI提供了丰富的功能,涵盖从AI模型的调用到与数据库的集成等多个方面,帮助开发者构建和管理AI驱动的应用程序。1.SpringAI背景SpringAI的背景源于Spring

- RabitQ 量化:既省内存又提性能

大禹智库

《向量数据库指南》《实战AI智能体》人工智能AI自动化大禹智库AI智能体向量数据库

突破高维向量内存瓶颈:MlivusCloudRaBitQ量化技术的工程实践与调优指南作为大禹智库高级研究员,拥有三十余年向量数据库与AI系统架构经验的我发现,在当今多模态AI落地的核心场景中,高维向量引发的内存资源消耗问题已成为制约系统规模化部署的“卡脖子”因素。特别是在大规模图像检索、个性化推荐系统和语义搜索引擎中,动辄数亿级别的向量数据需要实时处理,传统全精度索引方式会让内存资源消耗呈指数级增

- python爬虫从入门到精通

大模型猫叔

python爬虫数据库

目录一、正确认识Python爬虫二、了解爬虫的本质1.熟悉Python编程2.了解HTML3.了解网络爬虫的基本原理4.学习使用Python爬虫库三、了解非结构化数据的存储1.本地文件2.数据库四、掌握各种技巧,应对特殊网站的反爬措施1.User-Agent2.Cookies3.IP代理五、学习爬虫框架,搭建工程化的爬虫1.创建Scrapy项目2.创建Spider3.编写Spider4.运行Spi

- 戴尔R750XS服务器Windows Server 2012 R2 管理员密码忘记,如何解决?

bug菌¹

全栈Bug调优(实战版)服务器windows运维

本文收录于《全栈Bug调优(实战版)》专栏,主要记录项目实战过程中所遇到的Bug或因后果及提供真实有效的解决方案,希望能够助你一臂之力,帮你早日登顶实现财富自由;同时,欢迎大家关注&&收藏&&订阅!持续更新中,up!up!up!!备注:部分问题/疑难杂症搜集于互联网。全文目录:问题描述解决方案(请知悉:如下方案不保证一定适配你的问题)1.**通过“安全模式”重置管理员密码**2.**使用Windo

- Node.js特训专栏-实战进阶:16. RBAC权限模型设计

爱分享的程序员

Node.jsnode.js安全算法前端

欢迎来到Node.js实战专栏!在这里,每一行代码都是解锁高性能应用的钥匙,让我们一起开启Node.js的奇妙开发之旅!Node.js特训专栏主页专栏内容规划详情我将从RBAC权限模型的基础概念、核心组件讲起,详细阐述其设计原则、数据库模型设计,还会结合代码示例展示在实际开发中的实现方式,以及探讨模型的扩展与优化。RBAC权限模型设计:从理论到实战的完整方案在现代应用系统中,权限管理是保障数据安全

- Windows Server 2012 Hyper-V PK VMware 性能

weixin_33933118

运维操作系统

近几年来,服务器虚拟化已经有了长足的演进,从刚萌芽的技术演变为成熟的IT功能。在演化过程中,各种规模的企业开始利用其强大的功能,满足日新月异的业务需求。组织通过将工作负载虚拟化,能够控制并降低成本,同时提升IT系统的扩展性、灵活性和涵盖范围。但随着演进的发展,我们也逐渐地领悟到只凭虚拟化本身,无法使组织构建或利用云服务,而云服务正在不断成长,在业务工作中扮演日益重要的角色。微软已经通过Hyper-

- JAVA面试宝典 -《API设计:RESTful 与 GraphQL 对比实践》

没有bug.的程序员

JAVA面试宝典java面试restful

API设计:RESTful与GraphQL对比实践在微服务架构中,API设计如同城市交通网络规划——选择RESTful还是GraphQL,决定了数据流的效率与灵活性。本文通过实战代码与架构对比,揭秘两种风格的适用场景与融合方案。引言:API设计的两大流派之争为什么越来越多团队关注GraphQL?数据需求碎片化:移动端/多终端需要按需获取数据接口迭代成本:REST每次需求变更需发布新版本前后端协作效

- InfluxDB 数据模型:桶、测量、标签与字段详解(一)

计算机毕设定制辅导-无忧

#InfluxDBdb

一、引言**在大数据和物联网蓬勃发展的当下,时间序列数据的处理需求呈爆发式增长。InfluxDB作为一款高性能的开源时序数据库,凭借其卓越的特性,在时序数据库领域占据了重要地位,被广泛应用于各种场景。InfluxDB专为时间序列数据设计,拥有高效的存储和查询性能。它采用独特的存储引擎,能够快速写入大量带有时间戳的数据,并支持灵活的查询操作。其核心设计针对时间序列数据的特点进行了优化,包括时间索引、

- Enum 枚举

120153216

enum枚举

原文地址:http://www.cnblogs.com/Kavlez/p/4268601.html Enumeration

于Java 1.5增加的enum type...enum type是由一组固定的常量组成的类型,比如四个季节、扑克花色。在出现enum type之前,通常用一组int常量表示枚举类型。比如这样:

public static final int APPLE_FUJI = 0

- Java8简明教程

bijian1013

javajdk1.8

Java 8已于2014年3月18日正式发布了,新版本带来了诸多改进,包括Lambda表达式、Streams、日期时间API等等。本文就带你领略Java 8的全新特性。

一.允许在接口中有默认方法实现

Java 8 允许我们使用default关键字,为接口声明添

- Oracle表维护 快速备份删除数据

cuisuqiang

oracle索引快速备份删除

我知道oracle表分区,不过那是数据库设计阶段的事情,目前是远水解不了近渴。

当前的数据库表,要求保留一个月数据,且表存在大量录入更新,不存在程序删除。

为了解决频繁查询和更新的瓶颈,我在oracle内根据需要创建了索引。但是随着数据量的增加,一个半月数据就要超千万,此时就算有索引,对高并发的查询和更新来说,让然有所拖累。

为了解决这个问题,我一般一个月会进行一次数据库维护,主要工作就是备

- java多态内存分析

麦田的设计者

java内存分析多态原理接口和抽象类

“ 时针如果可以回头,熟悉那张脸,重温嬉戏这乐园,墙壁的松脱涂鸦已经褪色才明白存在的价值归于记忆。街角小店尚存在吗?这大时代会不会牵挂,过去现在花开怎么会等待。

但有种意外不管痛不痛都有伤害,光阴远远离开,那笑声徘徊与脑海。但这一秒可笑不再可爱,当天心

- Xshell实现Windows上传文件到Linux主机

被触发

windows

经常有这样的需求,我们在Windows下载的软件包,如何上传到远程Linux主机上?还有如何从Linux主机下载软件包到Windows下;之前我的做法现在看来好笨好繁琐,不过也达到了目的,笨人有本方法嘛;

我是怎么操作的:

1、打开一台本地Linux虚拟机,使用mount 挂载Windows的共享文件夹到Linux上,然后拷贝数据到Linux虚拟机里面;(经常第一步都不顺利,无法挂载Windo

- 类的加载ClassLoader

肆无忌惮_

ClassLoader

类加载器ClassLoader是用来将java的类加载到虚拟机中,类加载器负责读取class字节文件到内存中,并将它转为Class的对象(类对象),通过此实例的 newInstance()方法就可以创建出该类的一个对象。

其中重要的方法为findClass(String name)。

如何写一个自己的类加载器呢?

首先写一个便于测试的类Student

- html5写的玫瑰花

知了ing

html5

<html>

<head>

<title>I Love You!</title>

<meta charset="utf-8" />

</head>

<body>

<canvas id="c"></canvas>

- google的ConcurrentLinkedHashmap源代码解析

矮蛋蛋

LRU

原文地址:

http://janeky.iteye.com/blog/1534352

简述

ConcurrentLinkedHashMap 是google团队提供的一个容器。它有什么用呢?其实它本身是对

ConcurrentHashMap的封装,可以用来实现一个基于LRU策略的缓存。详细介绍可以参见

http://code.google.com/p/concurrentlinke

- webservice获取访问服务的ip地址

alleni123

webservice

1. 首先注入javax.xml.ws.WebServiceContext,

@Resource

private WebServiceContext context;

2. 在方法中获取交换请求的对象。

javax.xml.ws.handler.MessageContext mc=context.getMessageContext();

com.sun.net.http

- 菜鸟的java基础提升之道——————>是否值得拥有

百合不是茶

1,c++,java是面向对象编程的语言,将万事万物都看成是对象;java做一件事情关注的是人物,java是c++继承过来的,java没有直接更改地址的权限但是可以通过引用来传值操作地址,java也没有c++中繁琐的操作,java以其优越的可移植型,平台的安全型,高效性赢得了广泛的认同,全世界越来越多的人去学习java,我也是其中的一员

java组成:

- 通过修改Linux服务自动启动指定应用程序

bijian1013

linux

Linux中修改系统服务的命令是chkconfig (check config),命令的详细解释如下: chkconfig

功能说明:检查,设置系统的各种服务。

语 法:chkconfig [ -- add][ -- del][ -- list][系统服务] 或 chkconfig [ -- level <</SPAN>

- spring拦截器的一个简单实例

bijian1013

javaspring拦截器Interceptor

Purview接口

package aop;

public interface Purview {

void checkLogin();

}

Purview接口的实现类PurviesImpl.java

package aop;

public class PurviewImpl implements Purview {

public void check

- [Velocity二]自定义Velocity指令

bit1129

velocity

什么是Velocity指令

在Velocity中,#set,#if, #foreach, #elseif, #parse等,以#开头的称之为指令,Velocity内置的这些指令可以用来做赋值,条件判断,循环控制等脚本语言必备的逻辑控制等语句,Velocity的指令是可扩展的,即用户可以根据实际的需要自定义Velocity指令

自定义指令(Directive)的一般步骤

&nbs

- 【Hive十】Programming Hive学习笔记

bit1129

programming

第二章 Getting Started

1.Hive最大的局限性是什么?一是不支持行级别的增删改(insert, delete, update)二是查询性能非常差(基于Hadoop MapReduce),不适合延迟小的交互式任务三是不支持事务2. Hive MetaStore是干什么的?Hive persists table schemas and other system metadata.

- nginx有选择性进行限制

ronin47

nginx 动静 限制

http {

limit_conn_zone $binary_remote_addr zone=addr:10m;

limit_req_zone $binary_remote_addr zone=one:10m rate=5r/s;...

server {...

location ~.*\.(gif|png|css|js|icon)$ {

- java-4.-在二元树中找出和为某一值的所有路径 .

bylijinnan

java

/*

* 0.use a TwoWayLinkedList to store the path.when the node can't be path,you should/can delete it.

* 1.curSum==exceptedSum:if the lastNode is TreeNode,printPath();delete the node otherwise

- Netty学习笔记

bylijinnan

javanetty

本文是阅读以下两篇文章时:

http://seeallhearall.blogspot.com/2012/05/netty-tutorial-part-1-introduction-to.html

http://seeallhearall.blogspot.com/2012/06/netty-tutorial-part-15-on-channel.html

我的一些笔记

===

- js获取项目路径

cngolon

js

//js获取项目根路径,如: http://localhost:8083/uimcardprj

function getRootPath(){

//获取当前网址,如: http://localhost:8083/uimcardprj/share/meun.jsp

var curWwwPath=window.document.locati

- oracle 的性能优化

cuishikuan

oracleSQL Server

在网上搜索了一些Oracle性能优化的文章,为了更加深层次的巩固[边写边记],也为了可以随时查看,所以发表这篇文章。

1.ORACLE采用自下而上的顺序解析WHERE子句,根据这个原理,表之间的连接必须写在其他WHERE条件之前,那些可以过滤掉最大数量记录的条件必须写在WHERE子句的末尾。(这点本人曾经做过实例验证过,的确如此哦!

- Shell变量和数组使用详解

daizj

linuxshell变量数组

Shell 变量

定义变量时,变量名不加美元符号($,PHP语言中变量需要),如:

your_name="w3cschool.cc"

注意,变量名和等号之间不能有空格,这可能和你熟悉的所有编程语言都不一样。同时,变量名的命名须遵循如下规则:

首个字符必须为字母(a-z,A-Z)。

中间不能有空格,可以使用下划线(_)。

不能使用标点符号。

不能使用ba

- 编程中的一些概念,KISS、DRY、MVC、OOP、REST

dcj3sjt126com

REST

KISS、DRY、MVC、OOP、REST (1)KISS是指Keep It Simple,Stupid(摘自wikipedia),指设计时要坚持简约原则,避免不必要的复杂化。 (2)DRY是指Don't Repeat Yourself(摘自wikipedia),特指在程序设计以及计算中避免重复代码,因为这样会降低灵活性、简洁性,并且可能导致代码之间的矛盾。 (3)OOP 即Object-Orie

- [Android]设置Activity为全屏显示的两种方法

dcj3sjt126com

Activity

1. 方法1:AndroidManifest.xml 里,Activity的 android:theme 指定为" @android:style/Theme.NoTitleBar.Fullscreen" 示例: <application

- solrcloud 部署方式比较

eksliang

solrCloud

solrcloud 的部署其实有两种方式可选,那么我们在实践开发中应该怎样选择呢? 第一种:当启动solr服务器时,内嵌的启动一个Zookeeper服务器,然后将这些内嵌的Zookeeper服务器组成一个集群。 第二种:将Zookeeper服务器独立的配置一个集群,然后将solr交给Zookeeper进行管理

谈谈第一种:每启动一个solr服务器就内嵌的启动一个Zoo

- Java synchronized关键字详解

gqdy365

synchronized

转载自:http://www.cnblogs.com/mengdd/archive/2013/02/16/2913806.html

多线程的同步机制对资源进行加锁,使得在同一个时间,只有一个线程可以进行操作,同步用以解决多个线程同时访问时可能出现的问题。

同步机制可以使用synchronized关键字实现。

当synchronized关键字修饰一个方法的时候,该方法叫做同步方法。

当s

- js实现登录时记住用户名

hw1287789687

记住我记住密码cookie记住用户名记住账号

在页面中如何获取cookie值呢?

如果是JSP的话,可以通过servlet的对象request 获取cookie,可以

参考:http://hw1287789687.iteye.com/blog/2050040

如果要求登录页面是html呢?html页面中如何获取cookie呢?

直接上代码了

页面:loginInput.html

代码:

<!DOCTYPE html PUB

- 开发者必备的 Chrome 扩展

justjavac

chrome

Firebug:不用多介绍了吧https://chrome.google.com/webstore/detail/bmagokdooijbeehmkpknfglimnifench

ChromeSnifferPlus:Chrome 探测器,可以探测正在使用的开源软件或者 js 类库https://chrome.google.com/webstore/detail/chrome-sniffer-pl

- 算法机试题

李亚飞

java算法机试题

在面试机试时,遇到一个算法题,当时没能写出来,最后是同学帮忙解决的。

这道题大致意思是:输入一个数,比如4,。这时会输出:

&n

- 正确配置Linux系统ulimit值

字符串

ulimit

在Linux下面部 署应用的时候,有时候会遇上Socket/File: Can’t open so many files的问题;这个值也会影响服务器的最大并发数,其实Linux是有文件句柄限制的,而且Linux默认不是很高,一般都是1024,生产服务器用 其实很容易就达到这个数量。下面说的是,如何通过正解配置来改正这个系统默认值。因为这个问题是我配置Nginx+php5时遇到了,所以我将这篇归纳进

- hibernate调用返回游标的存储过程

Supanccy2013

javaDAOoracleHibernatejdbc

注:原创作品,转载请注明出处。

上篇博文介绍的是hibernate调用返回单值的存储过程,本片博文说的是hibernate调用返回游标的存储过程。

此此扁博文的存储过程的功能相当于是jdbc调用select 的作用。

1,创建oracle中的包,并在该包中创建的游标类型。

---创建oracle的程

- Spring 4.2新特性-更简单的Application Event

wiselyman

application

1.1 Application Event

Spring 4.1的写法请参考10点睛Spring4.1-Application Event

请对比10点睛Spring4.1-Application Event

使用一个@EventListener取代了实现ApplicationListener接口,使耦合度降低;

1.2 示例

包依赖

<p