Linux- 系统随你玩之--玩出花活的命令浏览器下

文章目录

- 1、背景

- 2、常规操作

-

- 2.1、测试相关

-

- 2.1.1、修改 HTML 请求标头

- 2.1.2、 模拟不同浏览器发出

- 2.1.3、重定向

- 2.2、 下载相关操作

-

- 2.2.1、 后台下载

- 2.2.2、设置下载重试次数

- 2.2.3、过滤指定格式下载

- 2.2.4、限制总下载文件大小

- 2.2.5、匿名FTP下载

- 2.2.6、FTP认证下载

- 2.2.7、利用代理服务器下载

- 3、好姐妹

- 3.1 、curl 和 wget

- 4、结语

1、背景

前文在续,书接上一回Linux- 系统随你玩之–玩出花活的命令浏览器上, 话说命令浏览器它是一个从网络上自动下载文件的自由工具,支持通过 HTTP、HTTPS、FTP 三个最常见的 TCP/IP协议 下载,并可以使用 HTTP 代理。

它的最大特色是断点续传、镜像整个站点。今天我们来讲讲它别的作用。

2、常规操作

2.1、测试相关

2.1.1、修改 HTML 请求标头

我们在做测试相关工作时 经常发送大量的各种终端的测试请求 其中,HTTP 标头是数据包初始的组成部分,因此会因各种场景需要做经常性修改后发送请求。

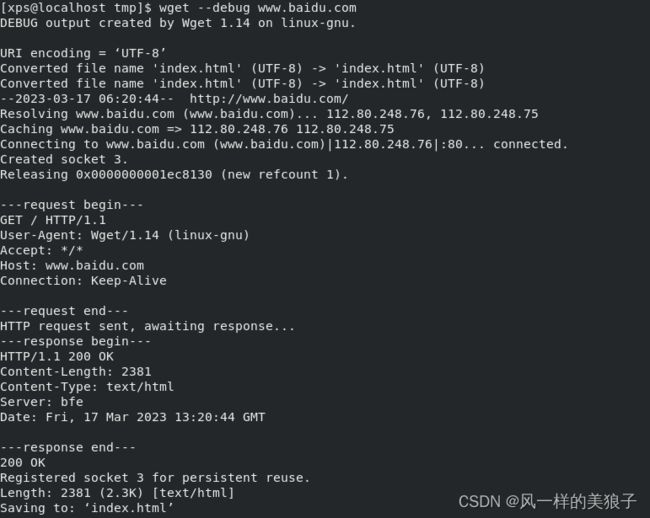

那我们在使用浏览器浏览网页时,你的浏览器向服务器发送了 HTTP 请求标头。具体都发了些什么呢?这个时候我们可以使用 --debug 选项查看 wget 每次请求发送的标头信息:

$wget --debug www.baidu.com

2.1.2、 模拟不同浏览器发出

你可以通过 --header 选项修改请求标头,增加不同浏览器参数来,来模拟测试特定的浏览器发出的请求效果。

wget --debug --header="User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/110.0.0.0 Safari/537.36" http://baidu.com

此外,你还可以伪装成特定的移动设备(比如 iPhone ):

wget --debug \--header = "User-Agent: Mozilla/5.0 (iPhone; CPU iPhone OS 13_5_1 like Mac OS X) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/13.1.1 Mobile/15E148 Safari /604.1" \HTTP:// www.baidu.com

2.1.3、重定向

与浏览器请求发送标头信息的方式相同,标头信息也包含在响应中。

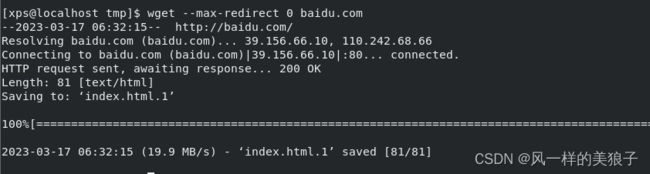

200 响应码意味着成功。而 301 响应则意味着 URL 已经指向不同的网站。

这种情况下,如果你还要下载文件,那么就需要配合使用 --max-redirect 参数选项 来达到 wget 的重定向功能 。

如果你不想要重定向,那么可以将 --max-redirect 设置为 0 。

或将其设置为其他数字以控制 wget 跟随的重定向数量。

2.2、 下载相关操作

2.2.1、 后台下载

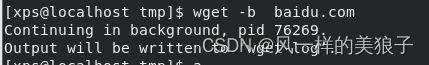

对于下载非常大的文件的时候,我们可以使用参数-b进行后台下载(网址可按实际情况改为网络文件名地址)

在后台下载过程中你可以使用以下命令来查看下载进度以了解进展。

2.2.2、设置下载重试次数

如果网络有问题或下载一个大文件也有可能失败。wget默认重试20次连接下载文件。

如果需要调整使用–tries增加重试次数。

wget –tries=40 http:baidu.com

2.2.3、过滤指定格式下载

使用wget –reject过滤指定格式下载

wget –reject=gif url

2.2.4、限制总下载文件大小

使用wget -Q限制总下载文件大小,避免下载过大超出预期数据量。

当你想要下载的文件超过10M而退出下载,你可以使用以下命令:

wget -Q10m -i filelist.jpg

切记:该参数只对 递归下载文件时才有效,对单个文件不起限制作用。

2.2.5、匿名FTP下载

你可以使用wget来完成ftp链接的下载。

使用wget匿名ftp下载

wget ftp-url

2.2.6、FTP认证下载

使用wget用户名和密码认证的ftp下载

wget –ftp-user=USERNAME –ftp-password=PASSWORD url

注意:对于需要证书做认证的网站,就只能利用其他下载工具了,例如它的好姐妹curl。

2.2.7、利用代理服务器下载

遇到网络需要经过代理服务器,可以让wget通过代理服务器进行文件的下载。我们可以在当前用户的目录下创建一个.wgetrc文件。

VI .wgetrc 文件中可以设置代理服务器内容如下:

http-proxy = 111.111.111.111:8080

ftp-proxy = 111.111.111.111:8080

如代理服务器还需要配合密码使用则增加下面的帐号信息:

–proxy-user=USER设置代理用户

–proxy-passwd=PASS设置代理密码

搭配使用参数–proxy=on/off 使用或者关闭代理。

3、好姐妹

3.1 、curl 和 wget

curl 和 wget 的一个最明显的区别是:默认情况下 wget 将查询的网页保存到系统,而 curl 将其显示在终端输出中但不保存它。

总之一句话就是 curl 访问链接而 wget 是下载链接。