Elasticsearch-7.8.0集群方式运行源码,并集成IK分词器

前言:

本章主要介绍在编译好elasticsearch-7.8.0源码后,如何在本地以集群方式运行elasticsearch源码

1、elasticsearch-7.8.0源码编译运行参考:http://t.csdn.cn/P0fYb

2、windows10 本地搭建elasticsearch-7.8.0集群,3个节点

首先下载Elasticsearch客户端后解压3份

- Elasticsearch客户端:Index of elasticsearch-local

解压后,重命名为elasticsearch-1、elasticsearch-2、elasticsearch-3

编辑elasticsearch-1\config目录下的elasticsearch.yml文件,添加如下,其他保持默认

# ------------------------------------ Node ------------------------------------

#

# Use a descriptive name for the node:

#

#

# Add custom attributes to the node:

#

#node.attr.rack: r1# 配置es集群的名称,es会自动发现在同一网段下的es,如果在同一网段下有多个集群,就可以用这个属性来区分不同的集群

cluster.name: my-application# 节点名称;其他节点需要修改的地方

node.name: node-1#指定该节点是否有资格被选举成为node

node.master: true#指定该节点是否存储索引数据,默认为true

node.data: true# 设置绑定的IP地址,还有其他节点和该节点交互的IP地址,本机ip

network.host: 127.0.0.1# 指定http端口;其他节点需要修改的地方

http.port: 9200# 设置节点间交互的tcp端口,默认9300;其他节点需要修改的地方

transport.tcp.port: 9300# 设置集群中master节点的初始列表,可以通过这些节点来自动发现新加入集群的节点

# 因为另外两台节点的端口自会设置为9301和9302,所以写入两台es的完整地址

discovery.zen.ping.unicast.hosts: ["127.0.0.1:9300","127.0.0.1:9301","127.0.0.1:9302"]# 初始化主节点,在启动集群时,指定一个指定node-1为主节点

cluster.initial_master_nodes: node-1# 如果需要使用head,那么需要解决跨域问题,使head插件可以访问es

http.cors.enabled: true

http.cors.allow-origin: "*"# path.data: /path/to/data

# 设置索引数据的存储路径,默认是es根目录下的data文件夹,可以设置多个存储路径,用逗号隔开,例:

# path.data: /path/to/data1,/path/to/data2

elasticsearch-2,elasticsearch-3,分别修改

## elasticsearch-2 ##

# 节点名称;其他节点需要修改的地方

node.name: node-2# 指定http端口;其他节点需要修改的地方

http.port: 9201# 设置节点间交互的tcp端口,默认9300;其他节点需要修改的地方

transport.tcp.port: 9301

## elasticsearch-3 ##

# 节点名称;其他节点需要修改的地方

node.name: node-3# 指定http端口;其他节点需要修改的地方

http.port: 9202# 设置节点间交互的tcp端口,默认9300;其他节点需要修改的地方

transport.tcp.port: 9302

最后得到elasticsearch3个节点,完成集群配置

3、接着修改elasticsearch-7.8 idea源码启动参数

-Des.path.home=E:\installations\es_tools\es_cluster\elasticsearch-1 -Des.path.conf=E:\installations\es_tools\es_cluster\elasticsearch-1\config -Dlog4j2.disable.jmx=true -Xmx4g -Xms4g4、idea启动源码后,进入elasticsearch-2,elasticsearch-3的bin目录,分别执行elasticsearch.bat(当然也可以先执行elasticsearch.bat,再启动源码,这里因为指定了elasticsearch-1为master,一般启动不会出错,故有此顺序)

# 初始化主节点,在启动集群时,指定一个指定node-1为主节点

cluster.initial_master_nodes: node-1

2)再看下elasticsearch.bat启动项的日志

idea控制台监控:添加了节点node-2

[2022-03-04T18:38:51,613][INFO ][o.e.c.s.MasterService ] [node-1] elected-as-master ([2] nodes joined)[{node-1}{w0T2pQLRQwa8hcwx9VMN6w}{Zi31eFwATy-wFsYZB4ErJw}{127.0.0.1}{127.0.0.1:9300}{dilmrt}{ml.machine_memory=16934494208, xpack.installed=true, transform.node=true, ml.max_open_jobs=20} elect leader, {node-2}{0fZSsuNeRRSZl-pePKfiKQ}{MvHsL7-lTX-wEtsQPK6Ntw}{127.0.0.1}{127.0.0.1:9301}{dilmrt}{ml.machine_memory=16934494208, ml.max_open_jobs=20, xpack.installed=true, transform.node=true} elect leader, _BECOME_MASTER_TASK_, _FINISH_ELECTION_], term: 2, version: 39, delta: master node changed {previous [], current [{node-1}{w0T2pQLRQwa8hcwx9VMN6w}{Zi31eFwATy-wFsYZB4ErJw}{127.0.0.1}{127.0.0.1:9300}{dilmrt}{ml.machine_memory=16934494208, xpack.installed=true, transform.node=true, ml.max_open_jobs=20}]}, added {{node-2}{0fZSsuNeRRSZl-pePKfiKQ}{MvHsL7-lTX-wEtsQPK6Ntw}{127.0.0.1}{127.0.0.1:9301}{dilmrt}{ml.machine_memory=16934494208, ml.max_open_jobs=20, xpack.installed=true, transform.node=true}}idea控制台监控:添加了节点node-2

[2022-03-04T18:38:59,905][INFO ][o.e.c.s.MasterService ] [node-1] node-join[{node-3}{f8t1Gla5SO-OqmHqgEWXuQ}{Fx4r91doQi2zRxMe0l0EEg}{127.0.0.1}{127.0.0.1:9302}{dilmrt}{ml.machine_memory=16934494208, ml.max_open_jobs=20, xpack.installed=true, transform.node=true} join existing leader], term: 2, version: 48, delta: added {{node-3}{f8t1Gla5SO-OqmHqgEWXuQ}{Fx4r91doQi2zRxMe0l0EEg}{127.0.0.1}{127.0.0.1:9302}{dilmrt}{ml.machine_memory=16934494208, ml.max_open_jobs=20, xpack.installed=true, transform.node=true}}若能看到以上信息,则集群启动正常。

3)若启动过程中,出现闪退、却又看不到报错日志的情况,此时可以通过cmd命令框执行bat启动文件,就可以看到报错信息了,然后进行对应的修改即可

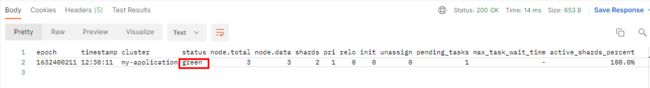

5、postman 验证集群启动成功

访问集群的任何一个节点(只需切换端口号即可),此处访问节点node-2进行测试,

1)输入地址localhost:9201/_cat/health?v 查询集群的健康状态

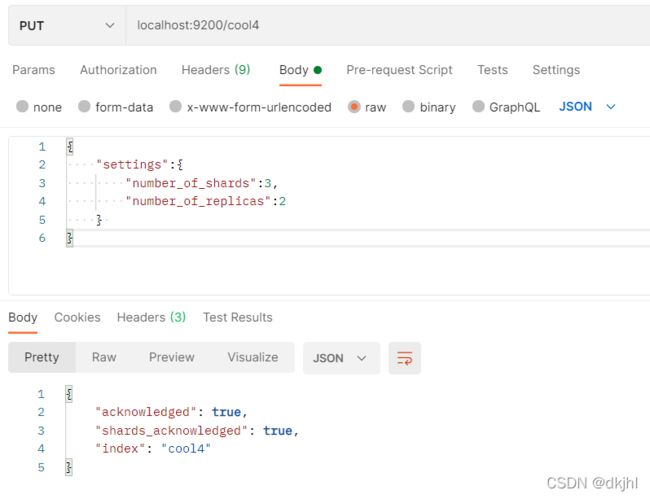

2)接下来就可以利用postman创建索引了

查看索引创建的具体位置,进入/elasticsearch-x/data/目录即可,data目录默认是在%ELASTICSEARCH_HOME%下

详见索引目录:\elasticsearch-1\data\nodes\0\indices\r_aurtN3QvOmjTB6ZQiRTA

①

![]()

②

③

④

⑤

6、集成IK分词器

GitHub - medcl/elasticsearch-analysis-ik at v7.8.0

- 注意:这里es和IK中文分词器的版本要一致,否则会出现不必要的报错。

将已经下载好的IK安装包解压到每个节点的plugin中

- 注意,每个节点下都要放一份,然后重新启动es集群,然后进行分词测试

用postman访问 localhost:9201/_analyze

请求体中的参数analyzer :ik_max_word 是指定分词的模式,

ik_max_word :最大程度的分词,分词的粒度比较细

ik_smart : 分词的粒度要粗一下,可以自行测试一下

text:将要进行分词的文本

分词结果如下: