VALSE 2019 4月12日 上午 第二会场 迁移学习与领域自适应 会议记录

4月12日 上午 第二会场 迁移学习与领域自适应

主持人:杜博——武汉大学

题目:Unsupervised and Weakly-supervised Domain Adaptation for Semantic Segmentation

讲者:段立新——电子科技大学

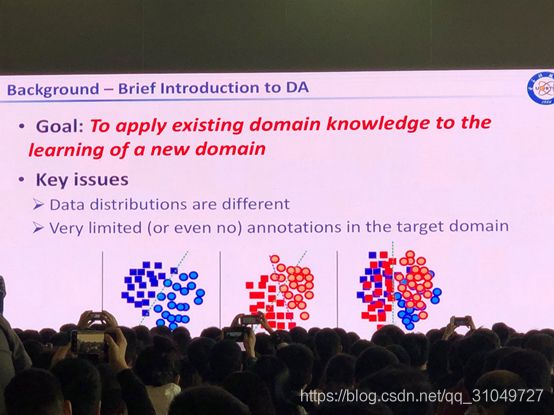

Goal

To apply existing domain knowledge to the learning of a new domain.

Contents

- Background

Brief introduction to domain adaptation

From recognition to semantic segmentation

- Domain adaptation for semantic segmentation

Unsupervised setting: No target annotations exist

Weakly-supervised setting: Image-level annotations exist

- Summary

Background

Domain adaptation目标:将已有的领域知识迁移到另一个领域的学习中。

传统机器学习与领域适应学习分别如下:

领域自适应学习中的关键问题在于:

- 数据的分布不同

- 在目标域中的标签是非常少(甚至没有)

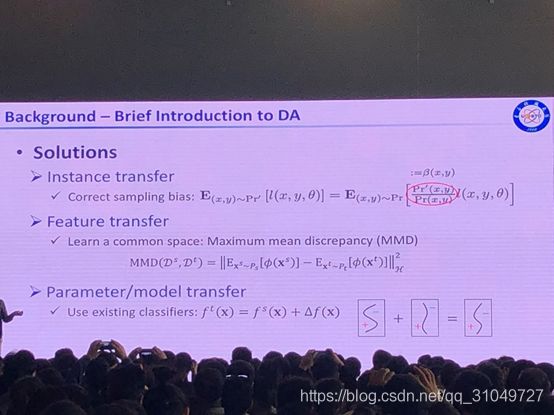

领域适应解决方法层次:

- Instance transfer

目标实例之间的迁移,比如将源领域之内的目标标签(同样也可是语义分割标签等)通过领域适应的方法,迁移到目标域中,并将问题转化为了一个完全监督问题来解决。

例如:将GTAV中的标签通过学习、迁移,最终转换到KITTI或者Cityscapes上,获得目标数据的标签,并以此训练网络。

- Feature transfer

学习一个common space,也就是将目标域和源域都进行特征提取,在特征的层面上将两个域进行统一。

- Parameter/model transfer

用一个已经存在的分类器,通过学习一个 来实现目标域

来实现目标域 和源域

和源域 的迁移。

的迁移。

Proposed Method

- Unsupervised Domain Adaptation for Segmentation

由2018ECCV的Zou等人的文章启发,Zou等人使用的是伪标签,LossFunc如下:

后来出现的2019 Zhang等人方法使用的全池化,池化后得到的结果是场景中可能出现的标签,显式对场景中出现标签进行建模。(没感觉特别有新意?因为感觉Zou的2018ECCV的文章同样可以把这个方法概括进去。感觉这个是上一篇文章的一个特殊情况。同时,这也是2018CVPR的Context-Encoding Network的想法)

这个作者将上面两个思路结合起来了,LossFunc如下:

同时,使用了多个尺度下的pooling把特征图弄到不同的尺度下,保证在不同尺度下的一致性(感觉跟PSPNet很像,但是这个做的事是在不同尺度下保证特征的一致性,跟PSP还是有不同)

- Weakly-supervised Domain Adaptation for Segmentation

问题:怎么去有效利用图像层面标签?

三个loss,分别是分割loss(仅针对源域)、对抗loss(源域对抗域均有)、判别loss(针对图像级别标签)

(说实话没感觉有什么novelty,用的所有的都是已有方法拼凑出来的,还是跟Context-Encoding-Network一样)

题目:Transfer Learning: From Algorithms to Theories and Back

讲者:龙明盛——清华大学

(这是我感觉讲的最好的,同时也是我听得最懵的,各种公式摆在上面看不懂,尽量总结内容)

在机器学习中,一个学习出来的learner是需要学习一个映射,即![]() ,而分布是

,而分布是![]() 。同样的,我们完成机器学习这件事情,是有一个误差界限保证,使得学习是有效的,即

。同样的,我们完成机器学习这件事情,是有一个误差界限保证,使得学习是有效的,即

而迁移学习就可以在这个框架下表示为如下问题,即在源域和目标域都有一个映射关系,而他们之间的分布是不一样的,即P与Q之间存在gap。

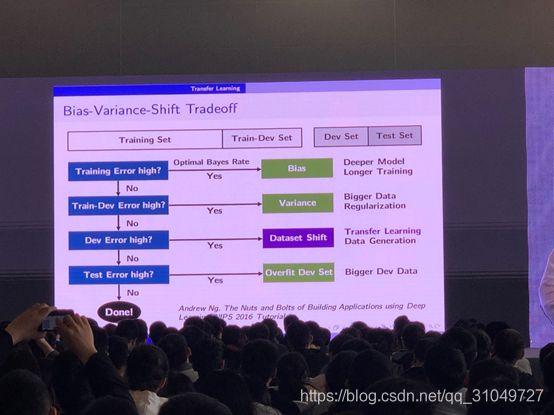

Andrew Ng在2016NIPS中曾经给出以下图,来说明bias变量的迁移权衡问题。

所有数据应该分为四类,

训练误差较大的时候,用更深的模型或者更长时间的训练

训练集上的验证误差较大时,用更大的数据量,或者使用正则化

验证集上误差较大的时候,需要迁移学习,或者重新生成数据

测试误差大的时候,说明在验证集上过拟合了,所以需要更大的验证集。

传统/基本方法进行迁移学习:

边缘分布

给定边缘分布下的label的条件分布

所以关键问题在于怎么将分布进行适配。

虽然存在对抗学习方法,但是对抗学习方法需要更多的数据正则化操作,所以只考虑边缘分布是不够的(不懂!)

于是提出了DAN方法(2015ICML)

核心观点:将两个域的数据分别用特征提取来将两个域的数据映射到高维空间中去,并且使得在高维空间中,两个域的期望相等(高维中的期望相等,可以等价为低维中的期望、方差等全都相等),以此实现域适应。

优势:多kernel学习,非参数化学习

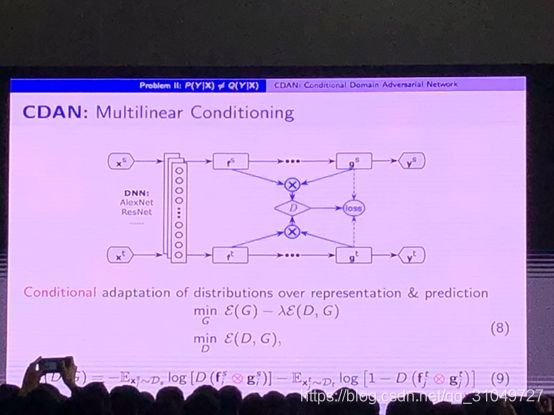

2018 NIPS CDAN

条件概率不相等时应该怎么办?(这个是真的没听明白)

总结一下就是很偏向机器学习方面,理论充分,令人信服,就是不太懂。

题目:迁移学习和领域自适应方法及进展

讲者:张磊——重庆大学

Weak learning(弱学习)

“A problem can be weak-learned if and only if it can be strong-learned.”

- Weakly-supervised leaning(周志华)-不完全,不确切,不准确(label)

- Transfer learning (杨强)-边缘分布、类条件分布(data vs. label)

- Domain adaptation(Kate Saenko)-知识共享(data)

Transfer Learning(TL)/Domain Adaptation(DA)的发展如图:

而TL/DA又分为几个层面,如图:

Instance Level

Feature Level

Classifier Level

Deep models

Adversarial transfer

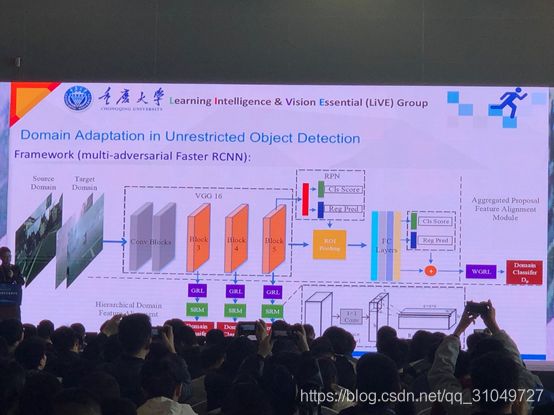

比较令我感兴趣的工作,该工作的目标是将清晰域的图像中目标检测结果迁移到含有雾的图像中来做,把这个过程当作一个领域迁移的问题来做。但是如同师姐所说:本身就有底层算法,为什么不直接用底层算法来做呢?不过在后来panel环节他并没有出现,没有机会问。

他还有一篇关于迁移学习综述,ppt翻的太快没记下名字,回头去他官网找一下。

Panel总结:

- 做迁移学习的时候应该从人的角度思考启发,思考迁移学习和人类的思考学习模型之间的关系。

- 迁移学习中的一个核心问题在于如何得到一个泛化性能好的特征。

- 从模型挖掘要迁移的指示,如何利用人的知识来提升迁移学习的性能。

- 从数据角度:实际上我们目前能够得到的数据是很多的(各种类型,各种模态),但是同时又是很少的(没办法直接投入实际使用),怎么去处理这两者的矛盾。从方法论角度:怎么构建优质的模型来进行迁移学习

- 迁移学习与GAN网络究竟有什么关系:首先,迁移学习是GAN网络的一个应用出口,但是GAN与迁移学习应该是相辅相成的。其次,迁移学习在创造之初实际上是一种监督学习,而GAN网络一开始是一个无监督学习(??不知道指的是什么样的无监督,如果单就判别器来看的话好像是无监督,但是从2014文章中看又像是有监督)。最后,要“from algorithm to theory”和“from theory to algorithm”,两者之间要有一个互相促进的关系。

- Domain之间我们一开始就假设有差异,但是真的有差异吗?有的是什么差异?怎么去判断差异存在必要性和是否存在差异?(这个问题我感觉他们讲的更侧重于从实验出发,所以感觉对于这个问题还没有系统性地思考。)

- 如何评估域适应的结果?例如如果是用GAN生成的脸,首先看face是否是真实的脸,身份是否发生了变化?其次就是生成的脸是否符合人类的认知,是否像是一个脸?所以就是分为主观(其他SDK,如googleAPI)和客观(各种指标)两个方面来进行评价。