MySQL运维篇(二)

四.MyCat

4.1 MyCat概述

4.1.1 介绍

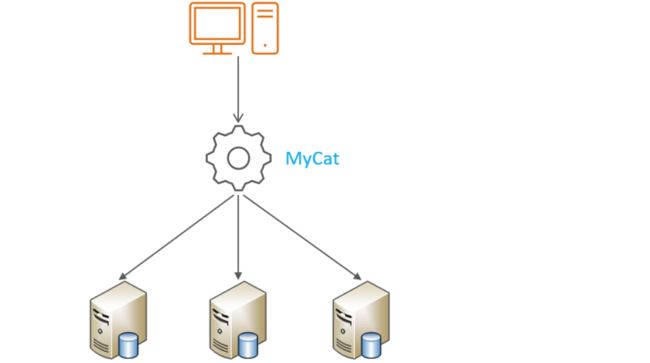

Mycat是开源的、活跃的、基于Java语言编写的数据库中间件。可以像使用mysql一样来使用 mycat,对于开发人员来说根本感觉不到mycat的存在。mycat不单只可以做MySQL的代理,其它常用的数据库也可以。

开发人员只需要连接MyCat即可,而具体底层用到几台数据库,每一台数据库服务器里面存储了什么数据,都无需关心。 具体的分库分表的策略,只需要在MyCat中配置即可。

优势: 性能可靠稳定、强大的技术团队、体系完善、社区活跃

4.1.2 下载

下载地址:http://dl.mycat.org.cn/

4.1.3 安装

Mycat是采用java语言开发的开源的数据库中间件,支持Windows和Linux运行环境,下面介绍 MyCat的Linux中的环境搭建。我们需要在准备好的服务器中安装如下软件。

- MySQL

- JDK

- Mycat

4.1.4 目录介绍

conf:存放mycat的配置文件

lib:存放mycat的项目依赖包(jar)

logs:存放mycat的日志文件

4.1.5 概念介绍

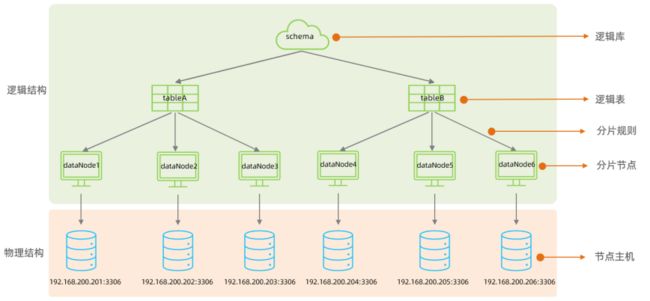

在MyCat的整体结构中,分为两个部分:上面的逻辑结构、下面的物理结构。

在MyCat的逻辑结构主要负责逻辑库、逻辑表、分片规则、分片节点等逻辑结构的处理,而具体的数据 存储还是在物理结构,也就是数据库服务器中存储的。

在后面讲解MyCat入门以及MyCat分片时,还会讲到上面所提到的概念。

4.2 MyCat配置

4.2.1 schema.xml

schema.xml 作为MyCat中最重要的配置文件之一 , 涵盖了MyCat的逻辑库 、 逻辑表 、 分片规 则、分片节点及数据源的配置。

主要包含以下三组标签:

- schema标签

- datanode标签

- datahost标签

1.schema标签

A.schema 中定义逻辑库

schema 标签用于定义 MyCat实例中的逻辑库 , 一个MyCat实例中, 可以有多个逻辑库 , 可以通 过 schema 标签来划分不同的逻辑库。MyCat中的逻辑库的概念,等同于MySQL中的database概念 , 需要操作某个逻辑库下的表时, 也需要切换逻辑库(use xxx)。

核心属性:

- name:指定自定义的逻辑库库名

- checkSQLschema:在SQL语句操作时指定了数据库名称,执行时是否自动去除;true:自动去 除,false:不自动去除

- sqlMaxLimit:如果未指定limit进行查询,列表查询模式查询多少条记录

B.schema 中的table定义逻辑表

table 标签定义了MyCat中逻辑库schema下的逻辑表 , 所有需要拆分的表都需要在table标签中定 义

核心属性:

- name:定义逻辑表表名,在该逻辑库下唯一

- dataNode:定义逻辑表所属的dataNode,该属性需要与dataNode标签中name对应;多个 dataNode逗号分隔

- rule:分片规则的名字,分片规则名字是在rule.xml中定义的

- primaryKey:逻辑表对应真实表的主键

- type:逻辑表的类型,目前逻辑表只有全局表和普通表,如果未配置,就是普通表;全局表,配 置为 global

2.datanode标签

核心属性:

- name:定义数据节点名称

- dataHost:数据库实例主机名称,引用自 dataHost 标签中name属性

- database:定义分片所属数据库

3.datahost标签

该标签在MyCat逻辑库中作为底层标签存在, 直接定义了具体的数据库实例、读写分离、心跳语句。

核心属性:

- name:唯一标识,供上层标签使用

- maxCon/minCon:最大连接数/最小连接数

- balance:负载均衡策略,取值 0,1,2,3

- writeType:写操作分发方式(0:写操作转发到第一个writeHost,第一个挂了,切换到第二 个;1:写操作随机分发到配置的writeHost)

- dbDriver:数据库驱动,支持 native、jdbc

4.2.2 rule.xml

rule.xml中定义所有拆分表的规则, 在使用过程中可以灵活的使用分片算法, 或者对同一个分片算法 使用不同的参数, 它让分片过程可配置化。主要包含两类标签:tableRule、Function。

4.2.3 server.xml

server.xml配置文件包含了MyCat的系统配置信息,主要有两个重要的标签:system、user。

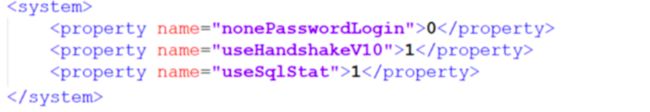

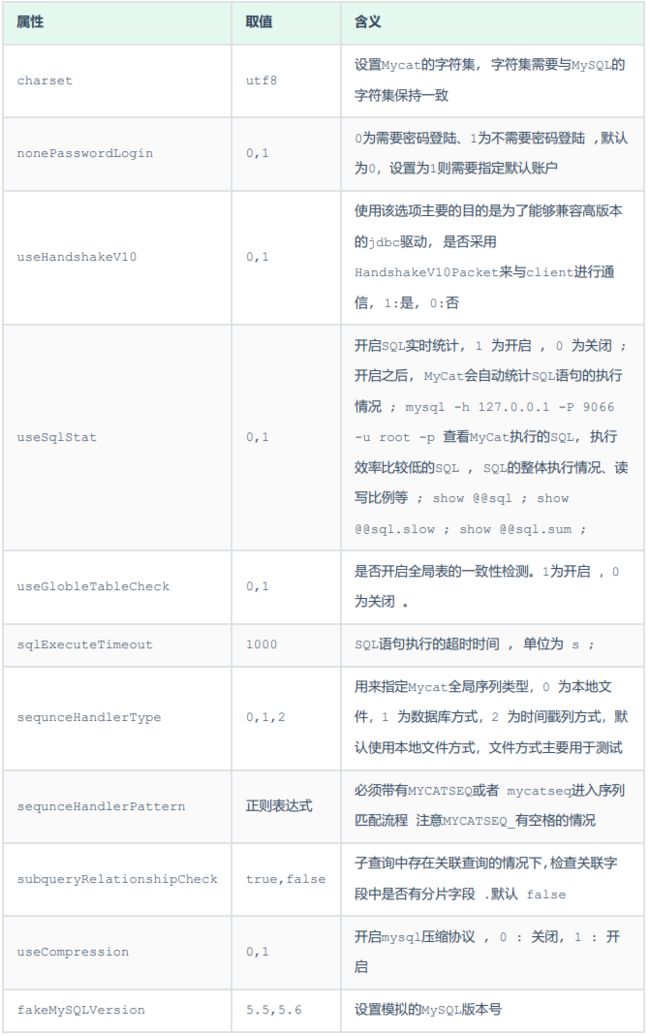

1.system标签

主要配置MyCat中的系统配置信息,对应的系统配置项及其含义,如下:

2.user标签

配置MyCat中的用户、访问密码,以及用户针对于逻辑库、逻辑表的权限信息,具体的权限描述方式及 配置说明如下:

在测试权限操作时,我们只需要将 privileges 标签的注释放开。 在 privileges 下的schema 标签中配置的dml属性配置的是逻辑库的权限。 在privileges的schema下的table标签的dml属性中配置逻辑表的权限。

4.3 MyCat分片

4.3.1 垂直拆分

对数据库进行垂直拆分

1.场景

在业务系统中, 涉及以下表结构 ,但是由于用户与订单每天都会产生大量的数据, 单台服务器的数据 存储及处理能力是有限的, 可以对数据库表进行拆分, 原有的数据库表如下。

现在考虑将其进行垂直分库操作,将商品相关的表拆分到一个数据库服务器,订单表拆分的一个数据库 服务器,用户及省市区表拆分到一个服务器。最终结构如下:

2.准备

准备三台服务器,IP地址如图所示:

并且在192.168.200.210,192.168.200.213, 192.168.200.214上面创建名为shopping数据库。

3.配置

A.schema.xml配置

select user()

select user()

select user()

B.server.xml配置

123456

SHOPPING

123456

SHOPPING

true

4.测试

A.上传测试SQL脚本到服务器的/root目录(资料里面有)

![]()

B.执行指令导入测试数据

重新启动MyCat后,在mycat的命令行中,通过source指令导入表结构,以及对应的数据,查看数据分布情况。

source /root/shopping-table.sql

source /root/shopping-insert.sql

将表结构及对应的测试数据导入之后,可以检查一下各个数据库服务器中的表结构分布情况。 检查是否和我们准备工作中规划的服务器一致。

C.查询用户的收件人及收件人地址信息(包含省、市、区)

在MyCat的命令行中,当我们执行以下多表联查的SQL语句时,可以正常查询出数据。

select ua.user_id, ua.contact, p.province, c.city, r.area , ua.address from

tb_user_address ua ,tb_areas_city c , tb_areas_provinces p ,tb_areas_region r

where ua.province_id = p.provinceid and ua.city_id = c.cityid and ua.town_id =

r.areaid ;

D.查询每一笔订单及订单的收件地址信息(包含省、市、区)

实现该需求对应的SQL语句如下:

SELECT order_id , payment ,receiver, province , city , area FROM tb_order_master o

, tb_areas_provinces p , tb_areas_city c , tb_areas_region r WHERE

o.receiver_province = p.provinceid AND o.receiver_city = c.cityid AND

o.receiver_region = r.areaid ;但是现在存在一个问题,订单相关的表结构是在 192.168.200.213 数据库服务器中,而省市区的数 据库表是在 192.168.200.214 数据库服务器中。那么在MyCat中执行是否可以成功呢?

经过测试,我们看到,SQL语句执行报错。原因就是因为MyCat在执行该SQL语句时,需要往具体的数 据库服务器中路由,而当前没有一个数据库服务器完全包含了订单以及省市区的表结构,造成SQL语句失败,报错。

对于上述的这种现象,我们如何来解决呢? 下面要介绍的全局表,就可以轻松解决这个问题。

5.全局表

对于省、市、区/县表tb_areas_provinces , tb_areas_city , tb_areas_region,是属于 数据字典表,在多个业务模块中都可能会遇到,可以将其设置为全局表,利于业务操作。

修改schema.xml中的逻辑表的配置,修改 tb_areas_provinces、tb_areas_city、 tb_areas_region 三个逻辑表,增加 type 属性,配置为global,就代表该表是全局表,就会在 所涉及到的dataNode中创建给表。对于当前配置来说,也就意味着所有的节点中都有该表了。

配置完毕后,重新启动MyCat。

1). 删除原来每一个数据库服务器中的所有表结构

2). 通过source指令,导入表及数据

source /root/shopping-table.sql

source /root/shopping-insert.sql

3). 检查每一个数据库服务器中的表及数据分布,看到三个节点中都有这三张全局表

4). 然后再次执行上面的多表联查的SQL语句

SELECT order_id , payment ,receiver, province , city , area FROM tb_order_master o

, tb_areas_provinces p , tb_areas_city c , tb_areas_region r WHERE

o.receiver_province = p.provinceid AND o.receiver_city = c.cityid AND

o.receiver_region = r.areaid ;

是可以正常执行成功的。

5). 当在MyCat中更新全局表的时候,我们可以看到,所有分片节点中的数据都发生了变化,每个节点的全局表数据时刻保持一致。

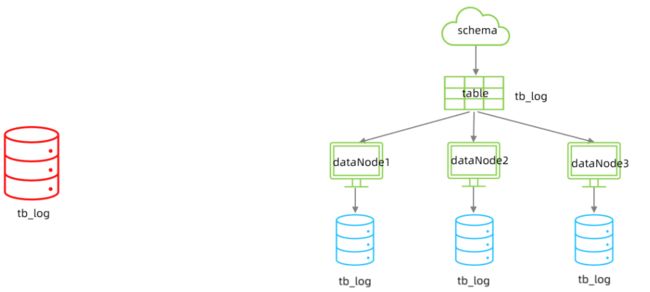

4.3.2 水平拆分

对数据库中的表进行水平拆分

1.场景

在业务系统中, 有一张表(日志表), 业务系统每天都会产生大量的日志数据 , 单台服务器的数据存 储及处理能力是有限的, 可以对数据库表进行拆分。

2.准备

准备三台服务器,具体的结构如下:

并且,在三台数据库服务器中分表创建一个数据库itcast。

3.配置

A.schema.xml

tb_log表最终落在3个节点中,分别是 dn4、dn5、dn6 ,而具体的数据分别存储在 dhost1、 dhost2、dhost3的itcast数据库中。

2.server.xml

配置root用户既可以访问 SHOPPING 逻辑库,又可以访问ITCAST逻辑库。

123456

SHOPPING,ITCAST

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行如下SQL创建表、并插入数据,查看数据分布情况。

CREATE TABLE tb_log (

id bigint(20) NOT NULL COMMENT 'ID',

model_name varchar(200) DEFAULT NULL COMMENT '模块名',

model_value varchar(200) DEFAULT NULL COMMENT '模块值',

return_value varchar(200) DEFAULT NULL COMMENT '返回值',

return_class varchar(200) DEFAULT NULL COMMENT '返回值类型',

operate_user varchar(20) DEFAULT NULL COMMENT '操作用户',

operate_time varchar(20) DEFAULT NULL COMMENT '操作时间',

param_and_value varchar(500) DEFAULT NULL COMMENT '请求参数名及参数值',

operate_class varchar(200) DEFAULT NULL COMMENT '操作类',

operate_method varchar(200) DEFAULT NULL COMMENT '操作方法',

cost_time bigint(20) DEFAULT NULL COMMENT '执行方法耗时, 单位 ms',

source int(1) DEFAULT NULL COMMENT '来源 : 1 PC , 2 Android , 3 IOS',

PRIMARY KEY (id)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

INSERT INTO tb_log (id, model_name, model_value, return_value, return_class,

operate_user, operate_time, param_and_value, operate_class, operate_method,

cost_time,source)

VALUES('1','user','insert','success','java.lang.String','10001','2022-01-06

18:12:28','{\"age\":\"20\",\"name\":\"Tom\",\"gender\":\"1\"}','cn.itcast.contro

ller.UserController','insert','10',1);

INSERT INTO tb_log (id, model_name, model_value, return_value, return_class,

operate_user, operate_time, param_and_value, operate_class, operate_method,

cost_time,source)

VALUES('2','user','insert','success','java.lang.String','10001','2022-01-06

18:12:27','{\"age\":\"20\",\"name\":\"Tom\",\"gender\":\"1\"}','cn.itcast.contro

ller.UserController','insert','23',1);

INSERT INTO tb_log (id, model_name, model_value, return_value, return_class,

operate_user, operate_time, param_and_value, operate_class, operate_method,

cost_time,source)

VALUES('3','user','update','success','java.lang.String','10001','2022-01-06

18:16:45','{\"age\":\"20\",\"name\":\"Tom\",\"gender\":\"1\"}','cn.itcast.contro

ller.UserController','update','34',1);

INSERT INTO tb_log (id, model_name, model_value, return_value, return_class,

operate_user, operate_time, param_and_value, operate_class, operate_method,

cost_time,source)

VALUES('4','user','update','success','java.lang.String','10001','2022-01-06

18:16:45','{\"age\":\"20\",\"name\":\"Tom\",\"gender\":\"1\"}','cn.itcast.contro

ller.UserController','update','13',2);

INSERT INTO tb_log (id, model_name, model_value, return_value, return_class,

operate_user, operate_time, param_and_value, operate_class, operate_method,

cost_time,source)

VALUES('5','user','insert','success','java.lang.String','10001','2022-01-06

18:30:31','{\"age\":\"200\",\"name\":\"TomCat\",\"gender\":\"0\"}','cn.itcast.co

ntroller.UserController','insert','29',3);

INSERT INTO tb_log (id, model_name, model_value, return_value, return_class,

operate_user, operate_time, param_and_value, operate_class, operate_method,

cost_time,source)

VALUES('6','user','find','success','java.lang.String','10001','2022-01-06

18:30:31','{\"age\":\"200\",\"name\":\"TomCat\",\"gender\":\"0\"}','cn.itcast.co

ntroller.UserController','find','29',2);4.4 分片规则

4.4.1 范围分片

1.介绍

根据指定的字段及其配置的范围与数据节点的对应情况, 来决定该数据属于哪一个分片。

2.配置

schema.xml逻辑表配置:

schema.xml数据节点配置:

rule.xml分片规则配置:

id

rang-long

autopartition-long.txt

0

分片规则配置属性含义:

在rule.xml中配置分片规则时,关联了一个映射配置文件 autopartition-long.txt,该配置文件的配置如下:

# range start-end ,data node index

# K=1000,M=10000.

0-500M=0

500M-1000M=1

1000M-1500M=2含义:0-500万之间的值,存储在0号数据节点(数据节点的索引从0开始) ; 500万-1000万之间的 数据存储在1号数据节点 ; 1000万-1500万的数据节点存储在2号节点 ;该分片规则,主要是针对于数字类型的字段适用。

4.4.2 取模分片

1.介绍

根据指定的字段值与节点数量进行求模运算,根据运算结果, 来决定该数据属于哪一个分片。

2.配置

schema.xml逻辑表配置:

schema.xml数据节点配置:

rule.xml分片规则配置:

id

mod-long

3

分片规则属性说明如下:

该分片规则,主要是针对于数字类型的字段适用。 在前面水平拆分的演示中,我们选择的就是取模分片。

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行SQL语句创建表、并插入数据,查看数据分布情况。

4.4.3 一致性hash分片

1.介绍

所谓一致性哈希,相同的哈希因子计算值总是被划分到相同的分区表中,不会因为分区节点的增加而改 变原来数据的分区位置,有效的解决了分布式数据的拓容问题。

2. 配置

schema.xml中逻辑表配置:

schema.xml中数据节点配置:

rule.xml中分片规则配置:

id

murmur

0

3

160

分片规则属性含义:

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行如下SQL创建表、并插入数据,查看数 据分布情况。

create table tb_order(

id varchar(100) not null primary key,

money int null,

content varchar(200) null

);

INSERT INTO tb_order (id, money, content) VALUES ('b92fdaaf-6fc4-11ec-b831-

482ae33c4a2d', 10, 'b92fdaf8-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b93482b6-6fc4-11ec-b831-

482ae33c4a2d', 20, 'b93482d5-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b937e246-6fc4-11ec-b831-

482ae33c4a2d', 50, 'b937e25d-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b93be2dd-6fc4-11ec-b831-

482ae33c4a2d', 100, 'b93be2f9-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b93f2d68-6fc4-11ec-b831-

482ae33c4a2d', 130, 'b93f2d7d-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b9451b98-6fc4-11ec-b831-

482ae33c4a2d', 30, 'b9451bcc-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b9488ec1-6fc4-11ec-b831-

482ae33c4a2d', 560, 'b9488edb-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b94be6e6-6fc4-11ec-b831-

482ae33c4a2d', 10, 'b94be6ff-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b94ee10d-6fc4-11ec-b831-

482ae33c4a2d', 123, 'b94ee12c-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b952492a-6fc4-11ec-b831-

482ae33c4a2d', 145, 'b9524945-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b95553ac-6fc4-11ec-b831-

482ae33c4a2d', 543, 'b95553c8-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b9581cdd-6fc4-11ec-b831-

482ae33c4a2d', 17, 'b9581cfa-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b95afc0f-6fc4-11ec-b831-

482ae33c4a2d', 18, 'b95afc2a-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b95daa99-6fc4-11ec-b831-

482ae33c4a2d', 134, 'b95daab2-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b9667e3c-6fc4-11ec-b831-

482ae33c4a2d', 156, 'b9667e60-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b96ab489-6fc4-11ec-b831-

482ae33c4a2d', 175, 'b96ab4a5-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b96e2942-6fc4-11ec-b831-

482ae33c4a2d', 180, 'b96e295b-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b97092ec-6fc4-11ec-b831-

482ae33c4a2d', 123, 'b9709306-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b973727a-6fc4-11ec-b831-

482ae33c4a2d', 230, 'b9737293-6fc4-11ec-b831-482ae33c4a2d');

INSERT INTO tb_order (id, money, content) VALUES ('b978840f-6fc4-11ec-b831-

482ae33c4a2d', 560, 'b978843c-6fc4-11ec-b831-482ae33c4a2d');

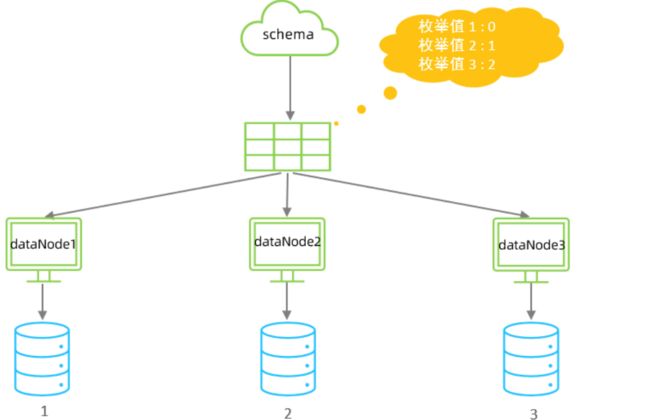

4.4.4 枚举分片

1.介绍

通过在配置文件中配置可能的枚举值, 指定数据分布到不同数据节点上, 本规则适用于按照省份、性 别、状态拆分数据等业务 。

2.配置

schema.xml中逻辑表配置:

schema.xml中数据节点配置:

rule.xml中分片规则配置:

sharding_id

hash-int

status

hash-int

2

partition-hash-int.txt

partition-hash-int.txt ,内容如下 :

1=0

2=1

3=2分片规则属性含义:

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行如下SQL创建表、并插入数据,查看数 据分布情况。

CREATE TABLE tb_user (

id bigint(20) NOT NULL COMMENT 'ID',

username varchar(200) DEFAULT NULL COMMENT '姓名',

status int(2) DEFAULT '1' COMMENT '1: 未启用, 2: 已启用, 3: 已关闭',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

insert into tb_user (id,username ,status) values(1,'Tom',1);

insert into tb_user (id,username ,status) values(2,'Cat',2);

insert into tb_user (id,username ,status) values(3,'Rose',3);

insert into tb_user (id,username ,status) values(4,'Coco',2);

insert into tb_user (id,username ,status) values(5,'Lily',1);

insert into tb_user (id,username ,status) values(6,'Tom',1);

insert into tb_user (id,username ,status) values(7,'Cat',2);

insert into tb_user (id,username ,status) values(8,'Rose',3);

insert into tb_user (id,username ,status) values(9,'Coco',2);

insert into tb_user (id,username ,status) values(10,'Lily',1);4.4.5 应用指定算法

1.介绍

运行阶段由应用自主决定路由到那个分片 , 直接根据字符子串(必须是数字)计算分片号。

2.配置

schema.xml中逻辑表配置:

schema.xml中数据节点配置:

rule.xml中分片规则配置:

id

sharding-by-substring

0

2

3

0

分片规则属性含义:

示例说明 : id=05-100000002 , 在此配置中代表根据id中从 startIndex=0,开始,截取siz=2位数字即 05,05就是获取的分区,如果没找到对应的分片则默认分配到defaultPartition 。

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行如下SQL创建表、并插入数据,查看数 据分布情况。

CREATE TABLE tb_app (

id varchar(10) NOT NULL COMMENT 'ID',

name varchar(200) DEFAULT NULL COMMENT '名称',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

insert into tb_app (id,name) values('0000001','Testx00001');

insert into tb_app (id,name) values('0100001','Test100001');

insert into tb_app (id,name) values('0100002','Test200001');

insert into tb_app (id,name) values('0200001','Test300001');

insert into tb_app (id,name) values('0200002','TesT400001');

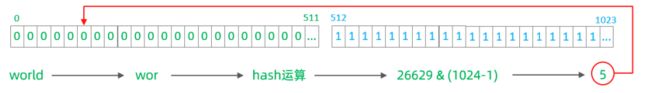

4.4.6 固定分片hash算法

1. 介绍

该算法类似于十进制的求模运算,但是为二进制的操作,例如,取 id 的二进制低 10 位 与 1111111111 进行位 & 运算,位与运算最小值为 0000000000,最大值为1111111111,转换为十 进制,也就是位于0-1023之间。

特点:

- 如果是求模,连续的值,分别分配到各个不同的分片;但是此算法会将连续的值可能分配到相同的 分片,降低事务处理的难度。

- 可以均匀分配,也可以非均匀分配。

- 分片字段必须为数字类型。

2.配置

schema.xml中逻辑表配置:

schema.xml中数据节点配置:

rule.xml中分片规则配置:

id

sharding-by-long-hash

2,1

256,512

分片规则属性含义:

约束 :

1). 分片长度 : 默认最大2^10 , 为 1024 ;

2). count, length的数组长度必须是一致的 ; 以上分为三个分区:0-255,256-511,512-1023

示例说明 :

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行如下SQL创建表、并插入数据,查看数据分布情况。

CREATE TABLE tb_longhash (

id int(11) NOT NULL COMMENT 'ID',

name varchar(200) DEFAULT NULL COMMENT '名称',

firstChar char(1) COMMENT '首字母',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

insert into tb_longhash (id,name,firstChar) values(1,'七匹狼','Q');

insert into tb_longhash (id,name,firstChar) values(2,'八匹狼','B');

insert into tb_longhash (id,name,firstChar) values(3,'九匹狼','J');

insert into tb_longhash (id,name,firstChar) values(4,'十匹狼','S');

insert into tb_longhash (id,name,firstChar) values(5,'六匹狼','L');

insert into tb_longhash (id,name,firstChar) values(6,'五匹狼','W');

insert into tb_longhash (id,name,firstChar) values(7,'四匹狼','S');

insert into tb_longhash (id,name,firstChar) values(8,'三匹狼','S');

insert into tb_longhash (id,name,firstChar) values(9,'两匹狼','L');4.4.7 字符串hash解析算法

1.介绍

截取字符串中的指定位置的子字符串, 进行hash算法, 算出分片。

2.配置

schema.xml中逻辑表配置:

schema.xml中数据节点配置:

rule.xml中分片规则配置:

name

sharding-by-stringhash

512

2

0:2

分片规则属性含义:

示例说明:

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行如下SQL创建表、并插入数据,查看数 据分布情况。

create table tb_strhash(

name varchar(20) primary key,

content varchar(100)

)engine=InnoDB DEFAULT CHARSET=utf8mb4;

INSERT INTO tb_strhash (name,content) VALUES('T1001', UUID());

INSERT INTO tb_strhash (name,content) VALUES('ROSE', UUID());

INSERT INTO tb_strhash (name,content) VALUES('JERRY', UUID());

INSERT INTO tb_strhash (name,content) VALUES('CRISTINA', UUID());

INSERT INTO tb_strhash (name,content) VALUES('TOMCAT', UUID());4.4.8 按天分片算法

1.介绍

按照日期及对应的时间周期来分片。

2.配置

schema.xml中逻辑表配置:

schema.xml中数据节点配置:

rule.xml中分片规则配置:

create_time

sharding-by-date

yyyy-MM-dd

2022-01-01

2022-01-30

10

分片规则属性含义:

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行如下SQL创建表、并插入数据,查看数据分布情况。

create table tb_datepart(

id bigint not null comment 'ID' primary key,

name varchar(100) null comment '姓名',

create_time date null

);

insert into tb_datepart(id,name ,create_time) values(1,'Tom','2022-01-01');

insert into tb_datepart(id,name ,create_time) values(2,'Cat','2022-01-10');

insert into tb_datepart(id,name ,create_time) values(3,'Rose','2022-01-11');

insert into tb_datepart(id,name ,create_time) values(4,'Coco','2022-01-20');

insert into tb_datepart(id,name ,create_time) values(5,'Rose2','2022-01-21');

insert into tb_datepart(id,name ,create_time) values(6,'Coco2','2022-01-30');

insert into tb_datepart(id,name ,create_time) values(7,'Coco3','2022-01-31');

4.4.9 自然月分片

1.介绍

使用场景为按照月份来分片, 每个自然月为一个分片。

2.配置

schema.xml中逻辑表配置:

schema.xml中数据节点配置:

rule.xml中分片规则配置:

create_time

partbymonth

yyyy-MM-dd

2022-01-01

2022-03-31

分片规则属性含义:

3.测试

配置完毕后,重新启动MyCat,然后在mycat的命令行中,执行如下SQL创建表、并插入数据,查看数 据分布情况。

create table tb_monthpart(

id bigint not null comment 'ID' primary key,

name varchar(100) null comment '姓名',

create_time date null

);

insert into tb_monthpart(id,name ,create_time) values(1,'Tom','2022-01-01');

insert into tb_monthpart(id,name ,create_time) values(2,'Cat','2022-01-10');

insert into tb_monthpart(id,name ,create_time) values(3,'Rose','2022-01-31');

insert into tb_monthpart(id,name ,create_time) values(4,'Coco','2022-02-20');

insert into tb_monthpart(id,name ,create_time) values(5,'Rose2','2022-02-25');

insert into tb_monthpart(id,name ,create_time) values(6,'Coco2','2022-03-10');

insert into tb_monthpart(id,name ,create_time) values(7,'Coco3','2022-03-31');

insert into tb_monthpart(id,name ,create_time) values(8,'Coco4','2022-04-10');

insert into tb_monthpart(id,name ,create_time) values(9,'Coco5','2022-04-30');4.5 MyCat管理及监控

4.5.1 MyCat原理

在MyCat中,当执行一条SQL语句时,MyCat需要进行SQL解析、分片分析、路由分析、读写分离分析 等操作,最终经过一系列的分析决定将当前的SQL语句到底路由到那几个(或哪一个)节点数据库,数据库将数据执行完毕后,如果有返回的结果,则将结果返回给MyCat,最终还需要在MyCat中进行结果合 并、聚合处理、排序处理、分页处理等操作,最终再将结果返回给客户端。

而在MyCat的使用过程中,MyCat官方也提供了一个管理监控平台MyCat-Web(MyCat-eye)。 Mycat-web 是 Mycat 可视化运维的管理和监控平台,弥补了 Mycat 在监控上的空白。帮 Mycat 分担统计任务和配置管理任务。Mycat-web 引入了 ZooKeeper 作为配置中心,可以管理多个节点。Mycat-web 主要管理和监控 Mycat 的流量、连接、活动线程和内存等,具备 IP 白名单、邮件告警等模块,还可以统计 SQL 并分析慢 SQL 和高频 SQL 等。为优化 SQL 提供依据。

4.5.2 MyCat管理

Mycat默认开通2个端口,可以在server.xml中进行修改。

- 8066 数据访问端口,即进行 DML 和 DDL 操作。

- 9066 数据库管理端口,即 mycat 服务管理控制功能,用于管理mycat的整个集群状态 连接MyCat的管理控制台:

mysql -h 192.168.200.210 -p 9066 -uroot -p123456

4.5.3 MyCat-eye

1.介绍

Mycat-web(Mycat-eye)是对mycat-server提供监控服务,功能不局限于对mycat-server使用。他通过JDBC连接对Mycat、Mysql监控,监控远程服务器(目前仅限于linux系统)的cpu、内 存、网络、磁盘。

Mycat-eye运行过程中需要依赖zookeeper,因此需要先安装zookeeper。

2.安装

1). zookeeper安装

2). Mycat-web安装

3.访问

地址:http://192.168.200.210:8082/mycat

4.配置

1). 开启MyCat的实时统计功能(server.xml)

1

2). 在Mycat监控界面配置服务地址

5.测试

配置好了之后,我们可以通过MyCat执行一系列的增删改查的测试,然后过一段时间之后,打开 mycat-eye的管理界面,查看mycat-eye监控到的数据信息。

A. 性能监控

B. 物理节点

C.SQL统计

D.SQL表分析

E. SQL监控

F. 高频SQL