啃Docker之Docker资源控制(Cgroup资源配置方法)

啃Docker之Docker资源控制(Cgroup资源配置方法)

- 前言

- 一:Cgroup资源分配

-

- 1.1:为什么容器要做资源分配?

- 1.2:Cgroup概述

- 1.2:使用stress压力测试工具来测试CPU和内存使用状况

-

- 1.2.1:stress工具介绍

- 1.2.2:操作步骤

- 二:CPU的周期限制

-

- 2.1:操作步骤

- 三:CPU Core控制

-

- 3.1:实操步骤

- 四:CPU配额控制参数的混合使用

-

- 4.1:实操步骤

- 五:内存限额

-

- 5.1:实操步骤

- 六:Block IO的限制

-

- 6.1:实操步骤

- 七:bps和iops的限制

-

- 7.1:实操步骤

前言

默认情况下容器是没有资源限制的,因为它本身就是一个进程,当一个容器占用太多资源的话,会对其他容器产生影响,所以 ,合理应该分配容器资源是作为管理员必须要关注的问题。

一:Cgroup资源分配

1.1:为什么容器要做资源分配?

-

虚拟机在创建的时候就已经做了资源分配,(虚拟CPU,虚拟内存,虚拟磁盘等)

-

容器是共享内核资源的,所以需要用Cgroup资源分配,参照因素是往年的监控系统中服务的吞吐量,和资源数据,资源耗用情况来分配

1.2:Cgroup概述

-

Docker通过Cgroup来控制容器使用的资源配额,包括CPU,内存,磁盘三大方面,基本覆盖了常见的资源配额和使用量的控制

-

Cgroup是Control Groups的缩写,是Linux内核提供的一种限制,记录,隔离进程组所使用的物理资源(如CPU 内存 磁盘IO 等等)的机制,被LXC docker等很多项目用于实现进程资源控制。Cgroup本身是提供将进程进行分组化管理的功能和接口的基础结构,I/O或内存的分配控制等,这些具体的资源管理功能称为Cgroup子系统,有以下几个大子系统实现:

- Blkio:设置限制每个存储块设备的管理(硬盘等)的输入输出控制,例如:磁盘 光盘以及usb等等

- CPU:使用调度程序为cgroup任务提供CPU的访问

- Cpuacct:产生cgroup任务提供CPU的访问

- Cpuacct:产生cgroup任务的CPU资源报告

- Cpuset:如果是多核心的CPU,这个子系统会为cgroup任务分配单独的CPU和内存

- Devices:允许或拒绝cgroup任务对设备的访问

- Freezer:暂停和恢复cgroup任务

- Memory:设置每个cgroup的内存限制以及产生内存资源报告

- Net_cls:标记每个网络包以供cgroup方便使用

- Ns:命名空间子系统

- Perf_event:增加了对每个group的监测跟踪的能力,可以监测属于某个特定的group的所有线程以及运行在特定CPU上的线程

1.2:使用stress压力测试工具来测试CPU和内存使用状况

1.2.1:stress工具介绍

stress 是Unix类系统下的工作量和压力测试工具。它将对用户指定的CPU数量的I/O,内存和硬盘的负载并报告它检测到任何错误。它用于自动压力测试和调试系统组件失败的唯一或更经常负荷时。它可以运行在x86,ppc64的,和PPC 32 GNU / Linux的,Tru64的,SPARC Solaris的,和其他平台

1.2.2:操作步骤

- 使用Dockerfile来创建一个基于centos的stress工具镜像

[root@localhost ~]# setenforce 0

[root@localhost ~]# iptables -F

[root@localhost ~]# systemctl start docker '开启docker功能'

[root@localhost opt]# mkdir /opt/stress '在/opt目录下创建一个stress目录'

[root@localhost stress]# cd /opt/stress/

[root@localhost stress]# vim Dockerfile '创建stress的镜像'

FROM centos:7 '基于Centos:7的镜像'

MAINTAINER This is cai '描述信息'

RUN yum -y install wget '安装wget下载工具'

RUN wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo '去阿里云官网配置yum源'

RUN yum -y install stress ##安装stress

[root@localhost stress]# docker build -t centos:stress . '创建镜像'

- 创建容器,–cpu-shares参数值不能保证可以获得1个vcpu或者多少GHz的CPU资源,它仅是一个弹性的加权值

[root@localhost stress]# docker run -itd --cpu-shares 100 centos:stress

-

说明:默认情况下,每个Docker容器的CPU份额都是1024,单独一个容器的份额是没有意义的。只有在同时运行多个容器时,容器的CPU加权的效果才能体现出来。

-

例如:如果两个容器A B的CPU分别为1000和500,在CPU进行时间片分配的时候,容器A比容器B多一倍机会获得CPU的时间片

-

但分配的结果取决于当时主机和其他容器的运行状态,实际上也无法保证容器A一定能获得CPU时间片。比如容器A的进程一直是空闲的,那么容器B是可以获取比容器A更多的CPU时间篇的。极端情况下,例如主机上只运行了一个容器,即使它的CPU份额只有50,它也可以独占整个主机的CPU资源

-

Cgroups只在容器分配资源紧缺时,即在需要对容器使用的资源进行限制时,才会生效。因此无法单纯根据某个容器的CPU份额来确定有多少CPU资源分配,结果取决于同时运行的其他容器的CPU分配和容器中进程运行情况

-

可以通过cpu share 可以设置容器使用CPU的优先级,比如启动了两个容器及运行查看CPU使用百分比

-

运行容器 容器名字为cpu512 ;–cpu-shares 512权重是512;镜像为centos:stress; stress -c 10:分配10个子进程

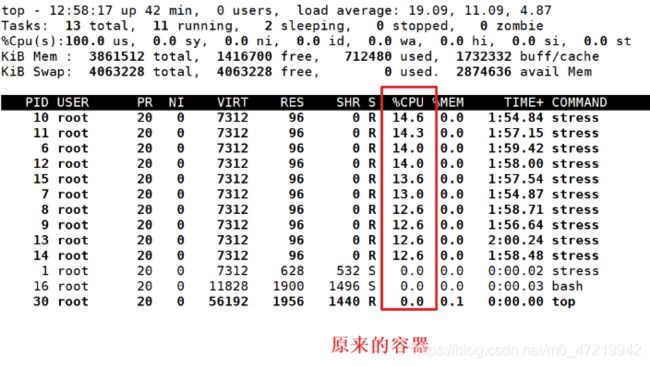

[root@localhost stress]# docker run -itd --name cpu512 --cpu-shares 512 centos:stress stress -c 10 #容器产生10个子函数进程

[root@localhost stress]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

2f1330d9cf4b centos:stress "stress -c 10" 22 sec

[root@localhost stress]# docker exec -it 2f1330d9cf4b bash 进入容器使用户top查看CPU使用情况

'CPU的占用率大概在40%左右,跑了10个进程'

- 这时再打开一个终端,将权重设置为1024,查看区别

[

root@localhost ~]# docker run -itd --name cpu1024 --cpu-shares 1024 centos:stress stress -c 10

2ea71fafe6df1295294ccfa895d03973eedb49865a34ac9a0b6592ec021d37bf

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

2ea71fafe6df centos:stress "stress -c 10" 8 seconds ago Up 7 seconds cpu1024

2f1330d9cf4b centos:stress "stress -c 10" 4 minutes ago Up 4 minutes cpu512

[root@localhost ~]# docker exec -it 2ea71fafe6df bash

[root@2ea71fafe6df /]# top

'按1查看几个CPU的情况'

'发现cpu1024容器的CPU占用率大概在25%左右'

- 这时再回到cpu512容器这边,发现cpu的占用率为1024的一半 1:2的比例,说明权重设置成功

二:CPU的周期限制

-

Docker提供了 --cpu-period --cpu-quota两个参数控制容器可以分配到CPU时钟周期

- –cpu-period:是用来指定容器对CPU的使用要在多长时间内做一次重新分配

- –cpu-quota:是用来指定在这个周期内,最多可以有多少时间用来跑这个容器,与–cpu-shares不同的是这种配置是指定一个绝对值,容器对CPU资源的使用绝对不会超过配置的值

-

cpu-period和cpu-quota的单位是微秒。cpu-period的最小值为1000微妙,最大值为1秒,默认值为0.1秒

-

cpu-quota的值默认为-1,表示不做控制。Cpu-period和cpu-quota参数一般联合使用

-

例如:容器进程需要每1秒使用单个CPU的0.2秒时间,可以将cpu-period设置为1000000(即1秒),cpu-quota设置为200000(0.2秒)。当然在多核情况下,如果允许容器进程完全占用两个CPU,则可以将cpu-period设置为100000(0.1秒),cpu-quota设置为200000(0.2秒),也就是说,0.2秒代表要使用2个核心数资源,当把一个0.1秒的核心数用完,还有0.1秒的就需要找另一个核心数去完成

2.1:操作步骤

- 运行容器,设置cpu为0.1秒刷新时间,占用总资源配额的是0.2秒

[root@localhost stress]# docker run -itd --cpu-period 100000 --cpu-quota 200000 centos:stress

- 进入容器查看刷新周期和创建的配额值

[root@localhost stress]# docker run -tid --cpu-period 100000 --cpu-quota 200000 centos:stress

8ef8b10290ff87e6f455ab6faed35d6667e8f087ca41f3b019f12cbe95427133

[root@localhost stress]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

8ef8b10290ff centos:stress "/bin/bash" About a minute ago Up About a minute

[root@localhost stress]# docker exec -it 8ef8b10290ff bash

[root@8ef8b10290ff /]# cat /sys/fs/cgroup/cpu/cpu.cfs_period_us

100000 '刷新周期为0.1秒'

[root@8ef8b10290ff /]# cat /sys/fs/cgroup/cpu/cpu.cfs_quota_us

200000 '可以使用两个CPU资源'

三:CPU Core控制

-

对多核CPU的服务器。Docker还可以控制容器运行使用哪些CPU内核,即使用–cpuset-cpus参数

-

这对具有多CPU的服务器尤其有用,可以对需要提供性能计算的容器进行性能最优的配置

3.1:实操步骤

- 运行容器;容器名为cpu1 用到的核心数是0和1

[root@localhost stress]# docker run -itd --name cpu01 --cpuset-cpus 0-1 centos:stress

c07d9999818631cae0d2ee608e9d849316c87842b631ba04f57aae5d3026ef65

[root@localhost stress]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

c07d99998186 centos:stress "/bin/bash" 9 seconds ago Up 8 seconds cpu01

[root@localhost stress]# docker exec -it c07d99998186 bash

[root@c07d99998186 /]# cat /sys/fs/cgroup/cpuset/cpuset.cpus

0-1

- 通过下面的指令可以查看容器中进程与CPU内核的绑定关系,达到绑定CPU内核的目的

[root@localhost stress]# docker exec c07d99998186 taskset -c -p 1

pid 1's current affinity list: 0,1 ''PID进程绑定到0和1上面'

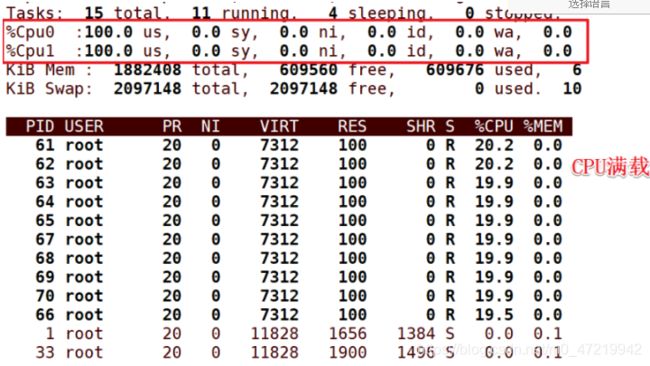

- 这时进入容器,让他跑10个线程,查看cpu0和1是否满载

[root@localhost stress]# docker exec -it c07d99998186 bash

[root@c07d99998186 /]# stress -c 10 '分配10个子进程'

'发现0和1的核心数满载,证明是绑定在0和1的核心数上'

[root@c07d99998186 /]# top

四:CPU配额控制参数的混合使用

-

通过cpuset-cpus参数指定容器A使用CPU内核0,容器B只是用CPU内核1

-

在主机上只有这两个容器使用对应CPU内核的情况,他们各自占用全部的内核资源,cpu-shares没有明显效果。

-

Cpuset-cpus cpuset-mems参数只在多核,多内存节点上的服务器有效,并且必须与实际的物理配置匹配,否则也无法达到资源控制的目的

-

在系统具有多个CPU内核的情况下,需要通过cpuset-cpus参数为设置容器CPU内核才能方便进行测试

4.1:实操步骤

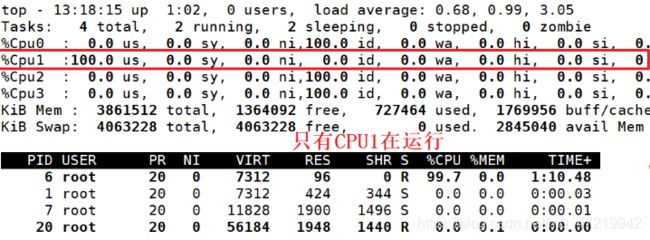

- 运行容器,容器名为cpu3;指定运行的核心数是1核心数,指定1个子进程

[root@localhost stress]# docker run -itd --name cpu3 --cpuset-cpus 1 centos:stress stress -c 1

32768c29c1fefff5c41556f6cbbfcc857eaadc177ed2654bec36048371db3b17

[root@localhost stress]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

32768c29c1fe centos:stress "stress -c 1" 6 seconds ago Up 5 seconds cpu3

[root@localhost stress]# docker exec -it 32768c29c1fe bash

[root@32768c29c1fe /]# top

五:内存限额

-

与操作系统类似,容器可使用的内存包括两个部分:物理内存和Swap

-

Docker通过下面两组参数来控制容器内存的使用量

- -m或–memory:设置物理内存的使用限额,例如100M;1024M

- –memory-swap:设置 内存+swap的使用限额

5.1:实操步骤

-

执行如下命令允许该容器最多使用200M内存和300M的swap

-

–vm1:启动1个内存工作线程

-

–vm-bytes 280M:每个线程分配280M内存(物理内存只有200M,所以会去借80M的虚拟内存,但是总内存数不能超过300M)

-

镜像名为:progrium/stress

[root@localhost ~]# docker run -it -m 200M --memory-swap=300M progrium/stress --vm 1 --vm-bytes 280M

- 如果让工作线程分配的内存超过300M,分配的内存超过限额,stress线程报错,容器会退出

[root@localhost ~]# docker run -it -m 200M --memory-swap=300M progrium/stress --vm 1 --vm-bytes 310M '设置的内存超过限额300M'

- 总结:物理内存资源小于等于(不能超过)内存+swap的使用限额

六:Block IO的限制

-

默认情况下,所有容器能平等地读写磁盘,可以通过设置–blkio-weight参数来改变容器Block IO的优先级

-

–blkio-weight与–cpu-shares类似,设置的是相对权重值,默认为500

6.1:实操步骤

- 设置容器A的磁盘读写权重为600

[root@localhost ~]# docker run -itd --name conA --blkio-weight 600 centos:stress

'进入容器查看设置情况'

[root@localhost stress]# docker exec -it 7b9d53a062fb bash

[root@7b9d53a062fb /]# cat /sys/fs/cgroup/blkio/blkio.weight

600 '设置的值为600'

- 这时在运行一个设置权重值为500,查看情况

[root@localhost stress]# docker run -itd --name conB --blkio-weight 500 centos:stress

fba42cee52fd4892b731bfefb6aa2d894e18747e72fcd79b50a0ba03c8893832

[root@localhost stress]# docker ps -a | grep conB

fba42cee52fd centos:stress "/bin/bash" 12 seconds ago Up 11 seconds

[root@localhost stress]# docker exec -it fba42cee52fd bash

[root@fba42cee52fd /]# cat /sys/fs/cgroup/blkio/blkio.weight

500

七:bps和iops的限制

-

bps是byte per second 每秒读写的数据量

-

iops是 io per second 每秒IO的次数

-

可通过以下的参数控制容器的bps和iops

- –device-read-bps:限制读某个设备的bps

- –device-write-bps:限制写某个设备的bps

- –device-read-iops:限制读某个设备的iops

- –device-write-iops:限制写某个设备的iops

7.1:实操步骤

- 将容器的sda系统盘的读写速率设置为5MB/s

[root@localhost ~]# docker run -it --device-write-bps /dev/sda:5MB centos:stress

- 进入容器写入1GB的文件,查看读写的速率

[root@455af49f49b7 /]# dd if=/dev/zero of=test bs=1M count=1024 oflag=direct

- 这时退出容器,重新创建容器不限速,查看读写速率

[root@455af49f49b7 /]# exit '退出容器'

exit

[root@localhost ~]# docker run -it centos:stress '不限速,运行容器'

[root@9e6875fda3e8 /]# dd if=/dev/zero of=test bs=1M count=1024 oflag=direct

1024+0 records in

1024+0 records out

1073741824 bytes (1.1 GB) copied, 0.980528 s, 1.1 GB/s ##发现不限速的读写速率是1.1GB/s

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-sRaWhrky-1601040748329)(C:\Users\kevin\AppData\Roaming\Typora\typora-user-images\image-20200925212926581.png)]](http://img.e-com-net.com/image/info8/5542c9b1c17d4745b4b18ead14112c02.jpg)