redis快速上手

Redis

1 概念

- 概念: redis是一款高性能的NOSQL系列的非关系型数据库

1.1.什么是NOSQL

NoSQL(NoSQL = Not Only SQL),意即“不仅仅是SQL”,是一项全新的数据库理念,泛指非关系型的数据库。

随着互联网web2.0网站的兴起,传统的关系数据库在应付web2.0网站,特别是超大规模和高并发的SNS类型的web2.0纯动态网站已经显得力不从心,暴露了很多难以克服的问题,而非关系型的数据库则由于其本身的特点得到了非常迅速的发展。NoSQL数据库的产生就是为了解决大规模数据集合多重数据种类带来的挑战,尤其是大数据应用难题。

1.1.1. NOSQL和关系型数据库比较

优点:

1)成本:nosql数据库简单易部署,基本都是开源软件,不需要像使用oracle那样花费大量成本购买使用,相比关系型数据库价格便宜。

2)查询速度:nosql数据库将数据存储于缓存之中,关系型数据库将数据存储在硬盘中,自然查询速度远不及nosql数据库。

3)存储数据的格式:nosql的存储格式是key,value形式、文档形式、图片形式等等,所以可以存储基础类型以及对象或者是集合等各种格式,而数据库则只支持基础类型。

4)扩展性:关系型数据库有类似join这样的多表查询机制的限制导致扩展很艰难。

缺点:

1)维护的工具和资料有限,因为nosql是属于新的技术,不能和关系型数据库10几年的技术同日而语。

2)不提供对sql的支持,如果不支持sql这样的工业标准,将产生一定用户的学习和使用成本。

3)不提供关系型数据库对事务的处理。

1.1.2. 非关系型数据库的优势:

1)性能NOSQL是基于键值对的,可以想象成表中的主键和值的对应关系,而且不需要经过SQL层的解析,所以性能非常高。

2)可扩展性同样也是因为基于键值对,数据之间没有耦合性,所以非常容易水平扩展。

1.1.3. 关系型数据库的优势:

1)复杂查询可以用SQL语句方便的在一个表以及多个表之间做非常复杂的数据查询。

2)事务支持使得对于安全性能很高的数据访问要求得以实现。对于这两类数据库,对方的优势就是自己的弱势,反之亦然。

1.1.4. 总结

关系型数据库与NoSQL数据库并非对立而是互补的关系,即通常情况下使用关系型数据库,在适合使用NoSQL的时候使用NoSQL数据库,

让NoSQL数据库对关系型数据库的不足进行弥补。

一般会将数据存储在关系型数据库中,在nosql数据库中备份存储关系型数据库的数据

1.2.主流的NOSQL产品

• 键值(Key-Value)存储数据库

相关产品: Tokyo Cabinet/Tyrant、Redis、Voldemort、Berkeley DB

典型应用: 内容缓存,主要用于处理大量数据的高访问负载。

数据模型: 一系列键值对

优势: 快速查询

劣势: 存储的数据缺少结构化

• 列存储数据库

相关产品:Cassandra, HBase, Riak

典型应用:分布式的文件系统

数据模型:以列簇式存储,将同一列数据存在一起

优势:查找速度快,可扩展性强,更容易进行分布式扩展

劣势:功能相对局限

• 文档型数据库

相关产品:CouchDB、MongoDB

典型应用:Web应用(与Key-Value类似,Value是结构化的)

数据模型: 一系列键值对

优势:数据结构要求不严格

劣势: 查询性能不高,而且缺乏统一的查询语法

• 图形(Graph)数据库

相关数据库:Neo4J、InfoGrid、Infinite Graph

典型应用:社交网络

数据模型:图结构

优势:利用图结构相关算法。

劣势:需要对整个图做计算才能得出结果,不容易做分布式的集群方案。

1.3 什么是Redis

Redis(REmote DIctionary Server,远程字典服务)是用C语言开发的一个开源的高性能键值对(key-value)数据库,官方提供测试数据,50个并发执行100000个请求,读的速度是110000次/s,写的速度是 81000次/s ,且Redis通过提供多种键值数据类型来适应不同场景下的存储需求。

Redis 是一个开源(BSD许可)的,内存中的数据结构存储系统,它可以用作数据库、缓存和消息中间件。 它支持多种类型的数据结构,如 字符串(strings), 散列(hashes), 列表(lists), 集合(sets), 有序集合(sorted sets) 与范围查询, bitmaps, hyperloglogs 和 地理空间(geospatial) 索引半径查询。 Redis 内置了 复制(replication),LUA脚本(Lua scripting), LRU驱动事件(LRU eviction),事务(transactions) 和不同级别的 磁盘持久化(persistence), 并通过 Redis哨兵(Sentinel)和自动 分区(Cluster)提供高可用性(high availability)。 -------Redis中文网

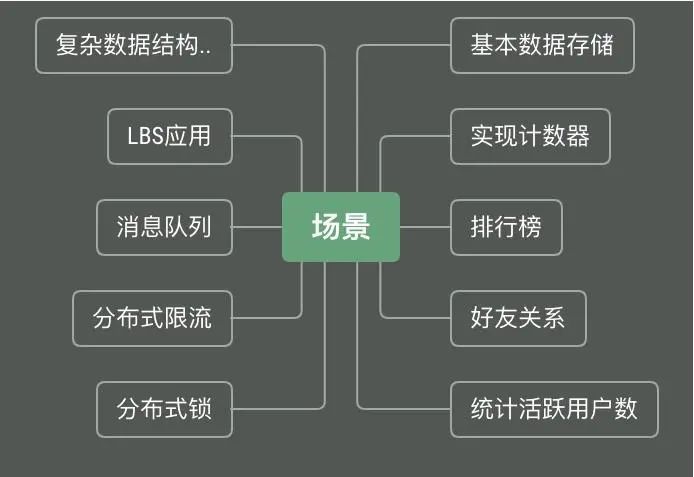

1.3.1 redis的应用场景

• 缓存(数据查询、短连接、新闻内容、商品内容等等)

• 聊天室的在线好友列表

• 任务队列。(秒杀、抢购、12306等等)

• 应用排行榜

• 网站访问统计

• 数据过期处理(可以精确到毫秒)

• 分布式集群架构中的session分离

二进制安全

在 C 语言中,字符串里面不能包含空字符,否则这个空字符会被当做是字符串结尾,换句话说,C 语言的字符串默认是以 ‘\0’ 结尾的,这不是二进制安全的,因为图片、音频等二进制数据里面会有 ‘\0’ 这一字符,C 字符串会忽略 ‘\0’ 这一字符后面的数据。在 Redis 中,有这样一个结构:

struct sdshdr {

int len;

int free;

char buf[];

};

它是用来表示字符串值的,称为 SDS(simple dynamic string), buf 是一个 char 类型的数组,用来保存二进制数据,len 记录字符串的长度(不一定是 buf 数组的长度),SDS 不使用空字符串,而是使用 len 的值来判断字符串是否结束,因此 Redis 可以保存特殊数据格式,包括二进制数据。如果要给二进制安全一个定义的话,可以这样描述:一个函数或方法能将任意输入作为原始的,无任何特殊格式意义的数据流,那么它就是二进制安全的。

发布于 2017-11-20 ----知乎

Redis 开源 遵循BSD 基于内存数据存储 被用于作为 数据库 缓存 消息中间件

BSD开源协议是一个给予使用者很大自由的协议。基本上使用者可以"为所欲为",可以自由的使用,修改源代码,也可以将修改后的代码作为开源或者专有软件再发布。但"为所欲为"的前提是当你发布使用了BSD协议的代码,或者以BSD协议代码为基础做二次开发自己的产品时,需要满足三个条件:

-

如果再发布的产品中包含源代码,则在源代码中必须带有原来代码中的BSD协议。

-

如果再发布的只是二进制类库/软件,则需要在类库/软件的文档和版权声明中包含原来代码中的BSD协议。

-

不可以用开源代码的作者/机构名字和原来产品的名字做市场推广。

1.3.2 基础知识

redis默认有16个数据库,默认用第0个

可以用命令select n 选择使用第nkeys个数据库

查看当前DB大小:DBSIZE

redis是单线程的,没有cpu上下文切换,性能瓶颈是内存和网络带宽

2 下载安装

官方没有提供windows版,因为服务器都是linux系统

微软官方曾提供补丁,但被拒绝了

现在在github上有一个windows的分支,微软官方维护到3.x版本,其他人维护到5.x

注意不要不设密码且用root用户登录6.x,存在安全漏洞!!

redis默认端口:6379

Linux下安装

将安装包放在/opt下,解压

安装gcc

使用yum更新gcc(可选)

Redis6需要c++11标准,gcc至少5.4。Centos默认的一般是4.8.5

#4.8.5版本gcc

yum install gcc-c++ -y

#更新

yum -y install centos-release-scl

yum -y install devtoolset-9-gcc devtoolset-9-gcc-c++ devtoolset-9-binutils

scl enable devtoolset-9 bash

echo "source /opt/rh/devtoolset-9/enable" >> /etc/profile

gcc -v

######################################## 6.x用这个史上最全gcc及库 ###################################################

yum -y install gcc gcc-c++ pcre pcre-devel autoconf libjpeg libjpeg-devel libpng libpng-devel freetype freetype-devel libxml2 libxml2-devel zlib zlib-devel glibc glibc-devel glib2 glib2-devel bzip2 bzip2-devel ncurses ncurses-devel curl curl-devel e2fsprogs e2fsprogs-devel krb5-devel libidn openssl openssl-devel nss_ldap openldap openldap-devel openldap-clients libxslt-devel libevent-devel libtool-ltdl bison libtool vim-enhanced

#libidn-devel openldap-servers ntp 这几个找不到,但是没关系

yum -y install centos-release-scl

yum -y install devtoolset-9-gcc devtoolset-9-gcc-c++ devtoolset-9-binutils

scl enable devtoolset-9 bash

echo "source /opt/rh/devtoolset-9/enable" >> /etc/profile

echo "gcc版本:">>/data/logs/install.log

echo gcc -v>>/data/logs/install.log

#把redis文件夹下所有能make的make一下

# 如有报错,尝试用make MALLOC=libc指定用libc作为内存分配器

make

make install

- curl默认有吗?

- vim增强默认有吗?

redis被自动安装在了/usr/local/bin文件夹下

将配置文件拷贝到当前目录下的文件夹中

cd /usr/local/bin

mkdir myconfig

cp /opt/redis-6.0.10/redis.conf myconfig

修改配置使redis后台运行

vim myconfig/redis.conf

第一个GENERAL下的daemonize no 改为yes

没用到的依赖

yum install tcl 安装tcl8.5

配置密码

redis6.x版本有漏洞!以root权限安装且不设密码的话,狗娘养的可以获取到root权限,然后安装挖矿脚本。

redis没有实现访问控制这个功能,但是它提供了一个轻量级的认证方式,可以编辑redis.conf配置来启用认证。

默认redis是没有密码的,在合适处配置

requirepass 密码

配置后启动redis,如果没有密码也可以连接到Redis服务器端口,但无法操作。

在配置文件的#SECURITY#部分的注释中,官方提醒道:由于redis的查询速度是非常快的,外部用户一秒内可以尝试多达150K个密码;所以密码要尽量长;

启动

在==/usr/local/bin==目录下

#启动服务

redis-server myconfig/redis.conf

#客户端连接,连本地只需要指定端口

redis-cli -p 6379 -a 密码

退出:exit

如果是远程服务器,别忘了更改安全组和修改配置文件!

3.1 protected-mode yes 改为 protected-mode no (即该配置项表示是否开启保护模式,默认是开启,开启后Redis只会本地进行访问,拒绝外部访问)。

3.2 注释掉 bin127.0.0.1 即 #bin 127.0.0.1 (ps: 不注释掉,表示指定 redis 只接收来自于该 IP 地址的请求,注释掉后,则表示将处理所有请求)。

配置总结

bind 127.0.0.1 #绑定ip

port 6379 #端口,集群的时候改

daemonize yes #以守护进程的方式后台运行。

protected-mode #保护模式

logfile "d:/production/server/redis/redis.log" #日志路径

3 命令操作

3.1 redis的数据结构

redis存储的是:key,value格式的数据,其中key都是字符串,value有5种不同的数据结构

- value的五种基本数据结构:

- 字符串类型 string

- 哈希类型 hash : map格式

- 列表类型 list : linkedlist格式。支持重复元素

- 集合类型 set : 不允许重复元素

- 有序集合类型 sortedset:不允许重复元素,且元素有顺序

- 三种特殊数据类型:

- geo

- hyperloglog

- bitmap

3.2 基本类型的基本操作

- 字符串类型 string

- 存储: set key value

```shell

127.0.0.1:6379> set username zhangsan

OK

```

- 获取: get keyName

```shell

127.0.0.1:6379> get username

"zhangsan"

```

- 删除: del keyName

```shell

127.0.0.1:6379> del age

(integer) 1

```

-

追加:APPEND username “append”

redis键名区分大小写,大小写不同将视为新的键

可以用追加直接增添新的键值对

-

STRLEN key 长度

-

incr keys 加一

INCRBY keys 10 加10

-

decr keys 减一

-

GETRANGE username 0 3 闭区间

-

SETRANGE username 1 xx

-

setex username 30 “tr” 30s后过期

-

getset username

-

mset k1 v1 k2 v2 同时设置多个

mget k1 k2

msetnx k1 v1 k3 v3 设置失败,都失败。这是个原子性的操作(k1已存在)

-

对象:set user:1 {name:zhangsan,age:3}

-

mset user:1:name zhangsan user:1:age:12

mget user:1:name

-

哈希类型 hash

存储: hset key field value

也可以hmset

127.0.0.1:6379> hset myhash username lisi (integer) 1 127.0.0.1:6379> hset myhash password 123 (integer) 1获取:

-

hget key field: 获取指定的field对应的值

127.0.0.1:6379> hget myhash username "lisi"- hgetall key:获取所有的field和value

127.0.0.1:6379> hgetall myhash 1) "username" 2) "lisi" 3) "password" 4) "123"127.0.0.1:6379> hlen myhash #判断字段数量 (integer) 3 127.0.0.1:6379> hexists myhash k5 #判断指定field是否存在 (integer) 0 127.0.0.1:6379> hkeys myhash #keys 1) "k1" 2) "k2" 3) "k3" 127.0.0.1:6379> hvals myhash 1) "v1" 2) "v2" 3) "v3" #自增 #如果没有这个key或field,会自己创建 #没有hincr命令 127.0.0.1:6379> hincrby myhash k4 6 (integer) 10删除: hdel key field

127.0.0.1:6379> hdel myhash username (integer) 1

-

列表类型 list:可以添加一个元素到列表的头部(左边)或者尾部(右边)

添加:

-

lpush key value: 将元素加入列表左表

-

rpush key value:将元素加入列表右边

127.0.0.1:6379> lpush myList a (integer) 1 127.0.0.1:6379> lpush myList b (integer) 2 127.0.0.1:6379> rpush myList c (integer) 3 #lset 设置指定位置,但不存在的话不会新建list 127.0.0.1:6379> lset list2 0 one (error) ERR no such key #list存在但没有这个index也不行 127.0.0.1:6379> lset list 99999 5 (error) ERR index out of range #127.0.0.1:6379> linsert key BEFORE|AFTER pivot element 127.0.0.1:6379> lrange list 0 -1 1) "ianhandsome" 2) "1" 127.0.0.1:6379> linsert list before 0 3 #不能是索引 (integer) -1 127.0.0.1:6379> lrange list 0 -1 1) "ianhandsome" 2) "1" 127.0.0.1:6379> linsert list before ianhandsome 3 (integer) 3 127.0.0.1:6379> lrange list 0 -1 1) "3" 2) "ianhandsome" 3) "1获取:

- lrange key start end :范围获取

#看来是闭区间 127.0.0.1:6379> lrange myList 0 -1 1) "b" 2) "a" 3) "c" #用index获取 127.0.0.1:6379> lrange list 0 -1 1) "1" 2) "2" 127.0.0.1:6379> lindex list 1 "2" 127.0.0.1:6379> lindex list 2 (nil) #Llen 获取长度删除:

-

lpop key: 删除列表最左边的元素,并将元素返回

-

rpop key: 删除列表最右边的元素,并将元素返回

#127.0.0.1:6379> lrem key count element 移除指定数量的指定值 #trim:裁剪list #ltrim 1 2 只保留1到2 127.0.0.1:6379> lrange list 0 -1 1) "ianhandsome" 2) "1" 3) "1" 4) "2" 5) "2" #rpoplush 移除最后一个元素并添加到新的列表头部 127.0.0.1:6379> rpoplpush list newlist "2" 127.0.0.1:6379> lrange newlist 0 -1 1) "2" #2333竟然没有其他类似的移动么 127.0.0.1:6379> lpoprpush list newlist (error) ERR unknown command `lpoprpush`, with args beginning with: `list`, `newlist`, 127.0.0.1:6379> rpoplpush list newlist "1" 127.0.0.1:6379> lrange newlist 0 -1 1) "1" 2) "2" 3) "2"应用

消息排队,消息队列

-

-

集合类型 set : 不允许重复元素

- 存储:sadd key value

127.0.0.1:6379> sadd myset a

(integer) 1

127.0.0.1:6379> sadd myset a

(integer) 0

127.0.0.1:6379> scard myset #看有几个元素

- 获取:smembers key:获取set集合中所有元素

127.0.0.1:6379> smembers myset

1) "a"

127.0.0.1:6379> sismember myset a #判断集合中是否含有a

(integer) 1

- 删除:srem key value:删除set集合中的某个元素

127.0.0.1:6379> srem myset a

(integer) 1

spop myset #随机删除

smove myset myset2 name #移动

4)数字集合类

- 差集

- 交集

- 并集

127.0.0.1:6379> sdiff myset myset2

1) "1"

2) "a"

3) "b"

127.0.0.1:6379> sinter myset myset2

1) "c"

127.0.0.1:6379> sunion myset myset2

1) "1"

2) "a"

3) "v"

4) "d"

5) "e"

7) "b"

-

**有序集合类型 sortedset:**不允许重复元素,且元素有顺序.每个元素都会关联一个double类型的分数。redis正是通过分数来为集合中的成员进行从小到大的排序。

使用跳表作为数据结构,查询时间复杂度为lg(n)

跳表

从链表改进而来,将部分链表结点提出来,再构建出一个新的链表。

先查部分链表,确定大致范围

跳表类似B+树,但没有阶数的概念,这里也不像mysql有每页16k的限制。和B+树在插入数据上有所不同

跳表新加入数据后,是否要在上层新增结点,纯靠随机函数

理论上为了达到二分的效果,每一层的结点数需要是下一层结点数的二分之一。

也就是说现在有一个新的数据插入了,它有50%的概率需要在第二层加入索引,有25%的概率需要在第三层加个索引,以此类推,直到最顶层。当数据量样本足够大的时候,数据的分布就符合我们理想中的"二分"。

B+树的层更低。三层左右就可以存储2kw左右的数据。跳表2kw大概在2的24次方左右,为了保证二分效果,大概24层。

所以mysql不用跳表,若层数高了,IO次数多,耗时;而Redis是内存数据库;

跳表的写入性能要比B+树更好,因为不用旋转和维持平衡

- 存储:zadd key score value

127.0.0.1:6379> zadd mysort 60 zhangsan

(integer) 1

127.0.0.1:6379> zadd mysort 50 lisi 80 wangwu

(integer) 1

- 获取:zrange key start end [withscores]

127.0.0.1:6379> zrange mysort 0 -1

1) "lisi"

2) "zhangsan"

3) "wangwu"

#带分数一起输出

127.0.0.1:6379> zrange mysort 0 -1 withscores

1) "zhangsan"

2) "60"

3) "wangwu"

4) "80"

5) "lisi"

6) "500"

127.0.0.1:6379> zrangebyscore mysort -inf +inf #这个的范围是分数

#总数

127.0.0.1:6379> zcard myzset

(integer) 3

#反转输出

127.0.0.1:6379> zrevrange myzset 0 -1

1) "v3"

- “v2”

3) “v1”

127.0.0.1:6379> zrevrangebyscore myzset 60 40- “v3”

- “v2”

127.0.0.1:6379> zcount key min max 统计

- 删除:zrem key value

```shell

127.0.0.1:6379> zrem mysort lisi

(integer) 1

3.3 通用命令

- keys * : 查询所有的键

- type key : 获取键对应的value的类型

- del key:删除指定的key value

- flushdb 清除当前数据库所有数据

- FLASHALL 清空所有数据库内容

- DBSIZE 当前数据库大小

- EXIETS keyname 判断某个键值对是否存在(当前数据库)

- move keyname 1 移动到另一个数据库

- EXPIRE keyname 10 让key10s后过期

- ttl keyname 看还有多长时间过期 ,负数就没了

3.4 三种特殊数据类型

geospatial 地理位置

4.持久化

redis是一个内存数据库,当redis服务器重启,或者电脑重启,数据会丢失,我们可以将redis内存中的数据持久化保存到硬盘的文件中。

Redis 提供了RDB和AOF两种持久化方式。默认是只开启RDB。当Redis重启时,它会优先使用AOF文件来还原数据集。

RDB:快照持久化

默认方式,不需要进行配置。

将某一时间点的所有数据持久化到硬盘上。

> 可以将快照复制到其它服务器从而创建具有相同数据的服务器副本。

在一定的间隔时间中,检测key的变化情况,然后持久化数据。

==rdb保存的文件是dump.rdb==

1. 编辑redis.windows.conf文件

==这里能用BGSAVE吗?==

```bash

# after 900 sec (15 min) if at least 1 key changed

save 900 1

# after 300 sec (5 min) if at least 10 keys changed

save 300 10

# after 60 sec if at least 10000 keys changed

save 60 10000

```

#保存的目录

dir ./

#文件名

dbfilename dump.rdb

-

重新启动redis服务器,并指定配置文件名称

D:\JavaWeb2018\day23_redis\资料\redis\windows-64\redis-2.8.9>redis-server.exe redis.windows.conf根据配置,快照将被写入dbfilename选项指定的文件里面,并存储在dir选项指定的路径上面。

用命令创建快照:

- flushall命令也会产生rdb文件

- BGSAVE命令 :客户端向Redis发送 BGSAVE命令 来创建一个快照。对于支持BGSAVE命令的平台来说(基本上所有平台支持,除了Windows平台),Redis会调用fork来创建一个子进程,然后子进程负责将快照写入硬盘,而父进程则继续处理命令请求。

- SAVE命令 :客户端还可以向Redis发送 SAVE命令 来创建一个快照,接到SAVE命令的Redis服务器在快照创建完毕之前不会再响应任何其他命令。SAVE命令不常用,我们通常只会在没有足够内存去执行BGSAVE命令的情况下,又或者即使等待持久化操作执行完毕也无所谓的情况下,才会使用这个命令。

- save选项 :如果用户设置了save选项(一般会默认设置),比如 save 60 10000,那么从Redis最近一次创建快照之后开始算起,当“60秒之内有10000次写入”这个条件被满足时,Redis就会自动触发BGSAVE命令。

- SHUTDOWN命令 :当Redis通过SHUTDOWN命令接收到关闭服务器的请求时,或者接收到标准TERM信号时,会执行一个SAVE命令,阻塞所有客户端,不再执行客户端发送的任何命令,并在SAVE命令执行完毕之后关闭服务器。(打烊命令)

- 一个Redis服务器连接到另一个Redis服务器:当一个Redis服务器连接到另一个Redis服务器,并向对方发送SYNC命令来开始一次复制操作的时候,如果主服务器目前没有执行BGSAVE操作,或者主服务器并非刚刚执行完BGSAVE操作,那么主服务器就会执行BGSAVE命令

如果系统真的发生崩溃,用户将丢失最近一次生成快照之后更改的所有数据。因此,快照持久化只适用于即使丢失一部分数据也不会造成一些大问题的应用程序。不能接受这个缺点的话,可以考虑AOF持久化。

恢复:只要将rdb文件放在启动目录下就可以自动恢复

redis会fork一个新的进程来进行RDB持久化工作

这个新的进程的内存空间是当时的内存?所以会保存那一时刻的数据,即使持久化全部完成前有数据被修改?

AOF:Append only file

日志记录的方式,可以记录每一条命令的操作。可以每一次命令操作后,持久化数据

使用 AOF 持久化需要设置同步选项,从而确定写命令同步到磁盘文件上的时机。这是因为对文件进行写入并不会马上将内容同步到磁盘上,而是先存储到缓冲区,然后由操作系统决定什么时候同步到磁盘。

编辑redis.windwos.conf文件

#先开启AOF模式

appendonly no(关闭aof) --> appendonly yes (开启aof)

#在Redis的配置文件中存在三种同步方式

# appendfsync always : 每一次操作都进行持久化(影响速度,影响固态盘的速度)

appendfsync everysec : 每隔一秒进行一次持久化

# appendfsync no : 不进行持久化(?由操作系统决定什么时候同步到磁盘?)

AOF文件的保存位置和RDB文件的位置相同,都是通过dir参数设置的,默认的文件名是appendonly.aof。

appendfsync always 可以实现将数据丢失减到最少,不过这种方式需要对硬盘进行大量的写入而且每次只写入一个命令,十分影响Redis的速度。另外使用固态硬盘的用户谨慎使用appendfsync always选项,因为这会明显降低固态硬盘的使用寿命。

appendfsync everysec 为了兼顾数据和写入性能,用户可以考虑 appendfsync everysec选项 ,让Redis每秒同步一次AOF文件,Redis性能几乎没受到任何影响。而且这样即使出现系统崩溃,用户最多只会丢失一秒之内产生的数据。当硬盘忙于执行写入操作的时候,Redis还会优雅的放慢自己的速度以便适应硬盘的最大写入速度。

appendfsync no 选项一般不推荐,这种方案会使Redis丢失不定量的数据而且如果用户的硬盘处理写入操作的速度不够的话,那么当缓冲区被等待写入的数据填满时,Redis的写入操作将被阻塞,这会导致Redis的请求速度变慢。

https://blog.csdn.net/ThinkWon/article/details/101522209 ------出自博客

重写/压缩AOF

AOF文件体积很大

为了解决AOF体积过大的问题,用户可以向Redis发送 BGREWRITEAOF命令 ,这个命令会通过移除AOF文件中的冗余命令来重写(rewrite)AOF文件来减小AOF文件的体积。BGREWRITEAOF命令和BGSAVE创建快照原理十分相似,所以AOF文件重写也需要用到子进程,这样会导致性能问题和内存占用问题,和快照持久化一样。更糟糕的是,如果不加以控制的话,AOF文件的体积可能会比快照文件大好几倍。

文件重写流程:

![]()

和快照持久化可以通过设置save选项来自动执行BGSAVE一样,AOF持久化设置以下参数

auto-aof-rewrite-percentage 和 auto-aof-rewrite-min-size

选项自动执行BGREWRITEAOF命令。举例:假设用户对Redis设置了如下配置选项并且启用了AOF持久化。那么当AOF文件体积大于64mb,并且AOF的体积比上一次重写之后的体积大了至少一倍(100%)的时候,Redis将执行BGREWRITEAOF命令。

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

无论是AOF持久化还是快照持久化,将数据持久化到硬盘上都是非常有必要的,但除了进行持久化外,用户还必须对持久化得到的文件进行备份(最好是备份到不同的地方),这样才能尽量避免数据丢失事故发生。如果条件允许的话,最好能将快照文件和重新重写的AOF文件备份到不同的服务器上面。

随着负载量的上升,或者数据的完整性变得越来越重要时,用户可能需要使用到复制特性。

如果aof文件有问题,无法启动redis

用redis-check-aof修复

然后重启即可恢复错误

如果aof文件大于64m,会fork一个新的文件进行重写。

会优先使用aof。rdb一般在从机上使用,save 900 1.

Redis 4.0 对持久化机制的优化

Redis 4.0 开始支持 RDB 和 AOF 的混合持久化(默认关闭,可以通过配置项 aof-use-rdb-preamble 开启)。

如果把混合持久化打开,AOF 重写的时候就直接把 RDB 的内容写到 AOF 文件开头。这样做的好处是可以结合 RDB 和 AOF 的优点, 快速加载同时避免丢失过多的数据。当然缺点也是有的, AOF 里面的 RDB 部分就是压缩格式不再是 AOF 格式,可读性较差。

这一策略由配置参数aof-use-rdb-preamble(使用RDB作为AOF文件的前半段)控制,默认关闭(no),设置为yes可开启

- no:按照AOF格式写入命令,与4.0前版本无差别;

- yes:先按照RDB格式写入数据状态,然后把重写期间AOF缓冲区的内容以AOF格式写入,文件前半部分为RDB格式,后半部分为AOF格式。

混合持久化优点如下:

- 大大减少了 aof 文件体积

- 加快了 aof 文件恢复速度,前面是 rdb ,恢复速度快

AOF 数据恢复

第一种:纯 AOF

恢复时,取出 AOF 中命令,一条条执行恢复

第二种:RDB+AOF

先执行 RDB 加载流程,执行完毕后,再取出余下命令,开始一条条执行

AOF 优缺点

优点

- AOF 实时性更好,丢失数据更少

- AOF 已经支持混合持久化,文件大小可以有效控制,并提高了数据加载时的效率

缺点

- 对于相同的数据集合,AOF 文件通常会比 RDB 文件大

- 在特定的 fsync 策略下,AOF 会比 RDB 略慢

- AOF 恢复速度比 RDB 慢

5. 事务

redis事物本质:一组命令的集合

一个事务中的所有命令都会序列化,会按顺序执行

一次性、顺序性、排他性

redis单条命令具有原子性,事务不保证!

没有隔离级别的概念

redis的事务:

- 开启事务 multi

- 命令入队

- 执行事务 exec

正常执行事务

127.0.0.1:6379> multi

OK

127.0.0.1:6379> set k1 v1

QUEUED

127.0.0.1:6379> set k2 v2

QUEUED

127.0.0.1:6379> get k2

QUEUED

127.0.0.1:6379> exec

1) OK

2) OK

3) "v2"

#discard 取消,前面的也不执行

编译时异常(命令有错) 所有命令都不执行

运行时异常 其他命令可以正常执行

所以说没有原子性

监控

悲观锁

很悲观,认为什么时候都会出问题,无论做什么都加锁

影响效率

乐观锁

认为什么时候都不会出问题,不一定会加锁

更新数据的时候判断一下,在此期间是否有人修改过这个数据

- 获取version

- 更新的时候比较version

使用watch

如果事务失败,先unwatch,再重新watch

使用案例:

案例需求:

1. 提供index.html页面,页面中有一个省份 下拉列表

2. 当 页面加载完成后 发送ajax请求,加载所有省份

- 注意:使用redis缓存一些不经常发生变化的数据。

- 数据库的数据一旦发生改变,则需要更新缓存。

- 数据库的表执行 增删改的相关操作,需要将redis缓存数据情况,再次存入

- 在service对应的增删改方法中,将redis数据删除。

- 数据库的数据一旦发生改变,则需要更新缓存。

附录

配置linux下Redis开机启动脚本

修改Redis配置文件

cd /cloudkd/redis vim redis.conf daemonize=yes bind=0.0.0.0

配置Redis启动脚本

vim /etc/init.d/redis

#!/bin/sh

#

# Simple Redis init.d script conceived to work on Linux systems

# as it does use of the /proc filesystem.

### BEGIN INIT INFO

# Provides: redis6379

# Required-Start: $local_fs $network

# Required-Stop: $local_fs

# Default-Start: 2 3 4 5

# Default-Stop: 0 1 6

# Short-Description: redis6379

# Description: penavico redis 6379

### END INIT INFO

REDISPORT=6379

EXEC=/cloudkd/redis/src/redis-server

CLIEXEC=/cloudkd/redis/src/redis-cli

PIDFILE=/opt/redis.pid

CONF="/cloudkd/redis/redis.conf"

#PASSWORD="cloudkd"

case "$1" in

start)

if [ -f $PIDFILE ]

then

echo "$PIDFILE exists, process is already running or crashed"

else

echo "Starting Redis server..."

$EXEC $CONF

fi

;;

stop)

if [ ! -f $PIDFILE ]

then

echo "$PIDFILE does not exist, process is not running"

else

PID=$(cat $PIDFILE)

echo "Stopping ..."

# $CLIEXEC -p $REDISPORT -a $PASSWORD shutdown

$CLIEXEC -p $REDISPORT shutdown

while [ -x /proc/${PID} ]

do

echo "Waiting for Redis to shutdown ..."

sleep 1

done

echo "Redis stopped"

fi

;;

*)

echo "Please use start or stop as first argument"

;;

esac

python脚本

vim hostname.py

#!/usr/bin/env python

# encoding:utf-8

import os

hosts = r"/etc/hosts"

if __name__ == '__main__':

name = os.popen("hostname")

hostname = name.read().split()[0]

copyfile = os.system('cp /etc/hosts /opt/hosts.back')

with open(hosts, 'a') as f:

f.write("127.0.0.1 " + hostname)

f.close()

启动服务

service redis start&& chkconfig redis on

配置文件中其他配置研究

pidfile

# If a pid file is specified, Redis writes it where specified at startup

# and removes it at exit.

#

# When the server runs non daemonized, no pid file is created if none is

# specified in the configuration. When the server is daemonized, the pid file

# is used even if not specified, defaulting to "/var/run/redis.pid".

#

# Creating a pid file is best effort: if Redis is not able to create it

# nothing bad happens, the server will start and run normally.

pidfile /var/run/redis_6379.pid

log

# Specify the server verbosity level.

# This can be one of:

# debug (a lot of information, useful for development/testing)

# verbose (many rarely useful info, but not a mess like the debug level)

# notice (moderately verbose, what you want in production probably)

# warning (only very important / critical messages are logged)

loglevel notice

# Specify the log file name. Also the empty string can be used to force

# Redis to log on the standard output. Note that if you use standard

# output for logging but daemonize, logs will be sent to /dev/null

logfile /var/log/redis/redis.log