nginx 实现负载均衡

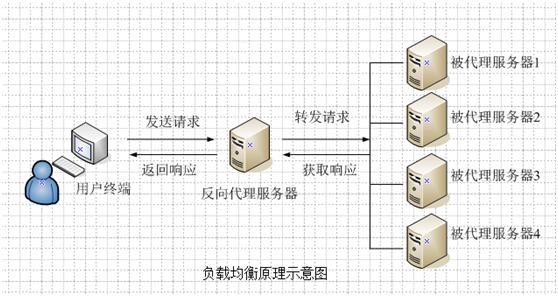

负载均衡简介:

负载均衡是由多台服务器以对称的方式组成一个服务器集合,每台服务器都具有等价的地位,都可以单独对外提供服务而无须其他服务器的辅助。其工作模式为将外部发送来的请求均匀分配到对称结构中的某一台服务器上,而接收到请求的服务器独立地回应客户的请求。均衡负载能够平均分配客户请求到服务器列阵,基于此提供快速获取重要数据,解决大量并发访问服务问题。

负载均衡作用:

1、转发功能

按照一定的算法【权重、轮询】,将客户端请求转发到不同应用服务器上,减轻单个服务器压力,提高系统并发量。

2、故障移除

通过心跳检测的方式,判断应用服务器当前是否可以正常工作,如果服务器期宕掉,自动将请求发送到其他应用服务器。

3、恢复添加

如检测到发生故障的应用服务器恢复工作,自动将其添加到处理用户请求队伍中。

一、环境

server1,安装nginx、tomcat

server2,安装tomcat

二、nginx配置

upstream backend {

server 192.168.60.233 weight=1;

server 192.168.40.215 weight=2;

}

server {

listen 80;

listen [::]:80;

server_name 127.0.0.1;

root /usr/share/nginx/html;

location / {

proxy_pass http://backend;

proxy_redirect default;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

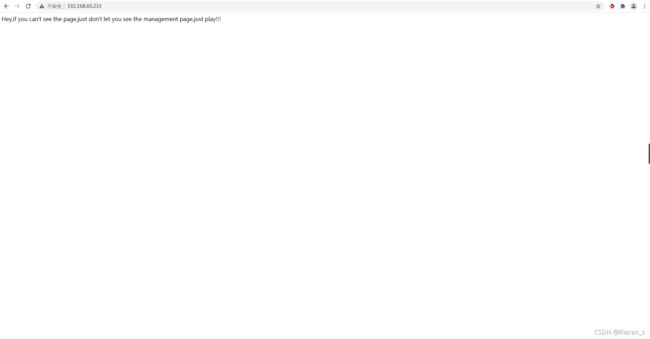

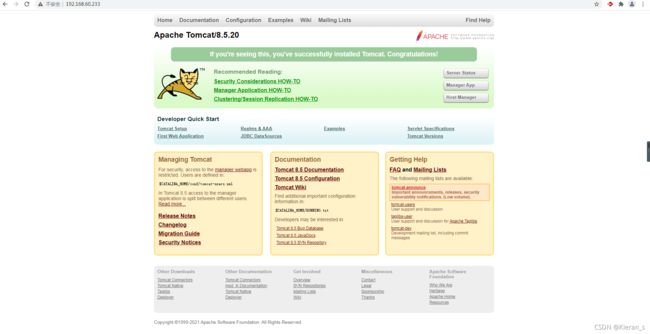

}三、测试

刷新页面发现页面会发生变化,证明负载配置成功。因为我配的权重第二个是第一个的两倍,所以第二个出现的概率会是第一个的两倍。

四、后续问题

如果关了60.233的tomcat,再多次刷新页面,接下来出现的就会都是40.215tomcat的页面,但是时而快时而慢。这其中原因是当如果nginx将请求转发到40.215时,服务器会马上跳转成功,但是如果是转到60.233,因为60.233的tomcat已经关闭了,所以会出现一段等待响应过程的过程,要等它失败后才会转到40.215的tomcat。

而这个等待响应的时间我们是可以配置的。

这个时间由以下3个参数控制:

proxy_connect_timeout:与服务器连接的超时时间,默认60s

fail_timeout:当该时间内服务器没响应,则认为服务器失效,默认10s

max_fails:允许连接失败次数,默认为1

等待时间 = proxy_connect_timeout + fail_timeout * max_fails

upstream backend {

server 192.168.60.233 weight=1 fail_timeout=2s max_fails=2;

server 192.168.40.215 weight=2 fail_timeout=2s max_fails=2;

}

server {

listen 80;

listen [::]:80;

server_name 127.0.0.1;

root /usr/share/nginx/html;

location / {

proxy_pass http://backend;

proxy_redirect default;

proxy_connect_timeout 2s;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}如图,proxy_connect_timeout + fail_timeout * max_fails只需要等待6s。

五、负载均衡策略

1、轮询

这种是默认的策略,把每个请求按顺序逐一分配到不同的server,如果server挂掉,能自动剔除。

upstream backend {

server 192.168.60.233;

server 192.168.40.215;

} 2、最少连接

把请求分配到连接数最少的server

upstream fengzp.com {

least_conn;

server 192.168.60.233;

server 192.168.40.215;

}3、权重

weight指定server访问比率,weight默认是1。以下配置会是server2访问的比例是server1的两倍。

upstream backend {

server 192.168.60.233 weight=1;

server 192.168.40.215 weight=2;

} 4、ip_hash

每个请求会按照访问ip的hash值分配,这样同一客户端连续的Web请求都会被分发到同一server进行处理,可以解决session的问题。如果server挂掉,能自动剔除。

upstream fengzp.com {

ip_hash;

server 192.168.60.233;

server 192.168.40.215;

}ip_hash可以和weight结合使用

端口号我隐藏掉了,打架测试的时候可以加上!