【动手学深度学习】--04.模型选择、过拟合和欠拟合

文章目录

- 模型选择、过拟合和欠拟合

-

- 1.模型选择

-

- 1.1训练误差和泛化误差

- 1.2验证数据集和测试数据集

- 1.3K-则交叉验证

- 2.过拟合和欠拟合

-

- 2.1模型容量

- 2.2VC维

- 2.3数据复杂度

- 3.代码实现

-

- 3.1生成数据集

- 3.2对模型进行训练和测试

- 3.3三阶多项式拟合(正常)

- 3.4线性函数拟合(欠拟合)

- 3.5高阶多项式函数拟合(过拟合)

模型选择、过拟合和欠拟合

学习视频:模型选择 + 过拟合和欠拟合【动手学深度学习v2】

官方笔记:模型选择、欠拟合和过拟合

1.模型选择

1.1训练误差和泛化误差

- 训练误差:模型在训练数据上的误差

- 泛化误差:模型在新数据上的误差(主要看的是泛化误差)

模型选择:通常在评估几个候选模型后选择最终的模型

1.2验证数据集和测试数据集

1.3K-则交叉验证

总结:

- 训练数据集:训练模型参数

- 验证数据集:选择模型超参数

- 非大数据集上通常使用k-折交叉验证

2.过拟合和欠拟合

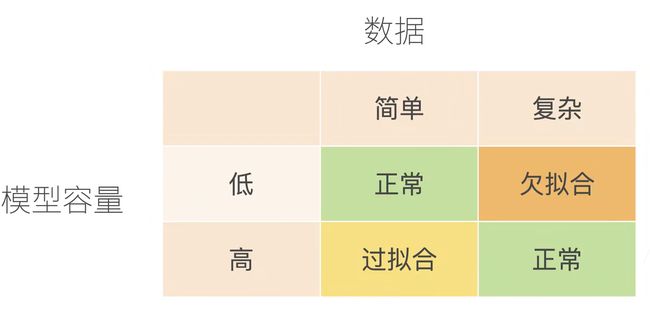

当我们比较训练和验证误差时,我们要注意两种常见的情况。 首先,我们要注意这样的情况:训练误差和验证误差都很严重, 但它们之间仅有一点差距。 如果模型不能降低训练误差,这可能意味着模型过于简单(即表达能力不足), 无法捕获试图学习的模式。 此外,由于我们的训练和验证误差之间的泛化误差很小, 我们有理由相信可以用一个更复杂的模型降低训练误差。 这种现象被称为欠拟合(underfitting)。

另一方面,当我们的训练误差明显低于验证误差时要小心, 这表明严重的过拟合(overfitting)。 注意,过拟合并不总是一件坏事。 特别是在深度学习领域,众所周知, 最好的预测模型在训练数据上的表现往往比在保留(验证)数据上好得多。 最终,我们通常更关心验证误差,而不是训练误差和验证误差之间的差距。

2.1模型容量

模型容量的影响

估计模型容量

2.2VC维

- 统计学习理论的一个核心思想

- 对于一个分类模型,VC等于一个最大的数据集的大小,不管如何标号,都存在一个模型来对它进行完美分类

线性分类器的VC

VC维的用处

-

提供为什么一个模型好的理论依据

- 它可以衡量训练误差和泛化误差之间的间隔

-

但在深度学习中很少使用

- 衡量不是很准确

- 计算深度学习模型的VC维很困难

2.3数据复杂度

多个重要因素

- 样本个数

- 每个样本的元素个数

- 时间、空间结构

- 多样性

总结:

- 模型容量需要匹配数据复杂度,否则可能导致欠拟合和过拟合

- 统计机器学习提供数学工具来衡量模型复杂度

- 实际中一般靠观察训练误差和验证误差

3.代码实现

利用多项式回归来探索这些概念

import math

import numpy as np

import torch

from torch import nn

from d2l import torch as d2l

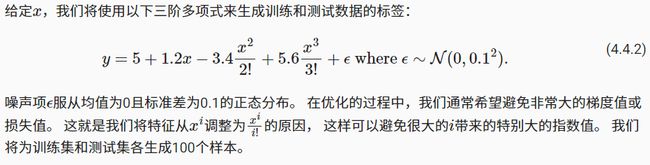

3.1生成数据集

max_degree = 20 #多项式的最大阶数

n_train,n_test = 100,100 #训练和测试数据集的大小

true_w = np.zeros(max_degree) #分配大量空间

true_w[0:4] = np.array([5,1.2,-3.4,5.6])

features = np.random.normal(size=(n_train + n_test,1))

np.random.shuffle(features)

poly_features = np.power(features,np.arange(max_degree).reshape(1,-1))

for i in range(max_degree):

poly_features[:, i] /= math.gamma(i + 1) # gamma(n)=(n-1)!

# labels的维度:(n_train+n_test,)

labels = np.dot(poly_features, true_w)

labels += np.random.normal(scale=0.1, size=labels.shape)

这里使用np.power生成带有阶数的数据,本来features是一个size * 1的张量,借助power函数和np.arrange(max_degree).reshape(1,-1),使其变成一个size * 20的向量,每个向量对相应位置的索引取得阶乘。从而实现X @ W = Y ,即size * 1的向量。

# NumPy ndarray转换为tensor张量

true_w, features, poly_features, labels = [torch.tensor(x, dtype=

torch.float32) for x in [true_w, features, poly_features, labels]]

features[:2], poly_features[:2, :], labels[:2]

3.2对模型进行训练和测试

实现一个函数来评估模型在给定数据集上的损失

def evaluate_loss(net, data_iter, loss):

"""评估给定数据集上模型的损失"""

metric = d2l.Accumulator(2) # 损失的总和,样本数量

for X, y in data_iter:

out = net(X)

y = y.reshape(out.shape)

l = loss(out, y)

metric.add(l.sum(), l.numel())

return metric[0] / metric[1]

训练函数

def train(train_features, test_features, train_labels, test_labels,

num_epochs=400):

loss = nn.MSELoss(reduction='none')

input_shape = train_features.shape[-1]

# 不设置偏置,因为我们已经在多项式中实现了它

net = nn.Sequential(nn.Linear(input_shape, 1, bias=False))

batch_size = min(10, train_labels.shape[0])

train_iter = d2l.load_array((train_features, train_labels.reshape(-1,1)),

batch_size)

test_iter = d2l.load_array((test_features, test_labels.reshape(-1,1)),

batch_size, is_train=False)

trainer = torch.optim.SGD(net.parameters(), lr=0.01)

#画图显示

animator = d2l.Animator(xlabel='epoch', ylabel='loss', yscale='log',

xlim=[1, num_epochs], ylim=[1e-3, 1e2],

legend=['train', 'test'])

for epoch in range(num_epochs):

d2l.train_epoch_ch3(net, train_iter, loss, trainer)

if epoch == 0 or (epoch + 1) % 20 == 0:

animator.add(epoch + 1, (evaluate_loss(net, train_iter, loss),

evaluate_loss(net, test_iter, loss)))

print('weight:', net[0].weight.data.numpy())

3.3三阶多项式拟合(正常)

首先使用三阶多项式函数,它与数据生成函数的阶数相同。 结果表明,该模型能有效降低训练损失和测试损失。 学习到的模型参数也接近真实值w=[5,1.2,-3.4,5.6]

# 从多项式特征中选择前4个维度,即1,x,x^2/2!,x^3/3!

train(poly_features[:n_train, :4], poly_features[n_train:, :4],

labels[:n_train], labels[n_train:])

3.4线性函数拟合(欠拟合)

让我们再看看线性函数拟合,减少该模型的训练损失相对困难。 在最后一个迭代周期完成后,训练损失仍然很高。 当用来拟合非线性模式(如这里的三阶多项式函数)时,线性模型容易欠拟合

# 从多项式特征中选择前2个维度,即1和x

train(poly_features[:n_train, :2], poly_features[n_train:, :2],

labels[:n_train], labels[n_train:])

3.5高阶多项式函数拟合(过拟合)

现在,让我们尝试使用一个阶数过高的多项式来训练模型。 在这种情况下,没有足够的数据用于学到高阶系数应该具有接近于零的值。 因此,这个过于复杂的模型会轻易受到训练数据中噪声的影响。 虽然训练损失可以有效地降低,但测试损失仍然很高。 结果表明,复杂模型对数据造成了过拟合。

# 从多项式特征中选取所有维度

train(poly_features[:n_train, :], poly_features[n_train:, :],

labels[:n_train], labels[n_train:], num_epochs=1500)