一、前言

- Ceph 在 k8s 中用做共享存储还是非常方便的,Ceph 是比较老牌的分布式存储系统,非常成熟并且功能也强大,支持三种模式(快存储、文件系统存储、对象存储),那么如何在 k8s 使用 ceph 呢?

- k8s 环境的部署,请参考:云原生之深入解析K8S 1.24的高可用环境部署。

- 关于 Ceph 的环境部署和实战操作,请参考:云原生之深入解析分布式存储系统Ceph的环境部署和实战操作。

二、Ceph Rook 简介

- Rook 是一个开源的云原生存储编排工具,提供平台、框架和对各种存储解决方案的支持,以和云原生环境进行本地集成。Rook 将存储软件转变成自我管理、自我扩展和自我修复的存储服务,通过自动化部署、启动、配置、供应、扩展、升级、迁移、灾难恢复、监控和资源管理来实现。Rook 底层使用云原生容器管理、调度和编排平台提供的能力来提供这些功能。

- Rook 利用扩展功能将其深度地集成到云原生环境中,并为调度、生命周期管理、资源管理、安全性、监控等提供了无缝的体验,Rook 目前支持 Ceph、NFS、Minio Object Store 和 CockroachDB。

三、通过 Rook 在 k8s 中部署 Ceph

① 下载部署包

git clone --single-branch --branch v1.10.8 https://github.com/rook/rook.git

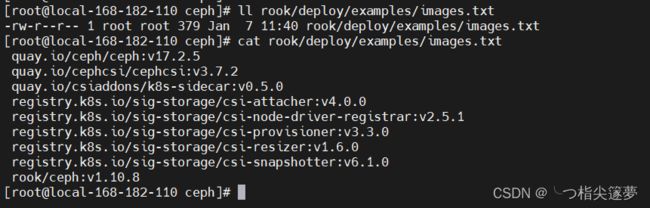

- 由于镜像源在国外,国内无法下载,这里需要修改一些镜像或者提前下载 tag,操作如下:

cd rook/deploy/examples/

#(registry.aliyuncs.com/google_containers/<image>:<tag>),后四个镜像我FQ下

docker pull registry.aliyuncs.com/google_containers/csi-node-driver-registrar:v2.5.1

docker tag registry.aliyuncs.com/google_containers/csi-node-driver-registrar:v2.5.1 registry.k8s.io/sig-storage/csi-node-driver-registrar:v2.5.1

docker pull registry.aliyuncs.com/google_containers/csi-snapshotter:v6.1.0

docker tag registry.aliyuncs.com/google_containers/csi-snapshotter:v6.1.0 registry.k8s.io/sig-storage/csi-snapshotter:v6.1.0

docker pull registry.aliyuncs.com/google_containers/csi-attacher:v4.0.0

docker tag registry.aliyuncs.com/google_containers/csi-attacher:v4.0.0 registry.k8s.io/sig-storage/csi-attacher:v4.0.0

docker pull registry.aliyuncs.com/google_containers/csi-resizer:v1.6.0

docker tag registry.aliyuncs.com/google_containers/csi-resizer:v1.6.0 registry.k8s.io/sig-storage/csi-resizer:v1.6.0

docker pull registry.aliyuncs.com/google_containers/csi-resizer:v1.6.0

docker tag registry.aliyuncs.com/google_containers/csi-resizer:v1.6.0 registry.k8s.io/sig-storage/csi-resizer:v1.6.0

docker pull registry.aliyuncs.com/google_containers/csi-provisioner:v3.3.0

docker tag registry.aliyuncs.com/google_containers/csi-provisioner:v3.3.0 registry.k8s.io/sig-storage/csi-provisioner:v3.3.0

② 部署 Rook Operator

cd rook/deploy/examples

kubectl create -f crds.yaml -f common.yaml -f operator.yaml

# 检查

kubectl -n rook-ceph get pod

helm repo add rook-release https://charts.rook.io/release

helm install --create-namespace --namespace rook-ceph rook-ceph rook-release/rook-ceph -f values.yaml

③ 创建 Rook Ceph 集群

- 现在 Rook Operator 处于 Running 状态,接下来就可以创建 Ceph 集群,为了使集群在重启后不受影响,请确保设置的 dataDirHostPath 属性值为有效得主机路径:

cd rook/deploy/examples

kubectl apply -f cluster.yaml

④ 部署 Rook Ceph 工具

cd rook/deploy/examples

kubectl create -f toolbox.yaml

⑤ 部署 Ceph Dashboard

cd rook/deploy/examples

kubectl apply -f dashboard-external-https.yaml

# 获取 dashboard admin密码

kubectl -n rook-ceph get secret rook-ceph-dashboard-password -o jsonpath="{['data']['password']}" | base64 -d

- 通过 Ceph Dashboard 查看 Ceph 集群状态:

# 查看对外端口

kubectl get svc -n rook-ceph

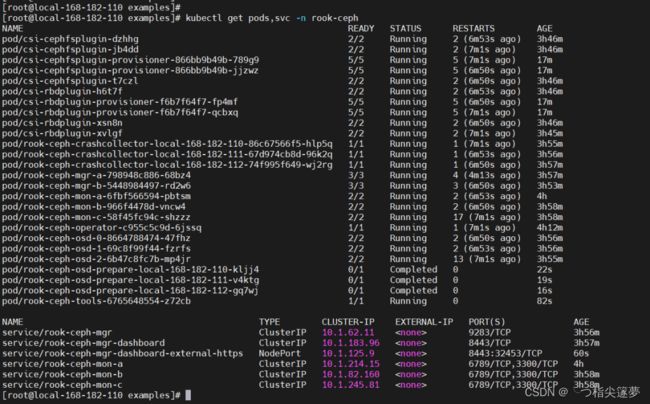

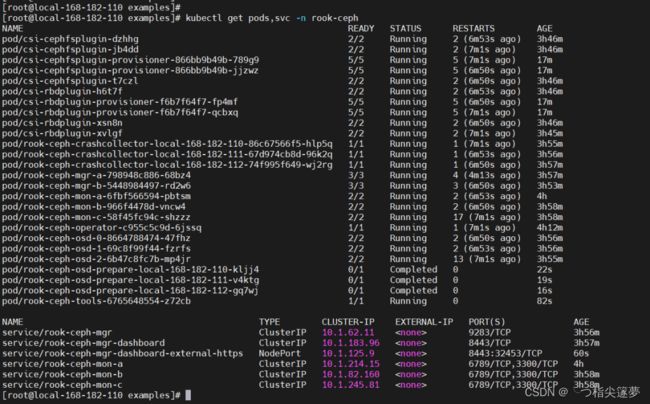

⑥ 检查

kubectl get pods,svc -n rook-ceph

⑦ 通过 ceph-tool 工具 pod 查看 ceph 集群状态

kubectl exec -it `kubectl get pods -n rook-ceph|grep rook-ceph-tools|awk '{print $1}'` -n rook-ceph -- bash

ceph -s

四、测试验证

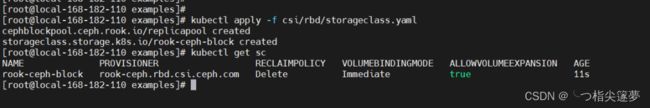

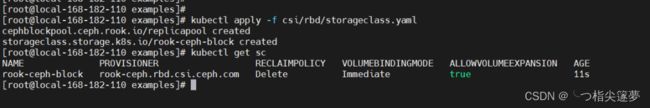

① 块存储(RBD)测试

cd rook/deploy/examples

# 创建一个名为replicapool的rbd pool

kubectl apply -f csi/rbd/storageclass.yaml

kubectl apply -f mysql.yaml

kubectl apply -f wordpress.yaml

② 文件系统 (CephFS) 测试

kubectl apply -f csi/cephfs/storageclass.yaml

kubectl apply -f filesystem.yaml

③ 对象存储 (RGW) 测试

kubectl create -f object.yaml

# 验证rgw pod正常运行

kubectl -n rook-ceph get pod -l app=rook-ceph-rgw

kubectl create -f object-user.yaml

# 获取AccessKey

kubectl -n rook-ceph get secret rook-ceph-object-user-my-store-my-user -o yaml | grep AccessKey | awk '{print $2}' | base64 --decode

# 获取 SecretKey

kubectl -n rook-ceph get secret rook-ceph-object-user-my-store-my-user -o yaml | grep SecretKey | awk '{print $2}' | base64 --decode

kubectl apply -f rgw-external.yaml

kubectl -n rook-ceph get service rook-ceph-rgw-my-store rook-ceph-rgw-my-store-external

#首先,需要安装 python-boto 包,用于测试连接 S3

yum install python-boto -y

# 然后,编写 python 测试脚本

# cat s3.py

#!/usr/bin/python

import boto

import boto.s3.connection

access_key = 'C7492VVSL8O11NZBK3GT'

secret_key = 'lo8IIwMfmow4fjkSOMbjebmgjzTRBQSO7w83SvBd'

conn = boto.connect_s3(

aws_access_key_id = access_key,

aws_secret_access_key = secret_key,

host = '192.168.182.110', port=30369,

is_secure=False,

calling_format = boto.s3.connection.OrdinaryCallingFormat(),

)

bucket = conn.create_bucket('my-first-s3-bucket')

for bucket in conn.get_all_buckets():

print "{name}\t{created}".format(

name = bucket.name,

created = bucket.creation_date,

)