离线数仓16—— DolphinSchedule工作流调度

文章目录

- 第13章 数据仓库工作流调度

-

- 13.1 调度工具部署

- 13.2 新数据生成

-

- 13.2.1 用户行为日志

- 13.2.2 业务数据

- 13.3 工作流调度实操

-

- 13.3.1 DolphinScheduler集群模式

- 13.3.2 DolphinScheduler单机模式

第13章 数据仓库工作流调度

13.1 调度工具部署

13.2 新数据生成

13.2.1 用户行为日志

1)启动日志采集通道,包括Kafka、Flume等

(1)启动Zookeeper

[atguigu@hadoop102 ~]$ zk.sh start

(2)启动Kafka

[atguigu@hadoop102 ~]$ kf.sh start

(3)启动Flume

[atguigu@hadoop102 ~]$ f1.sh start

[atguigu@hadoop102 ~]$ f2.sh start

2)修改日志模拟器配置文件

修改hadoop102和hadoop103两台节点中的/opt/module/applog/application.yml文件,修改mock.date参数如下。

mock.date: "2020-06-15"

3)执行日志生成脚本

[atguigu@hadoop102 ~]$ lg.sh

4)观察HDFS上是否有2020-06-15的日志数据生成

13.2.2 业务数据

1)修改Maxwell配置文件

(1)修改/opt/module/maxwell/config.properties文件

[atguigu@hadoop102 maxwell]$ vim /opt/module/maxwell/config.properties

(2)修改mock_date参数设置如下

mock_date=2020-06-15

2)启动增量表采集通道,包括Maxwel、Kafka、Flume等

(1)启动Maxwell

[atguigu@hadoop102 ~]$ mxw.sh start

注:若Maxwell当前正在运行,为确保上述mock参数生效,需重启Maxwell。

(2)启动Flume

[atguigu@hadoop102 ~]$ f3.sh start

3)修改业务数据模拟器配置文件中的mock_date参数

mock.date=2020-06-15

4)执行业务数据生成命令

[atguigu@hadoop102 db_log]$ java -jar gmall2020-mock-db-2021-10-10.jar

5)观察HDFS上增量表是否有2020-06-15的数据生成

13.3 工作流调度实操

由于DolphinScheduler集群模式启动进程较多,对虚拟机内存要求较高。故下面提供两种方式,可根据虚拟机内存情况进行选择。

13.3.1 DolphinScheduler集群模式

1)启动DolphinScheduler

[atguigu@hadoop102 dolphinscheduler]$ bin/start-all.sh

2)使用普通用户登录

3)向DolphinScheduler资源中心上传工作流所需脚本

(1)创建文件夹

(2)上传工作流所需脚本

将工作流所需的所有脚本上传到资源中心scripts路径下,结果如下

4)向DolphinScheduler的WorkerServer节点分发脚本依赖的组件

由于工作流要执行的脚本需要调用Hive、DataX等组件,故在DolphinScheduler的集群模式下,需要确保每个WorkerServer节点都有脚本所依赖的组件。

[atguigu@hadoop102 ~]$ xsync /opt/module/hive/

[atguigu@hadoop102 ~]$ xsync /opt/module/spark/

[atguigu@hadoop102 ~]$ xsync /opt/module/datax/

5)配置运行环境

(1)切换到 admin 用户,在环境管理下创建环境

(2)在环境配置中添加如下内容

标红部分根据集群情况修改。

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export HADOOP_CONF_DIR=/opt/module/hadoop-3.1.3/etc/hadoop

export SPARK_HOME=/opt/module/spark

export SPARK_HOME2=/opt/soft/spark2

export PYTHON_HOME=/opt/soft/python

export JAVA_HOME=/opt/module/jdk1.8.0_212

export HIVE_HOME=/opt/module/hive

export FLINK_HOME=/opt/soft/flink

export DATAX_HOME=/opt/module/datax

export PATH=$HADOOP_HOME/bin:$SPARK_HOME1/bin:$SPARK_HOME2/bin:$PYTHON_HOME:$JAVA_HOME/bin:$HIVE_HOME/bin:$FLINK_HOME/bin:$DATAX_HOME/bin:$PATH

6)创建工作流

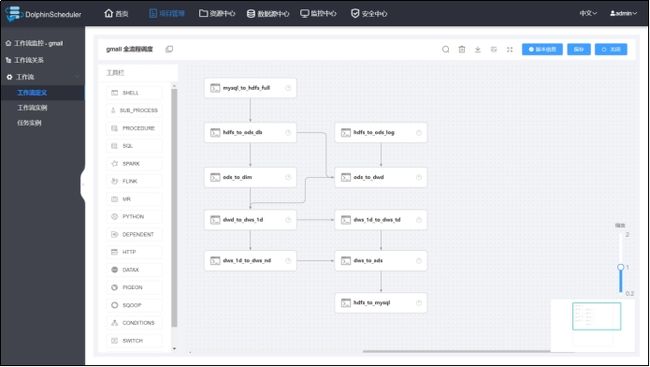

(1)在gmall项目下创建工作流

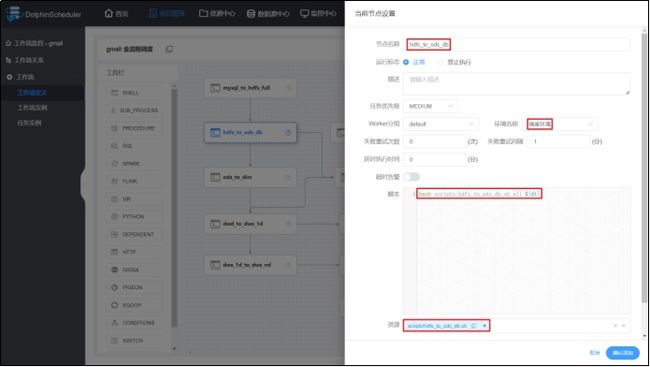

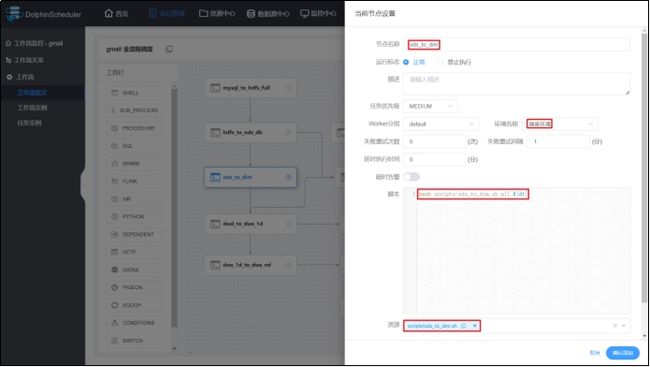

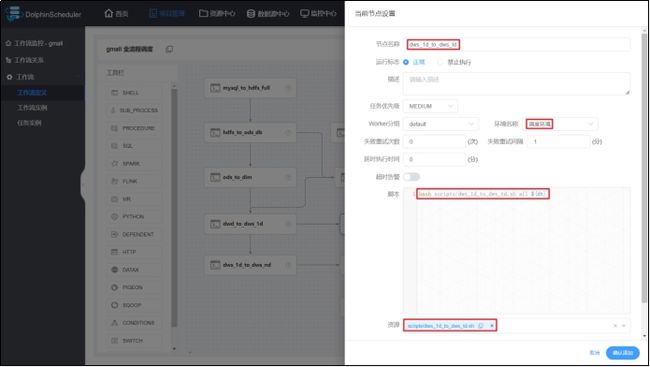

(2)各任务节点配置如下

1mysql_to_hdfs_full

2hdfs_to_ods_db

3hdfs_to_ods_log

4ods_to_dwd

5ods_to_dim

6dwd_to_dws_1d

7dws_1d_to_dws_nd

8dws_1d_to_dws_td

9dws_to_ads

10hdfs_to_mysql

(3)各节点依赖关系如下

(4)保存工作流

注:定时调度时,全局参数值应设置为$[yyyy-MM-dd-1]或者空值。

7)上线工作流

8)执行工作流

注:工作流启动前选择的环境无效,必须在创建任务节点时选择对应环境。此处的“环境名称”可以置空。

13.3.2 DolphinScheduler单机模式

1)启动DolphinScheduler

[atguigu@hadoop102 dolphinscheduler]$ bin/dolphinscheduler-daemon.sh start standalone-server

2)安全中心配置

由于DolphinScheduler的单机模式使用的是内置的ZK和数据库,故在集群模式下所做的相关配置在单机模式下并不可见,所以需要重新配置,必要的配置为创建租户和创建用户。

(1)使用管理员用户登录

(2)创建租户

(3)创建用户

3)切换普通用户登录

4)创建项目

5)其余操作

.(img-IhT6HnGj-1672365135778)]

(2)创建租户

[外链图片转存中…(img-YvTWblBf-1672365135779)]

(3)创建用户

[外链图片转存中…(img-qEgVUUYm-1672365135780)]

3)切换普通用户登录

[外链图片转存中…(img-NWG3mLLZ-1672365135780)]

4)创建项目

[外链图片转存中…(img-KLZSQXPh-1672365135781)]

5)其余操作

其余操作与集群模式基本一致,其中分发Hive、Spark、DataX这一步可以省略。