Docker高级——网络配置

Docker网络

默认网络

安装 Docker 以后,会默认创建三种网络,可以通过 docker network ls 查看

[root@test ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

6f24f7cbfa10 bridge bridge local

2dc34a1c0f04 host host local

80147a6b6933 none null local

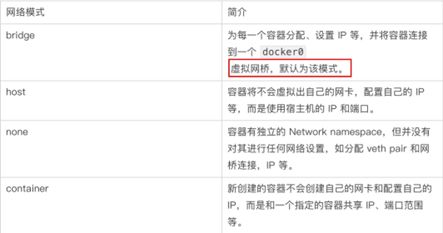

Docker提供了几种网络模式,用于管理容器之间的通信和与外部网络的连接。下面是几种常见的网络模式及其原理:

- 桥接模式(Bridge):桥接模式是Docker默认的网络模式。在桥接模式下,Docker会为每个容器创建一个虚拟网络接口,并通过一个虚拟交换机连接这些接口。容器可以相互通信,也可以通过主机的网络接口连接到外部网络。

- 主机模式(Host):主机模式下,容器与主机共享网络栈,即容器使用主机的网络接口和IP地址。这意味着容器可以直接使用主机的网络功能,但也可能导致端口冲突和安全风险。

- 无网络模式(None):无网络模式下,容器没有网络接口和连接,只能与其他容器进行通信。这种模式适用于一些特殊需求,如只需要容器之间的通信,而不需要与外部网络连接的情况。

- 覆盖网络模式(Overlay):覆盖网络模式用于在多个Docker主机之间创建一个虚拟网络,容器可以跨主机进行通信。这种模式通常用于构建分布式应用程序或容器集群。

这些网络模式可以根据实际需求进行选择和配置,以满足容器之间和容器与外部网络的通信需求。

- bridge模式:使用--network bridge指定,默认使用docker0

- host模式:使用--network host指定

- none模式:使用--network none指定

- container模式:使用--network container:NAME或者容器ID指定

容器实例内默认网络IP生产规则

先启动两个ubuntu容器实例

[root@test ~]# docker run -it --name u1 ubuntu bash

Unable to find image 'ubuntu:latest' locally

latest: Pulling from library/ubuntu

3153aa388d02: Pull complete

Digest: sha256:0bced47fffa3361afa981854fcabcd4577cd43cebbb808cea2b1f33a3dd7f508

Status: Downloaded newer image for ubuntu:latest

root@ab3aff38e17c:/# ^C

root@ab3aff38e17c:/# exit

exit

[root@test ~]# docker run -it --name u2 ubuntu bash

root@53685573c8cd:/# exit

exit

$ docker inspect 容器ID or 容器名字

[root@test ~]# docker start u1

u1

[root@test ~]# docker inspect u1| tail -n 20

"Networks": {

"bridge": {

"IPAMConfig": null,

"Links": null,

"Aliases": null,

"NetworkID": "6f24f7cbfa10048e76b574ec90900abadf9fefbe49a2df57f356d43cecdaf33a",

"EndpointID": "60b9e3c0386bdbc7779b66a27b3d2f0e06136081cb9eae7a99801ae9d0a8707b",

"Gateway": "172.17.0.1",

"IPAddress": "172.17.0.2",

"IPPrefixLen": 16,

"IPv6Gateway": "",

"GlobalIPv6Address": "",

"GlobalIPv6PrefixLen": 0,

"MacAddress": "02:42:ac:11:00:02",

"DriverOpts": null

}

}

}

}

]

[root@test ~]# docker start u2

u2

[root@test ~]# docker inspect u2| tail -n 20

"Networks": {

"bridge": {

"IPAMConfig": null,

"Links": null,

"Aliases": null,

"NetworkID": "6f24f7cbfa10048e76b574ec90900abadf9fefbe49a2df57f356d43cecdaf33a",

"EndpointID": "4ac287832bd590e3758c60f5beef97e294d16fcc6cded9b2c3ffbc30a0a02429",

"Gateway": "172.17.0.1",

"IPAddress": "172.17.0.3",

"IPPrefixLen": 16,

"IPv6Gateway": "",

"GlobalIPv6Address": "",

"GlobalIPv6PrefixLen": 0,

"MacAddress": "02:42:ac:11:00:03",

"DriverOpts": null

}

}

}

}

]

关闭u2实例,新建u3,查看ip变化

[root@test ~]# docker run -it --name u3 ubuntu bash

root@db76ae3a6f5d:/# exit

exit

[root@test ~]# docker start u3

u3

[root@test ~]# docker inspect u3| tail -n 20

"Networks": {

"bridge": {

"IPAMConfig": null,

"Links": null,

"Aliases": null,

"NetworkID": "6f24f7cbfa10048e76b574ec90900abadf9fefbe49a2df57f356d43cecdaf33a",

"EndpointID": "c67f166e2c399d62ada2d58a7a274f161378aa0a9c9c352e7907c3f2a7f8df45",

"Gateway": "172.17.0.1",

"IPAddress": "172.17.0.3",

"IPPrefixLen": 16,

"IPv6Gateway": "",

"GlobalIPv6Address": "",

"GlobalIPv6PrefixLen": 0,

"MacAddress": "02:42:ac:11:00:03",

"DriverOpts": null

}

}

}

}

]

docker容器内部的ip是有可能会发生改变的

Bridge 网络模式

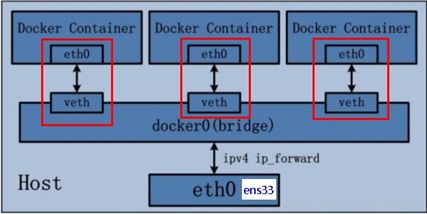

Docker 服务默认会创建一个 docker0 网桥(其上有一个 docker0 内部接口),该桥接网络的名称为docker0,它在内核层连通了其他的物理或虚拟网卡,这就将所有容器和本地主机都放到同一个物理网络。Docker 默认指定了 docker0 接口 的 IP 地址和子网掩码,让主机和容器之间可以通过网桥相互通信。

在该模式中,Docker 守护进程创建了一个虚拟以太网桥 docker0,新建的容器会自动桥接到这个接口,附加在其上的任何网卡之间都能自动转发数据包。

默认情况下,守护进程会创建一对对等虚拟设备接口 veth pair,将其中一个接口设置为容器的 eth0 接口(容器的网卡),另一个接口放置在宿主机的命名空间中,以类似 vethxxx 这样的名字命名,从而将宿主机上的所有容器都连接到这个内部网络上。

运行一个基于 busybox 镜像构建的容器 bbox01,查看 ip addr:

[root@test ~]# docker run -it --name bbox01 busybox

Unable to find image 'busybox:latest' locally

latest: Pulling from library/busybox

809d8e20e203: Pull complete

Digest: sha256:2376a0c12759aa1214ba83e771ff252c7b1663216b192fbe5e0fb364e952f85c

Status: Downloaded newer image for busybox:latest

/ # ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

26: eth0@if27: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue

link/ether 02:42:ac:11:00:06 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.6/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

守护进程还会从网桥 docker0 的私有地址空间中分配一个 IP 地址和子网给该容器,并设置 docker0 的 IP 地址为容器的默认网关。也可以安装 yum install -y bridge-utils 以后,通过 brctl show 命令查看网桥信息

[root@test ~]# yum install -y bridge-utils

[root@test ~]# brctl show

bridge name bridge id STP enabled interfaces

docker0 8000.02428fef6e06 no veth155aaec

vethad8699e

vethc94dda7

vethda06ae9

vethded9001

对于每个容器的 IP 地址和 Gateway 信息,我们可以通过 docker inspect 容器名称|ID 进行查看,在 NetworkSettings 节点中可以看到详细信息

[root@test ~]# docker network inspect bridge

[

{

"Name": "bridge",

"Id": "6f24f7cbfa10048e76b574ec90900abadf9fefbe49a2df57f356d43cecdaf33a",

"Created": "2023-07-11T07:22:15.715138449Z",

"Scope": "local",

"Driver": "bridge",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": null,

"Config": [

{

"Subnet": "172.17.0.0/16",

"Gateway": "172.17.0.1"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"ConfigFrom": {

"Network": ""

},

"ConfigOnly": false,

"Containers": {

"19d14c2fdb62b0b30e33e9fa5f95813ae949cdba450f3b942a152cbf03ad9b45": {

"Name": "db1",

"EndpointID": "c230a062220ca20aca60fbe4d5f987eb4c6909f6967b918f51ac31cd1620f613",

"MacAddress": "02:42:ac:11:00:03",

"IPv4Address": "172.17.0.3/16",

"IPv6Address": ""

},

"2715db54f63af6991cf200dd25ec8bb035ad367c98994abd054727b831e61edb": {

"Name": "bbox01",

"EndpointID": "5801b8ff13e9adabb55a39fd5cb3d6d8124af807311f10bf05f842c621952637",

"MacAddress": "02:42:ac:11:00:06",

"IPv4Address": "172.17.0.6/16",

"IPv6Address": ""

},

"3f2d71eecb6cd747ce694ecaa4bab58a22360886002837ea65f2659cd61119d6": {

"Name": "db3",

"EndpointID": "a2630ab3ef3836884fe855cbd99af08fabab7424134bfa67e886329db4a45430",

"MacAddress": "02:42:ac:11:00:05",

"IPv4Address": "172.17.0.5/16",

"IPv6Address": ""

},

"6fad6aa97b03adf3a613e5109792c0c1d35f0d076ea9a097d3f645d54139eec9": {

"Name": "db2",

"EndpointID": "a74cc32c585de49e1799311dd74791070b4fce3a1c8ad06c57a27de6363593fd",

"MacAddress": "02:42:ac:11:00:04",

"IPv4Address": "172.17.0.4/16",

"IPv6Address": ""

},

"9b45a8a658434d43a73857ab3d3f98bfaaeb8b9bc4b15a20bcfbba74ff6b3439": {

"Name": "dbdata",

"EndpointID": "fb6974276d93659c2bbaaf9cb74e51a4a120970ff842f0d52295a272ccd7129e",

"MacAddress": "02:42:ac:11:00:02",

"IPv4Address": "172.17.0.2/16",

"IPv6Address": ""

}

},

"Options": {

"com.docker.network.bridge.default_bridge": "true",

"com.docker.network.bridge.enable_icc": "true",

"com.docker.network.bridge.enable_ip_masquerade": "true",

"com.docker.network.bridge.host_binding_ipv4": "0.0.0.0",

"com.docker.network.bridge.name": "docker0",

"com.docker.network.driver.mtu": "1500"

},

"Labels": {}

}

]

Bridge说明

-

Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。因为在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的Container-IP直接通信。

-

docker run 的时候,没有指定network的话默认使用的网桥模式就是bridge,使用的就是docker0。在宿主机ifconfig,就可以看到docker0和自己create的network(后面讲)eth0,eth1,eth2……代表网卡一,网卡二,网卡三……,lo代表127.0.0.1,即localhost,inet addr用来表示网卡的IP地址

-

网桥docker0创建一对对等虚拟设备接口一个叫veth,另一个叫eth0,成对匹配。

- 整个宿主机的网桥模式都是docker0,类似一个交换机有一堆接口,每个接口叫veth,在本地主机和容器内分别创建一个虚拟接口,并让他们彼此联通(这样一对接口叫veth pair);

- 每个容器实例内部也有一块网卡,每个接口叫eth0;

- docker0上面的每个veth匹配某个容器实例内部的eth0,两两配对,一一匹配。

通过上述,将宿主机上的所有容器都连接到这个内部网络上,两个容器在同一个网络下,会从这个网关下各自拿到分配的ip,此时两个容器的网络是互通的。

查看所有 bridge 网络模式下的容器,在 Containers 节点中可以看到容器名称

关于

bridge网络模式的使用,只需要在创建容器时通过参数--net bridge或者--network bridge指定即可,当然这也是创建容器默认使用的网络模式,也就是说这个参数是可以省略的

Bridge 桥接模式的实现步骤主要如下:

- Docker Daemon 利用 veth pair 技术,在宿主机上创建一对对等虚拟网络接口设备,假设为 veth0 和 veth1。而 veth pair 技术的特性可以保证无论哪一个 veth 接收到网络报文,都会将报文传输给另一方。

- Docker Daemon 将 veth0 附加到 Docker Daemon 创建的 docker0 网桥上。保证宿主机的网络报文可以发往 veth0;

- Docker Daemon 将 veth1 添加到 Docker Container 所属的 namespace 下,并被改名为 eth0。如此一来,宿主机的网络报文若发往 veth0,则立即会被 Container 的 eth0 接收,实现宿主机到 Docker Container 网络的联通性;同时,也保证 Docker Container 单独使用 eth0,实现容器网络环境的隔离性。

Host 网络模式

容器不会获得一个独立的Network Namespace,而是和宿主机共用一个Network Namespace。容器将不会虚拟出自己的网卡而使用宿主机的IP和端口。

docker run -d --network host --name tomcat83 billygoo/tomcat8-jdk8

# 查看容器实例内部

[root@test ~]# docker inspect tomcat83 | tail -n 20

"Networks": {

"host": {

"IPAMConfig": null,

"Links": null,

"Aliases": null,

"NetworkID": "2dc34a1c0f045de9d4f92334e27325912f47f228de3c9ed680385bf1247a4b48",

"EndpointID": "bc0c47dab8947cb1d0667b30dc4cecaa836c1a8f4ce4e429cb0fea9a86b48d9a",

"Gateway": "",

"IPAddress": "",

"IPPrefixLen": 0,

"IPv6Gateway": "",

"GlobalIPv6Address": "",

"GlobalIPv6PrefixLen": 0,

"MacAddress": "",

"DriverOpts": null

}

}

}

}

]

没有设置-p的端口映射了,如何访问启动的tomcat83?

http://宿主机IP:8080/

[root@test ~]# curl http://127.0.0.1:8080

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8" />

<title>Apache Tomcat/8.0.53</title>

<link href="favicon.ico" rel="icon" type="image/x-icon" />

<link href="favicon.ico" rel="shortcut icon" type="image/x-icon" />

<link href="tomcat.css" rel="stylesheet" type="text/css" />

</head>

...

所以容器共享宿主机网络IP,这样的好处是外部主机与容器可以直接通信。

None 网络模式

在none模式下,并不为Docker容器进行任何网络配置。 也就是说,这个Docker容器没有网卡、IP、路由等信息,只有一个lo。需要我们自己为Docker容器添加网卡、配置IP等。

禁用网络功能,只有lo标识(就是127.0.0.1表示本地回环)

[root@test ~]# docker run -d -p 8084:8080 --network none --name tomcat84 billygoo/tomcat8-jdk8

bca3fd1c4a6502e30154c4de69d3ce2cfba3fe39480fd99c4e266f0072a56fe6

[root@test ~]# docker inspect tomcat84 | tail -n 20

"Networks": {

"none": {

"IPAMConfig": null,

"Links": null,

"Aliases": null,

"NetworkID": "80147a6b6933fe9d3a6b15fb75e671f1c011b9fc3e06dc8622e49e5ed28e8df5",

"EndpointID": "005a23aae4e1a74128f4dd1fbf97af1b80cae21f0ffc1d715fee8e049602fe1f",

"Gateway": "",

"IPAddress": "",

"IPPrefixLen": 0,

"IPv6Gateway": "",

"GlobalIPv6Address": "",

"GlobalIPv6PrefixLen": 0,

"MacAddress": "",

"DriverOpts": null

}

}

}

}

]

Container ⽹络模式

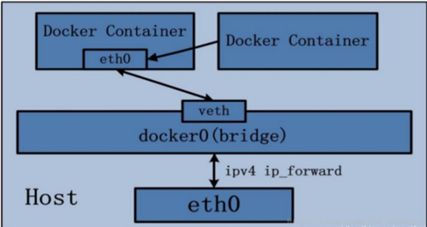

新建的容器和已经存在的一个容器共享一个网络ip配置而不是和宿主机共享。新创建的容器不会创建自己的网卡,配置自己的IP,而是和一个指定的容器共享IP、端口范围等。同样,两个容器除了网络方面,其他的如文件系统、进程列表等还是隔离的。

启动Alpine

Alpine操作系统是一个面向安全的轻型 Linux发行版

[root@test ~]# docker run -it --name alpine1 alpine /bin/sh

Unable to find image 'alpine:latest' locally

latest: Pulling from library/alpine

31e352740f53: Already exists

Digest: sha256:82d1e9d7ed48a7523bdebc18cf6290bdb97b82302a8a9c27d4fe885949ea94d1

Status: Downloaded newer image for alpine:latest

/ # ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

42: eth0@if43: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue state UP

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

[root@test ~]# docker run -it --network container:alpine1 --name alpine2 alpine /bin/sh

/ # ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

44: eth0@if45: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue state UP

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

假如此时关闭alpine1,再看看alpine2

[root@test ~]# docker stop alpine1

alpine1

/ # ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

/ #

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-lTt8VMM0-1689323325504)(Docker基础——网络配置.assets/image-20230714105946363.png)]

自定义网络模式

自定义桥接网络,自定义网络默认使用的是桥接网络bridge

新建自定义网络

[root@test ~]# docker network create zk_network

7fc25b7da1b5c1cf32e51f58ed617d6e31c06f3cb7c0d92cf0f67303836d2650

[root@test ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

6f24f7cbfa10 bridge bridge local

2dc34a1c0f04 host host local

80147a6b6933 none null local

7fc25b7da1b5 zk_network bridge local

新建容器加入上一步新建的自定义网络

[root@test ~]# docker run -d -p 8081:8080 --network zk_network --name tomcat81 billygoo/tomcat8-jdk8

0739ecb41385379498fbca63e5ce3b4ae07480b5c22e3e4660cbb90c5f838e7c

[root@test ~]# docker run -d -p 8082:8080 --network zk_network --name tomcat82 billygoo/tomcat8-jdk8

84e438e30c4b40a4a9b0cdd97ce78625733f5e60760d953ac2cabbaf28e59809

互相ping测试

[root@test ~]# docker exec -it tomcat81 bash

root@0739ecb41385:/usr/local/tomcat# ping tomcat82

PING tomcat82 (172.18.0.3) 56(84) bytes of data.

64 bytes from tomcat82.zk_network (172.18.0.3): icmp_seq=1 ttl=64 time=0.197 ms

64 bytes from tomcat82.zk_network (172.18.0.3): icmp_seq=2 ttl=64 time=0.109 ms

^C

--- tomcat82 ping statistics ---

2 packets transmitted, 2 received, 0% packet loss, time 1000ms

rtt min/avg/max/mdev = 0.109/0.153/0.197/0.044 ms

root@0739ecb41385:/usr/local/tomcat# ^C

root@0739ecb41385:/usr/local/tomcat# exit

exit

[root@test ~]# docker exec -it tomcat82 bash

root@84e438e30c4b:/usr/local/tomcat# ping tomcat81

PING tomcat81 (172.18.0.2) 56(84) bytes of data.

64 bytes from tomcat81.zk_network (172.18.0.2): icmp_seq=1 ttl=64 time=0.235 ms

64 bytes from tomcat81.zk_network (172.18.0.2): icmp_seq=2 ttl=64 time=0.101 ms

64 bytes from tomcat81.zk_network (172.18.0.2): icmp_seq=3 ttl=64 time=0.130 ms

^C

--- tomcat81 ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 2000ms

rtt min/avg/max/mdev = 0.101/0.155/0.235/0.058 ms

root@84e438e30c4b:/usr/local/tomcat# exit

exit

自定义网络本身就维护好了主机名和ip的对应关系(ip和域名都能通)

Docker平台架构

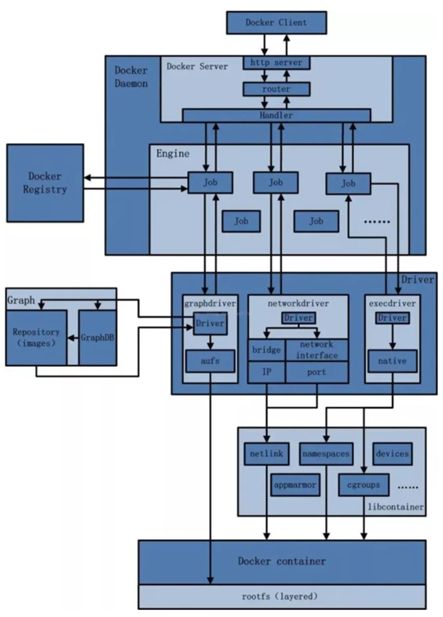

从其架构和运行流程来看,Docker 是一个 C/S 模式的架构,后端是一个松耦合架构,众多模块各司其职。

Docker 运行的基本流程为:

1 用户是使用 Docker Client 与 Docker Daemon 建立通信,并发送请求给后者。

2 Docker Daemon 作为 Docker 架构中的主体部分,首先提供 Docker Server 的功能使其可以接受 Docker Client 的请求。

3 Docker Engine 执行 Docker 内部的一系列工作,每一项工作都是以一个 Job 的形式的存在。

4 Job 的运行过程中,当需要容器镜像时,则从 Docker Registry 中下载镜像,并通过镜像管理驱动 Graph driver将下载镜像以Graph的形式存储。

5 当需要为 Docker 创建网络环境时,通过网络管理驱动 Network driver 创建并配置 Docker 容器网络环境。

6 当需要限制 Docker 容器运行资源或执行用户指令等操作时,则通过 Execdriver 来完成。

7 Libcontainer是一项独立的容器管理包,Network driver以及Exec driver都是通过Libcontainer来实现具体对容器进行的操作

整体架构