跟我一起从零开始学python(十一)简述spark

前言

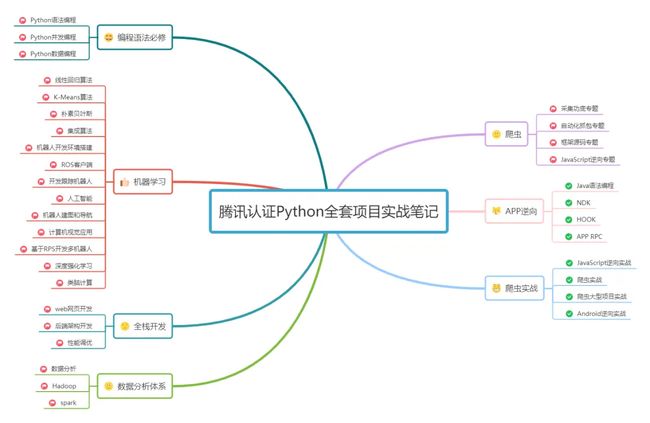

回顾之前讲述了python语法编程 必修入门基础和网络编程,多线程/多进程/协程等方面的内容,后续讲到了数据库编程篇MySQL,Redis,MongoDB篇,和机器学习,全栈开发,数据分析前面没看的也不用往前翻,系列文已经整理好了:

1.跟我一起从零开始学python(一)编程语法必修

2.跟我一起从零开始学python(二)网络编程

3.跟我一起从零开始学python(三)多线程/多进程/协程

4.跟我一起从零开始学python(四)数据库编程:MySQL数据库

5.跟我一起从零开始学python(五)数据库编程:Redis数据库

6.跟我一起从零开始学python(六)数据库编程:MongoDB数据库

7.跟我一起从零开始学python(七)机器学习

8.跟我一起从零开始学python(八)全栈开发

9.跟我一起从零开始学python(九)数据分析

10.跟我一起从零开始学python(十)Hadoop从零开始入门

本系列文根据以下学习路线展开讲述,由于内容较多,:

从零开始学python到高级进阶路线图

一丶spark概述

Apache Spark是一种基于内存的分布式计算框架,被广泛用于大数据处理、机器学习、图形计算等领域。相比Hadoop MapReduce等传统批处理框架,Spark具有更高的计算速度和更丰富的数据处理操作,可以支持交互式查询和流式处理等应用场景。

Spark的主要特点包括:

-

高效性:Spark使用内存计算,提高了计算速度,可以比Hadoop MapReduce更快地处理大规模数据。

-

易用性:Spark提供了丰富的数据处理和机器学习API,可以使用多种编程语言进行编写,包括Scala、Java、Python和R。

-

可扩展性:Spark可以在集群上进行分布式计算,支持多种集群管理器,包括YARN、Mesos和Kubernetes等。

-

多样性:Spark支持多种数据处理模式,包括批处理、流处理和交互式查询等,可以满足多种应用场景的需求。

Spark的数据处理核心是基于RDD(Resilient Distributed Datasets)的数据模型。RDD是一种分布式的、容错的数据集合,支持多种数据操作方式,包括Map、Filter、Reduce和Join等。RDD可以在计算过程中针对数据错误进行自动修复和容错处理,保证了数据处理的可靠性和稳定性。

Spark还提供了丰富的扩展功能,包括Spark SQL、Spark Streaming和MLlib等。Spark SQL支持SQL查询和结构化数据处理,Spark Streaming支持流数据处理,而MLlib则提供了多种机器学习算法和工具,方便了大数据上的机器学习应用。

在大数据工程技术体系中,Spark是一个非常重要的组成部分,可以帮助我们高效地处理和分析大数据。了解Spark技术的特点和优势,掌握其基本的编程和使用方法,可以对提升我们的大数据处理能力和应用水平有很大的帮助。

二丶spark core

Spark Core是Apache Spark的核心组件,负责管理和调度Spark应用程序的所有任务。其主要功能包括分布式数据处理、内存计算、任务调度和容错处理等。

具体来说,Spark Core主要由以下几个模块组成:

-

RDD(Resilient Distributed Datasets): Spark Core使用RDD作为其数据模型,可以对数据进行分布式处理。RDD是一个分布式的容错数据集合,支持多种数据操作方式,例如Map、Filter、Reduce和Join等。RDD的容错处理机制可以自动修复数据错误,从而保证了数据处理的可靠性和稳定性。

-

SparkContext: SparkContext是Spark应用程序的主要入口点,负责与Spark集群进行通信和任务调度。SparkContext可以为Spark应用程序提供分布式计算的环境和资源管理。

-

Task Scheduling: Spark Core使用DAG(Directed Acyclic Graph)来表示Spark应用程序的任务调度关系。Spark将应用程序的所有任务划分成DAG中的一系列Stage,使用Task Scheduling算法在Spark集群中进行任务的并行调度和执行。

-

Memory Management: Spark Core使用内存计算作为其数据处理的核心方式,可以提高数据处理速度。Spark Core使用自己的内存管理系统来控制内存使用,包括使用序列化和压缩技术来优化数据传输和存储。

-

Cluster Manager Integration: Spark Core可以与多种集群管理器进行集成,包括Hadoop YARN、Apache Mesos和Kubernetes等。这样可以方便地在分布式计算集群上运行Spark应用程序。

在Spark应用程序中,开发人员通常使用Spark Core的API来编写应用程序,并利用Spark Context来创建RDD和执行RDD操作。Spark Core可以帮助我们以分布式、快速、可靠的方式处理大规模数据,是Spark生态系统中最关键的组件之一。

三丶Spark sql

Spark SQL是Apache Spark生态系统中的一个模块,用于处理结构化数据。它提供了一种以SQL方式查询分布式数据集的标准化界面,同时支持SQL查询的性能优化以及与Spark生态系统的整合。

Spark SQL的主要功能包括:

-

SQL查询:Spark SQL支持传统的SQL查询语句,包括SELECT、FROM、WHERE、GROUP BY和ORDER BY等,可以直接查询RDD和DataFrame。此外,Spark SQL还支持Hive和DDL语句,可以直接操作外部存储系统中的数据。

-

DataFrame API:Spark SQL提供了DataFrame API,提供了更加面向对象的方法来查询和操作数据。DataFrame是一个由行和列组成的分布式数据集合,与Pandas和R语言中的DataFrame类似。

-

数据源连接:Spark SQL支持与多种数据存储系统进行连接,包括Hive、MySQL、Postgres、Cassandra和HDFS等。通过连接这些数据存储系统,可以直接使用SQL查询和DataFrame API对这些数据进行处理。

-

性能优化:Spark SQL在执行查询时,会自动进行性能优化,包括查询优化、数据倾斜处理、谓词下推、列式存储和分区裁剪等。这些性能优化可以提高查询的速度和效率。

-

与MLlib和GraphX的整合:Spark SQL可以与MLlib和GraphX进行整合,可以通过SQL查询和DataFrame API对机器学习和图计算进行处理。

-

UDF和UDAF:Spark SQL支持用户自定义函数(UDF)和用户自定义聚合函数(UDAF),可以在SQL查询中使用。

Spark SQL是一个非常强大和灵活的工具,可以轻松地查询和处理大规模的结构化数据集。它提供了多种接口和工具,可以帮助开发人员更高效地处理数据,并从中获取价值。

sparkSQL核心编码

Apache Spark是一个分布式计算引擎,可用于处理和分析大规模的结构化和非结构化数据。Spark SQL是Spark生态系统中的一个组件,它提供了一种基于SQL语言进行结构化数据处理的方式,同时兼容Hive元数据存储和查询。在本文中,我们将重点介绍Spark SQL的核心编码技术。

1.DataFrame和Dataset的概念

DataFrame和Dataset是Spark SQL中最常用的两种数据结构,它们都是分布式的、可弹性扩展的、高性能的数据集合。

DataFrame是一种带有命名列和模式的分布式数据集,它类似于关系型数据库中的表格数据,每一列都有固定的数据类型,并且支持了丰富的算子操作。

Dataset是一种通过Spark的编程接口类型安全的分布式数据集,它融合了DataFrame和RDD的优点,支持类型安全的lambda表达式和编译时类型检查,同时也支持多种编程语言。

2.DataFrame API和SQL查询

Spark SQL提供两种API接口:DataFrame API和SQL接口。在实际开发中,我们建议优先使用DataFrame API进行操作,因为DataFrame API在表达能力和性能方面都要比它的SQL接口更强大。

示例:使用DataFrame API查询指定列的数据

val df = spark.read.csv("file.csv")

df.select("_c0").show()

示例:使用SQL查询指定列的数据

val df = spark.read.csv("file.csv")

df.createTempView("tmp_table")

spark.sql("SELECT _c0 FROM tmp_table").show()

3.数据分区和分桶

在分布式计算中,数据的分区和分桶非常重要,因为它可以让数据更好地利用集群中的计算资源,提高计算性能。

数据分区是指将数据集合划分为多个子集,每个子集可以分配给集群中的不同节点并行计算,以达到加速计算和分摊计算资源的目的。在Spark SQL中,数据分区是由Spark自动进行的,同时也可以通过repartition和coalesce等API手动进行设置。

示例:使用repartition指定数据分区数目

val df = spark.read.csv("file.csv")

df.repartition(10)

数据分桶是一种分区的方式,在数据分桶中,数据按照某个特定的列进行分配到各个桶中,每个桶都包含特定的数据范围。这种方法可以更加精细地控制数据分布和并行计算的负载平衡。

示例:使用分桶技术进行数据分布控制

val df = spark.read.csv("file.csv")

df.write

.bucketBy(100, "column1")

.sortBy("column2")

.saveAsTable("bucketed_table")

4.缓存

在执行Spark SQL查询时,Spark会自动将查询结果缓存到内存中,以便后续的查询可以更快地访问这些数据。但是,如果在查询过程中需要使用的数据过大,内存可能会不够用,这时就需要利用Spark的缓存机制,将数据缓存到磁盘上,以避免重复的输入输出和计算。

示例:使用缓存来加速数据查询

val df = spark.read.csv("file.csv")

df.cache()

df.count()

df.filter("_c0 = 'value'").show()

5.谓词下推

谓词下推是一种Spark SQL优化技术,它可以把查询中的条件语句尽可能地推迟到最后才执行,以减少数据的传输和处理。

示例:使用谓词下推提高查询性能

val df = spark.read.csv("file.csv")

df.filter("_c0 = 'value' and _c1 = 'value'")

6.广播变量

广播变量是一种优化技术,用于在计算集群的所有节点中共享数据,避免重复传输复杂数据结构,以提高查询性能。

示例:使用广播变量减少数据传输

val data = sc.parallelize(Seq("value1", "value2")).collectAsMap()

val broadcastData = spark.sparkContext.broadcast(data)

val df = spark.read.csv("file.csv")

df.filter(col("_c0").isin(broadcastData.value))

7.容错机制

Spark SQL具有很好的容错机制,允许在遇到错误时自动出发重试,实现数据的高可靠和稳定处理。具体而言,Spark SQL利用RDD间的依赖关系对任务进行追溯和恢复,保证了计算过程中的可靠性和稳定性。

8.可维护性

在编写Spark SQL代码时,应该注意代码的可读性和维护性。良好的代码规范和注释可以使代码更易于阅读和理解,而合理的代码组织和可重用的函数则可以降低代码的冗余和复杂度。

示例:使用函数提高代码的可重用性

def sumColumn(df: DataFrame, column: String): Long = {

df.select(column).rdd.map(row => row(0).toString.toLong).reduce(_ + _)

}

val df = spark.read.csv("file.csv")

val sum = sumColumn(df, "_c0")

综上所述,Spark SQL是大数据处理和分析的重要技术路线,其中DataFrame和Dataset API、数据分区和分桶、缓存、谓词下推、广播变量、容错机制和可维护性都是使用Spark SQL的核心编程技术和最佳实践。

四丶spark内核原理

Apache Spark是一个快速且通用的大数据处理引擎,其内核由Scala编写而成,允许使用Java、Python、R和SQL等多种编程语言来编写大数据处理应用程序。Spark采用内存计算和分布式架构,以提高大数据处理的运行效率。

Spark的内核由许多组件组成,包括Spark Core、Spark SQL、Spark Streaming、MLlib和GraphX等。其中,Spark Core是所有组件的基础,提供了分布式任务调度、内存管理、任务并发控制等功能。在Spark Core中,最核心的概念是弹性分布式数据集(Resilient Distributed Dataset,简称RDD),它是由一系列分布在不同节点上的数据块组成的,可以并发地进行操作和处理。

1.Spark的RDD具有以下三个核心特性:

-

弹性:RDD能够在节点故障时自动恢复,保证数据处理的健壮性和可靠性。

-

分布式:RDD把数据分散存储在多个节点上,支持并行处理。

-

不可变性:RDD是不可变的,即在对RDD进行操作时,不会改变原有RDD的内容,而是生成新的RDD。

2.Spark内核的执行流程如下:

-

任务提交:通过SparkContext创建一个任务,并将其提交到Spark集群中。

-

任务划分:任务会被Spark根据RDD中的分区将其划分成多个Stage,每个Stage包含多个Task。

-

任务调度:Spark会将每个Stage中的Task分配到可用的节点上执行,遵循数据本地化原则,尽可能将计算任务分配给包含数据的节点。

-

任务执行:每个Task会在分配到的节点上执行,并与其它Task并行地进行计算。

-

结果汇总:所有Task的计算结果会被合并到一起,形成最终的计算结果。

总体来说,Spark的内核通过RDD这一抽象概念提供了高度可靠和高效的大数据处理框架,使得用户能够更加轻松地处理和分析海量的数据,并加速计算过程。