[NAS4](2023Neurocomputin)Bi-fidelity Evolutionary Multiobjective Search for Adversarially Robust...

论文链接:https://arxiv.org/abs/2207.05321

代码链接:暂未公布

摘要:

【问题背景】人们发现深度神经网络容易受到对抗性攻击,因此在安全敏感的环境中引起了潜在的担忧。 为了解决这个问题,最近的研究从架构的角度研究了深度神经网络的对抗鲁棒性。

【动机】然而,搜索深度神经网络的架构在计算上是昂贵的,特别是在与对抗性训练过程相结合时。

【本文方法】为了应对上述挑战,本文提出了一种双保真多目标神经架构搜索方法。 首先,我们将增强深度神经网络对抗鲁棒性的 NAS 问题转化为多目标优化问题。 具体来说,除了低保真性能预测器作为第一个目标之外,我们还利用一个辅助目标——其值是经过高保真评估训练的代理模型的输出。 其次,我们通过结合三种性能估计方法(即参数共享、低保真度评估和基于代理的预测器)来降低计算成本。

- 使用NSGA-II作为架构进化的baseline;

- 利用低保真度适应度low-fidelity fitness evaluations来估计架构在干净图像和对抗性示例上的性能,这里低保真度适应度通过从部分预训练的超网中继承权重获得;

- 利用高保真评估high-fidelity evaluations来预测候选架构的性能来训练代理,并将预测值用作辅助目标auxiliary-objective,这里高保真度适应度通过从全部预训练的超网中继承权重获得。

【实验结果】在 CIFAR-10、CIFAR-100 和 SVHN 数据集上进行的广泛实验证实了所提出方法的有效性。

1. Introduction

【攻击防御的背景】近年来,深度网络(DNN)已成功用于执行各种复杂的应用,例如图像分类[1]-[8]、目标检测[9]、[10]和语言建模[11]。 然而,DNN 模型很容易受到有意设计的带有难以察觉的扰动的对抗性示例的影响 [12]。 随着 DNN 在自动驾驶汽车和面部识别系统等安全敏感应用中的广泛使用,开发准确且稳健的模型至关重要。 人们已经做出了很多努力来解决对抗性例子的威胁。 防御技术可以分为两种类型,即在遇到对抗性示例之前增强DNN的主动技术,包括对抗性训练、防御蒸馏和分类器鲁棒性,以及在构建DNN后检测对抗性示例的反应性技术,包括对抗性示例 检测、输入重建和网络验证。

【NAS引入和对应的搜索加速方法】尽管在防御策略上付出了相当大的努力,但大多数研究人员还是基于一两个特定的手动设计的卷积神经网络(CNN)(例如 PreAct ResNet [14] 和 WideResNet [15])进行了实验。 最近,神经架构搜索(NAS)引起了越来越多的关注,并在各种任务上取得了可喜的性能。 早期的 NAS 算法 [16] 承受着极其沉重的计算负担,因为评估每个候选架构的真实性能需要从头开始训练网络。 因此,如何快速、准确地估计候选架构的性能是NAS的主要挑战。 已采用各种估计策略来降低计算成本。 提出了一些构建具有更少层或更少通道的低保真代理网络的方法[17] - [19]并训练它们解决较小规模的代理任务 [19]-[21]。然而,已经发现从此类代理任务获得的架构可能在目标任务上表现不佳。 为了解决这个问题,参数共享[17]、[22]和基于预测器的评估器[23]、[24]被提出作为另外两种有效的方法来估计架构的性能。 参数共享方法训练一个以所有可达到的结构作为子网的超网。 在搜索过程中,子网的参数源自从超网继承的权重。 然而,从超网得出的权重对于评估候选架构的性能可能并不完全可靠。 因此,有人建议使用几个梯度步骤来微调共享权重[25]。 基于预测器的评估器被提出通过使用一组标有相应性能的 DNN 来训练代理模型来加速 NAS。 在搜索过程中,代理模型直接预测新搜索架构的性能。 为了进一步加速NAS进程,Luo等人。 [26]尝试将参数共享评估器和基于预测器的评估器结合起来。 然而,与使用昂贵的评估相比,他们未能找到具有更好性能的架构。

【鲁棒架构搜索介绍】尽管以上介绍的工作都已经取得了巨大的成就,但现存的NAS方法主要关注分类精度受限于密集的计算和内存成本。只有很少方法从架构设计的角度尝试理解对抗鲁棒性。Alparalan探索了架构尺寸对模型鲁棒性的影响。Huang使用网格搜索观察模型宽度和深度对对抗训练好的WideResNet-34的影响。但是以上的研究考虑的是模型参数,而不是网络结构的拓扑。鲁棒架构搜索(Robust architecture search, RAS)[29]采用进化算法搜索鲁棒的网络结构,其对来自更广泛搜索空间的可转移黑盒攻击可能不太敏感。RAS 发现的模型的性能是通过干净图像的验证准确性加上 2812 个对抗性示例的准确性来衡量的。尽管RAS进化得到的网络在此场景中不太敏感,但其通用性有限,只能在pre-labeled对抗样本下使用。Dong提出一个差分NAS架构用于对抗医疗图像分割,其自动化地搜索鉴别器的架构。RobNet使用对抗训练和one-shot NAS理解网络架构对对抗攻击的性能,展示出密集连接的结构对模型的鲁棒性有很大贡献。Yue等人提出了一种称为E2RNAS的算法,它将多重梯度下降算法与双层优化相结合,以搜索有效、高效和鲁棒的架构,这是第一个提出同时优化性能、鲁棒性和资源约束的工作。 尽管E2RNAS的搜索成本不到1个GPU天,但在PGD攻击下获得的架构的分类精度(6%∼11%)并不令人满意。 为了寻找目标容量的稳健架构,Ning 等人提出了multi-shot NAS,它训练八个具有不同初始通道数的超网,所发现的架构在目标容量方面优于同行竞争对手,但超网训练成本远高于一次性 NAS。 Chen等人提出ABanditNAS,它采用antibandit策略来搜索由去噪块、无权操作、Gabor滤波器和卷积组成的多个单元。 Cazenavette等人提出了一种深度追踪算法,将架构搜索表述为联合计算所有网络激活的全局稀疏编码问题。 Hosseini等人介绍了DSRNA,它采用可微的NAS来最大化两个提出的鲁棒性指标,即认证下界和雅可比范数界。 Wang等人提出了一种多目标梯度优化方法,并设计了一个新的搜索空间来自动搜索人工智能物联网(AIoT)系统的鲁棒架构。Mok等人提出了 AdvRush,它采用 DARTS作为骨干搜索算法来搜索具有平滑输入损失情况的架构。 TAM-NAS专注于微型网络的鲁棒性,利用一次性 NAS 和多目标优化来获得对抗精度、干净精度和模式大小之间的权衡解决方案。 然而,这项工作主要集中在微小的神经网络上。 在我们之前的工作 MORAS中,除了原始数据集的性能之外,我们还引入了针对多种对抗性攻击的鲁棒性度量作为目标函数,以搜索对各种对抗性攻击不太敏感的架构。 然而,搜索过程非常耗时,因为群体中的每个架构都必须经过训练才能获得适应度值。

为了进一步提高 NAS 的效率,提高 DNN 的对抗鲁棒性,在这项工作中,我们提出了 MORAS-S 方法——基于代理作为辅助目标的多目标鲁棒架构搜索。 具体来说,这项工作的主要贡献如下:

- 为了增强 DNN 的对抗鲁棒性,我们通过引入在线代理模型作为附加目标(辅助目标),将 NAS 问题转化为多目标优化问题,以预测候选架构的高保真适应度值;

- 为了加速搜索过程,我们通过将参数共享与基于预测器的评估器相结合来预测候选架构的性能,其中直接从稳健的超网训练继承的参数将用作性能评估器。 一方面,从部分验证集计算出的性能被用作低保真度适应性评估。 另一方面,我们在整个验证集上计算架构的性能作为高保真适应度评估,并且根据高保真适应度评估构建的代理模型将用于近似高保真适应度函数。

- 基准数据集上的实验表明,所提出的 MORAS-SH 方法可以有效地找到具有可比分类精度的鲁棒架构。

II. Related Work

在过去几年中,在研究如何获得更鲁棒的网络方面取得了可喜的进展。 在本节的其余部分中,将回顾与这项工作相关的一些方法,包括对抗性攻击和防御、加速网络性能评估的方法以及进化多目标 NAS。

A. Adversarial Attack and Defense

深度学习模型已经被对抗攻击误导,比如说fast gradient sign method (FGSM),基本迭代算法和C&W攻击。其中一个最强大的对抗攻击,PGD,联合随机初始化和多步攻击,可被表示如下:

已经设计出了大量的对策来提升深度学习模型的鲁棒性,比如对抗训练、防御性蒸馏、特征压缩防御性-GAN,和基于自动编码的降噪等。其中,对抗训练已被证明是提升鲁棒性有效的方法,其最小化在干净和对抗样本上的加权损失。在本文中,我们用PGD-AT(PGD对抗训练)来训练超网,其数学公式如下:

B. Neural Architecture Evaluators

在NAS中,如果网络完全从头开始训练,回花费大量的时间。实际上,参数共享和基于指标的评估器是2种常用的技术以高效评价网络。

参数共享。也称为权重共享,在给定参数空间内构建和训练一个非常大的网络,然后子网直接共享来自超网的参数。这个过度参数化的超网将包含所有可能的子网。因此,子网的评价极大减少了评价候选架构的时间。基于采样的单路经训练sample-based single-path training是一种训练超网的常见方式,其通过均匀采样或公平多路径采样并优化单路径进行训练。训练之后,超网可以作为一个不同路径的性能评估器。当选择路径,可以通过不同的搜索策略实施(进化算法/强化学习)。

基于指标的评估器。NAS 中最流行的预测器是基于代理的监督学习预测器。为了获得训练预测器的数据,需要首先训练大量的架构,这是非常耗时的。预测器然后将架构描述作为输入,并输出预测的性能分数。 利用良好的预测器,可以选择有前途的架构并由昂贵的评估器进行评估。 查询时间短,允许NAS期间进行大量预测。

总体来说,one-shot evaluators和predictor-based evaluators能加速NAS过程。但是,如何有效结合他们并进一步减少计算时间是一个具有挑战性的问题。

C. Evolutionary Multiobject Neural Architecture Search

大多数 NAS 方法专注于发现具有最佳分类精度的架构。 然而,在实际应用中,还应同时考虑其他因素,例如模型大小、功耗和鲁棒性。

差分NAS,基于强化学习的方法,贝叶斯优化经常用标量化或附加约束将多目标NAS转化为单目标优化。但是标量化scalarized approaches展示出并不如Pareto有效。多目标EAs在解决多目标优化问题上非常流行。Kim等人提出NEMO,带有多目标优化的神经进化以在精度和推理速度间平衡,使用NSGA-II方法;Elsken引入LEMONADE将验证误差作为昂贵目标+模型尺寸作为便宜目标,将便宜目标评价多次以节约时间。但是,仍需要57 GPU days在CIFAR10上。Yang提出pNSGA-III同时优化模型尺寸和分类精度;Zhu等人使用NSGA-II优化精度和浮点数用于federated NAS; Hu提出随机权重评价并使用NSGA-II优化FLOPs和精度。

还有一些方法考虑超过2个目标。Lu提出NSGANet-V2并优化5个目标包括精度、模型大小、MAdds, CPU和GPU延迟;Ning采用基于轮盘赌的EA框架考虑性能和容量,这里性能是干净样本和对抗样本精度的加权和。

总体而言,NSGA-II已经成功应用于多目标NAS。尽管取得了显着的进展,但针对多目标 NAS 架构抵御对抗性攻击的弹性的研究仍然零星。 在我们之前的工作中,我们引入了 MORAS,来搜索对各种对抗性攻击不太敏感的架构。 然而,搜索过程非常耗时,因为群体中的每个架构都必须经过训练才能获得适应度值。 相比之下,这项工作将超网训练与代理相结合来辅助评估过程,从而进一步提高搜索效率。

MORAS: J. Liu and Y. Jin, “Multi-objective search of robust neural architectures against multiple types of adversarial attacks,” Neurocomputing, vol. 453, pp. 73–84, 2021.

III. THE PROPOSED APPROACH:MORAS-SH

MORAS-SH:以代理作为辅助目标的多目标架构搜索对抗鲁棒性

- 使用NSGA-II作为架构进化的baseline;

- 利用低保真度适应度low-fidelity fitness evaluations来估计架构在干净图像和对抗性示例上的性能,这里低保真度适应度通过从部分预训练的超网中继承权重获得;

- 利用高保真评估high-fidelity evaluations来预测候选架构的性能来训练代理,并将预测值用作辅助目标auxiliary-objective,这里高保真度适应度通过从全部预训练的超网中继承权重获得。

A. Preliminaries

1)Search Space and Encoding Strategy:

富有表现力且适当的搜索空间对于搜索鲁棒网络非常重要,因为搜索空间的类型和大小限制了可以搜索的可能网络的范围。本文使用的搜索空间和stage-wise search space的相同,使用邻接矩阵编码,图2展示了搜索空间和编码策略。

每个block由一个有向无环图(DAG)表示,有2个来自pre-previous和previous的block的节点+4个内部节点。每个内部节点可以接收在它之前节点的信息,比如节点3能接收来自节点0,1,2的信息。节点间的边表示操作,有4种操作:none, skip connection 3x3 separable convolution, residual 3x3 separable convolution。具体编码时:决策变量的总维度是(2+3+4+5)84=56。

2)Embedding:

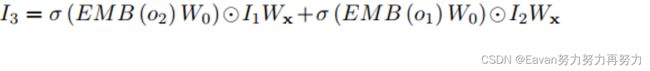

代理模型常由MLP/RBF构建。但是,如果代表网络结构的编码可以直接用于预测器的输入,代理模型的预测结果是不精确的。这项工作采用了一种名为 GATES[61] 的基于图的神经架构编码器,它将神经架构映射到连续的嵌入空间,然后连接四个阶段块拓扑的嵌入作为架构嵌入。 GATES的编码过程模仿了实际的特征图计算,可以表示网络承载的信息。

上图中,节点3的信息计算如下:

[61]GATES: X. Ning, Y. Zheng, T. Zhao, Y. Wang, and H. Yang, “A generic graphbased neural architecture encoding scheme for predictor-based nas,” in Computer Vision – ECCV 2020, A. Vedaldi, H. Bischof, T. Brox, and J.-M. Frahm, Eds. Cham: Springer International Publishing, 2020, pp. 189–204.

B. Multiobjective

从概念上讲,多目标化旨在同时优化主要目标和辅助目标。 由于辅助目标可以帮助更好地指导搜索,因此多目标化可以比仅仅关注主要目标带来更好的性能。 在这项工作中,除了网络的准确性和鲁棒性的主要目标之外,我们还引入了代理模型的预测分数作为辅助目标。 据我们所知,这是首次尝试利用代理模型的预测值作为辅助目标,在 NAS 中采用多目标化。

使用低保真适应度函数和代理模型进行的评估在计算上都很便宜,但与高保真适应度函数相关。 然而,它们都不够准确,无法找到双保真优化问题的令人满意的解决方案。 此外,根据低保真度评估估计的性能可能与替代者预测的性能不一致。 因此,我们使用从代理获得的预测分数作为附加目标,以通过低保真度评估来协助进化过程。 我们将 NAS 表述为以下三目标最小化问题:

代理模型经过训练,可以使用数据 S 来近似高保真度适应度。最初,我们使用以下方法对 m 个解决方案进行采样:拉丁超立方采样(LHS)并使用高保真度评估来计算它们的适应度,这是通过整个验证集的错误率来计算的。 与低保真度评估类似,高保真度评估也会在干净的数据集和对抗性样本上产生错误率。 然而,为了简化优化问题并降低训练代理模型的难度,我们采用干净错误率和对抗错误率的加权和,而不是两者,作为架构的标签。 也就是说,预测分数和辅助目标只是一维而不是二维。为了简单起见,权重都设置为 0.5。

代理模型的输入是使用 GATES 嵌入后的架构值。 代理模型的近似误差是不可避免的,这可能会误导所提出算法的搜索。 因此,在进化G代后,当前种群的填充样本将被添加到S中, 正如[64]中所建议的,我们选择有前途和不确定的解决方案作为填充样本,代理模型构建的伪代码总结在算法1中。

C. Overall Framework

1) 超网训练:对抗性地训练一个超网N,通过7-step PGD attack.

2) 架构进化:随机初始化有n个个体的种群。对每个个体,使用低保真度评估来估计其适应度值,并使用从代理模型获得的预测分数作为辅助目标。根据NSGA-II更新个体,具体地,SBX交叉和多项式变异。当使用数据S时更新代理模型。

3)最终训练:由于我们在搜索过程中使用低保真度评估来评估候选架构,并以代理作为辅助目标,因此评估精度较低。 我们将此过程视为预筛选标准。 计算预算耗尽后,我们在完整的验证集上以高保真度根据预筛选标准评估A^中的所有非支配解,进行二次筛选,然后过滤掉非支配解A,从头开始进行最终的对抗训练 使用 PGD-AT 进行完全训练数据 D。

Bi-fidelity Evolutionary Multiobjective Search for Adversarially Robust..._第1张图片](http://img.e-com-net.com/image/info8/50ea65b010474bbd8288cd6761388a3c.jpg)

Bi-fidelity Evolutionary Multiobjective Search for Adversarially Robust..._第2张图片](http://img.e-com-net.com/image/info8/46759270cace4b29893448a315d10c39.jpg)

Bi-fidelity Evolutionary Multiobjective Search for Adversarially Robust..._第3张图片](http://img.e-com-net.com/image/info8/9748416aa7cd450d9c691eac227db00f.jpg)

Bi-fidelity Evolutionary Multiobjective Search for Adversarially Robust..._第4张图片](http://img.e-com-net.com/image/info8/378ae00d575d4774adecc524a0fc3366.jpg)

Bi-fidelity Evolutionary Multiobjective Search for Adversarially Robust..._第5张图片](http://img.e-com-net.com/image/info8/09c97886ea614c2e90a7f73a8c3930f7.jpg)