【AI】数学基础——线代(向量部分)

参考:

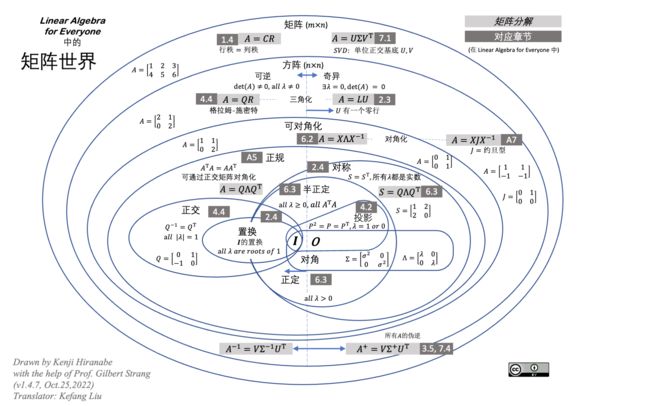

kenjihiranabe——The-Art-of-Linear-Algebra-zh-CN

详细计算方法与理论:见矩阵论

线性代数的本质在于将具体事物抽象为数学对象,并描述其静态和动态特性

-

最基本的概念是 set

集合的定义是由某些具有某些共性的对象汇总成的集体。

将这些对象用数字或符号表示(对象映射到数域),这样集合中的元素就变为了多个数字或符号以某种方式排列成的组合

文章目录

-

- 2.1 对象的表示

- 2.2 线性空间

-

- 2.2.1 向量

- 2.2.2 向量空间

-

- 线性空间参考系

- 2.2.3 范数(模)

-

- 几种范数

- 距离

- 2.2.4 向量运算

-

- 模——向量的大小

- 内积——向量间的相对位置

- 向量乘向量

- 2.2.5 正交向量组与规范正交基

-

- 正交向量组

- 规范正交基

- 2.2.6 向量组的秩

【AI】数学基础——线代(矩阵&特征值,特征向量&矩阵分解)

2.1 对象的表示

在线代中,由单独的数a构成的元素被称为 标量 (scalar):一个标量可以是整数、实数或复数

- a , b , c a,b,c a,b,c

多个标量 a 1 , a 2 , ⋯ , a n a_1,a_2,\cdots,a_n a1,a2,⋯,an 按一定顺序组成一个序列,这样的元素称为 向量 (vector)

- 向量代表了维度的增加,向量中每个元素需要使用一个索引确定

- α = ( a 1 , a 2 , ⋯ , a n ) \alpha=(a_1,a_2,\cdots,a_n) α=(a1,a2,⋯,an)

矩阵 (matrix) 由维度相同的向量组成

- 矩阵代表了维度的增加,矩阵中每个元素需要使用两个索引确定

- A = ( a 11 a 12 a 13 a 21 a 22 a 23 a 31 a 32 a 33 ) A=\left(\begin{matrix}a_{11}&a_{12}&a_{13}\\a_{21}&a_{22}&a_{23}\\a_{31}&a_{32}&a_{33}\end{matrix}\right) A= a11a21a31a12a22a32a13a23a33

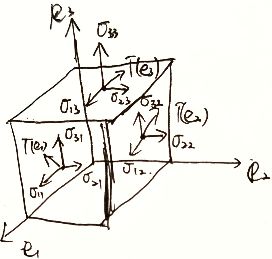

张量 (tensor) 矩阵中的每个元素都是向量,则形成张量

- A = ( 1 1 2 2 0 1 0 2 3 3 2 2 0 3 0 2 ) = ( 1 2 3 2 ) ⊗ ( 1 1 0 1 ) A=\left(\begin{matrix}1&1&2&2\\0&1&0&2\\3&3&2&2\\0&3&0&2\end{matrix}\right)=\left(\begin{matrix}1&2\\3&2\end{matrix}\right)\otimes\left(\begin{matrix}1&1\\0&1\end{matrix}\right) A= 1030113320202222 =(1322)⊗(1011)

计算机处理离散取值的二进制信息,因此模拟世界的信号必须在定义域和值域上同时进行数字化,才能被计算机存储和处理。

线性代数是用模拟数字世界表示真实物理世界的工具

在计算机存储中:

-

标量 占据零维度数组

-

向量 占据一维数组:如语音信号

-

矩阵 占据二维数组:如灰度图像

-

张量 占据三维乃至更高维度数组:如RGB图像和视频

e ⃗ T ⊗ e ⃗ = ( i ⃗ T , j ⃗ T , k ⃗ T ) ( i ⃗ j ⃗ k ⃗ ) = ( i ⃗ T ⋅ i ⃗ j ⃗ T ⋅ i ⃗ k ⃗ T ⋅ i ⃗ i ⃗ T ⋅ j ⃗ j ⃗ T ⋅ j ⃗ k ⃗ T ⋅ j ⃗ i ⃗ T ⋅ k ⃗ j ⃗ T ⋅ k ⃗ k ⃗ T ⋅ k ⃗ ) = ( ( i ⃗ , i ⃗ ) ( i ⃗ , j ⃗ ) ( i ⃗ , k ⃗ ) ( j ⃗ , i ⃗ ) ( j ⃗ , j ⃗ ) ( j ⃗ , k ⃗ ) ( k ⃗ , i ⃗ ) ( k ⃗ , j ⃗ ) ( k ⃗ , k ⃗ ) ) = ( σ 11 σ 12 σ 13 σ 21 σ 22 σ 23 σ 31 σ 32 σ 33 ) \vec{e}^T\otimes \vec{e}=\left(\vec{i}^T,\vec{j}^T,\vec{k}^T\right)\left(\begin{aligned}\vec{i}\\\vec{j}\\\vec{k}\end{aligned}\right)=\left(\begin{matrix}\vec{i}^T\cdot\vec{i}&\vec{j}^T\cdot\vec{i}&\vec{k}^T\cdot\vec{i}\\\vec{i}^T\cdot\vec{j}&\vec{j}^T\cdot\vec{j}&\vec{k}^T\cdot\vec{j}\\\vec{i}^T\cdot\vec{k}&\vec{j}^T\cdot\vec{k}&\vec{k}^T\cdot\vec{k}\\\end{matrix}\right)=\left(\begin{matrix}(\vec{i},\vec{i})&(\vec{i},\vec{j})&(\vec{i},\vec{k})\\(\vec{j},\vec{i})&(\vec{j},\vec{j})&(\vec{j},\vec{k})\\(\vec{k},\vec{i})&(\vec{k},\vec{j})&(\vec{k},\vec{k})\end{matrix}\right)=\left(\begin{matrix}\sigma_{11}&\sigma_{12}&\sigma_{13}\\\sigma_{21}&\sigma_{22}&\sigma_{23}\\\sigma_{31}&\sigma_{32}&\sigma_{33}\\\end{matrix}\right) eT⊗e=(iT,jT,kT) ijk = iT⋅iiT⋅jiT⋅kjT⋅ijT⋅jjT⋅kkT⋅ikT⋅jkT⋅k = (i,i)(j,i)(k,i)(i,j)(j,j)(k,j)(i,k)(j,k)(k,k) = σ11σ21σ31σ12σ22σ32σ13σ23σ33

描述空间中各点沿各方向的受力情况

2.2 线性空间

2.2.1 向量

m ⃗ = m x i ⃗ + m y j ⃗ + m z k ⃗ = ( m x , m y , m z ) ( i ⃗ j ⃗ k ⃗ ) \vec{m}=m_x\vec{i}+m_y\vec{j}+m_z\vec{k}=(m_x,m_y,m_z)\left(\begin{aligned}\vec{i}\\\vec{j}\\\vec{k}\end{aligned}\right) m=mxi+myj+mzk=(mx,my,mz) ijk

- 大小

- 方向

2.2.2 向量空间

如果有一个集合,它的元素都是具有相同维数的向量

-

定义了加法和数乘等结构化运算,将这个空间称为 线性空间

-

定义了内积运算的线性空间,将这个空间称为 内积空间

在线性空间中,任一一个向量代表的是n维空间中的一个点;线性空间中的任一点也都可以唯一地用一个向量表示

线性空间参考系

正交基 :一组两两正交的向量构成了这个空间的正交基

标准正交基 :(欧几里得空间)正交基中基向量的 L 2 L^2 L2 范数的单位长度为1,则这组正交基就是标准正交基

- 正交基的作用就是给内积空间定义基准,用于空间中的所有向量(点)

2.2.3 范数(模)

用于描述向量大小,记为 ∥ ⋅ ∥ \Vert \cdot \Vert ∥⋅∥

可以理解为:将向量转换为实数的函数

性质

- 任一向量 X ⃗ \vec{X} X , ∥ X ∥ ≥ 0 \Vert X\Vert\ge 0 ∥X∥≥0 ,当且仅当 X ⃗ = 0 ⃗ \vec{X}=\vec{0} X=0 ,有 ∥ X ∥ = 0 \Vert X\Vert=0 ∥X∥=0

- ∥ λ X ∥ = λ ∥ X ∥ \Vert \lambda X\Vert=\lambda\Vert X\Vert ∥λX∥=λ∥X∥

- 三角不等式: ∥ X + Y ∥ ≤ ∥ X ∥ + ∥ Y ∥ \Vert X+Y\Vert\le \Vert X\Vert+\Vert Y \Vert ∥X+Y∥≤∥X∥+∥Y∥

几种范数

L-0范数

∥ X ∥ 0 = 向量分量非零元素个数 \Vert X\Vert_0=向量分量非零元素个数 ∥X∥0=向量分量非零元素个数

- ∥ ( 1 0 ) ∥ 0 = 1 \Vert \left(\begin{aligned}1\\0\end{aligned}\right)\Vert_0=1 ∥(10)∥0=1 , ∥ ( 1 2 ) ∥ 0 = 2 \Vert \left(\begin{aligned}1\\2\end{aligned}\right)\Vert_0=2 ∥(12)∥0=2

L-1范数(最大列和)

∥ X ∥ 1 = ∑ i = 1 n ∣ x i ∣ \Vert X\Vert_1=\sum_{i=1}^n\vert x_i\vert ∥X∥1=∑i=1n∣xi∣

L-2范数

∥ X ∥ 2 = ∑ i = 1 n ∣ x i ∣ 2 \Vert X\Vert_2=\sqrt{\sum_{i=1}^n\vert x_i\vert^2} ∥X∥2=∑i=1n∣xi∣2

L-p范数

∥ X ∥ p = ∑ i = 1 n ∣ x i ∣ 2 p \Vert X\Vert_p=\sqrt[p]{\sum_{i=1}^n\vert x_i\vert^2} ∥X∥p=p∑i=1n∣xi∣2

L- ∞ \infty ∞范数(最大行和)

∥ X ∥ ∞ = max 1 ≤ i ≤ n { ∣ x i ∣ } \Vert X\Vert_\infty=\max_{1\le i\le n}\{\vert x_i\vert\} ∥X∥∞=max1≤i≤n{∣xi∣}

p范数与无穷范数关系

L-p范数

令 ∣ x j ∣ = max 1 ≤ i ≤ n { ∣ x i ∣ } ⇒ ∣ x j ∣ ∞ ≫ ∣ x i ∣ ∞ ∥ X ∥ p = ∑ i = 1 n ∣ x i ∣ p p = p → ∞ ∣ x 1 ∣ ∞ + ∣ x 2 ∣ ∞ + ⋯ + ∣ x n ∣ ∞ ∞ ≈ ∣ x j ∣ ∞ ∞ = ∣ x j ∣ = max 1 ≤ i ≤ n { ∣ x i ∣ } \begin{aligned} &令 \vert x_j\vert=\max_{1\le i\le n}\{\vert x_i\vert\} \Rightarrow \vert x_j\vert^{\infty}\gg \vert x_i\vert^{\infty}\\ &\Vert X\Vert_p=\sqrt[p]{\sum_{i=1}^n\vert x_i\vert^p}\xlongequal{p\rightarrow \infty}\sqrt[\infty]{\vert x_1\vert^{\infty}+\vert x_2\vert^{\infty}+\cdots+\vert x_n\vert^{\infty}}\approx{} \sqrt[\infty]{\vert x_j\vert^\infty}=\vert x_j\vert=\max_{1\le i\le n}\{\vert x_i\vert\} \end{aligned} 令∣xj∣=1≤i≤nmax{∣xi∣}⇒∣xj∣∞≫∣xi∣∞∥X∥p=pi=1∑n∣xi∣pp→∞∞∣x1∣∞+∣x2∣∞+⋯+∣xn∣∞≈∞∣xj∣∞=∣xj∣=1≤i≤nmax{∣xi∣}

距离

欧氏距离(L-2范数): L − 2 ( A , B ) = m x 2 + m y 2 L-2(A,B)=\sqrt{m_x^2+m_y^2} L−2(A,B)=mx2+my2

曼哈顿距离(L-1范数): L − 1 ( A , B ) = ∣ m x ∣ + ∣ m y ∣ L-1(A,B)=\vert m_x\vert +\vert m_y\vert L−1(A,B)=∣mx∣+∣my∣

2.2.4 向量运算

模——向量的大小

n n n 维向量的模长, ∣ X ∣ = ( X , X ) = x 1 2 + x 2 2 + ⋯ + x n 2 ≥ 0 \vert X\vert=\sqrt{(X,X)}=\sqrt{x_1^2+x_2^2+\cdots+x_n^2}\ge 0 ∣X∣=(X,X)=x12+x22+⋯+xn2≥0

单位向量 ∣ x ∣ = 1 \vert x\vert=1 ∣x∣=1

齐次性 ∣ λ x ∣ = ∣ λ ∣ ⋅ ∣ x ∣ \vert \lambda x\vert=\vert \lambda\vert\cdot\vert x\vert ∣λx∣=∣λ∣⋅∣x∣

三角不等性 ∣ x + y ∣ ≤ ∣ x ∣ + ∣ y ∣ \vert x+y\vert\le \vert x\vert+\vert y\vert ∣x+y∣≤∣x∣+∣y∣

内积——向量间的相对位置

矢量 → 标量 矢量\rightarrow 标量 矢量→标量

x = ( x 1 x 2 ⋮ x n ) x=\left(\begin{aligned}x_1\\x_2\\\vdots\\x_n\end{aligned}\right) x= x1x2⋮xn , y = ( y 1 y 2 ⋮ y n ) y=\left(\begin{aligned}y_1\\y_2\\\vdots\\y_n\end{aligned}\right) y= y1y2⋮yn

( x , y ) = y T x = y 1 x 1 + y 2 x 2 + ⋯ + y n x n (x,y)=y^Tx=y_1x_1+y_2x_2+\cdots+y_nx_n (x,y)=yTx=y1x1+y2x2+⋯+ynxn

( y , x ) = x T y = x 1 y 1 + x 2 y 2 + ⋯ + x n y n (y,x)=x^Ty=x_1y_1+x_2y_2+\cdots+x_ny_n (y,x)=xTy=x1y1+x2y2+⋯+xnyn

性质

-

对称性:对于实数向量内积 ( x , y ) = ( y , x ) (x,y)=(y,x) (x,y)=(y,x)

-

线性

( x , λ y ) = ( λ x , y ) = λ ( x , y ) (x,\lambda y)=(\lambda x,y)=\lambda(x,y) (x,λy)=(λx,y)=λ(x,y)

( x + y , z ) = ( x , z ) + ( y , z ) (x+y,z)=(x,z)+(y,z) (x+y,z)=(x,z)+(y,z)

内积描述的是夹角,用于表示两个向量之间的相对位置

A ⋅ B = ∥ A ∥ ⋅ ∥ B ∥ c o s θ A\cdot B=\Vert A\Vert\cdot \Vert B\Vert cos\theta A⋅B=∥A∥⋅∥B∥cosθ

若 A ⊥ B A\bot B A⊥B ,则 θ = π 2 \theta=\frac{\pi}{2} θ=2π , A ⋅ B = 0 A\cdot B=0 A⋅B=0

投影

若 ∥ B ∥ = 1 \Vert B\Vert=1 ∥B∥=1 ,则 A ⋅ B A\cdot B A⋅B 为A在B上的投影长度

向量乘向量

向量内积与秩1矩阵

2.2.5 正交向量组与规范正交基

( x , y ) = 0 (x,y)=0 (x,y)=0 ,则两向量正交

正交向量组

两两正交的非零向量组

- 正交向量组必线性无关

eg

已知 R 3 R^3 R3 空间 α 1 = ( 1 1 1 ) \alpha_1=\left(\begin{aligned}1\\1\\1\end{aligned}\right) α1= 111 , α 2 = ( 1 − 2 1 ) \alpha_2=\left(\begin{aligned}1\\-2\\1\end{aligned}\right) α2= 1−21 正交,求 α 3 \alpha_3 α3 使 α 1 , α 2 , α 3 \alpha_1,\alpha_2,\alpha_3 α1,α2,α3 为正交向量组

设 α 3 = ( x 1 x 2 x 3 ) \alpha_3=\left(\begin{aligned}x_1\\x_2\\x_3\end{aligned}\right) α3= x1x2x3 ,由于 α 1 , α 2 , α 3 \alpha_1,\alpha_2,\alpha_3 α1,α2,α3 两两正交 ,有 ( α 1 , α 3 ) = ( α 2 , α 3 ) = 0 ⇒ { x 1 + x 2 + x 3 = 0 x 1 − 2 x 2 + x 3 = 0 (\alpha_1,\alpha_3)=(\alpha_2,\alpha_3)=0\Rightarrow\left\{\begin{aligned}&x_1+x_2+x_3=0\\&x_1-2x_2+x_3=0\end{aligned}\right. (α1,α3)=(α2,α3)=0⇒{x1+x2+x3=0x1−2x2+x3=0

有 A X = ( 1 1 1 1 − 2 1 ) ( x 1 x 2 x 3 ) = 0 AX=\left(\begin{matrix}1&1&1\\1&-2&1\end{matrix}\right)\left(\begin{aligned}x_1\\x_2\\x_3\end{aligned}\right)=0 AX=(111−211) x1x2x3 =0 , A → ( 1 1 1 1 − 2 1 ) → ( 1 1 1 0 − 3 0 ) → ( 1 0 1 0 1 0 ) A\rightarrow\left(\begin{matrix}1&1&1\\1&-2&1\end{matrix}\right)\rightarrow\left(\begin{matrix}1&1&1\\0&-3&0\end{matrix}\right)\rightarrow\left(\begin{matrix}1&0&1\\0&1&0\end{matrix}\right) A→(111−211)→(101−310)→(100110)

r ( A ) = 2 , n − r ( A ) = 1 r(A)=2,n-r(A)=1 r(A)=2,n−r(A)=1 ,故线性方程组的基础解系中有一个无关向量

∴ { x 1 = − x 3 x 2 = 0 ⇒ α 3 = ( − 1 0 1 ) \therefore \left\{\begin{aligned}&x_1=-x_3\\&x_2=0\end{aligned}\right.\Rightarrow \alpha_3=\left(\begin{aligned}-1\\0\\1\end{aligned}\right) ∴{x1=−x3x2=0⇒α3= −101

规范正交基

n n n 维向量 e 1 , e 2 ⋯ , e r e_1,e_2\cdots,e_r e1,e2⋯,er 是向量空间 V ⊂ R n V\subset R^n V⊂Rn 中的向量

{ e 1 , e 2 ⋯ , e r 为单位正交向量 e 1 , e 2 ⋯ , e r 是 V 的一个基 \left\{ \begin{aligned} &e_1,e_2\cdots,e_r为单位正交向量\\ &e_1,e_2\cdots,e_r是V的一个基 \end{aligned} \right. {e1,e2⋯,er为单位正交向量e1,e2⋯,er是V的一个基

则称 e 1 , e 2 ⋯ , e r e_1,e_2\cdots,e_r e1,e2⋯,er 为 V V V 的一个规范正交基

如:

e 1 = ( 1 0 0 0 ) , e 2 = ( 0 1 0 0 ) , e 3 = ( 0 0 1 0 ) , e 4 = ( 0 0 0 1 ) e_1=\left(\begin{aligned}1\\0\\0\\0\end{aligned}\right),e_2=\left(\begin{aligned}0\\1\\0\\0\end{aligned}\right),e_3=\left(\begin{aligned}0\\0\\1\\0\end{aligned}\right),e_4=\left(\begin{aligned}0\\0\\0\\1\end{aligned}\right) e1= 1000 ,e2= 0100 ,e3= 0010 ,e4= 0001 是 R 4 R^4 R4 的一个规范正交基

2.2.6 向量组的秩

设向量组 α 1 , ⋯ , α n \alpha_1,\cdots,\alpha_n α1,⋯,αn ,存在 α 1 , ⋯ , α s \alpha_1,\cdots,\alpha_s α1,⋯,αs ,使 α j = k 1 α 1 + ⋯ + k s α s ( j ≠ 1 , 2 , ⋯ , s ) \alpha_j=k_1\alpha_1+\cdots+k_s\alpha_s(j\neq 1,2,\cdots,s) αj=k1α1+⋯+ksαs(j=1,2,⋯,s) ,则称 α j \alpha_j αj 可由 α s , ⋯ , α s \alpha_s,\cdots,\alpha_s αs,⋯,αs 线性表出

线性无关 :若有 k 1 α 1 + ⋯ + k r α r = 0 ⇒ k 1 = k 2 = ⋯ = k r = 0 k_1\alpha_1+\cdots+k_r\alpha_r=0\Rightarrow k_1=k_2=\cdots=k_r=0 k1α1+⋯+krαr=0⇒k1=k2=⋯=kr=0 ,则称 α 1 , ⋯ , α r \alpha_1,\cdots,\alpha_r α1,⋯,αr 为极大线性无关组

r ( α 1 ⋯ α n ) = r ( α 1 ⋯ α r ) = r r(\alpha_1\cdots\alpha_n)=r(\alpha_1\cdots\alpha_r)=r r(α1⋯αn)=r(α1⋯αr)=r 为向量组的秩