pytorch(b站小土堆学习笔记P1-P15)

P3. Python学习中的两大法宝函数(当然也可以用在PyTorch)

import torch

#查看pytorch有哪些指令

print(dir(torch))

print(dir(torch.cuda))

#查看每条指令怎么用

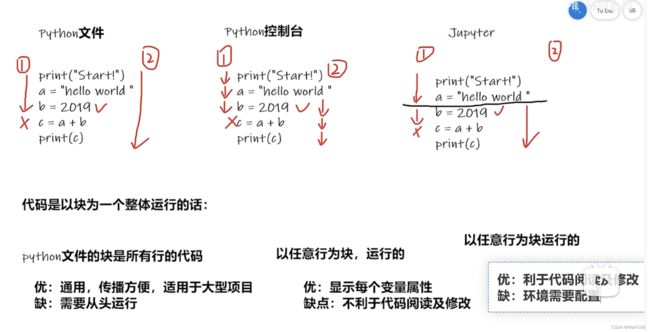

help(torch.cuda.is_available)P4. PyCharm及Jupyter使用及对比

P5 dataset和dataloader

P6. Dataset类代码实战

import os

from PIL import Image

from torch.utils.data import Dataset

# dataset有两个作用:1、加载每一个数据,并获取其label;2、用len()查看数据集的长度

class MyData(Dataset):

def __init__(self, root_dir, label_dir): # 初始化,为这个函数用来设置在类中的全局变量

self.root_dir = root_dir

self.label_dir = label_dir

self.path = os.path.join(self.root_dir,self.label_dir)

# 单纯的连接起来而已,背下来怎么用就好了,因为在win下和linux下的斜线方向不一样,所以用这个函数来连接路径

self.img_path = os.listdir(self.path) # img_path 的返回值,就已经是一个列表了

def __getitem__(self, idx): # 获取数据对应的 label

img_name = self.img_path[idx] # img_name 在上一个函数的最后,返回就是一个列表了

img_item_path = os.path.join(self.root_dir, self.label_dir, img_name) # 这行的返回,是一个图片的路径,加上图片的名称了,能够直接定位到某一张图片了

img = Image.open(img_item_path) # 这个步骤看来是不可缺少的,要想 show 或者 操作图片之前,必须要把图片打开(读取),也就是 Image.open()一下,这可能是 PIL 这个类型图片的特有操作

label = self.label_dir # 这个例子中,比较特殊,因为图片的 label 值,就是图片所在上一级的目录

return img, label # img 是每一张图片的名称,根据这个名称,就可以使用查看(直接img)、print、size等功能

# label 是这个图片的标签,在当前这个类中,标签,就是只文件夹名称,因为我们就是这样定义的

def __len__(self):

return len(self.img_path) # img_path,已经是一个列表了,len()就是在对这个列表进行一些操作

if __name__ == '__main__':

root_dir = "dataset/train"

ants_label_dir = "ants"

bees_label_dir = "bees"

ants_dataset = MyData(root_dir, ants_label_dir)

bees_dataset = MyData(root_dir, bees_label_dir)

train_dataset = ants_dataset + bees_dataset

# runfile('E:/pythonProject/learn_pytorch/read_data.py')

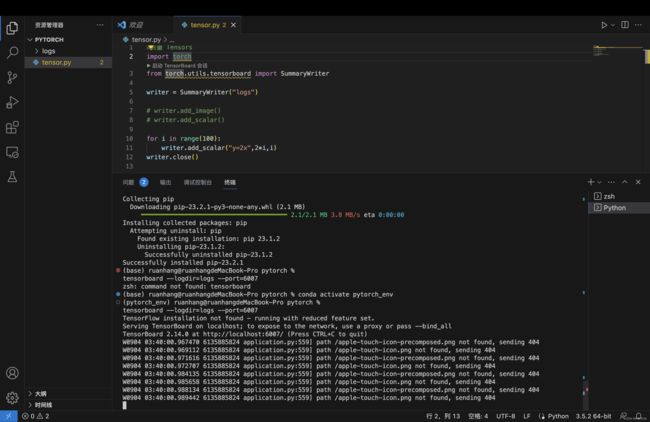

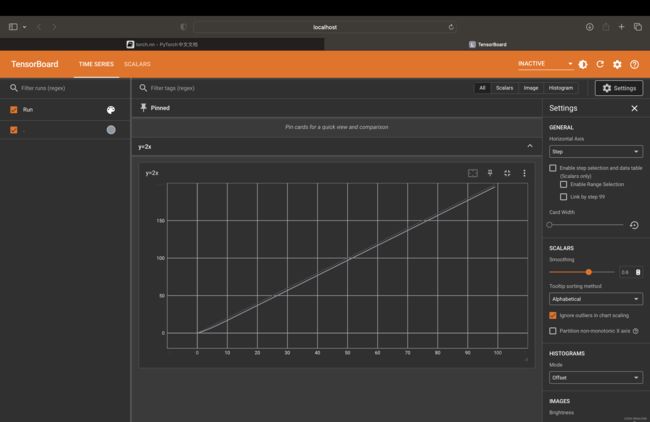

P7/8. TensorBoard的使用

用于数据可视化

运行方式

# 切换到 Logs的上一层目录中

tensorboard --logdir=logs --port=6007demo1

from torch.utils.tensorboard import SummaryWriter

writer = SummaryWriter("logs")

# writer.add_image()

# writer.add_scalar()

for i in range(100):

writer.add_scalar("y=2x",2*i,i)

writer.close()

demo2

from torch.utils.tensorboard import SummaryWriter

from PIL import Image

from torchvision import transforms

writer = SummaryWriter("../logs")

img = Image.open('../images/pytorch.png')

# img.show()

print(img)

trans_tensor = transforms.ToTensor()

img_tensor = trans_tensor(img)

writer.add_image('ToTensor',img_tensor)

trans_norm = transforms.Normalize([2, 3, 5, 10], [0.5, 0.5, 0.5, 0.5])

img_norm = trans_norm(img_tensor)

writer.add_image("Normalize",img_norm,2) #2,表示第2步

writer.close()

P10/P11/P12/P13 Transform(处理图片 先忽略)

数据集下载

用好pytorch官网

#下载路径为../data;第二个参数表示现在训练集;第三个参数表示下载成tensor类型,最后将download设置为true

train_data = torchvision.datasets.CIFAR10(root="../data", train=True, transform=torchvision.transforms.ToTensor(),

download=True)

#,train=False 表示下载测试集

test_data = torchvision.datasets.CIFAR10(root="../data", train=False, transform=torchvision.transforms.ToTensor(),

download=True)

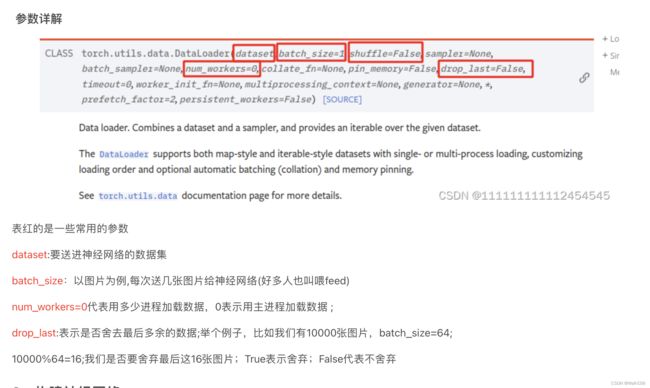

P15 DataLoader加载数据集

加载数据集方式主要使用的是DataLoader;我们不管是自己制作的数据集,还是从网上下载的数据集,当我们把这些数据送到神经网络训练的时候,我们必须用一些特定的方式送给神经网络。这便是DataLoader的作用,比如最常见的batch_size。有时数据集非常的大几万甚至几十万张图片,一张一张送进送进神经网络效率太低,所以我们要成批(batch_size)的送给神经网络。还有我们是否对数据集打乱等等。