IM即时通讯系统[SpringBoot+Netty]——梳理(总)

文章目录

- 一、为什么要自研一套即时通讯系统

-

- 1、实现一个即时通讯系统有哪些方式

-

- 1.1、使用开源产品做二次开发或直接使用

- 1.2、使用付费的云服务商

- 1.3、自研

- 2、如何自研一套即时通讯系统

-

- 2.1、早期即时通讯系统是如何实现

- 2.2、一套即时通讯系统的基本组成

- 2.3、当下的即时通讯系统常用架构

- 2.4、总结

- 二、基础数据的开发

-

- 1、导入用户资料、删除用户资料、修改用户资料、查询用户资料

- 2、即时通讯中最有价值的数据—关系链模块业务分析与数据库设计

-

- 2.1、最有价值的数据—好友关系链

- 2.2、好友关系

- 2.3、数据库设计

- 3、导入、添加、更新好友、删除好友、删除所有好友、拉取指定好友、拉取所有好友业务的功能实现

- 4、校验好友关系其实远比你想的要复杂

- 5、添加、删除、校验黑名单业务实现

- 6、好友申请列表的拉取、新建好友申请、好友申请审批、好友申请列表已读业务实现

- 7、好友分组业务介绍和数据库设计

- 8、好友分组的创建、获取、添加、删除成员、分组删除业务的实现

- 9、即时通讯最复杂的模块—群组模块业务分析和数据库设计

- 10、导入群和群成员业务实现

- 11、创建群组、修改群信息、获取群信息业务功能实现

- 12、获取用户加入的群列表业务功能实现

- 13、解散群组、转让群组的业务功能实现

- 14、拉人入群成员、移出群聊、退出群聊业务功能实现

- 15、获取群组成员信息、修改群组成员信息业务功能实现

- 16、禁言群、禁言群成员业务功能实现

- 三、BIO、NIO和Netty入门

-

- 1、BIO、NIO

- 2、netty

- 四、Netty企业开发必须掌握的技能

-

- 1、使用netty实现简单的聊天室

- 2、netty的编解码

- 3、底层数据流转的核心—pipline机制

- 4、传输层协议TCP留给我们的难题—Netty解决半包、粘包方

-

- 4.1、TCP传输中的问题(半包、黏包)

- 4.2、Netty怎么解决半包、黏包

- 5、传输层协议TCP留给我们的难题—使用私有协议解决半包、黏包、byteBuf底层API

- 6、IdleStateHandler心跳机制源码详解

- 7、使用Netty实现文件上下传

- 五、IM开发核心之构建TCP网关(上)

-

- 1、编写LimServer

- 2、编写LimWebSocketServer

- 3、使用snakeyaml动态配置文件

- 4、大白话讲通信协议—详解主流通讯协议

-

- 4.1、文本协议

- 4.2、二进制协议

- 4.3、xml协议

- 4.4、可以落地使用的协议

- 5、私有协议编解码—设计篇

- 6、私有协议编解码—实现篇

-

- 6.1、LimServer的编解码器

- 6.2、LimWebSocketServer的编解码器

- 六、IM开发核心之建构TCP网关(下)

-

- 1、登录消息—保存用户NioSocketChannel

- 2、分布式缓存中间件—Redisson快速入门操作

- 3、用户登录网关层—保存用户Session

- 4、用户退出网关层—离线删除用户Session

- 5、服务端心跳检测

- 6、RabbitMQ的安装、发布订阅、路由模式详解

- 7、TCP接入RabbitMQ、打通和逻辑层的交互

- 8、分布式TCP服务注册中心的选型

- 9、TCP服务注册—Zookeeper注册TCP服务

- 10、服务改造-TCP服务分布式改造

-

- 10.1、 广播模式

- 10.2、 一致性Hash

- 10.3、 构建路由层

- 11、即时通讯系统支持多端登录模式—应对多端登录的场景

- 七、打通业务服务器与IM服务器多端同步

-

- 1、负载均衡策略—随机模式

- 2、负载均衡策略—轮询模式

- 3、负载均衡策略—一致性Hash

- 4、配置负载均衡策略

- 5、使用Apache—HttpClient封装http请求工具

- 6、用户资料变更、群组模块回调

- 7、数据多端同步

- 8、封装查询用户Session工具类

- 9、封装MessageProducer给用户发送消息

- 10、编写用户资料、好友模块变更通知

- 11、封装GroupMessageProducer给用户发送消息

- 12、编写群组模块TCP通知

- 13、TCP服务处理逻辑层投递的MQ消息

- 14、接口调用鉴权加密—加解密算法HMAC-SHA256

- 八、消息业务的流程之打通消息收发核心

-

- 1、消息收发的核心流程

- 2、单聊消息分发逻辑—RabbitMQ连接tcp层和网关层

- 3、单聊消息分发逻辑—发送消息前置校验

- 4、单聊消息分发逻辑—消息分发的主流程

- 5、详细分析群聊业务

- 6、发送群聊消息前置校验

- 7、群聊消息的分发逻辑

- 8、聊天记录存储结构单聊群聊读扩散、写扩散选型

- 9、 IM消息ID专题—分布式自增id解决方案介绍

- 10、如何将单聊、群聊消息持久化到DB

- 11、实现发送单聊和群聊的接口

- 九、消息业务的核心之消息可达性、一致性、幂等性、实时性

-

- 1、消息实时性—利用多线程解决消息串行的问题,提高处理效率

- 2、消息实时性—校验逻辑前置由tcp通过feign接口提前校验

- 3、消息实时性—利用mq异步持久化消息

- 4、用了TCP就不会丢包、丢消息了吗?

- 5、单人消息可靠性—双重ACK保证上下行消息可靠

- 6、单人消息有序性—消息并行可能导致消息乱序

- 7、单人消息幂等性—保证消息不重复

- 8、群聊消息实时性—消息并行、持久化解耦、前置校验

- 9、群聊消息有序性—消息并行可能导致消息乱序

- 10、群聊消息消息幂等性—保证消息不重复

- 11、详解消息已读等的实现方案

- 12、构建聊天会话—消息已读功能实现

- 13、离线消息—离线消息设计和实现

- 十、揭秘QQ、微信数据同步的演进

-

- 1、剖析qq和微信背后数据同步的完整过程

- 2、如何将好友关系链、会话、群组全量拉取改为增量拉取

- 3、手把手带你实现增量同步接口

- 4、获取某个用户的req

- 5、如何实现增量拉取离线消息

- 十一、打造QQ在线状态功能之为你的应用增添色彩

-

- 1、在线状态设计

- 2、Netty网关用户状态变更通知、登录ack

- 3、逻辑层处理用户上线下线

- 4、在线状态订阅—临时订阅

- 5、实现手动设置客户端状态接口

- 6、推拉结合实现在线状态更新

- 十二、IM扩展—能做的事情还有很多

-

- 1、如何让陌生人只能发送几条消息

- 2、如何实现消息的撤回

- 3、如何设计亿级聊天记录存储方案

总结一下

一、为什么要自研一套即时通讯系统

1、实现一个即时通讯系统有哪些方式

首先从市面上看im系统(无非就这三种方式):

- 使用开源产品做二次开发或者直接使用

- 使用付费的云服务商

- 自研

1.1、使用开源产品做二次开发或直接使用

优点:可以快速的上手,使用

缺点:功能缺失,可持续性不强,没有团队做后期的维护和扩展,是否和自己公司的技术栈相匹配

1.2、使用付费的云服务商

优点:既不用开发im系统,也不需要运维服务器,大型的服务商技术比较成熟,消息传递的可靠性高,根据服务商官方的sdk和ui库,很容易的给自己的服务加上im功能

缺点:无法窥探服务商的源码(闭源),定制化的需求很难满足,官方的扩展如果没有解决你的需求,基本上就无解了,还要有信息和数据是重要的资产,放在别人的手里不太好,服务的费用高

1.3、自研

优点:切合公司技术栈进行开发,不用担心后期维护,定制自己的需求,数据安全得到保护

缺点:需要有特别熟悉im系统的人开发,对技术水平有一定的要求,人力成本增加

2、如何自研一套即时通讯系统

2.1、早期即时通讯系统是如何实现

![]()

这是早期的京东客服实现的技术架构

这个架构会造成资源的浪费,没有消息发送的时候,轮询也不会停止

2.2、一套即时通讯系统的基本组成

![]()

-

客户端:PC端(MAC、WINDOS)、手机端(安卓、苹果)、WEB端 -

服务层:接入层:im系统的门户,是im系统中较为核心的模块,维护着客户端和服务端的长链接,消息由客户端发送给接入层,接入层交递给逻辑层进行处理;接入层主要分为四个功能:第一个是保持长链接、第二个是协议解析、第三个是我们的session维护、第四个是消息推送;当消息处理完成后,也是由接入层投递给客户端;在接入层和客户端中必须要有协议(应用层协议:文本协议和二进制协议—MQTT、XMPP、HTPP等协议;私有协议)逻辑层:业务系统的一个又一个的模块:用户、关系链、群组、消息

-

存储层:MySQL、Redis

2.3、当下的即时通讯系统常用架构

![]()

-

长连接在收发消息即时,有消息来可以通过长连接可以直接投递给用户,对比长轮询而言,避免了许多的空循环(可以参考本文:web通讯的四种方式)

-

接入层和逻辑层可以通过

rpc调用或者mq解耦 -

逻辑层连接的各大持久层完成持久化工作

2.4、总结

接入层:去维护我们客户端的长连接和消息的收发,协议可以考虑使用TCP协议(可靠的);选择一个合适的应用层协议(MQTT、XMPP、私有协议);接入层还要做好用户session的维护,接入层和传统的web开发有不同,接入层是有状态的服务,传统的http是无状态的服务

逻辑层:处理消息收发的核心逻辑,配合接入层和存储层,真正的做到消息的不丢、不漏、不串

存储层:要有合理的设计,为逻辑层提供数据服务,能够承载海量的聊天记录数据

二、基础数据的开发

1、导入用户资料、删除用户资料、修改用户资料、查询用户资料

这里我觉得不错的地方,用导入用户资料的逻辑做示范:

![]()

![]()

然后这里就是一些增删改查的逻辑,这里就不写了,自己过一遍知道大致意思,后面也一样

2、即时通讯中最有价值的数据—关系链模块业务分析与数据库设计

2.1、最有价值的数据—好友关系链

为什么要这么说呢?你看微信、QQ为什么地位这么牢固呢?就是因为他们里面有你的好友,如果你换了一款聊天软件这些好友你就都没有了,你说这是不是价值挺高。

2.2、好友关系

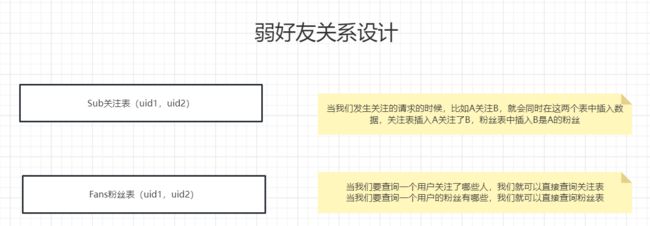

- 弱好友关系:微博那种订阅的方式

- 强好友关系:像是微信这种(本系统采用的方式)

2.3、数据库设计

-

弱好友好关系设计:

-

强好友关系设计:

![]()

- 最终设计

3、导入、添加、更新好友、删除好友、删除所有好友、拉取指定好友、拉取所有好友业务的功能实现

这里贴一个添加好友的具体逻辑的代码,其他的和这个大致思路差不多

// 添加好友的逻辑

@Transactional

public ResponseVO doAddFriend(RequestBase requestBase, String fromId, FriendDto dto, Integer appId){

// A-B

// Friend表插入 A 和 B 两条记录

// 查询是否有记录存在,如果存在则判断状态,如果是已经添加,则提示已经添加了,如果是未添加,则修改状态

// 第一条数据的插入

LambdaQueryWrapper<ImFriendShipEntity> lqw = new LambdaQueryWrapper<>();

lqw.eq(ImFriendShipEntity::getAppId, appId);

lqw.eq(ImFriendShipEntity::getFromId, fromId);

lqw.eq(ImFriendShipEntity::getToId, dto.getToId());

ImFriendShipEntity entity = imFriendShipMapper.selectOne(lqw);

long seq = 0L;

// 不存在这条消息

if(entity == null){

// 直接添加

entity = new ImFriendShipEntity();

seq = redisSeq.doGetSeq(appId + ":" + Constants.SeqConstants.Friendship);

entity.setAppId(appId);

entity.setFriendSequence(seq);

entity.setFromId(fromId);

BeanUtils.copyProperties(dto, entity);

entity.setStatus(FriendShipStatusEnum.FRIEND_STATUS_NORMAL.getCode());

entity.setCreateTime(System.currentTimeMillis());

int insert = imFriendShipMapper.insert(entity);

if(insert != 1){

// TODO 添加好友失败

return ResponseVO.errorResponse(FriendShipErrorCode.ADD_FRIEND_ERROR);

}

writeUserSeq.writeUserSeq(appId, fromId, Constants.SeqConstants.Friendship, seq);

}else{

// 存在这条消息,去根据状态做判断

// 他已经是你的好友了

if(entity.getStatus() == FriendShipStatusEnum.FRIEND_STATUS_NORMAL.getCode()){

// TODO 对方已经是你的好友

return ResponseVO.errorResponse(FriendShipErrorCode.TO_IS_YOUR_FRIEND);

}else{

ImFriendShipEntity update = new ImFriendShipEntity();

if(StringUtils.isNotEmpty(dto.getAddSource())){

update.setAddSource(dto.getAddSource());

}

if(StringUtils.isNotEmpty(dto.getRemark())){

update.setRemark(dto.getRemark());

}

if(StringUtils.isNotEmpty(dto.getExtra())){

update.setExtra(dto.getExtra());

}

seq = redisSeq.doGetSeq(appId + ":" + Constants.SeqConstants.Friendship);

update.setFriendSequence(seq);

update.setStatus(FriendShipStatusEnum.FRIEND_STATUS_NORMAL.getCode());

int res = imFriendShipMapper.update(update, lqw);

if(res != 1){

// TODO 添加好友失败

return ResponseVO.errorResponse(FriendShipErrorCode.ADD_FRIEND_ERROR);

}

writeUserSeq.writeUserSeq(appId, fromId, Constants.SeqConstants.Friendship, seq);

}

}

// 第二条数据的插入

LambdaQueryWrapper<ImFriendShipEntity> lqw1 = new LambdaQueryWrapper<>();

lqw1.eq(ImFriendShipEntity::getAppId, appId);

lqw1.eq(ImFriendShipEntity::getFromId, dto.getToId());

lqw1.eq(ImFriendShipEntity::getToId, fromId);

ImFriendShipEntity entity1 = imFriendShipMapper.selectOne(lqw1);

// 不存在就直接添加

if(entity1 == null){

entity1 = new ImFriendShipEntity();

entity1.setAppId(appId);

entity1.setFromId(dto.getToId());

BeanUtils.copyProperties(dto, entity1);

entity1.setToId(fromId);

entity1.setFriendSequence(seq);

entity1.setStatus(FriendShipStatusEnum.FRIEND_STATUS_NORMAL.getCode());

entity1.setCreateTime(System.currentTimeMillis());

int insert = imFriendShipMapper.insert(entity1);

if(insert != 1){

// TODO 添加好友失败

return ResponseVO.errorResponse(FriendShipErrorCode.ADD_FRIEND_ERROR);

}

writeUserSeq.writeUserSeq(appId, dto.getToId(), Constants.SeqConstants.Friendship, seq);

}else{

// 存在就判断状态

if(FriendShipStatusEnum.FRIEND_STATUS_NORMAL.getCode() != entity1.getStatus()){

// TODO 对方已经是你的好友

return ResponseVO.errorResponse(FriendShipErrorCode.TO_IS_YOUR_FRIEND);

}else{

ImFriendShipEntity entity2 = new ImFriendShipEntity();

entity2.setFriendSequence(seq);

entity2.setStatus(FriendShipStatusEnum.FRIEND_STATUS_NORMAL.getCode());

imFriendShipMapper.update(entity2, lqw1);

writeUserSeq.writeUserSeq(appId, dto.getToId(), Constants.SeqConstants.Friendship, seq);

}

}

// TODO TCP通知

// A B 添加好友,要把添加好友的信息,发送给除了A其他的端,还要发送给B的所有端

// 发送给from

AddFriendPack addFriendPack = new AddFriendPack();

BeanUtils.copyProperties(entity, addFriendPack);

addFriendPack.setSequence(seq);

if(requestBase != null){

messageProducer.sendToUser(fromId, requestBase.getClientType(), requestBase.getImei(),

FriendshipEventCommand.FRIEND_ADD, addFriendPack, requestBase.getAppId());

}else{

messageProducer.sendToUser(fromId,

FriendshipEventCommand.FRIEND_ADD, addFriendPack, requestBase.getAppId());

}

// 发送给to

AddFriendPack addFriendToPack = new AddFriendPack();

BeanUtils.copyProperties(entity1, addFriendToPack);

messageProducer.sendToUser(entity1.getFromId(), FriendshipEventCommand.FRIEND_ADD, addFriendToPack,

requestBase.getAppId());

// 之后回调

if(appConfig.isDestroyGroupAfterCallback()){

AddFriendAfterCallbackDto addFriendAfterCallbackDto = new AddFriendAfterCallbackDto();

addFriendAfterCallbackDto.setFromId(fromId);

addFriendAfterCallbackDto.setToItem(dto);

callbackService.callback(appId, Constants.CallbackCommand.AddFriendAfter,

JSONObject.toJSONString(addFriendAfterCallbackDto));

}

return ResponseVO.successResponse();

}

后面的seq和回调、TCP通知可以先不看

4、校验好友关系其实远比你想的要复杂

这里的校验好友可以分为两种,一种是单向好友校验,一种是双向好友校验,这里贴出代码

// 校验好友关系

@Override

public ResponseVO checkFriendShip(CheckFriendShipReq req) {

// 双向校验的修改

// 1、先是把req中的所有的toIds都转化为key为属性,value为0的map

Map<String, Integer> result

= req.getToIds().stream().collect(Collectors.toMap(Function.identity(), s-> 0));

List<CheckFriendShipResp> resp = new ArrayList<>();

if(req.getCheckType() == CheckFriendShipTypeEnum.SINGLE.getType()){

resp = imFriendShipMapper.checkFriendShip(req);

}else{

resp = imFriendShipMapper.checkFriendShipBoth(req);

}

// 2、将复杂sql查询出来的数据转换为map

Map<String, Integer> collect = resp.stream()

.collect(Collectors.toMap(CheckFriendShipResp::getToId,

CheckFriendShipResp::getStatus));

// 3、最后比对之前result中和collect是否完全相同,collect中没有的话,就将这个数据封装起来放到resp中去

for (String toId : result.keySet()){

if(!collect.containsKey(toId)){

CheckFriendShipResp checkFriendShipResp = new CheckFriendShipResp();

checkFriendShipResp.setFromId(req.getFromId());

checkFriendShipResp.setToId(toId);

checkFriendShipResp.setStatus(result.get(toId));

resp.add(checkFriendShipResp);

}

}

return ResponseVO.successResponse(resp);

}

这里还要一个点,就是那个result最后和collect 里面的做一下对比,如果我们要校验的用户,不存在于数据库(双向校验在下面出现status=4的情况是,那个用户存在于数据库但是它的status为0),collect就查询不出来,也就要把那个数据也要加到resp中去,此时它的status=0

重要的点就是imFriendShipMapper这里面的两个sql语句

== checkFriendShip(单向校验) ==

@Select("")

public List<CheckFriendShipResp> checkFriendShip(CheckFriendShipReq req);

![]()

也就是我通过fromId和toId只要能查到,就算是校验成功,校验结果再通过if(status = 1, 1, 0) as status 来做判断,最后返回给前面

checkFriendShipBoth(双向校验)

@Select("")

public List<CheckFriendShipResp> checkFriendShipBoth(CheckFriendShipReq req);

![]()

5、添加、删除、校验黑名单业务实现

这里的校验黑名单业务和上面的校验好友业务是差不多的,这里也贴一下代码

// 校验黑名单

@Override

public ResponseVO checkFriendBlack(CheckFriendShipReq req) {

Map<String, Integer> toIdMap

= req.getToIds().stream().collect(Collectors.toMap(Function.identity(),s -> 0));

List<CheckFriendShipResp> resp = new ArrayList<>();

if(req.getCheckType() == CheckFriendShipTypeEnum.SINGLE.getType()){

resp = imFriendShipMapper.checkFriendShipBlack(req);

}else {

resp = imFriendShipMapper.checkFriendShipBlackBoth(req);

}

Map<String, Integer> collect

= resp.stream().collect(Collectors.toMap(CheckFriendShipResp::getToId, CheckFriendShipResp::getStatus));

for (String toId : toIdMap.keySet()) {

if(!collect.containsKey(toId)){

CheckFriendShipResp checkFriendShipResp = new CheckFriendShipResp();

checkFriendShipResp.setToId(toId);

checkFriendShipResp.setFromId(req.getFromId());

checkFriendShipResp.setStatus(toIdMap.get(toId));

resp.add(checkFriendShipResp);

}

}

return ResponseVO.successResponse(resp);

}

checkFriendShipBlack(单向校验)

@Select(""

)

List<CheckFriendShipResp> checkFriendShipBlack(CheckFriendShipReq req);

checkFriendShipBlackBoth(双向校验)

@Select(""

)

List<CheckFriendShipResp> checkFriendShipBlackBoth(CheckFriendShipReq toId);

6、好友申请列表的拉取、新建好友申请、好友申请审批、好友申请列表已读业务实现

这里的新建好友申请是在添加好友的业务中实现的,会根据用户的一个字段,是否需要申请才能加好友,代码如下

![]()

还有审批申请的代码

// 审批好友请求

@Override

@Transactional

public ResponseVO approverFriendRequest(ApproverFriendRequestReq req) {

ImFriendShipRequestEntity imFriendShipRequestEntity = imFriendShipRequestMapper.selectById(req.getId());

if(imFriendShipRequestEntity == null){

throw new ApplicationException(FriendShipErrorCode. FRIEND_REQUEST_IS_NOT_EXIST);

}

if(!req.getOperater().equals(imFriendShipRequestEntity.getToId())){

//只能审批发给自己的好友请求

throw new ApplicationException(FriendShipErrorCode.NOT_APPROVER_OTHER_MAN_REQUEST);

}

long seq = redisSeq.doGetSeq(req.getAppId() + ":" + Constants.SeqConstants.FriendshipRequest);

ImFriendShipRequestEntity update = new ImFriendShipRequestEntity();

// 这里审批是指同意或者拒绝,所以要写活

update.setApproveStatus(req.getStatus());

update.setUpdateTime(System.currentTimeMillis());

update.setId(req.getId());

update.setSequence(seq);

imFriendShipRequestMapper.updateById(update);

writeUserSeq.writeUserSeq(req.getAppId(),req.getOperater(), Constants.SeqConstants.FriendshipRequest,seq);

// 如果是统一的话,就可以直接调用添加好友的逻辑了

if(ApproverFriendRequestStatusEnum.AGREE.getCode() == req.getStatus()){

FriendDto dto = new FriendDto();

dto.setAddSource(imFriendShipRequestEntity.getAddSource());

dto.setAddWorking(imFriendShipRequestEntity.getAddWording());

dto.setRemark(imFriendShipRequestEntity.getRemark());

dto.setToId(imFriendShipRequestEntity.getToId());

ResponseVO responseVO = imFriendShipService.doAddFriend(req

, imFriendShipRequestEntity.getFromId(), dto, req.getAppId());

if(!responseVO.isOk() && responseVO.getCode() != FriendShipErrorCode.TO_IS_YOUR_FRIEND.getCode()){

return responseVO;

}

}

// TODO TCP通知

// 通知审批人的其他端

ApproverFriendRequestPack approverFriendRequestPack = new ApproverFriendRequestPack();

approverFriendRequestPack.setStatus(req.getStatus());

approverFriendRequestPack.setId(req.getId());

approverFriendRequestPack.setSequence(seq);

messageProducer.sendToUser(imFriendShipRequestEntity.getToId(), req.getClientType(), req.getImei(),

FriendshipEventCommand.FRIEND_REQUEST_APPROVER, approverFriendRequestPack, req.getAppId());

return ResponseVO.successResponse();

}

7、好友分组业务介绍和数据库设计

![]()

上图中左面的是微信的,一个用户可以在多个组内,右面的是qq的,一个用户只能在一个分组内,本系统实现的左边的方式,所以要设计一下数据库

![]()

![]()

8、好友分组的创建、获取、添加、删除成员、分组删除业务的实现

这部分主打的就是一个联合,像好友分组创建需要用到添加成员,删除好友分组,也需要清空组内的成员,添加群组成员的时候,也需要获取群组,耦合性很强

![]()

![]()

9、即时通讯最复杂的模块—群组模块业务分析和数据库设计

单聊不能像群聊那样聊的热火朝天的,所以我们要实现群聊

下面是腾讯云

![]()

本系统实现的是这两种群组类型

![]()

![]()

![]()

![]()

![]()

10、导入群和群成员业务实现

这里没啥说的

11、创建群组、修改群信息、获取群信息业务功能实现

复杂、耦合度高

12、获取用户加入的群列表业务功能实现

这里也没啥,就是查询这个group_member就可以找到用户加入的群了

@Select("select group_id from im_group_member where app_id = #{appId} and member_id = #{memberId}")

List<String> getJoinedGroupId(Integer appId, String memberId);

13、解散群组、转让群组的业务功能实现

略

14、拉人入群成员、移出群聊、退出群聊业务功能实现

略

15、获取群组成员信息、修改群组成员信息业务功能实现

略

16、禁言群、禁言群成员业务功能实现

略

三、BIO、NIO和Netty入门

1、BIO、NIO

这个可以看我的另一篇文章 IO线程模型

2、netty

这个东西很大,这里就做一点基础的阐述

官网:Netty is an asynchronous event-driven network application framework

for rapid development of maintainable high performance protocol servers & clients.

Netty是一个异步事件驱动的网络应用程序框架。用于快速开发可维护的高性能协议服务器和客户端。

官网:Netty is an NIO client server framework which enables quick and easy development of network applications such as protocol servers and clients. It greatly simplifies and streamlines network programming such as TCP and UDP socket server.

Netty是一个NIO客户端-服务器框架,可以快速轻松地开发网络应用程序,如协议服务器和客户端。它极大地简化和优化了网络编程,如TCP和UDP套接字服务器。

![]()

什么应用场景下会用到Netty?

- 开发任何网络编程,实现自己的rpc框架

- 能够作为一些公有协议的broker组件,如mqtt、http

- 不少的开源框架及大数据领域间的通信也会使用到netty

四、Netty企业开发必须掌握的技能

1、使用netty实现简单的聊天室

DiscardServerHandler

public class DiscardServerHandler extends ChannelInboundHandlerAdapter {

static Set<Channel> channelList = new HashSet<>();

// 有客户端连接进来就触发

@Override

public void channelActive(ChannelHandlerContext ctx) throws Exception {

// 通知其他人我上线了

channelList.forEach((e)->{

e.writeAndFlush("[客户端]" + ctx.channel().remoteAddress() + "上线了");

});

channelList.add(ctx.channel());

}

// 有读写事件发生的时候触发这个方法

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg) throws Exception {

String message = (String) msg;

System.out.println("收到数据: " + message);

// // 通知分发给聊天室内所有的客户端

// channelList.forEach((e)->{

// if(e == ctx.channel()){

// e.writeAndFlush("[自己]: " + message);

// }else{

// e.writeAndFlush("[客户端]:" + ctx.channel().remoteAddress() + " " + message);

// }

// });

}

/**

* channel 处于不活跃的时候会调用

* @param ctx

* @throws Exception

*/

@Override

public void channelInactive(ChannelHandlerContext ctx) throws Exception {

// 通知其他客户端 我下线了

channelList.remove(ctx.channel());

// 通知其他人我上线了

channelList.forEach((e)->{

e.writeAndFlush("[客户端]" + ctx.channel().remoteAddress() + "下线了");

});

}

}

主要就是写Handler,把复杂的逻辑,用几个API就可以弄好了

DiscardServer

public class DiscardServer {

private int port;

public DiscardServer(int port){

this.port = port;

}

public void run(){

EventLoopGroup bossGroup = new NioEventLoopGroup(1); // 线程池

EventLoopGroup workerGroup = new NioEventLoopGroup();

try {

ServerBootstrap b = new ServerBootstrap(); // (2)

b.group(bossGroup, workerGroup)

.channel(NioServerSocketChannel.class) // (3)

.childHandler(new ChannelInitializer<SocketChannel>() { // (4)

@Override

public void initChannel(SocketChannel ch) throws Exception {

ch.pipeline().addLast(new DiscardServerHandler());

}

})

.option(ChannelOption.SO_BACKLOG, 128) // (5)

.childOption(ChannelOption.SO_KEEPALIVE, true); // (6)

// Bind and start to accept incoming connections.

System.out.println("tcp start success");

ChannelFuture f = b.bind(port).sync(); // (7)

// Wait until the server socket is closed.

// In this example, this does not happen, but you can do that to gracefully

// shut down your server.

f.channel().closeFuture().sync();

} catch (InterruptedException e) {

throw new RuntimeException(e);

} finally {

workerGroup.shutdownGracefully();

bossGroup.shutdownGracefully();

}

}

}

Starter

public class Starter {

public static void main(String[] args) {

new DiscardServer(8001).run();

}

}

2、netty的编解码

网络调试助手——》操作系统——》网路——》对方操作系统——》找到对应的进程(传过去的不是字符串)

这里使用的是网络调试助手

Netty底层只认ByteBuf,我们不能将字符串直接发送给客户端,所以要在Server中加上一些编解码的代码,然后我们在接受消息的时候,就不用自己去解码了,直接就可以用了

![]()

![]()

3、底层数据流转的核心—pipline机制

![]()

public class DiscardServer {

private int port;

public DiscardServer(int port){

this.port = port;

}

public void run(){

EventLoopGroup bossGroup = new NioEventLoopGroup(1); // 线程池

EventLoopGroup workerGroup = new NioEventLoopGroup();

try {

ServerBootstrap b = new ServerBootstrap(); // (2)

b.group(bossGroup, workerGroup)

.channel(NioServerSocketChannel.class) // (3)

.childHandler(new ChannelInitializer<SocketChannel>() { // (4)

@Override

public void initChannel(SocketChannel ch) throws Exception {

Charset gbk = Charset.forName("GBK");

ch.pipeline().addLast("decoder", new StringDecoder(gbk));

ch.pipeline().addLast("encoder", new StringEncoder(gbk));

ch.pipeline().addLast(new DiscardServerHandler());

}

})

.option(ChannelOption.SO_BACKLOG, 128) // (5)

.childOption(ChannelOption.SO_KEEPALIVE, true); // (6)

// Bind and start to accept incoming connections.

System.out.println("tcp start success");

ChannelFuture f = b.bind(port).sync(); // (7)

// Wait until the server socket is closed.

// In this example, this does not happen, but you can do that to gracefully

// shut down your server.

f.channel().closeFuture().sync();

} catch (InterruptedException e) {

throw new RuntimeException(e);

} finally {

workerGroup.shutdownGracefully();

bossGroup.shutdownGracefully();

}

}

}

![]()

里面的这些Handler都要注意位置

4、传输层协议TCP留给我们的难题—Netty解决半包、粘包方

4.1、TCP传输中的问题(半包、黏包)

这里启动好聊天室的程序并启动一个python脚本向服务端循环发送消息

== python ==

import socket

s=socket.socket(socket.AF_INET,socket.SOCK_STREAM)

s.connect(("127.0.0.1",8001))

for i in range(100):

print(i)

string = "hello1哈"

body = bytes(string, 'gbk')

s.sendall(body)

当我们执行这个脚本,就会在服务端的控制台看到信息,我们看到的应该是100条一行一行的hello哈应该才是合理的,但是执行后会发现100条消息都显示在同一行了,第二次有的在同一行,有的各自在一行中

![]()

第一次发送

![]()

第二次发送

产生这个现象的原因就是TCP发送是流式发送的,有的时候发送的一套完整的,有的时候发送的是一段一段的数据,要怎么解决这个问题

4.2、Netty怎么解决半包、黏包

第一种解决方案

可以在server的pipeline中加一些东西,去限制读取的字节数,缺点是可能要考虑数据大小的问题

![]()

第二种解决方案

加这个分割符号,这个的缺点是正经要读取的数据中,不能在出现分割的字符串了

![]()

5、传输层协议TCP留给我们的难题—使用私有协议解决半包、黏包、byteBuf底层API

这里给出用私有协议去解决,也就是比如6123456,第一个6是要读取后面6个数字

![]()

这里先提到ByteBuf的核心API

public class NettyByteBuf {

public static void main(String[] args) {

// 创建byteBuf对象,该对象内部包含一个字节数组byte[10]

ByteBuf byteBuf = Unpooled.buffer(10);

System.out.println("byteBuf=" + byteBuf);

for (int i = 0; i < 8; i++) {

byteBuf.writeByte(i);

}

System.out.println("byteBuf=" + byteBuf);

for (int i = 0; i < 5; i++) {

System.out.println(byteBuf.getByte(i));

}

System.out.println("byteBuf=" + byteBuf);

for (int i = 0; i < 5; i++) {

System.out.println(byteBuf.readByte());

}

System.out.println("byteBuf=" + byteBuf);

System.out.println(byteBuf.readableBytes());

}

}

![]()

从上面控制台的结果不难看出,ridx的意思是已经读取到哪里了,widx已经占用了多少了,cap是一共的容量有多少

![]()

ridx也就是读索引,widx是写索引

| 常用API | 作用 |

|---|---|

| Unpooled.buffer(10) | 创建一个字节数组[10] |

| byteBuf.writeByte(i) | 往byteBuf中写入i |

| byteBuf.getByte(i) | 获取btyeBuf中第i个字节,读索引不动 |

| byteBuf.readByte() | 从开头开始读字节,读索引自动的向后移动 |

| byteBuf.readableBytes() | 获取到byteBuf中还没有读取到的字节 |

| byteBuf.markReaderIndex() | 记录读索引的位置 |

| byteBuf.resetReaderIndex() | 返回记录的读索引的位置 |

// 继承了这个类就可以去 自定义协议了

public class MyDecodecer extends ByteToMessageDecoder {

// 数据长度 + 数据

@Override

protected void decode(ChannelHandlerContext channelHandlerContext, ByteBuf byteBuf, List<Object> list) throws Exception {

// 一个int是4字节,可读长度要大于4才可以继续执行

if(byteBuf.readableBytes() < 4){

return;

}

// 数据长度

int i = byteBuf.readInt();

if(byteBuf.readableBytes() < i){

byteBuf.resetReaderIndex();

return;

}

// 开辟一个byte数组去接收数据

byte[] data = new byte[i];

byteBuf.readBytes(data);

System.out.println(new String(data));

byteBuf.markReaderIndex();

}

}

所以就可以自定义一个私有协议,按照你的规则去读取数据,记得把这个放到pipeline里面哦!

![]()

这样就可以解决半包和黏包问题了

6、IdleStateHandler心跳机制源码详解

可以先了解一下短连接和长连接 HTTP长连接和短连接

public class HeartbeatHandler extends ChannelInboundHandlerAdapter {

int readTimeout = 0;

@Override

public void userEventTriggered(ChannelHandlerContext ctx, Object evt) throws Exception {

// // IdleStateEven 超时类型

IdleStateEvent event = (IdleStateEvent) evt;

// ALL_IDLE : 一段时间内没有数据接收或者发送

// READER_IDLE : 一段时间内没有数据接收

// WRITER_IDLE : 一段时间内没有数据发送

if(event.state() == IdleState.READER_IDLE){

readTimeout++;

}

if(readTimeout >= 3){

System.out.println("超时超过3次,断开连接");

ctx.close();

}

System.out.println("触发了:" + event.state() + "事件");

}

}

![]()

这个实现的效果就是读超时3秒就会触发一次心跳检测,逻辑是超过三次就会断开连接

7、使用Netty实现文件上下传

==UploadFileDecodecer ==

public class UploadFileDecodecer extends ByteToMessageDecoder {

// 数据长度 + 数据

@Override

protected void decode(ChannelHandlerContext channelHandlerContext, ByteBuf byteBuf, List<Object> list) throws Exception {

// 一个int是4字节,可读长度要大于4才可以继续执行

if(byteBuf.readableBytes() < 8){

return;

}

// 数据长度

int command = byteBuf.readInt();

FileDto fileDto = new FileDto();

fileDto.setCommand(command);

// 文件名长度

int fileNameLen = byteBuf.readInt();

if(byteBuf.readableBytes() < fileNameLen){

byteBuf.resetReaderIndex();

return;

}

// 开辟一个byte数组去接收数据

byte[] data = new byte[fileNameLen];

byteBuf.readBytes(data);

String fileName = new String(data);

fileDto.setFileName(fileName);

if(command == 2){

int dataLen = byteBuf.readInt();

if(byteBuf.readableBytes() < dataLen){

byteBuf.resetReaderIndex();

return;

}

byte[] fileData = new byte[dataLen];

byteBuf.readBytes(fileData);

fileDto.setBytes(fileData);

}

byteBuf.markReaderIndex();

list.add(fileDto);

}

}

把这部分放到pipeline中放到UploadFileHandler前面,这里面通过自定义的协议解析出,文件的命令和文件名,文件的具体数据,然后封装到FileDto中,最后放到pipeline中,后面使用即可

UploadFileHandler

public class UploadFileHandler extends ChannelInboundHandlerAdapter {

// 有客户端连接进来就触发

@Override

public void channelActive(ChannelHandlerContext ctx) throws Exception {

}

// 有读写事件发生的时候触发这个方法

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg) throws Exception {

if(msg instanceof FileDto){

FileDto fileDto = (FileDto) msg;

if(fileDto.getCommand() == 1){

// 创建文件

File file = new File("E://" + fileDto.getFileName());

if(!file.exists()){

file.createNewFile();

}

}else if(fileDto.getCommand() == 2){

// 写入文件

save2File("E://" + fileDto.getFileName(), fileDto.getBytes());

}

}

}

public static boolean save2File(String fname, byte[] msg){

OutputStream fos = null;

try{

File file = new File(fname);

File parent = file.getParentFile();

boolean bool;

if ((!parent.exists()) &

(!parent.mkdirs())) {

return false;

}

fos = new FileOutputStream(file,true);

fos.write(msg);

fos.flush();

return true;

}catch (FileNotFoundException e){

return false;

}catch (IOException e){

File parent;

return false;

}

finally{

if (fos != null) {

try{

fos.close();

}catch (IOException e) {}

}

}

}

}

这里用到从解码的地方拿到的FileDto中,没有就创建,有就写

![]()

可以使用下面的python脚本测试

#-*- coding: UTF-8 -*-

import socket,os,struct

s=socket.socket(socket.AF_INET,socket.SOCK_STREAM)

s.connect(("127.0.0.1",8001))

filepath = "D://txt.txt"

if os.path.isfile(filepath):

filename = os.path.basename(filepath).encode('utf-8')

# 请求传输文件

command = 1

body_len = len(filename)

fileNameData = bytes(filename)

i = body_len.to_bytes(4, byteorder='big')

c = command.to_bytes(4, byteorder='big')

s.sendall(c + i + fileNameData)

fo = open(filepath,'rb')

while True:

command = 2;

c = command.to_bytes(4, byteorder='big')

filedata = fo.read(1024)

print(len(filedata))

b = len(filedata).to_bytes(4, byteorder='big')

if not filedata:

break

s.sendall(c + i + fileNameData + b + filedata)

fo.close()

#s.close()

else:

print(False)

五、IM开发核心之构建TCP网关(上)

1、编写LimServer

==LimServer ==

public class LimServer {

// 日志类

private final static Logger logger = LoggerFactory.getLogger(LimServer.class);

// 端口号

private int port;

// 端口号和两个Group的值都是从配置文件中取出来的

EventLoopGroup mainGroup;

EventLoopGroup subGroup;

ServerBootstrap server;

public LimServer(Integer port){

this.port = port;

// 两个Group

mainGroup = new NioEventLoopGroup();

subGroup = new NioEventLoopGroup();

// server

server = new ServerBootstrap();

server.group(mainGroup, subGroup)

.channel(NioServerSocketChannel.class)

// 服务端可连接队列大小

.option(ChannelOption.SO_BACKLOG, 10240)

// 参数表示允许重复使用本地地址和端口

.option(ChannelOption.SO_REUSEADDR, true)

// 是否禁用Nagle算法 简单点说是否批量发送数据 true关闭 false开启。 开启的话可以减少一定的网络开销,但影响消息实时性

.childOption(ChannelOption.TCP_NODELAY, true)

// 保活开关2h没有数据服务端会发送心跳包

.childOption(ChannelOption.SO_KEEPALIVE, true)

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) throws Exception {

}

});

}

server.bind(port);

}

Starter

public class Starter {

public static void main(String[] args) throws FileNotFoundException {

new LimServer(9000);

}

}

简单编写完这两部分后,用网络调试助手连接一下本机的9000端口,没有报错就是连接成功了

2、编写LimWebSocketServer

LimWebSocketServer

public class LimWebSocketServer {

private final static Logger logger = LoggerFactory.getLogger(LimWebSocketServer.class);

int port;

EventLoopGroup mainGroup;

EventLoopGroup subGroup;

ServerBootstrap server;

public LimWebSocketServer(int port) {

this.port= port;

mainGroup = new NioEventLoopGroup();

subGroup = new NioEventLoopGroup();

server = new ServerBootstrap();

server.group(mainGroup, subGroup)

.channel(NioServerSocketChannel.class)

.option(ChannelOption.SO_BACKLOG, 10240) // 服务端可连接队列大小

.option(ChannelOption.SO_REUSEADDR, true) // 参数表示允许重复使用本地地址和端口

.childOption(ChannelOption.TCP_NODELAY, true) // 是否禁用Nagle算法 简单点说是否批量发送数据 true关闭 false开启。 开启的话可以减少一定的网络开销,但影响消息实时性

.childOption(ChannelOption.SO_KEEPALIVE, true) // 保活开关2h没有数据服务端会发送心跳包

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) throws Exception {

ChannelPipeline pipeline = ch.pipeline();

// websocket 基于http协议,所以要有http编解码器

pipeline.addLast("http-codec", new HttpServerCodec());

// 对写大数据流的支持

pipeline.addLast("http-chunked", new ChunkedWriteHandler());

// 几乎在netty中的编程,都会使用到此hanler

pipeline.addLast("aggregator", new HttpObjectAggregator(65535));

/**

* websocket 服务器处理的协议,用于指定给客户端连接访问的路由 : /ws

* 本handler会帮你处理一些繁重的复杂的事

* 会帮你处理握手动作: handshaking(close, ping, pong) ping + pong = 心跳

* 对于websocket来讲,都是以frames进行传输的,不同的数据类型对应的frames也不同

*/

pipeline.addLast(new WebSocketServerProtocolHandler("/ws"));

}

});

}

server.bind(port);

logger.info("web start");

}

Starter

public class Starter {

public static void main(String[] args) throws FileNotFoundException {

new LimServer(9000);

new LimWebSocketServer(19000);

}

}

然后在启动,使用web.html验证

3、使用snakeyaml动态配置文件

<dependency>

<groupId>org.yamlgroupId>

<artifactId>snakeyamlartifactId>

dependency>

@Data

public class BootstrapConfig {

private TcpConfig lim;

@Data

public static class TcpConfig{

// tcp 绑定的端口号

private Integer tcpPort;

// webSocket 绑定的端口号

private Integer webSocketPort;

// boss线程 默认=1

private Integer bossThreadSize;

//work线程

private Integer workThreadSize;

// 心跳超时时间 单位ms

private Long heartBeatTime;

// 登录模式

private Integer loginModel;

// redis配置文件

private RedisConfig redis;

/**

* rabbitmq配置

*/

private Rabbitmq rabbitmq;

/**

* zk配置

*/

private ZkConfig zkConfig;

/**

* brokerId

*/

private Integer brokerId;

private String logicUrl;

}

}

将需要的配置文件中的数据做一个实体类,用于后面的接,收然后改造一下

LimServer

public class LimServer {

// 日志类

private final static Logger logger = LoggerFactory.getLogger(LimServer.class);

// 端口号

private int port;

// 端口号和两个Group的值都是从配置文件中取出来的

BootstrapConfig.TcpConfig config;

EventLoopGroup mainGroup;

EventLoopGroup subGroup;

ServerBootstrap server;

public LimServer(BootstrapConfig.TcpConfig config){

this.config = config;

// 两个Group

mainGroup = new NioEventLoopGroup(config.getBossThreadSize());

subGroup = new NioEventLoopGroup(config.getWorkThreadSize());

// server

server = new ServerBootstrap();

server.group(mainGroup, subGroup)

.channel(NioServerSocketChannel.class)

// 服务端可连接队列大小

.option(ChannelOption.SO_BACKLOG, 10240)

// 参数表示允许重复使用本地地址和端口

.option(ChannelOption.SO_REUSEADDR, true)

// 是否禁用Nagle算法 简单点说是否批量发送数据 true关闭 false开启。 开启的话可以减少一定的网络开销,但影响消息实时性

.childOption(ChannelOption.TCP_NODELAY, true)

// 保活开关2h没有数据服务端会发送心跳包

.childOption(ChannelOption.SO_KEEPALIVE, true)

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) throws Exception {

}

});

}

public void start(){

this.server.bind(config.getTcpPort());

}

}

LimWebSocket

public class LimWebSocketServer {

private final static Logger logger = LoggerFactory.getLogger(LimWebSocketServer.class);

BootstrapConfig.TcpConfig config;

EventLoopGroup mainGroup;

EventLoopGroup subGroup;

ServerBootstrap server;

public LimWebSocketServer(BootstrapConfig.TcpConfig config) {

this.config = config;

mainGroup = new NioEventLoopGroup();

subGroup = new NioEventLoopGroup();

server = new ServerBootstrap();

server.group(mainGroup, subGroup)

.channel(NioServerSocketChannel.class)

.option(ChannelOption.SO_BACKLOG, 10240) // 服务端可连接队列大小

.option(ChannelOption.SO_REUSEADDR, true) // 参数表示允许重复使用本地地址和端口

.childOption(ChannelOption.TCP_NODELAY, true) // 是否禁用Nagle算法 简单点说是否批量发送数据 true关闭 false开启。 开启的话可以减少一定的网络开销,但影响消息实时性

.childOption(ChannelOption.SO_KEEPALIVE, true) // 保活开关2h没有数据服务端会发送心跳包

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) throws Exception {

ChannelPipeline pipeline = ch.pipeline();

// websocket 基于http协议,所以要有http编解码器

pipeline.addLast("http-codec", new HttpServerCodec());

// 对写大数据流的支持

pipeline.addLast("http-chunked", new ChunkedWriteHandler());

// 几乎在netty中的编程,都会使用到此hanler

pipeline.addLast("aggregator", new HttpObjectAggregator(65535));

/**

* websocket 服务器处理的协议,用于指定给客户端连接访问的路由 : /ws

* 本handler会帮你处理一些繁重的复杂的事

* 会帮你处理握手动作: handshaking(close, ping, pong) ping + pong = 心跳

* 对于websocket来讲,都是以frames进行传输的,不同的数据类型对应的frames也不同

*/

pipeline.addLast(new WebSocketServerProtocolHandler("/ws"));

}

});

}

public void start(){

this.server.bind(this.config.getWebSocketPort());

}

}

lim:

tcpPort: 9000

webSocketPort: 19000

bossThreadSize: 1

workThreadSize: 8

heartBeatTime: 3000 # 心跳超时时间,单位 ms

brokerId: 1000

loginModel: 3

logicUrl: http://127.0.0.1:8000/v1

这两个将端口号和两个Group的大小都使用了配置文件动态配置

Starter

public class Starter {

public static void main(String[] args) throws FileNotFoundException {

if(args.length > 0){

start(args[0]);

}

}

private static void start(String path) throws FileNotFoundException {

try {

// 加载yml文件

Yaml yaml = new Yaml();

InputStream fileInputStream = new FileInputStream(path);

// 搞一个实体

BootstrapConfig bootstrapConfig = yaml.loadAs(fileInputStream, BootstrapConfig.class);

// 启动

new LimServer(bootstrapConfig.getLim()).start();

new LimWebSocketServer(bootstrapConfig.getLim()).start();

} catch (Exception e) {

e.printStackTrace();

System.exit(500);

}

}

}

![IM即时通讯系统[SpringBoot+Netty]——梳理(总)_第2张图片](http://img.e-com-net.com/image/info8/61a7d1c03a384bfeaa30152c796419cb.jpg)

这样所以的配置文件,就可以通过修改yaml文件,然后对BootstrapConfig实体类修改,最后在Starter中配置一下即可

4、大白话讲通信协议—详解主流通讯协议

4.1、文本协议

- 贴近人类书面表达的协议,如http协议

- 特点:

- 可读性好,便于调试

- 扩展性也好(通过key:value扩展)

- 解析效率一般

4.2、二进制协议

- 一段的传输内容里面,其中的固定的一位或者几位表示固定的意思(就和我们上面netty中解决半包、黏包用的私有协议差不多),如ip协议

- 特点:

- 可读性差,难于调试

- 扩展性不好(设计的好可以规避)

- 解析效率高

4.3、xml协议

- 特点

- 标准协议,可以跨域互通

- xml的优点,可读性好,扩展性好

- 解析代价高

- 有效数据传输率低(有大量的标签)

4.4、可以落地使用的协议

xmpp协议

- 优点:基于xml协议,容易理解,使用广泛,易于扩展

- 缺点:流量大,在移动端很耗电,交互过程复杂

mqtt协议

- 优点:适配多平台,相比xmpp,数据包更小

- 缺点:协议简单,公有协议无法自定义一些数据格式

私有协议(基于二进制协议)

- 优点:随心所欲,定制化较强,流量小

- 缺点:工作量巨大,扩展性差,需要考虑全面

5、私有协议编解码—设计篇

6、私有协议编解码—实现篇

6.1、LimServer的编解码器

ByteBufToMessageUtils

public class ByteBufToMessageUtils {

public static Message transition(ByteBuf in){

/** 获取command*/

int command = in.readInt();

/** 获取version*/

int version = in.readInt();

/** 获取clientType*/

int clientType = in.readInt();

/** 获取messageType*/

int messageType = in.readInt();

/** 获取appId*/

int appId = in.readInt();

/** 获取imeiLength*/

int imeiLength = in.readInt();

/** 获取bodyLen*/

int bodyLen = in.readInt();

if(in.readableBytes() < bodyLen + imeiLength){

in.resetReaderIndex();

return null;

}

byte [] imeiData = new byte[imeiLength];

in.readBytes(imeiData);

String imei = new String(imeiData);

byte [] bodyData = new byte[bodyLen];

in.readBytes(bodyData);

MessageHeader messageHeader = new MessageHeader();

messageHeader.setAppId(appId);

messageHeader.setClientType(clientType);

messageHeader.setCommand(command);

messageHeader.setLength(bodyLen);

messageHeader.setVersion(version);

messageHeader.setMessageType(messageType);

messageHeader.setImei(imei);

Message message = new Message();

message.setMessageHeader(messageHeader);

if(messageType == 0x0){

String body = new String(bodyData);

JSONObject parse = (JSONObject) JSONObject.parse(body);

message.setMessagePack(parse);

}

in.markReaderIndex();

return message;

}

}

MessageDecoder(解码)

public class MessageDecoder extends ByteToMessageDecoder {

@Override

protected void decode(ChannelHandlerContext ctx,

ByteBuf in, List<Object> out) throws Exception {

//请求头(指令

// 版本

// clientType

// 消息解析类型

// appId

// imei长度

// bodylen)+ imei号 + 请求体

if(in.readableBytes() < 28){

return;

}

Message message = ByteBufToMessageUtils.transition(in);

if(message == null){

return;

}

out.add(message);

}

}

MessageEncoder(编码)

public class MessageEncoder extends MessageToByteEncoder {

@Override

protected void encode(ChannelHandlerContext ctx, Object msg, ByteBuf out) throws Exception {

if(msg instanceof MessagePack){

MessagePack msgBody = (MessagePack) msg;

String s = JSONObject.toJSONString(msgBody.getData());

byte[] bytes = s.getBytes();

out.writeInt(msgBody.getCommand());

out.writeInt(bytes.length);

out.writeBytes(bytes);

}

}

}

接受消息的实体类

@Data

public class Message {

// 请求头

private MessageHeader messageHeader;

// 请求体

private Object messagePack;

@Override

public String toString() {

return "Message{" +

"messageHeader=" + messageHeader +

", messagePack=" + messagePack +

'}';

}

}

@Data

public class MessageHeader {

//消息操作指令 十六进制 一个消息的开始通常以0x开头

//4字节

private Integer command;

//4字节 版本号

private Integer version;

//4字节 端类型

private Integer clientType;

/**

* 应用ID

*/

// 4字节 appId

private Integer appId;

/**

* 数据解析类型 和具体业务无关,后续根据解析类型解析data数据 0x0:Json,0x1:ProtoBuf,0x2:Xml,默认:0x0

*/

//4字节 解析类型

private Integer messageType = 0x0;

//4字节 imel长度

private Integer imeiLength;

//4字节 包体长度

private int length;

//imei号

private String imei;

}

@Data

public class MessagePack<T> implements Serializable {

private String userId;

private Integer appId;

/**

* 接收方

*/

private String toId;

/**

* 客户端标识

*/

private int clientType;

/**

* 消息ID

*/

private String messageId;

/**

* 客户端设备唯一标识

*/

private String imei;

private Integer command;

/**

* 业务数据对象,如果是聊天消息则不需要解析直接透传

*/

private T data;

// /** 用户签名*/

// private String userSign;

}

加到这里面

6.2、LimWebSocketServer的编解码器

WebSocketMessageDecoder

public class WebSocketMessageDecoder extends MessageToMessageDecoder<BinaryWebSocketFrame> {

@Override

protected void decode(ChannelHandlerContext ctx, BinaryWebSocketFrame msg, List<Object> out) throws Exception {

ByteBuf content = msg.content();

if (content.readableBytes() < 28) {

return;

}

Message message = ByteBufToMessageUtils.transition(content);

if(message == null){

return;

}

out.add(message);

}

}

WebSocketMessageEncoder

public class WebSocketMessageEncoder extends MessageToMessageEncoder<MessagePack> {

private static Logger log = LoggerFactory.getLogger(WebSocketMessageEncoder.class);

@Override

protected void encode(ChannelHandlerContext ctx, MessagePack msg, List<Object> out) {

try {

String s = JSONObject.toJSONString(msg);

ByteBuf byteBuf = Unpooled.directBuffer(8+s.length());

byte[] bytes = s.getBytes();

byteBuf.writeInt(msg.getCommand());

byteBuf.writeInt(bytes.length);

byteBuf.writeBytes(bytes);

out.add(new BinaryWebSocketFrame(byteBuf));

}catch (Exception e){

e.printStackTrace();

}

}

}

加到这里面

这样一来,我们为LImServer和LImWebSocketServer提供了编解码器,这样我们的客户端只要按照我们的协议发送数据,我们就会拿到争取的数据,我们也可以将信息进行编码,发送给客户端,客户端也要遵守我们的编码规则,也就可以正常的拿到服务端发送给客户端的数据

六、IM开发核心之建构TCP网关(下)

1、登录消息—保存用户NioSocketChannel

这里也就是创建了一个Handler然后通过解析message中的command的命令,对应做出登录的逻辑,通过将每个用户登录进来的channel保存起来,维护每一个channel

2、分布式缓存中间件—Redisson快速入门操作

Redisson操作快速入门

3、用户登录网关层—保存用户Session

先考虑用什么Redis的数据结构,因为这个应用那个会支出多端登录,所以使用HashMap的数据结构,就可以使用一个key来存储多个端的session,这样比String类型更好

这里使用的是Redisson,所以要搞一些配置属性,修改BootStrap和Yaml文件,然后再创建Redis的管理类,最后将配置好的Redis放在Starter中去启动,在Handler中将设置好的UserSession保存到map中去。

4、用户退出网关层—离线删除用户Session

逻辑

- 先删除掉Channel

- 再删除掉Redis中存储的session

5、服务端心跳检测

和上面那个netty入门时候说的心跳检测差不多,没有读操作或者写操作,或者全操作就会触发userEventTriggered,然后进行一些你规定好的操作,这里我们实现的就是没有操作的每10秒触发一次心跳检测,检测你上次ping的时间和当前时间,如果超过了你规定的超时时间,就认为该用户已经离线了,触发离线逻辑

// 离线

public static void offLineUserSession(NioSocketChannel channel){

// 删除session

String userId = (String) channel.attr(AttributeKey.valueOf(Constants.UserId)).get();

Integer appId = (Integer) channel.attr(AttributeKey.valueOf(Constants.AppId)).get();

Integer clientType = (Integer) channel.attr(AttributeKey.valueOf(Constants.ClientType)).get();

String imei = (String) channel

.attr(AttributeKey.valueOf(Constants.Imei)).get();

SessionScoketHolder.remove(appId, userId, clientType, imei);

// 修改redis中的session的ConnectState

RedissonClient redissonClient = RedisManager.getRedissonClient();

RMap<String, String> map

= redissonClient.getMap(appId + Constants.RedisConstants.UserSessionConstants + userId);

// 获取session

String sessionStr = map.get(clientType.toString() + ":" + imei);

if(!StringUtils.isBlank(sessionStr)){

// 将session转换为对象

UserSession userSession = JSONObject.parseObject(sessionStr, UserSession.class);

// 修改连接状态为离线

userSession.setConnectState(ImConnectStatusEnum.OFFLINE_STATUS.getCode());

// 再写入redis中

map.put(clientType.toString() + ":" + imei, JSONObject.toJSONString(userSession));

}

}

触发离线逻辑,和上面那个登出的区别就是修改Redis中的session状态变成离线,那个是直接删除了

6、RabbitMQ的安装、发布订阅、路由模式详解

安装教程

如果自己有腾讯云、阿里云的虚拟的话,可以直接搞一个docker的RabbitMQ,这样更加方便,教程啥的网上搜一下就好

快速入门

7、TCP接入RabbitMQ、打通和逻辑层的交互

实现一个Mq的工具类

public class MqFactory {

// ConnectionFactory

private static ConnectionFactory factory = null;

// 这里一个存放channel的map

private static ConcurrentHashMap<String, Channel> channelMap = new ConcurrentHashMap<>();

public static void init(BootstrapConfig.Rabbitmq rabbitmq){

// 如果连接为空才进行初始化

if(factory == null){

factory = new ConnectionFactory();

factory.setHost(rabbitmq.getHost());

factory.setUsername(rabbitmq.getUserName());

factory.setPassword(rabbitmq.getPassword());

factory.setPort(rabbitmq.getPort());

factory.setVirtualHost(rabbitmq.getVirtualHost());

}

}

// 通过channel名字来获取不同的channel

public static Channel getChannel(String channelName) throws IOException, TimeoutException {

Channel channel = channelMap.get(channelName);

if(channel == null){

channel = getConnection().createChannel();

channelMap.put(channelName, channel);

}

return channel;

}

// 获取connection

private static Connection getConnection() throws IOException, TimeoutException {

Connection connection = factory.newConnection();

return connection;

}

}

创建一个MqReciver类

@Slf4j

public class MessageReciver {

private static String brokerId;

public static void startReciverMessage() {

try {

Channel channel = MqFactory.getChannel(Constants.RabbitConstants.MessageService2Im

+ brokerId);

// 绑定队列

channel.queueDeclare(Constants.RabbitConstants.MessageService2Im + brokerId,

true,false, false, null);

// 绑定交换机

channel.queueBind(Constants.RabbitConstants.MessageService2Im + brokerId,

Constants.RabbitConstants.MessageService2Im,

brokerId);

channel.basicConsume(Constants.RabbitConstants.MessageService2Im + brokerId, false

, new DefaultConsumer(channel){

// 获取到rabbitmq中的信息

@Override

public void handleDelivery(String consumerTag, Envelope envelope,

AMQP.BasicProperties properties, byte[] body) throws IOException {

try {

String msgStr = new String(body);

log.info(msgStr);

}

}

});

} catch (Exception e) {

throw new RuntimeException(e);

}

}

}

![IM即时通讯系统[SpringBoot+Netty]——梳理(总)_第16张图片](http://img.e-com-net.com/image/info8/bb59e38b045a430f8246acd3f3ef4336.jpg)

这样的话就TCP就可以从RabiitMq中获取到消息了,这样的话,只要逻辑层往对应的交换机中投递消息,TCP就可以收到了,也就是打通了和逻辑层的交互

8、分布式TCP服务注册中心的选型

如果要接入多个服务,单台机器肯定是撑不住这么大的并发的,要考虑分布式,这就不得不考虑服务发现的问题,所以要引入服务注册来解决这个问题

现在的开发,都会把服务做拆分,就会引出网关和逻辑服务直接发现的问题,这里有一种土办法,把服务的ip地址配置在网关中,A服务有这几个ip,B服务有这几个ip,如果采用这种方案,我们在增加或者删除一台服务器的时候,所有的网关服务都要手动的去修改配置,去重启,这样不太长久,不现实

如果是http服务器,我们可以通过反向代理,把请求转发给可用的服务,但是这个方案在即时通讯系统中是行不通的,因为它是有状态服务,和普通的http服务不一样,有状态服务会保留用户活跃的信息,比如我们客户和A服务器建立了连接Channel,用户的信息保存在了A服务器里面,可以互通数据,当我们用B服务器,用户和B服务器之间没有交互数据的,我们拿不到Channel里面的信息

CAP理论

- 一致性

- 可用性

- 分区容错性

主流注册中心

- Eureka:SpringCloud配套的,但是已经停止维护了,最好不要用

- Consul:轻量级的注册中心,但是Java领域覆盖面不是很广

- Kubernetes:配套使用K8S较好

- Nacos:是首选的注册中心,它既可以支持AP、也可以支持CP

- Zookeeper:临时节点和watch机制,创建连接会生成节点,节点发生改变会通知,感知力强

本系统采取Zookeeper作为注册中心

9、TCP服务注册—Zookeeper注册TCP服务

安装教程

ZKit

/**

* @author li

* 直接用来创建Zookeeper目录的

* @data 2023/4/19

* @time 14:37

*/

public class ZKit {

private ZkClient zkClient;

public ZKit(ZkClient client){

this.zkClient = client;

}

// im-coreRoot/tcp/ip:port

public void createRootNode(){

boolean exists = zkClient.exists(Constants.ImCoreZkRoot);

if(!exists){

zkClient.createPersistent(Constants.ImCoreZkRoot);

}

boolean tcpExists = zkClient.exists(Constants.ImCoreZkRoot +

Constants.ImCoreZkRootTcp);

if(!tcpExists){

zkClient.createPersistent(Constants.ImCoreZkRoot +

Constants.ImCoreZkRootTcp);

}

boolean webExists = zkClient.exists(Constants.ImCoreZkRoot +

Constants.ImCoreZkRootWeb);

if(!webExists){

zkClient.createPersistent(Constants.ImCoreZkRoot +

Constants.ImCoreZkRootWeb);

}

}

// ip:port

public void createNode(String path){

if(!zkClient.exists(path)){

zkClient.createPersistent(path);

}

}

}

RegistryZk

@Slf4j

public class RegistryZk implements Runnable{

private ZKit zKit;

private String ip;

private BootstrapConfig.TcpConfig tcpConfig;

public RegistryZk(ZKit zKit, String ip, BootstrapConfig.TcpConfig tcpConfig) {

this.zKit = zKit;

this.ip = ip;

this.tcpConfig = tcpConfig;

}

@Override

public void run() {

// 注册Zookeeper

// 先注册1级目录

zKit.createRootNode();

// 再注册2级目录

String tcpPath = Constants.ImCoreZkRoot + Constants.ImCoreZkRootTcp

+ "/" + ip + ":" + this.tcpConfig.getTcpPort();

zKit.createNode(tcpPath);

log.info("Registry zookeeper tcpPath success, msg=[{}]", tcpPath);

String webPath = Constants.ImCoreZkRoot + Constants.ImCoreZkRootWeb

+ "/" + ip + ":" + this.tcpConfig.getWebSocketPort();

zKit.createNode(webPath);

log.info("Registry zookeeper webPath success, msg=[{}]", webPath);

}

}

Starter

这样在我们启动这个Starter这个服务的时候,连接Zookeeper的客户端就可以查看到你创建的目录了

10、服务改造-TCP服务分布式改造

因为我们要实现的即时通讯系统是有状态的服务,所以我们要考虑的更多

比如每个netty1都维护着对应的用户,netty1维护着u1、u10、u100,netty2维护者u2、u20、u200,当我们u1向u2发送一条消息的时候,netty1中并没有连接netty2的Channel,消息就会丢失,这样目前还是不妥的,所以我们要加以改造

这里提供集中解决方法

10.1、 广播模式

![IM即时通讯系统[SpringBoot+Netty]——梳理(总)_第20张图片](http://img.e-com-net.com/image/info8/c53de80cd2774ccea97e330fe86d6f01.jpg)

这样实现起来很简单,可以使用RabiitMq,但是容易产生消息风暴,如果要发送100个消息,这样就会变成200个,造成一些浪费、无效的通讯

10.2、 一致性Hash

![IM即时通讯系统[SpringBoot+Netty]——梳理(总)_第21张图片](http://img.e-com-net.com/image/info8/088cbd3de0244742b41cf098416b96b9.jpg)

这种方式的实现方式是,u1这个用户根据一些id等的属性,会在注册的时候去做一个hash运算,直接就给他注册到算好的netty上,比如是u1,根据这个1算出它在netty1上,u2根据2算出它在netty2上,当u1要给u2发消息的时候,就会根据u2计算出u2在哪个netty2中,点对点的给他发送过去,不用发那么多份,但是缺点也很明显,重度的依赖服务的发现的稳定性,要及时的感知到netty2是否存在,netty2下线的时候要及时的通知

10.3、 构建路由层

通过构建路由层,比如说把注册的用户和对应的netty服务ip存储到里面,当u1给u2消息的时候,就会在路由层去寻找,然后发送,可靠性比较高,并且可以用mq解耦,路由层是无状态的可以水平拓展,可以扩展多个,缺点是很复杂,多了一层东西就多了代码,多了一些组件,并且需要独立维护路由层,也会依赖路由层的依赖性和可靠性

11、即时通讯系统支持多端登录模式—应对多端登录的场景

做好一些配置的东西

多端登录在有状态的分布式下,推荐使用广播(或者一致性hash)的模式,因为你不知道某个用户到底在几个端登录,这样是最容易的方法了。

UserLoginMessageListener

public class UserLoginMessageListener {

private final static Logger logger = LoggerFactory.getLogger(UserLoginMessageListener.class);

private Integer loginModel;

public UserLoginMessageListener(Integer loginModel){

this.loginModel = loginModel;

}

// 监听用户登录

public void listenerUserLogin(){

RTopic topic = RedisManager.getRedissonClient().getTopic(Constants.RedisConstants.UserLoginChannel);

// 使用Redisson的订阅模式做 监听 当有用户的某个端登录就会

topic.addListener(String.class, new MessageListener<String>() {

@Override

public void onMessage(CharSequence charSequence, String message) {

logger.info("收到用户上线:" + message);

UserClientDto userClientDto = JSONObject.parseObject(message, UserClientDto.class);

// 获取所有的CHANNELS

List<NioSocketChannel> nioSocketChannels

= SessionScoketHolder.get(userClientDto.getAppId(), userClientDto.getUserId());

for (NioSocketChannel nioSocketChannel : nioSocketChannels) {

// 单端登录

if(loginModel == DeviceMultiLoginEnum.ONE.getLoginMode()){

// 获取clietType

Integer clientType = (Integer) nioSocketChannel.attr(AttributeKey.valueOf(Constants.ClientType)).get();

// 获取imei号

String imei = (String)nioSocketChannel.attr(AttributeKey.valueOf(Constants.Imei)).get();

if(!(clientType + ":" + imei).equals(userClientDto.getClientType() + ":" + userClientDto.getImei())){

// TODO 踢掉客户端

// 告诉客户端 其他端登录

MessagePack<Object> messagePack = new MessagePack<>();

messagePack.setToId((String) nioSocketChannel.attr(AttributeKey.valueOf(Constants.UserId)).get());

messagePack.setUserId((String) nioSocketChannel.attr(AttributeKey.valueOf(Constants.UserId)).get());

messagePack.setCommand(SystemCommand.MUTUALLOGIN.getCommand());

nioSocketChannel.writeAndFlush(messagePack);

}

}else if(loginModel == DeviceMultiLoginEnum.TWO.getLoginMode()){

if(userClientDto.getClientType() == ClientType.WEB.getCode()){

continue;

}

Integer clientType = (Integer) nioSocketChannel.attr(AttributeKey.valueOf(Constants.ClientType)).get();

if(clientType == ClientType.WEB.getCode()){

continue;

}

// 获取imei号

String imei = (String)nioSocketChannel.attr(AttributeKey.valueOf(Constants.Imei)).get();

if(!(clientType + ":" + imei).equals(userClientDto.getClientType() + ":" + userClientDto.getImei())){

// TODO 踢掉客户端

MessagePack<Object> messagePack = new MessagePack<>();

messagePack.setToId((String) nioSocketChannel.attr(AttributeKey.valueOf(Constants.UserId)).get());

messagePack.setUserId((String) nioSocketChannel.attr(AttributeKey.valueOf(Constants.UserId)).get());

messagePack.setCommand(SystemCommand.MUTUALLOGIN.getCommand());

nioSocketChannel.writeAndFlush(messagePack);

}

}else if(loginModel == DeviceMultiLoginEnum.THREE.getLoginMode()){

Integer clientType = (Integer) nioSocketChannel.attr(AttributeKey.valueOf(Constants.ClientType)).get();

String imei = (String)nioSocketChannel.attr(AttributeKey.valueOf(Constants.Imei)).get();

if(clientType == ClientType.WEB.getCode()){

continue;

}

Boolean isSameClient = false;

// 如果新登录的端和旧的端都是手机端,做处理

if((clientType == ClientType.IOS.getCode()

|| clientType == ClientType.ANDROID.getCode()) &&

(userClientDto.getClientType() == ClientType.IOS.getCode()

|| userClientDto.getClientType() == ClientType.ANDROID.getCode())){

isSameClient = true;

}

// 如果新登录的端和旧的端都是电脑端,做处理

if((clientType == ClientType.MAC.getCode()

|| clientType == ClientType.WINDOWS.getCode()) &&

(userClientDto.getClientType() == ClientType.MAC.getCode()

|| userClientDto.getClientType() == ClientType.WINDOWS.getCode())){

isSameClient = true;

}

if(isSameClient && !(clientType + ":" + imei).equals(userClientDto.getClientType() + ":" + userClientDto.getImei())){

// TODO 踢掉客户端

MessagePack<Object> messagePack = new MessagePack<>();

messagePack.setToId((String) nioSocketChannel.attr(AttributeKey.valueOf(Constants.UserId)).get());

messagePack.setUserId((String) nioSocketChannel.attr(AttributeKey.valueOf(Constants.UserId)).get());

messagePack.setCommand(SystemCommand.MUTUALLOGIN.getCommand());

nioSocketChannel.writeAndFlush(messagePack);

}

}

}

}

});

}

}

这东西理解起来有点抽象

因为这是Redis的订阅模式,就要在启动Redis的时候一起启动了

七、打通业务服务器与IM服务器多端同步

这里考虑到SDK如何获取到tcp服务的地址

- 可以在SDK上写死一个ip,让这个SDK一直去连接这个地址。如果这个地址挂了,这个服务就会挂掉,这个sdk就得进行修改

- 也可以在SDK上写多个ip,如果这四个ip都挂了,才算挂了

- 暴露一个http请求,每次用户登录的时候,都会往这个请求,拿一次tcp的连接地址,如果是web端获取到web的地址,如果是tcp就拿到tcp的地址

这里我们要使用上面的第三种方式来实现,所以要在逻辑层导入zk方面的东西

@Component

public class ZKit {

private static Logger logger = LoggerFactory.getLogger(ZKit.class);

@Autowired

private ZkClient zkClient;

/**

* get all TCP server node from zookeeper

*

* @return

*/

public List<String> getAllTcpNode() {

List<String> children = zkClient.getChildren(Constants.ImCoreZkRoot + Constants.ImCoreZkRootTcp);

// logger.info("Query all node =[{}] success.", JSON.toJSONString(children));

return children;

}

/**

* get all WEB server node from zookeeper

*

* @return

*/

public List<String> getAllWebNode() {

List<String> children = zkClient.getChildren(Constants.ImCoreZkRoot + Constants.ImCoreZkRootWeb);

// logger.info("Query all node =[{}] success.", JSON.toJSONString(children));

return children;

}

}

通过配置文件动态注入zk的地址和超时间,然后就可以使用上面那个获取到tcp和web的服务地址了

1、负载均衡策略—随机模式

public interface RouteHandle {

public String routeServer(List<String> values, String key);

}

public class RandomHandle implements RouteHandle {

@Override

public String routeServer(List<String> values, String key) {

int size = values.size();

if(size == 0){

throw new ApplicationException(UserErrorCode.SERVER_NOT_AVAILABLE);

}

// 随机获取一个im地址值

int i = ThreadLocalRandom.current().nextInt(size);

return values.get(i);

}

}

2、负载均衡策略—轮询模式

public class LoopHandle implements RouteHandle {

private AtomicLong index = new AtomicLong();

@Override

public String routeServer(List<String> values, String key) {

int size = values.size();

if(size == 0){

throw new ApplicationException(UserErrorCode.SERVER_NOT_AVAILABLE);

}

Long l = index.incrementAndGet() % size;

if(l < 0){

l = 0L;

}

return values.get(l.intValue());

}

}

这里使用的是一个原子类,每次放温暖的时候都去加1,然后再取模,达到轮询的目的去取地址

3、负载均衡策略—一致性Hash

实现一致性hash还需要实现不同的HashMap,这里使用了抽象类,来保证扩展性

public class ConsistentHashHandle implements RouteHandle {

private AbstractConsistentHash abstractConsistentHash;

public void setAbstractConsistentHash(AbstractConsistentHash abstractConsistentHash) {

this.abstractConsistentHash = abstractConsistentHash;

}

// TreeMap实现一致性hash

@Override

public String routeServer(List<String> values, String key) {

return abstractConsistentHash.process(values, key);

}

}

public abstract class AbstractConsistentHash {

// add

protected abstract void add(long key, String value);

// sort

protected void sort(){};

// 获取节点 get

protected abstract String getFirstNodeValue(String value);

// 处理之前事件

protected abstract void processBefore();

// 传入节点列表以及客户端信息获取一个服务节点

public synchronized String process(List<String> values, String key){

processBefore();

for (String value : values) {

add(hash(value), value);

}

sort();

return getFirstNodeValue(key) ;

}

// hash运算

public Long hash(String value){

MessageDigest md5;

try {

md5 = MessageDigest.getInstance("MD5");

} catch (NoSuchAlgorithmException e) {

throw new RuntimeException("MD5 not supported", e);

}

md5.reset();

byte[] keyBytes = null;

try {

keyBytes = value.getBytes("UTF-8");

} catch (UnsupportedEncodingException e) {

throw new RuntimeException("Unknown string :" + value, e);

}

md5.update(keyBytes);

byte[] digest = md5.digest();

// hash code, Truncate to 32-bits

long hashCode = ((long) (digest[3] & 0xFF) << 24)

| ((long) (digest[2] & 0xFF) << 16)

| ((long) (digest[1] & 0xFF) << 8)

| (digest[0] & 0xFF);

long truncateHashCode = hashCode & 0xffffffffL;

return truncateHashCode;

}

}

public class TreeMapConsistentHash extends AbstractConsistentHash{

// map

private TreeMap<Long, String> treeMap = new TreeMap<>();

//

private static final int NODE_SIZE = 2;

@Override

protected void add(long key, String value) {

for (int i = 0; i < NODE_SIZE; i++) {

treeMap.put(super.hash("node" + key + i), value);

}

treeMap.put(key, value);

}

@Override

protected String getFirstNodeValue(String value) {

Long hash = super.hash(value);

SortedMap<Long, String> last = treeMap.tailMap(hash);

if(!last.isEmpty()){

return last.get(last.firstKey());

}

if(treeMap.size() == 0){

throw new ApplicationException(UserErrorCode.SERVER_NOT_AVAILABLE);

}

return treeMap.firstEntry().getValue();

}

@Override

protected void processBefore() {

treeMap.clear();

}

}

这里实现的是TreeMap,也可以使用其他的Map去实现,这里一些方法要被重写,一些不用,这个TreeMap要重写add、get方法

这里还要考虑一个问题,比如我们计算出来的hash值是一个10和一个1000000,两个数相差过大,当我们根据userId去获取服务地址的时候,通过调用tailMap可能总是会选择到10或100000,造成一种不均衡的状态,所以这里引入了一种添加虚拟节点的方式,每一个普通节点附加两个虚拟节点,虚拟节点的key是普通节点的key加一些东西,然后value和普通节点的一样,也就是最终比如之前就有10、1000000,但是添加了之后有了10、100、1000、10000、100060、100000,就可以在一定程度上解决老是获取到那固定的服务地址,避免造成涝的涝死,旱死的旱死的局面

测试的时候就可以通过不同的userId去尝试获取不同的服务地址了

4、配置负载均衡策略

之前我们使用的策略都是手动在BeabConfig中修改的,这样的肯定不使用,所以我们要把这个放到配置文件中去,下面的就是去做一些优化

@Configuration

public class BeanConfig {

@Autowired

private AppConfig appConfig;

@Bean

public RouteHandle routeHandle() throws Exception {

// 获取配置文件中使用的哪个路由策略

Integer imRouteWay = appConfig.getImRouteWay();

// 使用的路由策略的具体的路径

String routWay = "";

// 通过配置文件中的路由策略的代表值去Enum获取到具体路径的类

ImUrlRouteWayEnum handler = ImUrlRouteWayEnum.getHandler(imRouteWay);

// 赋值给具体路径

routWay = handler.getClazz();

// 通过反射拿到路由策略的类

RouteHandle routeHandle = (RouteHandle) Class.forName(routWay).newInstance();

// 如果是hash策略的话,还要搞一个具体的hash算法

if (handler == ImUrlRouteWayEnum.HASH){

// 通过反射拿到ConsistentHashHandle中的方法

Method method = Class.forName(routWay).getMethod("setAbstractConsistentHash", AbstractConsistentHash.class);

// 从配置文件中拿到指定hash算法的代表值

Integer consistentHashWay = appConfig.getConsistentHashWay();

// 具体hash算法的类的路径

String hashWay = "";

// 通过Enue拿到对象

RouteHashMethodEnum handler1 = RouteHashMethodEnum.getHandler(consistentHashWay);

// 赋值

hashWay = handler1.getClazz();

// 通过反射拿到hash算法

AbstractConsistentHash abstractConsistentHash = (AbstractConsistentHash) Class.forName(hashWay).newInstance();

method.invoke(routeHandle, abstractConsistentHash);

}

return routeHandle;

}

}

配置

5、使用Apache—HttpClient封装http请求工具

@Configuration

@ConfigurationProperties(prefix = "httpclient")

public class GlobalHttpClientConfig {

private Integer maxTotal; // 最大连接数

private Integer defaultMaxPerRoute; // 最大并发链接数

private Integer connectTimeout; // 创建链接的最大时间

private Integer connectionRequestTimeout; // 链接获取超时时间

private Integer socketTimeout; // 数据传输最长时间

private boolean staleConnectionCheckEnabled; // 提交时检查链接是否可用

PoolingHttpClientConnectionManager manager = null;

HttpClientBuilder httpClientBuilder = null;

// 定义httpClient链接池

@Bean(name = "httpClientConnectionManager")

public PoolingHttpClientConnectionManager getPoolingHttpClientConnectionManager() {

return getManager();

}

private PoolingHttpClientConnectionManager getManager() {

if (manager != null) {

return manager;

}

manager = new PoolingHttpClientConnectionManager();

manager.setMaxTotal(maxTotal); // 设定最大链接数

manager.setDefaultMaxPerRoute(defaultMaxPerRoute); // 设定并发链接数

return manager;

}

/**

* 实例化连接池,设置连接池管理器。 这里需要以参数形式注入上面实例化的连接池管理器

*

* @Qualifier 指定bean标签进行注入

*/

@Bean(name = "httpClientBuilder")

public HttpClientBuilder getHttpClientBuilder(

@Qualifier("httpClientConnectionManager") PoolingHttpClientConnectionManager httpClientConnectionManager) {

// HttpClientBuilder中的构造方法被protected修饰,所以这里不能直接使用new来实例化一个HttpClientBuilder,可以使用HttpClientBuilder提供的静态方法create()来获取HttpClientBuilder对象

httpClientBuilder = HttpClientBuilder.create();

httpClientBuilder.setConnectionManager(httpClientConnectionManager);

return httpClientBuilder;

}

/**

* 注入连接池,用于获取httpClient

*

* @param httpClientBuilder

* @return

*/

@Bean

public CloseableHttpClient getCloseableHttpClient(

@Qualifier("httpClientBuilder") HttpClientBuilder httpClientBuilder) {

return httpClientBuilder.build();

}

public CloseableHttpClient getCloseableHttpClient() {

if (httpClientBuilder != null) {

return httpClientBuilder.build();

}

httpClientBuilder = HttpClientBuilder.create();

httpClientBuilder.setConnectionManager(getManager());

return httpClientBuilder.build();

}

/**

* Builder是RequestConfig的一个内部类 通过RequestConfig的custom方法来获取到一个Builder对象

* 设置builder的连接信息

*

* @return

*/

@Bean(name = "builder")

public RequestConfig.Builder getBuilder() {

RequestConfig.Builder builder = RequestConfig.custom();

return builder.setConnectTimeout(connectTimeout).setConnectionRequestTimeout(connectionRequestTimeout)

.setSocketTimeout(socketTimeout).setStaleConnectionCheckEnabled(staleConnectionCheckEnabled);

}

/**

* 使用builder构建一个RequestConfig对象

*

* @param builder

* @return

*/

@Bean

public RequestConfig getRequestConfig(@Qualifier("builder") RequestConfig.Builder builder) {

return builder.build();

}

public Integer getMaxTotal() {

return maxTotal;

}

public void setMaxTotal(Integer maxTotal) {

this.maxTotal = maxTotal;

}

public Integer getDefaultMaxPerRoute() {

return defaultMaxPerRoute;

}

public void setDefaultMaxPerRoute(Integer defaultMaxPerRoute) {

this.defaultMaxPerRoute = defaultMaxPerRoute;

}

public Integer getConnectTimeout() {

return connectTimeout;

}

public void setConnectTimeout(Integer connectTimeout) {

this.connectTimeout = connectTimeout;

}

public Integer getConnectionRequestTimeout() {

return connectionRequestTimeout;

}

public void setConnectionRequestTimeout(Integer connectionRequestTimeout) {

this.connectionRequestTimeout = connectionRequestTimeout;

}

public Integer getSocketTimeout() {

return socketTimeout;

}

public void setSocketTimeout(Integer socketTimeout) {

this.socketTimeout = socketTimeout;

}

public boolean isStaleConnectionCheckEnabled() {

return staleConnectionCheckEnabled;

}

public void setStaleConnectionCheckEnabled(boolean staleConnectionCheckEnabled) {

this.staleConnectionCheckEnabled = staleConnectionCheckEnabled;

}

}

这样就可以根据这个类上面的注解获取到httpclient中的配置文件的属性了

@Component

public class HttpRequestUtils {

@Autowired

private CloseableHttpClient httpClient;

@Autowired

private RequestConfig requestConfig;

@Autowired

GlobalHttpClientConfig httpClientConfig;

public String doGet(String url, Map<String, Object> params, String charset) throws Exception {

return doGet(url,params,null,charset);

}

/**

* 通过给的url地址,获取服务器数据

*

* @param url 服务器地址

* @param params 封装用户参数

* @param charset 设定字符编码

* @return

*/

public String doGet(String url, Map<String, Object> params, Map<String, Object> header, String charset) throws Exception {

if (StringUtils.isEmpty(charset)) {

charset = "utf-8";

}

URIBuilder uriBuilder = new URIBuilder(url);

// 判断是否有参数

if (params != null) {

// 遍历map,拼接请求参数

for (Map.Entry<String, Object> entry : params.entrySet()) {

uriBuilder.setParameter(entry.getKey(), entry.getValue().toString());

}

}

// 声明 http get 请求

HttpGet httpGet = new HttpGet(uriBuilder.build());

httpGet.setConfig(requestConfig);

if (header != null) {

// 遍历map,拼接header参数

for (Map.Entry<String, Object> entry : header.entrySet()) {

httpGet.addHeader(entry.getKey(),entry.getValue().toString());

}

}

String result = "";

try {

// 发起请求

CloseableHttpResponse response = httpClient.execute(httpGet);

// 判断状态码是否为200

if (response.getStatusLine().getStatusCode() == 200) {

// 返回响应体的内容

result = EntityUtils.toString(response.getEntity(), charset);

}

} catch (IOException e) {

e.printStackTrace();

throw new RuntimeException(e);

}

return result;

}

/**

* GET请求, 含URL 参数

*

* @param url

* @param params

* @return 如果状态码为200,则返回body,如果不为200,则返回null

* @throws Exception

*/

public String doGet(String url, Map<String, Object> params) throws Exception {

return doGet(url, params, null);

}

/**

* GET 请求,不含URL参数

*

* @param url

* @return

* @throws Exception

*/

public String doGet(String url) throws Exception {

return doGet(url, null, null);

}

public String doPost(String url, Map<String, Object> params, String jsonBody, String charset) throws Exception {

return doPost(url,params,null,jsonBody,charset);

}

/**

* 带参数的post请求

*

* @param url

* @return

* @throws Exception

*/

public String doPost(String url, Map<String, Object> params, Map<String, Object> header, String jsonBody, String charset) throws Exception {

if (StringUtils.isEmpty(charset)) {

charset = "utf-8";

}

URIBuilder uriBuilder = new URIBuilder(url);

// 判断是否有参数

if (params != null) {

// 遍历map,拼接请求参数

for (Map.Entry<String, Object> entry : params.entrySet()) {

uriBuilder.setParameter(entry.getKey(), entry.getValue().toString());

}

}

// 声明httpPost请求

HttpPost httpPost = new HttpPost(uriBuilder.build());

// 加入配置信息

httpPost.setConfig(requestConfig);

// 判断map是否为空,不为空则进行遍历,封装from表单对象

if (StringUtils.isNotEmpty(jsonBody)) {

StringEntity s = new StringEntity(jsonBody, charset);

s.setContentEncoding(charset);

s.setContentType("application/json");

// 把json body放到post里

httpPost.setEntity(s);

}

if (header != null) {

// 遍历map,拼接header参数

for (Map.Entry<String, Object> entry : header.entrySet()) {

httpPost.addHeader(entry.getKey(),entry.getValue().toString());

}

}

String result = "";

// CloseableHttpClient httpClient = HttpClients.createDefault(); // 单个

CloseableHttpResponse response = null;

try {

// 发起请求

response = httpClient.execute(httpPost);

// 判断状态码是否为200

if (response.getStatusLine().getStatusCode() == 200) {

// 返回响应体的内容

result = EntityUtils.toString(response.getEntity(), charset);

}

} catch (IOException e) {

e.printStackTrace();

throw new RuntimeException(e);

}

return result;

}

/**

* 不带参数post请求

* @param url

* @return

* @throws Exception

*/

public String doPost(String url) throws Exception {

return doPost(url, null,null,null);

}

/**

* get 方法调用的通用方式

* @param url

* @param tClass

* @param map

* @param charSet

* @return

* @throws Exception

*/

public <T> T doGet(String url, Class<T> tClass, Map<String, Object> map, String charSet) throws Exception {

String result = doGet(url, map, charSet);

if (StringUtils.isNotEmpty(result))

return JSON.parseObject(result, tClass);

return null;

}

/**

* get 方法调用的通用方式

* @param url

* @param tClass

* @param map

* @param charSet

* @return

* @throws Exception

*/

public <T> T doGet(String url, Class<T> tClass, Map<String, Object> map, Map<String, Object> header, String charSet) throws Exception {

String result = doGet(url, map, header, charSet);

if (StringUtils.isNotEmpty(result))

return JSON.parseObject(result, tClass);

return null;

}

/**

* post 方法调用的通用方式

* @param url

* @param tClass

* @param map

* @param jsonBody

* @param charSet

* @return

* @throws Exception

*/

public <T> T doPost(String url, Class<T> tClass, Map<String, Object> map, String jsonBody, String charSet) throws Exception {

String result = doPost(url, map,jsonBody,charSet);

if (StringUtils.isNotEmpty(result))

return JSON.parseObject(result, tClass);

return null;

}

public <T> T doPost(String url, Class<T> tClass, Map<String, Object> map, Map<String, Object> header, String jsonBody, String charSet) throws Exception {

String result = doPost(url, map, header,jsonBody,charSet);

if (StringUtils.isNotEmpty(result))

return JSON.parseObject(result, tClass);

return null;

}

/**

* post 方法调用的通用方式

* @param url

* @param map

* @param jsonBody

* @param charSet

* @return

* @throws Exception

*/

public String doPostString(String url, Map<String, Object> map, String jsonBody, String charSet) throws Exception {

return doPost(url, map,jsonBody,charSet);

}

/**

* post 方法调用的通用方式

* @param url

* @param map

* @param jsonBody

* @param charSet

* @return

* @throws Exception

*/

public String doPostString(String url, Map<String, Object> map, Map<String, Object> header, String jsonBody, String charSet) throws Exception {

return doPost(url, map, header, jsonBody,charSet);

}

}

然后用封装的http请求工具封装一个回调的类

@Component

public class CallbackService {

private Logger logger = LoggerFactory.getLogger(CallbackService.class);

@Autowired

private HttpRequestUtils httpRequestUtils;

@Autowired

private AppConfig appConfig;

@Autowired

private ShareThreadPool shareThreadPool;

public void callback(Integer appId, String callbackCommand, String jsonBody){

shareThreadPool.submit(()->{

try {

httpRequestUtils.doPost(appConfig.getCallbackUrl(), Object.class, builderUrlParams(appId, callbackCommand),

jsonBody, null);

} catch (Exception e) {

logger.error("callback 回调{} : {}出现异常 : {} ",callbackCommand , appId, e.getMessage());

}

});

}

public ResponseVO beforecallback(Integer appId, String callbackCommand, String jsonBody){

try {

ResponseVO responseVO

= httpRequestUtils.doPost("", ResponseVO.class, builderUrlParams(appId, callbackCommand)

, jsonBody, null);

return responseVO;

} catch (Exception e) {

logger.error("callback 之前 回调{} : {}出现异常 : {} ",callbackCommand , appId, e.getMessage());

return ResponseVO.successResponse();

}

}

public Map builderUrlParams(Integer appId, String command){

Map map = new HashMap();

map.put("appId", appId);

map.put("command", command);

return map;

}

}

这个回调的地址也是可以配置在配置文件中的,当你需要得知服务端的状态的时候就可以设置这个回调地址,添加了回调逻辑的操作,就会给你发送一条消息,以便你知晓请求的怎么样了

6、用户资料变更、群组模块回调

这些回调函数的开关都放在配置文件中了,当我们这个修改用户信息成功了以后,调用这个回调函数,往设置好回调地址的地方用http发一条信息,修改群组模块也如此。

7、数据多端同步

技术选取