ElasticSearch - 基于 docker 部署 es、kibana,配置中文分词器、扩展词词典、停用词词典

目录

一、ElasticSearch 部署

1.1、创建网络

1.2、加载镜像

1.3、运行

1.4、检查是否部署成功

二、部署 Kibana

2.1、加载镜像

2.2、运行

三、部署 IK 分词器

3.1、查看数据卷目录

3.2、上传分词器

3.3、重启容器

3.4、测试

3.4、扩展词词典

3.5、停用词词典

一、ElasticSearch 部署

1.1、创建网络

这里为了 es 和 将来要下载的 kibana 进行互联,因此需要我们去创建一个网络.

Ps:这里也可以使用 docker-compose 一键互联,但是考虑到未来可能不会使用 kibana(可替代组件,前面的章节讲过),只需要 es,所以这里我们还是单独部署.

docker network create es-net1.2、加载镜像

这里我们使用 es 的 7.12.1 版本的镜像,体积比较大,接近 1G,大家可以自己去 pull 下来,也可以去找一些现有的资源(因为太大了,我上传不了,bibana 也是如此).

上传完成以后,去加载镜像即可.

docker load -i es.tar

1.3、运行

部署单点 es 命令如下.

docker run -d \

--name es \

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \

-e "discovery.type=single-node" \

-v es-data:/usr/share/elasticsearch/data \

-v es-plugins:/usr/share/elasticsearch/plugins \

--privileged \

--network es-net \

-p 9200:9200 \

-p 9300:9300 \

elasticsearch:7.12.1- -e 表示配置环境变量,这里环境变量有两个.

- -e "ES_JAVA_OPTS=-Xms512m -Xmx512m"`:内存大小(es 底层是 Java 实现的,所以这里是配置 jvm 的堆内存大小),值得注意的是,这里 512 已经是能配置的最小内存了,不能更小,否则回出现内存不足的情况.

- -e "discovery.type=single-node"`:非集群模式(single node 就是单个节点的意思)

- -v es-data:/usr/share/elasticsearch/data`:挂载数据卷,绑定es的数据目录

- -v es-plugins:/usr/share/elasticsearch/plugins`:挂载数据卷,绑定es的插件目录(将来作拓展,就要在这里存东西)

- --privileged`:授予数据卷访问权

- --network es-net` :加入一个名为es-net的网络中

- -p 9200:9200: 这里是 http 协议端口,供我们访问.

- -p 9300:9300:这里是 es 容器各个节点之间的互联端口.(这个端口现在用不到,不暴露也没关系,只是后面部署集群的时候,还得打开).

如果要设置集群,可以如下配置:

- -e "cluster.name=es-docker-cluster"`:设置集群名称

运行镜像

1.4、检查是否部署成功

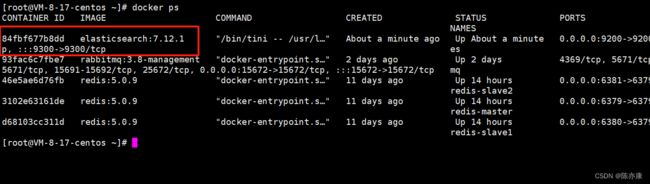

可以先通过 docker ps 命令,看一下是不是启动成功了.

接下来,打开浏览器,输入 http://你的云服务ip:9200 即可(这里我就不暴露 ip了,孩子吃了不少教训,害怕黑客攻击了...)

Ps:这里别忘了开 9200 端口的防火墙.

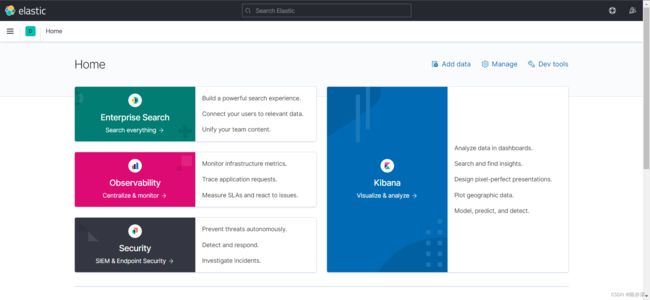

如果看到如下界面,就说明 ElasticSearch 部署完成~

二、部署 Kibana

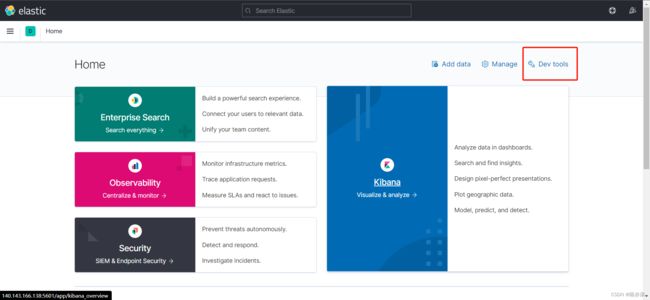

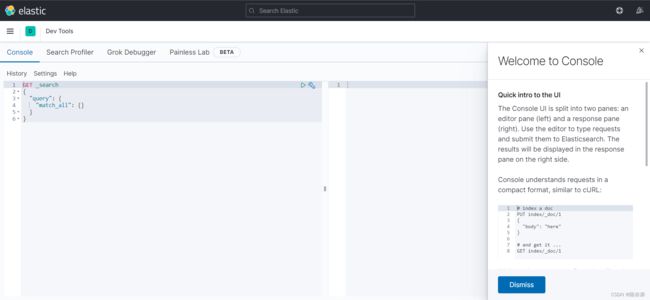

这里为什么还要安装 kibana 呢?因为 kibana 中提供了一个 dev tools 工具,可以让我们非常方便的编写 es 中 DSL 语句.

2.1、加载镜像

这里的镜像同样不建议大家去 pull,可以去网上找找其他的资源,但是值得注意的是,kibana 的版本要和 es 匹配才行.

docker load -i kibana.tar2.2、运行

运行以下命令,运行镜像

docker run -d \

--name kibana \

-e ELASTICSEARCH_HOSTS=http://es:9200 \

--network=es-net \

-p 5601:5601 \

kibana:7.12.1- --network es-net` :加入一个名为es-net的网络中,与elasticsearch在同一个网络中.

- -e ELASTICSEARCH_HOSTS=http://es:9200"`:设置elasticsearch的地址,因为kibana已经与elasticsearch在一个网络,因此可以用容器名直接访问elasticsearch.

- -p 5601:5601`:端口映射配置.

Kibana 启动一般比较慢,需要多等待一会,可以通过 docker logs -f kibana 命令来查看他的运行日志信息.

最后,在浏览器中输入地址:http://你的云服务器 ip:5601 既可看到结果.

这里专门提供了一个工具,用来编写 DSL 代码,来操作 es,并且还有 DSl 语句自动补全功能.

三、部署 IK 分词器

前面章节我们讲到,建立倒排索引需要对用户输入的内容进行分词处理(比如用户输入“华为手机”,会分成 “华为”和“手机”),但是由于 es 默认的分词器是不支持中文分词的,因此这里需要我们去安装 IK 分词器.

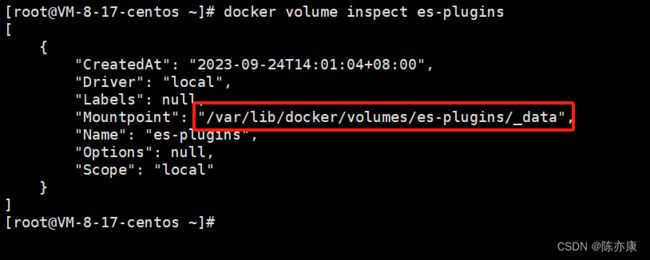

3.1、查看数据卷目录

安装插件需要知道 es 的 plugins 的目录位置,而我们使用了数据卷挂载,因此只需要查看 es 的数据卷目录,通过以下命令即可查看 :

docker volume inspect es-plugins3.2、上传分词器

这里我们可以在网上找 ik 分词器的压缩包,下载下来解压,命名为 ik.

![]()

然后上传到 es 容器的插件数据卷中.

如果直接上传文件夹失败,那么还是压缩成 zip 文件,上传,然后通过 unzip 进行解压.

3.3、重启容器

使用以下命令重启容器

docker restart es3.4、测试

IK 分词器,包含两种模式:

- ik_smart:最少切分,例如 “世界上” 这个内容,首先就是看这个整体是否是一个词,如果是就将他作为一个词条,然后这个词就拆分完成了;如果不是一个词,才继续拆分.

- ik_max_word:最细切分,例如 “世界上” 这个内容,首先就看这个整体是否是一个词,如果是就将他作为一个词条,然后在看是否能继续切分,如果可以就继续切分,找到新词条.

以下我们可以看一下使用 ik_smart 对 "java是世界上最好的语言进行分词".

ik_max_word 分词输入:

GET /_analyze

{

"analyzer": "ik_max_word",

"text": "java是世界上最好的语言"

}输出如下:

{

"tokens" : [

{

"token" : "java",

"start_offset" : 0,

"end_offset" : 4,

"type" : "ENGLISH",

"position" : 0

},

{

"token" : "是",

"start_offset" : 4,

"end_offset" : 5,

"type" : "CN_CHAR",

"position" : 1

},

{

"token" : "世界上",

"start_offset" : 5,

"end_offset" : 8,

"type" : "CN_WORD",

"position" : 2

},

{

"token" : "世界",

"start_offset" : 5,

"end_offset" : 7,

"type" : "CN_WORD",

"position" : 3

},

{

"token" : "上",

"start_offset" : 7,

"end_offset" : 8,

"type" : "CN_CHAR",

"position" : 4

},

{

"token" : "最好",

"start_offset" : 8,

"end_offset" : 10,

"type" : "CN_WORD",

"position" : 5

},

{

"token" : "的",

"start_offset" : 10,

"end_offset" : 11,

"type" : "CN_CHAR",

"position" : 6

},

{

"token" : "语言",

"start_offset" : 11,

"end_offset" : 13,

"type" : "CN_WORD",

"position" : 7

}

]

}

ik_smart 分词输入:

GET /_analyze

{

"analyzer": "ik_smart",

"text": "java是世界上最好的语言"

}输出:

{

"tokens" : [

{

"token" : "java",

"start_offset" : 0,

"end_offset" : 4,

"type" : "ENGLISH",

"position" : 0

},

{

"token" : "是",

"start_offset" : 4,

"end_offset" : 5,

"type" : "CN_CHAR",

"position" : 1

},

{

"token" : "世界上",

"start_offset" : 5,

"end_offset" : 8,

"type" : "CN_WORD",

"position" : 2

},

{

"token" : "最好",

"start_offset" : 8,

"end_offset" : 10,

"type" : "CN_WORD",

"position" : 3

},

{

"token" : "的",

"start_offset" : 10,

"end_offset" : 11,

"type" : "CN_CHAR",

"position" : 4

},

{

"token" : "语言",

"start_offset" : 11,

"end_offset" : 13,

"type" : "CN_WORD",

"position" : 5

}

]

}

3.4、扩展词词典

随着互联网的不断发展,也出现了很多新的词语,在原有的词汇列表中不存在,比如:“鸡你太美”,“奥里给”.......

所以我们的词汇也需要不断更新,IK分词器也提供了扩展词汇的功能.

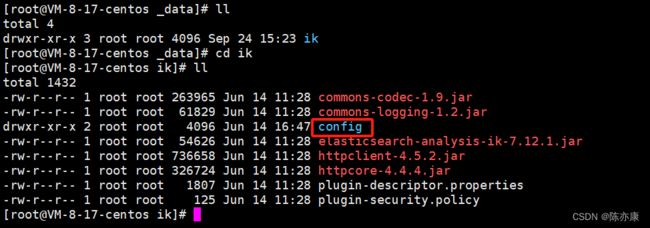

a)在 es 的插件数据卷目录下,进入 ik 文件夹,接着进入 config 目录.

找到如下文件

b)通过 vim 打开 IKAnalyzer.vfg.xml 配置文件,添加以下内容:

IK Analyzer 扩展配置

ext.dic

c)新建一个 ext.dic,添加需要的词汇.

Ps:当前文件的编码必须是 UTF-8 格式,严禁使用Windows记事本编辑

d)重启 es

docker restart ese)测试效果

ik_max_word 分词输入:

GET /_analyze

{

"analyzer": "ik_max_word",

"text": "听过鸡你太美和奥里给吗?"

}输出:

{

"tokens" : [

{

"token" : "听过",

"start_offset" : 0,

"end_offset" : 2,

"type" : "CN_WORD",

"position" : 0

},

{

"token" : "鸡你太美",

"start_offset" : 2,

"end_offset" : 6,

"type" : "CN_WORD",

"position" : 1

},

{

"token" : "太美",

"start_offset" : 4,

"end_offset" : 6,

"type" : "CN_WORD",

"position" : 2

},

{

"token" : "和",

"start_offset" : 6,

"end_offset" : 7,

"type" : "CN_CHAR",

"position" : 3

},

{

"token" : "奥里给",

"start_offset" : 7,

"end_offset" : 10,

"type" : "CN_WORD",

"position" : 4

},

{

"token" : "吗",

"start_offset" : 10,

"end_offset" : 11,

"type" : "CN_CHAR",

"position" : 5

}

]

}

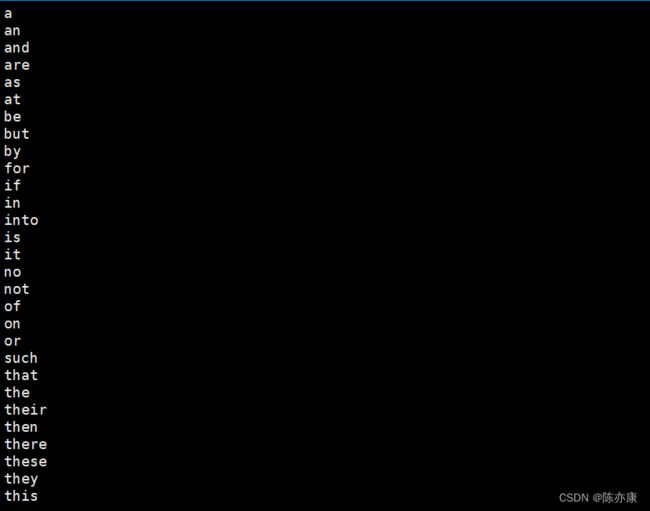

3.5、停用词词典

在互联网项目中,在网络间传输的速度很快,所以很多语言是不允许在网络上传递的,如:关于宗教、政治等敏感词语,那么我们在搜索时也应该忽略当前词汇。

IK分词器也提供了强大的停用词功能,让我们在索引时就直接忽略当前的停用词汇表中的内容。

a)IKAnalyzer.cfg.xml配置文件内容添加

IK Analyzer 扩展配置

ext.dic

stopword.dic

b)在 stopword.dic 中添加停用词.

可以看到这里,原本已经有一些停用的词(一些介词...没必要创建索引)

这里我们添加 “小黑子”,如下

c)重启 es

docker restart esd)测试

可以看出,并没有分出 小黑子 这个词条