Linux-多路转接-epoll

epoll

- 接口认识

-

- epoll_create

- epoll_ctl

- epoll_wait

- epoll工作原理

-

- 在内核中创建的数据结构

- epoll模型的一个完整工作流程

- epoll工作模式

-

- LT-水平触发

- ET-边缘触发

- 两种方式的对比

- epoll的使用场景

- 对于poll的改进

- 惊群效应

-

- 什么是惊群效应

- 如何解决惊群效应

- 原子操作/mutex/spinlock如何选择

- 简单reactor模式的epoll服务器的编写

接口认识

epoll_create

int epoll_create(int size);

创建一个epoll模型,在Linux2.8.6之后size参数是被忽略的,通常传递一个大于0的整数。

返回值是一个文件描述符,所以在使用完毕后要close掉,防止资源泄漏。

epoll_ctl

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

第一个参数为创建的epoll模型对应的fd。

第二个参数为在epoll模型中对让内核关心的文件描述符某些事件进行增删改。

EPOLL_CTL_ADD:在epoll模型中添加让内核关心对某个fd的某些事件。

EPOLL_CTL_MOD:修改epoll模型中某个fd所关心的事件。

EPOLL_CTL_MOD:删除epoll模型中某个fd,不用让内核关心此fd了。

第三个参数为对哪个文件描述符fd进行操作。

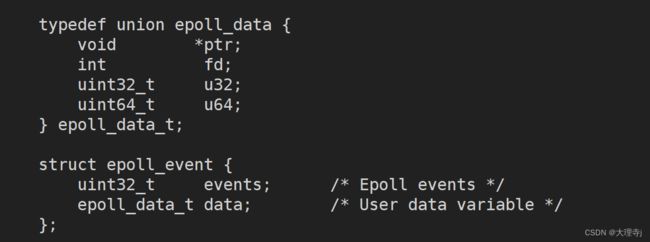

第四个参数是一个结构体类型,其内部结构如下:

epoll_event结构体中包含两个字段:uint32_t表示要让内核关心的哪些事件,epoll_data_t是一个联合体,通常设置fd字段即可,ptr指针可以用来存放用户自定义数据的地址,在epoll_wait返回时,会将我们当初设置的字段原样返回。

events字段:

epoll_wait

int epoll_wait(int epfd, struct epoll_event *events,

int maxevents, int timeout);

第一个参数为创建的epoll模型对应的fd。

第二个参数需要用户传递一个数组进去,返回时其内容会被填充,表示内核告诉用户哪些fd的哪些事件已经就绪了。

第三个参数为用户传递数组的大小。

第四个参数为等待时间:

大于0:表示经过timeout时间的等待没有事件就绪,就返回。

等于0:表示没有事件就绪就直接返回。返回值设置为0。

-1:表示阻塞等待模式

返回值:大于0:表示用户传入的数组中多少个元素被设置。

等于0:表明timeout。

小于0:表明epoll_wait出错。

epoll工作原理

在内核中创建的数据结构

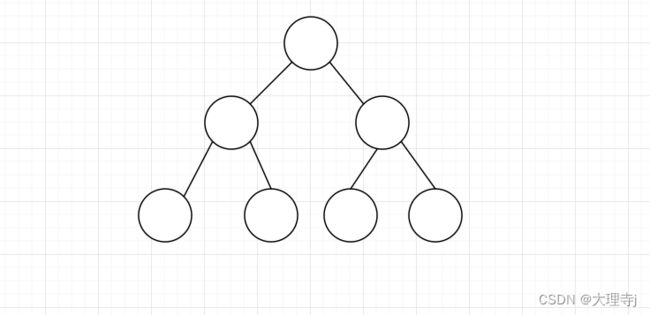

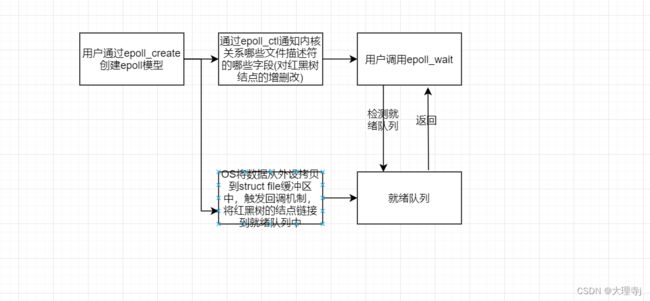

在用户通过epoll_create创建一个epoll模型时,在内核中其实创建了以下的数据结构:

红黑树结点中存放的内容包括:fd,用户让内核关心这个fd的哪些事件,这个fd的哪些事件已经就绪了(revents)等。除此之外还会包括一些连接字段。红黑树是一颗近似平衡的搜索二叉树,所以用户通过epoll_ctl对某个fd进行插入,修改,删除,就是对红黑树结点做插入,修改,删除,效率是很高的。

一个就绪队列:

就绪队列中的结点就表示,让内核关心的哪些fd上的哪些事件已经就绪了,用户调用epoll_wait时,内核就是将就绪队列中的信息拷贝给用户,另外epoll_wait可以以O(1)的事件复杂度来判断有没有事件就绪,因为如果就绪队列为空,表示没有事件就绪,如果事件不为空表示有事件就绪。

struct file中的回调指针被设置

以读事件为例,内核怎么知道读事件就绪了呢?这我们就要弄清楚数据是从哪里来的,首先网络通信中接收到的数据一定是网卡先收到的,当网卡收到数据时可能会触发某种中断机制,通知操作系统,随后数据通过网络协议栈的层层解析最终被放到struct file中的缓冲区中,对于用户而言,数据被放到了struct file缓冲区中才代表实践就绪了,那么既然是操作系统将数据拷贝到的struct file缓冲区中的,在epoll的工作原理下,OS将数据拷贝到struct file缓冲区中时,会触发回调机制,将红黑树的结点链接到就绪队列中(内核中的数据结构的某个结点可以数据多个数据结构)。

写事件与读事件类似。

epoll模型的一个完整工作流程

epoll工作模式

LT-水平触发

LT模式是epoll的默认工作方式,当内核缓冲区的数据越过设定的水位线后,epoll_wait就会返回,通知用户有事件已经就绪了,如果用户置之不理不去处理这个事件,那么epoll会一直通知用户这个事件已经就绪了。

ET-边缘触发

ET工作模式下,epoll检测到某个套接字上的事件已经就绪了,但是用户并没有处理,那么下次调用epoll_wait的时候就不会返回,也就意味这只会通知一次,只有当套接字中有新的数据到来时才会再次通知用户一次。

对于ET工作模式,假设某个客户端就给服务器发送了一次数据,那么对于服务器而言就必须要将数据全部读取上来,因为epoll不会通我第二次,并且如果采用阻塞式的读取,如果某次恰好将数据读取完,那么下次再读取时就会阻塞住,这时不合理的,所以ET模式一定要搭配非阻塞IO使用,ET这种工作模式倒逼用户一次就将数据读取完。

两种方式的对比

由于ET模式倒逼用户一次将数据读取完,那么就能有效的减少epoll触发的次数,epoll可以利用重复通知某一进程的资源去通知其他进程,其IO效率是比LT要高的。但是,对于LT而言也可以采用非阻塞IO的方式一次将数据读取完,这种情况下LT和ET的IO效率是相等的。所以ET的IO效率是>=LT的iIO效率的。

ET模式适合于高IO的场景。

LT模式适合于高响应的模式,对于LT模式,可以每次读取一部分,对这一部分数据做处理尽快的响应客户端请求,所以LT适用于高响应的场景。

epoll的使用场景

epoll适用于存在大量的客户端连接,但只有少部分的连接处于活跃状态的的场景下,例如各种互联网APP的入口服务器,就很适合使用epoll。但是,如果只有很少的连接,就不太适合使用epoll。

对于poll的改进

在用户层面不再用维护pollfd这样类型的数组了,在epoll中由内核进行管理。

不用将用户维护关于fd的某些事件的的信息,每次调用时都拷贝给内核。

在epoll_wait返回时,不用对用户维护的数组做遍历来检测哪些fd上的哪些事件已经就绪,因为返回的都是已经就绪的事件。

惊群效应

什么是惊群效应

在多线程或者多进程的场景下,多个线程或者多个进程共同监听同一个端口,当一个新的连接到来时,操作系统不知道通知哪个进程/线程去获取这个连接,所以就直接都通知,导致多个进程/线程只有一个能够成功的获取这个连接,而对于其他没获取连接成功的进程/线程,本有阻塞状态->运行状态,这种进程/线程的切换是浪费资源的,在一个多用户的服务上,如果存在这种惊群效应,那么对CPU是有一定消耗的。

如何解决惊群效应

在Nginx中,是采用加锁的方式来处理惊群效应的,在连接到来时,多个进程谁先抢到锁,谁去获取这个连接。

Nginx中锁的设计:在多个进程之间共享一块内存,在内存中设置一个变量-share_mtx,其值只有两种状态,0和1,当某个进程想去获取连接前,先去判断share_mtx,如果这个值为0,将其改为1,然后去获取连接。如果有的进程判断时,这个值本身就是1,那么去休眠一定时间,并将这个值改为0。这样设计肯定是存在漏洞的,势必会存在某几个进程同时判断share_mtx的值都是0,那么这几个进程都会去获取连接,所以对这个过程要做处理:1.可以采用CAS将这个判断+赋值的过程整合成一个原子操作2.使用mutex互斥锁3.使用spinlock自旋锁。

原子操作/mutex/spinlock如何选择

临界区内代码量较小,且CPU体系结构的指令集中有指令能够支持,则选择原子操作。

临界区内代码量很大,使用mutex互斥锁。

介于两者之间的使用spinlock。

简单reactor模式的epoll服务器的编写

#ifndef __M_SERVER_H__

#define __M_SERVER_H__

#include "Sock.hpp"

#include "err.hpp"

#include "log.hpp"

#include