Redis 笔记(黑马点评 —— 基础篇 + 实战篇)

Redis

- 1. Redis 入门

- 2. 五大基本数据类型

-

- 2.1 String

- 2.2 Hash

- 2.3 List

- 2.4 Set

- 2.5 ZSet

- 2.6 应用场景

- 3. RedisTemplate

-

- 3.1 RedisTemplate 的使用

- 3.1 RedisTemplate 存在的问题

- 3.3 StringRedisTemplate

- 4. 短信登录

-

- 项目准备

- 4.1 基于 Session 实现登录

-

- 4.1.1 发送验证码

- 4.1.2 登录和注册

- 4.1.3 登录验证(拦截器)

- 4.2 登录的实现方案

-

- 4.2.1 Session

- 4.2.2 Redis + Token

- 4.2.3 Redis + JWT

- 4.3 基于 Redis + Token 实现登录

-

- 4.3.1 发送验证码 / 登录和注册

- 4.3.2 前端对 Token 的处理

- 4.3.2 登录验证(拦截器)

- 5. 缓存

-

- 5.1 添加缓存

-

- 5.1.1 /shop/{id}

- 5.1.2 /shop-type/list

- 5.2 数据过期策略

- 5.3 数据淘汰策略

- 5.4 数据更新策略

- 5.5 缓存穿透

-

- 5.5.1 缓存空对象

- 5.5.2 布隆过滤器

- 5.6 缓存雪崩

- 5.7 缓存击穿

-

- 5.7.1 synchronized

- 5.7.2 setnx

- 5.7.3 逻辑过期

- 5.8 封装 Redis Cache 工具类

- 6. 秒杀相关

-

- 6.1 全局唯一 ID

- 6.2 优惠券秒杀

-

- 6.2.1 添加优惠券

- 6.2.2 下单优惠券

- 6.3 超卖问题

-

- 6.3.1 乐观锁(版本号 & CAS)

- 6.3.2 CAS 解决超卖问题

- 6.4 一人一单

-

- 6.4.1 增加一人一单逻辑

- 6.4.2 解决并发安全问题

- 6.4.3 集群环境下的并发问题

- 7. 分布式锁

-

- 7.1 Redis 实现分布式锁

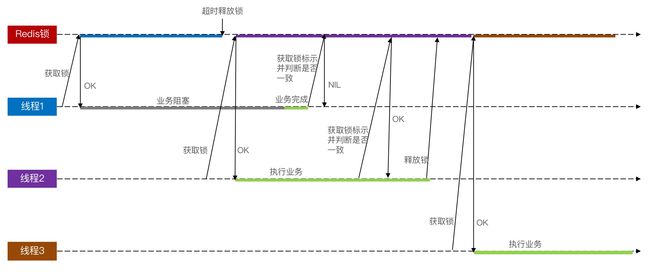

- 7.2 分布式锁的误删问题

- 7.3 Lua 脚本解决原子性问题

- 7.4 总结

- 8. Redisson 分布式锁

-

- 8.1 Redisson 分布式锁的使用

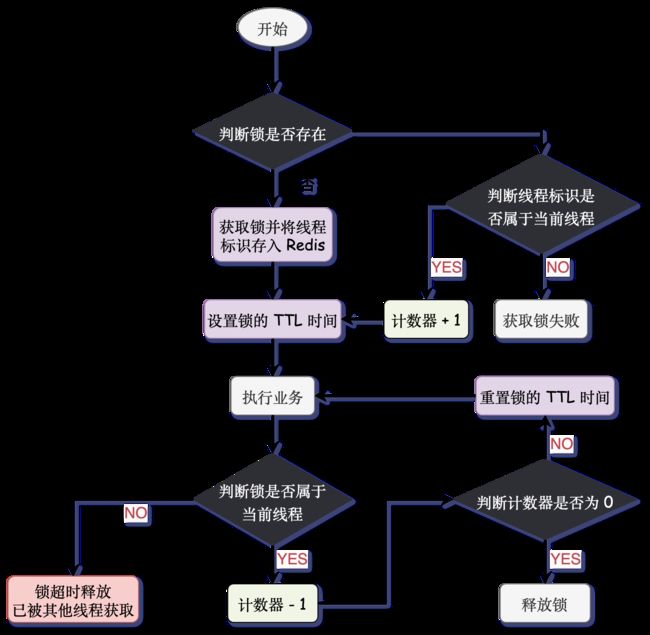

- 8.2 可重入原理

- 8.3 可重试原理

- 8.4 超时续约原理(WatchDog)

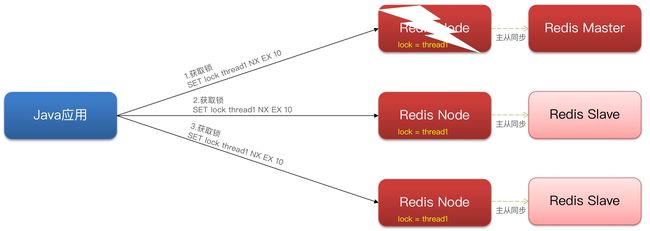

- 8.5 主从一致原理(MultiLock)

- 8.6 总结

- 9. 优化秒杀

- 10. Redis 消息队列

-

- 10.1 基于 List 结构

- 10.2 基于 PubSub

- 10.3 基于 Stream

-

- 10.3.1 Stream 的消费者组模式

- 10.3.2 基于 Stream 消息队列实现异步秒杀

- 11. 点赞相关

-

- 11.1 发布并查看笔记

- 11.2 点赞

- 11.3 点赞排行榜

- 12. 关注相关

-

- 12.1 关注和取关

- 12.2 共同关注

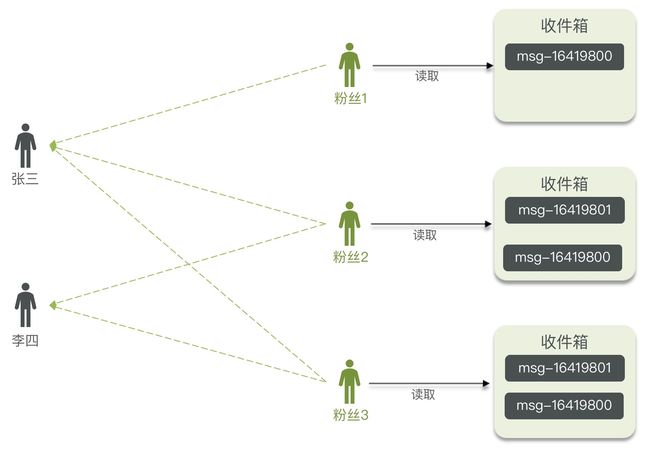

- 12.3 关注推送 - Feed 流

-

- 12.3.1 Feed 流的实现方案

- 12.3.2 Feed 流的滚动分页

- 12.3.3 代码实现

- 13. GEO 附近搜索

-

- 13.1 GEO 数据结构

- 13.2 附近商家搜索

- 14. BitMap 签到

-

- 14.1 BitMap 数据结构

- 14.2 签到

- 14.3 统计连续签到天数

- 15. HyperLogLog UV 统计

- 16. Ops

-

- 16.1 Redis 持久化

-

- 16.1.1 RDB

- 16.1.2 AOF

- 16.1.3 RDB 和 AOF

- 16.2 Redis 主从集群

- 16.3 哨兵机制

- 16.4 Redis 分布式存储方案

-

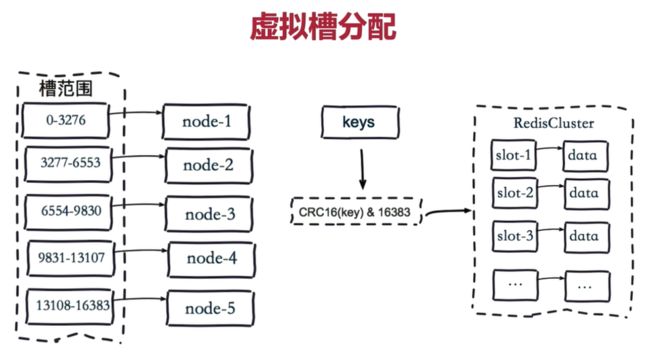

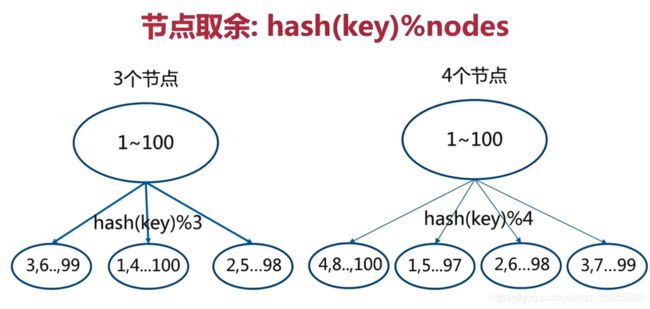

- 哈希取余分区

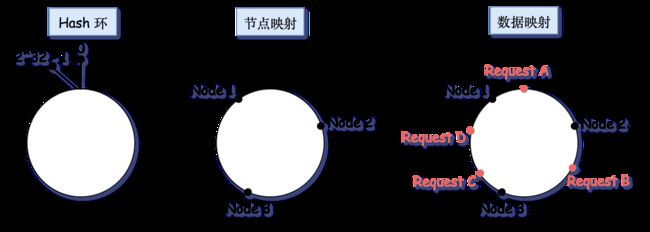

- 一致性哈希算法分区

- 哈希槽分区

项目源码地址:https://gitee.com/sjd75/comment

1. Redis 入门

(NoSQL, Not Only SQL) 非关系型数据库

关系型数据库:以 表格 的形式存在,以 行和列 的形式存取数据,一系列的行和列被称为表,无数张表组成了 数据库。支持复杂的 SQL 查询,能够体现出数据之间、表之间的关联关系;也支持事务,便于提交或者回滚。

非关系型数据库:以 key-value 的形式存在,可以想象成电话本的形式,人名(key)对应电话号码(value)。不需要写一些复杂的 SQL 语句,不需要经过 SQL 的重重解析,性能很高;可扩展性也比较强,数据之间没有耦合性,需要新加字段就直接增加一个 key-value 键值对即可。

Redis 是 速度极快的、基于内存的,键值型 NoSQL 数据库。

-

为什么这么快?

- 完全基于内存操作。

- 使用非阻塞的 IO 多路复用机制。

- 数据结构简单,对数据操作也简单。

- 使用单线程,避免了上下文切换和竞争产生的消耗。

-

支持多种数据类型,包括 String、Hash、List、Set、ZSet 等。

-

支持数据的持久化,支持 RDB 和 AOF 两种持久化机制。

-

支持主从集群、分片集群。

-

Redis 的数据类型

- Key 的类型只能为 字符串。

- Value 支持五种数据类型:字符串(stirng)、列表(list)、集合(set)、散列表(hash)、有序集合(zset)。

-

Redis 有16个数据库,默认使用的是第 0 个。

# 切换数据库 select [0-15] # 查看数据库大小 dbsize # 清除当前数据库内容 flushdb # 清除所有数据库内容 flushall

Redis 相关配置及通用命令

# 监听的地址,默认是 127.0.0.1 只能本地访问;修改为 0.0.0.0,可以在任意 IP 访问。

bind 0.0.0.0

# 守护进程

daemonize yes

# 密码

requirepass root

# 启动 Redis 服务

redis-server devTools/redis-6.2.7/redis.conf

# 启动 Redis 客户端

redis-cli -p 6379

# 若有密码,启动 Redis 客户端后需要输入密码

auth 密码

# 关闭 Redis 服务(quit 退出后 shutdown 关闭)

quit

redis-cli shutdown

# 查看所有符合的 key

KEYS patthern

# 删除一个 或 多个 指定的key

DEL key [key ...]

# 判断某个 key 是否存在

EXISTS key

# 给一个 key 设置有效时间,超时后该 key 会被自动删除

EXPIRE key seconds

# 查看一个 key 的剩余有效时间

TTL key

# 查看某个 key 所存储的 value 的类型

TYPE key

# 为某个 key 重命名

RENAME key newkey

Key 的结构

假设 Blog 中需要存储:用户信息、文章信息,且 用户ID 和 文章ID 都为 1。

让 Redis 的 key 形成层级结构,使用 : 隔开:项目名:业务名:类型:id。

set blog:user:1 Jack

set blog:article:1 Spring

若 value 是一个 Java 对象,可以将对象序列化为 JSON 字符串后存储(注意加单引号)。

set blog:user:1 '{"id":1, "name":"Jack", "age":22}'

set blog:user:2 '{"id":2, "name":"Mike", "age":23}'

set blog:article:1 '{"id":1, "title":"Spring"}'

2. 五大基本数据类型

2.1 String

String 的三种类型:字符串、整型、浮点型。

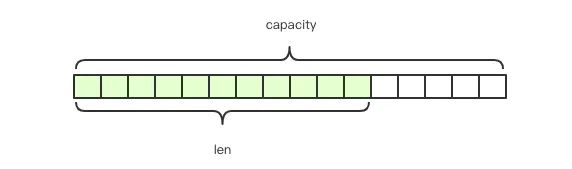

Java 的 String 是不可变的,无法修改。Redis 的 String 是动态的,可以修改的。Redis 的 String 在内部结构实现上类似于 Java 的 ArrayList,采用预分配冗余空间的方式来减少内存的频繁分配。如图所示,当前字符串实际分配的空间为 capacity,一般高于实际的字符串长度 len。当字符串长度小于 1M 时,扩容是对现有空间的成倍增长;如果长度超过 1M 时,扩容一次只会多增加 1M 的空间。String 的最大长度为 512M。

相关操作

SET key value :添加 或 修改一个键值对。

GET key :获取某个 key 的 value。

MSET key value [key value ...] :批量 SET。

MGET key [key ...] :批量 GET。

STRLEN key :获取某个 key 存储的长度。

# GET / SET

> set k1 v1

> get k1

"v1"

> set k1 value1

> get k1

"value1"

# MGET / MSET

> mset k2 v2 k3 v3

> mget k2 k3

1) "v2"

2) "v3"

> mget k1 k2 k3

1) "value1"

2) "v2"

3) "v3"

# STRLEN

> strlen k1

(integer) 6

> strlen k2

(integer) 2

INCR key :一个整型的 value 自增 1。

INCRBY key increment :一个整型的 value 增加 increment。

INCRBYFLOAT key increment :让一个浮点型的 key 自增。

# 整型自增 1

> set k1 1

> incr k1

(integer) 2

# 整型增加 increment

> incrby k1 3

(integer) 5

# 浮点型增加 increment

> set k2 1.1

> INCRBYFLOAT k2 2.2

"3.3"

SETNX key value :添加一个 String 类型的键值对,前提是这个 key 不存在。

SETEX key seconds value :添加一个 String 类型的键值对,并且指定有效时间。

# SETNX

> setnx k1 v1

(integer) 1

> setnx k1 v2

(integer) 0

> get k1

"v1"

# SETEX

> setex k2 10 v2

> ttl k2

(integer) 5

> ttl k2

(integer) -2

> get k2

(nil)

2.2 Hash

Hash 的 value 可以看作一个 Map 集合,Key-Value 形式,只不过 Value 是一个 Map,也就是 Key-Map(Key-Map

- String 类型存储对象需要将其序列化为 JSON 字符串后存储,如果需要修改对象的某个字段,比较不方便,只能修改整个 JSON 字符串。

- Hash 适合存储结构体信息(对象),Hash 可以对用户结构中的每个字段单独存储,可以针对结构中的单个字段进行 CRUD。

| KEY | VLAUE |

|---|---|

blog:user:1 |

{"id": 1, "name": "Jack", "age": 22} |

blog:user:2 |

{"id": 2, "name": "Mike", "age": 23} |

| KEY | VALUE | |

| field | value | |

| blog:user:1 | name | Jack |

| age | 22 | |

| blog:user:2 | name | Mike |

| age | 23 | |

相关操作

HSET key field value [field value ...] :添加 Hash 类型的键值对,或修改 HashKey 的 field 的 value。(HSET 和 HMSET 都可以批量操作)

HGET key field:获取 HashKey 的 field 的 value。(HMGET 批量获取)

HSETNX key field value :添加一个 Hash 类型的键值对,前提是这个 field 不存在。(不能批量添加,一次只能指定一个 HashKey-field-value)

# HSET / HMSET

> hset blog:user:1 id 1

> hset blog:user:1 name Jack

> hset blog:user:1 age 22

> hmset blog:user:2 id 2 name Mike age 23

# HGET / HMGET

> HGET blog:user:1 name

"Jack"

> hmget blog:user:1 id name age

1) "1"

2) "Jack"

3) "22"

> hmget blog:user:2 id name age

1) "2"

2) "Mike"

3) "23

# 修改 field

> hset blog:user:1 name Jack123 age 18

> hmget blog:user:1 name age

1) "Jack123"

2) "18"

# HSETNX 不能批量添加,一次只能指定一个 HashKey-field-value

> hsetnx blog:user:3 id 3

(integer) 1

127.0.0.1:6379> hsetnx blog:user:3 id 3

(integer) 0

HGETALL key :获取指定 HashKey 中的所有 field 和 value。

HKEYS key :获取指定 HashKey 中的所有 field。

HVALS key :获取指定 HashKey 中的所有 field 的 value。

> hgetall blog:user:2

1) "id"

2) "2"

3) "name"

4) "Mike"

5) "age"

6) "23"

> hkeys blog:user:2

1) "id"

2) "name"

3) "age"

> hvals blog:user:2

1) "2"

2) "Mike"

3) "23"

HINCRBY key field increment :一个整型的 HashKey 的 field 的 value 增加 increment。

> HINCRBY blog:user:2 age 3

(integer) 26

> HINCRBY blog:user:2 age 4

(integer) 30

HLEN key :查看 HashKey 的字段数量。

HDEL key field [field ...] :批量删除 HashKey 的 field 和 field 对应的 value。

HEXISTS key field :查看 HashKey 的指定字段 field 是否存在。

> hlen blog:user:2

(integer) 3

> hexists blog:user:2 age

(integer) 1

> hdel blog:user:2 age

(integer) 1

> hexists blog:user:2 age

(integer) 0

> hlen blog:user:2

(integer) 2

2.3 List

List 类似 Java 中的 LinkedList,可以看作一个双向链表(有序可重复)。使用 List 可以对链表的两端进行 push 和 pop 操作、读取单个或多个元素、根据值查找或删除元素、支持正向检索和反向检索。

相关操作

LPUSH key element [element ...] :对链表的头插入一个或多个元素。

LPOP key [count] :移除并返回链表的头部元素。

RPUSH key element [element ...] :对链表的尾插入一个或多个元素。

RPOP key :移除并返回链表的尾部元素。

# linked 中的元素:5 4 3 2 1

> lpush linked 1 2 3 4 5

# lpop 是从头部开始移除元素

> lpop linked

"5"

> lpop linked

"4"

> lpop linked 3

1) "3"

2) "2"

3) "1"

# linked 中的元素:1 2 3 4 5

> rpush linked 1 2 3 4 5

# rpop 是从尾部开始移除元素

> rpop linked

"5"

> rpop linked

"4"

> rpop linked 3

1) "3"

2) "2"

3) "1"

LRANGE key start end :返回指定下标范围内的所有元素。

LTRIM key start end :只保留指定范围内的元素,其他的删除。

LINDEX key index :返回指定下标的值。

LLEN key :返回列表的元素个数。

# 返回第 1、2 个元素

> lrange linked 0 1

1) "5"

2) "4"

# 返回所有元素

> lrange linked 0 -1

1) "5"

2) "4"

3) "3"

4) "2"

5) "1"

# 保留 0、1、2 下标对应的元素

> ltrim linked 0 2

OK

> lrange linked 0 -1

1) "5"

2) "4"

3) "3"

BLPOP / BRPOP kye [key ...] timeout :与 LPOP 和 RPOP 类似,但是在没有指定元素时可以等待指定时间,而不是直接返回 nil。

# 此时数据库中没有 key 为 test 的数据,10 秒内不会返回 nil

> blpop test 10

# 在另外一个终端添加一个 test

> lpush test 1

# 10 秒之内若新增了 test,会将其 POP,并返回等待时间。

> blpop test 10

1) "test"

2) "1"

(7.55s)

栈:LPUSH + LPOP 或 RPUSH + RPOP。

队列:LPUSH + RPOP 或 RPUSH + LPOP。

2.4 Set

Redis 的 Set 类似 HashSet,可以看作一个 value 为 null 的 HashMap;其特征也与 HashSet 类似:无序不可重复,支持 交集、并集、差集等功能。

相关操作

SADD key member [member ...] :向 Set 中添加一个或多个元素。

SMEMBERS key :获取指定 Set 中的所有元素。

SISMEMBER key member :判断 Set 中是否存在指定元素。

SCARD key :返回 Set 中的元素个数。

SREM key member [member ...] :移除 Set 中的指定元素。

> sadd set 1 2 3 4 5

> smembers set

1) "1"

2) "2"

3) "3"

4) "4"

5) "5"

> sismember set 1

(integer) 1

> sismember set 10

(integer) 0

> scard set

(integer) 5

> srem set 4 5

(integer) 2

> scard set

(integer) 3

SINTER key [key ...] :求 n 个 key 间的交集。

SDIFF key [key ...] :求 n 个 key 间的差集。

SUNION key [key ...] :求 n 个 key 间的并集。

> sadd set1 1 2 3 5 7 9

> sadd set2 1 2 4 6 8 10

> sinter set1 set2

1) "1"

2) "2"

> sdiff set1 set2

1) "3"

2) "5"

3) "7"

4) "9"

> sdiff set2 set1

1) "4"

2) "6"

3) "8"

4) "10"

> sunion set1 set2

1) "1"

2) "2"

3) "3"

4) "4"

5) "5"

6) "6"

7) "7"

8) "8"

9) "9"

10) "10"

2.5 ZSet

Redis 的 ZSet 是一个可排序的 Set 集合,类似 ZSet。ZSet 的每一个元素都带有一个 score 属性,可以基于 score 属性对元素排序。

**注意:**排名默认升序,降序需要在命令的 Z 后面添加 REV。

相关操作

ZADD key [score member ...] :以 score 为权重向 ZSet 中添加一个或多个元素,如果存在则更新 score。

ZREM key member [member ...] :删除 ZSet 中的指定元素。

ZCARD key :返回 ZSet 中的元素个数。

ZSCORE key member :获取 ZSet 中指定元素的 score 值。

> zadd students 85 Jack 89 Lucy 82 Rose 95 Tom 78 Jerry 92 Amy 76 Miles

> zcard students

(integer) 7

> zrem students Miles

> zcard students

(integer) 6

> zscore students Jack

"85"

> zscore students Rose

"82"

ZRANK key member :获取 ZSet 中指定元素的排名(按照 score 升序)。

ZCOUNT key min max :统计 score 的值在给定范围内的元素个数。

ZINCRBY key increment member :让 ZSet 中的指定元素的 score 增加 increment。

# 升序

> zrank students Tom

(integer) 5

# 降序

> zrevrank students Tom

(integer) 0

> zcount students 90 100

(integer) 2

> zcount students 80 100

(integer) 5

> zincrby students 5 Tom

"100"

ZRANGE key min max :按照 score 排序后,获取 指定范围 内的元素。

# 升序

# 获取倒数前三

> zrange students 0 2

1) "Jerry"

2) "Rose"

3) "Jack"

# 获取所有元素

> zrange students 0 -1

1) "Jerry"

2) "Rose"

3) "Jack"

4) "Lucy"

5) "Amy"

6) "Tom"

# 降序

> zrevrange students 0 2

1) "Tom"

2) "Amy"

3) "Lucy"

> zrevrange students 0 -1

1) "Tom"

2) "Amy"

3) "Lucy"

4) "Jack"

5) "Rose"

6) "Jerry"

ZRANGEBYSCORE key min max :按照 score 排序后,获取 指定 score 范围 内的元素。

# 获取 score 在 0-80 范围内的元素

> zrangebyscore students 0 80

1) "Jerry"

ZINTER numberKeys key [key ...] | ZDIFF numberKeys key [key ...] | ZUNION numberKeys key [key ...] :求 n 个 Zset 的交集、差集、并集。

> zadd zset1 1 a 2 b 3 c 4 d 5 e

> zadd zset2 1 a 2 b 3 c 6 f 7 g

# 求 2 个 ZSet 的交集

> zinter 2 zset1 zset2

1) "a"

2) "b"

3) "c"

# 求 2 个 ZSet 的差集

> zdiff 2 zset1 zset2

1) "d"

2) "e"

> zdiff 2 zset2 zset1

1) "f"

2) "g"

# 求 2 个 ZSet 的并集

> zunion 2 zset1 zset2

1) "a"

2) "b"

3) "d"

4) "e"

5) "c"

6) "f"

7) "g"

2.6 应用场景

String

- 缓存热点数据。

- 全局 ID / 分布式 ID

- 分布式锁(

set key value NX EX)。 - 分布式 Session。

Hash

Hash:value 可以看作一个 Map 集合,Key-Value 形式,只不过 Value 是一个 Map,也就是 Key-Map(Key-Map

- String 类型存储对象需要将其序列化为 JSON 字符串后存储,如果需要修改对象的某个字段,比较不方便,只能修改整个 JSON 字符串。

- Hash 适合存储结构体信息(对象),Hash 可以对用户结构中的每个字段单独存储,可以针对结构中的单个字段进行 CRUD。

List

List:类似 Java 中的 LinkedList,可以看作一个双向链表(有序可重复)。使用 List 可以对链表的两端进行 push 和 pop 操作、读取单个或多个元素、根据值查找或删除元素、支持正向检索和反向检索。

- 时间线、队列、栈。

Set

点赞

假设文章 id 为 article1,用户 id 为 user1, user2。

# 点赞

> sadd like:article1 user1

> sadd like:article1 user2

# 取消点赞

> srem like:article1 user1

# 点赞数

> scard like:article1

(integer) 2

# 点赞用户

> smembers like:article1

1) "user1"

2) "user2"

关注

# 关注(user1 关注 user 2,user3 关注 user4)

> sadd follow:user1 user2

> sadd follow:user3 user4

# 互相关注

> sadd follow:user2 user1

> sadd follow:user4 user3

# 共同关注(user1 和 user2 共同关注 user3)

> sadd follow:user1 user3

> sadd follow:user2 user3

> sinter follow:user1 follow:user2

1) "user3"

# 可能认识的人(user1)

# user1 关注 user2,user2 关注 user1、user3、user4

> sadd follow:user1 user2

> sadd follow:user2 user1 user3 user4

# user1、user3 的并集 allFollow

> SUNIONSTORE allFollow follow:user1 follow:user2

> SMEMBERS allFollow

1) "user1"

2) "user3"

3) "user4"

4) "user2"

# 剔除 自身(user1) 和 已关注过的(user2)

> srem allFollow user1

> sdiff allFollow follow:user1

1) "user4"

2) "user3"

ZSet

百度搜索热点

# 2023-01-01 的热点新闻

> zadd hot:20230101 999 title1 777 title2 520 tag3

> ZRANGE hot:20230101 0 -1 withscores

1) "tag3"

2) "520"

3) "title2"

4) "777"

5) "title1"

6) "999"

# 点击量 +1

> ZINCRBY hot:20230101 1 title1

"1000"

3. RedisTemplate

SpringData 是 Spring 中数据操作的模块,包含对各种数据库的集成,其中对 Redis 的集成模块就叫做 SpringDataRedis。

SpringDataRedis 提供了对不同 Redis 客户端的整合(Lettuce 和 Jedis),通过 RedisTemplate 统一 API 操作 Redis。

通过 RedisTemplate 的 opsForValue()、opsForHash()、opsForList()、opsForSet()、opsForZSet() 方法可以操作 String、Hash、List、Set、ZSet 类型的数据。

3.1 RedisTemplate 的使用

导入 spring-boot-starter-data-redis 和 commons-pool2(Redis 连接池) 依赖,并且配置相关信息。

spring:

redis:

host: 127.0.0.1

password: root

port: 6379

lettuce:

pool:

max-active: 8 # 最大连接数

max-idle: 8 # 最大空闲数

min-idle: 0 # 最小空闲数

max-wait: 100 # 连接等待时间

注入 RestTemplate,测试。

// 自动注入的 `RedisTemplate` 需要加上泛型

@Resource

private RedisTemplate redisTemplate;

@Test

public void test() {

redisTemplate.opsForValue().set("k1", "v1");

Map<String, String> map = new HashMap<>();

map.put("k2", "v2");

map.put("k3", "v3");

map.put("k4", "v4");

map.put("k5", "v5");

redisTemplate.opsForValue().multiSet(map);

redisTemplate.opsForValue().multiGet(Arrays.asList("k1", "k2", "k3", "k4")).forEach(System.out::println); // v1 v2 v3 v4 v5

}

# 在 Redis 中查看通过 RedisTemplate 插入的数据

> keys *

1) "\xac\xed\x00\x05t\x00\x02k1"

2) "\xac\xed\x00\x05t\x00\x02k2"

3) "\xac\xed\x00\x05t\x00\x02k3"

4) "\xac\xed\x00\x05t\x00\x02k4"

5) "\xac\xed\x00\x05t\x00\x02k5"

> get "\xac\xed\x00\x05t\x00\x02k1"

"\xac\xed\x00\x05t\x00\x02v1"

3.1 RedisTemplate 存在的问题

通过以上操作可以发现:RedisTemplate 可以将任意类型的数据写入到 Redis 中,在写入前会将其序列化为字节形式存储,底层默认采用 ObjectOutputStream 序列化。

但是,可读性差,内存占用大。

自定义 RedisTemplate 的序列化方式

导入 jackson-databind 依赖,并编写配置类 RedisTemplateConfig。

@Configuration

public class RedisTemplateConfig {

@Bean

public RedisTemplate<String, Object> redisTemplate(RedisConnectionFactory redisConnectionFactory) {

// 创建 RedisTemplate 对象

RedisTemplate<String, Object> redisTemplate = new RedisTemplate<>();

// 设置连接工厂

redisTemplate.setConnectionFactory(redisConnectionFactory);

// 设置序列化工具

GenericJackson2JsonRedisSerializer jsonRedisSerializer = new GenericJackson2JsonRedisSerializer();

// Key 和 HashKey 采用 String 序列化(StringRedisSerializer)

redisTemplate.setKeySerializer(RedisSerializer.string());

redisTemplate.setHashKeySerializer(RedisSerializer.string());

// Value 和 HashValue 采用 JSON 序列化(GenericJackson2JsonRedisSerializer)

redisTemplate.setValueSerializer(jsonRedisSerializer);

redisTemplate.setHashValueSerializer(jsonRedisSerializer);

return redisTemplate;

}

}

// 自动注入的 `RedisTemplate` 需要加上泛型

@Autowired

private RedisTemplate<String, Object> redisTemplate;

@Test

public void test() {

redisTemplate.opsForValue().set("k1", "v1");

redisTemplate.opsForValue().set("user:1", new User("Jack", 21));

}

通过以上的方法能够解决数据序列化时 可读性差、内存占用大 的问题。

但是 JSON 的序列化方式仍然存在一些问题:为了反序列化时知道对象的类型,JSON 序列化器会将类的 class 类型写入 JSON 结果,存入 Redis 中,会带来额外的内存开销。

{

"@class": "com.sun.entity.User",

"username": "Jack",

"age": 21

}

3.3 StringRedisTemplate

为了节省内存空间,Spring 提供了一个 StringRedisTemplate,它的 key 和 value 的序列化方式默认就是 String,统一使用 String 序列化器。

当需要存储 Java 对象时,手动完成对象的序列化和反序列化。

- 使用 StringRedisTemplate。

- 写入数据到 Redis 中,手动将对象序列化为 JSON。

- 从 Redis 中读取数据,手动将读取到的 JSON 反序列化为对象。

@Autowired

private StringRedisTemplate stringRedisTemplate;

private static final ObjectMapper objectMapper = new ObjectMapper();

@Test

public void ttt() throws JsonProcessingException {

User user = new User("Michael", 27);

// 手动序列化

String json = objectMapper.writeValueAsString(user);

// 写入数据

stringRedisTemplate.opsForValue().set("user:1", json);

// 读取数据

String data = stringRedisTemplate.opsForValue().get("user:1");

// 反序列化

User deserializedUser = objectMapper.readValue(data, User.class);

System.out.println(deserializedUser);

}

{

"username": "Michael",

"age": 27

}

4. 短信登录

项目准备

后端代码导入

git clone https://gitee.com/sjd75/comment.git

前端代码导入

Windows:在 nginx 目录下打开 CMD 窗口,输入 start nginx.exe;

Mac OS:

brew install nginx

# 查看 Nginx 安装地址

brew info nginx

/opt/homebrew/var/www

/opt/homebrew/etc/nginx/nginx.conf

# 将前端项目中 html/hmdp 复制到 /opt/homebrew/var/www 中

# 将前端项目中 conf/nginx.conf 复制到 /opt/homebrew/etc/nginx/nginx.conf 替换并修改

# 启动服务

sudo nginx

# 停止服务

sudo nginx -s stop

ThrowUtils

/**

* 抛异常工具类(条件成立则抛异常)

*/

public class ThrowUtils {

public static void throwIf(boolean condition, RuntimeException runtimeException) {

if (condition) {

throw runtimeException;

}

}

public static void throwIf(boolean condition, ErrorCode errorCode) {

throwIf(condition, new BusinessException(errorCode));

}

public static void throwIf(boolean condition, ErrorCode errorCode, String message) {

throwIf(condition, new BusinessException(errorCode, message));

}

}

Hutool 相关方法

BeanToMap 方法

// 使用 CopyOptions 处理字段值

Map<String, Object> map4UserDTO = BeanUtil.beanToMap(userDTO, new HashMap<>(),

CopyOptions.create()

// 是否忽略值为空的字段

.setIgnoreNullValue(true)

// StringRedisTemplate 只支持 String 类型,将属性转换为 String 后再存储到 Map 中(该方法优先级更高,此处也需要判空)

.setFieldValueEditor((fieldName, fieldValue) -> {

if (null == fieldValue) {

return "";

}

return fieldValue.toString();

})

);

// 封装一下

public class BeanMapUtil {

public static <T> Map<String, Object> beantoMap(T t) {

return BeanUtil.beanToMap(t, new HashMap<>(32),

CopyOptions.create()

.setIgnoreNullValue(true)

.setFieldValueEditor((fieldName, fieldValue) -> {

if (null == fieldValue) {

return "";

}

return fieldValue.toString();

})

);

}

}

fillBeanWithMap 方法

/**

* 使用 Map 填充 Bean 对象

*

* @param Bean 类型

* @param map Map

* @param bean Bean

* @param isIgnoreError 是否忽略注入错误

* @return Bean

*/

UserDTO userDTO = new UserDTO();

userDTO = BeanUtil.fillBeanWithMap(map4UserDTO, userDTO, false);

JSON 转换为 List

List<Shop> shopList = JSONUtil.toList(JSONUtil.parseArray(jsonStr), ShopType.class);

4.1 基于 Session 实现登录

4.1.1 发送验证码

前端发送请求,提交手机号。

校验手机号是否合格,合格则生成验证码并保存到 Redis 中,然后发送验证码。

/**

* 发送手机验证码并将手机号和验证码保存到 Session 中

*/

@PostMapping("/code")

public CommonResult<String> sendCode(@RequestParam("phone") String phone) {

return userService.sendCode(phone);

}

@Override

public CommonResult<String> sendCode(String phone, HttpSession httpSession) {

// 1. 校验手机号

ThrowUtils.throwIf(StringUtils.isBlank(phone), ErrorCode.PARAMS_ERROR);

ThrowUtils.throwIf(Boolean.TRUE.equals(RegexUtils.isPhoneInvalid(phone)), ErrorCode.PARAMS_ERROR, "该手机号不合法");

httpSession.setAttribute("phone", phone);

// 2. 手机号格式正确,则生成验证码并保存到 Session 中

String captcha = RandomUtil.randomNumbers(6);

httpSession.setAttribute("captcha", captcha);

// 3. 发送验证码

// todo 暂时不接入第三方短信 API 接口

log.debug("captcha: {}", captcha);

return CommonResult.success("验证码发送成功");

}

4.1.2 登录和注册

前端发送请求,提交手机号和验证码。

- 校验手机号和验证码是否合格:合格后从 Redis 中获取该手机号对应的验证码,然后进行比对。

- 比对不一致则登录失败;比对一致则根据手机号查询用户。

- 用户不存在则创建新用户,并将其用户信息存入 Session,登录成功。

- 用户存在则直接将用户信息存入 Session,登录成功。

/**

* 登录功能

* @param loginForm 登录请求的参数:手机号、验证码(验证码登录);或者手机号、密码(密码登录)。

*/

@PostMapping("/login")

public CommonResult<String> login(@RequestBody LoginFormDTO loginForm){

return userService.login(loginForm);

}

@Override

public CommonResult<String> login(LoginFormDTO loginForm, HttpSession session) {

// 1. 校验手机号

// 1. 校验请求参数

String loginPhone = loginForm.getPhone();

String loginCaptcha = loginForm.getCode();

String phone = (String) session.getAttribute("phone");

ThrowUtils.throwIf(StringUtils.isAnyBlank(loginPhone, loginCaptcha), ErrorCode.PARAMS_ERROR, "手机号和验证码不能为空");

ThrowUtils.throwIf(Boolean.FALSE.equals(RegexUtils.isPhoneInvalid(loginPhone)), ErrorCode.PARAMS_ERROR, "该手机号不合法");

ThrowUtils.throwIf(!StrUtil.equals(loginPhone, phone), ErrorCode.PARAMS_ERROR, "两次输入的手机号不相同");

// 2. 校验验证码是否正确

String captcha = (String) session.getAttribute("captcha");

ThrowUtils.throwIf(!StringUtils.equals(loginCaptcha, captcha), ErrorCode.PARAMS_ERROR, "验证码错误");

// 3. 判断当前手机号是否已注册(未注册则创建新用户)

User user = this.lambdaQuery().eq(User::getPhone, loginPhone).one();

if (user == null) {

user = createNewUser(user, loginPhone);

}

// 4. 存在则将用户保存到 Session 中(保证存入 Session 中的用户信息不包含敏感信息,使用 UserDTO)

UserDTO userDTO = BeanUtil.copyProperties(user, UserDTO.class);

session.setAttribute("user", userDTO);

return CommonResult.success("登录成功");

}

/**

* 根据手机号创建用户

*/

private User createNewUser(User user, String loginPhone) {

user = new User();

user.setPhone(loginPhone);

// 为 Nickname 设置前缀(USER_NICK_NAME_PREFIX = "user_")

user.setNickName(USER_NICK_NAME_PREFIX + RandomUtil.randomString(10));

boolean result = this.save(user);

ThrowUtils.throwIf(!result, ErrorCode.OPERATION_ERROR);

return user;

}

4.1.3 登录验证(拦截器)

登录拦截器负责拦截需要登录的请求:从 Session 中获取用户信息,用户信息不为空则将用户信息存入 ThreadLocal 中即可;否则直接拦截。

ThreadLocal

线程安全问题的核心在于多个线程会对同一个临界区共享资源进行操作,如果每个线程都使用自己的「共享资源」,即多个线程间达到隔离的状态,这样就不会出现线程安全的问题。

ThreadLocal 表示线程的「本地变量」,即每个线程都拥有该变量副本,人手一份、各用各的,这样就可以避免共享资源的竞争。

每个 Thread 中都具备⼀个 ThreadLocalMap ,⽽ ThreadLocalMap 可以存储以 ThreadLocal 为 key ,Object 对象为 value。(可以理解为 key 为当前线程,value 为变量值)

public class MyThreadLocal<T> {

private Map<Thread, T> map = new HashMap<>();

// 设置当前线程的局部变量值

public void set(T t) {

map.put(Thread.currentThread(), t);

}

// 返回当前线程对应的局部变量值

public T get() {

return map.get(Th read.currentThread());

}

// 移除当前线程对应的局部变量值

public void remove() {

map.remove(Thread.currentThread());

}

}

public class UserHolder {

private static final ThreadLocal<UserDTO> threadLocal = new ThreadLocal<>();

public static void saveUser(UserDTO user){

threadLocal.set(user);

}

public static UserDTO getUser(){

return threadLocal.get();

}

public static void removeUser(){

threadLocal.remove();

}

}

登录拦截器

@Component

public class LoginInterceptor implements HandlerInterceptor {

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

UserDTO user = (UserDTO) request.getSession().getAttribute("user");

if (user == null) {

response.setStatus(HttpServletResponse.SC_UNAUTHORIZED); // 401

return false;

}

UserHolder.saveUser(user);

return true;

}

@Override

public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) throws Exception {

// 线程处理完之后移除用户,防止内存泄漏

UserHolder.removeUser();

}

}

配置拦截器

@Configuration

public class WebMvcConfiguration implements WebMvcConfigurer {

@Resource

private LoginInterceptor loginInterceptor;

@Override

public void addInterceptors(InterceptorRegistry registry) {

registry.addInterceptor(loginInterceptor).excludePathPatterns(

"/shop/**", "/shop-type/**", "/upload/**", "/voucher/**",

"/blog/hot", "/user/login", "/user/code"

);

}

}

/**

* 获取当前登录的用户并返回

*/

@GetMapping("/me")

public CommonResult<UserDTO> me(){

return CommonResult.success(UserHolder.getUser());

}

登录成功后需要将用户信息存储到 Session 中,存储的是 UserDTO;通过拦截器中的 ThreadLocal 获取用户信息,获取到的也是 UserDTO;在 Controller 中通过 ThreadLocal 获取用户信息后返回,返回的也是 UserDTO。

这样做是为了隐藏敏感信息,不能将整个 User 对象返回,而是返回一个 UserDTO 对象(仅包含 id、nickName、icon 属性),存入 Session 中的用户信息也应该是一个 UserDTO。

4.2 登录的实现方案

4.2.1 Session

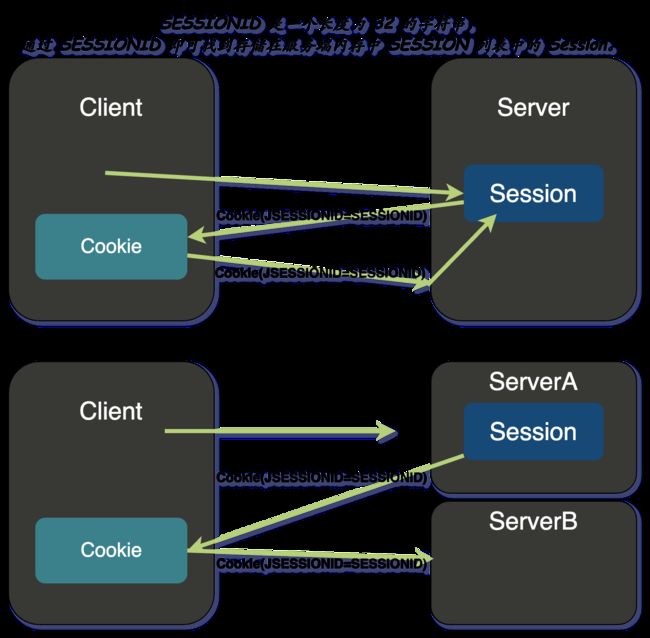

Session 的原理

- 客户端发送请求,服务器将登录信息存储在 Session 中,Session 依赖于 Cookie,即服务器创建 Session 时会分配一个 SESSIONID,并在响应时将这个 SESSIONID 存储到 Cookie 中。

- 客户端收到这个 Cookie 后自动保存,并在下次访问时带上这个 Cookie,届时服务器就能通过这个 Cookie 中的 SESSIONID 找到对应的 Session 从而识别用户。

对于分布式系统而言,服务器之间是隔离的,Session 是不共享的,存在 Session 共享问题。

- 客户端第一次访问服务器,请求被分发到了 ServerA 上,ServerA 会为该客户端创建 Session。

- 客户端再次访问服务器,请求被分发到 ServerB 上,ServerB 中没有这个客户端携带的 SESSIONID 对应的 Session,用户身份无法得到验证,从而产生了「不一致」的问题。

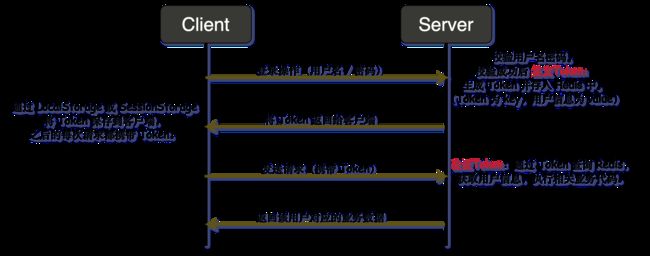

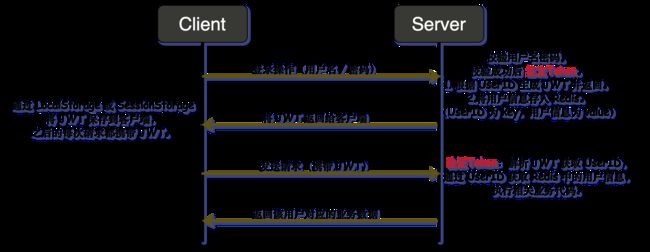

4.2.2 Redis + Token

- 客户端通过账号密码登录。

- 服务器通过查询数据库进行验证。

- 验证成功后 签发 Token(创建一个 Token 存储在 Redis 中),并在响应时将这个 Token 返回给客户端。

- 客户端收到这个 Token 后将其保存到 SessionStorage 或 LocalStorage(浏览器的一种存储方式),并在下次访问时带上这个 Token。

- Token 和 SESSIONID 作用相同,只是由服务器实现转变为由我们自己创建一个 Token 存储到 Cookie 中返回给客户端,并同时存储到 Redis 中。

- Token 令牌:服务端生成的一串加密字符串,作为客户端请求时的一个标识。

- 客户端再次访问服务器时携带 Token。服务器 验证 Token:通过请求头中的 Token 查询 Redis 中存储的用户信息即可识别用户。

4.2.3 Redis + JWT

JWT (Json Web Token),JWT 由三部分组成:Header(加密算法和 Token 类型)、Playload(数据)、Sinature。

// Decoded

header = {

"alg": "HS256",

"typ": "JWT"

}

playload = {

"sub": "1234567890",

"name": "John Doe",

"iat": 1516239022

}

signature = HMACSHA256(base64UrlEncode(header) + "." + base64UrlEncode(payload), 签名Secret)

// Encoded

eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiIxMjM0NTY3ODkwIiwibmFtZSI6IkpvaG4gRG9lIiwiaWF0IjoxNTE2MjM5MDIyfQ.7hQ9doI17Q47YK31oBIf-etsfFTVhSK9wwqgoOOr_zs

编码后的内容(分为三个部分,每个部分之间用 . 连接)

- Header 经过 BASE64 编码后生成字符串。

- Playload 经过 BASE64 编码后生成字符串。

- 第三部分内容通过 Signature 表达式可以得到:前两部分内容 + 密钥,HS256 算法进行加密签名。

普通 Token 和 JWT 的区别主要体现在 签发 Token 和 验证 Token。

- 普通 Token 的签发:验证通过后,服务器可以通过 UUID 生成一个字符串作为 Token 或者 对账号密码加密生成一个字符串,存储到 Redis 中并返回给客户端。

- 普通 Token 的验证:客户端发送请求时携带 Token,服务器对请求头中的 Token 与 Redis 中存储的 Token 进行对比。

- JWT 的签发:对 Header、Playload 进行 BASE64 编码得到两个字符串,前两部分内容用点连接;将前两部分合起来与密钥通过 HS256 算法加密签名。

- JWT 的验证:客户端发送请求时携带 JWT,获取 JWT 前两段内容,将其与密钥通过 HS256 算法加密签名;签名后的结果与 JWT 中第三段内容进行对比。

Redis + JWT

- 客户端通过账号密码登录。

- 服务器通过查询数据库进行验证。

- 验证成功后 签发 Token(根据 UserID 创建一个 JWT),并在响应时将这个 JWT 返回给客户端。

- 注意,此处存储到 Redis 中的是 以 UserID 为 key,用户信息为 value。

- 客户端收到这个 JWT 后将其保存到 SessionStorage 或 LocalStorage(浏览器的一种存储方式),并在下次访问时带上这个 JWT。

- 客户端再次访问服务器时携带 JWT。服务器 验证 Token:解析请求头中的 JWT 获取 UserID,根据 UserID 查询 Redis 中存储的用户信息即可识别用户。

4.3 基于 Redis + Token 实现登录

4.3.1 发送验证码 / 登录和注册

/**

* 发送手机验证码并将验证码保存到 Redis 中

*/

@PostMapping("/code")

public CommonResult<String> sendCode(@RequestParam("phone") String phone) {

return userService.sendCode(phone);

}

/**

* 登录功能(登录成功后返回 Token)

* @param loginForm 登录请求的参数:手机号、验证码(验证码登录);或者手机号、密码(密码登录)。

*/

@PostMapping("/login")

public CommonResult<String> login(@RequestBody LoginFormDTO loginForm){

return userService.login(loginForm);

}

@Slf4j

@Service

public class UserServiceImpl extends ServiceImpl<UserMapper, User> implements UserService {

@Resource

private StringRedisTemplate stringRedisTemplate;

/**

* 发送手机验证码并将验证码保存到 Redis 中

*/

@Override

public CommonResult<String> sendCode(String phone) {

// 1. 验证手机号

ThrowUtils.throwIf(StringUtils.isBlank(phone), ErrorCode.PARAMS_ERROR);

ThrowUtils.throwIf(Boolean.TRUE.equals(RegexUtils.isPhoneInvalid(phone)), ErrorCode.PARAMS_ERROR, "该手机号不合法");

// 2. 生成验证码并存入 Redis(设置过期时间为 2 min)

String captcha = RandomUtil.randomNumbers(6);

stringRedisTemplate.opsForValue().set(LOGIN_CAPTCHA_KEY + phone, captcha, TTL_TWO, TimeUnit.MINUTES);

// 3. 发送验证码

// todo 暂时不接入第三方短信 API 接口

log.info("captcha = {}", captcha);

return CommonResult.success("验证码发送成功");

}

/**

* 登录功能(登录成功后返回 Token)

* @param loginForm 登录请求的参数:手机号、验证码(验证码登录);或者手机号、密码(密码登录)。

*/

@Override

public CommonResult<String> login(LoginFormDTO loginForm) {

// 1. 校验请求参数

String loginPhone = loginForm.getPhone();

String loginCaptcha = loginForm.getCode();

ThrowUtils.throwIf(StringUtils.isAnyBlank(loginPhone, loginCaptcha), ErrorCode.PARAMS_ERROR, "手机号和验证码不能为空");

ThrowUtils.throwIf(Boolean.TRUE.equals(RegexUtils.isPhoneInvalid(loginPhone)), ErrorCode.PARAMS_ERROR, "该手机号不合法");

// 2. 从 Redis 中获取该手机号对应的验证码,并进行比对

String captcha = stringRedisTemplate.opsForValue().get(LOGIN_CAPTCHA_KEY + loginPhone);

ThrowUtils.throwIf(!StringUtils.equals(loginCaptcha, captcha), ErrorCode.PARAMS_ERROR, "验证码错误");

// 3. 判断当前手机号是否已注册(未注册则创建新用户)

User user = this.lambdaQuery().eq(User::getPhone, loginPhone).one();

if (user == null) {

user = createNewUser(user, loginPhone);

}

// 4. 避免敏感信息泄漏,用一个 UserDTO 装载必要信息即可

UserDTO userDTO = BeanUtil.copyProperties(user, UserDTO.class);

// 5. 随机生成 Token 作为登录令牌

String token = UUID.randomUUID().toString(true);

String loginUserKey = LOGIN_USER_KEY + token;

// 6. 保存用户信息到 Redis 中并设置有效时间。(使用 Hash 存储 User 对象)

Map<String, Object> map4User = BeanUtil.beanToMap(userDTO, new HashMap<>(16),

CopyOptions.create()

// 忽略空值,当源对象为 null 时,不注入此值

.ignoreNullValue()

// StringRedisTemplate 只支持 String 类型,将属性转换为 String 后再存储到 Map 中(此处也需要判空)

.setFieldValueEditor((fieldName, fieldValue) -> {

if (fieldValue == null) {

return "";

}

return fieldValue.toString();

})

);

stringRedisTemplate.opsForHash().putAll(loginUserKey, map4User);

stringRedisTemplate.expire(loginUserKey, TTL_THIRTY, TimeUnit.MINUTES);

return CommonResult.success(token);

}

/**

* 根据手机号创建用户

*/

private User createNewUser(User user, String loginPhone) {

user = new User();

user.setPhone(loginPhone);

// 为 Nickname 设置前缀(USER_NICK_NAME_PREFIX = "user_")

user.setNickName(USER_NICK_NAME_PREFIX + RandomUtil.randomString(10));

boolean result = this.save(user);

ThrowUtils.throwIf(!result, ErrorCode.OPERATION_ERROR);

return user;

}

}

4.3.2 前端对 Token 的处理

- 用户登录成功后返回 Token 给客户端,客户端将 Token 存储到 SessionStorage(浏览器的一种存储方式)。

- 通过 request 拦截器,将 SessionStorage 中的 Token 放入请求头中。每次发送请求,请求头中都会携带这个 Token 头部信息。

login(){

if(!this.radio){

this.$message.error("请先确认阅读用户协议!");

return

}

if(!this.form.phone || !this.form.code){

this.$message.error("手机号和验证码不能为空!");

return

}

axios.post("/user/login", this.form).then(({data}) => {

if(data){

// 将 Token 保存到 SessionStorage(浏览器的一种存储方式)

sessionStorage.setItem("token", data);

}

location.href = "/index.html"

}).catch(err => this.$message.error(err))

}

// request 拦截器,将 Token 放入请求头中

let token = sessionStorage.getItem("token");

axios.interceptors.request.use(

config => {

if(token) config.headers['authorization'] = token

return config

},

error => {

console.log(error)

return Promise.reject(error)

}

)

4.3.2 登录验证(拦截器)

默认情况下,30 分钟后未访问 Session 会自动销毁。对于 Token 而言,也需要一个这样的机制,即 只要有访问就刷新(重置) Token 的有效期,通过拦截器实现。

- 第一个拦截器拦截所有请求,只要携带 Token 访问页面就刷新 Token 的有效期,然后将从 Redis 中获取 Token 对应的用户信息并存入 ThreadLocal 中。否则执行放行。

- 第二个拦截器针对需要登录的请求,只需要判断 ThreadLocal 中是否存在用户信息即可。

@Component

public class RefreshTokenInterceptor implements HandlerInterceptor {

@Resource

private StringRedisTemplate stringRedisTemplate;

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

// 1. 从请求头中获取 Token

String token = request.getHeader("authorization");

if (StrUtil.isBlank(token)) {

// 直接放行

return true;

}

// 2. 根据 Token 获取 Redis 中存储的用户信息

String loginUserKey = LOGIN_USER_KEY + token;

// entries(key):返回 key 对应的所有 Map 键值对

Map<Object, Object> map4UserDTO = stringRedisTemplate.opsForHash().entries(loginUserKey);

if (MapUtil.isEmpty(map4UserDTO)) {

// 直接放行

return true;

}

// 3. 将 Map 转换为 UserDTO(第三个参数 isIgnoreError:是否忽略注入错误)后,存入 ThreadLocal

UserDTO userDTO = new UserDTO();

userDTO = BeanUtil.fillBeanWithMap(map4UserDTO, userDTO, false);

UserHolder.saveUser(userDTO);

// 4. 刷新 Token 有效期

stringRedisTemplate.expire(loginUserKey, TTL_THIRTY, TimeUnit.MINUTES);

return true;

}

@Override

public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) throws Exception {

// 线程处理完之后移除用户,防止内存泄漏

UserHolder.removeUser();

}

}

@Component

public class LoginInterceptor implements HandlerInterceptor {

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

// 判断 ThreadLocal 中是否有用户信息

if (ObjectUtil.isNull(UserHolder.getUser())) {

response.setStatus(HttpServletResponse.SC_UNAUTHORIZED);

return false;

}

return true;

}

}

@Configuration

public class WebMvcConfiguration implements WebMvcConfigurer {

@Resource

private RefreshTokenInterceptor refreshTokenInterceptor;

@Resource

private LoginInterceptor loginInterceptor;

@Override

public void addInterceptors(InterceptorRegistry registry) {

registry.addInterceptor(refreshTokenInterceptor).addPathPatterns("/**").order(0);

registry.addInterceptor(loginInterceptor).excludePathPatterns(

"/shop/**", "/shop-type/**", "/upload/**", "/voucher/**",

"/blog/hot", "/user/login", "/user/code"

).order(1);

}

}

5. 缓存

缓存:一种介于数据永久存储介质和数据应用之间的临时存储介质,也就是 存储在内存中的临时数据,读写性能很高。缓存通过减少 IO 的方式来提高程序的执行效率。

5.1 添加缓存

客户端发送请求,根据请求参数先从 Redis 中获取数据。

- 命中 则直接返回数据。

- 未命中 则从数据库中查询数据(需要判断数据库中是否存在数据),将查询到的数据写入到缓存中后返回数据。

5.1.1 /shop/{id}

/**

* 根据 id 查询商铺信息(添加缓存)

*/

@GetMapping("/{id}")

public CommonResult<Shop> getShopById(@PathVariable("id") Long id) {

return shopService.getShopById(id);

}

// 采用 Hash 存储

@Override

public CommonResult<Shop> getShopById(Long id) {

ThrowUtils.throwIf(id == null, ErrorCode.PARAMS_ERROR);

String shopKey = CACHE_SHOP_KEY + id; // CACHE_SHOP_KEY = "cache:shop:"

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

Map<Object, Object> map4ShopInRedis = stringRedisTemplate.opsForHash().entries(shopKey);

Shop shop = new Shop();

if (MapUtil.isNotEmpty(map4ShopInRedis)) {

shop = BeanUtil.fillBeanWithMap(map4ShopInRedis, shop, false);

return CommonResult.success(shop);

}

// 2. 从 Redis 中未查询到数据,则从数据库中查询

shop = this.getById(id);

ThrowUtils.throwIf(shop == null, ErrorCode.NOT_FOUND_ERROR, "该商铺不存在");

// 3. 将从数据库中查询到的数据存入 Redis 后返回

Map<String, Object> map4Shop = BeanUtil.beanToMap(shop, new HashMap<>(32),

CopyOptions.create()

.ignoreNullValue()

.setFieldValueEditor((fieldName, fieldValue) -> {

if (fieldValue == null) {

return "";

}

return fieldValue.toString();

})

);

stringRedisTemplate.opsForHash().putAll(shopKey, map4Shop);

stringRedisTemplate.expire(shopKey, TTL_TWO, TimeUnit.HOURS);

return CommonResult.success(shop);

}

// 采用 String 存储

@Override

public CommonResult<Shop> getShopById(Long id) {

ThrowUtils.throwIf(id == null, ErrorCode.PARAMS_ERROR);

String shopKey = CACHE_SHOP_KEY + id;

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

String shopJsonInRedis = stringRedisTemplate.opsForValue().get(shopKey);

if (StringUtils.isNotBlank(shopJsonInRedis)) {

return CommonResult.success(JSONUtil.toBean(shopJsonInRedis, Shop.class));

}

// 2. 从 Redis 中未查询到数据,则从数据库中查询

Shop shop = this.getById(id);

ThrowUtils.throwIf(shop == null, ErrorCode.NOT_FOUND_ERROR, "该商铺不存在");

// 3. 将从数据库中查询到的数据存入 Redis 后返回

stringRedisTemplate.opsForValue().set(shopKey, JSONUtil.toJsonStr(shop), TTL_TWO, TimeUnit.HOURS);

return CommonResult.success(shop);

}

5.1.2 /shop-type/list

/**

* 展示商铺类型(缓存)

*/

@GetMapping("/list")

public CommonResult<List<ShopType>> getShopTypeList() {

return shopTypeService.getShopTypeList();

}

List(ShopType 类型的 List 转换为 JSON 类型的 List 后存入,从 Redis 中获取到的 List 是 JSON 类型的,转换为 ShopType 后返回)

@Override

public CommonResult<List<ShopType>> getShopTypeList() {

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

List<String> shopTypeJsonList = stringRedisTemplate.opsForList().range(CACHE_SHOP_TYPE_KEY, 0, -1);

List<ShopType> shopTypeList = new ArrayList<>();

if (CollectionUtil.isNotEmpty(shopTypeJsonList)) {

for (String shopTypeJsonInRedis : shopTypeJsonList) {

shopTypeList.add(JSONUtil.toBean(shopTypeJsonInRedis, ShopType.class));

}

return CommonResult.success(shopTypeList);

}

// 2. 从 Redis 中未查询到数据,则从数据库中查询

shopTypeList = this.lambdaQuery().orderByAsc(ShopType::getSort).list();

ThrowUtils.throwIf(CollectionUtil.isEmpty(shopTypeList), ErrorCode.NOT_FOUND_ERROR, "商铺类型列表不存在");

// 3. 将从数据库中查询到的数据存入 Redis 后返回

List<String> shopTypeListJson = shopTypeList.stream()

.map(shopType -> JSONUtil.toJsonStr(shopType))

.collect(Collectors.toList());

stringRedisTemplate.opsForList().leftPushAll(CACHE_SHOP_TYPE_KEY, shopTypeListJson);

stringRedisTemplate.expire(CACHE_SHOP_TYPE_KEY, TTL_TWO, TimeUnit.HOURS);

return CommonResult.success(shopTypeList);

}

String(JSON 转 List:JSONUtil.toList(JSONUtil.parseArray(jsonStr), ShopType.class))

@Override

public CommonResult<List<ShopType>> getShopTypeList() {

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

String shopTypeJsonInRedis = stringRedisTemplate.opsForValue().get(CACHE_SHOP_TYPE_KEY);

List<ShopType> shopTypeList = null;

if (StringUtils.isNotBlank(shopTypeJsonInRedis)) {

shopTypeList = JSONUtil.toList(JSONUtil.parseArray(shopTypeJsonInRedis), ShopType.class);

return CommonResult.success(shopTypeList);

}

// 2. 从 Redis 中未查询到数据,则从数据库中查询

shopTypeList = this.list();

ThrowUtils.throwIf(CollectionUtil.isEmpty(shopTypeList), ErrorCode.NOT_FOUND_ERROR, "商铺类型列表不存在");

// 3. 将从数据库中查询到的数据存入 Redis 后返回

stringRedisTemplate.opsForValue().set(CACHE_SHOP_TYPE_KEY, JSONUtil.toJsonStr(shopTypeList), TTL_TWO, TimeUnit.HOURS);

return CommonResult.success(shopTypeList);

}

5.2 数据过期策略

数据过期策略:对数据设置 TTL 时间后,超过了 TTL 时间就需要将数据从 Redis 中删除,可以按照不同规则删除。删除规则就是的数据过期策略。

Redis 的过期删除策略:惰性删除 + 定期删除,两种策略配合使用。

惰性删除:获取该 Key 时检查是否过期,未过期则返回,过期则删除。

- 对 CPU 友好,只有获取该 Key 时才会进行过期检查,不会浪费时间检查未使用到的 Key。

- 对内存不友好,如果一个 Key 已过期但未使用,该 Key 会一直存在在内存中而不会释放。

set name Jack 10

# 获取时判断该 Key 是否过期,过期则删除

get name

定期删除:每隔一段时间对 Redis 中的一部分 Key 进行检查,将其中过期的 Key 删除。(随着时间推移可以遍历一遍 Redis 中存储的 Key)

- SLOW 模式:该模式是一个定时任务,默认执行频率为 10hz(每秒清理 10 次),每次耗时不超过 25 ms。

- FAST 模式:执行频率不固定,但两次清理的间隔不低于 2 ms,每次耗时不超过 1ms。

定期删除可以通过限制删除执行的时长和频率减少删除操作对 CPU 的影响,也能释放过期 Key 占用的内存。但是难以确定删除执行的时长和频率。

5.3 数据淘汰策略

数据淘汰策略:当 Redis 中的内存不足时,此时再向 Redis 中添加新 Key,Redis 就会按照某种规则将内存中的数据淘汰(删除)。这种删除数据的规则就是数据淘汰策略。

Redis 支持 8 种数据淘汰策略

- noeviction(默认):内存不足时,不淘汰任何 Key,但是添加新 Key 会报错。

- volatile-ttl:比较设置了 TTL 时间的 Key 的 TTL 值,TTL 越小越先被淘汰。

- allkeys-random:对所有 Key,随机淘汰。

- volatile-random:对设置了 TTL 的 Key,随机淘汰。

- allkeys-lru(优先使用):对所有 Key,基于 LRU 算法淘汰。

- Least Recently Used 最近最少使用

- volatile-lru:对设置了 TTL 的 Key,基于 LRU 算法淘汰。

- allkeys-lfu:对所有 Key,基于 LFU 算法淘汰。

- Least Frequently Used 使用频率最小

- volatile-lfu:对设置了 TTL 的 Key,基于 LFU 算法淘汰。

若数据库中有 1000 条万数据,Redis 中只能缓存 20 万条数据,如何保证 Redis 中的数据都是热点数据:使用 allkeys-lru 数据淘汰策略。

5.4 数据更新策略

- 内存淘汰:Redis 内存达到设置的最大值时,触发数据淘汰机制。(默认存在,Redis 按照指定的淘汰策略自动执行)

- 一致性较差:这种方式无法控制淘汰哪些数据,可能有数据在数据库中发生了变化,但是未被淘汰,导致数据库和 Redis 中的数据不一致。

- 超时剔除:为缓存添加 TTL 时间,缓存超时后自动删除,下次查询时从数据库中查并更新缓存。

- 这种方式还是存在数据库和 Redis 的数据不一致,假设 TTL 时间为 30 分钟,在这 30 分钟之内若数据库中的数据发生变化,此时 Redis 和数据库数据依然不一致。

- 主动更新:手动调用方法删除缓存,可以用于解决缓存和数据库不一致问题。

操作缓存和数据库时需要考虑的三个问题

- 删除缓存还是更新缓存?

- 每次更新数据库的同时更新缓存:若数据库更新了 100 次,期间没有任何查询请求,此时缓存的更新就是无效操作。

- 数据库更新就删除缓存:数据库更新后缓存被删除,此时数据库无论更新多少次,缓存都不会做任何操作。直到有查询请求,缓存才会将数据库中的数据写入到缓存中。

- 如何保证缓存和数据库的操作同时成功或失败?

- 单体系统:将缓存与数据库操作放在一个事务。

- 分布式系统:利用 TCC 等分布式事务方案。

- 先操作缓存还是先操作数据库?

- 先删除缓存,再操作数据库。假设缓存为 10,数据库为 10。(t1、t2、t3 代表三个时刻)

- t1:线程 1 删除缓存,并更新数据库为 20。t2:线程 2 查询缓存未命中,从数据库中查询并写入缓存。✔️

- t1:线程 1 删除缓存。t2:线程 2 查询缓存未命中,从数据库中查询并写入缓存。t3:线程 t1 更新数据库为 20。❌

- **先操作数据库,再删除缓存。**假设缓存为 10,数据库为 10。(t1、t2、t3、t4 代表四个时刻)

- t1:线程 1 更新数据库为 20,删除缓存。t2:线程 2 查询缓存未命中,从数据库中查询并写入缓存。✔️

- t1:线程 1 查询缓存未命中,从数据库中查询。t2:线程 2 更新数据库为 20,删除缓存。t3:线程 1 写入缓存。❌(这种方式出现的概率很小,缓存写入的速度很快。更可能出现的情况是:线程 1 写入缓存后,线程 2 更新数据库然后将缓存删除)

- 先删除缓存,再操作数据库。假设缓存为 10,数据库为 10。(t1、t2、t3 代表三个时刻)

最佳方案

低一致性需求:使用 Redis 自带的数据淘汰机制。

高一致性需求:使用主动更新策略,并以超时剔除作为兜底方案。

- 读操作:缓存命中则直接返回;缓存未命中则查询数据库,并写入缓存,设定超时时间。

- 写操作:先操作数据库,再删缓存。(确保数据库与缓存操作的原子性)

为 /shop 接口添加缓存更新策略

/**

* 更新商铺信息(先操作数据库,后删除缓存)

*/

@PutMapping

public CommonResult<String> update(@RequestBody Shop shop) {

return shopService.update(shop);

}

@Transactional

@Override

public Result updateShop(Shop shop) {

if (ObjectUtil.isNull(shop.getId())) {

throw new RuntimeException("商铺 Id 不能为空");

}

boolean isUpdated = updateById(shop);

if (BooleanUtil.isFalse(isUpdated)) {

throw new RuntimeException("数据库更新失败");

}

Boolean isDeleted = redisTemplate.delete(CACHE_SHOP_KEY + shop.getId());

if (BooleanUtil.isFalse(isDeleted)) {

throw new RuntimeException("数据库更新成功,但是 Redis 删除失败");

}

return Result.ok();

}

// 1. 访问商铺 `localhost:8081/shop/1`,商铺信息被存储到 Redis 缓存中。

// 2. 修改商铺信息 `localhost:8081/shop`(PUT),数据库的数据发生变化、Redis 中存储的数据被删除。

{

"id": 1,

"name": "103茶餐厅"

}

5.5 缓存穿透

**客户端请求的数据在 Redis 和数据库中都不存在,缓存永远不会生效,请求永远都打在数据库上。**如果并发的发起大量的这种请求(恶意攻击),每次请求都查询数据库,可能导致数据库宕机(数据库能够承载的并发远不如 Redis)。

5.5.1 缓存空对象

客户端请求的数据在 Redis 和数据库中都不存在,为了防止不断的请求:将 空值 缓存到 Redis 中并且设置 TTL 时间后,返回给该请求。

- 缓存中包含过多的

空值,会造成额外的内存消耗。(设置 TTL 可以缓解) - 可能造成短期的不一致:第一次请求的数据在 Redis 和数据库中都不存在,缓存空对象后,数据库中新增了该请求对应的数据。

@Override

public CommonResult<Shop> getShopById(Long id) {

ThrowUtils.throwIf(id == null, ErrorCode.PARAMS_ERROR);

String shopKey = CACHE_SHOP_KEY + id;

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

String shopJsonInRedis = stringRedisTemplate.opsForValue().get(shopKey);

if (StringUtils.isNotBlank(shopJsonInRedis)) {

return CommonResult.success(JSONUtil.toBean(shopJsonInRedis, Shop.class));

}

// 命中空值

if (shopJsonInRedis != null) {

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR, "该商铺不存在");

}

// 2. 从 Redis 中未查询到数据,则从数据库中查询

Shop shop = this.getById(id);

// 若数据中也查询不到,则缓存空值后返回提示信息

if (shop == null) {

stringRedisTemplate.opsForValue().set(CACHE_SHOP_KEY + id, "", TTL_TWO, TimeUnit.MINUTES);

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR, "该商铺不存在");

}

// 3. 将从数据库中查询到的数据存入 Redis 后返回

stringRedisTemplate.opsForValue().set(shopKey, JSONUtil.toJsonStr(shop), TTL_TWO, TimeUnit.HOURS);

return CommonResult.success(shop);

}

5.5.2 布隆过滤器

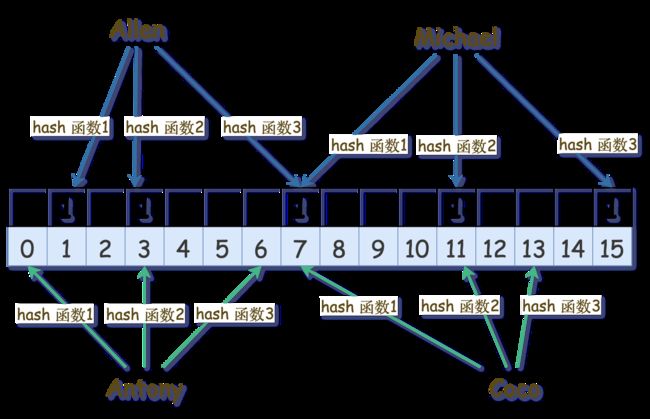

布隆过滤器(Bloom Filter):一个很长的二进制数组(初始化值为 0),通过一系列的 Hash 函数判断该数据是否存在。 布隆过滤器的运行速度快、内存占用小,但是存在误判的可能。

- 存储数据时经过 n 个 hash 函数,计算出 n 个 hash 值,hash 值映射后得到 n 个索引,设置索引处的值为 1。(若当前索引处值已经为 1,则不需要任何操作)

- 查询数据时也会经过 n 个 hash 函数,计算出 n 个 hash 值,hash 值映射后得到 n 个索引,判断索引处的值是否为 1。

- 查询 Anthony:经过 hash 算法得到的 hash 值映射后数组下标为 0、2、6,下标对应的值没有全为 1,数组中不存在该元素。

- 查询 Coco:经过 hash 算法得到的 hash 值映射后数组下标为 0、2、6,下标对应的值都为 1,数组中可能存在该元素。

请求进来先查询布隆过滤器,不存在则直接返回,存在则查询 Redis;命中则返回,否则查询数据库并写入 Redis 后返回。(预热缓存的同时需要预热布隆过滤器)

5.6 缓存雪崩

大量缓存同时过期,或者 Redis 服务宕机;导致大量的请求直接访问数据库,造成数据库瞬间压力过大、宕机。

- 缓存的 TTL 设置为随机值,避免同时失效。

- Redis 集群(针对 Redis 宕机)。

stringRedisTemplate.opsForValue().set(shopKey, JSONUtil.toJsonStr(shop), TTL_THIRTY + RandomUtil.randomInt(30), TimeUnit.MINUTES);

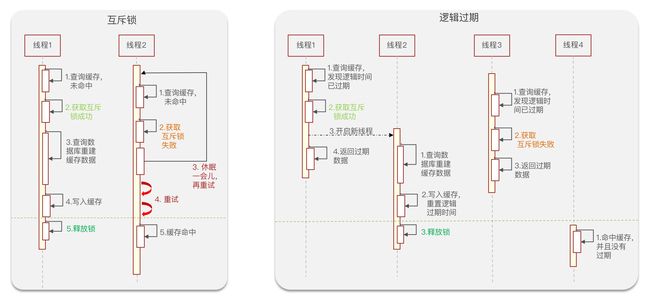

5.7 缓存击穿

缓存击穿问题也叫热点 Key 问题:一个被高并发访问的 Key 突然失效,在这个失效的瞬间大量请求穿过缓存直接请求数据库,给数据库带来巨大的冲击。

缓存击穿整体过程:

- 一个线程查询缓存,未命中,查询数据库并重建缓存(缓存重建业务比较复杂,时间长)。

- 在这个重建缓存的过程中,大量的请求穿过缓存直接请求数据库并重建缓存,导致性能下降。

缓存击穿的解决方案:互斥锁(一致性)、逻辑过期(可用性)。

互斥锁的测试:使用 Jmeter 测试,创建线程组,线程数设置为 1000,Ramp-Up 时间为 5 秒。QPS(Query Per Second)为 200。

逻辑过期的测试:线程数设置为 1000,Ramp-Up 时间为 1 秒,先预热数据,过期后修改数据库,此时会经历短暂的数据不一致(重建缓存)。

5.7.1 synchronized

- 查询缓存,存在则直接返回。

- 不存在:执行 synchronized 代码块。

- 先查缓存,存在则直接返回。(若多个线程执行到同步代码块,某个线程拿到锁查询数据库并重建缓存后,其他拿到锁进来的线程直接查询缓存后返回,避免重复查询数据库并重建缓存)

- 查询数据库,重建缓存。

@SneakyThrows

@Override

public CommonResult<Shop> getShopById(Long id) {

ThrowUtils.throwIf(id == null, ErrorCode.PARAMS_ERROR);

String shopKey = CACHE_SHOP_KEY + id;

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

String shopJsonInRedis = stringRedisTemplate.opsForValue().get(shopKey);

if (StringUtils.isNotBlank(shopJsonInRedis)) {

return CommonResult.success(JSONUtil.toBean(shopJsonInRedis, Shop.class));

}

// 命中空值

if (shopJsonInRedis != null) {

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR, "该商铺不存在");

}

// 2. 从 Redis 中未查询到数据,则从数据库中查询。(synchronized)

Shop shop = new Shop();

synchronized (ShopServiceImpl.class) {

// 3. 再次查询 Redis:若多个线程执行到同步代码块,某个线程拿到锁查询数据库并重建缓存后,其他拿到锁进来的线程直接查询缓存后返回,避免重复查询数据库并重建缓存。

shopJsonInRedis = stringRedisTemplate.opsForValue().get(shopKey);

if (StringUtils.isNotBlank(shopJsonInRedis)) {

return CommonResult.success(JSONUtil.toBean(shopJsonInRedis, Shop.class));

}

// 4. 查询数据库,缓存空值避免缓存穿透,重建缓存。

shop = this.getById(id);

if (shop == null) {

stringRedisTemplate.opsForValue().set(CACHE_SHOP_KEY + id, "", TTL_TWO, TimeUnit.MINUTES);

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR, "该商铺不存在");

}

// 模拟缓存重建延迟

Thread.sleep(100);

stringRedisTemplate.opsForValue().set(shopKey, JSONUtil.toJsonStr(shop), TTL_TWO, TimeUnit.HOURS);

}

return CommonResult.success(shop);

}

5.7.2 setnx

利用 Redis 的 setnx 方法来表示获取锁(Redis 中没有这个 Key,可以成功插入;如果有这个 Key,则插入失败),直接删除这个 Key 表示释放锁。

/**

* 获取互斥锁

*/

public boolean tryLock(String key) {

Boolean result = stringRedisTemplate.opsForValue().setIfAbsent(key, "1", TTL_TWO, TimeUnit.SECONDS);

return Boolean.TRUE.equals(result);

}

/**

* 释放互斥锁

*/

public void unlock(String key) {

stringRedisTemplate.delete(key);

}

@SneakyThrows

@Override

public CommonResult<Shop> getShopById(Long id) {

ThrowUtils.throwIf(id == null, ErrorCode.PARAMS_ERROR);

String shopKey = CACHE_SHOP_KEY + id;

String lockKey = LOCK_SHOP_KEY + id;

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

String shopJsonInRedis = stringRedisTemplate.opsForValue().get(shopKey);

if (StringUtils.isNotBlank(shopJsonInRedis)) {

return CommonResult.success(JSONUtil.toBean(shopJsonInRedis, Shop.class));

}

// 命中空值

if (shopJsonInRedis != null) {

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR, "该商铺不存在");

}

// 2. 从 Redis 中未查询到数据,尝试获取锁后从数据库中查询。

Shop shop = new Shop();

boolean tryLock = tryLock(lockKey);

try {

// 2.1 未获取到锁则等待一段时间后重试(通过递归调用重试)

if (BooleanUtil.isFalse(tryLock)) {

Thread.sleep(50);

this.getShopById(id);

}

// 2.2 获取到锁:查询数据库、缓存重建。

if (tryLock) {

// 3. 再次查询 Redis:若多个线程执行到获取锁处,某个线程拿到锁查询数据库并重建缓存后,其他拿到锁进来的线程直接查询缓存后返回,避免重复查询数据库并重建缓存。

shopJsonInRedis = stringRedisTemplate.opsForValue().get(shopKey);

if (StringUtils.isNotBlank(shopJsonInRedis)) {

return CommonResult.success(JSONUtil.toBean(shopJsonInRedis, Shop.class));

}

// 4. 查询数据库,缓存空值避免缓存穿透,重建缓存。

shop = this.getById(id);

if (shop == null) {

stringRedisTemplate.opsForValue().set(CACHE_SHOP_KEY + id, "", TTL_TWO, TimeUnit.MINUTES);

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR, "该商铺不存在");

}

// 模拟缓存重建延迟

Thread.sleep(100);

stringRedisTemplate.opsForValue().set(shopKey, JSONUtil.toJsonStr(shop), TTL_TWO, TimeUnit.HOURS);

}

} finally {

// 5. 释放锁

unlock(lockKey);

}

return CommonResult.success(shop);

}

5.7.3 逻辑过期

无需考虑缓存雪崩(Redis 宕机除外)、缓存穿透问题:缓存何时过期通过代码控制而非 TTL。需要进行数据预热,缓存未命中时直接返回空。

- 先查询缓存,未命中则直接返回。

- 命中则判断缓存是否过期,未过期则直接返回。

- 过期:获取锁。

- 未获取到锁:直接返回。

- 获取到锁:开启一个新的线程后直接返回,这个线程负责重建缓存后释放锁。

缓存预热(将热点数据提前存储到 Redis 中)

存储到 Redis 中的 Key 永久有效,过期时间通过代码控制而非 TTL。Redis 存储的数据需要带上一个逻辑过期时间,即 Shop 实体类中需要一个逻辑过期时间属性。新建一个 RedisData,该类包含两个属性 expireTime 和 Data,对原来的代码没有入侵性。

@Data

public class RedisData {

private LocalDateTime expireTime;

private Object data;

}

/**

* 缓存预热(将热点数据提前存储到 Redis 中)

*/

public void saveHotDataIn2Redis(Long id, Long expireSeconds) {

Shop shop = this.getById(id);

ThrowUtils.throwIf(shop == null, ErrorCode.NOT_FOUND_ERROR, "该数据不存在");

RedisData redisData = new RedisData();

redisData.setData(shop);

redisData.setExpireTime(LocalDateTime.now().plusSeconds(expireSeconds));

stringRedisTemplate.opsForValue().set(CACHE_SHOP_KEY + id, JSONUtil.toJsonStr(redisData));

}

# Redis 中存储的数据会多一个 expireTime 的值

{

"expireTime": 1681660099861,

"data": {

"id": 1,

"name": "101茶餐厅",

"typeId": 1,

...

}

}

逻辑过期

/**

* 缓存预热(将热点数据提前存储到 Redis 中)

*/

public void saveHotDataIn2Redis(Long id, Long expireSeconds) throws InterruptedException {

Shop shop = this.getById(id);

ThrowUtils.throwIf(shop == null, ErrorCode.NOT_FOUND_ERROR, "该数据不存在");

// 模拟缓存重建延迟,让一部分线程先执行完毕,在此期间会短暂的不一致

Thread.sleep(200);

RedisData redisData = new RedisData();

redisData.setData(shop);

redisData.setExpireTime(LocalDateTime.now().plusSeconds(expireSeconds));

stringRedisTemplate.opsForValue().set(CACHE_SHOP_KEY + id, JSONUtil.toJsonStr(redisData));

}

private static final ExecutorService ES = Executors.newFixedThreadPool(10);

@SneakyThrows

@Override

public CommonResult<Shop> getShopById(Long id) {

ThrowUtils.throwIf(id == null, ErrorCode.PARAMS_ERROR);

String shopKey = CACHE_SHOP_KEY + id;

String lockKey = LOCK_SHOP_KEY + id;

// 1. 先从 Redis 中查询数据,未命中则直接返回

String redisDataJson = stringRedisTemplate.opsForValue().get(shopKey);

if (StringUtils.isBlank(redisDataJson)) {

return CommonResult.success(null);

}

// 2. 判断是否过期,未过期则直接返回

RedisData redisData = JSONUtil.toBean(redisDataJson, RedisData.class);

JSONObject jsonObject = (JSONObject) redisData.getData();

Shop shop = JSONUtil.toBean(jsonObject, Shop.class);

LocalDateTime expireTime = redisData.getExpireTime();

if (expireTime.isAfter(LocalDateTime.now())) {

return CommonResult.success(shop);

}

// 3. 未获取到锁直接返回

boolean tryLock = tryLock(lockKey);

if (BooleanUtil.isFalse(tryLock)) {

return CommonResult.success(shop);

}

// 4. 获取到锁:开启一个新的线程后返回旧数据。(这个线程负责查询数据库、重建缓存)

// 此处无需 DoubleCheck,因为未获取到锁直接返回旧数据,能保证只有一个线程执行到此处

ES.submit(() -> {

try {

// 查询数据库、重建缓存

this.saveHotDataIn2Redis(id, 3600 * 24L);

} catch (Exception e) {

log.error(e.getMessage());

} finally {

unlock(lockKey);

}

});

return CommonResult.success(shop);

}

5.8 封装 Redis Cache 工具类

@Component

@Slf4j

public class CacheClient {

private static final ExecutorService ES = Executors.newFixedThreadPool(10);

private final StringRedisTemplate stringRedisTemplate;

public CacheClient(StringRedisTemplate stringRedisTemplate) {

this.stringRedisTemplate = stringRedisTemplate;

}

/**

* 获取锁

*/

public boolean tryLock(String key) {

Boolean result = stringRedisTemplate.opsForValue().setIfAbsent(key, "1", TTL_TWO, TimeUnit.SECONDS);

return BooleanUtil.isTrue(result);

}

/**

* 释放锁

*/

public void unlock(String key) {

stringRedisTemplate.delete(key);

}

/**

* 数据预热(将热点数据提前存储到 Redis 中)

*

* @param key 预热数据的 Key

* @param value 预热数据的 Value

* @param expireTime 逻辑过期时间

* @param timeUnit 时间单位

*/

public void dataWarmUp(String key, Object value, Long expireTime, TimeUnit timeUnit) {

RedisData redisData = new RedisData();

redisData.setData(value);

redisData.setExpireTime(LocalDateTime.now().plusSeconds(timeUnit.toSeconds(expireTime)));

stringRedisTemplate.opsForValue().set(key, JSONUtil.toJsonStr(redisData));

}

/**

* 将 Java 对象序列化为 JSON 存储到 Redis 中并且设置 TTL 过期时间

*

* @param key String 类型的键

* @param value 序列化为 JSON 的值

* @param time TTL 过期时间

* @param timeUnit 时间单位

*/

public void set(String key, Object value, Long time, TimeUnit timeUnit) {

stringRedisTemplate.opsForValue().set(key, JSONUtil.toJsonStr(value), time, timeUnit);

}

/**

* 解决缓存穿透问(缓存空值)

*

* @param keyPrefix Key 前缀

* @param id id

* @param type 实体类型

* @param function 有参有返回值的函数

* @param time TTL 过期时间

* @param timeUnit 时间单位

* @param 实体类型

* @param id 类型

* @return 设置某个实体类的缓存,并解决缓存穿透问题

*/

public <R, ID> R setWithCachePenetration(String keyPrefix, ID id, Class<R> type, Function<ID, R> function, Long time, TimeUnit timeUnit) {

String key = keyPrefix + id;

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

String jsonStr = stringRedisTemplate.opsForValue().get(key);

if (StringUtils.isNotBlank(jsonStr)) {

return JSONUtil.toBean(jsonStr, type);

}

// 命中空值

if (jsonStr != null) {

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR);

}

// 2. 从 Redis 中未查询到数据,则从数据库中查询

R result = function.apply(id);

// 若数据中也查询不到,则缓存空值后返回提示信息

if (result == null) {

stringRedisTemplate.opsForValue().set(key, "", TTL_TWO, TimeUnit.MINUTES);

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR);

}

// 3. 将从数据库中查询到的数据存入 Redis 后返回

this.set(key, result, time, timeUnit);

return result;

}

/**

* 解决缓存击穿问题(synchronized)

*/

public <R, ID> R setWithCacheBreakdown4Synchronized(String keyPrefix, ID id, Class<R> type, Function<ID, R> function, Long time, TimeUnit timeUnit) {

String key = keyPrefix + id;

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

String jsonStr = stringRedisTemplate.opsForValue().get(key);

if (StringUtils.isNotBlank(jsonStr)) {

return JSONUtil.toBean(jsonStr, type);

}

// 命中空值

if (jsonStr != null) {

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR);

}

// 2. 从 Redis 中未查询到数据,则从数据库中查询。(synchronized)

R result = null;

synchronized (CacheClient.class) {

// 3. 再次查询 Redis:若多个线程执行到同步代码块,某个线程拿到锁查询数据库并重建缓存后,其他拿到锁进来的线程直接查询缓存后返回,避免重复查询数据库并重建缓存。

jsonStr = stringRedisTemplate.opsForValue().get(key);

if (StringUtils.isNotBlank(jsonStr)) {

return JSONUtil.toBean(jsonStr, type);

}

// 4. 查询数据库、缓存空值避免缓存穿透、重建缓存。

result = function.apply(id);

if (result == null) {

stringRedisTemplate.opsForValue().set(key, "", TTL_TWO, TimeUnit.MINUTES);

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR);

}

this.set(key, result, time, timeUnit);

}

return result;

}

/**

* 解决缓存击穿问题(setnx)

*/

public <R, ID> R setWithCacheBreakdown4SetNx(String keyPrefix, ID id, Class<R> type, Function<ID, R> function, Long time, TimeUnit timeUnit) {

String key = keyPrefix + id;

String lockKey = LOCK_SHOP_KEY + id;

// 1. 先从 Redis 中查询数据,存在则将其转换为 Java 对象后返回

String jsonStr = stringRedisTemplate.opsForValue().get(key);

if (StringUtils.isNotBlank(jsonStr)) {

return JSONUtil.toBean(jsonStr, type);

}

// 命中空值

if (jsonStr != null) {

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR);

}

// 2. 从 Redis 中未查询到数据,尝试获取锁后从数据库中查询。

R result = null;

boolean tryLock = tryLock(lockKey);

try {

// 2.1 未获取到锁则等待一段时间后重试(通过递归调用重试)

if (BooleanUtil.isFalse(tryLock)) {

Thread.sleep(50);

this.setWithCacheBreakdown4SetNx(keyPrefix, id, type, function, time, timeUnit);

}

// 2.2 获取到锁:查询数据库、缓存重建。

if (tryLock) {

// 3. 再次查询 Redis:若多个线程执行到同步代码块,某个线程拿到锁查询数据库并重建缓存后,其他拿到锁进来的线程直接查询缓存后返回,避免重复查询数据库并重建缓存。

jsonStr = stringRedisTemplate.opsForValue().get(key);

if (StringUtils.isNotBlank(jsonStr)) {

return JSONUtil.toBean(jsonStr, type);

}

// 4. 查询数据库、缓存空值避免缓存穿透、重建缓存。

result = function.apply(id);

if (result == null) {

stringRedisTemplate.opsForValue().set(key, "", TTL_TWO, TimeUnit.MINUTES);

throw new BusinessException(ErrorCode.NOT_FOUND_ERROR);

}

this.set(key, result, time, timeUnit);

}

} catch (Exception e) {

log.error(e.getMessage());

} finally {

unlock(lockKey);

}

return result;

}

/**

* 解决缓存击穿问题(逻辑过期时间)

*/

public <R, ID> R setWithCacheBreakdown4LogicalExpiration(String keyPrefix, ID id, Class<R> type, Function<ID, R> function, Long time, TimeUnit timeUnit) {

String key = keyPrefix + id;

String lockKey = LOCK_SHOP_KEY + id;

// 1. 先从 Redis 中查询数据,未命中则直接返回

String jsonStr = stringRedisTemplate.opsForValue().get(key);

if (StringUtils.isBlank(jsonStr)) {

return null;

}

// 2. 判断是否过期,未过期则直接返回

RedisData redisData = JSONUtil.toBean(jsonStr, RedisData.class);

JSONObject jsonObject = JSONUtil.parseObj(redisData.getData());

R result = JSONUtil.toBean(jsonObject, type);

LocalDateTime expireTime = redisData.getExpireTime();

if (expireTime.isAfter(LocalDateTime.now())) {

return result;

}

// 3. 未获取到锁直接返回

boolean tryLock = tryLock(lockKey);

if (BooleanUtil.isFalse(tryLock)) {

return result;

}

// 4. 获取到锁:开启一个新的线程后返回旧数据。(这个线程负责查询数据库、重建缓存)

// 此处无需 DoubleCheck,因为未获取到锁直接返回旧数据,能保证只有一个线程执行到此处

ES.submit(() -> {

try {

this.dataWarmUp(key, function.apply(id), time, timeUnit);

} finally {

unlock(lockKey);

}

});

return result;

}

}

@Resource

private CacheClient cacheClient;

@Override

public CommonResult<Shop> getShopById(Long id) {

// 缓存穿透

Shop shop = cacheClient.setWithCachePenetration(CACHE_SHOP_KEY, id, Shop.class, this::getById, TTL_TWO, TimeUnit.MINUTES);

// 缓存击穿:synchronized

Shop shop = cacheClient.setWithCacheBreakdown4Synchronized(CACHE_SHOP_KEY, id, Shop.class, this::getById, TTL_TWO, TimeUnit.HOURS);

// 缓存击穿:setnx

Shop shop = cacheClient.setWithCacheBreakdown4SetNx(CACHE_SHOP_KEY, id, Shop.class, this::getById, TTL_TWO, TimeUnit.HOURS);

// 缓存击穿:逻辑过期

Shop shop = cacheClient.setWithCacheBreakdown4LogicalExpiration(CACHE_SHOP_KEY, id, Shop.class, this::getById, TTL_TWO, TimeUnit.HOURS);

return CommonResult.success(shop);

}

6. 秒杀相关

每个店铺都可以发布优惠券,保存到 tb_voucher 表中;当用户抢购时,生成订单并保存到 tb_voucher_order 表中。

订单表如果使用数据库自增 ID,会存在以下问题:

- ID 的规律太明显,容易暴露信息。

- 单表数据量的限制,订单过多时单表很难存储得下。数据量过大后需要拆库拆表,但拆分表了之后,各表从逻辑上是同一张表,所以 id 不能一样, 于是需要保证 ID 的唯一性。

6.1 全局唯一 ID

全局唯一 ID 的特点

- 唯一性:Redis 独立于数据库之外,不论有多少个数据库、多少张表,访问 Redis 获取到的 ID 可以保证唯一。

- 高可用:Redis 高可用(集群等方案)。

- 高性能:Redis 速度很快。

- 递增性:例如 String 的 INCR 命令,可以保证递增。

- 安全性:为了增加 ID 的安全性,在使用 Redis 自增数值的基础上,在拼接一些其他信息。

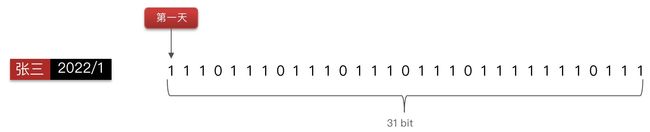

全局唯一 ID 的组成(存储数值类型占用空间更小,使用 long 存储,8 byte,64 bit)

- 符号位:1 bit,永远为 0,代表 ID 是正数。

- 时间戳:31 bit,以秒为单位,可以使用 69 年。

- 序列号:32 bit,当前时间戳对应的数量,也就是每秒可以对应 2^32 个不同的 ID。

Redis ID 自增策略:通过设置每天存入一个 Key,方便统计订单数量;ID 构造为 时间戳 + 计数器。

获取指定时间的时间戳

long timestamp = LocalDateTime.of(2023, 1, 1, 0, 0, 0).toEpochSecond(ZoneOffset.UTC);

System.out.println("timestamp = " + timestamp); // timestamp = 1672531200

LocalDateTime datetime = LocalDateTime.ofEpochSecond(timestamp, 0, ZoneOffset.UTC);

System.out.println("datetime = " + datetime); // 2023-01-01T00:00

使用 Redis 生成全局唯一 ID

@Component

public class RedisIdWorker {

/**

* 指定时间戳(2023年1月1日 0:0:00) LocalDateTime.of(2023, 1, 1, 0, 0, 0).toEpochSecond(ZoneOffset.UTC)

*/

private static final long BEGIN_TIMESTAMP_2023 = 1672531200L;

/**

* 序列号位数

*/

private static final int BIT_COUNT = 32;

private final StringRedisTemplate stringRedisTemplate;

public RedisIdWorker(StringRedisTemplate stringRedisTemplate) {

this.stringRedisTemplate = stringRedisTemplate;

}

public long nextId(String keyPrefix) {

// 1. 时间戳

long timestamp = LocalDateTime.now().toEpochSecond(ZoneOffset.UTC) - BEGIN_TIMESTAMP_2023;

// 2. 生成序列号:自增 1,Key 不存在会自动创建一个 Key。(存储到 Redis 中的 Key 为 keyPrefix:date,Value 为自增的数量)

Long serialNumber = stringRedisTemplate.opsForValue().increment(keyPrefix + ":" + DateTimeFormatter.ofPattern("yyyy-MM-dd").format(LocalDate.now()));

// 3. 时间戳左移 32 位,序列号与右边的 32 个 0 进行与运算

return timestamp << BIT_COUNT | serialNumber;

}

}

测试(300 个线程生成共生成 3w 个 id)

@Resource

private RedisIdWorker redisIdWorker;

public static final ExecutorService ES = Executors.newFixedThreadPool(500);

@Test

void testGloballyUniqueID() throws Exception {

// 程序是异步的,分线程全部走完之后主线程再走,使用 CountDownLatch;否则异步程序没有执行完时主线程就已经执行完了

CountDownLatch latch = new CountDownLatch(300);

Runnable task = () -> {

for (int i = 0; i < 100; i++) {

long globallyUniqueID = redisIdWorker.nextId("sun");

System.out.println("globallyUniqueID = " + globallyUniqueID);

}

latch.countDown();

};

long begin = System.currentTimeMillis();

for (int i = 0; i < 300; i++) {

ES.submit(task);

}

latch.await();

long end = System.currentTimeMillis();

System.out.println("Execution Time: " + (end - begin));

}

6.2 优惠券秒杀

6.2.1 添加优惠券

优惠券分为普通券和秒杀券,普通券可以任意购买,特价券需要秒杀抢购。

tb_voucher优惠券表(包含普通券和秒杀券) :优惠券的基本信息、是否为秒杀券等字段。tb_seckill_voucher秒杀券表:关联的优惠券 ID、秒杀优惠券的库存、抢购开始时间、抢购结束时间等字段。该表与tb_voucher表是一对一关系。

/**

* 新增秒杀券的同时在优惠券表中新增优惠券

*/

@PostMapping("/seckill")

public CommonResult<Long> addSeckillVoucher(@RequestBody Voucher voucher) {

return voucherService.addSeckillVoucher(voucher);

}

@Override

@Transactional

public CommonResult<Long> addSeckillVoucher(Voucher voucher) {

// 新增优惠券

boolean result = this.save(voucher);

ThrowUtils.throwIf(!result, ErrorCode.OPERATION_ERROR, "新增优惠券失败");

// 新增秒杀券

SeckillVoucher seckillVoucher = new SeckillVoucher();

seckillVoucher.setVoucherId(voucher.getId());

seckillVoucher.setStock(voucher.getStock());

seckillVoucher.setBeginTime(voucher.getBeginTime());

seckillVoucher.setEndTime(voucher.getEndTime());

result = seckillVoucherService.save(seckillVoucher);

ThrowUtils.throwIf(!result, ErrorCode.OPERATION_ERROR, "新增秒杀券失败");

return CommonResult.success(voucher.getId());

}

// type 为 1 代表秒杀券

{

"shopId": 1,

"title": "100元代金券",

"subTitle": "周一到周五均可使用",

"rules": "全场通用\\n无需预约\\n可无限叠加\\不兑现、不找零\\n仅限堂食",

"payValue": 8000,

"actualValue": 10000,

"type": 1,

"stock": 100,

"beginTime":"2023-05-05T13:13:13",

"endTime":"2023-06-06T14:14:14"

}

# tb_voucher

`id` 2

`shop_id` 1

`title` 100元代金券

`sub_title` 周一到周五均可使用

`rules` 全场通用\n无需预约\n可无限叠加\不兑现、不找零\n仅限堂食

`pay_value` 8000

`actual_value` 10000

`type` 1

`status` 1

`create_time` 2023-05-05 13:13:13

`update_time` 2023-05-05 13:13:13

# tb_seckill_voucher

`voucher_id` 2

`stock` 100

`create_time` 2023-05-05 13:13:13

`begin_time` 2023-05-05 13:13:13

`end_time` 2023-06-06 14:14:14

`update_time` 2023-05-05 13:13:13

6.2.2 下单优惠券

- 发送下单请求,提交优惠券 ID。

- 下单前需要判断:秒杀是否开始或结束、库存是否充足。

- 库存充足则扣减库存,创建订单并返回订单 ID。

/**

* 秒杀下单优惠券

* @param voucherId 优惠券 ID

* @return 订单 ID

*/

@PostMapping("/seckill/{id}")

public CommonResult<Long> seckillVoucher(@PathVariable("id") Long voucherId) {

return voucherOrderService.seckillVoucher(voucherId);

}

@Resource

private SeckillVoucherService seckillVoucherService;

@Resource

private RedisIdWorker redisIdWorker;

/**

* VERSION1.0 - 秒杀下单优惠券(通过 CAS 解决超卖问题)

*/

@Override

@Transactional

public CommonResult<Long> seckillVoucher(Long voucherId) {

// 1. 判断秒杀是否开始或结束、库存是否充足。

SeckillVoucher seckillVoucher = seckillVoucherService.getById(voucherId);

ThrowUtils.throwIf(seckillVoucher == null, ErrorCode.NOT_FOUND_ERROR);

LocalDateTime now = LocalDateTime.now();

ThrowUtils.throwIf(now.isBefore(seckillVoucher.getBeginTime()), ErrorCode.OPERATION_ERROR, "秒杀尚未开始");

ThrowUtils.throwIf(now.isAfter(seckillVoucher.getEndTime()), ErrorCode.OPERATION_ERROR, "秒杀已经结束");

ThrowUtils.throwIf(seckillVoucher.getStock() < 1, ErrorCode.OPERATION_ERROR, "库存不足");

// 2. 扣减库存

Long userId = UserHolder.getUser().getId();

// UPDATE tb_seckill_voucher SET stock = stock - 1 WHERE voucher_id = ?

boolean result = seckillVoucherService.update()

.setSql("stock = stock - 1")

.eq("voucher_id", voucherId)

.gt("stock", 0)

.update();

ThrowUtils.throwIf(!result, ErrorCode.OPERATION_ERROR, "下单失败");

// 3. 下单

VoucherOrder voucherOrder = new VoucherOrder();

voucherOrder.setUserId(userId);

voucherOrder.setId(redisIdWorker.nextId("seckillVoucherOrder"));

voucherOrder.setVoucherId(voucherId);

result = this.save(voucherOrder);

ThrowUtils.throwIf(!result, ErrorCode.OPERATION_ERROR, "下单失败");

return CommonResult.success(voucherOrder.getId());

}

6.3 超卖问题

Jmeter 测试:添加线程组,线程数 200,Ram-Up 时间 0,循环 1 次;请求 localhost:8081/voucher-order/seckill/秒杀券id;添加 HTTP 信息头管理器设置 Authorization。

通过 Jmeter 测试发现秒杀优惠券的库存为 负数,生成的订单数量超过 100 份。出现了 超卖问题。

超卖问题:假设库存为 1,有线程1、2、3,时刻 t1、t2、t3、t4。

- t1:线程1 查询库存,库存为 1;

- t2:线程2、线程 3 查询库存,库存为 1;

- t3:线程1 下单,库存扣减为 0。

- t4:线程2 和 线程3 下单,库存扣减为 -2。

6.3.1 乐观锁(版本号 & CAS)

悲观锁,也就是互斥锁,互斥锁的同步方式是悲观的。

将资源锁定,只供一个线程调用,而阻塞其他线程。

乐观锁(通过 版本号机制 & CAS 实现)

不会将资源锁定,但是在 更新时会判断在此期间有没有其他线程更新该数据。

- 如果没有其他线程修改则更新成功。

- 如果被其他线程修改了,则放弃本次更新操作以避免出现冲突,并通过报错、重试等方式进行下一步处理。

版本号机制

一般是在数据库表中加上一个 version 字段表示 数据被修改的次数。数据被修改时 version 值加 1。

- 线程 A 读取数据,同时读取到

version值。 - 提交更新时,若刚才读到的

version值未发生变化:则提交更新并且version值加 1。 - 提交更新时,若刚才读到的

version值发生了变化:放弃更新,并通过报错、自旋重试等方式进行下一步处理。

CAS(Compare And Set 对比交换)

CAS 操作需要输入两个数值,一个旧值(操作前的值)和一个新值,操作时先比较下在旧值有没有发生变化,若未发生变化才交换成新值,发生了变化则不交换。

CAS 是原子操作,多线程并发使用 CAS 更新数据时,可以不使用锁。原子操作是最小的不可拆分的操作,操作一旦开始,不能被打断,直到操作完成。也就是多个线程对同一块内存的操作是串行的。

版本号机制解决超卖问题。(假设 stock = 1,version = 1)

-

t1:线程 A 获取的 stock 和 version 为 1 和 1。

-

t2:线程 B 获取的 stock 和 version 为 1 和 1。

-

t3:线程 A 更新时比对 version 的值,值相同,提交更新。(更新操作包括

version = version +1)update tb_seckill_voucher set stock = stock - 1 and version = version + 1 where id = 2 and version = 1 -

t4:线程 B 更新时比对 version 的值,值不同,放弃更新,通过报错、重试等方式进行下一步处理。

# 此时 version = 2 update tb_seckill_voucher set stock = stock - 1 and version = version + 1 where id = 2 and version = 1;

CAS 解决超卖问题。(假设 stock = 1)

-

t1:线程 A 获取的 stock 为 1。

-

t2:线程 B 获取的 stock 为 1。

-

t3:线程 A 更新时比对 stock 的值,值未发生变化,提交更新。

update tb_seckill_voucher set stock = stock - 1 where id = 2 and stock = 1; -

t4:线程 B 更新时比对 stock 的值,值已经发生了变化,放弃更新,通过报错、重试等方式进行下一步处理。

# 此时 stock = 0 update tb_seckill_voucher set stock = stock - 1 where id = 2 and stock = 1;

6.3.2 CAS 解决超卖问题

方式1:库存尚未不足时就会导致很多线程更新失败,若有 10 个线程查询到的 stock 为100,只要有一个更新成功,stock 值发生了变化,其他线程都会更新失败。

// 扣减库存

boolean result = seckillVoucherService.lambdaUpdate()

.eq(SeckillVoucher::getVoucherId, voucherId)

.gt(SeckillVoucher::getStock, 0)

.set(SeckillVoucher::getStock, stock - 1)

.update();

方式2:只需要让 stock > 0 即可,可以有效的提高线程更新的成功率。

// 扣减库存

boolean result = seckillVoucherService.lambdaUpdate()

.eq(SeckillVoucher::getVoucherId, voucherId)

.gt(SeckillVoucher::getStock, 0)

.set(SeckillVoucher::getStock, stock - 1)

.update();

6.4 一人一单

6.4.1 增加一人一单逻辑

- 发送下单请求,提交优惠券 ID。

- 下单前需要判断:秒杀是否开始或结束、库存是否充足。

- 库存充足:根据优惠券 ID 和用户 ID 查询订单,判断该用户是否购买过该优惠券。

- 该用户对该优惠券的订单不存在时,扣减库存、创建订单、返回订单 ID。

@Override

public CommonResult<Long> seckillVoucher(Long voucherId) {

// 判断秒杀是否开始或结束、库存是否充足。

SeckillVoucher seckillVoucher = seckillVoucherService.getById(voucherId);

ThrowUtils.throwIf(seckillVoucher == null, ErrorCode.NOT_FOUND_ERROR);

LocalDateTime now = LocalDateTime.now();

ThrowUtils.throwIf(now.isBefore(seckillVoucher.getBeginTime()), ErrorCode.OPERATION_ERROR, "秒杀尚未开始");

ThrowUtils.throwIf(now.isAfter(seckillVoucher.getEndTime()), ErrorCode.OPERATION_ERROR, "秒杀已经结束");

ThrowUtils.throwIf(seckillVoucher.getStock() < 1, ErrorCode.OPERATION_ERROR, "库存不足");

// 下单

return this.createVoucherOrder(voucherId);

}

/**

* 下单(超卖 - CAS、一人一单 - synchronized)

*/

@Override

@Transactional

public CommonResult<Long> createVoucherOrder(Long voucherId) {

// 1. 判断当前用户是否下过单

Long userId = UserHolder.getUser().getId();

Integer count = this.lambdaQuery()

.eq(VoucherOrder::getVoucherId, voucherId)

.eq(VoucherOrder::getUserId, userId)

.count();

ThrowUtils.throwIf(count > 0, ErrorCode.OPERATION_ERROR, "禁止重复下单");

// 2. 扣减库存

boolean result = seckillVoucherService.update()

.setSql("stock = stock - 1")

.eq("voucher_id", voucherId)

.gt("stock", 0)

.update();

ThrowUtils.throwIf(!result, ErrorCode.OPERATION_ERROR, "下单失败");

// 3. 下单

VoucherOrder voucherOrder = new VoucherOrder();

voucherOrder.setUserId(userId);

voucherOrder.setId(redisIdWorker.nextId("seckillVoucherOrder"));

voucherOrder.setVoucherId(voucherId);

result = this.save(voucherOrder);

ThrowUtils.throwIf(!result, ErrorCode.OPERATION_ERROR, "下单失败");

return CommonResult.success(voucherOrder.getId());

}

6.4.2 解决并发安全问题

单人下单(一个用户),高并发的情况下:该用户的 10 个线程同时执行到 查询该用户 ID 和秒杀券对应的订单数量,10 个线程查询到的值都为 0,即未下单。于是会出现一个用户下 10 单的情况。

**此处仍需加锁,乐观锁适合更新操作,插入操作需要选择悲观锁。**若直接在方法上添加 synchronized 关键字,会让锁的范围(粒度)过大,导致性能较差。因此,采用 一个用户一把锁 的方式。

一个用户一把锁

-

首先,需要保证锁必须是同一把。

**

userId.toString()获取用户 ID 对应的字符串常量池保证用的锁是同一把。**保证了一个用户即使在高并发的情况下也只能下单一次的同时,不同用户也不会争抢同一把锁,提高性能。(同一个用户的多个线程争抢同一把锁,保证一个线程下单成功,其他线程失败)toString()方法底层会new一个字符串,因此获取到的的字符串是不同的对象。- 通过

intern()方法可以 直接从常量池里获取到与该值相同的字符串常量。同一个用户 ID 相同,userId.toString().itern()相同。

@Override @Transactional public CommonResult<Long> createVoucherOrder(Long voucherId, Integer stock) { Long userId = UserHolder.getUser().getId(); synchronized(userId.toString().intern()) { ... } } -

其次,事务是在方法执行完毕后由 Spring 提交的:开启事务执行方法,抢到锁后执行相关代码,释放锁后才会提交事务。这种方式依然存在并发安全问题,因为锁的范围小了。

@Override @Transactional public CommonResult<Long> createVoucherOrder(Long voucherId, Integer stock) { Long userId = UserHolder.getUser().getId(); // 假设此处有 1 个线程抢到锁并执行同步代码块,还有 9 个线程在等待。 synchronized(userId.toString().intern()) { ... } // 锁释放后才会提交事务,当锁释放的瞬间,又有其他线程抢到了锁。循环往复,还是存在一个用户下多单的问题。 }因此,需要扩大锁的范围:将整个方法用

synchronized包裹起来。@Override public Result seckillVoucher(Long voucherId) { ... Long userId = UserHolder.getUser().getId(); synchronized (userId.toString().intern()) { // 此处实际上执行的是 `this.createVoucherOrder(voucherId);`,这个 this 指的是当前类 return createVoucherOrder(voucherId); } } -

最后,方法的调用没有经过动态代理,Spring 的事务是通过动态代理 AOP 实现的,必需使用代理对象调用方法。

<dependency> <groupId>org.aspectjgroupId> <artifactId>aspectjweaverartifactId> dependency>// 在主启动类上添加该注解(exposeProxy 暴露代理对象) @EnableAspectJAutoProxy(exposeProxy = true)synchronized (userId.toString().intern()) { // 获取代理 VoucherOrderService 接口的代理对象 VoucherOrderService proxy = (VoucherOrderService) AopContext.currentProxy(); return proxy.createVoucherOrder(voucherId); }

终极版

/**

* VERSION2.0 - 秒杀下单优惠券(通过 synchronized 解决一人一单问题)

*/

@Override

public CommonResult<Long> seckillVoucher(Long voucherId) {

// 判断秒杀是否开始或结束、库存是否充足。

SeckillVoucher seckillVoucher = seckillVoucherService.getById(voucherId);

ThrowUtils.throwIf(seckillVoucher == null, ErrorCode.NOT_FOUND_ERROR);

LocalDateTime now = LocalDateTime.now();

ThrowUtils.throwIf(now.isBefore(seckillVoucher.getBeginTime()), ErrorCode.OPERATION_ERROR, "秒杀尚未开始");

ThrowUtils.throwIf(now.isAfter(seckillVoucher.getEndTime()), ErrorCode.OPERATION_ERROR, "秒杀已经结束");

ThrowUtils.throwIf(seckillVoucher.getStock() < 1, ErrorCode.OPERATION_ERROR, "库存不足");

// 下单

synchronized (UserHolder.getUser().getId().toString().intern()) {

// 1. 锁释放后才能提交事务,若释放锁的瞬间其他线程抢占到锁则继续执行,仍然存在一人多单的问题,因此需要扩大锁的范围为整个方法。

// 2. this 指向当前类而非代理类,Spring 事务通过动态代理 AOP 实现,必需使用代理对象调用方法。

// 3. 导入 aspectjweaver,在主启动类上添加 @EnableAspectJAutoProxy(exposeProxy = true) 注解。(exposeProxy 暴露代理对象)

VoucherOrderService voucherOrderService = (VoucherOrderService) AopContext.currentProxy();

return voucherOrderService.createVoucherOrder(voucherId);

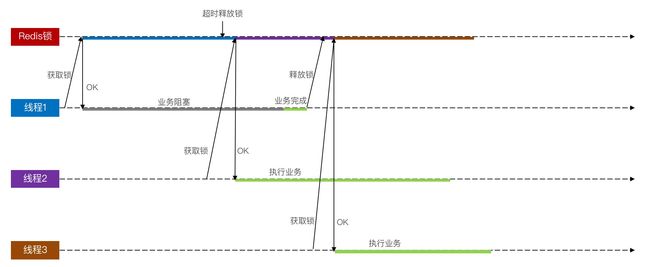

// return this.createVoucherOrder(voucherId);