量子计算和AI居然是这种关系 第一次有人给我们完整地说了说

16岁时保送中国科大少年班,本科毕业后即留校工作,同时攻读研究生;28岁时开始进军当时最新的量子计算实验研究领域,成为我国最早从事这项研究的科学家之一;接下来的近20年里,杜江峰一头扎进量子计算领域。

2002年,在国际上第一次成功地实现了量子博弈的实验研究,实现中国国内量子计算实验研究工作首次刊发在国际权威杂志《物理评论快报》上。

2009年,他带领自己的科研团队做出的又一项重要成果产生了:首次在真实固态体系中实现了最优动力学去耦,这项成果发表于国际权威杂志《自然》。

2015年,一项关于“量子探针”的成果惊艳世界:其团队利用钻石中的氮-空位点缺陷作为“量子探针”,选取了细胞分裂中的一种重要蛋白为探测对象,将量子技术应用于单个蛋白分子研究,在室温大气条件下获得了世界上首张单蛋白质分子的磁共振谱。这项成果在权威期刊《科学》上发表,被认为是“通往活体细胞中单蛋白质分子实时成像的里程碑”。

近期,在数博会的人工智能和量子计算演讲中,国内量子计算大拿杜江峰详细地为我们解释了量子计算和人工智能的关系,让平时对量子计算的一脸懵逼的互联网人士,恍若从梦想走进现实——

一听到量子,好多人搞不清楚量子,包括当年发现量子的人都说不懂量子。但量子革命,从AlphaGo到量子人工智能,它很有可能有一个这样一个过程。

刚刚也提到了人工智能最近已经取得了很好的成绩,一个机器已能下过一个人,实际上定义的任何机器,总会超过人。就像现在设计的汽车和飞机速度比人快,计算机能力比人的计算能力强,本质上来说人工智能不会走到一个有情感、有思维,往往是经验性的东西。

一般意义上来说,一幅图象,计算机来描述图象都是基本上看到一幅图象,它会按照像素来展开,里面有灰度,有深度……对它形成一些数据。人工智能对这个数据是否能有感官上进一步深入了解?看到这个图象看到比传统计算上更深的意义?比如甚至知道什么样的绘画风格。这就是我们今天要探讨的问题。

当人工智能遇上量子计算

人工智能的能力来源是什么?今天会议的主题是大数据 ,为什么前面加一个大,因为这是是一个动态的工作,信息量越来越大的时代,如何从浩瀚的东西中得到有利生活质量的东西,首先要对这个数据进行描述。这就意味着要描述的对象,由传统的数据从单一逐渐走向各种复杂数据。

人工智能核心资源是计算能力,在二十年前,一个机器人,当时用32个CPU, 达到120MHz的速度。现在是2000个CPU,300个GPU,提升的计算能力,使得处理学习或者智能的能力得到比较大的增强,不过现在问题是,如何过渡到量子这块?计算能力能否无限提升?

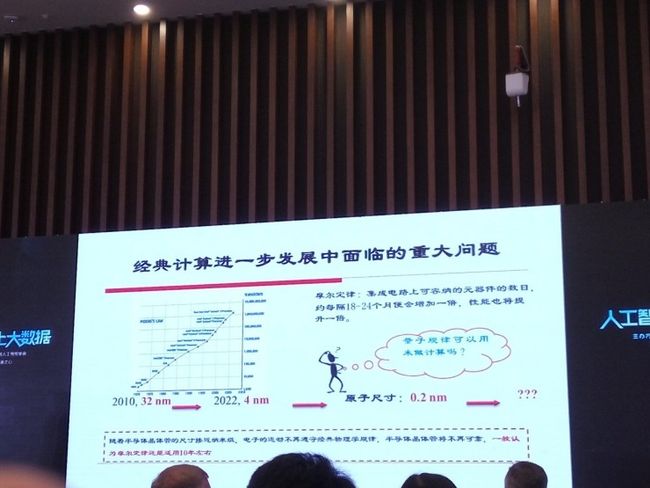

摩尔定律在半个世纪前预言了经典计算,每隔18-24个月,集成电路上可容纳的元器件数目增加一倍,计算性能增加一倍。经典计算的能力,从32纳米,在未来到四个纳米,再到更小的纳米,一般都认为摩尔定律最多还能适用10年。

我们知道一个例子,从物理科学基础上讲一个电子不可再分的,不可能永远从90多纳米到60多纳米,到40多纳米,到30多纳米……将来能够到零点几纳米甚至更小纳米的层面。从科学的原理上来讲,宏观问题上,是按照牛顿三大定律主宰的,但到纳米层面,牛顿定律不再适用,而会进入一个新的科学,也就是我们经常说的量子力学,描述的基础就不一样了。

另外一个,还有一个热耗散的问题,我们在研究里面也发现,经典计算机器件的原理,热耗散不可避免,这是原理上决定的。譬如买到早期计算机有一个风扇散热,你做的集成度越高,热耗越严重。

但量子计算来做这块,原理上保持可逆计算,没有热耗散,可以在里面自循环,这样没有一个热耗散,也是遵从量子力学规律的东西。这是未来量子计算是一个比较好的前景和方向。

另外,量子力学是近代技术的支柱,一百多年前量子理论开始提出,到现在的晶体管,到激光,到后面的高温超导,都会有一个产业的发展和产生。

会带来无边的“诱惑”

在过去很长一段时间里,我们对量子力学都是被动的观察和解释,我看到了一些现象,我根据这个现象得到一些应用,比如激光,就是量子力学发展的成果,激光无处不在,包括投影也是激光投影。

第一次量子革命就是对晶体管,对激光的发展,支撑了整个过去信息革命的一个发展,最近随着过去二三十年技术的积累,现在可以一定程度地掌控量子,可以对单个分子或者原子进行掌控 。

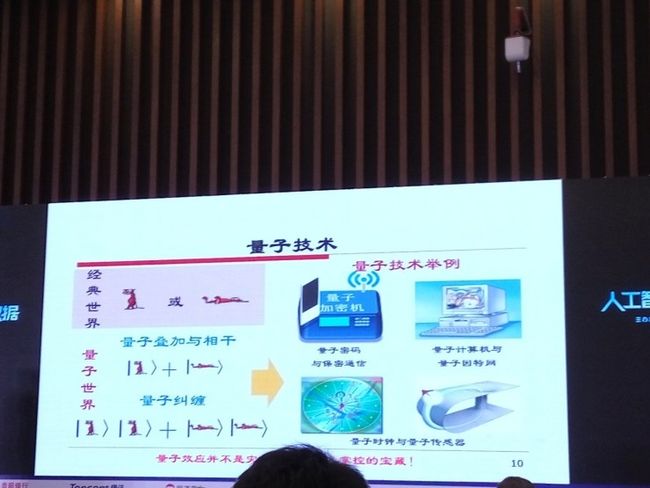

在微观有主动调控能力有了这种调控,可能会产生一系列新的技术,这方面比较清楚的,在量子信息里面,目前分三个方向:

一个是量子密码,大概7月份,中国的第一颗,也是全球第一颗量子卫星在500公里轨道开始发射,实现一个安全的密码输送;

一个是量子通讯,同时在发改委的干线,今年年底明年开始在城市间,从北京到上海,上海到合肥的一个地面的有线网络,空中的无线网络。

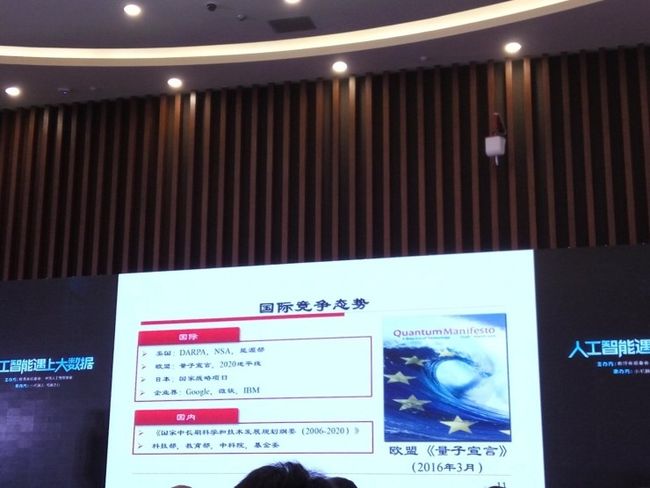

另一个是量子时钟和量子传感器,最近几年,精密测量得到非常好的推广和应用,大概一个月前,欧盟通过了一个量子宣言,比如没有GPS的导航,有一些量子传感器,大概有10亿欧元,在2020年计划里面有一个投入。

总的来说,现在已经有了非常好的发展前景。为什么说量子近年好很多?原因很简单。计算机经典的储存单元是什么?一般是一个(电荷上的)高电频和低电频,高电频代表1,低电频代表0,叫它二进制,量子力学告诉我们高电频和低电频同一瞬间同时存在。

所谓的量子叠加和量子相干,如果我有一个16位的计算机,或者32位的,它的输入就是电频里面的2的16次方或者2的32次方。

量子计算就是进行叠加,这时候高速的来源就在这个地方,可以2的多少次方处于所有状态里面,可以在这个里面透视做计算。在这个基础上,我们做量子计算,量子密码,量子因特网,量子时钟,甚至是量子传感器。

巨头林立的国际竞争

在量子计算这块,包括美国和日本的国际项目,以及微软和IBM,中科院有一个国家计算机的规划纲要,有比较大的投入,企业界逐渐开始往这个方面进入,比如阿里和中科大也成了量子计算机实验室。总的来说,量子力学跟人工智能有什么关系?

有这样一个关系的话。

如果做成人工智能,如果只是加速,原来需要一千台机器,或者需要一万台,现在(用量子计算机)可能四台就可以了,形成快速的计算能力。

另外一个领域,量子力学在模型里面解决传统的没有的模型,那是另外一个方向。

量子用于计算就是计算,用于通讯就是通讯,用于人工智能就是人工智能。利用相干叠加的方式,实现了计算,无法比拟的超级计算能力,可以把复杂度的NP计算问题,就可以变成P问题。

如果做基础的人来讲,不管是经典还是量子,我们处理的都是效率的问题,把一些遥遥无期的东西变成一些结果。

大数分解,金融行业经常用到的,给你一个非常大的一个数,找到它的两个素数是什么,经典万亿次的计算机需要15万年,如(用万亿次的)是量子计算机,只需要一秒。在计算数据处理里面是一个基本的方式,如果用一个亿亿次的经典计算需要一百年,但是把速度可以降下来,只用一个万亿次的量子计算可能就0.01秒的时间。

量子人工智能的计算能力为人工智能发展提供革命性的工具,能够指数加速学习能力和速度,轻松应对大数据数据的挑战。

以及最新的理论进展

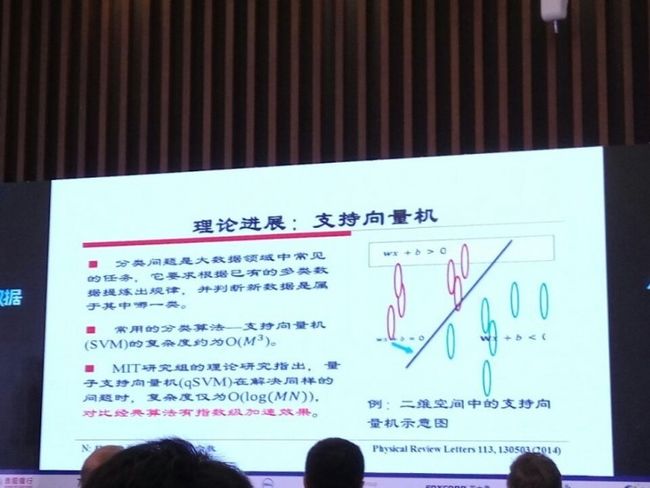

在人工智能这块,谷歌开始建立量子人工智实验室,包括微软等在做一些人工智能方面的东西。这几年开始,甚至在AlphaGo出来之前,在学界就已经有一些研究,人工智能里面的分类问题,是大数据中常见的任务,根据已有的数据体现规律,判断新数据是属于哪一类。如下图所示,MIT在这方面已经有如下的理论进展一:

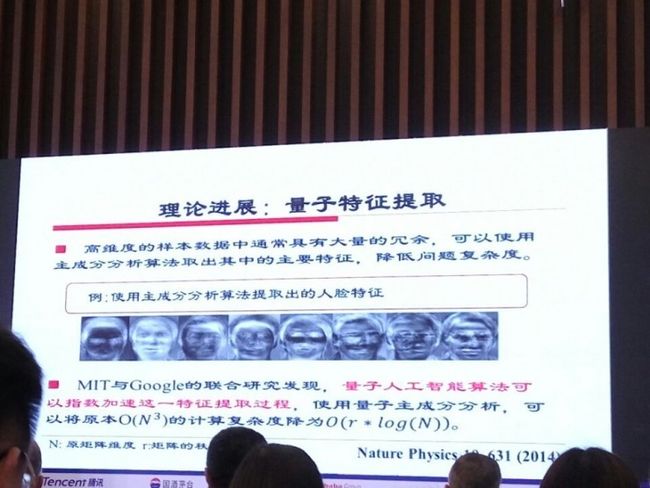

另一个理论进展,是MIT和Google的联合研究发现,量子人工智能算法可以加速特征提取过程:

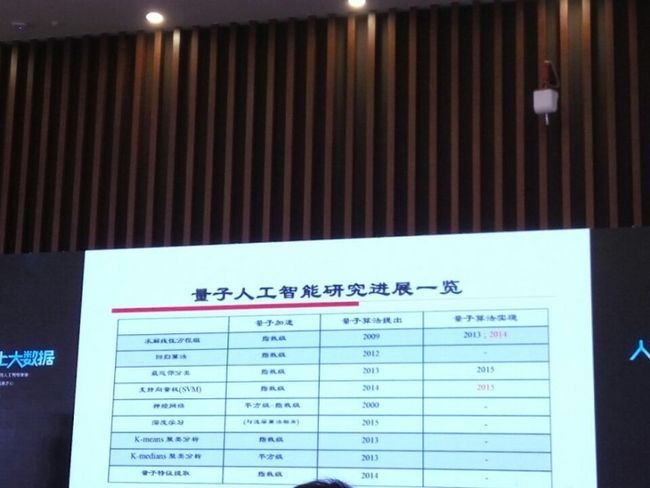

整体的研究进展如下图所示(红色的两个部分是我们实验室做的,把这个体系放到量子的模型机上,来演示这个实验。这是去年的一个工作。)

整体的研究进展如下图所示(红色的两个部分是我们实验室做的,把这个体系放到量子的模型机上,来演示这个实验。这是去年的一个工作。)

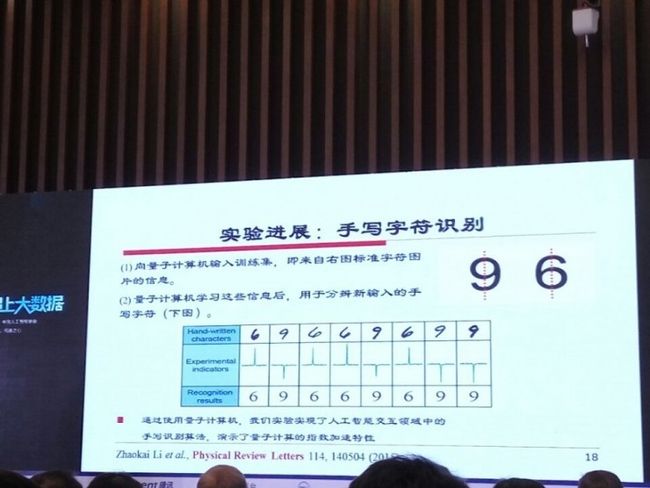

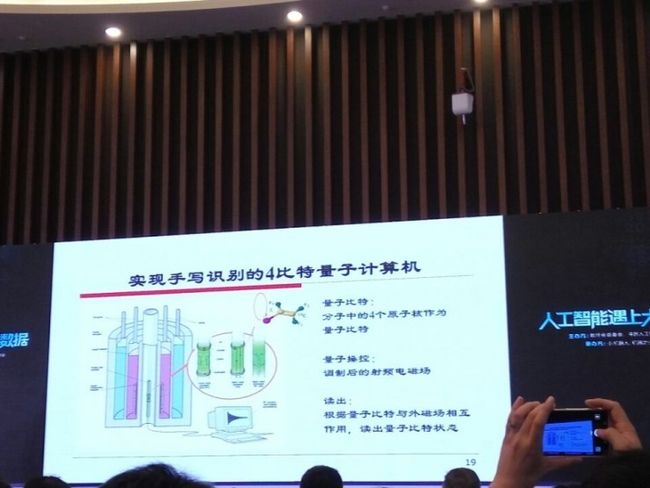

最后,以实际进展向大家举一个量子计算运用到人工智能的例子,这种指数加速是可行的,通过我们专用仪器设备,来读出量子比特状态:

MIT和一些媒体的报告,包随着数据越来越大,现在每年生产信息2的60次方,就是60比特,用经典比特资源,约百万块硬盘能够存下数据;但要描述宇宙所需的信息量时,会达到2的300次方,就是300比特,按现在的的比特资源就已经不可能储存了。

IBM制造的计算系统包含了5个量子比特,在其它实验室大概有十个。在未来五到十年能达到三十个比特,就已经是非常了不起的一个能力了(注:如果一个量子计算机能够组建成50个量子比特,当今世界前500名的超级计算机全部加起来,功能都无法胜过它。)。也就是说可以空间可以达到2的30次方,在大数据方,量子人工智能计算能力巨大的优势,实现这样的一个弯道超车。

最后

我想说,第一次量子深刻影响了晶体管和激光的发展,第二次量子革命对人类一定是有巨大促进的作用。我们不应该去惧怕科学上的一些进展,因为毕竟机器是人造的。现在眼前并没有看到一个机器有人的情感来毁灭人,我的观点应该不是这样的。谢谢大家!

原文发布时间为:2016-05-31

本文作者:宗仁

本文来源:雷锋网,如需转载请联系原作者。