YOLOv5训练自己数据集(详细易懂版)

YOLOv5作为图像检测界的一哥,检测效果毋庸置疑,本篇文章就带你一起手把手教学YOLOv5实现

1.下载YOLOv5源码

官方下载地址:GitHub - ultralytics/yolov5: YOLOv5 in PyTorch > ONNX > CoreML > TFLite

考虑到有些小伙伴没有科学上网的途径,也可以在我的网盘里提取源码

网盘链接:百度网盘 请输入提取码

提取码:639k

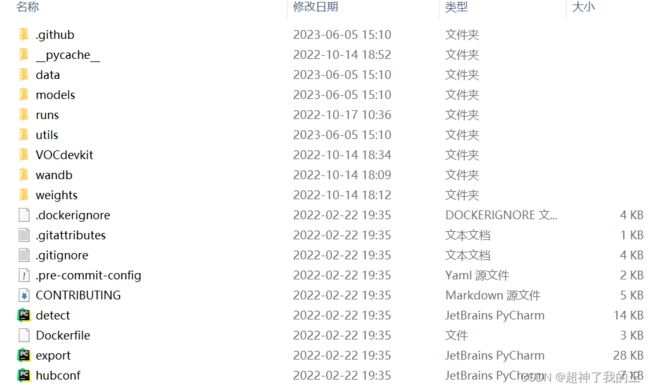

目录结构就是这样

这里的数据集就用具有代表性的钢材表面缺陷数据集,总共是6个类别,每个类别是400张图像。

如果大家想使用自己数据集进行训练,可以继续往下读,我会介绍如何制作数据集

2.修改配置文件

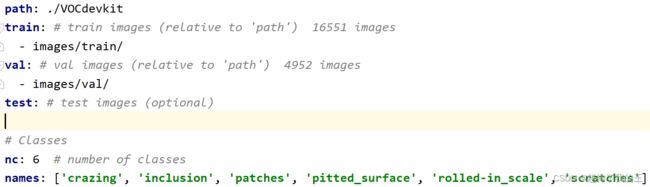

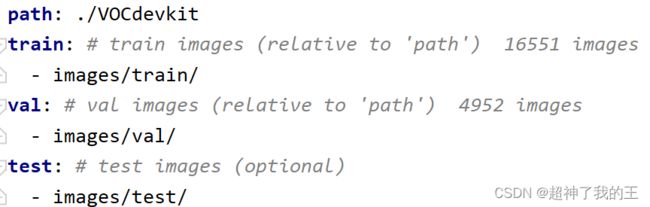

(1)复制data目录下的VOC.yaml文件,起名为voc_bm(当然也可以自己命名),修改成以下格式。

这里的路径信息按照我这样写就行。对于验证集(这里仅针对需要做评估实验的同学,如果想要实现我这个项目这样就行了,不用看下图),可以写成如下格式,当然要有自己的测试集,不然白写。

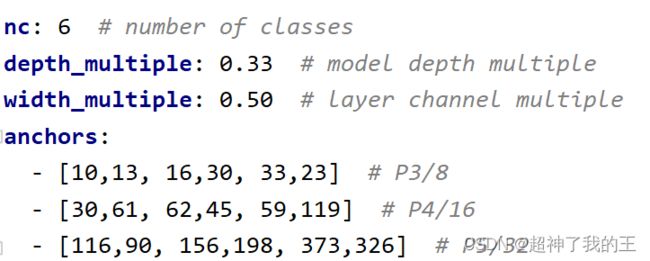

(2)复制models文件夹下的yolov5s.yaml文件,命名为yolov5s_bm。这里只需要修改类别为6就行,对应自己数据集的类别

3.训练参数指定

打开终端(CMD),切换到自己的虚拟环境,运行下列代码即可训练

python train.py --data data/voc_bm.yaml --cfg models/yolov5s_bm.yaml --batch-size 16 --epochs 300 --workers 4 --name yolov5s

这里解释以下这些参数的作用:

--data和--cfg就是咋们上述的参数配置,--batch-size 16这里是批处理大小,这个参数看自己显存大小,如果自己配置好就16,否则就4或者1都行。具体的影响就是最终生成的runs文件夹下的训练过程图像,如果是16,那一幅图中就会有16张训练图像结果,如果是1的话就是生成单个图像。

--epoch是训练次数,一般科研学术都是300轮,其实要不了这么多,一般200轮就可以开始收敛了,如果不想训练长时间,就可以减少次数,一般yolov5在100轮就有这样的效果。

--worker表示工作的线程数,这个也开始根据自己的配置定,如果设备不错也可以体验8线程带来的快感!

--name 表示最终会生成一个文件夹runs,runs文件夹下会又有一个文件夹名称(存放训练结果),因此这个按个人喜好来命名。

这样为了探究其他参数,咋们多说一点

parser = argparse.ArgumentParser()

parser.add_argument('--weights', type=str, default=ROOT / 'yolov5s.pt', help='initial weights path')

# parser.add_argument('--weights', type=str, default=ROOT / '', help='initial weights path')

parser.add_argument('--cfg', type=str, default='', help='model.yaml path')

parser.add_argument('--data', type=str, default=ROOT / 'data/coco128.yaml', help='dataset.yaml path')

parser.add_argument('--hyp', type=str, default=ROOT / 'data/hyps/hyp.scratch-low.yaml', help='hyperparameters path')

parser.add_argument('--epochs', type=int, default=300)

parser.add_argument('--batch-size', type=int, default=16, help='total batch size for all GPUs, -1 for autobatch')

parser.add_argument('--imgsz', '--img', '--img-size', type=int, default=640, help='train, val image size (pixels)')

parser.add_argument('--rect', action='store_true', help='rectangular training')

parser.add_argument('--resume', nargs='?', const=True, default=False, help='resume most recent training')

parser.add_argument('--nosave', action='store_true', help='only save final checkpoint')

parser.add_argument('--noval', action='store_true', help='only validate final epoch')

parser.add_argument('--noautoanchor', action='store_true', help='disable AutoAnchor')

parser.add_argument('--evolve', type=int, nargs='?', const=300, help='evolve hyperparameters for x generations')

parser.add_argument('--bucket', type=str, default='', help='gsutil bucket')

parser.add_argument('--cache', type=str, nargs='?', const='ram', help='--cache images in "ram" (default) or "disk"')

parser.add_argument('--image-weights', action='store_true', help='use weighted image selection for training')

parser.add_argument('--device', default='', help='cuda device, i.e. 0 or 0,1,2,3 or cpu')

parser.add_argument('--multi-scale', action='store_true', help='vary img-size +/- 50%%')

parser.add_argument('--single-cls', action='store_true', help='train multi-class data as single-class')

parser.add_argument('--optimizer', type=str, choices=['SGD', 'Adam', 'AdamW'], default='SGD', help='optimizer')

parser.add_argument('--sync-bn', action='store_true', help='use SyncBatchNorm, only available in DDP mode')

parser.add_argument('--workers', type=int, default=8, help='max dataloader workers (per RANK in DDP mode)')

parser.add_argument('--project', default=ROOT / 'runs/train', help='save to project/name')

parser.add_argument('--name', default='exp', help='save to project/name')

parser.add_argument('--exist-ok', action='store_true', help='existing project/name ok, do not increment')

parser.add_argument('--quad', action='store_true', help='quad dataloader')

parser.add_argument('--cos-lr', action='store_true', help='cosine LR scheduler')

parser.add_argument('--label-smoothing', type=float, default=0.0, help='Label smoothing epsilon')

parser.add_argument('--patience', type=int, default=100, help='EarlyStopping patience (epochs without improvement)')

parser.add_argument('--freeze', nargs='+', type=int, default=[0], help='Freeze layers: backbone=10, first3=0 1 2')

parser.add_argument('--save-period', type=int, default=-1, help='Save checkpoint every x epochs (disabled if < 1)')

parser.add_argument('--local_rank', type=int, default=-1, help='DDP parameter, do not modify')

# Weights & Biases arguments

parser.add_argument('--entity', default=None, help='W&B: Entity')

parser.add_argument('--upload_dataset', nargs='?', const=True, default=False, help='W&B: Upload data, "val" option')

parser.add_argument('--bbox_interval', type=int, default=-1, help='W&B: Set bounding-box image logging interval')

parser.add_argument('--artifact_alias', type=str, default='latest', help='W&B: Version of dataset artifact to use')

opt = parser.parse_known_args()[0] if known else parser.parse_args()

return opt

--weights:是否使用预训练权重,如果不想使用预训练权重可以空,一般预训练权重会比自己训练结果好一些

--cfg:这不就是咋们说的训练参数吗?

--data:同上

--hyp:超参数设置就在里面

--epoch:训练次数

--batch-size:批处理大小

--imgsz:训练集或测试集图像尺寸,默认640,可以不用修改

--rect:作用未知(猜想是画矩形框用的)

--resume:重新训练

--nosave:默认就行

。。。。。

。。。。。

太多了,我列举几个重要的

--device:默认就行,但如果有多个gpu,可以写0,1,2,3

--optimizer:默认就行,就是选择用哪个优化器(控制梯度下降)

--workers:线程数

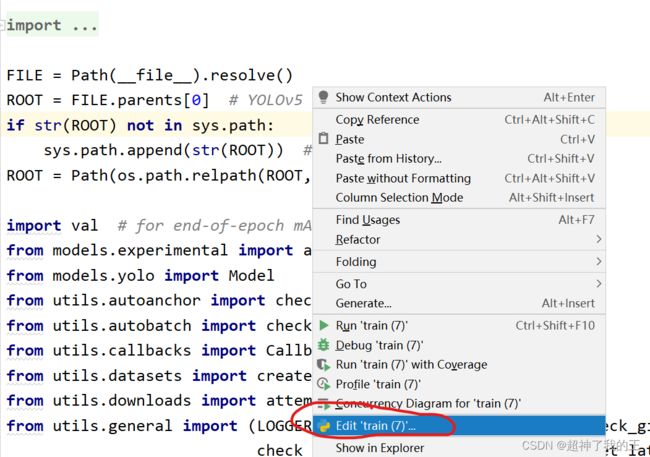

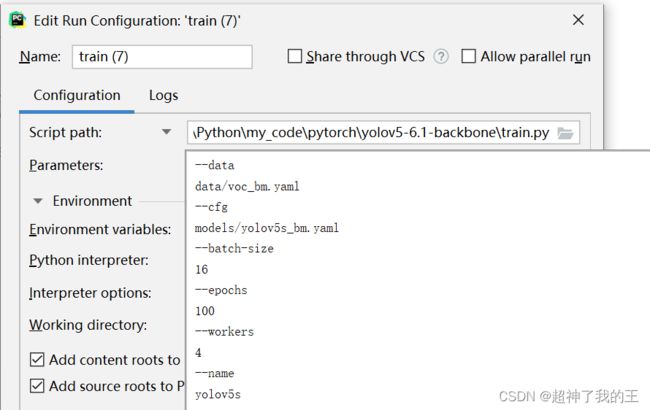

4.部分新手训练者会在Pycharm中训练,那他的第三步就可以在解释器中进行

(1)打开pycharm,右击

--data data/voc_bm.yaml --cfg models/yolov5s_bm.yaml --weights '' --batch-size 16 --epochs 100 --workers 4 --name yolov5s

之后确定运行即可。

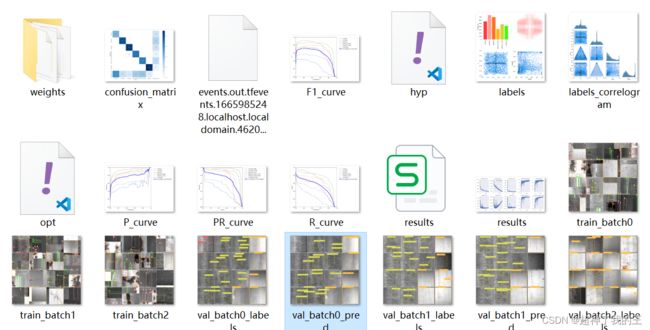

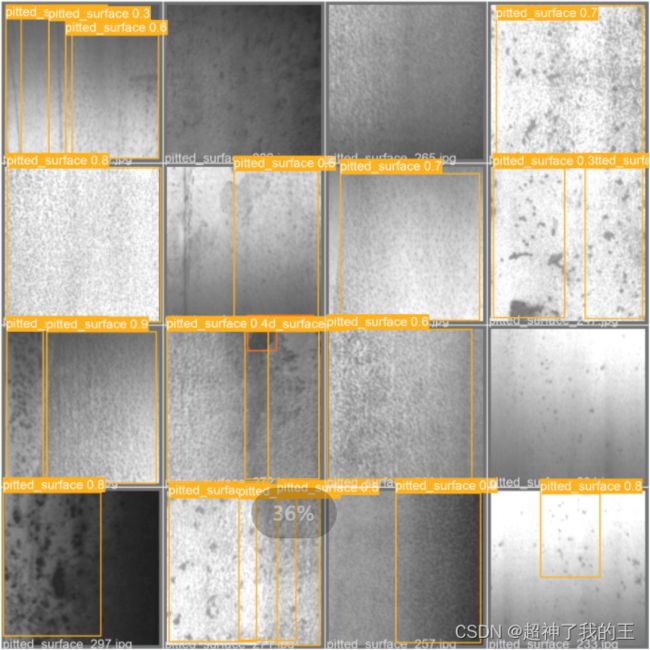

5.结果

进入runs下的yolov5s文件夹下查看,这是所有关于训练的信息

咋们看看训练过程中的图像。