Hadoop——MapReduce

在Hadoop中每个MapReduce应用程序被表示成一个作业,每个作业又被分成多个任务。

应用程序向框架提交一个MapReduce作业,作业一般会将输入的数据集合分成彼此独立的数据块,然后由map任务以并行方式完成对数据分块的处理。框架对map的输出进行排序,之后输出到reduce任务。

集群中一个节点既是计算节点,又是存储节点。这种设计效率非常高,框架可以在数据所在的节点上调度任务执行,大大节省了集群节点间的整体带宽。

Hadoop的MapReduce框架使用YARN管理资源,框架组成分为三个部分:一个主节点上的资源管理器ResourceManager,每个从节点上的节点管理器NodeManager,每个应用程序对应的MRAppMaster。

1、处理步骤

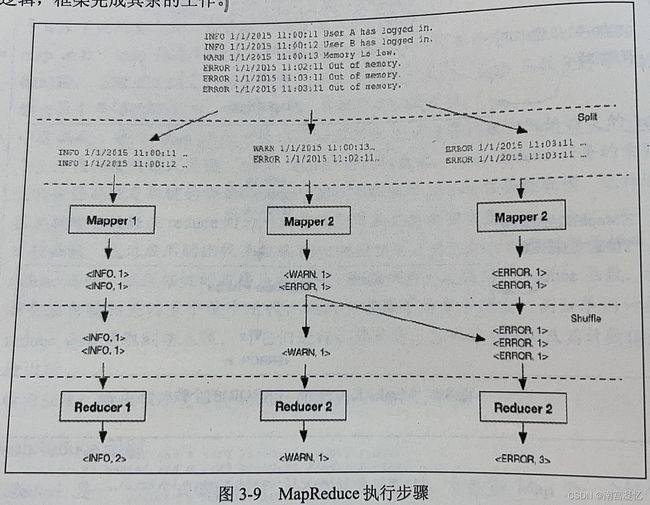

MapReduce数据处理分为Split、Map、Shuffle、Reduce,应用程序实现Map和Reduce步骤的逻辑,Split和Shuffle步骤由框架自动完成。

(1)Split

在执行任务前,原始数据被分割成若干split,每个split作为一个map任务的输入,在map执行过程中,split会被分解成一个个记录(键/值对)。

(2)Map

对于文本文件,默认为文件里的一行是一条记录,一行的内容作为键/值对中的值,从split的起始位置到每行的字节偏移量,是键/值对中的键。

map任务处理每一个记录时,会生成一个新的中间键/值对,map任务的输出就是这些中间键/值对的全部集合。为每个map任务生成最终的输出文件前,先会依据键进行分区,以便将同一分组的数据交给同一个reduce任务处理。

在有多个reduce任务的情况下,每个map任务会基于分区键生成多个输出文件,此时可以根据需求自己定制partitioner。

在应用程序中最好对map任务的输出文件进行压缩以获得最优的性能。

(3)Shuffle

Map步骤之后,Reduce步骤之前,还有一个重要步骤叫做Shuffle。系统对map任务的输出执行排序和转换并映射为reduce任务的输入,此过程就是Shuffle。

在Shuffle中,会把map任务输出的一组无规则的数据尽量转换成一组具有一定规则的数据,然后把数据传递给reduce任务运行的节点。

Shuffle横跨Map端和Reduce端,在Map端包括spill过程,在Reduce端包括copy和sort过程。

(4)Reduce

Reduce步骤负责数据的计算归并,它处理Shuffle后的每个键及其对应值的列表,并将一系列键/值对返回给客户端应用。Reduce对所有中间结果进行归并、聚合,最终生成一个汇总的结果。

2、应用程序定义

(1)输入程序

输入程序将输入的文件分解成适当大小的“splits”(通常是64MB或128MB),框架为每一个split赋予一个Map任务。

(2)map函数

map函数处理输入的键/值对,生成零个或多个中间输入键/值对。

(3)分区函数

每个map函数的输出通过应用定义的分区函数分配给特定的reduce任务。

分区函数的输入是键、值、reduce任务的数量,输出的是reduce任务的索引值。

选择适当的分区函数对于数据在reduce间的平均分布和负载均衡非常重要。

(4)比较函数

通过应用的比较函数从Map运行的节点为reduce拉取数据并排序

(5)reduce函数

框架按键的排序为每个唯一的键调用一次reduce函数。

reduce函数会在与键相关的多个值中迭代,然后生成零个或多个输出。

(6)输出程序

输出程序负责将reduce的输出写入稳定存储。

3、MapReduce实例

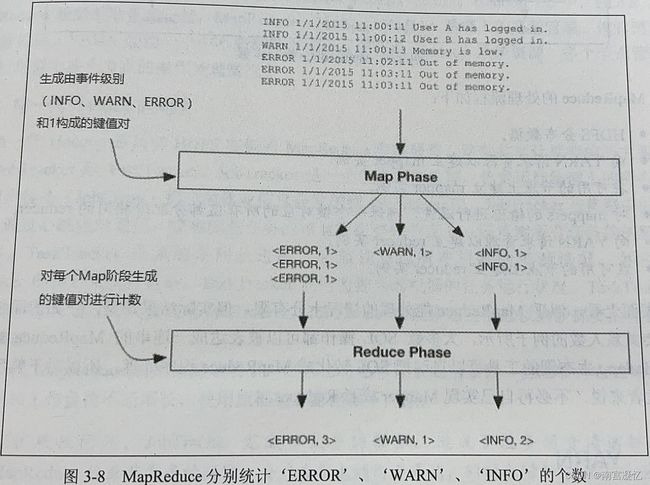

现在想知道日志中ERROR、WARN、INFO分别的个数。

如图所示,在map阶段检查每一行并标识键值对,如果行以“INFO”开头,键值对为

在reduce阶段,对每个map阶段生成的唯一键值"INFO","WARN","ERROR"进行计数。

Hadoop MapReduce的实现分为split、map、shuffle、reduce 4步,开发者只需要在Mappers和Reducers的Java类中编码map和reduce阶段的逻辑,框架完成其余的工作。