【python】某站视频评论爬取+情感分析

【python】毕站视频评论爬取+情感分析

-

- 前言

- 环境配置

- 爬取毕站评论(1)

-

- 如何获取发送请求的关键信息

- 爬取毕站评论(2)

- 正则表达式匹配所需信息

- 文本数据处理

- 情感分析

- 运行结果

- 总结

前言

最近逛毕站看到个关于某毕站视频弹幕的python情感分析的小项目,感觉挺有意思的,想求个源码玩一玩,不料竟然要我20大洋,正好放寒假了,那就自己查查资料学一学吧,随便练练手,提升下兴趣,于是便开始了这个小项目。(2023.1.2)

实现方法

爬虫爬取毕站评论信息 > 关键词正则匹配的方式抽取信息 > 文本数据处理 > nlp情感分析

“”"

爬虫代码实现步骤是什么?

1、发送请求

2.获取数据

3.解析数据

4.保存数据

“”"

环境配置

本文用PyCharm来写,所需的库为

import re

import time

import jieba

import requests

import xlwt

from snownlp import SnowNLP

这里简单介绍下snowNLP,一个处理中文文本的类库,可以分词,标注,还可以进行情绪分析。

因版权问题以下url以xxxxxxxxxxxxx显示

爬取毕站评论(1)

# 爬虫第一步:发送请求

# 请求网址

main_url = 'https://xxxxxxxxxxxxxx'

reply_url = 'https://xxxxxxxxxxxxxx'

# 请求头

headers = {

# user-agent用户代理表示浏览器基本身份标识

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/108.0.0.0 Safari/537.36'

}

# 发送请求

response = requests.get(url=main_url, headers=headers)

# 解决网页数据乱码

response.encoding = 'utf-8' # 出现数据乱码的话就可以加这句话

上面代码中可以看到有两个请求网址一个是main_url,另一个是reply_url,这两者的区别是

main_url可以得到如下图所示的主评论和三个评论的评论

而reply_url可以得到如下图所示的主评论的所有评论

实际上写代码中用main_url就可以了

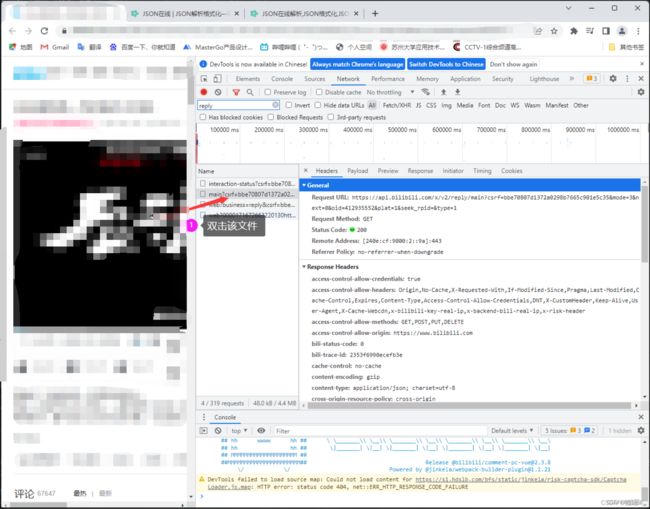

如何获取发送请求的关键信息

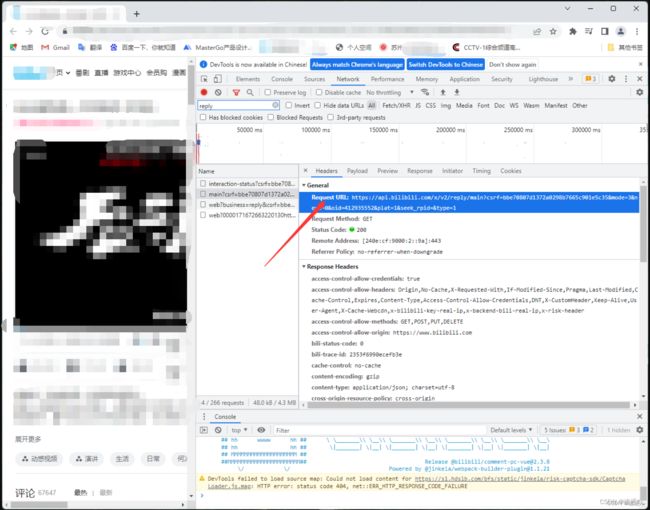

这里以Chrome浏览器 + b站热门视频《后浪》进行演示

打开视频网站,点击F12可以跳出开发者模式,如下图所示

在这里你能找到所需url,请求头所需的内容如cookie,user-agent等内容,这里我们仅需要url和user-agent

爬取毕站评论(2)

以上代码仅是爬取了一页的评论,如果想获取多页评论就需要添加for循环并动态修改url中next的值,并对数据进行合并处理。代码如下:

messages_list = []

unames_list = []

for i in range(30):

# 请求网址

time.sleep(1) # 防止操作过快,网站防爬

main_url = f'https://xxxxxxxxxxxx...next={i}....'

# 请求头

headers = {

# user-agent用户代理表示浏览器基本身份标识

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/108.0.0.0 Safari/537.36'

}

# 发送请求

response = requests.get(url=main_url, headers=headers)

# 解决网页数据乱码

response.encoding = 'utf-8'

# 评论的作者和名字

messages = re.findall(r'"message":"(.*?)",', response.content.decode())[1:]

for message in messages:

messages_list.append(message)

unames = re.findall(r'"uname":"(.*?)",', response.content.decode())

for uname in unames:

unames_list.append(uname)

print(messages_list)

print(unames_list)

正则表达式匹配所需信息

# 子评论的作者和名字

messages = re.findall(r'"message":"(.*?)",', response.content.decode())[1:]

for message in messages:

messages_list.append(message)

unames = re.findall(r'"uname":"(.*?)",', response.content.decode())

for uname in unames:

unames_list.append(uname)

print(messages_list)

print(unames_list)

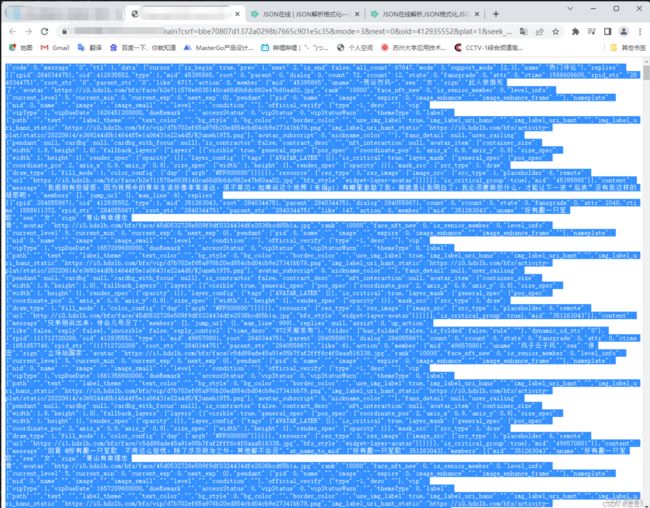

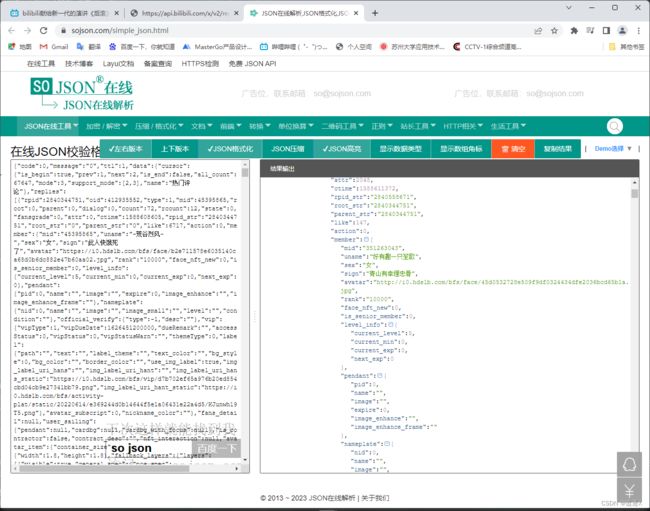

关于如何快速便捷的找到关键字呢?,我们可以采用一个叫JSON在线解析的一个小工具

在这就可以较为清楚到找到对应的信息啦,注意要搭配原视频下的评论和Ctrl+F快速查找使用更方便哦

文本数据处理

通过以上操作,我们便获得了评论的作者和文本信息了,但是这些评论中有很多我们不需要的奇怪字符,这些字符可能会影响我们接下来的情感分析,所以对这些文本进行数据的清理是很有必要的;

# 文本数据处理

def clear_character(message):

pattern1 = '[a-zA-Z0-9]'

pattern2 = re.compile(u'[^\s1234567890::' + '\u4e00-\u9fa5]+')

pattern3 = '[\s+\.\!\/_,$%^*(+\"\']+|[+——!,。??、~@#¥%……&*()]+'

line1 = re.sub(pattern1, '', message) # 去除英文字母和数字

line2 = re.sub(pattern2, '', line1) # 去除表情和其他字符

line3 = re.sub(pattern3, '', line2) # 去除去掉残留的冒号及其它符号

new_message = ''.join(line3.split()) # 去除空白

return new_message

def fen_ci(new_message):

with open('停用词表.txt', 'r', encoding='utf-8') as f:

stop_word = f.read()

word = jieba.cut(new_message)

words = []

for i in list(word):

if i not in stop_word:

words.append(i)

words = "".join(words)

return words

这里我用了两个函数对所获文本进行处理,第一个是比较基础的去除一些奇怪字符,第二个是做了一个jieba分词和停用词设置这里用了网上常见的停用词表,直接复制网上的就好,也可以根据自己的特殊情况进行设置;"停用词表.txt"该文件直接放在项目文件下就行。

情感分析

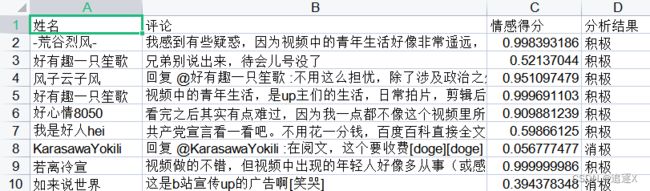

这里我用一个emotional函数进行情感分析,并将结果保存到表格里,代码和注释如下:

def emotional(messages_list, unames_list):

# 保存到表格中

# 实例化表格

workbook = xlwt.Workbook(encoding='utf-8')

# 实例化一个sheet

worksheet = workbook.add_sheet('sheet_000001')

# 第一个值为行第二个值为列第三个值为内容

worksheet.write(0, 0, '姓名')

worksheet.write(0, 1, '评论')

worksheet.write(0, 2, '情感得分')

worksheet.write(0, 3, '分析结果')

# 统计情绪

pos_count = 0 # 积极情绪计数器

neg_count = 0 # 消极情绪计数器

for i in range(len(messages_list)):

# 姓名

name = unames_list[i]

# 评论

message = messages_list[i]

# 调用之前的两个函数进行数据处理

new_message = clear_character(message)

words = fen_ci(new_message)+' ' # 这里要加个' '防止函数将某些评论直接处理没了

# 情感得分

sentiments_score = SnowNLP(words).sentiments

if sentiments_score < 0.5:

tag = '消极'

neg_count += 1

else:

tag = '积极'

pos_count += 1

# 分数在0-1之前我们可以定义为小于0.5的为消极情绪 大于等于0.5的为积极情绪

# 将结果一行一行写到表格中

worksheet.write(i + 1, 0, name)

worksheet.write(i + 1, 1, message) # 这里可以改为words写入处理过的评论信息

worksheet.write(i + 1, 2, sentiments_score)

worksheet.write(i + 1, 3, tag)

workbook.save('nlp分析.xls')

# 统计一下评论的情绪分别的占比是多少

# round去限制小数有多少位

try:

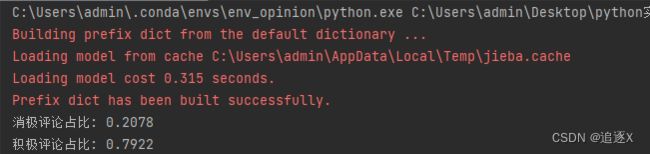

print('消极评论占比:', round(neg_count / (neg_count + pos_count), 4))

print('积极评论占比:', round(pos_count / (neg_count + pos_count), 4))

except Exception as e:

print('程序出现了异常:', e)

运行结果

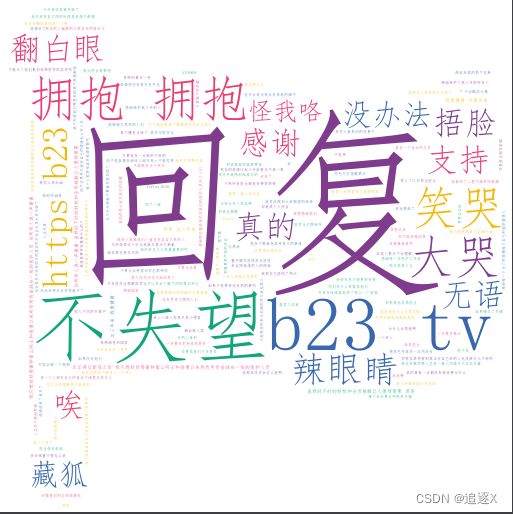

此外调用wordcloud 词云模块,还可以做出好玩的词云图,如图

总结

好了,到此,这个简单的项目就结束了。事实上,这就是个简单的爬虫+数据处理的小项目,关于情感分析的模块也没建立自己的模型分析,你甚至可以尝试调用百度的API接口来完成这个有意思的小项目。

最后求点赞,求收藏!求评论,爱你

(有不懂的可以私信我,我会在文章中进行补充)

以上就是本文的主要内容,有错误请各位大佬指正。