[云原生1.]Docker数据管理与Cgroups资源控制管理

文章目录

- 1. Docker的数据管理

-

- 1.1 数据卷

-

- 1.1.1 示例

- 1.2 数据卷容器

- 2. 容器互联

- 3. Cgroups资源控制管理

-

- 3.1 简介

- 3.2 cgroups的主要功能

- 3.3 cpu时间片的简单介绍

- 3.4 对CPU使用的限制

-

- 3.4.1 对CPU使用的限制(基于单个容器)

- 3.4.2 对CPU使用的限制(基于多个容器)

- 3.5 设置容器绑定指定的cpu

- 4. 对内存使用的限制

- 5. 对磁盘IO配额控制(blkio)的限制

-

- 5.1 模拟实现

- 6. 清理docker占用的磁盘空间

1. Docker的数据管理

管理 Docker 容器中数据主要有两种方式:

1. 数据卷(Data Volumes)

2. 数据卷容器(DataVolumes Containers)。

1.1 数据卷

- 数据卷是一个供容器使用的特殊目录,位于容器中。

- 可将宿主机的目录挂载到数据卷上,对数据卷的修改操作立刻可见,并且更新数据不会影响镜像,从而实现数据在宿主机与容器之间的迁移。

- 数据卷的使用类似于 Linux 下对目录进行的 mount 操作。

1.1.1 示例

docker pull centos:7

#获取centos7的镜像

#将宿主机目录/var/www 挂载到容器中的/data1

#注:宿主机本地目录的路径必须是使用绝对路径。如果路径不存在,Docker会自动创建相应的路径。

docker run -v /var/www:/data1 --name web1 -it centos:7 /bin/bash #-v 选项可以在容器内创建数据卷

#进入容器

echo "this is web1" > /data1/abc.txt

exit

#返回宿主机进行查看

cat /var/www/abc.txt

1.2 数据卷容器

如果需要在容器之间共享一些数据,最简单的方法就是使用数据卷容器。

数据卷容器是一个普通的容器,专门提供数据卷给其他容器挂载使用。

#创建一个容器作为数据卷容器

docker run --name web2 -v /data1 -v /data2 -it centos:7 /bin/bash

echo "this is web2" > /data1/abc.txt

echo "THIS IS WEB2" > /data2/ABC.txt

#使用 --volumes-from 来挂载 web2 容器中的数据卷到新的容器

docker run -it --volumes-from web2 --name web3 centos:7 /bin/bash

cat /data1/abc.txt

cat /data2/ABC.txt

2. 容器互联

容器互联是通过容器的名称在容器间建立一条专门的网络通信隧道。

简单点说,就是会在源容器和接收容器之间建立一条隧道,接收容器可以看到源容器指定的信息。

#创建并运行源容器取名web1

docker run -itd -P --name web1 centos:7 /bin/bash

#创建并运行接收容器取名web2,使用--link选项指定连接容器以实现容器互联

bash复制代码docker run -itd -P --name web2 --link web1:scj centos:7 /bin/bash

#--link 容器名:连接的别名

#进web2 容器, ping web1

docker exec -it web2 bash

ping web1

3. Cgroups资源控制管理

3.1 简介

Cgroup 是 ControlGroups 的缩写,是 Linux 内核提供的一种可以限制、记录、隔离进程组所使用的物理资源(如 CPU、内存、磁盘 IO 等等) 的机制,被 LXC、docker 等很多项目用于实现进程资源控制。

Cgroup 本身是提供将进程进行分组化管理的功能和接口的基础结构,I/O 或内存的分配控制等具体的资源管理是通过该功能来实现的。

3.2 cgroups的主要功能

资源限制:可以对任务使用的资源总额进行限制。

优先级分配:通过分配的cpu时间片数量以及磁盘IO带宽大小,实际上相当于控制了任务运行优先级。

资源统计:可以统计系统的资源使用量,如cpu时长,内存用量等。

任务控制: cgroup可以对任务 执行挂起、恢复等操作。

3.3 cpu时间片的简单介绍

时间片即CPU分配给各个程序的时间,每个线程被分配一个时间段,称作它的时间片,即该进程允许运行的时间,使各个程序从表面上看是同时进行的。

如果在时间片结束时进程还在运行,则CPU将被剥夺并分配给另一个进程。

如果进程在时间片结束前阻塞或结束,则CPU当即进行切换。而不会造成CPU资源浪费。

- 在宏观上:我们可以同时打开多个应用程序,每个程序并行不悖,同时运行。

- 但在微观上:由于只有一个CPU,一次只能处理程序要求的一部分,如何处理公平,一种方法就是引入时间片,每个程序轮流执行。

3.4 对CPU使用的限制

3.4.1 对CPU使用的限制(基于单个容器)

Linux通过CFS (Completely Fair Scheduler, 完全公平调度器)来调度各个进程对CPU的使用。

CFS默认的调度周期是100ms。

我们可以设置每个容器进程的调度周期,以及在这个周期内各个容器最多能使用多少CPU时间。

使用 --cpu-period 即可设置调度周期

使用 --cpu-quota 即可设置在每个周期内容器能使用的CPU时间。两者可以配合使用。

CFS 周期的有效范围是 1ms~1s,对应的 --cpu-period 的数值范围是 1000~1000000。

而容器的 CPU 配额必须不小于 1ms,即 --cpu-quota 的值必须 >= 1000。

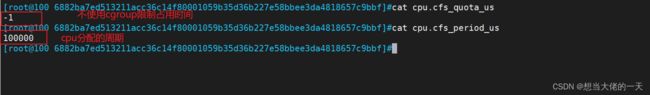

#先进入到容器的目录当中查看他们的cpu设置cd /sys/fs/cgroup/cpu/docker/容器的id

cat cpu.cfs_quota_us

cat cpu.cfs_period_us

---------------------------------------------------------------------------------------------------------

#cpu.cfs_period_us:cpu分配的周期(微秒,所以文件名中用 us 表示),默认为100000。

#cpu.cfs_quota_us:表示该cgroups限制占用的时间(微秒),默认为-1,表示不限制。 如果设为50000,表示占用50000/100000=50%的CPU。

---------------------------------------------------------------------------

#进行CPU压力测试

docker exec -it web2 bash

vim /cpu.sh

#!/bin/bash

i=0

while true

do

let i++

done

#一个循环脚本

chmod +x /cpu.sh

./cpu.sh

#添加执行权限并执行

top

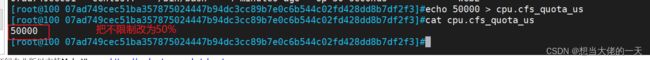

#设置50%的比例分配CPU使用时间上限

docker run -itd --name web --cpu-quota 50000 centos:7 /bin/bash #可以重新创建一个容器并设置限额

或者

cd /sys/fs/cgroup/cpu/docker/07ad749cec51ba357875024447b94dc3cc89b7e0c6b544c02fd428dd8b7df2f3/

echo 50000 > cpu.cfs_quota_us

docker exec -it 07ad749cec51 /bin/bash

./cpu.sh

3.4.2 对CPU使用的限制(基于多个容器)

Docker 通过 --cpu-shares 指定 CPU 份额,默认值为1024,值为1024的倍数。

#创建两个容器为 c1 和 c2,若只有这两个容器,设置容器的权重,使得c1和c2的CPU资源占比为1/3和2/3。

docker run -itd --name c1 --cpu-shares 512 centos:7

docker run -itd --name c2 --cpu-shares 1024 centos:7

#分别进入容器,进行压力测试

yum install -y epel-release

yum install -y stress

stress -c 4 #产生四个进程,每个进程都反复不停的计算随机数的平方根

进行压力测试,查看容器状态

docker stats

可以看到在 CPU 进行时间片分配的时候,容器 c2 比容器 c1 多一倍的机会获得 CPU 的时间片。

但分配的结果取决于当时主机和其他容器的运行状态, 实际上也无法保证容器 c1 一定能获得 CPU 时间片。

比如容器 c1 的进程一直是空闲的,那么容器 c2 是可以获取比容器 c1 更多的 CPU 时间片的。

极端情况下,例如主机上只运行了一个容器,即使它的 CPU 份额只有 50,它也可以独占整个主机的 CPU 资源。

3.5 设置容器绑定指定的cpu

创建一个容器进行测试

css复制代码格式:

docker run --cpuset-cpus CPUID1[,CPUID2...]

docker run -itd --name c1--cpuset-cpus 1,3 centos:7 /bin/bash

docker exec -it c1 bash

stress -c 4

4. 对内存使用的限制

docker run -id --name c2 centos:7

#一个未被限制的容器

docker run -id --name c1 -m 512m centos:7

#-m可以对容器的内存进行限制

使用docker stats进行查看

限制可用的 swap 大小, --memory-swap

强调一下,--memory-swap 是必须要与 --memory 一起使用的。

正常情况下,--memory-swap 的值包含容器可用内存和可用 swap。

所以 -m 300m --memory-swap=1g 的含义为:容器可以使用 300M 的物理内存,并且可以使用 700M(1G - 300)的 swap。

如果 --memory-swap 设置为 0 或者 不设置,则容器可以使用的 swap 大小为 -m 值的两倍。

如果 --memory-swap 的值和 -m 值相同,则容器不能使用 swap。

如果 --memory-swap 值为 -1,它表示容器程序使用的内存受限,而可以使用的 swap 空间使用不受限制(宿主机有多少 swap 容器就可以使用多少)。

5. 对磁盘IO配额控制(blkio)的限制

--device-read-bps:限制某个设备上的读速度bps(数据量),单位可以是kb、mb(M)或者gb。

例:docker run -itd --name test9 --device-read-bps /dev/sda:1M centos:7 /bin/bash

--device-write-bps : 限制某个设备上的写速度bps(数据量),单位可以是kb、mb(M)或者gb。

例:docker run -itd --name test10 --device-write-bps /dev/sda:1mb centos:7 /bin/bash

--device-read-iops :限制读某个设备的iops(次数)

--device-write-iops :限制写入某个设备的iops(次数)

5.1 模拟实现

#先创建一个容器来先不限制他的读写性能,看看读写的速度

docker run -id --name c3 centos:7 bash

docker exec -it c3 /bin/bash

dd if=/dev/zero of=/opt/test1.txt bs=1M count=10 oflag=direct

#再创建一个容器限制他的读写性能

docker run -id --name c4 --device-write-bps /dev/sda:1M centos:7 bash

docker exec -it c4 /bin/bash

dd if=/dev/zero of=/opt/test1.txt bs=1M count=10 oflag=direct

6. 清理docker占用的磁盘空间

可以用于清理磁盘,删除关闭的容器、无用的数据卷和网络

docker system prune -a

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第1张图片](http://img.e-com-net.com/image/info8/102efbd42f2f41d0b26651b5a81243f9.jpg)

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第2张图片](http://img.e-com-net.com/image/info8/7bc4c9a2deed44a6879648f201b25586.jpg)

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第3张图片](http://img.e-com-net.com/image/info8/349eef112ead4d0a87f92f4375a9c191.jpg)

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第4张图片](http://img.e-com-net.com/image/info8/576174638198470e97c5aa40c9913426.jpg)

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第5张图片](http://img.e-com-net.com/image/info8/e496c51d37a6427ab9a87eda55e6d268.jpg)

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第6张图片](http://img.e-com-net.com/image/info8/47456f37e42243aeb7798a3398a7c37b.jpg)

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第7张图片](http://img.e-com-net.com/image/info8/1ca424c0b82e4cbbbc8e7040bef02230.jpg)

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第8张图片](http://img.e-com-net.com/image/info8/cdd434a07c404887ab632a9ec9aa956d.jpg)

![[云原生1.]Docker数据管理与Cgroups资源控制管理_第9张图片](http://img.e-com-net.com/image/info8/f92fb48d91ad435ca0a89a6dc71d2930.jpg)