应用ceph文件系统存储(ceph-13.2.10)

记录:333

场景:在CentOS 7.9操作系统上,部署ceph-13.2.10集群。应用ceph文件系统(ceph file system);主要是创建ceph文件系统、客户端挂载ceph文件系统等操作。

版本:

操作系统:CentOS 7.9

ceph版本:ceph-13.2.10

名词:

Ceph:一个开源的分布式存储系统。

Ceph: Ceph is a distributed object store and file system designed to provide excellent performance, reliability and scalability.

地址:

官网:https://docs.ceph.com/

安装包地址:https://mirrors.aliyun.com/ceph/rpm-mimic/

1.基础环境

1.1 Ceph集群(服务端)

集群已安装软件:ceph-deploy、ceph、ceph-radosgw。

集群已部署组件:mon、mgr、mds、osd、rgw。

查看集群状态:ceph -s

1.2 Ceph客户端

在集群之外的主机app166中部署客户端。操作ceph集群的存储系统。

安装命令:yum install -y ceph-common

解析:在客户端主机安装ceph-common,操作集群。

1.3主机软件规划

ceph集群和ceph客户端的主机、IP以及组件分布规划。

1.4安装ceph

离线安装ceph集群,可以参考如下博文。

博文:离线安装ceph集群(ceph-13.2.10)

地址:https://blog.csdn.net/zhangbeizhen18/article/details/128052772

2.创建ceph文件系统

在主节点app161操作,操作目录:cd /etc/ceph。

(1)查看mds确定已安装mds

查看命令:ceph mds stat

解析:查看mds状态,如果没安装mds,那么需安装mds。

安装命令:ceph-deploy mds create app161 app162 app163

(2)创建两个存储池

一个ceph文件系统至少要两个RADOS存储池,一个用于存放数据,一个用于存放元数据。

创建存放数据pool:ceph osd pool create xihu_data 16

创建存放元数据pool:ceph osd pool create xihu_metadata 8

解析:创建存储池xihu_data和xihu_metadata。

(3)创建ceph文件系统

命令:ceph fs new hangzhoufs xihu_metadata xihu_data

解析:使用ceph fs new创建ceph文件系统;文件系统名称:hangzhoufs;存储池xihu_data和xihu_metadata。

(4)查ceph文件系统

命令:ceph fs ls

解析:查看ceph文件系统,打印文件系统名称和存储池。

打印信息:name: hangzhoufs, metadata pool: xihu_metadata, data pools: [xihu_data ]

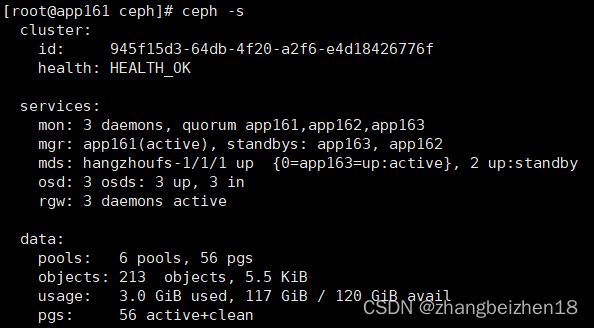

(5)查看集群状态

命令:ceph -s

解析:查看集群状态。包括cluster、services、data三个模块。mds下已经看到hangzhoufs文件系统。

3.开启客户端认证

在主节点app161操作,操作目录:cd /etc/ceph。

(1)确认ceph.conf文件

文件:/etc/ceph/ceph.conf

内容:auth_client_required = cephx

(2)确认客户端秘钥

秘钥文件名称:/etc/ceph/ceph.client.admin.keyring

秘钥内容:

[client.admin]

key = AQDtioBjVwefMBAAu0/oJPK2khWK+juNOQkyZw==

caps mds = "allow *"

caps mgr = "allow *"

caps mon = "allow *"

caps osd = "allow *"4.客户端挂载ceph文件系统

在客户端节app166操作,操作目录:cd /etc/ceph。

挂载ceph文件系统目的就是把ceph文件系统挂载到客户端app166中。

4.1安装客户端

安装客户端:yum install -y ceph-common

4.2配置户端

(1)创建配置目录

命令:mkdir -p /etc/ceph

解析:如果没有则创建目录。

(2)生成配置文件

从主节点app161的/etc/ceph/ceph.client.admin.keyring中的取出key值。

写入到客户端节点app166的/etc/ceph/client-admin.key。

方式一:

创建文件:vi /etc/ceph/client-admin.key

添加内容:AQDtioBjVwefMBAAu0/oJPK2khWK+juNOQkyZw==

方式二:

命令:echo 'AQDtioBjVwefMBAAu0/oJPK2khWK+juNOQkyZw=='>>/etc/ceph/client-admin.key

(3)创建挂载文件系统的目录

命令:mkdir /hangzhoufs_data

解析:此目录就是为了把远程文件系统挂载到本地使用。

(4)挂载文件系统

挂载ceph文件系统命令:mount.ceph 192.168.19.161:6789:/ /hangzhoufs_data/ -o name=admin,secretfile=/etc/ceph/client-admin.key

解析:mount.ceph,挂载命令。192.168.19.161:6789:/,指定主机和端口,其中端口6789是mon的端口,/斜杆表示从文件系统根目录。/hangzhoufs_data/,表示挂载到本地的目录。-o表示指定参数选项。name=admin,表示用户名,实际就是ceph.client.admin.keyring文件中的admin。secretfile,表示秘钥文件。

(5)查看客户端挂载文件系统

命令:df -h

解析:挂载后:192.168.19.161:6789:/ 37G 0 37G 0% /hangzhoufs_data;从磁盘挂载信息看到已经挂载成功。

(6)在客户端操作挂载目录

目录:cd /hangzhoufs_data

5.应用ceph文件系统

在客户端节app166中。/hangzhoufs_data目录就是挂载了ceph文件系统,对这个文件做增删改查操作,就是在操作ceph文件系统。数据也是存储在ceph文件系统。

6.删除ceph文件系统

6.1删除客户端数据

在客户端节app166操作,操作目录:cd /hangzhoufs_data。

(1)删除数据

命令:rm -rf /hangzhoufs_data/*

解析:删除已经挂载目录数据。

(2)卸载已挂载的目录

命令:umount /hangzhoufs_data/

解析:卸载已挂载的目录

(3)查看磁盘

命令:df -h

解析:查看磁盘情况。

6.2停止mds守护进程

节点app161:systemctl stop ceph-mds.target

节点app162:systemctl stop ceph-mds.target

节点app163:systemctl stop ceph-mds.target

6.3删除ceph文件系统

命令:ceph fs rm hangzhoufs --yes-i-really-mean-it

解析:hangzhoufs是已创建的ceph文件系统名称。

6.4删除ceph存储池pool

删除元数据池:ceph osd pool delete xihu_metadata xihu_metadata --yes-i-really-really-mean-it

删除数据池:ceph osd pool delete xihu_data xihu_data --yes-i-really-really-mean-it

解析:删除pool时,需传递两次pool的名称。

6.5重启mds守护进程

节点app161:systemctl start ceph-mds.target

节点app162:systemctl start ceph-mds.target

节点app163:systemctl start ceph-mds.target

解析:重启mds。

以上,感谢。

2022年11月26日