ceph-deploy部署ceph集群,安装Web-UI

使用ceph-deploy快速安装ceph

1.把ceph仓库添加到ceph-deploy管理节点

- 新增 /etc/yum.repos.d/ceph.repo(管理节点上) .

[ceph-noarch]

baseurl=http://download.ceph.com/rpm-nautilus/el7/noarch

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=https://download.ceph.com/keys/release.asc`

- 安装python-setuptools 否则可能出错,(在管理节点上)

yum install python-setuptools

- 更新源并且安装ceph-deploy

yum install ceph-deploy -y

#使用ceph-deploy --version 查看版本信息

2.配置各个节点的hosts文件(在所有节点上)

10.2.239.88 admin

10.2.239.89 node2

10.2.239.90 node2

3.配置ssh无密码登录(管理节点上)

- 生成秘钥对

ssh-keygen

- 拷贝key到各个节点

ssh-copy-id admin

ssh-copy-id node2

ssh-copy-id node3

4.配置ntp服务器实现时间同步

-

在管理节点安装ntp服务端

-

在其他节点安装ntp客户端,然后同步netp服务端的时间

5.创建一个目录,存放ceph-deploy执行过程中生成的一些配置文件

mkdir cluster

cd cluster

6.创建集群(cluster),部署新的monitor

ceph-deploy new node1 #此操作会生成一堆配置文件

7.配置Ceph.conf配置文件(ceph osd默认节点为3个,修改节点个数为2)

osd pool default size = 2 #这步不是必须的,如果osd的个数超过三个就不需要设置

8.安装ceph到各节点(在管理节点上)

ceph-deploy install {ceph-node}{ceph-node}

9.获取秘钥key,回在my-cluster目录下生成几个key

ceph-deploy mon create-initial

10.分发key admin的配置文件推送到子节点上

ceph-deploy admin {ceph-admin}{ceph-node}

11.查看集群状态

ceph health

ceph -s

12.在node1上安装mgr

ceph-deploy mgr create node1

13.给集群中添加节点(在管理节点中)

```sh

ceph-deploy osd create node1 --data /dev/sdb

ceph-deploy osd create node2 --data /dev/sdb

ceph-deploy osd create node3 --data /dev/sdb

14.查看集群中的osd(在管理节点)

ceph osd tree

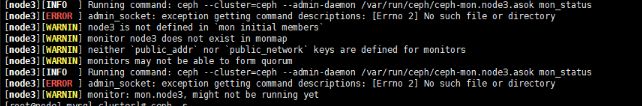

15.扩展mon

mon使用 Paxos算法,部署奇数个,自动保持高可用,自动会仲裁

ceph-deploy mon add node2 --address ip地址xxx

eph-deploy --overwrite-conf config push node1 node2 node3 #修改配置后,推送到各个节点

16.增加mds 元数据服务器

ceph-deploy mds create node1 #免费版本 只支持部署一个mds

17.查看 mon高可用节点的选举状态

ceph quorum_status --format json-prett

18.查看mon状态

ceph mon stat``ceph mon dump #查看更加详细的参数

19.mgr高可用

ceph-deploy mgr create node2 node3

20.安装dashborad(在mgr节点) Web-UI

- 安装ceph-mgr-dashboard

yum install ceph-mgr-dashboard

- 查询是否安装成功

ceph mgr module ls | grep dashboard

- 生成证书

ceph dashboard create-self-signed-cert

- 创建具有管理员权限的用户

ceph dashboard ac-user-create <username> <password> administrator

- 启动dashboard

ceph mgr module enable dashboard --force

- 访问WEB-UI

https://10.2.239.88:8443

#默认端口为8443,端口可以修改 详见https://docs.ceph.com/en/latest/mgr/dashboard/#enabling