k8s、数据存储

数据存储的概念

容器磁盘上的文件的生命周期是短暂的,这就使得在容器中运行重要应用时会出现一些问题。首先,当容器崩溃时,kubelet 会重启它,但是容器中的文件将丢失——容器以干净的状态(镜像最初的状态)重新启动。其次,在Pod中同时运行多个容器时,这些容器之间通常需要共享文件。Kubernetes 中的Volume抽象就很好的解决了这些问题。Pod中的容器通过Pause容器共享Volume。

1、emptyDir存储卷

当Pod被分配给节点时,首先创建emptyDir卷,并且只要该Pod在该节点上运行,该卷就会存在。正如卷的名字所述,它最初是空的。Pod 中的容器可以读取和写入emptyDir卷中的相同文件,尽管该卷可以挂载到每个容器中的相同或不同路径上。当出于任何原因从节点中删除 Pod 时,emptyDir中的数据将被永久删除。

总结:可以实现 pod 中的容器之间共享数据,但是存储卷不能持久化数据,并且会随着 pod 生命周期而一起删除

案例:

vim pod-emptydir.yaml

apiVersion: v1

kind: Pod

metadata:

name: pod-emptydir

namespace: default

labels:

app: myapp

tier: frontend

spec:

containers:

- name: myapp

image: ikubernetes/myapp:v1

imagePullPolicy: IfNotPresent

ports:

- name: http

containerPort: 80

#定义容器挂载内容

volumeMounts:

#使用的存储卷名称,如果跟下面volume字段name值相同,则表示使用volume的这个存储卷

- name: html

#挂载至容器中哪个目录

mountPath: /usr/share/nginx/html/

- name: busybox

image: busybox:latest

imagePullPolicy: IfNotPresent

volumeMounts:

- name: html

#在容器内定义挂载存储名称和挂载路径

mountPath: /data/

command: ['/bin/sh','-c','while true;do echo $(date) >> /data/index.html;sleep 2;done']

#定义存储卷

volumes:

#定义存储卷名称

- name: html

#定义存储卷类型

emptyDir: {}

kubectl apply -f pod-emptydir.yaml #创建pod

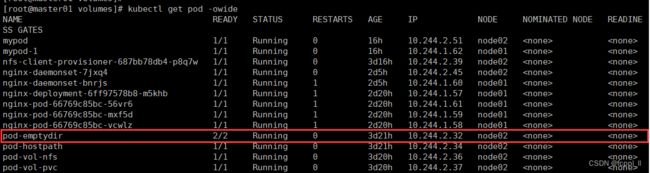

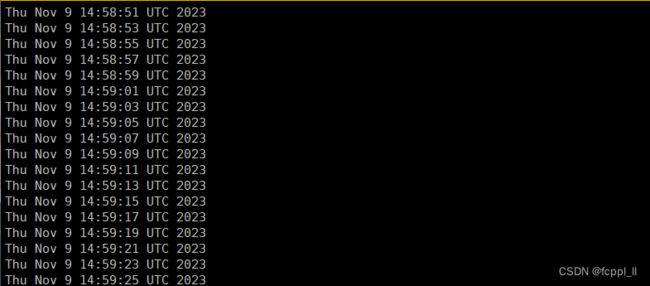

kubectl get pods -o wide #查看详细信息//在上面定义了2个容器,其中一个容器是输入日期到index.html中,然后验证访问nginx的html是否可以获取日期。以验证两个容器之间挂载的emptyDir实现共享。

curl 10.244.2.322、hostPath存储卷

hostPath卷将 node 节点的文件系统中的文件或目录挂载到集群中。

hostPath可以实现持久存储,但是在node节点故障时,也会导致数据的丢失

总结:可以实现持久化数据,使用node节点的目录或者文件挂载到容器,但是存储空间会受到node节点单机限制,node节点故障数据会丢失,pod 跨 node 节点不能共享数据

案例:

在 node01 节点上创建挂载目录

mkdir -p /data/pod/volume1

echo 'node01.kgc' > /data/pod/volume1/index.html

在 node02 节点上创建挂载目录

mkdir -p /data/pod/volume1

echo 'node02.kgc' > /data/pod/volume1/index.html创建 Pod 资源

vim pod-hostpath.yaml

apiVersion: v1

kind: Pod

metadata:

name: pod-hostpath

namespace: default

spec:

containers:

- name: myapp

image: ikubernetes/myapp:v1

#定义容器挂载内容

volumeMounts:

#使用的存储卷名称,如果跟下面volume字段name值相同,则表示使用volume的这个存储卷

- name: html

#挂载至容器中哪个目录

mountPath: /usr/share/nginx/html

#读写挂载方式,默认为读写模式false

readOnly: false

#volumes字段定义了paues容器关联的宿主机或分布式文件系统存储卷

volumes:

#存储卷名称

- name: html

#路径,为宿主机存储路径

hostPath:

#在宿主机上目录的路径

path: /data/pod/volume1

#定义类型,这表示如果宿主机没有此目录则会自动创建

type: DirectoryOrCreate

kubectl apply -f pod-hostpath.yaml访问测试 :

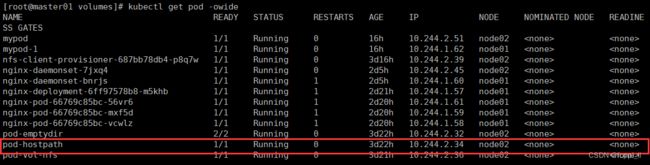

kubectl get pods -o wide

curl 对应的IP地址删除pod,再重建,验证是否依旧可以访问原来的内容

kubectl delete -f pod-hostpath.yaml

kubectl apply -f pod-hostpath.yaml 3、 nfs共享存储卷

HostPath可以解决数据持久化的问题,但是一旦Node节点故障了,Pod如果转移到了别的节点,又会出现问题了,此时需要准备单独的网络存储系统,比较常用的用NFS、CIFS。

总结: 可以实现持久化存储,使用 nfs 将存储设备空间挂载到容器, pod 可以跨节点共享数据

案例:

在stor01节点上安装nfs,并配置nfs服务

mkdir /data/volumes -p

chmod 777 /data/volumes

vim /etc/exports

/data/volumes 192.168.86.0/24(rw,no_root_squash)

systemctl start rpcbind

systemctl start nfs

showmount -e

Export list for stor01:

/data/volumes 192.168.10.0/24master节点操作

vim pod-nfs-vol.yaml

apiVersion: v1

kind: Pod

metadata:

name: pod-vol-nfs

namespace: default

spec:

containers:

- name: myapp

image: ikubernetes/myapp:v1

volumeMounts:

- name: html

mountPath: /usr/share/nginx/html

volumes:

- name: html

nfs:

path: /data/volumes

server: stor01

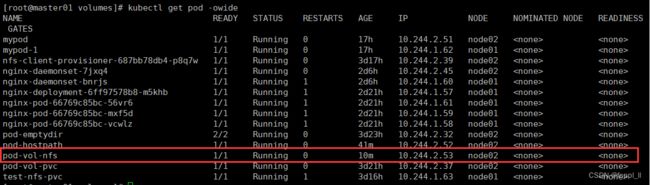

kubectl apply -f pod-nfs-vol.yaml

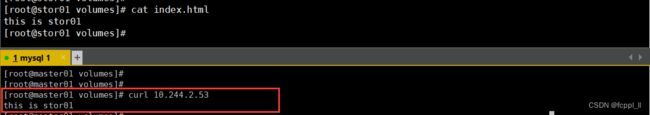

kubectl get pods -o wide在nfs服务器上创建index.html

echo "this is stor01" > /data/volumes/index.html

master节点操作

curl 10.244.2.53

this is stor01

高级存储

前面了解了使用NFS提供存储,此时就要求用户会搭建NFS系统,并且会在yaml配置nfs,由于k8s支持的存储系统有很多,要求客户全都掌握,显然不现实。为了能够屏蔽底层存储实现的细节,方便用户使用,k8s引入了PV和PVC两种资源对象

-

PV 全称叫做【 Persistent Volume】:持久化存储卷: k8s在指定的存储设备空间中创建的可持久化的存储资源(PV是集群中的资源)

-

PVC 的全称叫做【Persistent Volume claim】:是持久化存储的请求:是对pv存储资源的请求和绑定(PVC是对这些资源的请求,也是对资源的索引检查。)

PVC 的使用逻辑:在 Pod 中定义一个存储卷(该存储卷类型为 PVC),定义的时候直接指定大小,PVC 必须与对应的 PV 建立关系,PVC 会根据配置的定义去 PV 申请,而 PV 是由存储空间创建出来的。PV 和 PVC 是 Kubernetes 抽象出来的一种存储资源。

PV和PVc之间的相互作用遵循这个生命周期

Provisioning(配置)---> Binding(绑定)---> Using(使用)---> Releasing(释放) ---> Recycling(回收)

- Provisioning【配置】:即 Pv 的创建,可以直接创建PV(静态方式),也可以使用storageClass(动态创建)

- Binding【绑定】 :将PV分配给Pvc

- Uing【使用】:Pod 通过 Pvc使用该Volume,并可以通过准入控制storageProtection【1.9及以前版本为rVCFrotection】阻止删除正在使用的 PVC

- Releasing【释放】 :Pod释放volume并删除pvc

- Reclaiming【回收】:回收PV,可以保留PV以便下次使用,也可以直接从云存储中删除

根据这 5个阶段,PV 的状态有以下 4 种

- Available 【可用】:表示可用状态,还未被任何 PVC 绑定

- Bound 【已绑定】:表示 PV 已经绑定到 PVC

- Released 【已释放】:表示 PVC 被删掉,但是资源尚未被集群回收

- Eailed 【失败】:表示该 PV 的自动回收失败

一个PV从创建到销毁的具体流程如下:

- 一个PV创建完后状态会变成Available【可用】,等待被PVC绑定

- 一旦被PVC邦定,PV的状态会变成Bound【已绑定】,就可以被定义了相应 Pvc 的 Pod 使用

- Pod使用完后会释放PV,PV的状态变成Releasedo【已释放】

- 变成 Released【已释放】的Pv会根据定义的回收策略做相应的回收工作。

有三种回收策略,Rctain、Delete和Recycle

- Retain:就是保留现场,Kes集群什么也不做,等待用户手动去处理 PV 里的数据,处理完后,再手动删除PV。

- Delete:K8s会自动删除该PV及里面的数据。

- Recycle:K8s会将Pv里的数据删除,然后把Pv的状态变成Available【可用】,又可以被新的Pvc绑定使用。

1、PV(持久化卷)

PV是存储资源的抽象,下面是资源清单文件

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv2 #注意:pv是存储资源的抽象,它不存命名空间的定义

spec:

nfs: #存储类型,与底层真正存储对应(有多种,比如NFS、GFS、CIFS等)

path:(定义挂载卷路径)

server:(定义服务器名称)

cappcity: #存储能力,也就是存储的空间大小

storage: 2Gi

accessModes: #访问模式

storageClassName: #存储类别

persistentVolumeReclaimPolicy: #回收策略PV的关键配置参数说明

- 存储类型

底层实际存储的类型,k8s支持多种存储类型,每种存储类型的配置都有所差异

- 存储能力(capacity)

目前只支持存储空间的设置(storage=1Gi),未来可能加入IOPS、吞吐量等指标的配置

- 访问模式(accessModes)

用户描述用户应用对存储资源的访问权限

访问权限包括下面几种方式

- ReadWriteOnce(RWO): 读写权限,但是只能被单个节点挂载

- ReadOnlyMany(ROX): 只读权限,可以被多个节点挂载

- ReadWriteMany(RWX):读写权限,可以被多个节点挂载

2、PVC(持久化卷声明)

PVC是资源的申请,用来声明对存储空间、访问模式、存储类别需求信息。

资源清单文件

apiVersion: v1

kind: PersistentVolumeClaim #定义pvc的资源类型

metadata:

name: pvc

namespace: dev #可以定义命名空间

sepc:

accessModes: #访问模式

selector: #采用标签对PV选择

storageClassName: #存储类别

resources: #请求空间

requests:

storage: 5GiPVC的关键配置参数说明

-

访问模式(accessModes)

用于描述用户应用对存储资源的访问权限

-

选择条件(selector)

通过Label Selector 的设置,可使PVC 对于系统中已存在的PV进行筛选

-

存储类别(storageClassName)

PVC在定义时可以设置需要的后端存储类别,只有设置了该class的PV才能被系统选出

-

资源请求(Resources)

描述对存储资源的请求