YOLOv5简介

YOLOv5

一、输入端

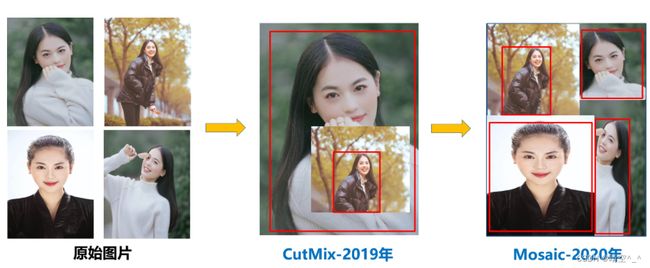

1. Mosaic数据增强:

CutMix 数据增强:随机生成一个裁剪框Box,裁剪掉A图中的相应位置,然后用B图相应位置的ROI放到A中被裁剪的区域中形成新的样本。采用加权求和的方式计算损失,将A区域中被cut掉的位置随机填充训练集中其他数据的区域像素值,分类结果按一定比例分配。

Mosaic数据增强:对四张图片进行拼接,每一张图片都有其对应的框框,将四张图片拼接之后就获得一张新的图片,同时也获得这张图片对应的锚框,之后将这张新的图片传入到神经网络当中学习,相当于一次传入四张图片进行学习。

论文中说这极大丰富了检测物体的背景!且在标准化BN计算的时候一次会计算四张图片的数据!主要用于小目标检测

2. 自适应锚框计算:

在输入图像中采样大量的区域,判断这些区域中是否包含感兴趣的目标,并调整区域边界从而更准确地预测目标的真实边界框(ground-truth bounding box)。 不同的模型使用的区域采样方法可能不同。 锚框:以每个像素为中心,生成多个缩放比和宽高比(aspect ratio)不同的边界框。

3. 自适应图片缩放:

1、原理:输入网络的尺寸统一缩放到同一个尺寸时,检测效果会更好(train中放入的图并不经过letterbox,而是检测的时候使用letterbox)。如果是简单的使用resize,很有可能就造成了图片信息的丢失,所以提出了letterbox自适应图片缩放技术。

letterbox的主要思想是尽可能的利用网络感受野的信息特征。比如在YOLOV5中最后一层的Stride=5,即最后一层的特征图中每个点,可以对应原图中32X32的区域信息

2、思想:图片变换比例一致指的是,长宽的收缩比例应该采用相同的比例。有效利用感受野信息则是指,对于收缩后不满足条件的一边,用灰白条填充至可以被感受野整除。

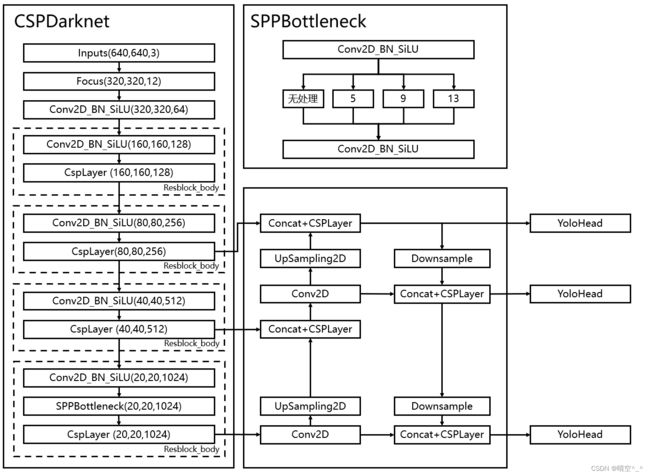

二、backbone

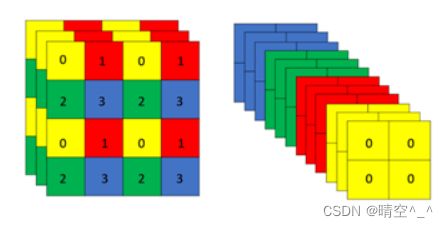

1、Focus层(现已弃用):

在获得输入后首先利用focus层将图像的宽高信息转换为通道信息。具体做法是在一张图片中,每隔一个像素获得一个像素,这时获得四个独立的特征层,之后进行特征层的堆叠。目的是减少参数量,增加运行速度。

在YOLOv5最新版本下,Focus层已经改为普通的 64 × 64 64 \times 64 64×64卷积层。如图:

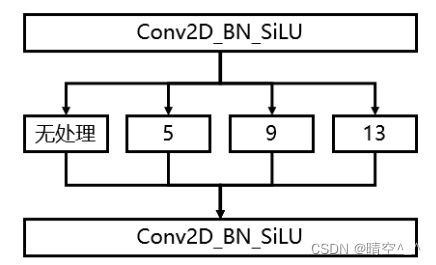

2、Conv2D_BN_SiLU卷积块:

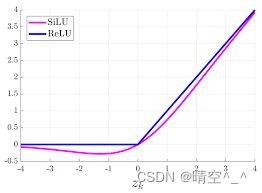

其中,SiLU激活函数是sigmoid和ReLU的改进版,其具有无上界有下界、平滑和单调的特性。

f ( x ) = x × s i g m o i d ( X ) f(x)=x \times sigmoid(X) f(x)=x×sigmoid(X)

部分版本也采用LeakyReLU激活函数。

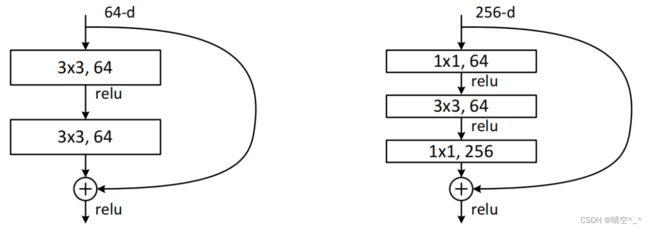

3、bottleneck

building block(图左)和bottleneck(图右)都是在Resnet提出的。其中,building block是Resnet34提出的,bottleneck是Resnet50提出的。在bottleneck中,1×1的卷积层的作用是减少参数量。经过实验证明,bottleneck即减少了参数量优化了计算,又保持了原有的精度。如果网络层数少的话,选用building block。而如果网络层数很深,为了减少计算量选用bottleneck。

shortcut处选择的是add而不是concat。作用是使特征图相加,维持通道数不变。

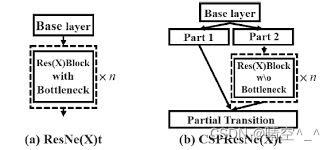

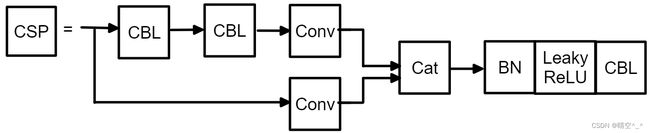

4、 CSPLayer:

YOLOv5的CSPNet结构将原输入分成两支(图b),两支分别进行卷积操作使得通道数减半。之后一个分支进行Bottleneck × N操作,然后concat两个分支进行通道数的堆叠。可以抽象的理解为CSPlayer有一个大的“残差边”。 这样的操作使得输入CSPLayer的特征与输出的通道数一致,目的是使模型习得更多的特征。

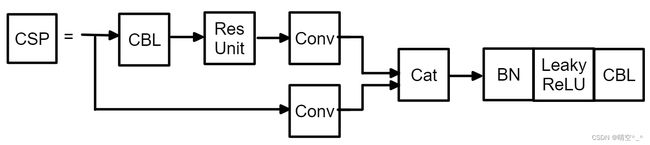

其中Backbone的CSPLayer结构为:

(CBL为Conv+BN+leakyReLU,CBS为Conv+BN+SiLU)

如图,其将输入先分成两支,一支先经过CBL块(后期改为CBS),再经过多个残差结构(Bottleneck × N),再经过一个卷积调整通道数。另一个分支直接进行卷积调整通道数。之后对这两个分支按通道进行堆叠,最后在经过一个CBL(后期改为CBS)。

Neck的CSPLayer结构为:

Neck层的CSPLayer将中间的残差结构换成了2 × X个CBL(后期为CBS)。主要原因是Neck层比较浅。

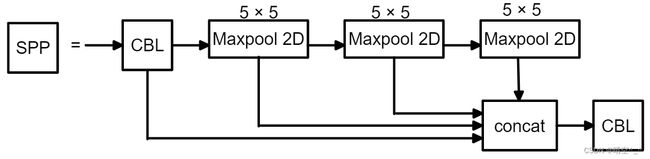

5、SPPBottleneck:

传统的SPP又称金字塔池化可以将任意大小的特征图转换成固定大小的特征向量。但是在YOLOv5中,SPPBottleneck主要作用是通过不同池化核大小的最大池化进行特征提取,提高网络的感受野。其中,shotcut处为concat,因此应保证每次池化后map大小不变。

SPPF,在YOLOv5后期提出了SPPF结构,其将并行的最大层化改为了串行的最大池化层,虽然对结构进行了修改但是目的完全一样。

其中,串行的2个5×5和1个9×9是等价的,串行的3个5×5和1个13×13是等价的。并行和串行的效果一样,但串行的效率更高。

三 、Neck层

如图,YOLOv5提取三个特征层进行目标检测,分别位于中间层、中下层和底层。三个特征层的尺寸分别为 ( 80 , 80 , 256 ) (80, 80, 256) (80,80,256)、 ( 40 , 40 , 512 ) (40, 40, 512) (40,40,512)和 ( 20 , 20 , 1024 ) (20, 20 ,1024) (20,20,1024)。

特征金字塔可以将不同shape的特征层进行特征融合,有利于提取更好的特征,具体融合方式如图。其中,上采样采用插值,下采样采用卷积。

FPN(语义信息)+PAN(定位信息):

通常认为,深层的特征层携带有较强的语义特征信息和较弱的定位信息;浅层的特征层有较强的位置信息和较弱的语义信息。FPN就是把深层的语义特征传到浅层,从而增强多个尺度上的语义表达。而PAN则把浅层的定位信息传导到深层,增强多个尺度上的定位能力。

如图,FPN是自底向上,将高层的语义特征传递上去,对整个金字塔进行增强,但是只增强了语义信息而没有增强位置信息;通过在FPN后加上一个自顶向下的PAN对位置信息进行补充,将顶层的位置信息传递下去。

四、 YOLO Head

通过特征金字塔,获得了三个加强特征,分别为 ( 20 , 20 , 1024 ) (20, 20, 1024) (20,20,1024)、 ( 40 , 40 , 512 ) (40, 40, 512) (40,40,512)、 ( 80 , 80 , 256 ) (80, 80, 256) (80,80,256),之后将这三个加强特征传入YOLO Head获得预测结果。

对于每一个特征层,首先使用一个卷积调整通道数,最终的通道数与数据集的类别数相关。其中,每一个特征层的每一个特征点存在3个锚框。

假设使用的是voc数据集,类别是20种,最后的维度为75=3×(4+1+20)

其中:3代表三个锚框;4代表每一个锚框的回归参数;1代表该特征点是否包含物体(该特征点是否为背景);20用于判断该特征点的种类。

假设使用的是coco数据集(类别为80),则最后的通道数为255=3×(4+1+80)。

五、 预测

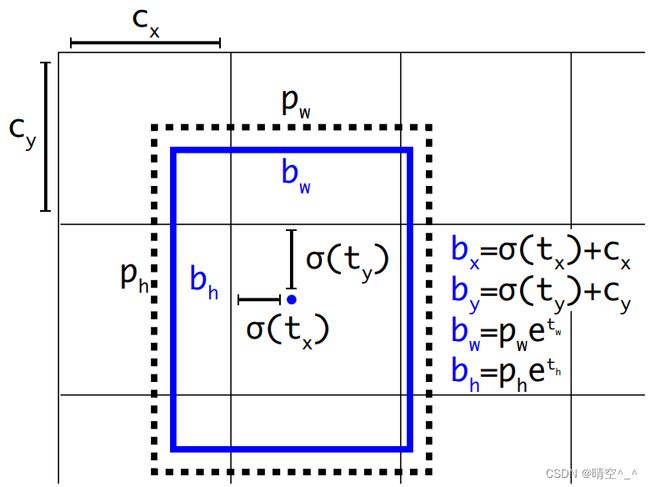

1、 解码

假设数据集为coco数据集,获得的特征层预测结果为: ( N , 20 , 20 , 255 ) (N, 20, 20, 255) (N,20,20,255)、 ( N , 40 , 40 , 255 ) (N, 40, 40, 255) (N,40,40,255)、 ( N , 80 , 80 , 255 ) (N, 80, 80, 255) (N,80,80,255),之后将255拆分成3个85,对应3个锚框的85个参数。

将 ( N , 20 , 20 , 255 ) (N, 20, 20, 255) (N,20,20,255)特征层reshape成 ( N , 20 , 20 , 3 , 85 ) (N, 20, 20, 3, 85) (N,20,20,3,85),之后对每个特征点对应的三个锚框进行解码操作:

其中: p w p_w pw、 p h p_h ph为锚框的长宽, c x c_x cx、 c y c_y cy为预测锚框对应的单元格离图片左上角的距离。 ( t x , t y , t w , t h ) (t_x, t_y, t_w, t_h) (tx,ty,tw,th)是预测偏移量。 σ \sigma σ为sigmoid激活函数。

图一为YOLOv2/3/4的锚框回归计算公式,图二为YOLOv5的锚框回归计算公式。

- 宽高计算:作者认为原始的yolo /darknet框方程式存在严重缺陷,宽度和高度虽然永远>0,但不受限制,因为它们只是 o u t = e i n out=e^{in} out=ein。这种指数的运算很危险,易导致梯度不稳定,训练难度加大,使用 ( 2 σ ( t w ) ) 2 \left(2\sigma\left( t_w \right) \right)^2 (2σ(tw))2既能够保证宽高>0,也能对宽高限制,最大值为anchor框宽高的4倍。

- 偏移计算:因为YOLOv5的正样本定义与YOLO之前系列的不同,故在此公式的计算也不相同。关于正负样本在”训练“处进行介绍。

2、得分筛选与非极大抑制:

得分筛选与非极大抑制的过程可以概括如下:

- 找出该图片中得分大于门限函数的框。在进行重合框筛选前就进行得分的筛选可以大幅度减少框的数量。

- 对种类进行循环,非极大抑制的作用是筛选出一定区域内属于同一种类得分最大的框,对种类进行循环可以帮助我们对每一个类分别进行非极大抑制。

- 根据得分对该种类进行从大到小排序。

- 每次取出得分最大的框,计算其与其它所有预测框的重合程度,重合程度过大的则剔除。

六、训练

1、 LOSS组成

网络的损失与网络的预测组成相同,分为:Reg部分(特征点的回归参数)、Obj部分(该特征点是否包含物体)、Cls部分(特征点物体的种类)。

2、 正样本匹配:

从IOU匹配变成shape匹配,先计算gt与9个锚框的长宽比,如果长宽比小于设定阈值,说明该gt和对应的锚框匹配,一个gt可能与几个锚框均能匹配上,因为同之前YOLO一样,YOLOv5有三层网络,9个锚框, 从小到大,每3个锚框对应一层网络,所以一个gt可能在不同的网络层上做预测训练,大大增加了正样本的数量,当然也会出现gt与所有锚框都匹配不上的情况,这样gt就会被当成背景,不参与训练。

3、 筛选框匹配:

gt框与锚框匹配后,得到锚框对应的网络层的grid,看gt中心点落在哪个grid上,不仅取该grid中和gt匹配的锚框作为正样本,还取相邻的的两个grid中的anchor为正样本。同时gt不仅与一个锚框匹配,如果跟几个锚框都匹配上,而且锚框不在同一个网络层上,所以可能有3-9个正样本,增大正样本数量。

4、 LOSS计算:

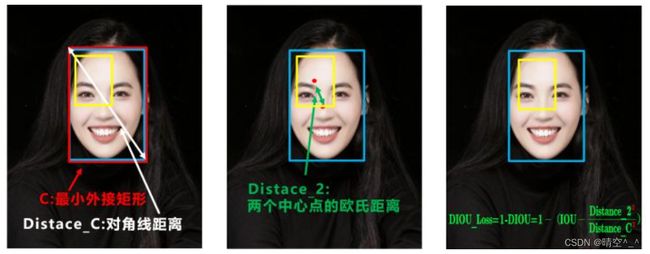

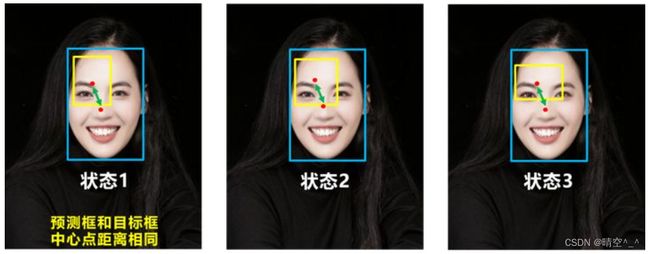

1、DIOU Loss: 好的目标框函数应该考虑三个重要几何因素:重叠面积、中心点距离和长宽比如何最小化预测框和目标框之间的归一化距离:DIOU_Loss

DIOU_Loss考虑了重叠面积和中心点距离,当目标框包裹预测框的时候,直接度量2个框的距离,因此DIOU Loss收敛的更快。

问题:没有考虑长宽比:如1、2、3,目标框包裹预测框,本来DIOU_Loss可以起作用,但是预测框的中心点的位置都是一样的,因此按照DIOU Loss的计算公式,三者的值都是相同的。

2、CIOU Loss:CIOU Loss在DIOU Loss的基础上增加了一个影响因子,将预测框和目标框的长宽比都考虑进去了。

C I O U _ L o s s = 1 − C I O U = 1 − ( I O U − D i s t a n c e _ 2 2 D i s t a n c e _ C 2 − v 2 ( 1 − I O U ) + v ) CIOU\_Loss = 1-CIOU=1-(IOU -\frac{Distance\_2^2}{Distance\_C^2}- \frac{v^2}{(1-IOU)+v}) CIOU_Loss=1−CIOU=1−(IOU−Distance_C2Distance_22−(1−IOU)+vv2)

其中, v v v是衡量长宽比一致性的参数,也可以定义为:

v = 4 π 2 ( a r c t a n w g t h g t − a r c t a n w P h P ) 2 v=\frac{4}{\pi^2}(arctan\frac{w^{gt}}{h^{gt}}-arctan\frac{w^P}{h^P})^2 v=π24(arctanhgtwgt−arctanhPwP)2

这样,CIOU Loss就将目标框回归函数应该考虑三个重要集合因素:重叠面积、中心点距离、长宽比全都考虑进去了。

3、Obj部分,由第正样本匹配部分可知道每个真实框对应的先验框,所有真实框对应的先验框都是正样本,剩余的先验框均为负样本,根据正负样本和特征点的是否包含物体的预测结果计算交叉熵损失,作为Obj部分的Loss组成。

4、 Cls部分,由第三部分可知道每个真实框对应的先验框,获取到每个框对应的先验框后,取出该先验框的种类预测结果,根据真实框的种类和先验框的种类预测结果计算交叉熵损失,作为Cls部分的Loss组成。