- sealos自动部署k8s集群

SilentCodeY

linux运维服务器云原生kubernetes容器

官网:安装K8s集群|Sealos:专为云原生开发打造的以K8s为内核的云操作系统1、sealos工具下载二进制自动下载VERSION=`curl-shttps://api.github.com/repos/labring/sealos/releases/latest|grep-oE'"tag_name":"[^"]+"'|head-n1|cut-d'"'-f4`curl-sfLhttps://m

- CI/CD(三) 安装nfs并指定k8s默认storageClass

qq_41369135

kubernetesci/cddockernfsstorageClass

一、NFS服务端安装(主节点10.60.0.20)1.安装NFS服务端sudoaptupdatesudoaptinstall-ynfs-kernel-server2.创建共享目录并配置权限sudomkdir-p/data/k8ssudochownnobody:nogroup/data/k8s#允许匿名访问sudochmod777/data/k8s3.配置NFS导出规则编辑/etc/exports文

- k8s--集群内的pod调用集群外的服务

IT艺术家-rookie

k8s与docker容器技术kubernetes容器云原生

关于如何让同一个局域网内的Kubernetes服务的Pod访问同一局域网中的电脑上的服务。可能的解决方案包括使用ClusterIP、NodePort、HeadlessService、HostNetwork、ExternalIPs,或者直接使用Pod网络。每种方法都有不同的适用场景,需要逐一分析。例如,ClusterIP是默认的,只能在集群内部访问,所以可能需要其他方式。NodePort会在每个节点

- k8s运维 设置Pod实现JVM内存根据容器内存动态调整

风行無痕

K8Skubernetesjvm容器

一、实现方式推荐方案:利用JVM容器感知特性,按比例动态分配。适用场景:动态根据Pod内存限制自动分配堆内存,无需硬编码参数Java要求:Java8u191+或Java11+Java8u191+或Java11+支持通过-XX:InitialRAMPercentage替代-Xms,根据容器内存限制自动计算堆内存。在容器环境变量中配置-XX:MaxRAMPercentage=75.0,使JVM根据容

- 使用kubeadm部署高可用IPV4/IPV6集群---V1.32

使用kubeadm部署高可用IPV4/IPV6集群https://github.com/cby-chen/Kubernetes开源不易,帮忙点个star,谢谢了k8s基础系统环境配置配置IP#注意!#若虚拟机是进行克隆的那么网卡的UUID和MachineID会重复#需要重新生成新的UUIDUUID和MachineID#UUID和MachineID重复无法DHCP获取到IPV6地址sshroot@1

- Kubernetes配置全解析:从小白到高手的进阶秘籍

ivwdcwso

操作系统与云原生kubernetes容器云原生k8s配置

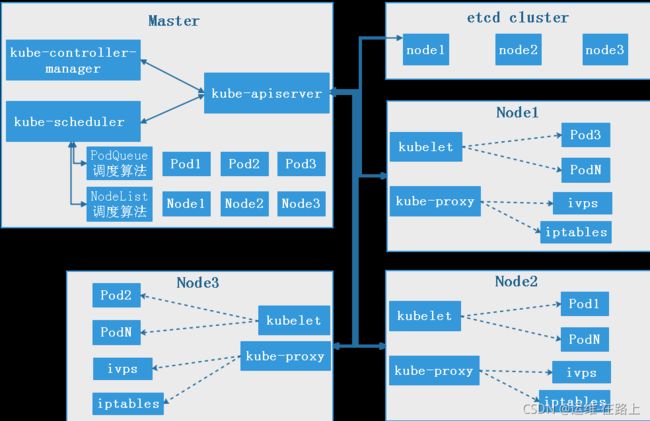

导语在Kubernetes(K8s)的世界里,合理且精准的配置是释放其强大功能的关键。无论是搭建集群、部署应用,还是优化资源利用,配置都贯穿始终。然而,K8s配置涉及众多参数与组件,错综复杂,令不少初学者望而却步。本文将带你一步步深入K8s配置领域,从小白进阶为配置高手,轻松驾驭K8s集群。一、Kubernetes集群配置Master节点配置kube-api-server:这是K8s集群的“门面”

- k8s学习笔记(3)--- kubernetes核心技术概念

梦谜

k8s基础知识k8基本核心概念

kubernetes核心技术概念1.容器(Container)2.API对象3.集群(Cluster)4.Master5.Node6.Pod7.复制控制器(ReplicationController,RC)8.副本集(ReplicaSet,RS)9.部署(Deployment)10.服务(Service)11.任务(Job)12.定时任务(CronJob)13.后台支撑服务集(DaemonSet)

- 云原生周刊丨CIO 洞察:Kubernetes 解锁 AI 新纪元

KubeSphere 云原生

云原生kubernetes人工智能

开源项目推荐DRANETDRANET是由谷歌开发的K8s网络驱动程序,利用K8s的动态资源分配(DRA)功能,为高吞吐量和低延迟应用提供高性能网络支持。它旨在优化资源管理,确保K8s集群中的网络资源能够按需高效分配。DRANET采用Apache-2.0开源许可,鼓励社区贡献与扩展,是云原生环境下提升网络性能的创新解决方案。LazyjournalLazyjournal是一个用Go语言编写的终端用户界

- k8s集群版本升级

少陽君

K8Skubernetes容器云原生

Kubernetes集群版本升级是为了获得最新的功能、增强的安全性和性能改进。然而,升级过程需要谨慎进行,特别是在生产环境中。通常,Kubernetes集群的版本升级应遵循逐步升级的策略,不建议直接跳过多个版本。Kubernetes版本升级的常见流程:升级顺序:先升级控制平面节点(MasterNodes),然后升级工作节点(WorkerNodes)。遵循版本兼容性:Kubernetes支持小版本的

- 新书速览|云原生Kubernetes自动化运维实践

全栈开发圈

云原生运维kubernetes

《云原生Kubernetes自动化运维实践》本书内容:《云原生Kubernetes自动化运维实践》以一名大型企业集群运维工程师的实战经验为基础,全面系统地阐述Kubernetes(K8s)在自动化运维领域的技术应用。《云原生Kubernetes自动化运维实践》共16章,内容由浅入深,逐步揭示K8s的原理及实际操作技巧。第1章引领读者踏入Kubernetes的世界,详细介绍其起源、核心组件的概念以及

- 分析K8S中Node状态为`NotReady`问题

网络飞鸥

Kuberneteskubernetes容器云原生

在Kubernetes(k8s)集群中,Node状态为NotReady通常意味着节点上存在某些问题,下面为你分析正常情况下节点应运行的容器以及解决NotReady状态的方法。正常情况下Node节点应运行的容器1.kubeletkubelet是节点上的核心组件,它负责与控制平面通信,管理节点上的容器生命周期。它通常作为系统服务运行,而不是以容器形式存在,但也有使用容器化部署的情况。2.kube-pr

- K8S之POD调度

〰振振 ༽

K8Skubernetesdocker容器

K8S-Pod调度1、Deployment/RC:全自动调度简述Deployment或RC的主要功能就是自动部署一个容器应用的多份副本,及持续监控副本的数量并维持该值。创建Deploymentkubectlcreate-fnginx-deployment.yaml#nginx-deployment.yamlapiVersion:apps/v1kind:Deploymentmetadata:name

- K8S遇到过的比较深刻的Pod问题

Gold Steps.

技术博文分享kubernetes容器云原生故障处理

第一案:Pod集体自杀凌晨12点的告警总是格外刺眼。值班群里突然炸出一连串消息:"支付服务全部下线!但Pod日志显示一切正常!"运维组赶到战场时,发现大量Pod像多米诺骨牌般接连消失,监控面板上却全是绿色对勾。错误排查:#查看案发时间线kubectlgetevents--sort-by='.lastTimestamp'|grep-ikilled#查看Pod详细信息kubectldescribepo

- k8s主要控制器简述(一)ReplicaSet与Deployment

小刘爱喇石( ˝ᗢ̈˝ )

kubernetes容器云原生

目录一、ReplicaSet关键特性示例解释支持的Operator二、Deployment1.声明式更新示例2.滚动更新示例3.回滚示例4.ReplicaSet管理示例5.自动恢复示例6.扩展和缩容示例示例一、ReplicaSetReplicaSet是Kubernetes中的一个核心控制器,用于确保指定数量的Pod副本始终处于运行状态。它的主要职责是维护一组稳定的Pod副本,确保在任何时候都有指定

- golang面经整理(一)(k8s,docker二次开发方向,云原生方向)

gooooer

1024程序员节

笔者在2022年7月份-9月份之间面试了很多golang和k8s相关的面试,主要想从事云原生相关的开发工作,大小公司面试了很多,现将整体面试感受和一些通用的问题做一些整理记录,帮助大家在面试的时候更好的进行准备。最近大环境不好,大厂的岗位也少了不少。主要投递的岗位包含广州、深圳的岗位,面试的是golang工程师相关的岗位,但其实单纯做云原生相关岗位比较少,基本上局限于国内的几朵云,阿里云,华为云,

- K8S集群新增和删除Node节点(K8s Cluster Adds and Removes Node Nodes)

Linux运维老纪

天涯海角k8s伴你同行kubernetes容器云原生云计算运维开发linux

实战:在已有K8S集群如何新增和删除Node节点在Kubernetes(K8S)集群中,Node节点是集群中的工作节点,它们运行着容器的实际实例。管理K8S集群中的Node节点,包括新增和删除节点,是一个常见且重要的操作,可以帮助你根据需求扩展或缩减集群的容量。本篇文章将分享一下如何在已有集群添加新节点和删除现有节点1新增节点到K8S集群新增节点可以分为准备节点、配置节点和将其加入集群三步。1.1

- Kubernetes学习笔记-移除Nacos迁移至K8s

人生偌只如初见

KubernetesJ2EEkubernetesk8sjava

项目服务的配置管理和服务注册发现由原先的Nacos全面迁移到Kubernetes上。一、移除Nacos移除Nacos组件依赖。com.alibaba.cloudspring-cloud-starter-alibaba-nacos-discoverycom.alibaba.cloudspring-cloud-starter-alibaba-nacos-configorg.springframewor

- k8s往secret里导入证书_Kubernetes K8S之存储Secret详解

weixin_39604598

k8s往secret里导入证书

K8S之存储Secret概述与类型说明,并详解经常使用Secret示例html主机配置规划服务器名称(hostname)系统版本配置内网IP外网IP(模拟)k8s-masterCentOS7.72C/4G/20G172.16.1.11010.0.0.110k8s-node01CentOS7.72C/4G/20G172.16.1.11110.0.0.111k8s-node02CentOS7.72C/

- K8S中若要挂载其他命名空间中的 Secret

网络飞鸥

Kuberneteskubernetes容器云原生

在Kubernetes(k8s)里,若要挂载其他命名空间中的Secret,你可以通过创建一个Secret的ServiceAccount和RoleBinding来实现对其他命名空间Secret的访问,接着在Pod中挂载这个Secret。下面是详细的步骤和示例代码:步骤创建ServiceAccount:在要挂载Secret的命名空间里创建一个ServiceAccount。创建Role与RoleBind

- 【K8S】ImagePullBackOff状态问题排查。

执键行天涯

K8skubernetes容器云原生

ImagePullBackOff是在使用Kubernetes(K8s)时经常遇到的一种错误状态,下面为你详细介绍其含义、可能的原因及解决办法。含义当你在K8s集群中创建一个Pod时,Kubelet会尝试从指定的镜像仓库拉取所需的容器镜像。如果拉取镜像失败,Kubelet会进行重试。随着重试次数的增加,重试的间隔时间会逐渐变长,这就是所谓的“指数退避”策略。当Kubelet多次尝试拉取镜像都失败后,

- helm安装kubernetes-dashboard(2,Linux运维开发技巧

2401_83974783

2024年程序员学习kuberneteslinux运维开发

当前k8s集群版本1.23.61.1添加repo[root@masterhelm]#helmrepoaddkubernetes-dashboardhttps://kubernetes.github.io/dashboard/[root@masterhelm]#helmsearchrepokubernetes-dashboard/kubernetes-dashboardNAMECHARTVERSIO

- k8s中PAUSE容器与init容器比较 local卷与hostpath卷比较

小刘爱喇石( ˝ᗢ̈˝ )

kubernetes容器云原生

目录一、PAUSE容器与INIT容器比较1.Pause容器作用特点示例2.Init容器作用特点示例3.Pause容器vsInit容器4.总结这两个哪个先启动呢?详细启动顺序为什么Pause容器最先启动?示例总结二、local卷与hostpath卷1.local卷定义特点配置示例2.hostPath卷定义特点配置示例3.local卷vshostPath卷4.选择建议一、PAUSE容器与INIT容器比

- k8s服务中userspace,iptables,和ipvs的比较

小刘爱喇石( ˝ᗢ̈˝ )

kubernetes云原生

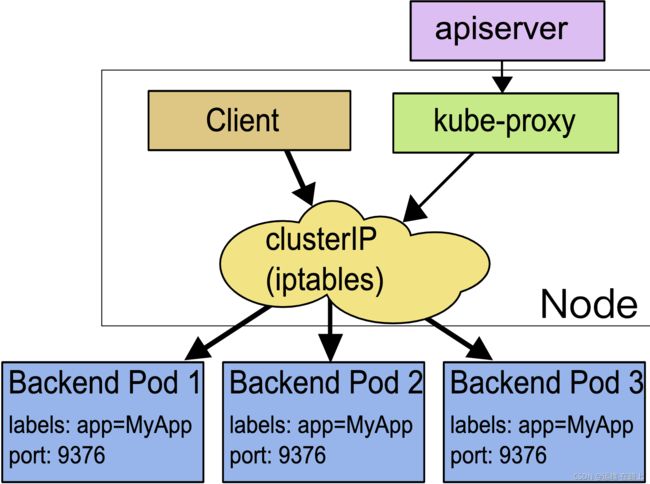

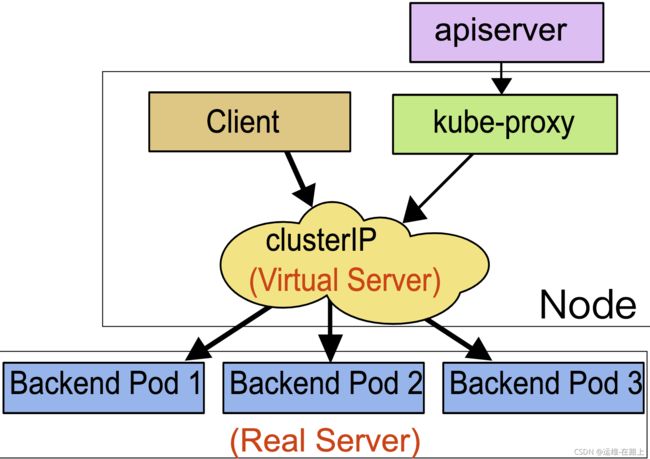

在Kubernetes中,kube-proxy是负责实现服务负载均衡的组件。它支持三种代理模式:userspace、iptables和ipvs。这三种模式在性能、功能和复杂性上有所不同。以下是它们的详细比较:1.Userspace模式Userspace是Kubernetes最早支持的代理模式,kube-proxy在用户空间监听服务的IP和端口,并将流量转发到后端Pod。工作原理kube-proxy

- Docker Compose 和 Kubernetes(K8s)对比

孽小倩

docker容器dockerk8skubernetes

DockerCompose和Kubernetes(K8s)在某些方面有相似的功能,但它们的核心用途和适用场景不同。以下是它们的主要区别和联系:1.DockerCompose和Kubernetes的区别对比项DockerComposeKubernetes(K8s)核心作用管理多个Docker容器管理容器编排(大规模应用)适用环境本地开发、测试环境生产环境、大规模集群容器编排能力基础编排(启动多个容器

- 【DevOps】Rancher:rancher2.4.16 高可用安装文档

运维归一

DevOpsdockerzookeeper运维

视频教程视频教程:https://edu.csdn.net/learn/38191/604440?spm=1003.2001.3001.4143RancherHA集群安装部署当前最新版本V2.4.16安装流程:rke安装k8s,在k8s集群上搭建helm,通过helm创建rancher容器应用节点名称ip地址系统版本rke,k8s-master01,rancher192.168.1.9centos

- 流式编程 JDK8 Stream的简单使用方法介绍

桔仔

javajdkstream

JDK8Stream文章目录JDK8Stream概念特点代码简洁多核友好示例foreach方式Stream方式流程操作特性常用操作符具体用法一、流的创建1.1使用Collection下的stream()和parallelStream()方法。1.2使用Arrays中的stream()方法,将数组转成流。1.3使用Stream中的静态方法:of()、iterate()、generate()。1.4使

- K8S学习之基础四十:配置altermanager发送告警到钉钉群

云上艺旅

K8S学习kubernetes学习钉钉prometheus云原生容器

配置altermanager发送告警到钉钉群创建钉钉群,设置机器人助手(必须是管理员才能设置),获取webhookwebhook:https://oapi.dingtalk.com/robot/send?access_token=25bed933a52d69f192347b5be4b2193bc0b257a6d9ae68d81619e3ae3d93f7c6#创建cm,配置钉钉群信息vialertm

- K8S学习之基础三十六:node-exporter部署

云上艺旅

K8S学习kubernetes学习贪心算法prometheus云原生

Prometheusv2.2.1编写yaml文件,包含创建ns、configmap、deployment、service#创建monitoring空间viprometheus-ns.yamlapiVersion:v1kind:Namespacemetadata:name:monitoring#创建SA并绑定权限kubectlcreateserviceaccountmonitor-nmonitori

- 基于k8s集群免密拉取需认证的仓库镜像

星溢

kubernetesdockerlinuxhttp

一、环境背景1、k8s集群,1.17+,目前k8s最新版本已更新至V1.31版本;2、镜像仓库,如harbor、registry、portus、nexus等;3、配置镜像仓库用户登录认证,参考资料如下:harbor参考:https://www.geekby.cn/posts/harbor-https/registry参考:https://www.cnblogs.com/chen2ha/p/1478

- k8s 配置私有镜像仓库认证

狗贤

Kuberneteskubernetes容器

1.创建Docker注册表的Secret首先,创建一个类型为dockerconfigjson的Secret,用于存储Docker注册表的认证信息。方法1:使用DockerCLI和kubectl不适用于阿里云格式不一样登录Docker注册表:dockerlogin这会生成一个包含认证信息的配置文件,通常位于~/.docker/config.json。创建Secret:kubectl-npromcre

- 面向对象面向过程

3213213333332132

java

面向对象:把要完成的一件事,通过对象间的协作实现。

面向过程:把要完成的一件事,通过循序依次调用各个模块实现。

我把大象装进冰箱这件事为例,用面向对象和面向过程实现,都是用java代码完成。

1、面向对象

package bigDemo.ObjectOriented;

/**

* 大象类

*

* @Description

* @author FuJian

- Java Hotspot: Remove the Permanent Generation

bookjovi

HotSpot

openjdk上关于hotspot将移除永久带的描述非常详细,http://openjdk.java.net/jeps/122

JEP 122: Remove the Permanent Generation

Author Jon Masamitsu

Organization Oracle

Created 2010/8/15

Updated 2011/

- 正则表达式向前查找向后查找,环绕或零宽断言

dcj3sjt126com

正则表达式

向前查找和向后查找

1. 向前查找:根据要匹配的字符序列后面存在一个特定的字符序列(肯定式向前查找)或不存在一个特定的序列(否定式向前查找)来决定是否匹配。.NET将向前查找称之为零宽度向前查找断言。

对于向前查找,出现在指定项之后的字符序列不会被正则表达式引擎返回。

2. 向后查找:一个要匹配的字符序列前面有或者没有指定的

- BaseDao

171815164

seda

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.SQLException;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

public class BaseDao {

public Conn

- Ant标签详解--Java命令

g21121

Java命令

这一篇主要介绍与java相关标签的使用 终于开始重头戏了,Java部分是我们关注的重点也是项目中用处最多的部分。

1

- [简单]代码片段_电梯数字排列

53873039oycg

代码

今天看电梯数字排列是9 18 26这样呈倒N排列的,写了个类似的打印例子,如下:

import java.util.Arrays;

public class 电梯数字排列_S3_Test {

public static void main(S

- Hessian原理

云端月影

hessian原理

Hessian 原理分析

一. 远程通讯协议的基本原理

网络通信需要做的就是将流从一台计算机传输到另外一台计算机,基于传输协议和网络 IO 来实现,其中传输协议比较出名的有 http 、 tcp 、 udp 等等, http 、 tcp 、 udp 都是在基于 Socket 概念上为某类应用场景而扩展出的传输协

- 区分Activity的四种加载模式----以及Intent的setFlags

aijuans

android

在多Activity开发中,有可能是自己应用之间的Activity跳转,或者夹带其他应用的可复用Activity。可能会希望跳转到原来某个Activity实例,而不是产生大量重复的Activity。

这需要为Activity配置特定的加载模式,而不是使用默认的加载模式。 加载模式分类及在哪里配置

Activity有四种加载模式:

standard

singleTop

- hibernate几个核心API及其查询分析

antonyup_2006

html.netHibernatexml配置管理

(一) org.hibernate.cfg.Configuration类

读取配置文件并创建唯一的SessionFactory对象.(一般,程序初始化hibernate时创建.)

Configuration co

- PL/SQL的流程控制

百合不是茶

oraclePL/SQL编程循环控制

PL/SQL也是一门高级语言,所以流程控制是必须要有的,oracle数据库的pl/sql比sqlserver数据库要难,很多pl/sql中有的sqlserver里面没有

流程控制;

分支语句 if 条件 then 结果 else 结果 end if ;

条件语句 case when 条件 then 结果;

循环语句 loop

- 强大的Mockito测试框架

bijian1013

mockito单元测试

一.自动生成Mock类 在需要Mock的属性上标记@Mock注解,然后@RunWith中配置Mockito的TestRunner或者在setUp()方法中显示调用MockitoAnnotations.initMocks(this);生成Mock类即可。二.自动注入Mock类到被测试类 &nbs

- 精通Oracle10编程SQL(11)开发子程序

bijian1013

oracle数据库plsql

/*

*开发子程序

*/

--子程序目是指被命名的PL/SQL块,这种块可以带有参数,可以在不同应用程序中多次调用

--PL/SQL有两种类型的子程序:过程和函数

--开发过程

--建立过程:不带任何参数

CREATE OR REPLACE PROCEDURE out_time

IS

BEGIN

DBMS_OUTPUT.put_line(systimestamp);

E

- 【EhCache一】EhCache版Hello World

bit1129

Hello world

本篇是EhCache系列的第一篇,总体介绍使用EhCache缓存进行CRUD的API的基本使用,更细节的内容包括EhCache源代码和设计、实现原理在接下来的文章中进行介绍

环境准备

1.新建Maven项目

2.添加EhCache的Maven依赖

<dependency>

<groupId>ne

- 学习EJB3基础知识笔记

白糖_

beanHibernatejbosswebserviceejb

最近项目进入系统测试阶段,全赖袁大虾领导有力,保持一周零bug记录,这也让自己腾出不少时间补充知识。花了两天时间把“传智播客EJB3.0”看完了,EJB基本的知识也有些了解,在这记录下EJB的部分知识,以供自己以后复习使用。

EJB是sun的服务器端组件模型,最大的用处是部署分布式应用程序。EJB (Enterprise JavaBean)是J2EE的一部分,定义了一个用于开发基

- angular.bootstrap

boyitech

AngularJSAngularJS APIangular中文api

angular.bootstrap

描述:

手动初始化angular。

这个函数会自动检测创建的module有没有被加载多次,如果有则会在浏览器的控制台打出警告日志,并且不会再次加载。这样可以避免在程序运行过程中许多奇怪的问题发生。

使用方法: angular .

- java-谷歌面试题-给定一个固定长度的数组,将递增整数序列写入这个数组。当写到数组尾部时,返回数组开始重新写,并覆盖先前写过的数

bylijinnan

java

public class SearchInShiftedArray {

/**

* 题目:给定一个固定长度的数组,将递增整数序列写入这个数组。当写到数组尾部时,返回数组开始重新写,并覆盖先前写过的数。

* 请在这个特殊数组中找出给定的整数。

* 解答:

* 其实就是“旋转数组”。旋转数组的最小元素见http://bylijinnan.iteye.com/bl

- 天使还是魔鬼?都是我们制造

ducklsl

生活教育情感

----------------------------剧透请原谅,有兴趣的朋友可以自己看看电影,互相讨论哦!!!

从厦门回来的动车上,无意中瞟到了书中推荐的几部关于儿童的电影。当然,这几部电影可能会另大家失望,并不是类似小鬼当家的电影,而是关于“坏小孩”的电影!

自己挑了两部先看了看,但是发现看完之后,心里久久不能平

- [机器智能与生物]研究生物智能的问题

comsci

生物

我想,人的神经网络和苍蝇的神经网络,并没有本质的区别...就是大规模拓扑系统和中小规模拓扑分析的区别....

但是,如果去研究活体人类的神经网络和脑系统,可能会受到一些法律和道德方面的限制,而且研究结果也不一定可靠,那么希望从事生物神经网络研究的朋友,不如把

- 获取Android Device的信息

dai_lm

android

String phoneInfo = "PRODUCT: " + android.os.Build.PRODUCT;

phoneInfo += ", CPU_ABI: " + android.os.Build.CPU_ABI;

phoneInfo += ", TAGS: " + android.os.Build.TAGS;

ph

- 最佳字符串匹配算法(Damerau-Levenshtein距离算法)的Java实现

datamachine

java算法字符串匹配

原文:http://www.javacodegeeks.com/2013/11/java-implementation-of-optimal-string-alignment.html------------------------------------------------------------------------------------------------------------

- 小学5年级英语单词背诵第一课

dcj3sjt126com

englishword

long 长的

show 给...看,出示

mouth 口,嘴

write 写

use 用,使用

take 拿,带来

hand 手

clever 聪明的

often 经常

wash 洗

slow 慢的

house 房子

water 水

clean 清洁的

supper 晚餐

out 在外

face 脸,

- macvim的使用实战

dcj3sjt126com

macvim

macvim用的是mac里面的vim, 只不过是一个GUI的APP, 相当于一个壳

1. 下载macvim

https://code.google.com/p/macvim/

2. 了解macvim

:h vim的使用帮助信息

:h macvim

- java二分法查找

蕃薯耀

java二分法查找二分法java二分法

java二分法查找

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年6月23日 11:40:03 星期二

http:/

- Spring Cache注解+Memcached

hanqunfeng

springmemcached

Spring3.1 Cache注解

依赖jar包:

<!-- simple-spring-memcached -->

<dependency>

<groupId>com.google.code.simple-spring-memcached</groupId>

<artifactId>simple-s

- apache commons io包快速入门

jackyrong

apache commons

原文参考

http://www.javacodegeeks.com/2014/10/apache-commons-io-tutorial.html

Apache Commons IO 包绝对是好东西,地址在http://commons.apache.org/proper/commons-io/,下面用例子分别介绍:

1) 工具类

2

- 如何学习编程

lampcy

java编程C++c

首先,我想说一下学习思想.学编程其实跟网络游戏有着类似的效果.开始的时候,你会对那些代码,函数等产生很大的兴趣,尤其是刚接触编程的人,刚学习第一种语言的人.可是,当你一步步深入的时候,你会发现你没有了以前那种斗志.就好象你在玩韩国泡菜网游似的,玩到一定程度,每天就是练级练级,完全是一个想冲到高级别的意志力在支持着你.而学编程就更难了,学了两个月后,总是觉得你好象全都学会了,却又什么都做不了,又没有

- 架构师之spring-----spring3.0新特性的bean加载控制@DependsOn和@Lazy

nannan408

Spring3

1.前言。

如题。

2.描述。

@DependsOn用于强制初始化其他Bean。可以修饰Bean类或方法,使用该Annotation时可以指定一个字符串数组作为参数,每个数组元素对应于一个强制初始化的Bean。

@DependsOn({"steelAxe","abc"})

@Comp

- Spring4+quartz2的配置和代码方式调度

Everyday都不同

代码配置spring4quartz2.x定时任务

前言:这些天简直被quartz虐哭。。因为quartz 2.x版本相比quartz1.x版本的API改动太多,所以,只好自己去查阅底层API……

quartz定时任务必须搞清楚几个概念:

JobDetail——处理类

Trigger——触发器,指定触发时间,必须要有JobDetail属性,即触发对象

Scheduler——调度器,组织处理类和触发器,配置方式一般只需指定触发

- Hibernate入门

tntxia

Hibernate

前言

使用面向对象的语言和关系型的数据库,开发起来很繁琐,费时。由于现在流行的数据库都不面向对象。Hibernate 是一个Java的ORM(Object/Relational Mapping)解决方案。

Hibernte不仅关心把Java对象对应到数据库的表中,而且提供了请求和检索的方法。简化了手工进行JDBC操作的流程。

如

- Math类

xiaoxing598

Math

一、Java中的数字(Math)类是final类,不可继承。

1、常数 PI:double圆周率 E:double自然对数

2、截取(注意方法的返回类型) double ceil(double d) 返回不小于d的最小整数 double floor(double d) 返回不大于d的整最大数 int round(float f) 返回四舍五入后的整数 long round