微服务--07--Seata 分布式事务

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

- 分布式事务

- 1.认识Seata

- 2.部署TC服务

-

- 2.1.准备数据库表

- 2.2.准备配置文件

- 2.3.Docker部署

- 3.微服务集成Seata

-

- 3.1.引入依赖

- 3.2.改造配置

- 3.3.添加数据库表

- 3.4.测试

分布式事务

由于订单、购物车、商品分别在三个不同的微服务,而每个微服务都有自己独立的数据库,因此下单过程中就会跨多个数据库完成业务。而每个微服务都会执行自己的本地事务:

- 交易服务:下单事务

- 购物车服务:清理购物车事务

- 库存服务:扣减库存事务

整个业务中,各个本地事务是有关联的。因此每个微服务的本地事务,也可以称为分支事务。多个有关联的分支事务一起就组成了全局事务。我们必须保证整个全局事务同时成功或失败。

1.认识Seata

解决分布式事务的方案有很多,但实现起来都比较复杂,因此我们一般会使用开源的框架来解决分布式事务问题。在众多的开源分布式事务框架中,功能最完善、使用最多的就是阿里巴巴在2019年开源的Seata了。

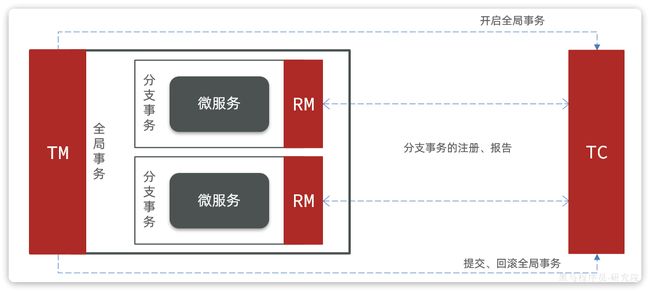

其实分布式事务产生的一个重要原因,就是参与事务的多个分支事务互相无感知,不知道彼此的执行状态。因此解决分布式事务的思想非常简单:

就是找一个统一的事务协调者,与多个分支事务通信,检测每个分支事务的执行状态,保证全局事务下的每一个分支事务同时成功或失败即可。大多数的分布式事务框架都是基于这个理论来实现的。

Seata也不例外,在Seata的事务管理中有三个重要的角色:

- TC (Transaction Coordinator) - 事务协调者:维护全局和分支事务的状态,协调全局事务提交或回滚。

- TM (Transaction Manager) - 事务管理器:定义全局事务的范围、开始全局事务、提交或回滚全局事务。

- RM (Resource Manager) - 资源管理器:管理分支事务,与TC交谈以注册分支事务和报告分支事务的状态,并驱动分支事务提交或回滚。

其中,TM和RM可以理解为Seata的客户端部分,引入到参与事务的微服务依赖中即可。将来TM和RM就会协助微服务,实现本地分支事务与TC之间交互,实现事务的提交或回滚。

而TC服务则是事务协调中心,是一个独立的微服务,需要单独部署。

2.部署TC服务

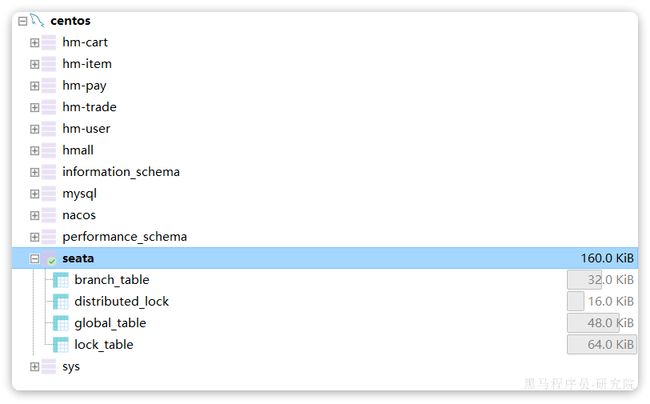

2.1.准备数据库表

Seata支持多种存储模式,但考虑到持久化的需要,我们一般选择基于数据库存储。执行课前资料提供的《seata-tc.sql》,导入数据库表:

2.2.准备配置文件

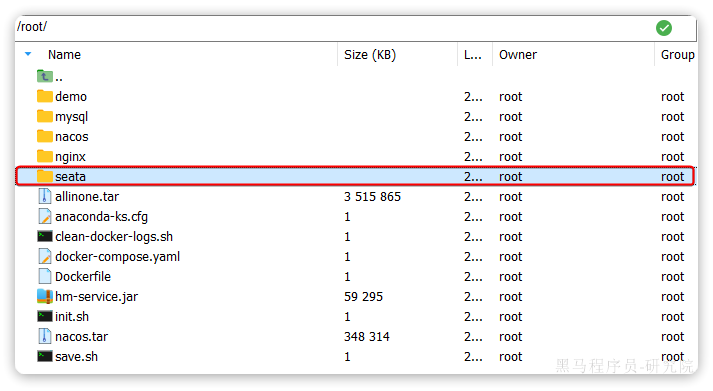

课前资料准备了一个seata目录,其中包含了seata运行时所需要的配置文件:

其中包含中文注释,大家可以自行阅读。

我们将整个seata文件夹拷贝到虚拟机的/root目录:

2.3.Docker部署

在虚拟机的/root目录执行下面的命令:

docker run --name seata \

-p 8099:8099 \

-p 7099:7099 \

-e SEATA_IP=192.168.150.101 \

-v ./seata:/seata-server/resources \

--privileged=true \

--network hmall \

-d \

seataio/seata-server:1.5.2

3.微服务集成Seata

参与分布式事务的每一个微服务都需要集成Seata,我们以trade-service为例。

3.1.引入依赖

为了方便各个微服务集成seata,我们需要把seata配置共享到nacos,因此trade-service模块不仅仅要引入seata依赖,还要引入nacos依赖:

<dependency>

<groupId>com.alibaba.cloudgroupId>

<artifactId>spring-cloud-starter-alibaba-nacos-configartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-bootstrapartifactId>

dependency>

<dependency>

<groupId>com.alibaba.cloudgroupId>

<artifactId>spring-cloud-starter-alibaba-seataartifactId>

dependency>

<dependency>

<groupId>com.alibaba.cloudgroupId>

<artifactId>spring-cloud-starter-alibaba-sentinelartifactId>

dependency>

3.2.改造配置

首先在nacos上添加一个共享的seata配置,命名为shared-seata.yaml:

seata:

registry: # TC服务注册中心的配置,微服务根据这些信息去注册中心获取tc服务地址

type: nacos # 注册中心类型 nacos

nacos:

server-addr: 192.168.150.101:8848 # nacos地址

namespace: "" # namespace,默认为空

group: DEFAULT_GROUP # 分组,默认是DEFAULT_GROUP

application: seata-server # seata服务名称

username: nacos

password: nacos

tx-service-group: hmall # 事务组名称

service:

vgroup-mapping: # 事务组与tc集群的映射关系

hmall: "default"

然后,改造trade-service模块,添加bootstrap.yaml:

spring:

application:

name: trade-service # 服务名称

profiles:

active: dev

cloud:

nacos:

server-addr: 192.168.150.101 # nacos地址

config:

file-extension: yaml # 文件后缀名

shared-configs: # 共享配置

- dataId: shared-jdbc.yaml # 共享mybatis配置

- dataId: shared-log.yaml # 共享日志配置

- dataId: shared-swagger.yaml # 共享日志配置

- dataId: shared-seata.yaml # 共享seata配置

可以看到这里加载了共享的seata配置。

然后改造application.yaml文件,内容如下:

server:

port: 8085

feign:

okhttp:

enabled: true # 开启OKHttp连接池支持

sentinel:

enabled: true # 开启Feign对Sentinel的整合

hm:

swagger:

title: 交易服务接口文档

package: com.hmall.trade.controller

db:

database: hm-trade

3.3.添加数据库表

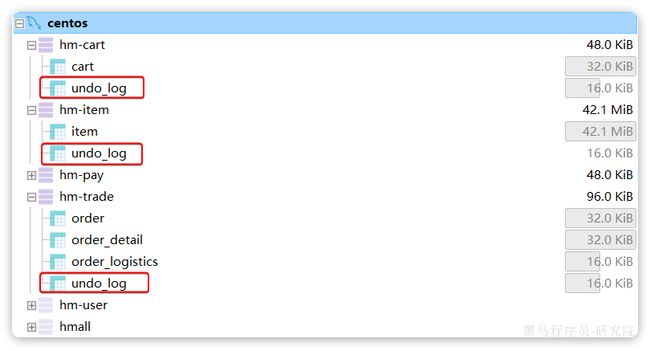

seata的客户端在解决分布式事务的时候需要记录一些中间数据,保存在数据库中。因此我们要先准备一个这样的表。

将课前资料的seata-at.sql分别文件导入hm-trade、hm-cart、hm-item三个数据库中:

3.4.测试

接下来就是测试的分布式事务的时候了。

我们找到trade-service模块下的com.hmall.trade.service.impl.OrderServiceImpl类中的createOrder方法,也就是下单业务方法。

将其上的@Transactional注解改为Seata提供的@GlobalTransactional:

@GlobalTransactional注解就是在标记事务的起点,将来TM就会基于这个方法判断全局事务范围,初始化全局事务。

我们重启trade-service、item-service、cart-service三个服务。再次测试,发现分布式事务的问题解决了!