斯坦福美女博士创业项目爆火!AI视频生成出道即顶流,半年融资5500万美元

丰色 萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

斯坦福华人博士休学搞创业,直接火爆AI圈!

新产品瞄准AI视频生成,刚出道就成行业顶流,引来一众大佬围观评价。

OpenAI大牛Andrej Karpathy转发,并激情附上长文一段:

每个人都能成为多模态梦境的导演,就像《盗梦空间》里的筑梦师一样。

就连Stability AI创始人也来点赞:

这个新产品名为Pika 1.0,背后公司Pika于今年4月成立。

要知道,这一行的产品已有不少,如成立5年的Runway等公司。

在AI视频生成“乱花迷人眼”的当下,这个新产品究竟是如何做到迅速破圈,吸引大量关注度的?

从放出的Demo效果来看,Pika 1.0不仅能根据文字图片,流畅地生成一段视频,动静转换就在一瞬间:

而且可编辑性还特别强,指定视频中的任意元素,一句话就能实现快速“换装”:

这样的效果,也使得公司成立仅半年,产品用户已经超过52万人。

更是新斩获5500万美元融资,其中个人投资者不乏各种大牛,如Quara创始人Adam D’Angelo、Perplexity的CEO Aravind Srinivas、GitHub前CEO Nat Friedman等等。

所以,Pika究竟有没有看起来这么好用?我们也立刻上手体验了一番。

AI视频新顶流长啥样?

此次火爆出圈的Pika 1.0,是Pika发布的第一个正式版本产品。

经过四个多月Discord社区的测试,Pika认为是时候推出本次重大升级了。

相比之前Pika还只能用文字或图像生成视频,如今的Pika 1.0,功能要更加丰富——

不仅能根据文字、图片或视频风格生成视频,还能对视频局部进行编辑。

可编辑性有多强?

不仅画面大小任意扩展,从5:2、1:1画布,到9:16以及16:9的超大屏,4种选择无缝转换:

像什么3D、动漫、电影等各式各样的风格滤镜,那就更不用说了。

最重要的是,1.0正式版推出了用户更友好的网页版,不用在discord中一遍遍艾特机器人,就能直接上手玩。

(不过,现在它还需要排队,需要点耐心。)

当然,也可以移步Discord社区先上手体验一番。

尽管它还未随网页版更新到Pika 1.0,但我们也实测了一下文字、图片生成视频的效果,还不错。

加入社区之后,直奔“Creations”,从下面的10个生成区随便选择一个进入即可开耍。

在输入框中输出“/”,选择最简单的“/create”命令:

在此,我们输入“a robot dancing in the rain, sunset, 4k, -gs 8”提示词交给机器人。

大概也就半分钟的时候,视频就出来了,速度相当快:

效果嘛,雨没有表现得很明显,但机器人的肢体动态性真的很强。

我们再来一个稍微长一些的提示词:

a teenager walks through the city streets,takes pictures of places(一个青少年穿过城市的街道,拍摄照片)

仍然超级快,结果就出来了:

Wow,这次真的有很满意,画面符合脑海中的预测,甚至比我们想象得还要好。

除了纯文字,咱还可以上传一张参考图像进行创作,使用“/animate”命令。

当当,一张静态表情包就动起来了:

总的来看,Pika给出的视频时长都是3s(所以使用太长的提示词也没用,后面会直接忽略掉),以及它还不能保证每次结果都很满意,但总体来说多试几次还是有不错的结果出现的。

在自测之外,我们也来看看网友的作品,其中不乏非常惊艳的效果。

比如有人创作的这只小怪兽,憨态可掬,让人忍不住想摸一把:

还有这段两位小女孩的演奏画面,看完我好像真的听到了优美的嗓音从中传出:

最绝的还是这个白鸽围绕短发美女翻飞的场面:

也太有氛围感了吧~

看罢如上效果,我们也来盘盘这家公司究竟是什么来头。

两位斯坦福华人博士创立

Pika的创始人一共有两位,郭文景(Demi Guo)和Chenlin Meng,都是斯坦福博士。

据The Information消息,郭文景于今年四月创立了Pika,随后Chenlin Meng加入成为联创,两人合作开发了这个文本生成视频模型。

从二人学术经历来看,她们分别专注于NLP和计算机视觉两个方向的AI研究,也都有生成式AI的学术经历。

联合创始人兼CEO郭文景,斯坦福大学AI实验室(NLP&图形学方向)博士。

她在美国出生,杭州长大,初中就读的是杭州外国语学校,从小就接触编程,夺得过IOI银牌,从本科开始正式留学,被哈佛大学提前录取。

此次创业,她的领英主页显示休学中(On Leave),应该是打算先忙创业的事情。

在斯坦佛大学读博之前,郭文景在哈佛大学取得了计算机硕士和数学本科学位。

在本科期间,她曾经gap过一年,专程在Facebook AI Research全职做了一段时间的研究工程师。

在职期间,她参与了用Transformer分析2.5亿个蛋白质序列的研究,目前这篇论文引用已有1200+,其中就包括后来大火的AlphaFold2:

除此之外,她也先后在Epic Games、谷歌和微软等多家公司实习过。

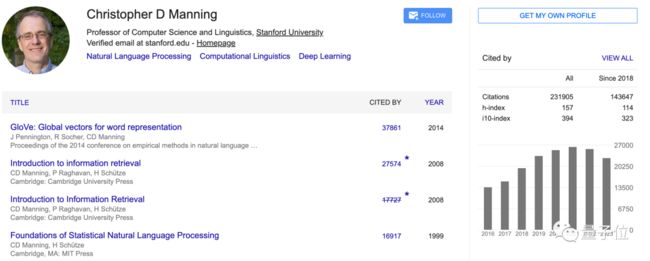

这次创业,郭文景的导师Christopher D Manning也给予了不少支持。

Christopher D Manning以NLP方向的研究闻名,如今在谷歌学术上的引用量已有23w+,而他也将成为Pika的学术顾问之一。

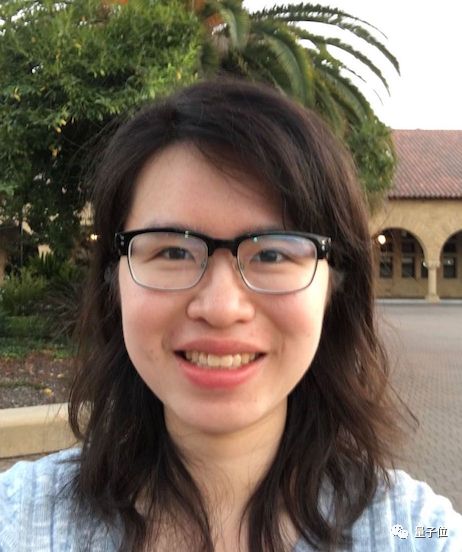

联合创始人兼CTO Chenlin Meng,同样是斯坦福计算机博士。

在此之前,她于2020年在斯坦福大学获得了数学本科学位。

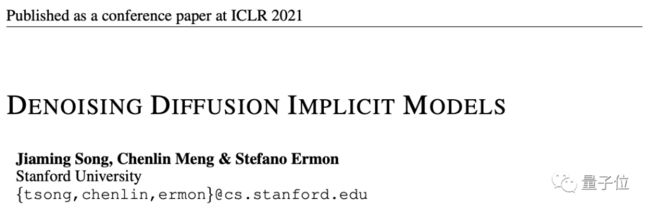

相比郭文景在NLP领域的研究经验,她在计算机视觉、3D视觉方面的学术经历更加丰富,参与的去噪扩散隐式模型(DDIM)论文,如今单篇引用已有1700+:

除此之外,她还有多篇生成式AI相关研究发表在ICLR、NeurIPS、CVPR、ICML等顶会上,且多篇入选Oral。

当然,随着Pika 1.0爆火,Pika也开启了进一步的招人计划,从技术、产品到运营都有需求:

一个月内5家产品亮相

值得一提的是,不止是正在快速扩张的Pika。

就AI视频这个行业而言,这段时间来整体都迎来了一段“爆发期”。

据不完全统计,从11月至今,短短一个月的时间就已经有5家AI视频生成产品发布或迎来大更新:

首先就是11月3日,Runway的Gen-2发布里程碑式更新,支持4K超逼真的清晰度作品。

然后时间来到11月16日,Meta发布Emu Video,这个工具在用户评估中号称打败Gen-2、Pika等对手,效果be like:

从Emu开始,大家都好像打起比赛来了,那叫一个争先恐后。

才过两天,11月18日,字节就半路杀出发布PixelDance,作品的动态性可谓史无前者,画面中的元素都动作幅度都相当大,且不变形,让人眼前一亮。

又仅过3天之后,11月21日,AIGC领域的佼佼者Stable AI也终于推出了自家的视频工具:Stable Video Diffusion。

效果嘛,也很能打。

同一天,Gen-2又没闲着,“横插一脚”上线“涂哪动哪”的运动笔刷新功能,直接标志出生成模型可控性上的一个重要里程碑。

最后,就是今天了,11月29日,来自创业公司的Pika直接带着网页版发布正式版1.0,叫板“老大哥”Runway。

在此之外,我们还从未见过哪个阶段有这么多各有特色、来自不同背景的产品争相亮相。

这也让人不得不感叹一句:

AI视频这是来到爆发前夜了?

欢迎大伙畅所欲言~

参考链接:

[1]https://twitter.com/demi_guo_/status/1729546758718656530

[2]https://pika.art/blog

[3]https://twitter.com/mignano/status/1729510740246020403